責任ある AI エージェントの構築: イノベーションと倫理のバランス

人工知能 (AI) は業界を変革しており、Salesforce の AgentForce などの自律型 AI エージェントや AutoGPT などのオープンソース ツールがその先頭に立っている。これらのエージェントは、複雑なタスクを自動化し、他のシステムと連携して、生産性を向上させます。しかし、自律性が高まるにつれ、偏見、透明性、説明責任などの問題に対処するために、責任ある AI 開発の必要性が重要になります。

AI エージェントの急速な導入は、その倫理的影響についての議論を引き起こしています。これらは医療、教育、販売などの業界に革命をもたらす大きな可能性を秘めていますが、責任を持って設計されなければリスクも伴います。開発者、組織、政府は、これらのシステムが革新的かつ倫理的であることを保証するために協力する必要があります。

責任ある AI エージェントを育成するとはどういう意味ですか?

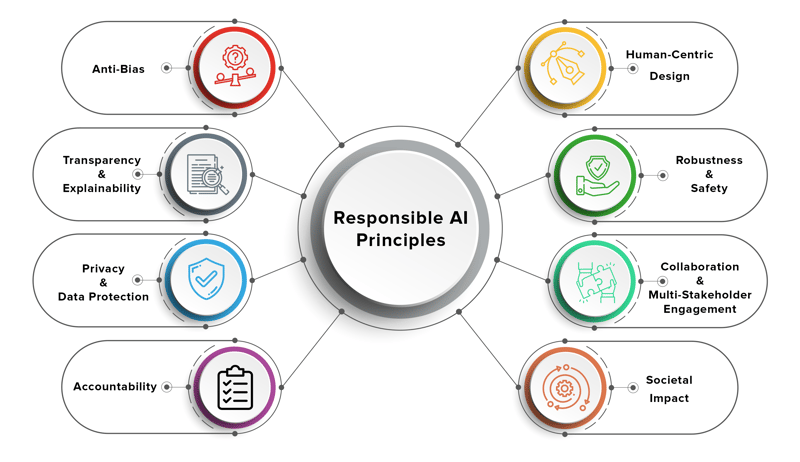

責任ある AI エージェントは、倫理的、透明性があり、責任を負うように設計されており、人間の価値観と一致し、危害を最小限に抑えます。これらのエージェントは公正に業務を遂行し、プライバシーを尊重し、決定について明確な説明を提供する必要があります。

責任ある AI の主要原則には次のものが含まれます。

- 公平性: 意思決定における偏見を回避し、すべてのユーザーに公平な結果が得られるようにします。

- 透明性: AI の意思決定をユーザーや関係者に理解できるようにします。

- 説明責任: AI の結果に対する責任を確立し、システムが監査可能であることを保証します。

- プライバシー: ユーザーデータを保護し、安全な操作を確保します。

- 持続可能性: エネルギー効率が高く環境に優しい AI システムを設計します。

責任ある AI の構築は単なる技術的な課題ではなく、開発者、倫理学者、政策立案者、エンドユーザー間の協力が必要な学際的な取り組みです。

AI システムにおける倫理的ジレンマの例

AI エージェントがより自律的になるにつれて、AI エージェントはその設計と展開を困難にする倫理的ジレンマに直面します。以下に実際の例をいくつか示します:

1.意思決定におけるバイアス

偏ったデータセットでトレーニングされた AI エージェントは、差別的な決定を下す可能性があります。例:

- 採用データにおける過去の偏りにより、採用エージェントは特定の層を他の層よりも優遇する可能性があります。

- 金融 AI エージェントは、偏った信用スコアリング モデルに基づいて、特定のグループへの融資を拒否する可能性があります。

2.透明性の欠如

多くの AI エージェントは「ブラックボックス」として動作し、解釈や説明が難しい決定を下します。例:

- カスタマー サービス AI エージェントは、明確な根拠を示さずに問題をエスカレーションしたり解決したりする可能性があり、ユーザー間の不満や不信感につながる可能性があります。

3.責任のギャップ

AI エージェントが間違いを犯した場合、誰が責任を負うのでしょうか?例:

- AI エージェントが制御する自動運転車が事故を起こした場合、責任は開発者、メーカー、それともユーザーのどれですか?

4.プライバシー侵害

AI エージェントが効果的に機能するには、多くの場合、ユーザーの機密データへのアクセスが必要です。ただし:

- 営業 AI エージェントが誤って顧客の機密情報を共有し、GDPR などのプライバシー法に違反する可能性があります。

5.販売およびマーケティングにおける AI の倫理的使用

Salesforce の AgentForce などのツールは、見込み顧客の発掘と顧客エンゲージメントを自動化することで、販売とマーケティングを変革しています。ただし:

- AI エージェントが製品をアップセルするために操作的な戦術を使用する場合、倫理的なマーケティング慣行に関する疑問が生じます。

これらのジレンマは、AI エージェントの設計と展開に倫理的考慮事項を組み込むことの重要性を浮き彫りにしています。

責任ある AI 開発のためのフレームワークとベスト プラクティス

これらの課題に対処するために、開発者と組織は次のフレームワークとベスト プラクティスを採用できます。

1.倫理的な AI フレームワーク

いくつかの組織が、責任ある AI に関する次のようなガイドラインを開発しています。

- Google の AI 原則: 公平性、プライバシー、説明責任に重点を置いています。

- OECD AI 原則: 人間中心の価値観と透明性を強調します。

- Salesforce の AI 倫理ガイドライン: AI システムの信頼を構築し、公平性を確保することを目的としています。

2.バイアスの軽減

- 多様で代表的なデータセットを使用して AI エージェントをトレーニングします。

- AI モデルのバイアスを定期的に監査し、必要に応じて再トレーニングします。

- 公平性指標を実装して、さまざまなグループに対する AI の決定の影響を評価します。

3.説明可能性と透明性

- S*HAP (SHApley Additive exPlanations)* や LIME (Local Interpretable Model-agnostic Explains) などのテクニックを使用して、AI の決定を解釈可能にします。

- AI エージェントがどのように意思決定を行うかについてユーザーに明確な説明を提供します。

4.責任のメカニズム

- AI プロジェクトに対する明確なガバナンス構造を確立します。

- AI の結果に対する責任を特定のチームまたは個人に割り当てます。

- 監査目的で AI エージェントのアクションの詳細なログを維持します。

5.プライバシーとセキュリティ

- 暗号化と安全なプロトコルを使用してユーザー データを保護します。

- 差分プライバシー技術を実装して機密情報を匿名化します。

- GDPR や CCPA などのデータ保護規制を遵守します。

6.継続的なモニタリングとフィードバック

- AI エージェントをリアルタイムで監視し、問題を検出して対処します。

- ユーザーのフィードバックを収集して、AI エージェントのパフォーマンスと倫理的調整を改善します。

- 変化する社会規範や価値観を反映するために AI モデルを定期的に更新します。

ステークホルダーの役割

責任ある AI エージェントの構築は、複数の関係者間の協力が必要な共有責任です。

政府

- AI システムの公平性、透明性、説明責任を確保するための規制を制定します。

- 倫理的な AI の研究開発を推進します。

- AI エージェントの展開を監視する監視機関を設立します。

組織

- 責任ある AI のための社内ポリシーとガイドラインを作成します。

- 倫理的な AI の実践について従業員を教育するためのトレーニング プログラムに投資します。

- 学術機関や非営利団体と提携して倫理的な AI 研究を推進します。

開発者

- AI エージェントの設計および開発中は、倫理的考慮事項を優先します。

- 組織内での責任ある AI 実践を提唱します。

- 倫理的な AI フレームワークとツールの最新の進歩に関する最新情報を入手してください。

Salesforce と AgentForce: ケーススタディ

顧客関係管理 (CRM) のリーダーである Salesforce は、責任ある AI 開発の最前線に立っています。同社の AgentForce プラットフォームは AI エージェントを活用して、販売プロセスを自動化し、顧客エンゲージメントを向上させ、ビジネスの成長を促進します。

Salesforce の特徴は、倫理的な AI への取り組みです。同社は、AI システムの公平性、透明性、説明責任を確保するために、堅牢なガイドラインを導入しました。例:

- バイアス検出: Salesforce はツールを使用して AI モデルのバイアスを特定し、軽減します。

- 説明可能性: AgentForce は、AI 主導の推奨事項がどのように作成されるかについての明確な洞察をユーザーに提供します。

- プライバシー: Salesforce は、顧客データが安全に取り扱われ、世界的な規制に準拠していることを保証します。

Salesforce は責任ある AI を優先することで、他の組織が従うべきベンチマークを設定しました。

結論

AI エージェントがより自律的になるにつれて、イノベーションと倫理のバランスをとることが不可欠です。偏見、透明性、説明責任などの問題に対処することで、AI エージェントが革新的であるだけでなく倫理的であることを保証できます。

責任ある AI エージェントを構築するには、開発者、組織、政府間の協力的な取り組みが必要です。倫理的な枠組みを採用し、偏見を軽減し、透明性を確保することで、害を最小限に抑えながら社会に利益をもたらす AI システムを構築できます。 Salesforce の AgentForce のようなツールは、責任ある AI が信頼と公平性を維持しながらイノベーションをどのように推進できるかを実証します。

AI の未来は明るいですが、AI にも責任があるかどうかは私たち次第です。

以上が責任ある AI エージェントの構築: イノベーションと倫理のバランスの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7876

7876

15

15

1649

1649

14

14

1409

1409

52

52

1301

1301

25

25

1245

1245

29

29

フロントエンドのサーマルペーパーレシートのために文字化けしたコード印刷に遭遇した場合はどうすればよいですか?

Apr 04, 2025 pm 02:42 PM

フロントエンドのサーマルペーパーレシートのために文字化けしたコード印刷に遭遇した場合はどうすればよいですか?

Apr 04, 2025 pm 02:42 PM

フロントエンドのサーマルペーパーチケット印刷のためのよくある質問とソリューションフロントエンド開発におけるチケット印刷は、一般的な要件です。しかし、多くの開発者が実装しています...

javascriptの分解:それが何をするのか、なぜそれが重要なのか

Apr 09, 2025 am 12:07 AM

javascriptの分解:それが何をするのか、なぜそれが重要なのか

Apr 09, 2025 am 12:07 AM

JavaScriptは現代のWeb開発の基礎であり、その主な機能には、イベント駆動型のプログラミング、動的コンテンツ生成、非同期プログラミングが含まれます。 1)イベント駆動型プログラミングにより、Webページはユーザー操作に応じて動的に変更できます。 2)動的コンテンツ生成により、条件に応じてページコンテンツを調整できます。 3)非同期プログラミングにより、ユーザーインターフェイスがブロックされないようにします。 JavaScriptは、Webインタラクション、シングルページアプリケーション、サーバー側の開発で広く使用されており、ユーザーエクスペリエンスとクロスプラットフォーム開発の柔軟性を大幅に改善しています。

誰がより多くのPythonまたはJavaScriptを支払われますか?

Apr 04, 2025 am 12:09 AM

誰がより多くのPythonまたはJavaScriptを支払われますか?

Apr 04, 2025 am 12:09 AM

スキルや業界のニーズに応じて、PythonおよびJavaScript開発者には絶対的な給与はありません。 1. Pythonは、データサイエンスと機械学習でさらに支払われる場合があります。 2。JavaScriptは、フロントエンドとフルスタックの開発に大きな需要があり、その給与もかなりです。 3。影響要因には、経験、地理的位置、会社の規模、特定のスキルが含まれます。

JavaScriptは学ぶのが難しいですか?

Apr 03, 2025 am 12:20 AM

JavaScriptは学ぶのが難しいですか?

Apr 03, 2025 am 12:20 AM

JavaScriptを学ぶことは難しくありませんが、挑戦的です。 1)変数、データ型、関数などの基本概念を理解します。2)非同期プログラミングをマスターし、イベントループを通じて実装します。 3)DOM操作を使用し、非同期リクエストを処理することを約束します。 4)一般的な間違いを避け、デバッグテクニックを使用します。 5)パフォーマンスを最適化し、ベストプラクティスに従ってください。

JavaScriptの進化:現在の傾向と将来の見通し

Apr 10, 2025 am 09:33 AM

JavaScriptの進化:現在の傾向と将来の見通し

Apr 10, 2025 am 09:33 AM

JavaScriptの最新トレンドには、TypeScriptの台頭、最新のフレームワークとライブラリの人気、WebAssemblyの適用が含まれます。将来の見通しは、より強力なタイプシステム、サーバー側のJavaScriptの開発、人工知能と機械学習の拡大、およびIoTおよびEDGEコンピューティングの可能性をカバーしています。

JavaScriptを使用して、同じIDを持つArray要素を1つのオブジェクトにマージする方法は?

Apr 04, 2025 pm 05:09 PM

JavaScriptを使用して、同じIDを持つArray要素を1つのオブジェクトにマージする方法は?

Apr 04, 2025 pm 05:09 PM

同じIDを持つ配列要素をJavaScriptの1つのオブジェクトにマージする方法は?データを処理するとき、私たちはしばしば同じIDを持つ必要性に遭遇します...

Shiseidoの公式Webサイトのように、視差スクロールと要素のアニメーション効果を実現する方法は?

または:

Shiseidoの公式Webサイトのようにスクロールするページを伴うアニメーション効果をどのように実現できますか?

Apr 04, 2025 pm 05:36 PM

Shiseidoの公式Webサイトのように、視差スクロールと要素のアニメーション効果を実現する方法は?

または:

Shiseidoの公式Webサイトのようにスクロールするページを伴うアニメーション効果をどのように実現できますか?

Apr 04, 2025 pm 05:36 PM

この記事の視差スクロールと要素のアニメーション効果の実現に関する議論では、Shiseidoの公式ウェブサイト(https://www.shisido.co.co.jp/sb/wonderland/)と同様の達成方法について説明します。

Console.log出力の違い結果:なぜ2つの呼び出しが異なるのですか?

Apr 04, 2025 pm 05:12 PM

Console.log出力の違い結果:なぜ2つの呼び出しが異なるのですか?

Apr 04, 2025 pm 05:12 PM

Console.log出力の違いの根本原因に関する詳細な議論。この記事では、Console.log関数の出力結果の違いをコードの一部で分析し、その背後にある理由を説明します。 �...