最新の大手言語モデル(LLMS)の重要な機能である

コンテキスト学習(ICL)は、入力プロンプト内の例に基づいてトランスを適応させることができます。 いくつかのショットプロンプトは、いくつかのタスクの例を使用して、望ましい動作を効果的に実証します。 しかし、トランスフォーマーはこの適応をどのように達成しますか?この記事では、ICLの背後にある潜在的なメカニズムについて説明します

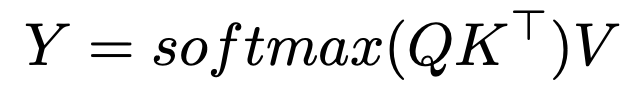

に新しいクエリ(x)をマッピングできます。

SoftMaxの注意と最近隣の検索です

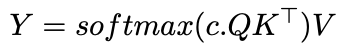

c は、注意割り当てを変更します:

cが無限に近づくにつれて、注意は1ホットのベクトルになり、最も類似したトークンのみに焦点を当てます。 有限cでは、注意はガウスカーネルの平滑化に似ています。 これは、ICLが入出力ペアに最も近い隣接アルゴリズムを実装する可能性があることを示唆しています。 意味とさらなる研究

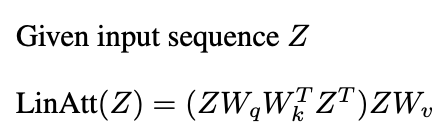

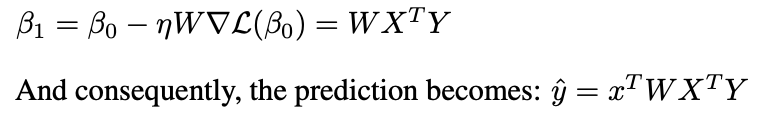

最近の研究(Garg etal。2022、Oswald etal。2023)は、変圧器のICLを勾配降下にリンクします。 SoftMax操作を省略する線形注意:

は、前処理された勾配降下(PGD)に似ています:

線形注意の1つの層が1つのPGDステップを実行します。

結論

結論

注意メカニズムは、学習アルゴリズムを実装し、デモンストレーションペアから学習することでICLを有効にすることができます。複数の注意層とMLPの相互作用は複雑ですが、研究はICLのメカニズムに光を当てています。この記事では、これらの洞察の高レベルの概要を説明しています

さらなる読み取り:この記事は、ミシガン大学での2024年秋の卒業生授業に触発されています。 エラーは著者のみです

以上がコンテキスト学習の背後にある数学の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。