2024年のコーディングのためのLLMS:価格、パフォーマンス、そして最高の戦い

コーディング用の大規模な言語モデル(LLMS)の急速に進化する風景は、開発者に豊富な選択肢を提供します。 この分析では、Public APIを介してアクセス可能なトップLLMを比較し、HumanvalやReal World ELOスコアなどのベンチマークで測定するコーディング能力に焦点を当てています。 個人的なプロジェクトを構築する場合でも、AIをワークフローに統合する場合でも、これらのモデルの長所と短所を理解することは、情報に基づいた意思決定に不可欠です。

LLM比較の課題:

モデルの更新が頻繁に更新される(マイナーなものでさえパフォーマンスに大きな影響を与える)、LLMの固有の確率が一貫性のない結果につながるため、ベンチマークの設計とレポートの潜在的なバイアスがあるため、直接的な比較は困難です。 この分析は、現在利用可能なデータに基づいた最高の効果的な比較を表しています。 評価メトリック:Humaneval and ELOスコア:この分析では、2つの重要なメトリックを使用しています。

- HumanVal:

- 指定された要件に基づいてコードの正確性と機能を評価するベンチマーク。 コードの完了と問題解決能力を測定します eloスコア(チャットボットアリーナ - コーディングのみ): 人間によって判断された頭と頭のLLM比較から導出されました。 ELOスコアが高いほど、相対的なパフォーマンスが優れていることを示しています。 100ポイントの違いは、高評価モデルの勝率が約64%であることを示唆しています。

- パフォーマンスの概要:

Openaiのモデルは、人間のランキングとELOランキングの両方を一貫して上回り、優れたコーディング機能を紹介します。

o1-mini モデルは、両方のメトリックで驚くほど大きな

モデルは、両方のメトリックで驚くほど大きな

モデルよりも優れています。 他の企業の最高のモデルは、Openaiの後続ですが、同等のパフォーマンスを示しています。

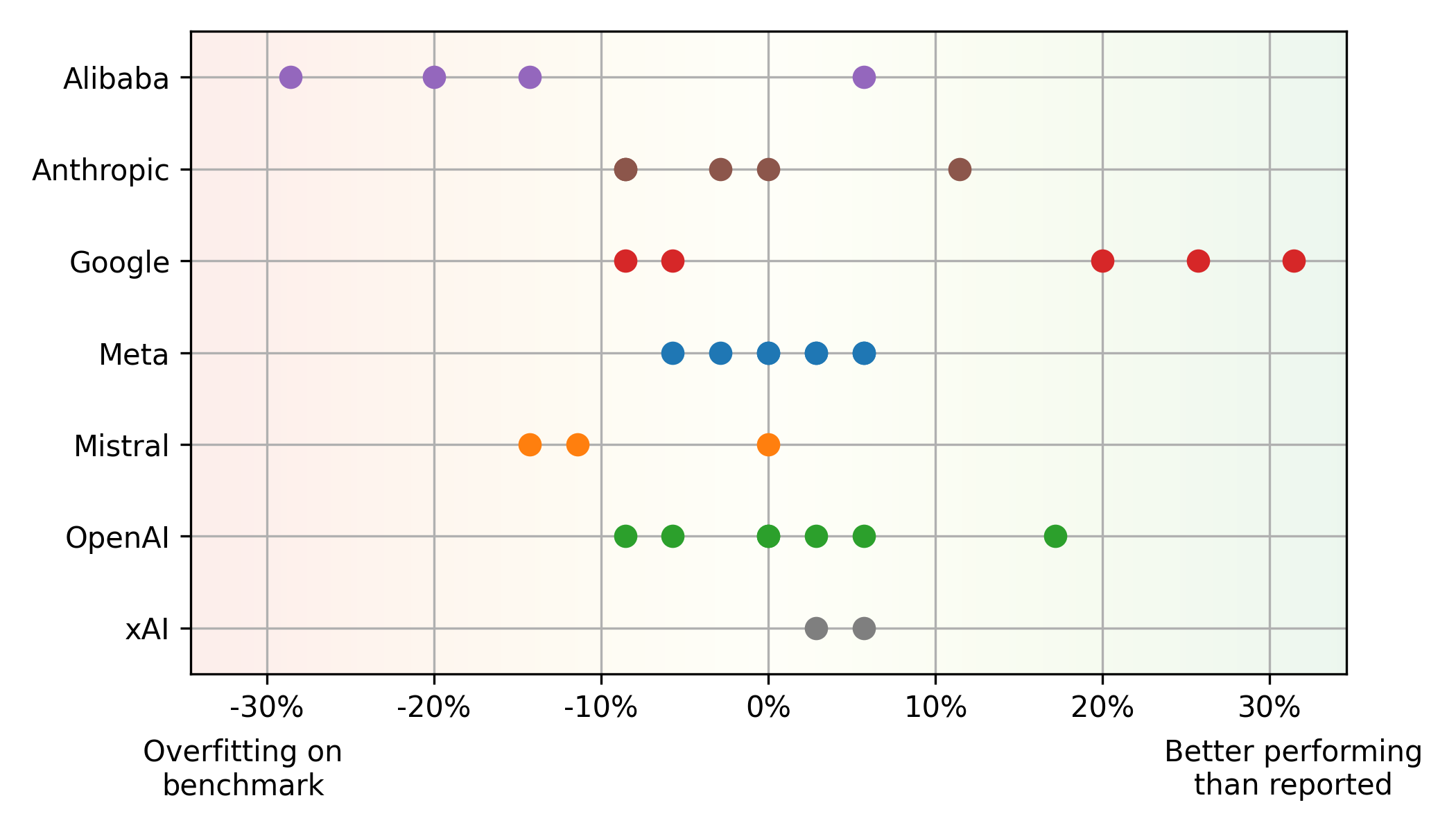

ベンチマークvs.実際のパフォーマンスの不一致:

ヒューマンルススコアとELOスコアの間に重要な不一致が存在します。 MistralのMistral Large

のようなモデルの中には、実際の使用(潜在的なオーバーフィット)よりもHumanvalでパフォーマンスが向上しますが、GoogleのGemini 1.5 Proなどの他のモデルは反対の傾向を示します(ベンチマークでの過小評価)。これは、ベンチマークのみに依存することの制限を強調しています。 AlibabaおよびMistralモデルは、多くの場合、ベンチマークに過剰に適合しますが、Googleのモデルは公正な評価に重点を置いているため、過小評価されているように見えます。 メタモデルは、ベンチマークと実世界のパフォーマンスの間の一貫したバランスを示しています。

パフォーマンスと価格のバランス:

パレートフロント(パフォーマンスと価格の最適バランス)は、主にOpenAI(高性能)とGoogle(Moneyの価値)モデルを備えています。 クラウドプロバイダーの平均に基づいて価格設定されたメタのオープンソースラマモデルも、競争力を示しています。

追加の洞察:

コーディングLLMランドスケープは動的です。 開発者は、パフォーマンスとコストの両方を考慮して、最新のモデルを定期的に評価する必要があります。 ベンチマークの制限を理解し、多様な評価メトリックを優先することは、情報に基づいた選択を行うために重要です。 この分析は、現在の状態のスナップショットを提供し、この急速に進化する分野で先を行くためには継続的な監視が不可欠です。

以上が2024年のコーディングのためのLLMS:価格、パフォーマンス、そして最高の戦いの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7943

7943

15

15

1652

1652

14

14

1412

1412

52

52

1303

1303

25

25

1250

1250

29

29

Meta Llama 3.2を始めましょう - 分析Vidhya

Apr 11, 2025 pm 12:04 PM

Meta Llama 3.2を始めましょう - 分析Vidhya

Apr 11, 2025 pm 12:04 PM

メタのラマ3.2:マルチモーダルとモバイルAIの前進 メタは最近、ラマ3.2を発表しました。これは、モバイルデバイス向けに最適化された強力なビジョン機能と軽量テキストモデルを特徴とするAIの大幅な進歩です。 成功に基づいてo

10生成AIコーディング拡張機能とコードのコードを探る必要があります

Apr 13, 2025 am 01:14 AM

10生成AIコーディング拡張機能とコードのコードを探る必要があります

Apr 13, 2025 am 01:14 AM

ねえ、忍者をコーディング!その日はどのようなコーディング関連のタスクを計画していますか?このブログにさらに飛び込む前に、コーディング関連のすべての問題について考えてほしいです。 終わり? - &#8217を見てみましょう

AVバイト:Meta' s llama 3.2、GoogleのGemini 1.5など

Apr 11, 2025 pm 12:01 PM

AVバイト:Meta' s llama 3.2、GoogleのGemini 1.5など

Apr 11, 2025 pm 12:01 PM

今週のAIの風景:進歩、倫理的考慮、規制の議論の旋風。 Openai、Google、Meta、Microsoftのような主要なプレーヤーは、画期的な新しいモデルからLEの重要な変化まで、アップデートの急流を解き放ちました

従業員へのAI戦略の販売:Shopify CEOのマニフェスト

Apr 10, 2025 am 11:19 AM

従業員へのAI戦略の販売:Shopify CEOのマニフェスト

Apr 10, 2025 am 11:19 AM

Shopify CEOのTobiLütkeの最近のメモは、AIの能力がすべての従業員にとって基本的な期待であると大胆に宣言し、会社内の重大な文化的変化を示しています。 これはつかの間の傾向ではありません。これは、pに統合された新しい運用パラダイムです

ビジョン言語モデル(VLM)の包括的なガイド

Apr 12, 2025 am 11:58 AM

ビジョン言語モデル(VLM)の包括的なガイド

Apr 12, 2025 am 11:58 AM

導入 鮮やかな絵画や彫刻に囲まれたアートギャラリーを歩くことを想像してください。さて、各ピースに質問をして意味のある答えを得ることができたらどうでしょうか?あなたは尋ねるかもしれません、「あなたはどんな話を言っていますか?

GPT-4o vs Openai O1:新しいOpenaiモデルは誇大広告に値しますか?

Apr 13, 2025 am 10:18 AM

GPT-4o vs Openai O1:新しいOpenaiモデルは誇大広告に値しますか?

Apr 13, 2025 am 10:18 AM

導入 Openaiは、待望の「Strawberry」アーキテクチャに基づいて新しいモデルをリリースしました。 O1として知られるこの革新的なモデルは、推論能力を強化し、問題を通じて考えられるようになりました

SQLに列を追加する方法は? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQLに列を追加する方法は? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQLの変更テーブルステートメント:データベースに列を動的に追加する データ管理では、SQLの適応性が重要です。 その場でデータベース構造を調整する必要がありますか? Alter Tableステートメントはあなたの解決策です。このガイドの詳細は、コルを追加します

AIインデックス2025を読む:AIはあなたの友人、敵、または副操縦士ですか?

Apr 11, 2025 pm 12:13 PM

AIインデックス2025を読む:AIはあなたの友人、敵、または副操縦士ですか?

Apr 11, 2025 pm 12:13 PM

スタンフォード大学ヒト指向の人工知能研究所によってリリースされた2025年の人工知能インデックスレポートは、進行中の人工知能革命の良い概要を提供します。 4つの単純な概念で解釈しましょう:認知(何が起こっているのかを理解する)、感謝(利益を見る)、受け入れ(顔の課題)、責任(責任を見つける)。 認知:人工知能はどこにでもあり、急速に発展しています 私たちは、人工知能がどれほど速く発展し、広がっているかを強く認識する必要があります。人工知能システムは絶えず改善されており、数学と複雑な思考テストで優れた結果を達成しており、わずか1年前にこれらのテストで惨めに失敗しました。 2023年以来、複雑なコーディングの問題や大学院レベルの科学的問題を解決することを想像してみてください