AI駆動の推論モデルは、2025年に世界を席巻しています! DeepSeek-R1とO3-Miniの発売により、AIチャットボットでは前例のないレベルの論理推論機能が見られました。この記事では、これらのモデルにAPIを介してアクセスし、論理的推論スキルを評価して、O3-MINIがDeepSeek-R1を置き換えることができるかどうかを調べます。標準のベンチマークでのパフォーマンスを比較し、論理パズルの解決やテトリスゲームの構築などの実際のアプリケーションを比較します!バックルして乗り心地に参加してください。

ベンチマークの結果は、OpenaiのO3-Miniが、数学を除くほぼすべての側面でDeepSeek-R1を上回ることを示しています。 Deepseekの71.38と比較して、世界平均スコアは73.94であるため、O3-Miniは全体的なパフォーマンスがわずかに強いことを示しています。特に推論に優れており、Deepseekの83.17に対して89.58を達成し、優れた分析および問題解決機能を反映しています。 また読む:Google Gemini 2.0 Pro vs Deepseek-R1:コーディングは誰ですか?

deepseek-r1 vs o3-mini:API価格の比較 これらのモデルをAPIを通じてテストしているので、これらのモデルの費用を見てみましょう。

| Model | Context length | Input Price | Cached Input Price | Output Price |

| o3-mini | 200k | .10/M tokens | .55/M tokens | .40/M tokens |

| deepseek-chat | 64k | .27/M tokens | .07/M tokens | .10/M tokens |

| deepseek-reasoner | 64k | .55/M tokens | .14/M tokens | .19/M tokens |

ソース:deepseek-r1 | o3-mini

deepseek-r1およびo3-miniにアクセスする方法

あなたがこれのためにしなければならないのは、必要なライブラリとAPIキーをインポートすることだけです:

from openai import OpenAI from IPython.display import display, Markdown import time

with open("path_of_api_key") as file:

openai_api_key = file.read().strip()with open("path_of_api_key") as file:

deepseek_api = file.read().strip()モデルが回答を生成するために時間をかける時間

deepseek-r1 api への入力 DeepSeek-R1

による 応答

INPUT_COST_CACHE_HIT = 0.14 / 1_000_000 # <pre class="brush:php;toolbar:false">task1_start_time = time.time()

client = OpenAI(api_key=api_key)

messages = messages=[

{

"role": "system",

"content": """You are a professional Programmer with a large experience ."""

},

{

"role": "user",

"content": """write a python code for this problem: generate a python code for Tetris game.

"""

}

]

# Use a compatible encoding (cl100k_base is the best option for new OpenAI models)

encoding = tiktoken.get_encoding("cl100k_base")

# Calculate token counts

input_tokens = sum(len(encoding.encode(msg["content"])) for msg in messages)

completion = client.chat.completions.create(

model="o3-mini-2025-01-31",

messages=messages

)

output_tokens = len(encoding.encode(completion.choices[0].message.content))

task1_end_time = time.time()

input_cost_per_1k = 0.0011 # Example: <pre class="brush:php;toolbar:false">INPUT_COST_CACHE_HIT = 0.14 / 1_000_000 # <pre class="brush:php;toolbar:false">task2_start_time = time.time()

client = OpenAI(api_key=api_key)

messages = [

{

"role": "system",

"content": """You are an expert in solving Reasoning Problems. Please solve the given problem"""

},

{

"role": "user",

"content": """In the following question, assuming the given statements to be true, find which of the conclusions among given conclusions is/are definitely true and then give your answers accordingly.

Statements: H > F ≤ O ≤ L; F ≥ V < D

Conclusions:

I. L ≥ V

II. O > D

The options are:

A. Only I is true

B. Only II is true

C. Both I and II are true

D. Either I or II is true

E. Neither I nor II is true

"""

}

]

# Use a compatible encoding (cl100k_base is the best option for new OpenAI models)

encoding = tiktoken.get_encoding("cl100k_base")

# Calculate token counts

input_tokens = sum(len(encoding.encode(msg["content"])) for msg in messages)

completion = client.chat.completions.create(

model="o3-mini-2025-01-31",

messages=messages

)

output_tokens = len(encoding.encode(completion.choices[0].message.content))

task2_end_time = time.time()

input_cost_per_1k = 0.0011 # Example: <pre class="brush:php;toolbar:false">INPUT_COST_CACHE_HIT = 0.14 / 1_000_000 # <pre class="brush:php;toolbar:false">task3_start_time = time.time()

client = OpenAI(api_key=api_key)

messages = [

{

"role": "system",

"content": """You are a Expert in solving Reasoning Problems. Please solve the given problem"""

},

{

"role": "user",

"content": """

Study the given matrix carefully and select the number from among the given options that can replace the question mark (?) in it.

__________________

| 7 | 13 | 174|

| 9 | 25 | 104|

| 11 | 30 | ? |

|_____|_____|____|

The options are:

A 335

B 129

C 431

D 100

Please mention your approch that you have taken at each step

"""

}

]

# Use a compatible encoding (cl100k_base is the best option for new OpenAI models)

encoding = tiktoken.get_encoding("cl100k_base")

# Calculate token counts

input_tokens = sum(len(encoding.encode(msg["content"])) for msg in messages)

completion = client.chat.completions.create(

model="o3-mini-2025-01-31",

messages=messages

)

output_tokens = len(encoding.encode(completion.choices[0].message.content))

task3_end_time = time.time()

input_cost_per_1k = 0.0011 # Example: .005 per 1,000 input tokens

output_cost_per_1k = 0.0044 # Example: .015 per 1,000 output tokens

# Calculate cost

input_cost = (input_tokens / 1000) * input_cost_per_1k

output_cost = (output_tokens / 1000) * output_cost_per_1k

total_cost = input_cost + output_cost

# Print results

print(completion.choices[0].message)

print("----------------=Total Time Taken for task 3:----------------- ", task3_end_time - task3_start_time)

print(f"Input Tokens: {input_tokens}, Output Tokens: {output_tokens}")

print(f"Estimated Cost: ${total_cost:.6f}")

# Display result

from IPython.display import Markdown

display(Markdown(completion.choices[0].message.content))DeepSeek-R1の完全な応答をここで見つけることができます。

出力トークンコスト:

入力トークン:28 |出力トークン:3323 |推定コスト:0.0073ドル

コード出力

o3-mini api

への入力比較分析

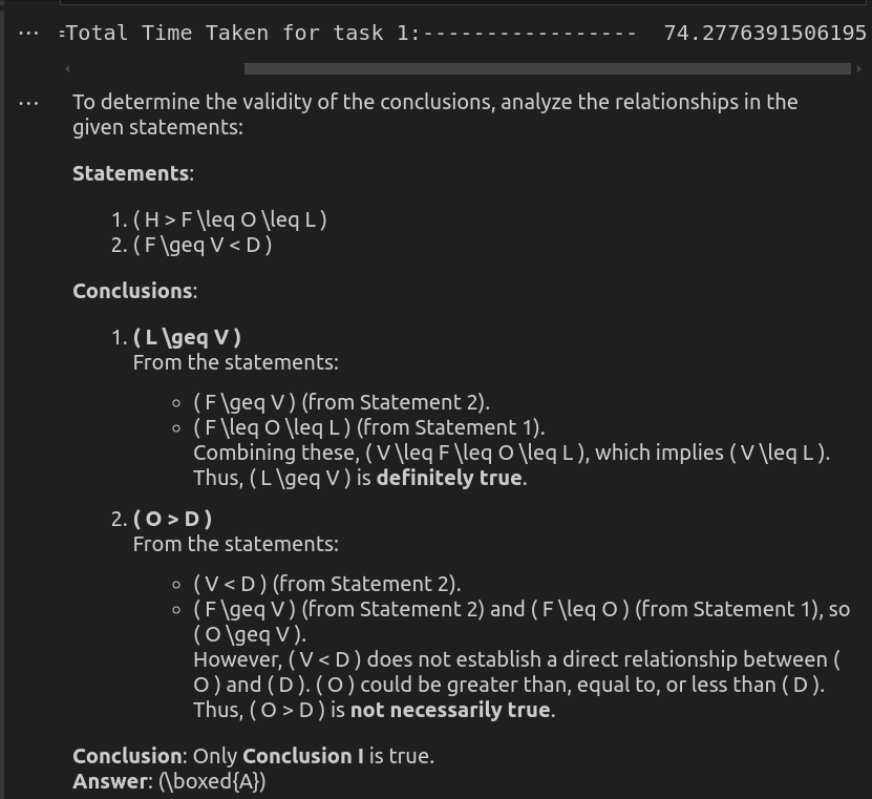

このタスクでは、モデルは実際のゲームプレイを可能にする機能的なテトリスコードを生成するために必要でした。 DeepSeek-R1は、コード出力ビデオで実証されているように、完全に機能する実装を正常に作成しました。対照的に、O3-Miniのコードはよく構築されているように見えましたが、実行中にエラーが発生しました。その結果、DeepSeek-R1はこのシナリオでO3-MINIを上回り、より信頼性の高いプレイ可能なソリューションを提供します。 スコア:deepseek-r1:1 | o3-mini:0 タスク2:関係の不平等の分析

プロンプト:

“次の質問では、与えられたステートメントが真実であると仮定して、与えられた結論の中でどの結論が真実であるかを見つけて、それに応じて答えを与えます。 ステートメント:

h&gt; f≤o≤l; f≥V&lt; d

結論:I。L≥VII。 o&gt; d

オプションは次のとおりです a。私だけが真実です

b。 IIのみが真です

c。 IとIIの両方がtrue

です d。 IまたはIIのいずれかがTRUE

です e。私もIIも真実ではありません

deepseek-r1 api への入力

出力トークンコスト:

入力トークン:136 |出力トークン:352 |推定コスト:$ 0.000004 DeepSeek-R1

によるfrom openai import OpenAI from IPython.display import display, Markdown import time

応答

o3-mini apiへの入力

出力トークンコスト:

入力トークン:135 |出力トークン:423 |推定コスト:$ 0.002010 O3-Mini

with open("path_of_api_key") as file:

openai_api_key = file.read().strip()比較分析

O3-MINIは最も効率的なソリューションを提供し、非常に短い時間で簡潔で正確な応答を提供します。明確さを維持しながら、論理的な健全性を確保し、迅速な推論タスクに最適です。 DeepSeek-R1も同様に正しいものの、はるかに遅く、より冗長です。論理的な関係の詳細な内訳は説明可能性を向上させますが、簡単な評価には過度に感じる可能性があります。どちらのモデルも同じ結論に到達しますが、O3-Miniの速度と直接的なアプローチにより、実用的な選択肢になります。

スコア:deepseek-r1:0 | o3-mini:1

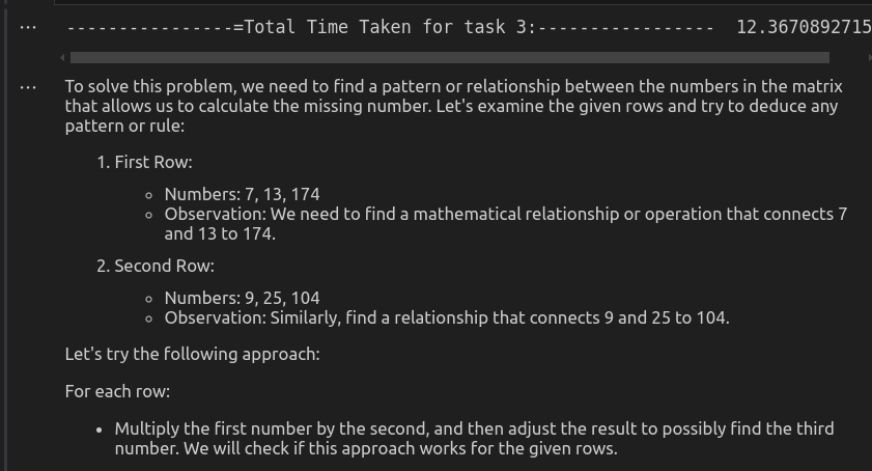

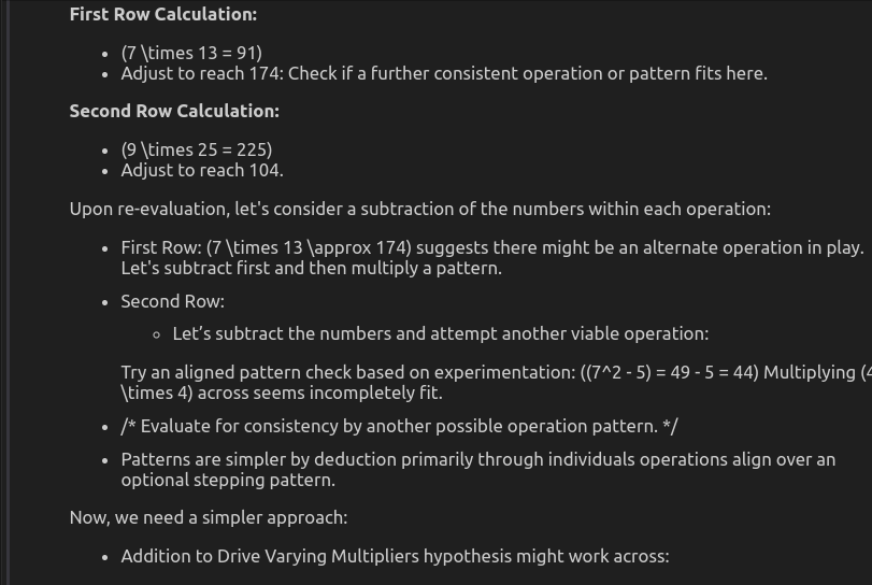

「指定されたマトリックスを注意深く調査し、その中の疑問符(?)を置き換えることができる与えられたオプションの中から数値を選択します。 ____________ | 7 | 13 | 174 |

| 9 | 25 | 104 |

| 11 | 30 | ? |

| _____ | ____ | ___ |

オプションは次のとおりです a 335b 129

c 431

d 100

各ステップで取ったアプローチに言及してください。 "

deepseek-r1 api

への入力

出力トークンコスト:入力トークン:134 |出力トークン:274 |推定コスト:$ 0.000003

DeepSeek-R1from openai import OpenAI from IPython.display import display, Markdown import time

による 応答

o3-mini api

への入力

入力トークン:134 |出力トークン:736 |推定コスト:0.003386ドル

O3-Mini with open("path_of_api_key") as file: openai_api_key = file.read().strip()

(1番目)^3-(2番目の番号)^2 = 3番目の番号 このパターンの適用:

このパターンの適用:

行1:7^3 - 13^2 = 343 - 169 = 174

行1:7^3 - 13^2 = 343 - 169 = 174

行2:9^3 - 25^2 = 729 - 625 = 104 行3:11^3 - 30^2 = 1331 - 900 = 431

したがって、正解は431です

deepseek-r1は、このパターンを正しく識別して適用し、正しい答えにつながります。その構造化されたアプローチは、結果を計算するのにかなり時間がかかるが、精度を保証します。一方、O3-Miniは一貫したパターンを確立できません。乗算、追加、指数などの複数の操作を試みますが、決定的な答えには到達しません。これにより、不明確で誤った応答が生じます。全体として、DeepSeek-R1は論理的な推論と精度でO3-Miniを上回りますが、O3-Miniは一貫性のない効果のないアプローチのために苦労しています。

スコア:

deepseek-r1:1 | o3-mini:0| Task No. | Task Type | Model | Performance | Time Taken (seconds) | Cost |

| 1 | Code Generation | DeepSeek-R1 | ✅ Working Code | 606.45 | .0073 |

| o3-mini | ❌ Non-working Code | 99.73 | .014265 | ||

| 2 | Alphabetical Reasoning | DeepSeek-R1 | ✅ Correct | 74.28 | .000004 |

| o3-mini | ✅ Correct | 8.08 | .002010 | ||

| 3 | Mathematical Reasoning | DeepSeek-R1 | ✅ Correct | 450.53 | .000003 |

| o3-mini | ❌ Wrong Answer | 12.37 | .003386 |

この分析では、言語モデルの速度と精度のトレードオフを強調しています。 O3-MINIは迅速で低リスクのアプリケーションに役立つ可能性がありますが、DeepSeek-R1は、その遅延問題に対処すると、推論集約型タスクの優れた選択肢として際立っています。 AIモデルが進化し続けるにつれて、パフォーマンス効率と正確性のバランスをとることが、さまざまなドメインにわたってAI駆動型のワークフローを最適化するための鍵となります。

また読む:OpenaiのO3-MiniはコーディングでClaude Sonnet 3.5を倒すことができますか?

よくある質問q1。 DeepSeek-R1とO3-Miniの重要な違いは何ですか? DeepSeek-R1は数学的推論と複雑なコード生成に優れているため、論理的な深さと精度を必要とするアプリケーションに最適です。一方、O3-MINIは大幅に高速ですが、しばしば精度を犠牲にし、時折間違った出力につながります。 DeepSeek-R1は、タスクをコーディングするためにO3-MINIよりも優れていますか? DeepSeek-R1は、その優れた精度と複雑なロジックを処理する能力により、コーディングと推論集約型タスクに適した選択肢です。 O3-MINIはより迅速な応答を提供しますが、エラーが生成される可能性があり、ハイステークスプログラミングタスクの信頼性が低下する可能性があります。 O3-MINIは実際のアプリケーションに適していますか? O3-MINIは、チャットボット、カジュアルなテキスト生成、インタラクティブなAIエクスペリエンスなど、低リスクのスピード依存性アプリケーションに最適です。ただし、高精度を必要とするタスクの場合、DeepSeek-R1が好ましいオプションです。推論と問題解決に適したモデル - deepseek-r1またはo3-mini?

a。 DeepSeek-R1には優れた論理的推論と問題解決機能があり、数学的な計算、プログラミング支援、科学的クエリに強い選択肢となっています。 O3-MINIは、複雑な問題解決シナリオで迅速ですが、時には一貫性のない応答を提供します。以上がO3-MINIは論理的な推論のためにDeepSeek-R1を置き換えることができますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。