QWEN2.5モデルを3分でローカルに実行するにはどうすればよいですか?

QWEN2.5-MAX:費用対効果の高い人間のような推論の大規模な言語モデル

AIの風景は、DeepSeek、Mistral Small 3、QWEN2.5 Maxなどの強力で費用対効果の高いモデルで賑わっています。 特に、QWEN2.5-MAXは、いくつかのベンチマークでDeepSeek V3を上回ることさえ、強力な専門家(MOE)モデルとして波を作っています。高度なアーキテクチャと大規模なトレーニングデータセット(最大18兆トークン)は、パフォーマンスの新しい標準を設定しています。この記事では、QWEN2.5-MAXのアーキテクチャ、その競争上の利点、およびDeepseek V3に匹敵する可能性について説明します。また、QWEN2.5モデルをローカルで実行することもガイドします

キーQWEN2.5モデル機能:

- 多言語のサポート:29を超える言語をサポートします。

- 拡張コンテキスト:最大128Kトークンまでの長いコンテキストを処理します 機能の強化された機能:

- コーディング、数学、指示のフォロー、および構造化されたデータ理解の大幅な改善。 目次:

キーQWEN2.5モデル機能

- ollama

- でqwen2.5を使用します qwen2.5:7b推論

- QWEN2.5-CODER:3B推論

- 結論

- オラマとローカルにqwen2.5を実行してください:

curl -fsSL https://ollama.com/install.sh | sh

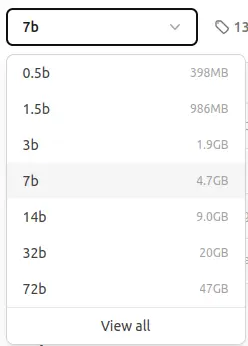

7Bパラメーターモデル(約4.7 GB)を使用します。限られたリソースを持つユーザーが小規模なモデルを利用できます。

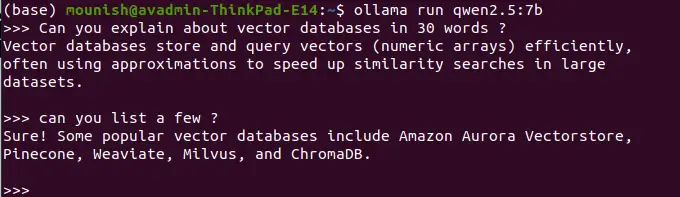

qwen2.5:7b推論:

qwen2.5:7b推論:

コマンドはモデルをダウンロードします。 これに似た出力が表示されます:

ollama pull qwen2.5:7b

その後、モデルを実行します:pull

<code>pulling manifest pulling 2bada8a74506... 100% ▕████████████████▏ 4.7 GB ... (rest of the output) ... success</code>

ollama run qwen2.5:7b

の例

30ワードでベクトルデータベースを定義します

プロンプト:

<code>Vector databases efficiently store and query numerical arrays (vectors), often using approximations for fast similarity searches in large datasets.</code>

注:ローカルランモデルには、リアルタイムアクセスとWeb検索機能がありません。 たとえば、

<code>Popular vector databases include Pinecone, Weaviate, Milvus, ChromaDB, and Amazon Aurora Vectorstore.</code>

プロンプト:今日の日付は何ですか?

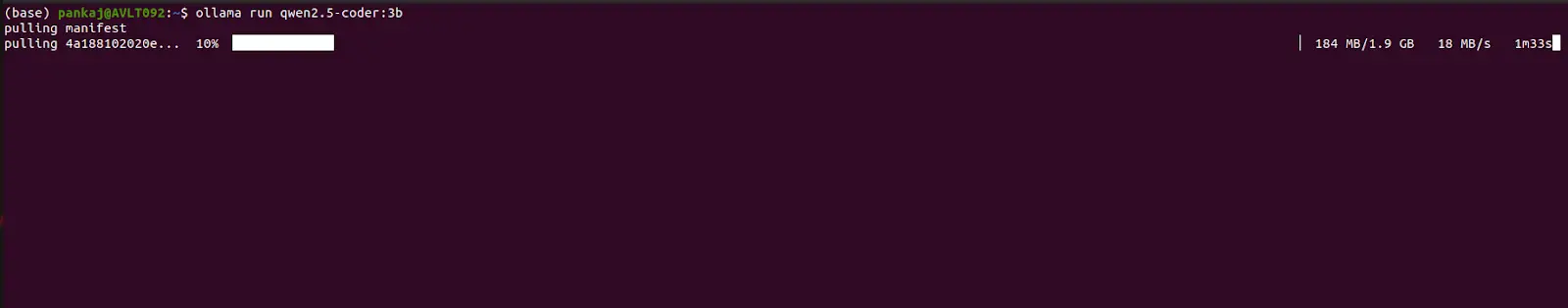

qwen2.5-coder:3b推論:

同じプロセスに従って、<code>Today's date is unavailable. My knowledge is not updated in real-time.</code>

コーディングプロンプトの例:qwen2.5-coder:3b

プロンプト:fibonacciシーケンスのPythonコードを提供します

(出力:FibonacciシーケンスのPythonコードがここに表示されます)プロンプト:

Python関数を使用してシンプルな計算機を作成します。(出力:簡単な計算機のPythonコードがこちらに表示されます)

結論: このガイドは、Ollamaを使用してQWEN2.5モデルをローカルに実行する方法を示しています。QWEN2.5-MAXの強度を強調しています。 ローカルの実行はセキュリティを改善しますが、リアルタイムの情報アクセスを犠牲にします。 QWEN2.5は、効率、セキュリティ、パフォーマンスの間の魅力的なバランスを提供し、さまざまなAIアプリケーションのDeepSeek V3の強力な代替手段となっています。 Google Colab経由のQWEN2.5-MAXへのアクセスの詳細については、別のリソースで入手できます。

以上がQWEN2.5モデルを3分でローカルに実行するにはどうすればよいですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1662

1662

14

14

1419

1419

52

52

1312

1312

25

25

1262

1262

29

29

1235

1235

24

24

Meta Llama 3.2を始めましょう - 分析Vidhya

Apr 11, 2025 pm 12:04 PM

Meta Llama 3.2を始めましょう - 分析Vidhya

Apr 11, 2025 pm 12:04 PM

メタのラマ3.2:マルチモーダルとモバイルAIの前進 メタは最近、ラマ3.2を発表しました。これは、モバイルデバイス向けに最適化された強力なビジョン機能と軽量テキストモデルを特徴とするAIの大幅な進歩です。 成功に基づいてo

10生成AIコーディング拡張機能とコードのコードを探る必要があります

Apr 13, 2025 am 01:14 AM

10生成AIコーディング拡張機能とコードのコードを探る必要があります

Apr 13, 2025 am 01:14 AM

ねえ、忍者をコーディング!その日はどのようなコーディング関連のタスクを計画していますか?このブログにさらに飛び込む前に、コーディング関連のすべての問題について考えてほしいです。 終わり? - &#8217を見てみましょう

AVバイト:Meta&#039; s llama 3.2、GoogleのGemini 1.5など

Apr 11, 2025 pm 12:01 PM

AVバイト:Meta&#039; s llama 3.2、GoogleのGemini 1.5など

Apr 11, 2025 pm 12:01 PM

今週のAIの風景:進歩、倫理的考慮、規制の議論の旋風。 Openai、Google、Meta、Microsoftのような主要なプレーヤーは、画期的な新しいモデルからLEの重要な変化まで、アップデートの急流を解き放ちました

従業員へのAI戦略の販売:Shopify CEOのマニフェスト

Apr 10, 2025 am 11:19 AM

従業員へのAI戦略の販売:Shopify CEOのマニフェスト

Apr 10, 2025 am 11:19 AM

Shopify CEOのTobiLütkeの最近のメモは、AIの能力がすべての従業員にとって基本的な期待であると大胆に宣言し、会社内の重大な文化的変化を示しています。 これはつかの間の傾向ではありません。これは、pに統合された新しい運用パラダイムです

ビジョン言語モデル(VLM)の包括的なガイド

Apr 12, 2025 am 11:58 AM

ビジョン言語モデル(VLM)の包括的なガイド

Apr 12, 2025 am 11:58 AM

導入 鮮やかな絵画や彫刻に囲まれたアートギャラリーを歩くことを想像してください。さて、各ピースに質問をして意味のある答えを得ることができたらどうでしょうか?あなたは尋ねるかもしれません、「あなたはどんな話を言っていますか?

GPT-4o vs Openai O1:新しいOpenaiモデルは誇大広告に値しますか?

Apr 13, 2025 am 10:18 AM

GPT-4o vs Openai O1:新しいOpenaiモデルは誇大広告に値しますか?

Apr 13, 2025 am 10:18 AM

導入 Openaiは、待望の「Strawberry」アーキテクチャに基づいて新しいモデルをリリースしました。 O1として知られるこの革新的なモデルは、推論能力を強化し、問題を通じて考えられるようになりました

最高の迅速なエンジニアリング技術の最新の年次編集

Apr 10, 2025 am 11:22 AM

最高の迅速なエンジニアリング技術の最新の年次編集

Apr 10, 2025 am 11:22 AM

私のコラムに新しいかもしれない人のために、具体化されたAI、AI推論、AIのハイテクブレークスルー、AIの迅速なエンジニアリング、AIのトレーニング、AIのフィールディングなどのトピックなど、全面的なAIの最新の進歩を広く探求します。

SQLに列を追加する方法は? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQLに列を追加する方法は? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQLの変更テーブルステートメント:データベースに列を動的に追加する データ管理では、SQLの適応性が重要です。 その場でデータベース構造を調整する必要がありますか? Alter Tableステートメントはあなたの解決策です。このガイドの詳細は、コルを追加します