LLMS用の顔のテキスト生成推論ツールキットを抱き締める-AIのゲームチェンジャー

顔のテキスト生成推論(TGI)を抱き締める力を活用:あなたのローカルLLMサーバー

大規模な言語モデル(LLM)は、特にテキスト生成においてAIに革命をもたらしています。 これにより、LLMの展開を簡素化するために設計されたツールが急増しました。 Faceのテキスト生成の推論(TGI)を抱きしめることは際立っており、LLMをサービスとしてローカルに実行するための強力で制作可能なフレームワークを提供します。 このガイドでは、TGIの機能を調査し、洗練されたAIテキスト生成のためにそれを活用する方法を示しています。

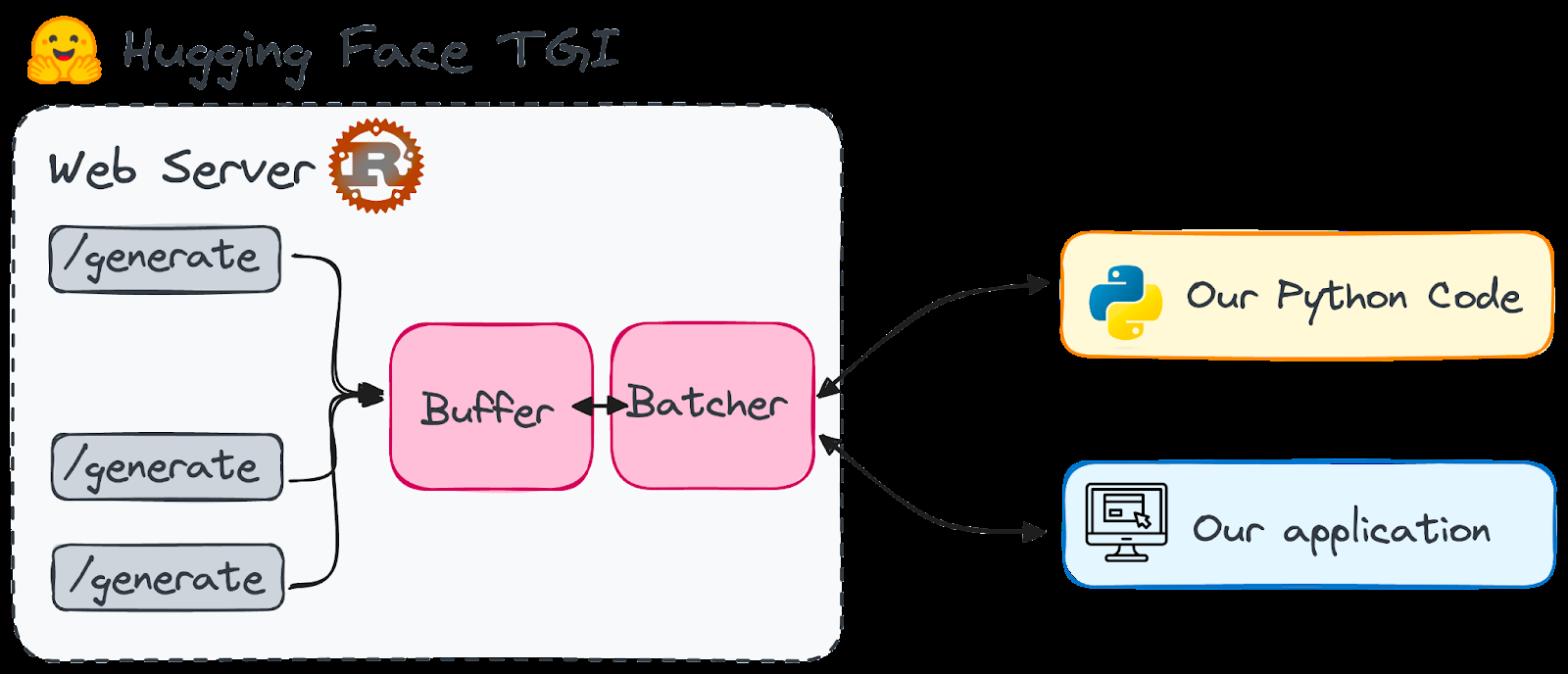

顔を抱きしめることを理解するtgiRustおよびPythonフレームワークであるTGIは、ローカルマシンでのLLMの展開とサービングを可能にします。 hfoilv1.0の下でライセンスされているため、補足ツールとして商業使用に適しています。 その重要な利点には、次のことが含まれます

- TGIは、スターコダー、ブルーム、GPT-Neox、Llama、T5などのモデルのテンソル並列性と動的バッチを使用してパフォーマンスを最適化します。

- 効率的なリソースの使用量:継続的なバッチと最適化コードは、複数のリクエストを同時に処理しながらリソース消費を最小限に抑えます。

- 柔軟性:透かし、バイアス制御のためのロジットワーピング、停止シーケンスなどの安全性とセキュリティ機能をサポートします。 TGIは、LLAMA、FALCON7B、MISTRALなどのLLMをより高速に実行するための最適化されたアーキテクチャを誇っています(完全なリストのドキュメントを参照)。

- なぜ抱きしめる顔tgi?を選ぶのか 顔は、オープンソースLLMSの中央のハブです。 以前は、多くのモデルがローカルで使用するにはリソースが集中しすぎており、クラウドサービスが必要でした。 ただし、QloraやGPTQの量子化などの進歩により、ローカルマシンでいくつかのLLMが管理可能になりました。 TGIは、LLMスタートアップ時間の問題を解決します。 モデルの準備を整えることで、即時の応答を提供し、長い待ち時間を排除します。 エンドポイントが一流の言語モデルの範囲に簡単にアクセスできることを想像してください。

ハグチャット

openAssistant

nat.dev

- TGIは現在、ARMベースのGPU Mac(M1以降)と互換性がありません。

- 顔を抱きしめるセットアップtgi

- 2つの方法が表示されます:ゼロからDockerの使用(簡単にするために推奨)。

方法1:ゼロから(より複雑)

- rust:

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | shのインストール

- Python仮想環境を作成:

conda create -n text-generation-inference python=3.9 && conda activate text-generation-inference - インストールprotoc(バージョン21.12の推奨):(

sudo)簡潔に省略された手順は、元のテキストを参照してください。 githubリポジトリをクローンします: -

git clone https://github.com/huggingface/text-generation-inference.git- をインストールします

cd text-generation-inference/ && BUILD_EXTENSIONS=False make install - をインストールします

の使用

Dockerがインストールされて実行されていることを確認してください- (互換性を最初にチェック)Dockerコマンドを実行します(Falcon-7Bを使用した例):

- 単一のgpuを使用している場合は を

- に置き換えます。

volume=$PWD/data && sudo docker run --gpus all --shm-size 1g -p 8080:80 -v $volume:/data ghcr.io/huggingface/text-generation-inference:0.9 --model-id tiiuae/falcon-7b-instruct --num-shard 1 --quantize bitsandbytesアプリケーションでTGIを使用する"all""0" TGIを起動した後、POSTリクエストを使用して

)を使用して対話します。 PythonとCurlを使用した例は、元のテキストに記載されています。

pythonライブラリ()は、相互作用を簡素化します 実用的なヒントとさらなる学習

トークン化、注意メカニズム、トランスアーキテクチャに精通してください。 モデルの最適化:/generate/streamtext-generationpip install text-generationLLMの基礎を理解する:- 適切なモデルの選択、トークナーのカスタマイズ、微調整など、モデルを準備して最適化する方法を学びます。

- 生成戦略:さまざまなテキスト生成戦略(貪欲な検索、ビーム検索、トップKサンプリング)を探索します。

- 結論 Face TGIのハグは、LLMをローカルに展開およびホストするユーザーフレンドリーな方法を提供し、データプライバシーやコスト制御などのメリットを提供します。強力なハードウェアを必要としますが、最近の進歩により多くのユーザーが実行可能にしています。 高度なLLMの概念とリソースのさらなる調査(元のテキストに記載)は、継続的な学習に強くお勧めします。

- rust:

以上がLLMS用の顔のテキスト生成推論ツールキットを抱き締める-AIのゲームチェンジャーの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1655

1655

14

14

1414

1414

52

52

1307

1307

25

25

1253

1253

29

29

1227

1227

24

24

Meta Llama 3.2を始めましょう - 分析Vidhya

Apr 11, 2025 pm 12:04 PM

Meta Llama 3.2を始めましょう - 分析Vidhya

Apr 11, 2025 pm 12:04 PM

メタのラマ3.2:マルチモーダルとモバイルAIの前進 メタは最近、ラマ3.2を発表しました。これは、モバイルデバイス向けに最適化された強力なビジョン機能と軽量テキストモデルを特徴とするAIの大幅な進歩です。 成功に基づいてo

10生成AIコーディング拡張機能とコードのコードを探る必要があります

Apr 13, 2025 am 01:14 AM

10生成AIコーディング拡張機能とコードのコードを探る必要があります

Apr 13, 2025 am 01:14 AM

ねえ、忍者をコーディング!その日はどのようなコーディング関連のタスクを計画していますか?このブログにさらに飛び込む前に、コーディング関連のすべての問題について考えてほしいです。 終わり? - &#8217を見てみましょう

AVバイト:Meta' s llama 3.2、GoogleのGemini 1.5など

Apr 11, 2025 pm 12:01 PM

AVバイト:Meta' s llama 3.2、GoogleのGemini 1.5など

Apr 11, 2025 pm 12:01 PM

今週のAIの風景:進歩、倫理的考慮、規制の議論の旋風。 Openai、Google、Meta、Microsoftのような主要なプレーヤーは、画期的な新しいモデルからLEの重要な変化まで、アップデートの急流を解き放ちました

従業員へのAI戦略の販売:Shopify CEOのマニフェスト

Apr 10, 2025 am 11:19 AM

従業員へのAI戦略の販売:Shopify CEOのマニフェスト

Apr 10, 2025 am 11:19 AM

Shopify CEOのTobiLütkeの最近のメモは、AIの能力がすべての従業員にとって基本的な期待であると大胆に宣言し、会社内の重大な文化的変化を示しています。 これはつかの間の傾向ではありません。これは、pに統合された新しい運用パラダイムです

ビジョン言語モデル(VLM)の包括的なガイド

Apr 12, 2025 am 11:58 AM

ビジョン言語モデル(VLM)の包括的なガイド

Apr 12, 2025 am 11:58 AM

導入 鮮やかな絵画や彫刻に囲まれたアートギャラリーを歩くことを想像してください。さて、各ピースに質問をして意味のある答えを得ることができたらどうでしょうか?あなたは尋ねるかもしれません、「あなたはどんな話を言っていますか?

GPT-4o vs Openai O1:新しいOpenaiモデルは誇大広告に値しますか?

Apr 13, 2025 am 10:18 AM

GPT-4o vs Openai O1:新しいOpenaiモデルは誇大広告に値しますか?

Apr 13, 2025 am 10:18 AM

導入 Openaiは、待望の「Strawberry」アーキテクチャに基づいて新しいモデルをリリースしました。 O1として知られるこの革新的なモデルは、推論能力を強化し、問題を通じて考えられるようになりました

SQLに列を追加する方法は? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQLに列を追加する方法は? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQLの変更テーブルステートメント:データベースに列を動的に追加する データ管理では、SQLの適応性が重要です。 その場でデータベース構造を調整する必要がありますか? Alter Tableステートメントはあなたの解決策です。このガイドの詳細は、コルを追加します

最高の迅速なエンジニアリング技術の最新の年次編集

Apr 10, 2025 am 11:22 AM

最高の迅速なエンジニアリング技術の最新の年次編集

Apr 10, 2025 am 11:22 AM

私のコラムに新しいかもしれない人のために、具体化されたAI、AI推論、AIのハイテクブレークスルー、AIの迅速なエンジニアリング、AIのトレーニング、AIのフィールディングなどのトピックなど、全面的なAIの最新の進歩を広く探求します。