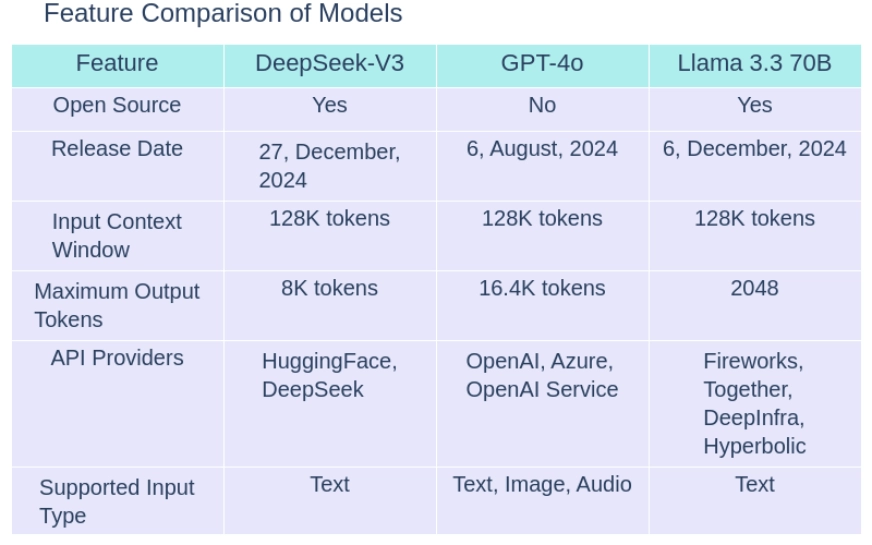

AI言語モデルの進化は、特にコーディングおよびプログラミングの状況で新しい標準を設定しています。充電をリードするのは、deepseek-v3、gpt-4o、およびllama 3.3 70bです。それぞれが独自の利点を提供します。このブログでは、AI言語モデルの比較を行い、GPT-4oのアーキテクチャ、パラメーター、コーディング機能、およびその2つの選択肢の実用的なケースに焦点を当てます。 DeepSeek-V3対GPT-4O対LlAMA 3.3 70Bの詳細な分析により、どのモデルがプログラミングタスクに最適か、これらの進歩が2025年にAIの未来をどのように形成しているかを明らかにします。 目次

-V3は、6710億パラメーターを備えたオープンソースの混合物(MOE)モデルであり、トークンあたり370億パラメーターをアクティブにします。最先端の負荷分散とマルチトークン予測方法を活用し、14.8兆トークンで訓練されています。複数のベンチマークにわたる最高層のパフォーマンスを実現するモデルは、わずか2.788百万H800 GPU時間のコストでトレーニング効率を維持しています。

DeepSeek-V3には、DeepSeek-R1 Liteの推論能力が組み込まれており、128Kコンテキストウィンドウを提供しています。さらに、テキスト、構造化されたデータ、複雑なマルチモーダル入力など、さまざまな入力タイプを処理でき、多様なユースケースに汎用性が高くなります。 また読む:deepseek-v3を使用したAIアプリケーションの構築 gpt-4o

GPT-4Oは、OpenAIが開発した高度な言語モデルで、最先端の建築改善を特徴としています。入力トークンの膨大なデータセットでトレーニングされているため、さまざまなタスクで非常に有能になり、印象的な正確さがあります。

このモデルはマルチモーダル入力をサポートし、推論能力を高め、多数のアプリケーションに汎用性を提供します。コンテキストウィンドウの128Kトークンを使用すると、リクエストごとに最大16,384個のトークンを生成し、1秒あたり約77.4トークンを処理できます。 2024年8月にリリースされたその知識は2023年10月まで延長され、市場で最も強力で適応性のあるモデルの1つになりました。

llama 3.3 70bllama3.3 70 b多言語大手言語モデル(LLM)は、700億パラメーターを備えたオープンソース、事前に訓練された命令チューニングされた生成モデルです。効率とスケーラビリティのために最適化されるように設計されています。 15兆以上のトークンで訓練された、幅広いタスクを処理するために最先端のテクニックを採用しています。 llama 3.3 70bは、最適化された変圧器アーキテクチャを使用する自動再帰言語モデルです。このモデルは、いくつかのベンチマークで顕著なパフォーマンスを実現し、最適化されたリソース割り当てでトレーニングコストを最小限に抑えます。

llama 3.3 70bは、幅広いコンテキストウィンドウをサポートし、微妙で正確なタスク処理のための高度な推論機能を組み込みます。テキストベースの入力を処理するように設計されていますが、構造化されたデータを処理することもでき、さまざまなアプリケーションで柔軟性を提供します。deepseek-v3 vs gpt-4o vs llama 3.3 70b:モデル評価

1。モデルの概要

| Benchmark | Description | DeepSeek-V3 | GPT-4o | Llama 3.3 70B |

| MMLU | Massive Multitask Language Understanding- Test knowledge across 57 subjects including maths, history, law and more | 88.5% | 88.7% | 88.5% |

| MMLU-Pro | A more robust MMLU benchmark with more complex reasoning focused questions and reduced prompt sensitivity | 75.9% | 74.68% | 75.9% |

| MMMU | Massive Multitask Multimodal Understanding: Text understanding across text, audio,images and videos | Not available | 69.1% | Not available |

| HellaSwag | A challenging sentence completion benchmark | 88.9% | Not available | Not available |

| HumanEval | Evaluates code generation and problem solving capabilities | 82.6% | 90.2% | 88.4% |

| MATH | Tests Mathematical problem solving abilities across various difficulty levels | 61.6% | 75.9% | 77% |

| GPQA | Test PhD-level knowledge in physics, chemistry and biology that require domain expertise | 59.1% | 53.6% | 50.5% |

| IFEval | Test model’s ability to accurately follow explicit formatting instructions, generate appropriate outputs and maintain consistent instructions | 86.1% | Not available | 92.1% |

ここで個々のベンチマークテストの結果を見つけることができます:

価格について言えば、GPT-4Oは、入力トークンと出力トークンのDeepSeek-V3に比べて約30倍高価です。一方、Llama 3.3 70bの指示は、入力トークンと出力トークンのDeepSeek-V3に比べて約1.5倍高価です。

DeepSeek-V3は、MMLU(大規模なマルチタスク言語の理解)やHumanval(コード生成)など、構造化されたタスク完了を必要とするベンチマークで優れています。ただし、数学(数学的な問題解決)などのベンチマークの課題に直面しており、そのパフォーマンスは競争力がありません。また、GPQA(一般化されたパッセージ質問応答)でリードし、このドメインの他のモデルを上回る。 gpt-4oは、HumanevalとMMLUで特にうまく機能し、さまざまなトピックで高品質の応答を生成する能力で際立っています。推論に基づいたタスクに輝いていますが、他のモデルのパフォーマンスが向上した数学やGPQAなどの専門分野で苦労しています。 llama 3.3 70bは、数学やイベールなどのベンチマークの強みを示しています(評価後の命令)。それは優れた問題解決能力を示し、他のモデルよりも複雑な指示をより効果的に追跡します。 HumanvalやGPQAなどの他のベンチマークでのパフォーマンスは、DeepSeek-V3やGPT-4Oよりも印象的ではありません。 deepseek-v3 vs gpt-4o vs llama 3.3 70b:コーディング機能

ここで、DeepSeek-V3、GPT-4O、およびLlama 3.3 70bのコード作成機能を比較します。そのために、3つのモデルすべてに同じプロンプトを提供し、以下のメトリックでの回答を評価します。

読みやすさ

応答

アレイを使用して多数の因子を計算する(手動で乗算を処理し、運用をキャリーするため)、Pythonの実装を次に示します。

生成されたコードの出力

による応答

これは、アレイを使用して数字を保存するために多数の要因を計算するPythonコードスニペットです。def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n < 0:

return "Factorial is not defined for negative numbers."

if n == 0 or n == 1:

return "1"

arr = [1] # Initialize the array with the first factorial value (1)

for x in range(2, n + 1):

arr = multiply(arr, x)

# The result is stored in reverse order in the array

return ''.join(map(str, reversed(arr)))

# Input a large number

try:

number = int(input("Enter a large number to calculate its factorial: "))

result = factorial_large_number_array(number)

print(f"The factorial of {number} is:\n{result}")

except ValueError:

print("Invalid input! Please enter a valid integer.")

Pythonの配列を使用して多数の因子係数を計算するには、結果を標準データ型の制限を超える非常に多数を処理するアレイ(またはリスト)に保存できます。実装する方法は次のとおりです 生成されたコードの出力

def multiply(x, res, res_size):

"""Multiplies x with the number represented by res[]"""

carry = 0

for i in range(res_size):

prod = res[i] * x + carry

res[i] = prod % 10

carry = prod // 10

while carry:

res.append(carry % 10)

carry = carry // 10

def factorial(n):

""" Calculates the factorial of a number n"""

res = [1]

res_size = 1

for i in range(2, n + 1):

multiply(i, res, res_size)

res_size = len(res)

return res

def print_factorial(n):

""" Prints the factorial of a number n"""

res = factorial(n)

print("Factorial of", n, "is:")

for digit in reversed(res):

print(digit, end="")

# Example usage:

n = 55

print_factorial(n)

比較結果

比較結果

DeepSeek-V3の応答は効率的できれいに構造化されていますが、堅牢なエラー処理と十分なドキュメントがありません。それは強い候補ですが、人々が簡単に従うか適応するのが明確に不足しています。

推奨事項:

この問題を解決するために、2ポインターアプローチを使用して、最大1文字で削除した後、文字列がパリンドロームになることができるかどうかを確認できます。これがPythonの実装<

生成されたコードの出力

応答 ここに、文字列が最大1文字で削除された後、文字列がパリンドロームになることができるかどうかをチェックするPythonソリューションです。

生成されたコードの出力def factorial(n):

# Initialize the result as a list with 1

result = [1]

# Multiply the result list with numbers from 2 to n

for x in range(2, n + 1):

carry = 0

# Multiply each digit in the result list with x

for i in range(len(result)):

product = result[i] * x + carry

result[i] = product % 10 # Store the last digit

carry = product // 10 # Carry over the remaining digits

# Add the remaining carry to the result list

while carry > 0:

result.append(carry % 10)

carry = carry // 10

# Reverse the result list to get the correct order

result.reverse()

return result

# Input: Number to find factorial of

n = int(input("Enter a number: "))

# Compute factorial

factorial_result = factorial(n)

# Convert the list of digits to a string for display

factorial_str = ''.join(map(str, factorial_result))

# Output the result

print(f"Factorial of {n} is: {factorial_str}") Deepseek-V3

Deepseek-V3

この問題を解決するには、最大1文字で削除することで文字列がパリンドロームになることができるかどうかを確認する必要があります。パリンドロームは、同じ前方と後方を読み取ります。これにアプローチする方法は次のとおりです 生成されたコードの出力

def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n < 0:

return "Factorial is not defined for negative numbers."

if n == 0 or n == 1:

return "1"

arr = [1] # Initialize the array with the first factorial value (1)

for x in range(2, n + 1):

arr = multiply(arr, x)

# The result is stored in reverse order in the array

return ''.join(map(str, reversed(arr)))

# Input a large number

try:

number = int(input("Enter a large number to calculate its factorial: "))

result = factorial_large_number_array(number)

print(f"The factorial of {number} is:\n{result}")

except ValueError:

print("Invalid input! Please enter a valid integer.")

比較洞察

比較洞察

Deepseek-V3の応答は、効率とシンプルさのバランスが整っていますが、ドキュメントでは不足しています。それは簡潔で迅速ですが、他の人がコードを簡単にフォローするのに十分な詳細がありません。そのアプローチは、時間とリソースが制限されているシナリオで有益ですが、コードの制作を可能にするために、より徹底的な説明とエラー処理が必要です。

推奨事項:

以上がdeepseek-v3 vs gpt-4o vs llama 3.3 70b:最高のAIモデルを見つけるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。