ThinkPHP开始

ThinkPHP入门

1,ThinkPHP是什么?

ThinkPHP是一个免费开源的,快速、简单的面向对象的轻量级PHP开发框架,是为了敏捷WEB应用开发和简化企业应用开发而诞生的(1)从thinkphp.cn官网下载文件包

(2)解压之后目录文件介绍:

2,如何使用ThinkPHP?

创建控制器,动作

创建 GoodsAction.class.php文件

在此文件中,GoodsAction类 继承自 Action类

访问的时候,通过在url上添加参数 m=Goods&a=show

其中url上的m参数表示:

m----module 模块的意思

ThinkPHP在处理的时候,将一个控制器认为是一个模块

a----表示控制器(模块)的方法pathInfo模式

这种携带url参数的形式不是很美观,

ThinkPHP提供了一种新的访问方式

叫做pathInfo模式,

例如上面的请求可以写成:

而且ThinkPHP默认的url模式就是pathInfo模式

模型处理数据

(1)先找到当前的项目使用哪个数据库,通过配置文件完成配置文件在项目的Conf目录中的conf.php 完成一个数组即可(可以参考系统的默认配置)

(2)利用框架提供的M()函数获得模型,参数为当前的表名(注意首字母大写)

然后调用模型的select()方法 获得当前表的所有记录,相当于 getAll()

视图层显示数据

直接调用当前控制器的display()方法即可完成模板的显示

默认的display()是可以不带参数的,会自动在模板目录找当前需要的模板文件

命名的时候:Tpl/模块/动作.html

模板引擎循

利用ThinkPHP内置的模板引擎中的foreach完成循环

也是标签语法

数据标签是花括号{$data}; 数组是通过 . 来访问,也可以使用 [] 来访问

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7739

7739

15

15

1643

1643

14

14

1397

1397

52

52

1290

1290

25

25

1233

1233

29

29

ワンクリックでPPTを生成!キミ: まずは「PPT出稼ぎ労働者」を普及させましょう

Aug 01, 2024 pm 03:28 PM

ワンクリックでPPTを生成!キミ: まずは「PPT出稼ぎ労働者」を普及させましょう

Aug 01, 2024 pm 03:28 PM

キミ: たった 1 文の PPT がわずか 10 秒で完成します。 PPTはとても面倒です!会議を開催するには PPT が必要であり、週次報告書を作成するには PPT が必要であり、投資を勧誘するには PPT を提示する必要があり、不正行為を告発するには PPT を送信する必要があります。大学は、PPT 専攻を勉強するようなものです。授業中に PPT を見て、授業後に PPT を行います。おそらく、デニス オースティンが 37 年前に PPT を発明したとき、PPT がこれほど普及する日が来るとは予想していなかったでしょう。 PPT 作成の大変な経験を話すと涙が出ます。 「20 ページを超える PPT を作成するのに 3 か月かかり、何十回も修正しました。PPT を見ると吐きそうになりました。」 「ピーク時には 1 日に 5 枚の PPT を作成し、息をすることさえありました。」 PPTでした。」 即席の会議をするなら、そうすべきです

thinkphp にはいくつかのバージョンがあります

Apr 09, 2024 pm 06:09 PM

thinkphp にはいくつかのバージョンがあります

Apr 09, 2024 pm 06:09 PM

ThinkPHP には、さまざまな PHP バージョン向けに設計された複数のバージョンがあります。メジャー バージョンには 3.2、5.0、5.1、および 6.0 が含まれますが、マイナー バージョンはバグを修正し、新機能を提供するために使用されます。最新の安定バージョンは ThinkPHP 6.0.16 です。バージョンを選択するときは、PHP バージョン、機能要件、コミュニティ サポートを考慮してください。最高のパフォーマンスとサポートを得るには、最新の安定バージョンを使用することをお勧めします。

CVPR 2024 のすべての賞が発表されました!オフラインでのカンファレンスには1万人近くが参加し、Googleの中国人研究者が最優秀論文賞を受賞した

Jun 20, 2024 pm 05:43 PM

CVPR 2024 のすべての賞が発表されました!オフラインでのカンファレンスには1万人近くが参加し、Googleの中国人研究者が最優秀論文賞を受賞した

Jun 20, 2024 pm 05:43 PM

北京時間6月20日早朝、シアトルで開催されている最高の国際コンピュータビジョンカンファレンス「CVPR2024」が、最優秀論文やその他の賞を正式に発表した。今年は、最優秀論文 2 件と学生優秀論文 2 件を含む合計 10 件の論文が賞を受賞しました。また、最優秀論文ノミネートも 2 件、学生優秀論文ノミネートも 4 件ありました。コンピュータービジョン (CV) 分野のトップカンファレンスは CVPR で、毎年多数の研究機関や大学が集まります。統計によると、今年は合計 11,532 件の論文が投稿され、2,719 件が採択され、採択率は 23.6% でした。ジョージア工科大学による CVPR2024 データの統計分析によると、研究テーマの観点から最も論文数が多いのは画像とビデオの合成と生成です (Imageandvideosyn

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

FP8 以下の浮動小数点数値化精度は、もはや H100 の「特許」ではありません。 Lao Huang は誰もが INT8/INT4 を使用できるようにしたいと考え、Microsoft DeepSpeed チームは NVIDIA からの公式サポートなしで A100 上で FP6 の実行を開始しました。テスト結果は、A100 での新しい方式 TC-FPx の FP6 量子化が INT4 に近いか、場合によってはそれよりも高速であり、後者よりも精度が高いことを示しています。これに加えて、エンドツーエンドの大規模モデルのサポートもあり、オープンソース化され、DeepSpeed などの深層学習推論フレームワークに統合されています。この結果は、大規模モデルの高速化にも即座に影響します。このフレームワークでは、シングル カードを使用して Llama を実行すると、スループットはデュアル カードのスループットの 2.65 倍になります。 1つ

ベアメタルから 700 億のパラメータを備えた大規模モデルまで、チュートリアルとすぐに使えるスクリプトがここにあります

Jul 24, 2024 pm 08:13 PM

ベアメタルから 700 億のパラメータを備えた大規模モデルまで、チュートリアルとすぐに使えるスクリプトがここにあります

Jul 24, 2024 pm 08:13 PM

LLM が大量のデータを使用して大規模なコンピューター クラスターでトレーニングされていることはわかっています。このサイトでは、LLM トレーニング プロセスを支援および改善するために使用される多くの方法とテクノロジが紹介されています。今日、私たちが共有したいのは、基礎となるテクノロジーを深く掘り下げ、オペレーティング システムさえ持たない大量の「ベア メタル」を LLM のトレーニング用のコンピューター クラスターに変える方法を紹介する記事です。この記事は、機械がどのように考えるかを理解することで一般的な知能の実現に努めている AI スタートアップ企業 Imbue によるものです。もちろん、オペレーティング システムを持たない大量の「ベア メタル」を LLM をトレーニングするためのコンピューター クラスターに変換することは、探索と試行錯誤に満ちた簡単なプロセスではありませんが、Imbue は最終的に 700 億のパラメータを備えた LLM のトレーニングに成功しました。プロセスが蓄積する

AIの活用 | AIが一人暮らしの女の子の生活ビデオブログを作成、3日間で数万件の「いいね!」を獲得

Aug 07, 2024 pm 10:53 PM

AIの活用 | AIが一人暮らしの女の子の生活ビデオブログを作成、3日間で数万件の「いいね!」を獲得

Aug 07, 2024 pm 10:53 PM

Machine Power Report 編集者: Yang Wen 大型モデルや AIGC に代表される人工知能の波は、私たちの生活や働き方を静かに変えていますが、ほとんどの人はまだその使い方を知りません。そこで、直感的で興味深く、簡潔な人工知能のユースケースを通じてAIの活用方法を詳しく紹介し、皆様の思考を刺激するコラム「AI in Use」を立ち上げました。また、読者が革新的な実践的な使用例を提出することも歓迎します。ビデオリンク: https://mp.weixin.qq.com/s/2hX_i7li3RqdE4u016yGhQ 最近、Xiaohongshu で一人暮らしの女の子の生活 vlog が人気になりました。イラスト風のアニメーションといくつかの癒しの言葉を組み合わせれば、数日で簡単に習得できます。

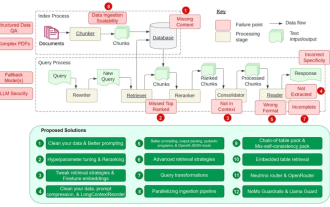

RAG の 12 の問題点を数え上げ、NVIDIA シニア アーキテクトが解決策を教える

Jul 11, 2024 pm 01:53 PM

RAG の 12 の問題点を数え上げ、NVIDIA シニア アーキテクトが解決策を教える

Jul 11, 2024 pm 01:53 PM

検索拡張生成 (RAG) は、検索を使用して言語モデルを強化する手法です。具体的には、言語モデルは回答を生成する前に、広範な文書データベースから関連情報を取得し、この情報を使用して生成プロセスをガイドします。このテクノロジーにより、コンテンツの精度と関連性が大幅に向上し、幻覚の問題を効果的に軽減し、知識の更新速度が向上し、コンテンツ生成の追跡可能性が向上します。 RAG は間違いなく、人工知能研究の中で最もエキサイティングな分野の 1 つです。 RAGについて詳しくは、当サイトのコラム記事「大型モデルの欠点を補うことに特化したRAGの新展開とは?」を参照してください。このレビューはそれを明確に説明しています。」しかし、RAG は完璧ではなく、ユーザーはそれを使用するときにいくつかの「問題点」に遭遇することがよくあります。最近、NVIDIA の生成 AI 高度なソリューション

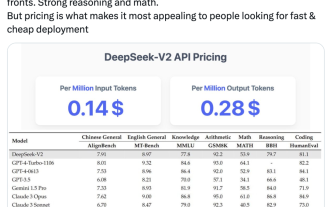

国内のオープンソース MoE 指標が爆発的に増加: GPT-4 レベルの機能、API 価格はわずか 1%

May 07, 2024 pm 05:34 PM

国内のオープンソース MoE 指標が爆発的に増加: GPT-4 レベルの機能、API 価格はわずか 1%

May 07, 2024 pm 05:34 PM

最新の国内大規模オープンソース MoE モデルは、デビュー直後から人気を集めています。 DeepSeek-V2 のパフォーマンスは GPT-4 レベルに達しますが、オープンソースで商用利用は無料で、API 価格は GPT-4-Turbo のわずか 1% です。そのため、公開されるとすぐに大きな話題を呼びました。公開されているパフォーマンス指標から判断すると、DeepSeekV2 の包括的な中国語機能は多くのオープンソース モデルの機能を上回っています。同時に、GPT-4Turbo や Wenkuai 4.0 などのクローズド ソース モデルも第一段階にあります。総合的な英語力もLLaMA3-70Bと同じ第一段階にあり、同じくMoEであるMixtral8x22Bを上回っています。また、知識、数学、推論、プログラミングなどでも優れたパフォーマンスを示します。 128K コンテキストをサポートします。これをイメージしてください