Python クローラーを最初から作成する - Scrapy フレームワークを使用してクローラーを作成する

Web クローラーは、インターネット上のデータをクロールするプログラムで、特定の Web ページの HTML データをクロールするために使用できます。クローラープログラムの開発にはいくつかのライブラリを使用しますが、フレームワークを使用することで大幅に効率が向上し、開発期間を短縮できます。 Scrapy は Python で書かれており、軽量でシンプルで使いやすいです。 Scrapy を使用すると、自分で開発するために多大な労力を費やすことなく、オンライン データの収集を簡単に完了できます。

まず最初に、質問に答える必要があります。

Q: Web サイトをクローラーにインストールするには何ステップかかりますか?

答えは非常に簡単で、4つのステップです:

新しいプロジェクト(プロジェクト): 新しいクローラープロジェクトを作成します

ターゲットのクリア(アイテム): クロールしたい目標を明確にします

スパイダーの作成(スパイダー): クローラーを作成してクロールを開始しますWeb ページ

ストレージ コンテンツ (パイプライン): クロールされたコンテンツを保存するパイプラインを設計します

さて、基本的なプロセスが決定したので、ステップごとに完了させてください。

1. 新しいプロジェクト (プロジェクト) を作成します

Shift キーを押しながら空のディレクトリを右クリックし、「ここでコマンド ウィンドウを開く」を選択し、次のコマンドを入力します:

scrapy startproject tutorial

ここで、tutorial はプロジェクト名です。

次のようなディレクトリ構造でチュートリアル フォルダーが作成されることがわかります:

tutorial/

scrapy.cfg

tutorial/

__init__.py

items.py

pipelines.py

settings.py

spiders/

__init__.py

...以下は各ファイルの役割を簡単に紹介します:

scrapy.cfg: プロジェクトの構成ファイル

tutorial/: プロジェクトのPython モジュール。ここで引用したコード

tutorial/items.py: プロジェクトの項目ファイル

tutorial/pipelines.py: プロジェクトのパイプライン ファイル

tutorial/settings.py: プロジェクトの設定ファイル

tutorial/spiders/:クローラーが保存されているディレクトリ

2. ターゲット (アイテム) をクリアします

Scrapy では、アイテムはクロールされたコンテンツをロードするために使用されるコンテナーであり、辞書である Python の Dic に似ていますが、エラーを減らすために追加の保護が提供されます。

一般的に言えば、アイテムはscrapy.item.Itemクラスを使用して作成でき、プロパティはscrapy.item.Fieldオブジェクト(ORMと同様のマッピング関係として理解できます)を使用して定義できます。

次に、アイテムモデルの構築を開始します。

まず第一に、必要なコンテンツは次のとおりです:

Name (名前)

Link (URL)

Description (説明)

チュートリアル ディレクトリ内の items.py ファイルを変更し、元のクラスの後に独自のクラスを追加します。

dmoz.org Web サイトのコンテンツをキャプチャしたいので、DmozItem という名前を付けることができます:

# Define here the models for your scraped items

#

# See documentation in:

# http://doc.scrapy.org/en/latest/topics/items.html

from scrapy.item import Item, Field

class TutorialItem(Item):

# define the fields for your item here like:

# name = Field()

pass

class DmozItem(Item):

title = Field()

link = Field()

desc = Field() 最初は少し混乱するように思えるかもしれませんが、これらの項目を定義すると、他のコンポーネントを使用するときに項目を正確に把握できるようになります。それ。

Item は、単純にカプセル化されたクラス オブジェクトとして理解できます。

3. クローラー (スパイダー) を作成します

クローラーの作成は、通常、最初にクロールし、次にフェッチする 2 つのステップに分かれています。

つまり、まず Web ページ全体のすべてのコンテンツを取得し、次に役立つ部分を取り出す必要があります。

3.1 クロール

Spider は、ドメイン (またはドメイン グループ) から情報をクロールするためにユーザーが作成したクラスです。

ダウンロード用の URL のリスト、リンクを追跡するスキーム、Web コンテンツを解析してアイテムを抽出する方法を定義します。

Spider を作成するには、scrapy.spider.BaseSpider でサブクラスを作成し、次の 3 つの必須属性を決定する必要があります。

name: クローラーの識別名。これは一意である必要があります。異なるクローラー名で異なる名前を定義する必要があります。

start_urls: クロールされた URL のリスト。クローラーはここからデータの取得を開始するため、データの最初のダウンロードはこれらの URL から開始されます。他のサブ URL は、これらの開始 URL から継承して生成されます。

parse(): 解析メソッド。呼び出し時に、各 URL から返された Response オブジェクトを唯一のパラメータとして渡します。これは、キャプチャされたデータの解析と照合 (項目への解析)、およびさらに多くの URL の追跡を行います。

ここでは、幅クローラーのチュートリアルで説明されているアイデアを参照して理解することができます。チュートリアルの配信: [Java] Zhihu Chin エピソード 5: HttpClient ツールキットと幅クローラーの使用。

つまり、URL を保存し、それを出発点として徐々に拡散し、条件を満たす Web ページの URL をすべて取得して保存し、クロールを続けます。

dmoz_spider.py という名前の最初のクローラーを作成し、tutorialspiders ディレクトリに保存しましょう。

dmoz_spider.py コードは次のとおりです。

from scrapy.spider import Spider

class DmozSpider(Spider):

name = "dmoz"

allowed_domains = ["dmoz.org"]

start_urls = [

"http://www.dmoz.org/Computers/Programming/Languages/Python/Books/",

"http://www.dmoz.org/Computers/Programming/Languages/Python/Resources/"

]

def parse(self, response):

filename = response.url.split("/")[-2]

open(filename, 'wb').write(response.body)allow_domains は、クローラーの制約領域である検索のドメイン名範囲であり、クローラーがこのドメイン名の Web ページのみをクロールすることを規定します。

parse関数からわかるように、リンクの最後の2つのアドレスが取り出され、ファイル名として保存されます。

それから実行して見てください。Shift キーを押しながらチュートリアル ディレクトリを右クリックし、コマンド ウィンドウを開き、次のように入力します。

scrapy crawl dmoz

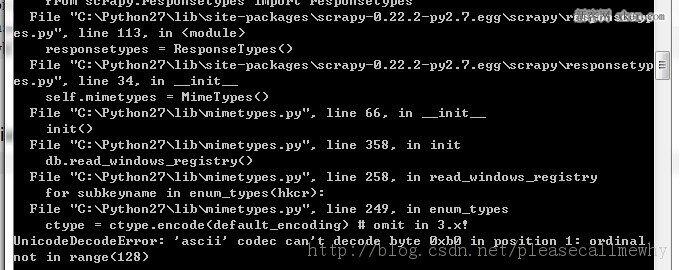

実行結果は図に示すとおりです。

エラーは次のとおりです。報告されました:

UnicodeDecodeError: 'ascii' codec can't decode byte 0xb0 in Position 1: ordinal not in range(128)

最初の Scrapy プロジェクトを実行したときにエラーが発生しました。

コーディングの問題があるはずです。グーグルで解決策を見つけました:

Python の Libsite-packages フォルダーの下に新しい sitecustomize.py を作成します:

import sys sys.setdefaultencoding('gb2312')

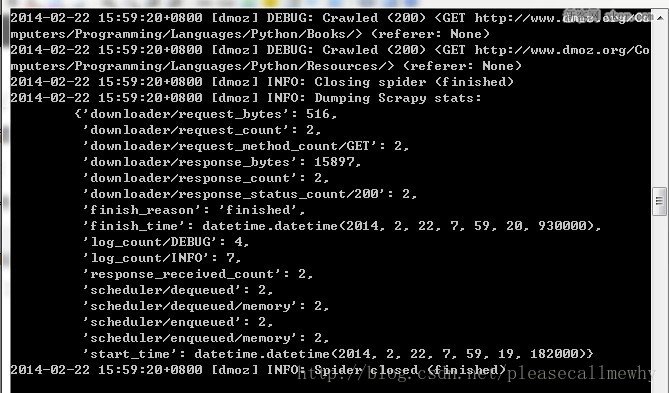

もう一度実行します。OK、問題は解決しました。結果:

最后一句INFO: Closing spider (finished)表明爬虫已经成功运行并且自行关闭了。

包含 [dmoz]的行 ,那对应着我们的爬虫运行的结果。

可以看到start_urls中定义的每个URL都有日志行。

还记得我们的start_urls吗?

http://www.dmoz.org/Computers/Programming/Languages/Python/Books

http://www.dmoz.org/Computers/Programming/Languages/Python/Resources

因为这些URL是起始页面,所以他们没有引用(referrers),所以在它们的每行末尾你会看到 (referer:

在parse 方法的作用下,两个文件被创建:分别是 Books 和 Resources,这两个文件中有URL的页面内容。

那么在刚刚的电闪雷鸣之中到底发生了什么呢?

首先,Scrapy为爬虫的 start_urls属性中的每个URL创建了一个 scrapy.http.Request 对象 ,并将爬虫的parse 方法指定为回调函数。

然后,这些 Request被调度并执行,之后通过parse()方法返回scrapy.http.Response对象,并反馈给爬虫。

3.2取

爬取整个网页完毕,接下来的就是的取过程了。

光存储一整个网页还是不够用的。

在基础的爬虫里,这一步可以用正则表达式来抓。

在Scrapy里,使用一种叫做 XPath selectors的机制,它基于 XPath表达式。

如果你想了解更多selectors和其他机制你可以查阅资料:点我点我

这是一些XPath表达式的例子和他们的含义

/html/head/title: 选择HTML文档

当然title这个标签对我们来说没有太多的价值,下面我们就来真正抓取一些有意义的东西。

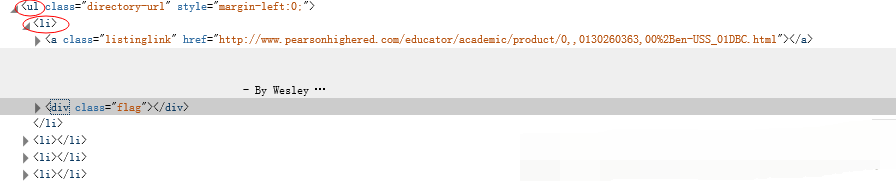

使用火狐的审查元素我们可以清楚地看到,我们需要的东西如下:

我们可以用如下代码来抓取这个

sel.xpath('//ul/li')

从

sel.xpath('//ul/li/text()').extract()

可以这样获取网站的标题:

sel.xpath('//ul/li/a/text()').extract()

从

sel.xpath('//ul/li/text()').extract()

可以这样获取网站的标题:

sel.xpath('//ul/li/a/text()').extract()

可以这样获取网站的超链接:

sel.xpath('//ul/li/a/@href').extract()

当然,前面的这些例子是直接获取属性的方法。

我们注意到xpath返回了一个对象列表,

那么我们也可以直接调用这个列表中对象的属性挖掘更深的节点

(参考:Nesting selectors andWorking with relative XPaths in the Selectors):

sites = sel.xpath('//ul/li')

for site in sites:

title = site.xpath('a/text()').extract()

link = site.xpath('a/@href').extract()

desc = site.xpath('text()').extract()

print title, link, desc

3.4xpath实战

我们用shell做了这么久的实战,最后我们可以把前面学习到的内容应用到dmoz_spider这个爬虫中。

在原爬虫的parse函数中做如下修改:

from scrapy.spider import Spider

from scrapy.selector import Selector

class DmozSpider(Spider):

name = "dmoz"

allowed_domains = ["dmoz.org"]

start_urls = [

"http://www.dmoz.org/Computers/Programming/Languages/Python/Books/",

"http://www.dmoz.org/Computers/Programming/Languages/Python/Resources/"

]

def parse(self, response):

sel = Selector(response)

sites = sel.xpath('//ul/li')

for site in sites:

title = site.xpath('a/text()').extract()

link = site.xpath('a/@href').extract()

desc = site.xpath('text()').extract()

print title注意,我们从scrapy.selector中导入了Selector类,并且实例化了一个新的Selector对象。这样我们就可以像Shell中一样操作xpath了。

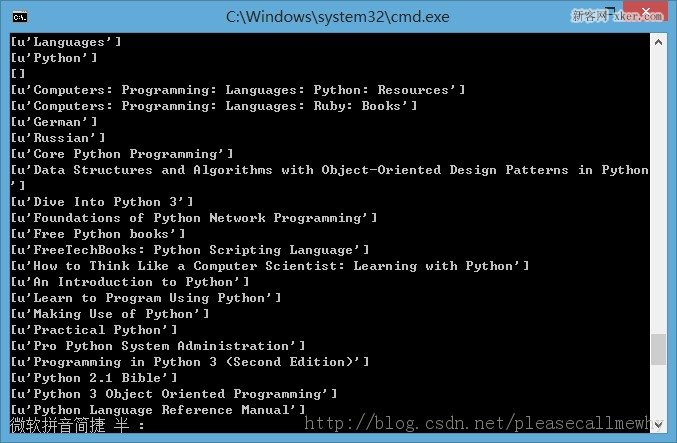

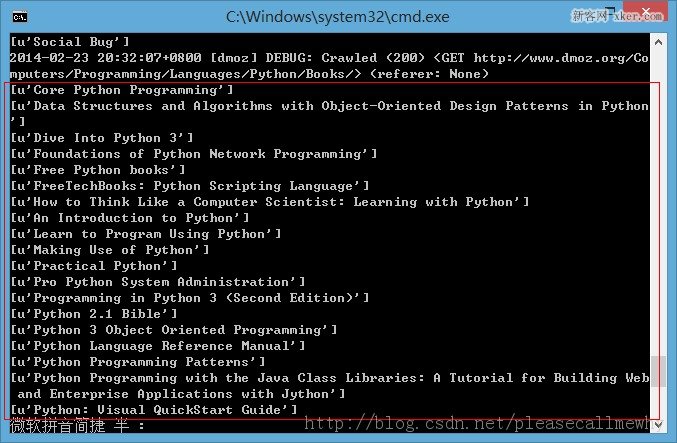

我们来试着输入一下命令运行爬虫(在tutorial根目录里面):

scrapy crawl dmoz

运行结果如下:

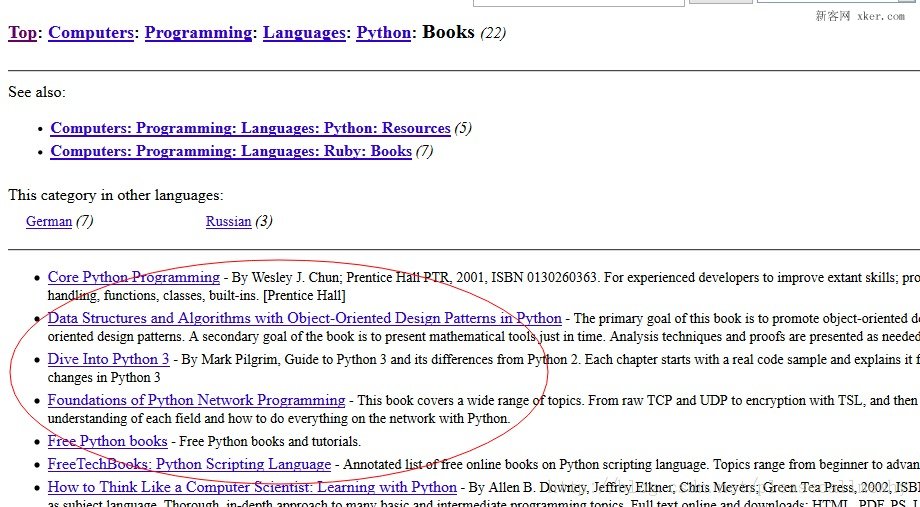

果然,成功的抓到了所有的标题。但是好像不太对啊,怎么Top,Python这种导航栏也抓取出来了呢?

我们只需要红圈中的内容:

看来是我们的xpath语句有点问题,没有仅仅把我们需要的项目名称抓取出来,也抓了一些无辜的但是xpath语法相同的元素。

审查元素我们发现我们需要的

- 具有class='directory-url'的属性,

那么只要把xpath语句改成sel.xpath('//ul[@class="directory-url"]/li')即可

将xpath语句做如下调整:

from scrapy.spider import Spider

from scrapy.selector import Selector

class DmozSpider(Spider):

name = "dmoz"

allowed_domains = ["dmoz.org"]

start_urls = [

"http://www.dmoz.org/Computers/Programming/Languages/Python/Books/",

"http://www.dmoz.org/Computers/Programming/Languages/Python/Resources/"

]

def parse(self, response):

sel = Selector(response)

sites = sel.xpath('//ul[@class="directory-url"]/li')

for site in sites:

title = site.xpath('a/text()').extract()

link = site.xpath('a/@href').extract()

desc = site.xpath('text()').extract()

print title成功抓出了所有的标题,绝对没有滥杀无辜:

3.5使用Item

接下来我们来看一看如何使用Item。

前面我们说过,Item 对象是自定义的python字典,可以使用标准字典语法获取某个属性的值:

>>> item = DmozItem() >>> item['title'] = 'Example title' >>> item['title'] 'Example title'

作为一只爬虫,Spiders希望能将其抓取的数据存放到Item对象中。为了返回我们抓取数据,spider的最终代码应当是这样:

from scrapy.spider import Spider

from scrapy.selector import Selector

from tutorial.items import DmozItem

class DmozSpider(Spider):

name = "dmoz"

allowed_domains = ["dmoz.org"]

start_urls = [

"http://www.dmoz.org/Computers/Programming/Languages/Python/Books/",

"http://www.dmoz.org/Computers/Programming/Languages/Python/Resources/"

]

def parse(self, response):

sel = Selector(response)

sites = sel.xpath('//ul[@class="directory-url"]/li')

items = []

for site in sites:

item = DmozItem()

item['title'] = site.xpath('a/text()').extract()

item['link'] = site.xpath('a/@href').extract()

item['desc'] = site.xpath('text()').extract()

items.append(item)

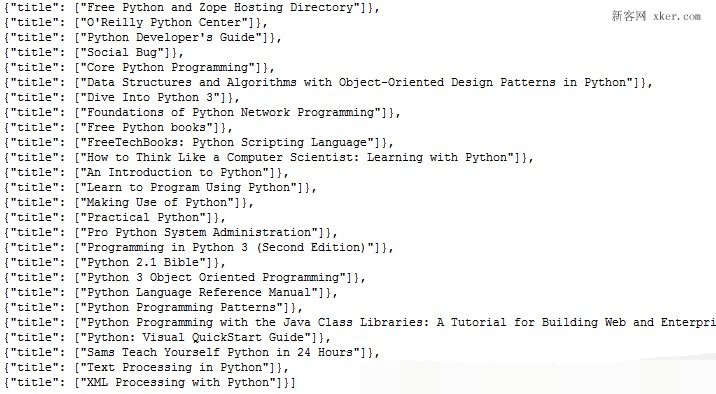

return items4.存储内容(Pipeline)

保存信息的最简单的方法是通过Feed exports,主要有四种:JSON,JSON lines,CSV,XML。

我们将结果用最常用的JSON导出,命令如下:

scrapy crawl dmoz -o items.json -t json

-o 后面是导出文件名,-t 后面是导出类型。

然后来看一下导出的结果,用文本编辑器打开json文件即可(为了方便显示,在item中删去了除了title之外的属性):

因为这个只是一个小型的例子,所以这样简单的处理就可以了。

如果你想用抓取的items做更复杂的事情,你可以写一个 Item Pipeline(条目管道)。

这个我们以后再慢慢玩^_^

以上便是python爬虫框架Scrapy制作爬虫抓取网站内容的全部过程了,非常的详尽吧,希望能够对大家有所帮助,有需要的话也可以和我联系,一起进步

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7318

7318

9

9

1625

1625

14

14

1349

1349

46

46

1261

1261

25

25

1209

1209

29

29

Pythonを使用してテキストファイルのZIPF配布を見つける方法

Mar 05, 2025 am 09:58 AM

Pythonを使用してテキストファイルのZIPF配布を見つける方法

Mar 05, 2025 am 09:58 AM

このチュートリアルでは、Pythonを使用してZIPFの法則の統計的概念を処理する方法を示し、法律の処理時にPythonの読み取りおよび並べ替えの効率性を示します。 ZIPF分布という用語が何を意味するのか疑問に思うかもしれません。この用語を理解するには、まずZIPFの法律を定義する必要があります。心配しないでください、私は指示を簡素化しようとします。 ZIPFの法則 ZIPFの法則は単に意味します。大きな自然言語のコーパスでは、最も頻繁に発生する単語は、2番目の頻繁な単語のほぼ2倍の頻度で表示されます。 例を見てみましょう。アメリカ英語の茶色のコーパスを見ると、最も頻繁な言葉は「thであることに気付くでしょう。

HTMLを解析するために美しいスープを使用するにはどうすればよいですか?

Mar 10, 2025 pm 06:54 PM

HTMLを解析するために美しいスープを使用するにはどうすればよいですか?

Mar 10, 2025 pm 06:54 PM

この記事では、Pythonライブラリである美しいスープを使用してHTMLを解析する方法について説明します。 find()、find_all()、select()、およびget_text()などの一般的な方法は、データ抽出、多様なHTML構造とエラーの処理、および代替案(SEL

Pythonでの画像フィルタリング

Mar 03, 2025 am 09:44 AM

Pythonでの画像フィルタリング

Mar 03, 2025 am 09:44 AM

ノイズの多い画像を扱うことは、特に携帯電話や低解像度のカメラの写真でよくある問題です。 このチュートリアルでは、OpenCVを使用してPythonの画像フィルタリング手法を調査して、この問題に取り組みます。 画像フィルタリング:強力なツール 画像フィルター

Pythonでファイルをダウンロードする方法

Mar 01, 2025 am 10:03 AM

Pythonでファイルをダウンロードする方法

Mar 01, 2025 am 10:03 AM

Pythonは、インターネットからファイルをダウンロードするさまざまな方法を提供します。これは、urllibパッケージまたはリクエストライブラリを使用してHTTPを介してダウンロードできます。このチュートリアルでは、これらのライブラリを使用してPythonからURLからファイルをダウンロードする方法を説明します。 ライブラリをリクエストします リクエストは、Pythonで最も人気のあるライブラリの1つです。クエリ文字列をURLに手動で追加したり、POSTデータのエンコードをフォームに追加せずに、HTTP/1.1リクエストを送信できます。 リクエストライブラリは、以下を含む多くの機能を実行できます フォームデータを追加します マルチパートファイルを追加します Python応答データにアクセスします リクエストを行います 頭

Pythonを使用してPDFドキュメントの操作方法

Mar 02, 2025 am 09:54 AM

Pythonを使用してPDFドキュメントの操作方法

Mar 02, 2025 am 09:54 AM

PDFファイルは、クロスプラットフォームの互換性に人気があり、オペレーティングシステム、読み取りデバイス、ソフトウェア間でコンテンツとレイアウトが一貫しています。ただし、Python Plansing Plain Text Filesとは異なり、PDFファイルは、より複雑な構造を持つバイナリファイルであり、フォント、色、画像などの要素を含んでいます。 幸いなことに、Pythonの外部モジュールでPDFファイルを処理することは難しくありません。この記事では、PYPDF2モジュールを使用して、PDFファイルを開き、ページを印刷し、テキストを抽出する方法を示します。 PDFファイルの作成と編集については、私からの別のチュートリアルを参照してください。 準備 コアは、外部モジュールPYPDF2を使用することにあります。まず、PIPを使用してインストールします。 ピップはpです

DjangoアプリケーションでRedisを使用してキャッシュする方法

Mar 02, 2025 am 10:10 AM

DjangoアプリケーションでRedisを使用してキャッシュする方法

Mar 02, 2025 am 10:10 AM

このチュートリアルでは、Redisキャッシングを活用して、特にDjangoフレームワーク内でPythonアプリケーションのパフォーマンスを向上させる方法を示しています。 Redisのインストール、Django構成、およびパフォーマンスの比較をカバーして、Beneを強調します

Natural Language Toolkit(NLTK)の紹介

Mar 01, 2025 am 10:05 AM

Natural Language Toolkit(NLTK)の紹介

Mar 01, 2025 am 10:05 AM

自然言語処理(NLP)は、人間の言語の自動または半自動処理です。 NLPは言語学と密接に関連しており、認知科学、心理学、生理学、数学の研究とのリンクがあります。コンピューターサイエンスで

TensorflowまたはPytorchで深い学習を実行する方法は?

Mar 10, 2025 pm 06:52 PM

TensorflowまたはPytorchで深い学習を実行する方法は?

Mar 10, 2025 pm 06:52 PM

この記事では、深い学習のためにTensorflowとPytorchを比較しています。 関連する手順、データの準備、モデルの構築、トレーニング、評価、展開について詳しく説明しています。 特に計算グラップに関して、フレームワーク間の重要な違い