KNN アルゴリズムの詳細な紹介

KNN アルゴリズムの正式名は k-Nearest Neighbor で、K 最近傍という意味です。

アルゴリズムの説明

KNN は分類アルゴリズムです。その基本的な考え方は、異なる特徴値間の距離を測定することで分類することです。

アルゴリズムのプロセスは次のとおりです:

1. サンプル データ セットを準備します (サンプル内の各データは分類されており、分類ラベルが付いています)。

3. テスト データを入力します。

4. A とサンプルセット内の各データ間の距離を計算します。

6. A からの距離が最も小さい k 点を選択します。最初の k 点の頻度

8. 最初の k 点の最も高い頻度を持つカテゴリを A の予測分類として返します。

主な要因

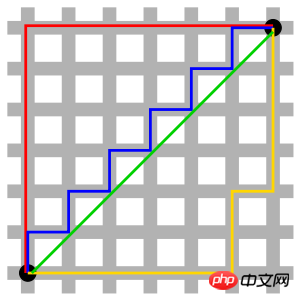

写真の赤い線はマンハッタン距離を表し、緑は直線距離であるユークリッド距離を表し、青と黄色は等価なマンハッタン距離を表します。 マンハッタン距離 - 2 点間の南北方向の距離に東西方向の距離を加えたもの、つまり d(i, j) = |xi-xj|+|yi-yj|。

グリッド内の距離を計算する問題に使用されます。

p=1 の場合、それはマンハッタン距離です。

p=2 の場合、それはユークリッド距離です。 p→∞の場合、それはチェビシェフ距離です。

5. 標準化ユークリッド距離 (標準化ユークリッド距離)

情報コーディング (耐障害性を高めるために、コード間の最小ハミング距離をできるだけ大きくする必要があります)。

9. 夾角の余弦 (コサイン)

Jaccard 類似性係数は、サンプルの類似性を測定するために使用できます。

11. ピアソン相関係数

ピアソン相関係数は、ピアソン積率相関係数とも呼ばれ、線形相関係数です。 ピアソン相関係数は、2 つの変数間の線形相関の程度を反映するために使用される統計です。

高次元が距離測定に及ぼす影響:

変数が増えると、ユークリッド距離の識別能力が低下します。

距離に対する変数の値の範囲の影響:

より大きな値の範囲を持つ変数は距離の計算において支配的な役割を果たすことが多いため、最初に変数を標準化する必要があります。

k

k のサイズが小さすぎると、分類結果がノイズ ポイントの影響を受けやすくなり、誤差が増加します。

k が大きすぎると、最近傍に他のカテゴリのポイントが多すぎる可能性があります (重み付け)。距離が k 値を減らす可能性があります)

k=N (サンプル数) の影響は、現時点では入力インスタンスが何であっても、最も多くの値を持つクラスに属すると単純に予測されるため、まったく望ましくありません。トレーニング インスタンスのモデルが単純すぎるため、トレーニング サンプル内の多くの有用な情報が無視されます。

実際のアプリケーションでは、K 値は通常、最適な値を選択するために交差検証法 (簡単に言えば、一部のサンプルをトレーニング セットとして使用し、一部のサンプルをテスト セットとして使用する) を使用するなど、比較的小さな値をとります。 K値。

経験則: k は通常、トレーニング サンプル数の平方根よりも小さくなります。

メリットとデメリット

1. メリット

シンプルで理解しやすく、実装が簡単で、精度が高く、外れ値に敏感ではありません。

2. 欠点

KNN は、モデルの構築が非常に簡単ですが、すべてのトレーニング サンプルを分類する必要があるため、システムのオーバーヘッドが大きくなります (大量の計算と大きなメモリ オーバーヘッド)。スキャンされ、距離が計算されます。

適用範囲

数値型と公称型(有限個の異なる値を持ち、その値が乱れているもの)。

顧客離れの予測、不正行為の検出など。

アルゴリズムの実装

ここでは、例として Python を使用して、ユークリッド距離に基づく KNN アルゴリズムの実装を説明します。

ユークリッド距離の式:

ユークリッド距離を例にしたサンプルコード:

#! /usr/bin/env python#-*- coding:utf-8 -*-# E-Mail : Mike_Zhang@live.comimport mathclass KNN: def __init__(self,trainData,trainLabel,k):

self.trainData = trainData

self.trainLabel = trainLabel

self.k = k def predict(self,inputPoint):

retLable = "None"arr=[]for vector,lable in zip(self.trainData,self.trainLabel):

s = 0for i,n in enumerate(vector) :

s += (n-inputPoint[i]) ** 2arr.append([math.sqrt(s),lable])

arr = sorted(arr,key=lambda x:x[0])[:self.k]

dtmp = {}for k,v in arr :if not v in dtmp : dtmp[v]=0

dtmp[v] += 1retLable,_ = sorted(dtmp.items(),key=lambda x:x[1],reverse=True)[0] return retLable

data = [

[1.0, 1.1],

[1.0, 1.0],

[0.0, 0.0],

[0.0, 0.1],

[1.3, 1.1],

]

labels = ['A','A','B','B','A']

knn = KNN(data,labels,3)print knn.predict([1.2, 1.1])

print knn.predict([0.2, 0.1])上記の実装は比較的単純で、scikit-learn などの既製のライブラリを開発時に使用できます。

- 手書きの数字を認識

以上がKNN アルゴリズムの詳細な紹介の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1662

1662

14

14

1419

1419

52

52

1311

1311

25

25

1261

1261

29

29

1234

1234

24

24

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

上記および筆者の個人的な理解: 現在、自動運転システム全体において、認識モジュールが重要な役割を果たしている。道路を走行する自動運転車は、認識モジュールを通じてのみ正確な認識結果を得ることができる。下流の規制および制御モジュール自動運転システムでは、タイムリーかつ正確な判断と行動決定が行われます。現在、自動運転機能を備えた自動車には通常、サラウンドビューカメラセンサー、ライダーセンサー、ミリ波レーダーセンサーなどのさまざまなデータ情報センサーが搭載されており、さまざまなモダリティで情報を収集して正確な認識タスクを実現しています。純粋な視覚に基づく BEV 認識アルゴリズムは、ハードウェア コストが低く導入が容易であるため、業界で好まれており、その出力結果はさまざまな下流タスクに簡単に適用できます。

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

C++sort 関数の基礎となる原則とアルゴリズムの選択を調べる

Apr 02, 2024 pm 05:36 PM

C++sort 関数の基礎となる原則とアルゴリズムの選択を調べる

Apr 02, 2024 pm 05:36 PM

C++sort 関数の最下層はマージ ソートを使用し、その複雑さは O(nlogn) で、クイック ソート、ヒープ ソート、安定したソートなど、さまざまなソート アルゴリズムの選択肢を提供します。

人工知能は犯罪を予測できるのか? CrimeGPT の機能を調べる

Mar 22, 2024 pm 10:10 PM

人工知能は犯罪を予測できるのか? CrimeGPT の機能を調べる

Mar 22, 2024 pm 10:10 PM

人工知能 (AI) と法執行機関の融合により、犯罪の予防と検出の新たな可能性が開かれます。人工知能の予測機能は、犯罪行為を予測するためにCrimeGPT (犯罪予測技術) などのシステムで広く使用されています。この記事では、犯罪予測における人工知能の可能性、その現在の応用、人工知能が直面する課題、およびこの技術の倫理的影響について考察します。人工知能と犯罪予測: 基本 CrimeGPT は、機械学習アルゴリズムを使用して大規模なデータセットを分析し、犯罪がいつどこで発生する可能性があるかを予測できるパターンを特定します。これらのデータセットには、過去の犯罪統計、人口統計情報、経済指標、気象パターンなどが含まれます。人間のアナリストが見逃す可能性のある傾向を特定することで、人工知能は法執行機関に力を与えることができます

改良された検出アルゴリズム: 高解像度の光学式リモートセンシング画像でのターゲット検出用

Jun 06, 2024 pm 12:33 PM

改良された検出アルゴリズム: 高解像度の光学式リモートセンシング画像でのターゲット検出用

Jun 06, 2024 pm 12:33 PM

01 今後の概要 現時点では、検出効率と検出結果の適切なバランスを実現することが困難です。我々は、光学リモートセンシング画像におけるターゲット検出ネットワークの効果を向上させるために、多層特徴ピラミッド、マルチ検出ヘッド戦略、およびハイブリッドアテンションモジュールを使用して、高解像度光学リモートセンシング画像におけるターゲット検出のための強化されたYOLOv5アルゴリズムを開発しました。 SIMD データセットによると、新しいアルゴリズムの mAP は YOLOv5 より 2.2%、YOLOX より 8.48% 優れており、検出結果と速度のバランスがより優れています。 02 背景と動機 リモート センシング技術の急速な発展に伴い、航空機、自動車、建物など、地表上の多くの物体を記述するために高解像度の光学式リモート センシング画像が使用されています。リモートセンシング画像の判読における物体検出

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

1. 58 Portraits プラットフォーム構築の背景 まず、58 Portraits プラットフォーム構築の背景についてお話ししたいと思います。 1. 従来のプロファイリング プラットフォームの従来の考え方ではもはや十分ではありません。ユーザー プロファイリング プラットフォームを構築するには、複数のビジネス分野からのデータを統合して、ユーザーの行動や関心を理解するためのデータ マイニングも必要です。最後に、ユーザー プロファイル データを効率的に保存、クエリ、共有し、プロファイル サービスを提供するためのデータ プラットフォーム機能も必要です。自社構築のビジネス プロファイリング プラットフォームとミドルオフィス プロファイリング プラットフォームの主な違いは、自社構築のプロファイリング プラットフォームは単一のビジネス ラインにサービスを提供し、オンデマンドでカスタマイズできることです。ミッドオフィス プラットフォームは複数のビジネス ラインにサービスを提供し、複雑な機能を備えていることです。モデリングを提供し、より一般的な機能を提供します。 2.58 中間プラットフォームのポートレート構築の背景のユーザーのポートレート 58

ドージコインとは

Apr 01, 2024 pm 04:46 PM

ドージコインとは

Apr 01, 2024 pm 04:46 PM

Dogecoin は、インターネット ミームに基づいて作成された暗号通貨であり、固定供給上限がなく、速い取引時間、低い取引手数料、そして大規模なミーム コミュニティを備えています。用途には、少額の取引、チップ、慈善寄付が含まれます。しかし、その無限の供給、市場のボラティリティ、ジョークコインとしての地位は、リスクと懸念ももたらします。ドージコインとは何ですか? Dogecoin は、インターネットのミームやジョークに基づいて作成された暗号通貨です。起源と歴史: Dogecoin は、2 人のソフトウェア エンジニア、ビリー マーカスとジャクソン パーマーによって 2013 年 12 月に作成されました。当時人気だった「Doge」ミームからインスピレーションを得た、片言の英語を話す柴犬をフィーチャーしたコミカルな写真。特徴と利点: 無制限の供給: ビットコインなどの他の暗号通貨とは異なります。

PyCharm 初心者ガイド: 置換関数の包括的な分析

Feb 25, 2024 am 11:15 AM

PyCharm 初心者ガイド: 置換関数の包括的な分析

Feb 25, 2024 am 11:15 AM

PyCharm は、開発効率を大幅に向上させる豊富な機能とツールを備えた強力な Python 統合開発環境です。その中でも置換機能は開発プロセスで頻繁に使用される機能の 1 つであり、開発者がコードを迅速に修正し、コードの品質を向上させるのに役立ちます。この記事では、初心者がこの関数をよりよく習得して使用できるように、特定のコード例と組み合わせて PyCharm の置換関数を詳細に紹介します。置換関数の概要 PyCharm の置換関数は、開発者がコード内の指定されたテキストを迅速に置換するのに役立ちます