ビッグデータアーキテクチャのいくつかの主要テクノロジー

エンタープライズ IT インフラストラクチャ プラットフォームの再構築は複雑な作業です。プラットフォームの再構築は、主要なビジネス推進要因の変化によって引き起こされることが多く、まさにそれが今起こっていることです。簡単に言うと、30 年近くにわたってエンタープライズ IT テクノロジーを支配してきたプラットフォームは、ビジネスを前進させるために必要なワークロードの需要を満たすことができなくなりました。

デジタル変革の中核はデータであり、ビジネスにおいて最も価値のあるものとなっています。組織は、互換性のない形式、従来のデータベースの制限、および複数のソースからのデータを柔軟に組み合わせることができないために消費するデータに長い間悩まされてきました。新興テクノロジーの出現により、これらすべてが変わることが約束されています。

ソフトウェア導入モデルの改善は、データ使用の障壁を取り除く重要な側面です。 「データの俊敏性」を高めるには、より柔軟なデータベースとよりスケーラブルなリアルタイム ストリーミング プラットフォームも必要です。実際、企業に柔軟なリアルタイムの「データ ファブリック」を提供するために組み合わせることができる基盤テクノロジーが少なくとも 7 つあります。

置き換えられるテクノロジーとは異なり、これら 7 つのソフトウェア イノベーションは、多くのユーザーのニーズや多くのユースケースに合わせて拡張できます。企業にとっては、より迅速に、より多くの情報に基づいた意思決定を行い、より良い顧客エクスペリエンスを生み出すことができます。

1. NoSQL データベース

RDBMS は、30 年近くデータベース市場を支配してきました。しかし、データ量の継続的な増加とデータ処理速度の加速に直面して、従来のリレーショナル データベースには欠点が明らかになりました。 NoSQL データベースは、その速度と拡張能力により、その地位を引き継ぎつつあります。ドキュメント データベースの場合、ソフトウェア エンジニアリングの観点から見たより単純なモデルが提供されます。このよりシンプルな開発モデルにより、市場投入までの時間が短縮され、企業が顧客や社内ユーザーのニーズにより迅速に対応できるようになります。

2. ライブ ストリーミング プラットフォーム

顧客にリアルタイムで応答することは、顧客体験にとって非常に重要です。過去 10 年間に消費者向け産業が大規模な混乱を経験したことは不思議ではありません。これは、企業がユーザーにリアルタイムで対応できるかどうかに関係しています。リアルタイム モデルに移行するには、イベント ストリーミングが必要です。

メッセージ主導型アプリは何年も前から存在しています。しかし、今日のストリーミング プラットフォームはかつてないほど大規模で、安価になっています。ストリーミング テクノロジーの最近の進歩により、ビジネスを最適化するための多くの新しい方法への扉が開かれました。イベント ストリーミングは、ソフトウェア開発およびテスト チームにリアルタイムのフィードバック ループを提供することで、企業が製品の品質を向上させ、新しいソフトウェアをより迅速に開発するのにも役立ちます。

3. Docker とコンテナ

コンテナは、開発者と運用者だけでなく、組織自体にも大きなメリットがあります。インフラストラクチャ分離に対する従来のアプローチは静的パーティショニングであり、各ワークロードに個別の固定リソース ブロック (物理サーバーか仮想マシンかを問わず) を割り当てます。静的パーティショニングによりトラブルシューティングが容易になりますが、十分に活用されていないハードウェアのコストは高くなります。たとえば、平均的な Web サーバーは、利用可能な総コンピューティング能力の 10% しか使用しません。

コンテナー テクノロジーの大きな利点は、新しい分離方法を作成できることです。コンテナーについて最もよく知っている人は、Ansible、Puppet、Chef などのツールを使用しても同じ利点が得られると信じているかもしれませんが、実際には、これらのテクノロジーは高度に補完的です。さらに、企業がどんなに努力しても、これらの自動化ツールは、異なるインフラストラクチャやハードウェア設定間でワークロードを自由に移動するために必要な分離を実現できません。同じコンテナーは、変更を加えることなく、オンプレミス データセンターのベア メタル ハードウェアまたはパブリック クラウドの仮想マシン上で実行できます。これが真のワークロード モビリティです。

4. コンテナ リポジトリ

コンテナ リポジトリは俊敏性にとって重要です。コンテナー イメージを構築するための DevOps プロセスとそれを保存するためのごみ箱がなければ、各コンテナーは実行する前にすべてのマシン上で構築する必要があります。リポジトリを使用すると、リポジトリを読み取るマシン上でコンテナ イメージを起動できるようになります。複数のデータセンターにわたって処理する場合、これはさらに複雑になります。 1 つのデータ センターでコンテナ イメージを構築した場合、そのイメージを別のデータ センターに移動するにはどうすればよいですか? 理想的には、企業は統合データ プラットフォームを活用して、データ センター間でリポジトリをミラーリングできるようになります。

ここで重要な点は、オンプレミスとクラウド コンピューティング間のミラーリング機能は、企業のデータ センター間のミラーリング機能とは大きく異なる可能性があるということです。統合データ プラットフォームは、組織内でデータ センター インフラストラクチャが使用されているか、クラウド コンピューティング インフラストラクチャが使用されているかに関係なく、これらの機能を提供することで、企業のこの問題を解決します。

5. コンテナ オーケストレーション

各コンテナには、静的なハードウェア パーティションではなく、独自のプライベート オペレーティング システムがあるように見えます。仮想マシンとは異なり、コンテナーはコンピューティングとメモリの静的なパーティショニングを必要としません。これにより、管理者は大量のメモリを気にすることなく、サーバー上で多数のコンテナを起動できるようになります。 Kubernetes などのコンテナ オーケストレーション ツールを使用すると、コンテナの起動、移動、環境内の別の場所での再起動が非常に簡単になります。

新しいインフラストラクチャ コンポーネントが配置された後、MapR-DB や MongoDB などのドキュメント データベース、MapR-ES や Apache Kafka (Kubernetes などのオーケストレーション ツール) などのイベント ストリーミング プラットフォーム、および Docker コンテナーを構築するための DevOps プロセスを実装した後ソフトウェアをデプロイする場合、これらのコンテナにどのコンポーネントをデプロイする必要があるかという問題を理解する必要があります。

6. マイクロサービス

歴史的に、マイクロサービスの概念は新しいものではありません。現在の違いは、実現テクノロジー (NoSQL データベース、イベント ストリーミング、コンテナ オーケストレーション) が数千のマイクロサービスの作成に合わせて拡張できることです。データ ストレージ、イベント ストリーミング、アーキテクチャ オーケストレーションに対するこれらの新しいアプローチがなければ、大規模なマイクロサービスの展開は不可能になります。大量のデータ、イベント、コンテナー インスタンスの管理に必要なインフラストラクチャは、必要なレベルまで拡張できません。

マイクロサービスは俊敏性を提供することがすべてです。マイクロサービスは通常、1 つの関数または小さな関数セットで構成されます。作業の機能単位が小さく、集中しているほど、サービスの作成、テスト、デプロイが容易になります。これらのサービスは分離する必要があります。そうしないと、企業は俊敏性を備えたマイクロサービスの約束を失うことになります。マイクロサービスは他のサービスに依存できますが、通常は負荷分散された REST API またはイベント ストリーミングを通じて行われます。イベント ストリーミングを使用すると、企業はリクエストとレスポンスのトピックを使用してイベントの履歴を簡単に追跡できます。このアプローチには、リクエスト フロー全体とリクエストからのすべてのデータをいつでも再生できるため、トラブルシューティングに大きな利点があります。

マイクロサービスは小さな作業をカプセル化し、相互に分離されているため、ほとんど障壁なくサービスを時間の経過とともに置き換えたりアップグレードしたりできます。レガシー モードでは、RPC のような密結合に依存すると、すべての接続を閉じてから再確立する必要がありました。手動構成ではエラーが発生しやすいため、これらを実装する場合、負荷分散は大きな問題になります。

7. Functions as a Service

マイクロサービスが業界を支配するのを見てきたように、サーバーレス コンピューティング、またはおそらくより正確には Functions as a Service (FaaS) と呼ばれるサービスの台頭も見られるでしょう。 FaaS は、コードを軽量フレームワークでラップし、コンテナに組み込み、オンデマンドで (ある種のトリガーに基づいて) 実行し、軽量フレームワークのおかげで自動的に負荷分散できるような方法でマイクロサービスを作成します。 FaaS の利点は、開発者がその機能にほぼ完全に集中できることです。したがって、FaaS はマイクロサービス アプローチの論理的な結論のように見えます。

イベントのトリガーは FaaS の重要なコンポーネントです。これがないと、作業を行う必要がある場合にのみ関数が呼び出され、リソースが消費されます。関数の自動呼び出しにより、FaaS は真に価値のあるものになります。誰かがユーザーのプロファイルを読み取るたびに、セキュリティ チームに通知するために実行する必要がある機能である監査イベントが発生することを想像してください。より具体的には、特定の種類のレコードのみをフィルターで除外する場合があります。これは完全にカスタマイズ可能なビジネス機能なので、オプションにすることもできます。 FaaS のようなデプロイメント モデルを使用すると、このようなワークフローを完了するのが非常に簡単であることに注意することが重要です。

イベントの統合

サービスをトリガーする背後にある魔法は、実際にはイベント ストリーム内のイベントだけです。特定の種類のイベントは他の種類よりもトリガーとして頻繁に使用されますが、企業がトリガーにしたいイベントはどれもトリガーになる可能性があります。トリガーとなるイベントはドキュメントの更新であり、新しいドキュメントに対して OCR プロセスを実行し、OCR プロセスからのテキストを NoSQL データベースに追加します。もっと興味深い考え方をすれば、画像がアップロードされるたびに、機械学習フレームワークを通じて画像の認識とスコアリングを行うことができます。ここには基本的な制限はありません。トリガー イベントが定義されている場合、何らかのイベントが発生し、そのイベントが関数をトリガーし、関数がその作業を完了します。

FaaS は、マイクロサービス導入の次の段階になります。ただし、FaaS に取り組む際に考慮しなければならない大きな要素が 1 つあります。それはベンダー ロックインです。 FaaS は、特定のストレージ メカニズム、特定のハードウェア インフラストラクチャ、およびオーケストレーションを隠します。これらはすべて開発者にとって素晴らしいことです。しかし、この抽象化により、ホスト型 FaaS 製品は、IT 業界がこれまで経験したことのないベンダー ロックインの最大の機会の 1 つとなっています。これらの API は標準化されていないため、これまでに行われた作業のほぼ 100% を失わずに、パブリック クラウドの FaaS 製品から移行することはほぼ不可能です。統合データ プラットフォームからのイベントを活用することで、より構造化された方法で FaaS にアプローチできれば、クラウド プロバイダー間の移動が容易になります。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7694

7694

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

PHPのビッグデータ構造処理スキル

May 08, 2024 am 10:24 AM

PHPのビッグデータ構造処理スキル

May 08, 2024 am 10:24 AM

ビッグ データ構造の処理スキル: チャンキング: データ セットを分割してチャンクに処理し、メモリ消費を削減します。ジェネレーター: データ セット全体をロードせずにデータ項目を 1 つずつ生成します。無制限のデータ セットに適しています。ストリーミング: ファイルやクエリ結果を 1 行ずつ読み取ります。大きなファイルやリモート データに適しています。外部ストレージ: 非常に大規模なデータ セットの場合は、データをデータベースまたは NoSQL に保存します。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

2024 年の AEC/O 業界の 5 つの主要な開発トレンド

Apr 19, 2024 pm 02:50 PM

2024 年の AEC/O 業界の 5 つの主要な開発トレンド

Apr 19, 2024 pm 02:50 PM

AEC/O(Architecture, Engineering & Construction/Operation)とは、建設業界における建築設計、工学設計、建設、運営を提供する総合的なサービスを指します。 2024 年、AEC/O 業界は技術の進歩の中で変化する課題に直面しています。今年は先進技術の統合が見込まれ、設計、建設、運用におけるパラダイムシフトが到来すると予想されています。これらの変化に対応して、業界は急速に変化する世界のニーズに適応するために、作業プロセスを再定義し、優先順位を調整し、コラボレーションを強化しています。 AEC/O 業界の次の 5 つの主要なトレンドが 2024 年の主要テーマとなり、より統合され、応答性が高く、持続可能な未来に向けて進むことが推奨されます: 統合サプライ チェーン、スマート製造

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

1. 58 Portraits プラットフォーム構築の背景 まず、58 Portraits プラットフォーム構築の背景についてお話ししたいと思います。 1. 従来のプロファイリング プラットフォームの従来の考え方ではもはや十分ではありません。ユーザー プロファイリング プラットフォームを構築するには、複数のビジネス分野からのデータを統合して、ユーザーの行動や関心を理解するためのデータ マイニングも必要です。最後に、ユーザー プロファイル データを効率的に保存、クエリ、共有し、プロファイル サービスを提供するためのデータ プラットフォーム機能も必要です。自社構築のビジネス プロファイリング プラットフォームとミドルオフィス プロファイリング プラットフォームの主な違いは、自社構築のプロファイリング プラットフォームは単一のビジネス ラインにサービスを提供し、オンデマンドでカスタマイズできることです。ミッドオフィス プラットフォームは複数のビジネス ラインにサービスを提供し、複雑な機能を備えていることです。モデリングを提供し、より一般的な機能を提供します。 2.58 中間プラットフォームのポートレート構築の背景のユーザーのポートレート 58

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

9 月 23 日、論文「DeepModelFusion:ASurvey」が国立国防技術大学、JD.com、北京理工大学によって発表されました。ディープ モデルの融合/マージは、複数のディープ ラーニング モデルのパラメーターまたは予測を 1 つのモデルに結合する新しいテクノロジーです。さまざまなモデルの機能を組み合わせて、個々のモデルのバイアスとエラーを補償し、パフォーマンスを向上させます。大規模な深層学習モデル (LLM や基本モデルなど) での深層モデルの融合は、高い計算コスト、高次元のパラメーター空間、異なる異種モデル間の干渉など、いくつかの課題に直面しています。この記事では、既存のディープ モデル フュージョン手法を 4 つのカテゴリに分類します。 (1) 「パターン接続」。損失低減パスを介して重み空間内の解を接続し、より適切な初期モデル フュージョンを取得します。

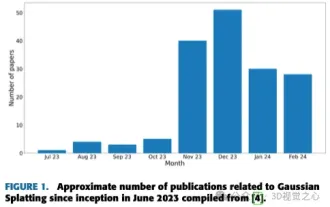

単なる 3D ガウス以上のもの!最先端の 3D 再構成技術の最新概要

Jun 02, 2024 pm 06:57 PM

単なる 3D ガウス以上のもの!最先端の 3D 再構成技術の最新概要

Jun 02, 2024 pm 06:57 PM

上記と著者の個人的な理解は、画像ベースの 3D 再構成は、一連の入力画像からオブジェクトまたはシーンの 3D 形状を推測することを含む困難なタスクであるということです。学習ベースの手法は、3D形状を直接推定できることから注目を集めています。このレビュー ペーパーは、これまでにない新しいビューの生成など、最先端の 3D 再構成技術に焦点を当てています。入力タイプ、モデル構造、出力表現、トレーニング戦略など、ガウス スプラッシュ メソッドの最近の開発の概要が提供されます。未解決の課題と今後の方向性についても議論します。この分野の急速な進歩と 3D 再構成手法を強化する数多くの機会を考慮すると、アルゴリズムを徹底的に調査することが重要であると思われます。したがって、この研究は、ガウス散乱の最近の進歩の包括的な概要を提供します。 (親指を上にスワイプしてください

Golang とフロントエンド テクノロジーの組み合わせ: Golang がフロントエンド分野でどのような役割を果たすかを探る

Mar 19, 2024 pm 06:15 PM

Golang とフロントエンド テクノロジーの組み合わせ: Golang がフロントエンド分野でどのような役割を果たすかを探る

Mar 19, 2024 pm 06:15 PM

Golang とフロントエンド テクノロジーの組み合わせ: Golang がフロントエンド分野でどのような役割を果たしているかを調べるには、具体的なコード例が必要です。インターネットとモバイル アプリケーションの急速な発展に伴い、フロントエンド テクノロジーの重要性がますます高まっています。この分野では、強力なバックエンド プログラミング言語としての Golang も重要な役割を果たします。この記事では、Golang がどのようにフロントエンド テクノロジーと組み合わされるかを検討し、具体的なコード例を通じてフロントエンド分野での可能性を実証します。フロントエンド分野における Golang の役割は、効率的で簡潔かつ学びやすいものとしてです。