Anaconda 環境で Scrapy クローラー フレームワークを作成するにはどうすればよいですか?この記事では、Anaconda 環境で Scrapy クローラー フレームワーク プロジェクトを作成する手順を紹介します。一読の価値があります。

Python クローラー チュートリアル-31-Scrapy クローラー フレームワーク プロジェクトの作成

まず、この記事は Anaconda 環境で書いていますので、Anaconda がインストールされていない場合は、公式 Web サイトにアクセスしてダウンロードしてください。まずはインストールしてください

Anaconda のダウンロード アドレス: https://www.anaconda.com/download/

Scrapy クローラー フレームワーク プロジェクトの作成

0. [cmd] を開きます

1. 使用する Anaconda 環境を入力します

ここではプロジェクトを作成し、自動生成されたファイルの役割を分析しました

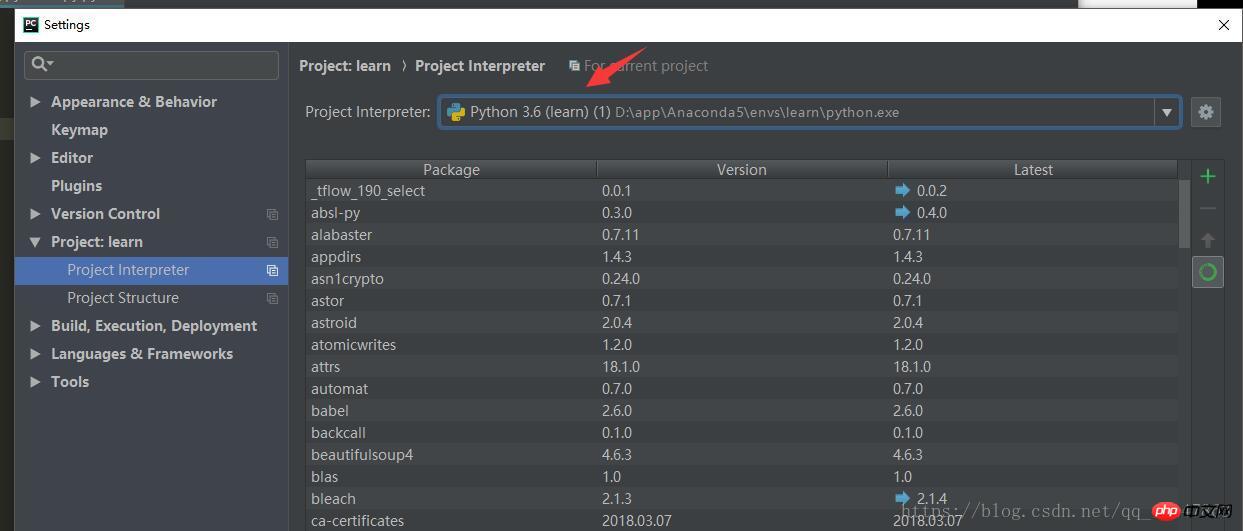

1. 環境名は次のとおりです。 [Pycharm] の [Settings] で見つかります。 [Project:] で

を見つけます。 2. コマンドを使用します: activate 環境名 (例:

activate) learn

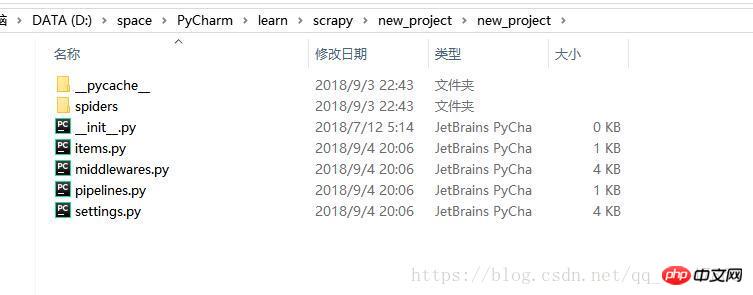

3. Scrapy プロジェクトを保存するディレクトリを入力します [注]

4. 新しいプロジェクト:scrapy startproject xxx プロジェクト名 (例:

##) #scrapy startproject new_project5. 操作のスクリーンショット:

#3. ストア コンテンツ: Pipelines.py

Pipeline.py ファイル

スパイダー オブジェクトが閉じられるときに呼び出されます

スパイダー オブジェクトが開かれるときに呼び出されます。

いくつかの必要なパラメータを初期化します。

スパイダーによって抽出された項目は、パラメータとして渡され、スパイダーとして使用されます。

このメソッドは実装する必要があります

Item オブジェクトを返す必要があり、破棄されたアイテムは後続のパイプラインに対応しません

パイプライン ファイル

クローラがデータを抽出してアイテムに保存した後、アイテムに保存されたデータには、クリーニング、駆虫、保存などのさらなる処理が必要です。

パイプラインは process_item 関数を処理する必要があります

process_item

_ init _: コンストラクター

open_spider(スパイダー):

close_spider(スパイダー):

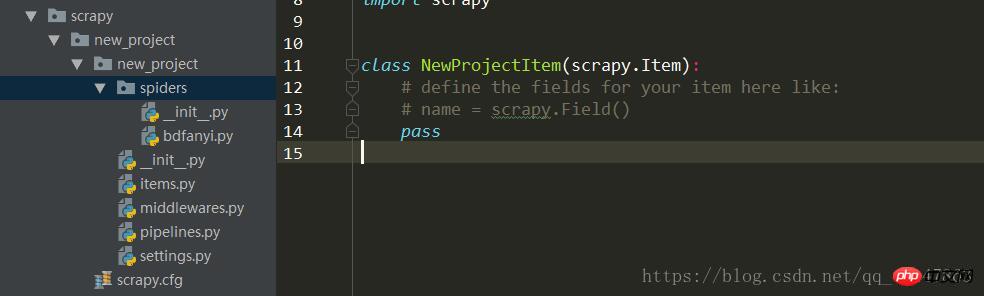

スパイダー ディレクトリ

Spider

_ init _: クローラー名を初期化し、_urls リストを開始します。

#start_requests: Requests オブジェクト交換を生成します。 ダウンロードして Scrapy## に応答を返します。 #parse: 返された応答に従って対応するアイテムを解析します。アイテムは自動的にパイプラインに入ります。必要に応じて URL を解析します。URL は自動的にリクエスト モジュールに渡され、サイクルが継続します

# start_requests: このメソッドは 1 回呼び出すことができ、start _urls コンテンツを読み取り、ループ プロセスを開始します。 name: クローラー名を設定します。 start_urls: クロールの最初のバッチを開始する URL を設定しますallow_domains: スパイダーがクロールできるドメイン名のリスト start_request(self): 1 回のみ呼び出される parse: 検出エンコーディング log: ログレコード関連する推奨事項:Python クローラー フレームワークのスクレイピー例の詳細な説明

スクレイピー クローラー入門チュートリアル 4 Spider (クローラー)

Python の Scrapy フレームワークを使用して Web クローラーを作成する簡単な例

以上がAnaconda 環境で Scrapy クローラー フレームワークを作成するための Python クローラーの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。