多くの言語でクロールできますが、python に基づくクローラーはより簡潔で便利です。クローラーも Python 言語の重要な部分になっています。クローラーを解析する方法もたくさんあります。前回の記事では、 クローラーを解析する 4 番目の方法である PyQuery について説明しましたが、今日は別の方法である XPath を紹介します。

#Python クローラーの xpath の基本的な使用法

1. はじめに

XPath は、XML ドキュメント内の情報を検索するための言語です。 XPath を使用すると、XML ドキュメント内の要素と属性をトラバースできます。 XPath は W3C XSLT 標準の主要な要素であり、XQuery と XPointer は両方とも XPath 式に基づいて構築されています。2. インストール

pip3 install lxml

3. 使用方法

1 、インポートfrom lxml import etree

from lxml import etree

wb_data = """

<div>

<ul>

<li class="item-0"><a href="link1.html">first item</a></li>

<li class="item-1"><a href="link2.html">second item</a></li>

<li class="item-inactive"><a href="link3.html">third item</a></li>

<li class="item-1"><a href="link4.html">fourth item</a></li>

<li class="item-0"><a href="link5.html">fifth item</a>

</ul>

</div>

"""

html = etree.HTML(wb_data)

print(html)

result = etree.tostring(html)

print(result.decode("utf-8"))<Element html at 0x39e58f0>

<html><body><div>

<ul>

<li class="item-0"><a href="link1.html">first item</a></li>

<li class="item-1"><a href="link2.html">second item</a></li>

<li class="item-inactive"><a href="link3.html">third item</a></li>

<li class="item-1"><a href="link4.html">fourth item</a></li>

<li class="item-0"><a href="link5.html">fifth item</a>

</li></ul>

</div>

</body></html>書き方その1

html = etree.HTML(wb_data)

html_data = html.xpath('/html/body/div/ul/li/a')

print(html)

for i in html_data:

print(i.text)<Element html at 0x12fe4b8> first item second item third item fourth item fifth item

(必要なタグ内に直接記述)コンテンツを見つけます。その後に /text() を追加するだけです)

html = etree.HTML(wb_data)

html_data = html.xpath('/html/body/div/ul/li/a/text()')

print(html)

for i in html_data:

print(i)

<Element html at 0x138e4b8> first item second item third item fourth item fifth item

4. HTML ファイルを開いて読みます

#使用parse打开html的文件

html = etree.parse('test.html')

html_data = html.xpath('//*')<br>#打印是一个列表,需要遍历

print(html_data)

for i in html_data:

print(i.text)

html = etree.parse('test.html') html_data = etree.tostring(html,pretty_print=True) res = html_data.decode('utf-8') print(res)

Print:

<div>

<ul>

<li class="item-0"><a href="link1.html">first item</a></li>

<li class="item-1"><a href="link2.html">second item</a></li>

<li class="item-inactive"><a href="link3.html">third item</a></li>

<li class="item-1"><a href="link4.html">fourth item</a></li>

<li class="item-0"><a href="link5.html">fifth item</a></li>

</ul>

</div>

5. 指定されたパスの下の a タグの属性を出力します (トラバースして特定の値を取得します。属性の値、タグの内容を見つけます)

html = etree.HTML(wb_data)

html_data = html.xpath('/html/body/div/ul/li/a/@href')

for i in html_data:

print(i)Print:

link1.html link2.html link3.html link4.html link5.html

6. xpath を使用して次のことを行うことがわかります。 ElementTree オブジェクトを 1 つずつ取得するため、コンテンツを見つける必要がある場合は、データのリストも参照する必要があります。

絶対パスの下で、link2.html に等しい a タグ属性のコンテンツを見つけます。

html = etree.HTML(wb_data)

html_data = html.xpath('/html/body/div/ul/li/a[@href="link2.html"]/text()')

print(html_data)

for i in html_data:

print(i)

印刷:

['2 番目のアイテム']

2 番目のアイテム

7. 上ではすべての絶対パスが見つかりました (それぞれがルートから検索されます)。下では相対パスが見つかりました。たとえば、すべての li タグの下にある a タグのコンテンツが見つかりました。

html = etree.HTML(wb_data)

html_data = html.xpath('//li/a/text()')

print(html_data)

for i in html_data:

print(i)

Print:

['first item', 'second item', 'third item', 'fourth item', 'fifth item'] first item second item third item fourth item fifth item

8. 上記では、絶対パスを使用して、href に等しいすべての a タグの属性を検索しました。 /--- 絶対パスです。次に、相対パスを使用して、a タグの下、li タグの下、l 相対パスの下の href 属性の値を見つけます。a の後には // が 2 つ必要であることに注意してください。鬼ごっこ。

html = etree.HTML(wb_data)

html_data = html.xpath('//li/a//@href')

print(html_data)

for i in html_data:

print(i)Print:

['link1.html', 'link2.html', 'link3.html', 'link4.html', 'link5.html'] link1.html link2.html link3.html link4.html link5.html

html = etree.HTML(wb_data)

html_data = html.xpath('//li/a[@href="link2.html"]')

print(html_data)

for i in html_data:

print(i.text)[<Element a at 0x216e468>] second item

10、查找最后一个li标签里的a标签的href属性

html = etree.HTML(wb_data)

html_data = html.xpath('//li[last()]/a/text()')

print(html_data)

for i in html_data:

print(i)

打印:

['fifth item'] fifth item

11、查找倒数第二个li标签里的a标签的href属性

html = etree.HTML(wb_data)

html_data = html.xpath('//li[last()-1]/a/text()')

print(html_data)

for i in html_data:

print(i)

打印:

['fourth item'] fourth item

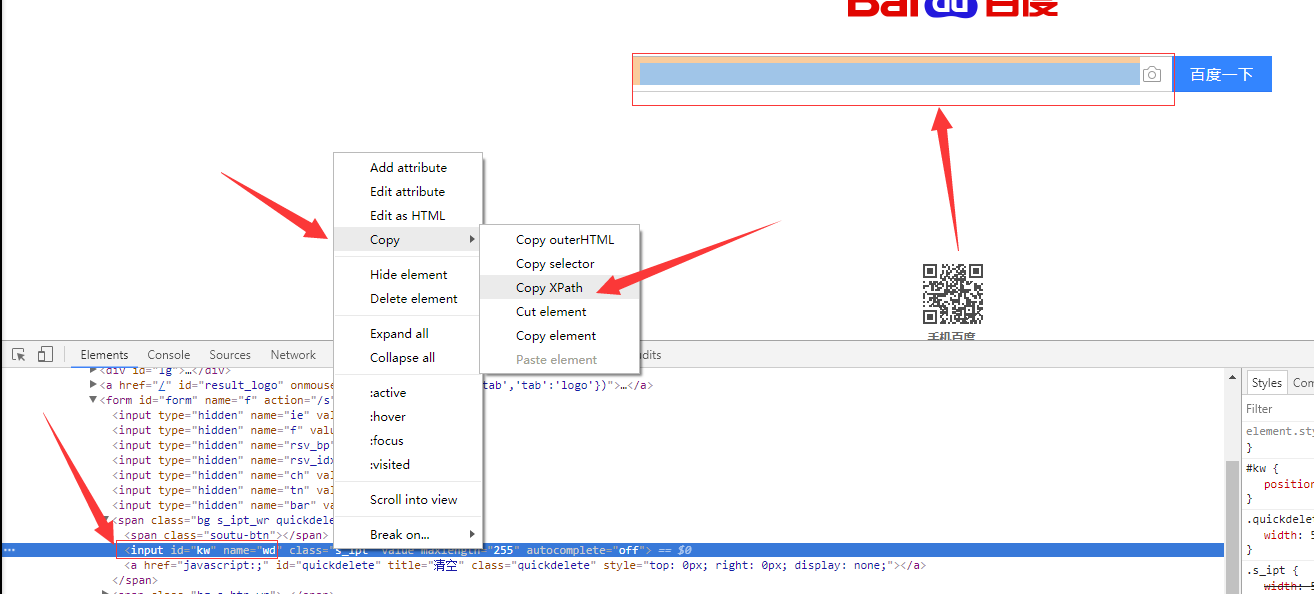

12、如果在提取某个页面的某个标签的xpath路径的话,可以如下图:

//*[@id="kw"]

解释:使用相对路径查找所有的标签,属性id等于kw的标签。

#!/usr/bin/env python

# -*- coding:utf-8 -*-

from scrapy.selector import Selector, HtmlXPathSelector

from scrapy.http import HtmlResponse

html = """<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<title></title>

</head>

<body>

<ul>

<li><a id='i1' href="link.html">first item</a></li>

<li><a id='i2' href="llink.html">first item</a></li>

<li><a href="llink2.html">second item<span>vv</span></a></li>

</ul>

<div><a href="llink2.html">second item</a></div>

</body>

</html>

"""

response = HtmlResponse(url='http://example.com', body=html,encoding='utf-8')

# hxs = HtmlXPathSelector(response)

# print(hxs)

# hxs = Selector(response=response).xpath('//a')

# print(hxs)

# hxs = Selector(response=response).xpath('//a[2]')

# print(hxs)

# hxs = Selector(response=response).xpath('//a[@id]')

# print(hxs)

# hxs = Selector(response=response).xpath('//a[@id="i1"]')

# print(hxs)

# hxs = Selector(response=response).xpath('//a[@href="link.html"][@id="i1"]')

# print(hxs)

# hxs = Selector(response=response).xpath('//a[contains(@href, "link")]')

# print(hxs)

# hxs = Selector(response=response).xpath('//a[starts-with(@href, "link")]')

# print(hxs)

# hxs = Selector(response=response).xpath('//a[re:test(@id, "i\d+")]')

# print(hxs)

# hxs = Selector(response=response).xpath('//a[re:test(@id, "i\d+")]/text()').extract()

# print(hxs)

# hxs = Selector(response=response).xpath('//a[re:test(@id, "i\d+")]/@href').extract()

# print(hxs)

# hxs = Selector(response=response).xpath('/html/body/ul/li/a/@href').extract()

# print(hxs)

# hxs = Selector(response=response).xpath('//body/ul/li/a/@href').extract_first()

# print(hxs)

# ul_list = Selector(response=response).xpath('//body/ul/li')

# for item in ul_list:

# v = item.xpath('./a/span')

# # 或

# # v = item.xpath('a/span')

# # 或

# # v = item.xpath('*/a/span')

# print(v)以上がクローラーの解析方法 5: XPathの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。