ビッグデータを始めるための 4 つの重要な常識とは何ですか?

#ビッグ データを始めるための 4 つの重要な常識

ビッグ データ エンジニアにとって非常に重要な仕事は、 pass データを分析して過去のイベントの特徴を見つけます。たとえば、Tencent のデータ チームは、会社のすべてのネットワーク プラットフォーム上の大規模で不規則なデータ情報を整理し、広告を含む会社のさまざまなビジネスのデータ ニーズをサポートするためにクエリできる特性を要約するためのデータ ウェアハウスを構築しています。ゲーム開発、ソーシャルネットワーキングなど。1. ビッグ データ分析の 5 つの基本側面

1. 視覚的分析ビッグ データ分析のユーザーには、ビッグ データ分析の専門家が含まれます。一般のユーザーもいますが、ビッグデータ分析の最も基本的な要件は視覚的な分析であり、視覚的な分析はビッグデータの特徴を直感的に表現でき、読者に受け入れられやすく、写真を見ながら話すのと同じくらい簡単で明確です。 2. データ マイニング アルゴリズムビッグ データ分析の理論的核心はデータ マイニング アルゴリズムであり、データ自体をより科学的に表現するために、さまざまなデータ マイニング アルゴリズムがさまざまなデータ型と形式に基づいています。世界中の統計学者に認められているこれらのさまざまな統計手法(真実とも言える)があるからこそ、データを深く掘り下げ、認識されている値を掘り起こすことができます。もう 1 つの側面として、これらのデータ マイニング アルゴリズムはビッグ データをより迅速に処理できますが、アルゴリズムが結論に達するまでに数年かかる場合、ビッグ データの価値は測り知ることができなくなります。 3. 予測分析機能ビッグデータ分析の最終応用分野の 1 つは、ビッグデータから特徴を抽出し、科学的にモデルを確立する予測分析です。モデルを通じて新しいデータを利用して将来のデータを予測します。 4. セマンティック エンジンビッグ データ分析は、ネットワーク データ マイニングで広く使用されており、ユーザーの検索キーワード、タグ キーワード、またはその他の入力セマンティクスからユーザー ニーズを分析および判断できます。より良いユーザーエクスペリエンスと広告のマッチングを実現します。 5. データ品質とデータ管理ビッグデータ分析は、データ品質とデータ管理から切り離すことができません。学術研究であろうと商業アプリケーション分野であろうと、高品質のデータと効果的なデータ管理は、分析結果が真実で価値があることを確認します。ビッグデータ分析の基本は上記の 5 つの側面ですが、もちろん、ビッグデータ分析をさらに深く掘り下げると、さらに特徴的で詳細な、専門的なビッグデータ分析手法が多数存在します。2. 適切なデータ分析ツールの選択方法

どのようなデータを分析するかを理解するために、ビッグ データには主に 4 つのタイプのデータが分析されます:トランザクションデータビッグデータプラットフォームは、より長い期間と大量の構造化されたトランザクションデータを取得できるため、POSやE-に限らず、より幅広い種類のトランザクションデータを分析できます。コマース ショッピング データには、Web サーバーによって記録されたインターネット クリック ストリーム データ ログなどの行動トランザクション データも含まれます。 人間が生成したデータ非構造化データは、電子メール、文書、写真、音声、ビデオに加え、ブログ、Wiki、特にソーシャル メディア フローを通じて生成されたデータにも広く存在します。このデータは、テキスト分析機能を使用した分析のための豊富なデータ ソースを提供します。 モバイル データ インターネットにアクセスできるスマートフォンやタブレットがますます普及しています。これらのモバイル デバイス上のアプリは、アプリ内トランザクション データ (製品の検索の記録など) からプロファイルやステータスのレポート イベント (新しい地理コードを報告する位置の変更など) まで、数え切れないほどのイベントを追跡および通信できます。 マシンとセンサーのデータこれには、スマート メーター、スマート温度コントローラー、工場の機械、インターネットに接続された家電製品などの機能デバイスによって作成または生成されたデータが含まれます。これらのデバイスは、インターネットワーク内の他のノードと通信するように構成でき、データを分析できるように中央サーバーにデータを自動的に送信することもできます。マシンとセンサーのデータは、新興のモノのインターネット (IoT) から生じる代表的な例です。 IoT からのデータを使用して、分析モデルを構築し、予測動作を継続的に監視し (センサー値が問題を示す時期を特定するなど)、所定の指示を提供する (実際の問題が発生する前に機器を検査するよう技術者に警告するなど) ことができます。 関連する推奨事項: 「FAQ」

3. ビッグ データの 3 つの人気のある職業 - データ サイエンティスト、データ エンジニア、データ アナリストを見分ける方法

ビッグデータの人気が高まるにつれ、ビッグデータに関連するキャリアも人気が高まり、人材育成の多くの機会がもたらされています。データサイエンティスト、データエンジニア、データアナリストは、ビッグデータ業界で最も人気のある職種となっています。どのように定義されているのでしょうか? 正確には何をするのですか? どのようなスキルが必要ですか? 見てみましょう。 この3つの職業はどのように位置づけられていますか?データサイエンティストとはどのような存在ですか

データ サイエンティストとは、科学的手法とデータ マイニング ツールを使用して、複雑で大量の数値、記号、テキスト、URL、オーディオまたはビデオ情報をデジタル的に再現して理解し、新しいデータの洞察を見つけることができるエンジニアまたはエンジニアを指します。 (統計学者やアナリストとは異なります)。

データ エンジニアの定義

データ エンジニアは一般に、「統計を深く理解しているスター ソフトウェア エンジニア」と定義されます。ビジネス上の問題に悩んでいるなら、データ エンジニアが必要です。その中心的な価値は、クリーンなデータからデータ パイプラインを作成できる機能にあります。ファイル システム、分散コンピューティング、データベースを完全に理解することは、優れたデータ エンジニアになるために必要なスキルです。

データ エンジニアはアルゴリズムについてかなりよく理解しています。したがって、データ エンジニアは基本的なデータ モデルを実行できる必要があります。ハイエンドのビジネスニーズにより、非常に複雑な計算の必要性が生じています。多くの場合、これらのニーズはデータ エンジニアの知識の範囲を超えているため、データ サイエンティストに支援を求める必要があります。

データ アナリストを理解する方法

データ アナリストとは、業界データの収集、分類、分析を専門とし、データ アナリストに基づいて業界の意思決定を行うさまざまな業界の人々を指します。データを調査、評価、予測する専門家。彼らは適切な質問の仕方を知っており、データ分析、データの視覚化、データのプレゼンテーションに非常に優れています。

これら 3 つの専門職の具体的な責任は何ですか

データ サイエンティストの職務責任

データ サイエンティストは、探索することで周囲の世界に目を向ける傾向があります。データ、世界。大量の散在データを分析可能な構造化データに変換するには、豊富なデータ ソースを見つけ、不完全な可能性がある他のデータ ソースを統合し、結果のデータ セットをクリーンアップすることも必要です。新しい競争環境では、課題は常に変化し、新しいデータが絶えず流入しています。データ サイエンティストは、一時的なデータ分析から継続的なデータ相互作用分析まで、さまざまな分析を意思決定者が行き来できるように支援する必要があります。彼らは発見をすると、その発見を伝え、新しいビジネスの方向性を提案します。彼らは視覚情報を創造的に提示し、見つけたパターンを明確で説得力のあるものにします。データに含まれるパターンを上司に提案して、製品、プロセス、意思決定に影響を与えます。

データ エンジニアの仕事責任

歴史の分析、将来の予測、選択の最適化は、ビッグ データ エンジニアが「データを扱う」際の 3 つの最も重要なタスクです。これら 3 つの作業を通じて、企業がより適切なビジネス上の意思決定を行えるように支援します。

ビッグデータ エンジニアの非常に重要な仕事は、データを分析して過去の出来事の特徴を見つけることです。たとえば、Tencent のデータ チームは、会社のすべてのネットワーク プラットフォーム上の大規模で不規則なデータ情報を整理し、広告を含む会社のさまざまなビジネスのデータ ニーズをサポートするためにクエリできる特性を要約するためのデータ ウェアハウスを構築しています。ゲーム開発、ソーシャルネットワーキングなど。

過去の出来事の特徴を明らかにする最大の役割は、企業が消費者をより深く理解できるようにすることです。ユーザーの過去の行動軌跡を分析することで、その人物を理解し、行動を予測することができます。

主要な要素を導入することで、ビッグデータ エンジニアは将来の消費者の傾向を予測できます。アリママのマーケティング プラットフォームでは、エンジニアが気象データを導入することでタオバオの販売者のビジネスを支援しようとしています。例えば、今年の夏が暑くなかった場合、特定の商品が昨年ほど売れない可能性が高く、エアコンや扇風機だけでなく、ベストや水着なども影響を受ける可能性があります。次に、気象データと販売データの関係を確立し、関連するカテゴリを見つけて、在庫を回転するように事前に販売者に警告します。

さまざまな企業のビジネスの性質に応じて、ビッグデータ エンジニアはデータ分析を通じてさまざまな目的を達成できます。 Tencent にとって、ビッグデータ エンジニアの仕事を反映する最も単純かつ直接的な例は、プロダクト マネージャーが選択肢 A と B のどちらかを選択するのに役立つオプション テスト (AB テスト) です。以前は、意思決定者は経験に基づいて判断することしかできませんでしたが、今ではビッグデータ エンジニアが大規模なリアルタイム テストを実行できるようになりました。たとえば、ソーシャル ネットワーク製品の例では、ユーザーの半数にインターフェイス A とインターフェイス A を表示させます。残りの半分はインターフェイス B を使用して、一定期間にわたるクリックスルー率とコンバージョン率の統計を観察し、マーケティング部門が最終的な選択を行うのに役立ちます。

データ アナリストの職務責任

インターネット自体はデジタルかつインタラクティブな特性を持っており、この特性がデータの収集、組織、研究に革命をもたらしました。これまで、「原子の世界」のデータ アナリストは、研究と分析をサポートするデータを取得するために、より高いコスト (資金、リソース、時間) を費やす必要がありましたが、データの豊富さ、包括性、継続性、適時性はインターネットよりもはるかに悪かったです。時代。

従来のデータ アナリストと比較すると、インターネット時代のデータ アナリストが直面しているのはデータの不足ではなく、データの過剰です。したがって、インターネット時代のデータ アナリストは、効率的なデータ処理を実行するための技術的手段の使い方を学ぶ必要があります。さらに重要なことは、インターネット時代のデータ アナリストは、データ調査手法の革新と画期的な進歩を続けなければならないということです。

業界に関する限り、データ アナリストの価値はこれと同様です。報道出版業界においては、いつの時代も、メディア運営者が視聴者の状況やトレンドの変化を正確かつ詳細かつタイムリーに把握できるかどうかが、メディアの成否の鍵を握っています。

さらに、ニュースや出版などのコンテンツ業界では、データ アナリストがコンテンツ消費者データ分析の機能を実行できることがさらに重要です。これは、ニュースや出版組織の顧客改善をサポートする重要な機能です。サービス。

これら 3 つのキャリアに従事するには、どのようなスキルを習得する必要がありますか?

A. データ サイエンティストが習得する必要があるスキル

1、コンピューター科学

一般的に、ほとんどのデータ サイエンティストは、プログラミングとコンピューター サイエンスに関連する専門的な背景を持っていることが求められます。簡単に言うと、ビッグデータを処理するために必要なHadoopやMahoutといった大規模並列処理技術や機械学習に関するスキルです。

2. 数学、統計、データマイニングなど

数学と統計のリテラシーに加えて、SPSS やデータマイニングなどの主流の統計分析ソフトウェアを使用するスキルも必要です。 SAS。中でも最近注目を集めているのが、統計解析用のオープンソースプログラミング言語とその動作環境「R」です。 R の強みは、豊富な統計分析ライブラリが含まれていることだけでなく、結果を視覚化するための高品質なチャート生成機能も備えており、これを簡単なコマンドで実行できることです。また、CRAN(The Comprehensive R Archive Network)と呼ばれるパッケージ拡張機構も備えており、拡張パッケージをインポートすることで、標準状態ではサポートされていない機能やデータセットを利用することができます。

3. データの可視化 (Visualization)

情報の質はその表現に大きく左右されます。データサイエンティストにとって、数値の羅列で構成されたデータに含まれる意味を分析し、Webプロトタイプを開発し、外部APIを利用してチャートやマップ、ダッシュボードなどのサービスを統合し、分析結果を可視化することは非常に重要なスキルの一つです。

B. データ エンジニアが習得する必要があるスキル

1、数学と統計関連の背景

ビッグ データ エンジニアの要件は、統計の背景があることを望んでいることです。および数学の修士号または博士号。理論的背景が欠如しているデータ ワーカーは、技術的な危険ゾーン (デンジャー ゾーン) に入る可能性が高くなります。さまざまなデータ モデルやアルゴリズムに従って、大量の数値が常に何らかの結果を生み出す可能性がありますが、その意味が分からない場合は、本当に意味のある結果ではなく、そのような結果は簡単に誤解を招く可能性があります。特定の理論的知識がなければ、モデルを理解し、モデルを再利用し、実際の問題を解決するためにモデルを革新することさえできます。

2. コンピュータコーディング能力

実際の開発能力と大規模データ処理能力はビッグデータエンジニアに必要な要素です。多くのデータの価値は採掘のプロセスから得られるため、金の価値を見つけるには自分で行う必要があります。たとえば、ソーシャル ネットワーク上で人々が生成した多くの記録は現在非構造化データとなっており、これらの意味不明なテキスト、音声、画像、さらにはビデオから意味のある情報を抽出するには、ビッグデータ エンジニアが自ら情報を掘り出す必要があります。一部のチームでは、ビッグ データ エンジニアの責任は主にビジネス分析ですが、コンピューターがビッグ データを処理する方法にも精通している必要があります。

3. 特定のアプリケーション分野または業界に関する知識

ビッグデータ エンジニアの役割において非常に重要な点は、ビッグデータは市場から切り離すことができないということです。特定のフィールドの値のアプリケーションと組み合わせることができます。したがって、1 つ以上の垂直産業での経験は、候補者が業界の知識を蓄積するのに役立ち、将来ビッグデータ エンジニアになる際に非常に役立ちます。

C. データ アナリストが習得する必要があるスキル

1. ビジネスを理解する。データ分析の仕事に従事するための前提条件は、ビジネスを理解すること、つまり業界の知識、企業のビジネス、プロセスに精通していることであり、独自の洞察を持っていることが最善です。 、分析結果はオフラインでのみ表示されるため、凧にはあまり使用価値がありません。

2. 経営について理解する。一方で、データ分析のフレームワークを構築する必要があります。たとえば、分析のアイデアを決定するには、マーケティングや経営学などの理論的な知識を参考にする必要があります。経営理論に詳しくない場合は、データ分析枠組みの構築が難しくなり、その後のデータ分析も困難になります。一方、役割は、データ分析の結論に基づいて、有益な分析の提案を提供することです。

3. 分析を理解する。データ分析を効果的に行うために、データ分析の基本原則と効果的なデータ分析手法を習得し、実務に柔軟に適用できることを指します。基本的な分析手法には、比較分析、グループ分析、クロス分析、構造分析、ファネルチャート分析、総合評価分析、因子分析、マトリックス相関分析などがあります。高度な分析手法には、相関分析、回帰分析、クラスター分析、判別分析、主成分分析、因子分析、対応分析、時系列などが含まれます。

4. ツールを理解します。データ分析に関連する共通ツールを使いこなすことを指します。データ分析手法は理論であり、データ分析ツールはデータ分析手法の理論を実装するためのツールです。ますます大量のデータに直面しているため、分析に電卓に頼ることはできません。データを完成させるには強力なデータ分析ツールに依存する必要があります。分析作業。

5. デザインを理解する。デザインを理解するとは、グラフを使用してデータ アナリストの分析ビューを効果的に表現し、分析結果が一目でわかるようにすることを意味します。グラフのデザインは、グラフィックの選択、レイアウト デザイン、カラー マッチングなどの主要なテーマであり、そのすべてにおいて特定のデザイン原則を習得する必要があります。

4. 新人からデータサイエンティストになるための 9 ステップの育成プラン

まず、データサイエンティストの定義は企業ごとに異なります。現在、統一された定義はありません。しかし、一般に、データ サイエンティストは、ソフトウェア エンジニアのスキルと統計学者のスキルを組み合わせており、自分が取り組みたい分野に投資された重要な業界知識を持っています。

データサイエンティストの約 90% は少なくとも大学教育を受けており、もちろん非常に幅広い分野で博士号や博士号を取得しています。採用担当者の中には、人文科学を専攻していれば他の人に重要なスキルを教えるのに必要な創造性があると考える人もいます。

それでは、データ サイエンスの学位プログラム (世界中の名門大学にキノコのように登場しています) を除いて、データ サイエンティストになるにはどのような手順を踏む必要がありますか?

数学と統計のスキルを復習しましょう

優れたデータ サイエンティストは、データが何を伝えているかを理解できなければなりません。そのためには、基本的な線形代数をしっかりと理解している必要があります。アルゴリズムと統計スキル。特定の状況では高度な数学が必要になる場合がありますが、ここから始めるのが良いでしょう。

機械学習の概念を理解する

機械学習は次に登場する言葉ですが、ビッグデータと密接に関係しています。機械学習は人工知能アルゴリズムを使用して、明示的なプログラミングを行わずにデータを価値に変換します。

コードを学ぶ

データ サイエンティストは、コードを微調整してデータの分析方法をコンピューターに指示する方法を知っている必要があります。 Python などのオープンソース言語から始めます。

データベース、データ プール、分散ストレージについて理解する

データは、データベース、データ プール、または分散ネットワーク全体に保存されます。このデータのリポジトリを構築する方法は、このデータにアクセス、使用、分析する方法によって異なります。データ ストレージを構築する際に、全体的なアーキテクチャや事前の計画がなければ、重大な結果が生じます。

データ変更とデータ クリーニングのテクニックを学ぶ

データ変更は、生データを、アクセスと分析が容易な別の形式に変換するプロセスです。データ クレンジングは、重複データや「不良」データを排除するのに役立ちます。どちらもデータ サイエンティストのツールボックスに含まれる重要なツールです。

優れたデータの視覚化とレポート作成の基本を理解する

グラフィック デザイナーである必要はありませんが、データの視覚化とレポート作成の方法をしっかりと理解する必要があります。素人でも理解しやすいデータ レポートを作成します。マネージャーや CEO のような人でも理解できます。

ツールボックスにツールを追加する

上記のスキルを習得したら、データ サイエンス ツールボックスを拡張して Hadoop、R 言語、Spark を含めます。これらのツールを使用する経験と知識があれば、データ サイエンスの求職者の大規模な集団よりも優位に立つことができます。

実践

新しい分野での仕事に就く前に、データ サイエンティストになるための練習をどのように行いますか?オープン ソース コードを使用して、好きなプロジェクトを開発したり、コンテストに参加したりできます。 , Web ジョブのデータ サイエンティストになり、ブートキャンプ、ボランティア、またはインターンに参加してください。優秀なデータ サイエンティストは、データ分野での経験と直観力があり、候補者となるために自分の仕事を実証できるでしょう。

コミュニティのメンバーになる

業界の思想的リーダーをフォローし、業界のブログや Web サイトを読み、参加し、質問し、最新のニュースや理論に関する最新情報を入手してください。 。

以上がビッグデータを始めるための 4 つの重要な常識とは何ですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7554

7554

15

15

1382

1382

52

52

83

83

11

11

28

28

96

96

パデュー大学による、時間をかける価値のある拡散モデルのチュートリアル

Apr 07, 2024 am 09:01 AM

パデュー大学による、時間をかける価値のある拡散モデルのチュートリアル

Apr 07, 2024 am 09:01 AM

拡散はより良いものを模倣するだけでなく、「創造」することもできます。拡散モデル(DiffusionModel)は、画像生成モデルである。 AI 分野でよく知られている GAN や VAE などのアルゴリズムと比較すると、拡散モデルは異なるアプローチを採用しており、その主な考え方は、最初に画像にノイズを追加し、その後徐々にノイズを除去するプロセスです。ノイズを除去して元の画像を復元する方法は、アルゴリズムの中核部分です。最後のアルゴリズムは、ランダムなノイズを含む画像から画像を生成できます。近年、生成 AI の驚異的な成長により、テキストから画像への生成、ビデオ生成など、多くのエキサイティングなアプリケーションが可能になりました。これらの生成ツールの背後にある基本原理は、以前の方法の制限を克服する特別なサンプリング メカニズムである拡散の概念です。

ワンクリックでPPTを生成!キミ: まずは「PPT出稼ぎ労働者」を普及させましょう

Aug 01, 2024 pm 03:28 PM

ワンクリックでPPTを生成!キミ: まずは「PPT出稼ぎ労働者」を普及させましょう

Aug 01, 2024 pm 03:28 PM

キミ: たった 1 文の PPT がわずか 10 秒で完成します。 PPTはとても面倒です!会議を開催するには PPT が必要であり、週次報告書を作成するには PPT が必要であり、投資を勧誘するには PPT を提示する必要があり、不正行為を告発するには PPT を送信する必要があります。大学は、PPT 専攻を勉強するようなものです。授業中に PPT を見て、授業後に PPT を行います。おそらく、デニス オースティンが 37 年前に PPT を発明したとき、PPT がこれほど普及する日が来るとは予想していなかったでしょう。 PPT 作成の大変な経験を話すと涙が出ます。 「20 ページを超える PPT を作成するのに 3 か月かかり、何十回も修正しました。PPT を見ると吐きそうになりました。」 「ピーク時には 1 日に 5 枚の PPT を作成し、息をすることさえありました。」 PPTでした。」 即席の会議をするなら、そうすべきです

PHPのビッグデータ構造処理スキル

May 08, 2024 am 10:24 AM

PHPのビッグデータ構造処理スキル

May 08, 2024 am 10:24 AM

ビッグ データ構造の処理スキル: チャンキング: データ セットを分割してチャンクに処理し、メモリ消費を削減します。ジェネレーター: データ セット全体をロードせずにデータ項目を 1 つずつ生成します。無制限のデータ セットに適しています。ストリーミング: ファイルやクエリ結果を 1 行ずつ読み取ります。大きなファイルやリモート データに適しています。外部ストレージ: 非常に大規模なデータ セットの場合は、データをデータベースまたは NoSQL に保存します。

CVPR 2024 のすべての賞が発表されました!オフラインでのカンファレンスには1万人近くが参加し、Googleの中国人研究者が最優秀論文賞を受賞した

Jun 20, 2024 pm 05:43 PM

CVPR 2024 のすべての賞が発表されました!オフラインでのカンファレンスには1万人近くが参加し、Googleの中国人研究者が最優秀論文賞を受賞した

Jun 20, 2024 pm 05:43 PM

北京時間6月20日早朝、シアトルで開催されている最高の国際コンピュータビジョンカンファレンス「CVPR2024」が、最優秀論文やその他の賞を正式に発表した。今年は、最優秀論文 2 件と学生優秀論文 2 件を含む合計 10 件の論文が賞を受賞しました。また、最優秀論文ノミネートも 2 件、学生優秀論文ノミネートも 4 件ありました。コンピュータービジョン (CV) 分野のトップカンファレンスは CVPR で、毎年多数の研究機関や大学が集まります。統計によると、今年は合計 11,532 件の論文が投稿され、2,719 件が採択され、採択率は 23.6% でした。ジョージア工科大学による CVPR2024 データの統計分析によると、研究テーマの観点から最も論文数が多いのは画像とビデオの合成と生成です (Imageandvideosyn

ベアメタルから 700 億のパラメータを備えた大規模モデルまで、チュートリアルとすぐに使えるスクリプトがここにあります

Jul 24, 2024 pm 08:13 PM

ベアメタルから 700 億のパラメータを備えた大規模モデルまで、チュートリアルとすぐに使えるスクリプトがここにあります

Jul 24, 2024 pm 08:13 PM

LLM が大量のデータを使用して大規模なコンピューター クラスターでトレーニングされていることはわかっています。このサイトでは、LLM トレーニング プロセスを支援および改善するために使用される多くの方法とテクノロジが紹介されています。今日、私たちが共有したいのは、基礎となるテクノロジーを深く掘り下げ、オペレーティング システムさえ持たない大量の「ベア メタル」を LLM のトレーニング用のコンピューター クラスターに変える方法を紹介する記事です。この記事は、機械がどのように考えるかを理解することで一般的な知能の実現に努めている AI スタートアップ企業 Imbue によるものです。もちろん、オペレーティング システムを持たない大量の「ベア メタル」を LLM をトレーニングするためのコンピューター クラスターに変換することは、探索と試行錯誤に満ちた簡単なプロセスではありませんが、Imbue は最終的に 700 億のパラメータを備えた LLM のトレーニングに成功しました。プロセスが蓄積する

AIの活用 | AIが一人暮らしの女の子の生活ビデオブログを作成、3日間で数万件の「いいね!」を獲得

Aug 07, 2024 pm 10:53 PM

AIの活用 | AIが一人暮らしの女の子の生活ビデオブログを作成、3日間で数万件の「いいね!」を獲得

Aug 07, 2024 pm 10:53 PM

Machine Power Report 編集者: Yang Wen 大型モデルや AIGC に代表される人工知能の波は、私たちの生活や働き方を静かに変えていますが、ほとんどの人はまだその使い方を知りません。そこで、直感的で興味深く、簡潔な人工知能のユースケースを通じてAIの活用方法を詳しく紹介し、皆様の思考を刺激するコラム「AI in Use」を立ち上げました。また、読者が革新的な実践的な使用例を提出することも歓迎します。ビデオリンク: https://mp.weixin.qq.com/s/2hX_i7li3RqdE4u016yGhQ 最近、Xiaohongshu で一人暮らしの女の子の生活 vlog が人気になりました。イラスト風のアニメーションといくつかの癒しの言葉を組み合わせれば、数日で簡単に習得できます。

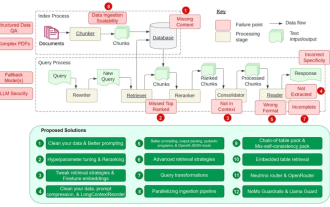

RAG の 12 の問題点を数え上げ、NVIDIA シニア アーキテクトが解決策を教える

Jul 11, 2024 pm 01:53 PM

RAG の 12 の問題点を数え上げ、NVIDIA シニア アーキテクトが解決策を教える

Jul 11, 2024 pm 01:53 PM

検索拡張生成 (RAG) は、検索を使用して言語モデルを強化する手法です。具体的には、言語モデルは回答を生成する前に、広範な文書データベースから関連情報を取得し、この情報を使用して生成プロセスをガイドします。このテクノロジーにより、コンテンツの精度と関連性が大幅に向上し、幻覚の問題を効果的に軽減し、知識の更新速度が向上し、コンテンツ生成の追跡可能性が向上します。 RAG は間違いなく、人工知能研究の中で最もエキサイティングな分野の 1 つです。 RAGについて詳しくは、当サイトのコラム記事「大型モデルの欠点を補うことに特化したRAGの新展開とは?」を参照してください。このレビューはそれを明確に説明しています。」しかし、RAG は完璧ではなく、ユーザーはそれを使用するときにいくつかの「問題点」に遭遇することがよくあります。最近、NVIDIA の生成 AI 高度なソリューション

2024 年の AEC/O 業界の 5 つの主要な開発トレンド

Apr 19, 2024 pm 02:50 PM

2024 年の AEC/O 業界の 5 つの主要な開発トレンド

Apr 19, 2024 pm 02:50 PM

AEC/O(Architecture, Engineering & Construction/Operation)とは、建設業界における建築設計、工学設計、建設、運営を提供する総合的なサービスを指します。 2024 年、AEC/O 業界は技術の進歩の中で変化する課題に直面しています。今年は先進技術の統合が見込まれ、設計、建設、運用におけるパラダイムシフトが到来すると予想されています。これらの変化に対応して、業界は急速に変化する世界のニーズに適応するために、作業プロセスを再定義し、優先順位を調整し、コラボレーションを強化しています。 AEC/O 業界の次の 5 つの主要なトレンドが 2024 年の主要テーマとなり、より統合され、応答性が高く、持続可能な未来に向けて進むことが推奨されます: 統合サプライ チェーン、スマート製造