史上最も効率的な Python クローラー フレームワーク (推奨)

Web クローラー (Web スパイダー、Web ロボット、FOAF コミュニティでは一般に Web ページ チェイサーとも呼ばれます) は、特定のルールに自動的に従う Web クローラーの一種です。 World Wide Web から情報をクロールするプログラムまたはスクリプト。さあ、これを一緒に学びましょう。

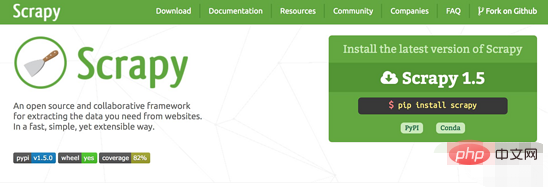

1.Scrapy

Scrapy は、Web サイトのデータをクロールし、構造化データを抽出するために作成されたアプリケーション フレームワークです。データマイニング、情報処理、履歴データの保存などの一連のプログラムで使用できます。 。このフレームワークを使用すると、Amazon の商品情報などのデータを簡単にクロールできます。

プロジェクトアドレス: https://scrapy.org/

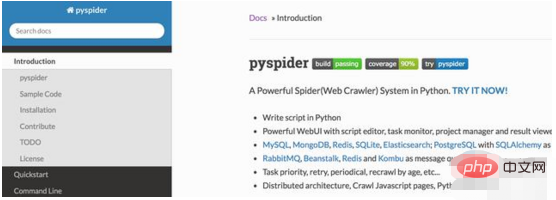

2.PySpider

pyspider はPython で実装された強力な Web クローラー システムです。スクリプトを作成し、機能をスケジュールし、ブラウザー インターフェイス上でリアルタイムでクロール結果を表示できます。バックエンドは一般的に使用されるデータベースを使用してクロール結果を保存し、タイミングも設定できます。タスクとタスクの優先順位など。

プロジェクトアドレス: https://github.com/binux/pyspider

3.Crawley

Crawley は、対応する Web サイトのコンテンツを高速にクロールでき、リレーショナルおよび非リレーショナル データベースをサポートし、データを JSON、XML などにエクスポートできます。

4.Portia

Portia は、プログラミングの知識がなくても Web サイトをクロールできるオープンソースのビジュアル クローラー ツールです。興味のあるページに注釈を付けるだけで、Portia が同様のページからデータを抽出するスパイダーを作成します。

5.Newspaper

新聞は、ニュース、記事の抽出、内容分析に使用できます。マルチスレッドの使用、10 を超える言語のサポートなど。 #プロジェクトアドレス: https://github.com/codelucas/newspaper

#プロジェクトアドレス: https://github.com/codelucas/newspaper

Beautiful Soup は、HTML または XML ファイルからデータを抽出できる Python ライブラリです。お気に入りのコンバータを通じて、ドキュメントのナビゲーション、検索、および変更の通常の方法を実現できます。Beautiful Soup を使用すると、数時間、さらには数日の作業時間を節約できます。

プロジェクトアドレス: https://www.crummy.com/software/BeautifulSoup/bs4/doc/

プロジェクトアドレス: https://www.crummy.com/software/BeautifulSoup/bs4/doc/

Grab は、Web スクレイパーを構築するための Python フレームワークです。 Grab を使用すると、単純な 5 行のスクリプトから数百万の Web ページを処理する複雑な非同期 Web サイト スクレイパーまで、さまざまな複雑さの Web スクレイパーを構築できます。 Grab は、ネットワーク リクエストを実行し、HTML ドキュメントの DOM ツリーと対話するなど、受信したコンテンツを処理するための API を提供します。

プロジェクトアドレス: http://docs.grablib.org/en/latest/#grab-spider-user-manual

プロジェクトアドレス: http://docs.grablib.org/en/latest/#grab-spider-user-manual

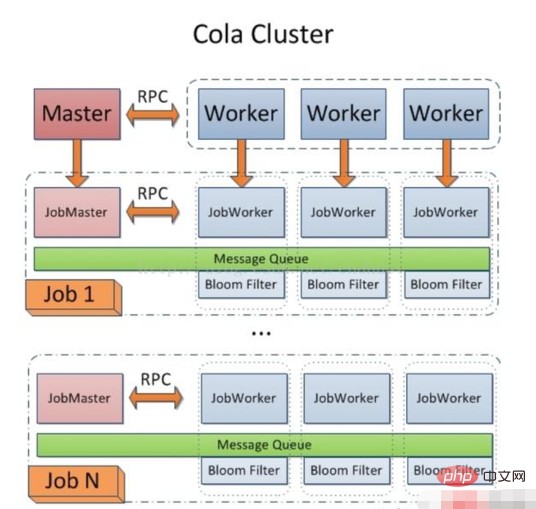

Cola は分散クローラー フレームワークであり、ユーザーは分散操作の詳細を意識することなく、いくつかの特定の関数を記述するだけで済みます。タスクは複数のマシンに自動的に分散され、プロセス全体がユーザーに透過的に行われます。

プロジェクト アドレス: https://github.com/chineking/cola

プロジェクト アドレス: https://github.com/chineking/cola

お読みいただきありがとうございます。多くのメリットがあることを願っています。

転載先: https://www.toutiao.com/i6560240315519730190/

推奨チュートリアル: "

python チュートリアル以上が史上最も効率的な Python クローラー フレームワーク (推奨)の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7380

7380

15

15

1628

1628

14

14

1357

1357

52

52

1267

1267

25

25

1216

1216

29

29

携帯電話でXMLをPDFに変換するとき、変換速度は高速ですか?

Apr 02, 2025 pm 10:09 PM

携帯電話でXMLをPDFに変換するとき、変換速度は高速ですか?

Apr 02, 2025 pm 10:09 PM

Mobile XMLからPDFへの速度は、次の要因に依存します。XML構造の複雑さです。モバイルハードウェア構成変換方法(ライブラリ、アルゴリズム)コードの品質最適化方法(効率的なライブラリ、アルゴリズムの最適化、キャッシュデータ、およびマルチスレッドの利用)。全体として、絶対的な答えはなく、特定の状況に従って最適化する必要があります。

携帯電話のXMLファイルをPDFに変換する方法は?

Apr 02, 2025 pm 10:12 PM

携帯電話のXMLファイルをPDFに変換する方法は?

Apr 02, 2025 pm 10:12 PM

単一のアプリケーションで携帯電話でXMLからPDF変換を直接完了することは不可能です。クラウドサービスを使用する必要があります。クラウドサービスは、2つのステップで達成できます。1。XMLをクラウド内のPDFに変換し、2。携帯電話の変換されたPDFファイルにアクセスまたはダウンロードします。

C言語合計の機能は何ですか?

Apr 03, 2025 pm 02:21 PM

C言語合計の機能は何ですか?

Apr 03, 2025 pm 02:21 PM

C言語に組み込みの合計機能はないため、自分で書く必要があります。合計は、配列を通過して要素を蓄積することで達成できます。ループバージョン:合計は、ループとアレイの長さを使用して計算されます。ポインターバージョン:ポインターを使用してアレイ要素を指し示し、効率的な合計が自己概要ポインターを通じて達成されます。アレイバージョンを動的に割り当てます:[アレイ]を動的に割り当ててメモリを自分で管理し、メモリの漏れを防ぐために割り当てられたメモリが解放されます。

XMLをPDFに変換できるモバイルアプリはありますか?

Apr 02, 2025 pm 08:54 PM

XMLをPDFに変換できるモバイルアプリはありますか?

Apr 02, 2025 pm 08:54 PM

XMLをPDFに直接変換するアプリケーションは、2つの根本的に異なる形式であるため、見つかりません。 XMLはデータの保存に使用され、PDFはドキュメントを表示するために使用されます。変換を完了するには、PythonやReportLabなどのプログラミング言語とライブラリを使用して、XMLデータを解析してPDFドキュメントを生成できます。

XMLを写真に変換する方法

Apr 03, 2025 am 07:39 AM

XMLを写真に変換する方法

Apr 03, 2025 am 07:39 AM

XMLは、XSLTコンバーターまたは画像ライブラリを使用して画像に変換できます。 XSLTコンバーター:XSLTプロセッサとスタイルシートを使用して、XMLを画像に変換します。画像ライブラリ:PILやImageMagickなどのライブラリを使用して、形状やテキストの描画などのXMLデータから画像を作成します。

画像に変換されたXMLのサイズを制御する方法は?

Apr 02, 2025 pm 07:24 PM

画像に変換されたXMLのサイズを制御する方法は?

Apr 02, 2025 pm 07:24 PM

XMLを介して画像を生成するには、XMLのメタデータ(サイズ、色)に基づいて画像を生成するために、ブリッジとしてグラフライブラリ(枕やJFreechartなど)を使用する必要があります。画像のサイズを制御するための鍵は、< width>の値を調整することです。および< height> XMLのタグ。ただし、実際のアプリケーションでは、XML構造の複雑さ、グラフ描画の細かさ、画像生成の速度とメモリ消費の速度、および画像形式の選択はすべて、生成された画像サイズに影響を与えます。したがって、グラフィックライブラリに熟練したXML構造を深く理解し、最適化アルゴリズムや画像形式の選択などの要因を考慮する必要があります。

XML形式を開く方法

Apr 02, 2025 pm 09:00 PM

XML形式を開く方法

Apr 02, 2025 pm 09:00 PM

ほとんどのテキストエディターを使用して、XMLファイルを開きます。より直感的なツリーディスプレイが必要な場合は、酸素XMLエディターやXMLSPYなどのXMLエディターを使用できます。プログラムでXMLデータを処理する場合、プログラミング言語(Pythonなど)やXMLライブラリ(XML.ETREE.ELEMENTTREEなど)を使用して解析する必要があります。

推奨されるXMLフォーマットツール

Apr 02, 2025 pm 09:03 PM

推奨されるXMLフォーマットツール

Apr 02, 2025 pm 09:03 PM

XMLフォーマットツールは、読みやすさと理解を向上させるために、ルールに従ってコードを入力できます。ツールを選択するときは、カスタマイズ機能、特別な状況の処理、パフォーマンス、使いやすさに注意してください。一般的に使用されるツールタイプには、オンラインツール、IDEプラグイン、コマンドラインツールが含まれます。