MySQL + ES + MongoDB と互換性を持たせて、数億のデータのディープ ページングを実現するにはどうすればよいでしょうか?

インタビューの質問と実際の経験

インタビュー質問: データ量が多い場合にディープ ページングを実現するにはどうすればよいですか?面接中や面接の準備中に、上記の質問に遭遇することがあります。基本的に、データベースとテーブルを分割してインデックスを構築するという答えがほとんどです。これは非常に標準的な正解ですが、現実は常に難しいため、面接官は通常、プロジェクトのスケジュールも人員も不足している中で、どうすればディープ ページングを実現できるか、と尋ねます。 この時期、実務経験のない学生は基本的に無感覚なので、聞いてください。

痛ましい教訓

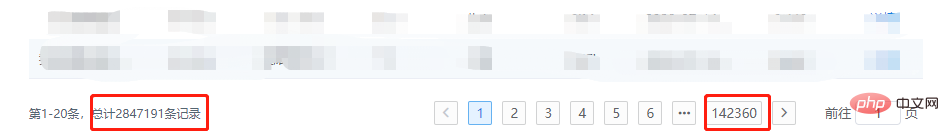

まず最初に明確にしておきたいのは、深度ページングは実行できますが、前の画像:

ランダムな深さのページ ジャンプが許可されない理由

ランダムな深さのページ ジャンプが技術的な観点から許可されない理由について簡単に説明しましょう、またはディープ ページングが推奨されないのはなぜですか?MySQL

ページングの基本原則:SELECT * FROM test ORDER BY id DESC LIMIT 10000, 20;

MongoDB

ページングの基本原理:db.t_data.find().limit(5).skip(5);

ElasticSearch

ビジネスの観点から見ると、ElasticSearch は一般的なデータベースではなく、検索エンジンです。フィルター条件で目的のデータが見つからない場合、深いページングを続けると、必要なデータは見つかりません。一歩下がって、クエリ用のデータベースとして ES を使用すると、ページング時に間違いなく max_result_window の制限に遭遇します。わかりましたか? 当局は最大値を教えてくれますオフセット制限は 10,000 です。 クエリ プロセス:- ページあたり 10 項目でページ 501 をクエリすると、クライアントは特定のノードにリクエストを送信します

- このノードはデータを各シャードにブロードキャストし、各シャードは最初の 5010 個のデータをクエリします。

- クエリ結果はノードに返され、データが統合されます

- クライアントに戻る

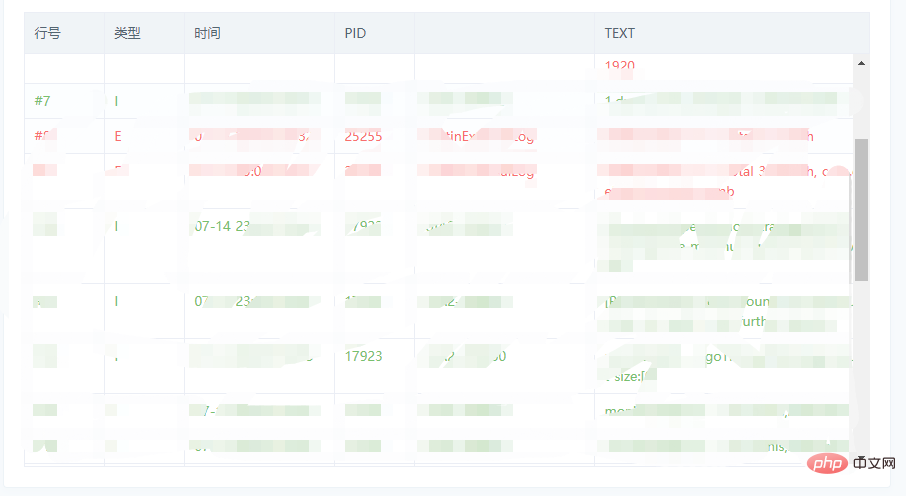

もう一度製品と合わせてください

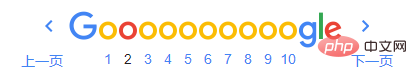

よく言われるように、テクノロジーで解決できない問題はビジネスで解決する必要があります。 インターンシップ中、私は製品が悪であると信じていたため、ディープ ページングとページ ジャンプを実装する必要がありました。今度は混乱を修正し、ビジネスに次の変更を加える必要があります: 期間などのデフォルトのフィルタ条件をできるだけ追加します。表示されるデータ量を減らすためです。ページジャンプの表示方法を変更し、スクロール表示に変更します。または狭い範囲でページをジャンプする場合スクロール表示参考図:

##一般的な解決策短期間での迅速な解決策には、主に次の点が含まれます。

- 必須: 並べ替えフィールドとフィルター条件の場合、インデックスを設定する必要があります

- コア: 狭い範囲のページ番号の既知のデータ、またはローリング ロードの既知のデータを使用して、オフセットを削減します

- 補足: 対処が難しい状況に遭遇した場合は、過剰なデータを取得してある程度まで傍受することもでき、パフォーマンスへの影響は大きくありません

元のページング SQL:

# 第一页 SELECT * FROM `year_score` where `year` = 2017 ORDER BY id limit 0, 20; # 第N页 SELECT * FROM `year_score` where `year` = 2017 ORDER BY id limit (N - 1) * 20, 20;

コンテキストを通じて、次のように書き換えられます:

# XXXX 代表已知的数据 SELECT * FROM `year_score` where `year` = 2017 and id > XXXX ORDER BY id limit 20;

在 没内鬼,来点干货!SQL优化和诊断 一文中提到过,LIMIT会在满足条件下停止查询,因此该方案的扫描总量会急剧减少,效率提升Max!

ES

方案和MySQL相同,此时我们就可以随用所欲的使用 FROM-TO Api,而且不用考虑最大限制的问题。

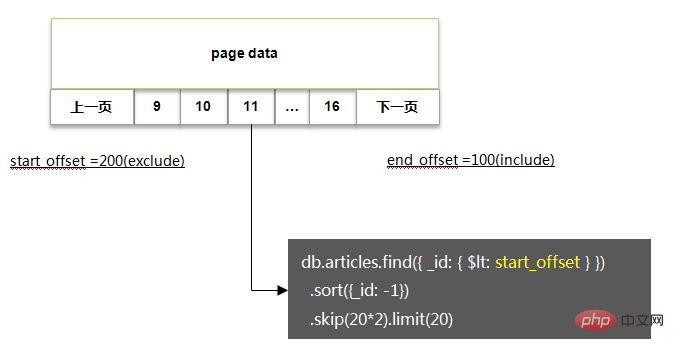

MongoDB

方案基本类似,基本代码如下:

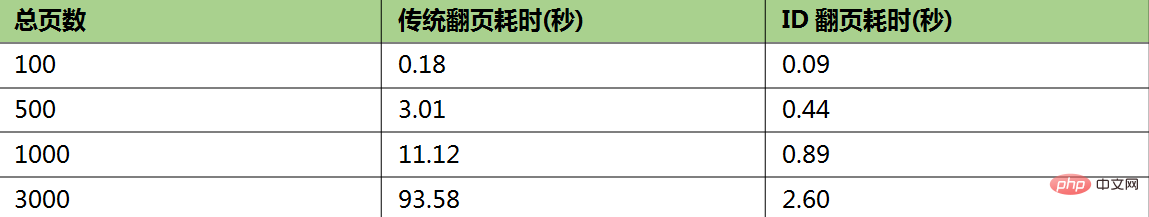

相关性能测试:

如果非要深度随机跳页

如果你没有杠过产品经理,又该怎么办呢,没关系,还有一丝丝的机会。

在 SQL优化 一文中还提到过MySQL深度分页的处理技巧,代码如下:

# 反例(耗时129.570s) select * from task_result LIMIT 20000000, 10; # 正例(耗时5.114s) SELECT a.* FROM task_result a, (select id from task_result LIMIT 20000000, 10) b where a.id = b.id; # 说明 # task_result表为生产环境的一个表,总数据量为3400万,id为主键,偏移量达到2000万

该方案的核心逻辑即基于聚簇索引,在不通过回表的情况下,快速拿到指定偏移量数据的主键ID,然后利用聚簇索引进行回表查询,此时总量仅为10条,效率很高。

因此我们在处理MySQL,ES,MongoDB时,也可以采用一样的办法:

限制获取的字段,只通过筛选条件,深度分页获取主键ID

通过主键ID定向查询需要的数据

瑕疵:当偏移量非常大时,耗时较长,如文中的 5s

推荐教程:《MySQL教程》

文章来源:https://juejin.im/post/5f0de4d06fb9a07e8a19a641

以上がMySQL + ES + MongoDB と互換性を持たせて、数億のデータのディープ ページングを実現するにはどうすればよいでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7445

7445

15

15

1372

1372

52

52

76

76

11

11

12

12

6

6

rootとしてmysqlにログインできません

Apr 08, 2025 pm 04:54 PM

rootとしてmysqlにログインできません

Apr 08, 2025 pm 04:54 PM

ルートとしてMySQLにログインできない主な理由は、許可の問題、構成ファイルエラー、一貫性のないパスワード、ソケットファイルの問題、またはファイアウォール傍受です。解決策には、構成ファイルのBind-Addressパラメーターが正しく構成されているかどうかを確認します。ルートユーザー許可が変更されているか削除されてリセットされているかを確認します。ケースや特殊文字を含むパスワードが正確であることを確認します。ソケットファイルの許可設定とパスを確認します。ファイアウォールがMySQLサーバーへの接続をブロックすることを確認します。

MySQLテーブルロックテーブルを変更するかどうか

Apr 08, 2025 pm 05:06 PM

MySQLテーブルロックテーブルを変更するかどうか

Apr 08, 2025 pm 05:06 PM

MySQLがテーブル構造を変更すると、メタデータロックが通常使用され、テーブルがロックされる可能性があります。ロックの影響を減らすために、次の測定値をとることができます。1。オンラインDDLでテーブルを使用できます。 2。バッチで複雑な変更を実行します。 3.小規模またはオフピーク期間中に操作します。 4. PT-OSCツールを使用して、より細かい制御を実現します。

MySQLユーザーとデータベースの関係

Apr 08, 2025 pm 07:15 PM

MySQLユーザーとデータベースの関係

Apr 08, 2025 pm 07:15 PM

MySQLデータベースでは、ユーザーとデータベースの関係は、アクセス許可と表によって定義されます。ユーザーには、データベースにアクセスするためのユーザー名とパスワードがあります。許可は助成金コマンドを通じて付与され、テーブルはCreate Tableコマンドによって作成されます。ユーザーとデータベースの関係を確立するには、データベースを作成し、ユーザーを作成してから許可を付与する必要があります。

MySQLはAndroidで実行できますか

Apr 08, 2025 pm 05:03 PM

MySQLはAndroidで実行できますか

Apr 08, 2025 pm 05:03 PM

MySQLはAndroidで直接実行できませんが、次の方法を使用して間接的に実装できます。Androidシステムに構築されたLightWeight Database SQLiteを使用して、別のサーバーを必要とせず、モバイルデバイスアプリケーションに非常に適したリソース使用量が少ない。 MySQLサーバーにリモートで接続し、データの読み取りと書き込みのためにネットワークを介してリモートサーバー上のMySQLデータベースに接続しますが、強力なネットワーク依存関係、セキュリティの問題、サーバーコストなどの短所があります。

mysqlは支払う必要がありますか

Apr 08, 2025 pm 05:36 PM

mysqlは支払う必要がありますか

Apr 08, 2025 pm 05:36 PM

MySQLには、無料のコミュニティバージョンと有料エンタープライズバージョンがあります。コミュニティバージョンは無料で使用および変更できますが、サポートは制限されており、安定性要件が低く、技術的な能力が強いアプリケーションに適しています。 Enterprise Editionは、安定した信頼性の高い高性能データベースを必要とするアプリケーションに対する包括的な商業サポートを提供し、サポートの支払いを喜んでいます。バージョンを選択する際に考慮される要因には、アプリケーションの重要性、予算編成、技術スキルが含まれます。完璧なオプションはなく、最も適切なオプションのみであり、特定の状況に応じて慎重に選択する必要があります。

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

MySQLデータベースパフォーマンス最適化ガイドリソース集約型アプリケーションでは、MySQLデータベースが重要な役割を果たし、大規模なトランザクションの管理を担当しています。ただし、アプリケーションのスケールが拡大すると、データベースパフォーマンスのボトルネックが制約になることがよくあります。この記事では、一連の効果的なMySQLパフォーマンス最適化戦略を検討して、アプリケーションが高負荷の下で効率的で応答性の高いままであることを保証します。実際のケースを組み合わせて、インデックス作成、クエリ最適化、データベース設計、キャッシュなどの詳細な主要なテクノロジーを説明します。 1.データベースアーキテクチャの設計と最適化されたデータベースアーキテクチャは、MySQLパフォーマンスの最適化の基礎です。いくつかのコア原則は次のとおりです。適切なデータ型を選択し、ニーズを満たす最小のデータ型を選択すると、ストレージスペースを節約するだけでなく、データ処理速度を向上させることもできます。

RDS MySQL Redshift Zero ETLとの統合

Apr 08, 2025 pm 07:06 PM

RDS MySQL Redshift Zero ETLとの統合

Apr 08, 2025 pm 07:06 PM

データ統合の簡素化:AmazonrdsmysqlとRedshiftのゼロETL統合効率的なデータ統合は、データ駆動型組織の中心にあります。従来のETL(抽出、変換、負荷)プロセスは、特にデータベース(AmazonrdsmysQlなど)をデータウェアハウス(Redshiftなど)と統合する場合、複雑で時間がかかります。ただし、AWSは、この状況を完全に変えたゼロETL統合ソリューションを提供し、RDSMYSQLからRedshiftへのデータ移行のための簡略化されたほぼリアルタイムソリューションを提供します。この記事では、RDSMysQl Zero ETLのRedshiftとの統合に飛び込み、それがどのように機能するか、それがデータエンジニアと開発者にもたらす利点を説明します。

MySQLのクエリ最適化は、特に大規模なデータセットを扱う場合、データベースのパフォーマンスを改善するために不可欠です

Apr 08, 2025 pm 07:12 PM

MySQLのクエリ最適化は、特に大規模なデータセットを扱う場合、データベースのパフォーマンスを改善するために不可欠です

Apr 08, 2025 pm 07:12 PM

1.正しいインデックスを使用して、データの量を削減してデータ検索をスピードアップしました。テーブルの列を複数回検索する場合は、その列のインデックスを作成します。あなたまたはあなたのアプリが基準に従って複数の列からのデータが必要な場合、複合インデックス2を作成します2。選択した列のみを避けます。必要な列のすべてを選択すると、より多くのサーバーメモリを使用する場合にのみサーバーが遅くなり、たとえばテーブルにはcreated_atやupdated_atやupdated_atなどの列が含まれます。