データ クリーニングには何が含まれますか?

データクリーニング手法には、1. 処理対象のデータを一定のルールに従ってボックスに入れてテストするビニング手法、2. 関数データを使用して描画する回帰手法があります。 3. クラスタリング手法は、抽象オブジェクトを異なるセットにグループ化し、そのセット内で予期しない孤立点を見つけることです。

#この記事の動作環境: Windows 7 システム、Dell G3 コンピューター。

データ クリーニングには何が含まれますか?

データのクリーニングには、ビニング法、クラスタリング法、回帰法という 3 つの方法があります。

1. ビニング手法

はよく使われる手法で、処理が必要なデータを一定のルールに従ってボックスに入れ、各データをテストするいわゆるビニング手法です。ボックス内にデータを配置し、データ内の各ボックスの実際の状況に基づいてデータを処理する方法を採用します。

2. 回帰手法

回帰手法では、関数のデータを使用して画像を描画し、画像を平滑化します。回帰手法には 2 種類あり、1 つは単線形回帰、もう 1 つは多重線形回帰です。単線形回帰は、一方の属性をもう一方の属性から予測できる、2 つの属性間の最適な直線を見つけることです。多重線形回帰は、ノイズを除去できるように、データを多次元曲面に適合させるための多くの属性を見つけることです。

3. クラスタリング手法

クラスタリング手法のワークフローは比較的単純ですが、操作は確かに複雑です。いわゆるクラスタリング手法は、抽象オブジェクトを異なる 、のセットにグループ化することです。セット内で予期しない孤立点を見つけます。これらの孤立点はノイズです。このようにして、ノイズを直接見つけて除去することができます。

拡張情報:

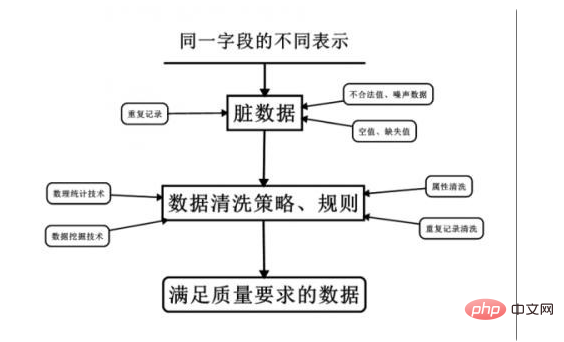

名前からわかるように、データ クリーニングとは、「汚れ」を「洗い流す」ことです。データ ファイルの修正 データの整合性のチェック、無効な値や欠損値の処理など、特定可能なエラーに対する最後の手段の手順。

データウェアハウス内のデータは、ある特定のテーマに沿ったデータの集合体であり、複数の業務システムから抽出されたデータであり、過去のデータも含まれているため、誤ったデータが含まれることは避けられません。これらの誤ったデータや競合するデータは明らかに望ましくないものであり、「ダーティ データ」と呼ばれます。

特定のルールに従って「汚れたデータ」を「洗い流す」必要があります。これがデータ クリーニングです。データクリーニングの業務は、要件を満たさないデータをフィルタリングし、フィルタリング結果を担当事業部に渡し、事業部での除外や修正が行われているかを確認してから抽出することです。

要件を満たさないデータは、主に不完全データ、誤ったデータ、重複データの 3 つのカテゴリに分類されます。データクリーニングはアンケート調査とは異なり、入力後のデータクリーニングは手作業ではなくコンピュータで行うのが一般的です。

関連知識の詳細については、FAQ 列をご覧ください。

以上がデータ クリーニングには何が含まれますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1666

1666

14

14

1425

1425

52

52

1325

1325

25

25

1272

1272

29

29

1252

1252

24

24

pandas でデータ クリーニングを実装する方法は何ですか?

Nov 22, 2023 am 11:19 AM

pandas でデータ クリーニングを実装する方法は何ですか?

Nov 22, 2023 am 11:19 AM

データ クリーニングの実装にパンダが使用する方法には、1. 欠損値の処理、2. 重複値の処理、3. データ型変換、4. 外れ値の処理、5. データの正規化、6. データのフィルタリング、7. データの集計とグループ化が含まれます。 ; 8 、ピボットテーブルなど詳細な紹介: 1. 欠損値の処理、Pandas は欠損値を処理するためのさまざまなメソッドを提供します。欠損値の場合は、「fillna()」メソッドを使用して、平均値、中央値などの特定の値を入力できます。2繰り返し値の処理、データ クリーニングでは、重複した値の削除などが非常に一般的な手順です。

データ クリーニングに Java および Linux スクリプト操作を使用する方法

Oct 05, 2023 am 11:57 AM

データ クリーニングに Java および Linux スクリプト操作を使用する方法

Oct 05, 2023 am 11:57 AM

データ クリーニングに Java および Linux スクリプト操作を使用する方法には、特定のコード サンプルが必要です。データ クリーニングは、データ分析プロセスの非常に重要なステップです。これには、データのフィルタリング、無効なデータのクリア、欠損値の処理などの操作が含まれます。この記事では、データ クリーニングに Java スクリプトと Linux スクリプトを使用する方法を紹介し、具体的なコード例を示します。 1. データ クリーニングに Java を使用する Java は、ソフトウェア開発で広く使用されている高級プログラミング言語で、豊富なクラス ライブラリと強力な機能を提供しており、データ クリーニングに非常に適しています。

Python の XML データ クリーニング テクノロジ

Aug 07, 2023 pm 03:57 PM

Python の XML データ クリーニング テクノロジ

Aug 07, 2023 pm 03:57 PM

Python による XML データ クリーニング テクノロジの紹介: インターネットの急速な発展に伴い、データの生成はますます高速になっています。 XML (Extensible Markup Language) は、広く使用されているデータ交換形式として、さまざまな分野で重要な役割を果たしています。ただし、XML データの複雑さと多様性により、大量の XML データの効果的なクリーニングと処理は非常に困難な作業になっています。幸いなことに、Python には、XML データ処理を簡単に実行できる強力なライブラリとツールがいくつか用意されています。

pandas を使用したデータのクリーニングと前処理のテクニックを探索する

Jan 13, 2024 pm 12:49 PM

pandas を使用したデータのクリーニングと前処理のテクニックを探索する

Jan 13, 2024 pm 12:49 PM

pandas を使用したデータ クリーニングと前処理の方法に関するディスカッション はじめに: データ分析と機械学習において、データ クリーニングと前処理は非常に重要なステップです。 pandas は Python の強力なデータ処理ライブラリとして、豊富な機能と柔軟な操作を備えており、データの効率的なクリーンアップと前処理に役立ちます。この記事では、一般的に使用されるいくつかの pandas メソッドを検討し、対応するコード例を示します。 1. データの読み取り まず、データ ファイルを読み取る必要があります。 pandas は多くの機能を提供します

MySQL を使用してデータ クリーニングと ETL を開発したプロジェクトの経験についてのディスカッション

Nov 03, 2023 pm 05:33 PM

MySQL を使用してデータ クリーニングと ETL を開発したプロジェクトの経験についてのディスカッション

Nov 03, 2023 pm 05:33 PM

MySQL を使用してデータ クリーニングと ETL を開発したプロジェクトの経験に関するディスカッション 1. はじめに 今日のビッグ データ時代では、データ クリーニングと ETL (抽出、変換、ロード) はデータ処理において不可欠なリンクです。データ クリーニングとは、データの品質と精度を向上させるために元のデータをクリーニング、修復、変換することを指します。ETL は、クリーニングされたデータを抽出、変換し、ターゲット データベースにロードするプロセスです。この記事では、MySQL を使用してデータ クリーニングと ETL エクスペリエンスを開発する方法について説明します。

PHP を使用して従業員勤怠データ クリーニング ツールを作成するにはどうすればよいですか?

Sep 25, 2023 pm 01:43 PM

PHP を使用して従業員勤怠データ クリーニング ツールを作成するにはどうすればよいですか?

Sep 25, 2023 pm 01:43 PM

PHP を使用して従業員勤怠データ クリーニング ツールを作成するにはどうすればよいですか?現代の企業では、勤怠データの正確性と完全性が管理と給与支払いの両方にとって非常に重要です。ただし、さまざまな理由により、出席データには誤った情報、欠落している情報、または一貫性のない情報が含まれる場合があります。したがって、従業員勤怠データのクリーニング ツールの開発は必要なタスクの 1 つとなっています。この記事では、PHP を使用してそのようなツールを作成する方法を説明し、いくつかの具体的なコード例を示します。まず、従業員勤怠データ クリーニング ツールが満たす必要がある機能要件を明確にします。

PHP機能のデータクリーニング機能

May 18, 2023 pm 04:21 PM

PHP機能のデータクリーニング機能

May 18, 2023 pm 04:21 PM

Web サイトやアプリケーションの開発が一般的になるにつれて、ユーザーが入力したデータを保護することがますます重要になっています。 PHP では、ユーザーが指定したデータが正しく、安全で、合法であることを確認するために、多くのデータ クリーニングおよび検証機能が利用できます。この記事では、一般的に使用されるいくつかの PHP 関数と、それらの関数を使用してデータをクリーンアップしてセキュリティの問題を軽減する方法を紹介します。 filter_var() filter_var() 関数は、電子メール、URL、整数、浮動小数点数など、さまざまなタイプのデータを検証およびクリーニングするために使用できます。

C++ ビッグ データ開発におけるデータ クリーニングの問題を解決するにはどうすればよいですか?

Aug 25, 2023 pm 04:12 PM

C++ ビッグ データ開発におけるデータ クリーニングの問題を解決するにはどうすればよいですか?

Aug 25, 2023 pm 04:12 PM

C++ ビッグ データ開発におけるデータ クリーニングの問題を解決するにはどうすればよいですか? はじめに: ビッグ データ開発において、データ クリーニングは非常に重要なステップです。正しく、完全で、構造化されたデータは、アルゴリズム分析とモデル トレーニングの基礎となります。この記事では、C++ を使用してビッグ データ開発におけるデータ クリーニングの問題を解決する方法を紹介し、コード例を通じて具体的な実装方法を示します。 1. データ クリーニングの概念 データ クリーニングとは、元のデータを後続の分析と処理に適したものにするための前処理を指します。主に次の側面が含まれます: 欠損値の処理: 欠損値の削除または埋め込み