Apache Avro データを解析する方法について話しましょう (例付きで説明)

Apache Avro データを解析するにはどうすればよいですか?この記事では、シリアル化して Avro データを生成する方法、デシリアライズして Avro データを解析する方法、FlinkSQL を使用して Avro データを解析する方法を紹介します。

インターネットの急速な発展に伴い、クラウド コンピューティング、ビッグデータ、人工知能 AI、モノのインターネットなどの最先端テクノロジーがハイテクの主流になりました。電子商取引ウェブサイト、顔認識、無人運転、スマートホーム、スマートシティなどの今日の時代のテクノロジーは、人々の日用品、食料、住居、交通手段を容易にするだけでなく、その舞台裏では常に大きな問題が存在します。さまざまなシステム プラットフォームによって収集、消去、分析されるデータの量が多く、低遅延、高スループット、データのセキュリティを確保することが特に重要です。Apache Avro 自体は、バイナリ送信のためにスキーマを通じてシリアル化されています。データの高速伝送を保証する一方で、データのセキュリティも確保します。avro は現在、さまざまな業界でますます広く使用されています。avro データをどのように処理および解析するかが特に重要です。この記事では、avro データを生成する方法を説明します。 avro データをシリアル化して分析に FlinkSQL を使用します。

この記事は avro 解析のデモです。現在、FlinkSQL は単純な avro データ解析にのみ適しています。複雑なネストされた avro データは当面サポートされていません。

シーンの紹介

この記事では主に次の 3 つの主要な内容を紹介します。

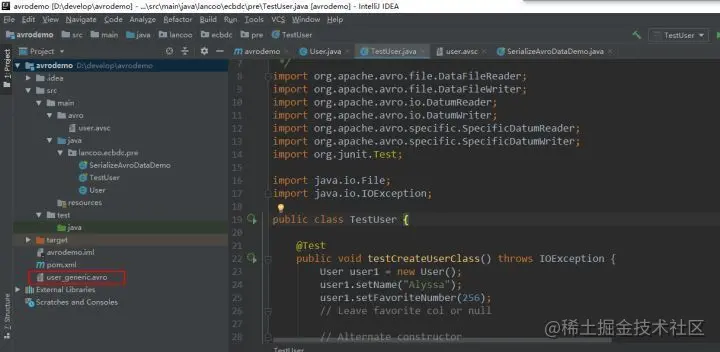

Avro データをシリアル化して生成する方法

-

Avro データを逆シリアル化して解析する方法

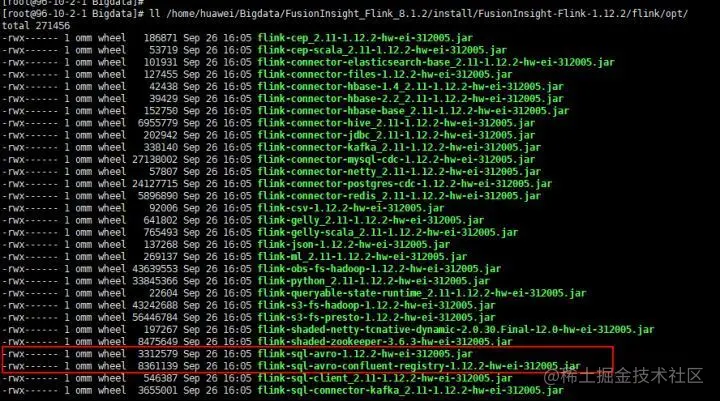

FlinkSQL を使用して Avro データを解析する方法

- avro とは何かを理解するには、Apache avro 公式 Web サイトのクイック スタート ガイドを参照してください。

- avro アプリケーション シナリオを理解する

1. 新しい avro maven プロジェクトを作成し、pom 依存関係を構成します

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.huawei.bigdata</groupId>

<artifactId>avrodemo</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.apache.avro</groupId>

<artifactId>avro</artifactId>

<version>1.8.1</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.avro</groupId>

<artifactId>avro-maven-plugin</artifactId>

<version>1.8.1</version>

<executions>

<execution>

<phase>generate-sources</phase>

<goals>

<goal>schema</goal>

</goals>

<configuration>

<sourceDirectory>${project.basedir}/src/main/avro/</sourceDirectory>

<outputDirectory>${project.basedir}/src/main/java/</outputDirectory>

</configuration>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<source>1.6</source>

<target>1.6</target>

</configuration>

</plugin>

</plugins>

</build>

</project>##プロジェクト######。#

保存提交任务

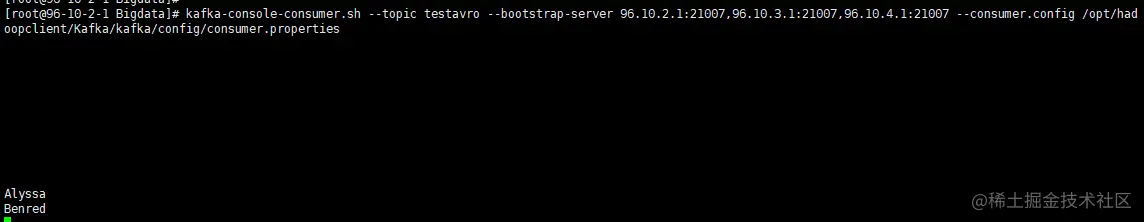

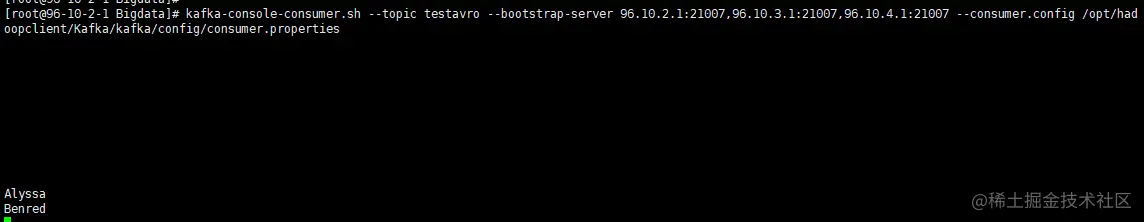

9、查看对应topic中是否有数据

FlinkSQL解析avro数据成功。

【推荐:Apache使用教程】

以上がApache Avro データを解析する方法について話しましょう (例付きで説明)の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7672

7672

15

15

1393

1393

52

52

1206

1206

24

24

91

91

11

11

ApacheでCGIディレクトリを設定する方法

Apr 13, 2025 pm 01:18 PM

ApacheでCGIディレクトリを設定する方法

Apr 13, 2025 pm 01:18 PM

ApacheでCGIディレクトリを設定するには、次の手順を実行する必要があります。「CGI-Bin」などのCGIディレクトリを作成し、Apacheの書き込み許可を付与します。 Apache構成ファイルに「Scriptalias」ディレクティブブロックを追加して、CGIディレクトリを「/cgi-bin」URLにマッピングします。 Apacheを再起動します。

Apacheを始める方法

Apr 13, 2025 pm 01:06 PM

Apacheを始める方法

Apr 13, 2025 pm 01:06 PM

Apacheを開始する手順は次のとおりです。Apache(コマンド:sudo apt-get install apache2または公式Webサイトからダウンロード)をインストールします(linux:linux:sudo systemctl start apache2; windows:apache2.4 "serviceを右クリックして「開始」を右クリック) (オプション、Linux:Sudo SystemCtl

Apacheのデータベースに接続する方法

Apr 13, 2025 pm 01:03 PM

Apacheのデータベースに接続する方法

Apr 13, 2025 pm 01:03 PM

Apacheはデータベースに接続するには、次の手順が必要です。データベースドライバーをインストールします。 web.xmlファイルを構成して、接続プールを作成します。 JDBCデータソースを作成し、接続設定を指定します。 JDBC APIを使用して、接続の取得、ステートメントの作成、バインディングパラメーター、クエリまたは更新の実行、結果の処理など、Javaコードのデータベースにアクセスします。

Apache80ポートが占有されている場合はどうすればよいですか

Apr 13, 2025 pm 01:24 PM

Apache80ポートが占有されている場合はどうすればよいですか

Apr 13, 2025 pm 01:24 PM

Apache 80ポートが占有されている場合、ソリューションは次のとおりです。ポートを占有するプロセスを見つけて閉じます。ファイアウォールの設定を確認して、Apacheがブロックされていないことを確認してください。上記の方法が機能しない場合は、Apacheを再構成して別のポートを使用してください。 Apacheサービスを再起動します。

Apacheのサーバー名以上の削除方法

Apr 13, 2025 pm 01:09 PM

Apacheのサーバー名以上の削除方法

Apr 13, 2025 pm 01:09 PM

Apacheから追加のservernameディレクティブを削除するには、次の手順を実行できます。追加のservernameディレクティブを識別して削除します。 Apacheを再起動して変更を有効にします。構成ファイルを確認して、変更を確認します。サーバーをテストして、問題が解決されていることを確認します。

Apacheバージョンを表示する方法

Apr 13, 2025 pm 01:15 PM

Apacheバージョンを表示する方法

Apr 13, 2025 pm 01:15 PM

Apacheサーバーでバージョンを表示するには3つの方法があります。コマンドライン(Apachectl -vまたはapache2ctl -v)を介して、サーバーステータスページ(http://&lt; server ipまたはdomain name&gt;/server -status)を確認します。

DebianがHadoopデータ処理速度を改善する方法

Apr 13, 2025 am 11:54 AM

DebianがHadoopデータ処理速度を改善する方法

Apr 13, 2025 am 11:54 AM

この記事では、DebianシステムのHadoopデータ処理効率を改善する方法について説明します。最適化戦略では、ハードウェアのアップグレード、オペレーティングシステムパラメーターの調整、Hadoop構成の変更、および効率的なアルゴリズムとツールの使用をカバーしています。 1.ハードウェアリソースの強化により、すべてのノードが一貫したハードウェア構成、特にCPU、メモリ、ネットワーク機器のパフォーマンスに注意を払うことが保証されます。高性能ハードウェアコンポーネントを選択することは、全体的な処理速度を改善するために不可欠です。 2。オペレーティングシステムチューニングファイル記述子とネットワーク接続:/etc/security/limits.confファイルを変更して、システムによって同時に開くことができるファイル記述子とネットワーク接続の上限を増やします。 JVMパラメーター調整:Hadoop-env.shファイルで調整します

Apacheを開始できない問題を解決する方法

Apr 13, 2025 pm 01:21 PM

Apacheを開始できない問題を解決する方法

Apr 13, 2025 pm 01:21 PM

Apacheは、次の理由で起動できません。構成ファイル構文エラー。他のアプリケーションポートとの競合。権限の問題。メモリから。デッドロックを処理します。デーモン障害。 Selinux許可の問題。ファイアウォールの問題。ソフトウェアの競合。