docker は物理マシン上で実行されますか? それとも仮想マシン上で実行されますか?

Docker は物理マシンでも仮想マシンでも実行でき、仮想マシンでも物理マシンでも、本質的にはレベルであるハードウェアとインフラストラクチャ、およびコンテナの配信方法です。主にソフトウェア中心の問題を解決するために使用され、仮想マシンと物理マシンの両方でコンテナを実行することが可能です。

このチュートリアルの動作環境: linux7.3 システム、docker バージョン 19.03、Dell G3 コンピューター。

Docker は物理マシンでも仮想マシンでも実行できます

Docker コンテナは仮想マシンでも物理マシンでも実行できます

は仮想マシンまたは物理マシンです マシンは両方ともハードウェア/インフラストラクチャの配信方法であり、本質的に同じレベルにあります。一方、コンテナは主にソフトウェア中心の一連の問題を解決します

厳密に言えば、コンテナと仮想マシンは階層的なものは、パッケージ化されたソフトウェア環境のコレクションです。

仮想マシンでコンテナを実行することは一般的になってきています。たとえば、AWS のコンテナ サービスは仮想マシンでのみ実行されます。

Docker デーモンは、メイン オペレーティング システムと直接通信して、各 Docker コンテナにリソースを割り当てることができます。また、コンテナをメイン オペレーティング システムから分離し、各コンテナを相互に分離することもできます。 Docker は、フロントエンド、バックエンド、データベースなどのさまざまなアプリケーションを分離するためによく使用されます。

拡張知識:

Docker デーモンは、メイン オペレーティング システムと直接通信して、各 Docker コンテナにリソースを割り当てることができます。また、メイン オペレーティング システムからコンテナを分離することもできます。システムを構築し、各コンテナを相互に分離します。 Docker は、フロントエンド、バックエンド、データベースなどのさまざまなアプリケーションを分離するためによく使用されます。

Docker には、コンパクトさ、迅速な移行と展開、効率的な運用という特徴がありますが、その分離性はサーバー仮想化よりも劣ります。異なるコンテナは異なる運送状 (Docker 上で実行される異なるアプリケーション インスタンス) に属し、それぞれから独立しています。その他(絶縁)。ただし、同じウェアハウス マネージャー (ホスト オペレーティング システム カーネル) によって管理されるため、ウェアハウス マネージャーはすべてのコンテナーの関連情報を確認できます (オペレーティング システム カーネルが共有されるため、関連情報も共有されます)。

仮想マシンは、オペレーティング環境全体を完全に分離することに優れています。たとえば、クラウド サービス プロバイダーは通常、仮想マシン テクノロジを使用してさまざまなユーザーを分離します。仮想マシンの起動には数分かかりますが、Docker コンテナは数ミリ秒で起動できます。オペレーティング システムが肥大化しなければ、Docker はディスク領域やその他のシステム リソースを大幅に節約できます。

サーバー仮想化は、複数の独立した「小さなドック」、つまりドック (物理ホストと仮想化層) 上の倉庫 (仮想マシン) を確立するようなものです。これは完全に独立した (分離された) スペースを持ち、異なる顧客 (仮想マシンの所有者) に属します。各ウェアハウスには独自のウェアハウス マネージャー (現在の仮想マシンのオペレーティング システム カーネル) があり、他のウェアハウスを管理することはできません。情報の共有はありません。

したがって、Docker テクノロジを使用するか、サーバー仮想化テクノロジを使用するか、さまざまなアプリケーション シナリオやニーズに応じて、さまざまな方法を採用する必要があります。

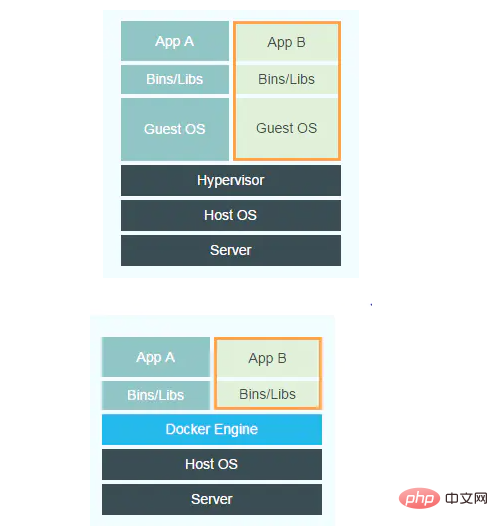

Docker と仮想マシンの実装原理の比較

次の図は、仮想マシンと Docker の実装フレームワークをそれぞれ示しています。

2 つの図の違いを比較すると、左側の図の仮想マシンのゲスト OS レイヤーとハイパーバイザー レイヤーは、docker の Docker エンジン レイヤーに置き換えられています。仮想マシンのゲスト OS は、仮想マシンにインストールされるオペレーティング システムであり、完全なオペレーティング システム カーネルです。仮想マシンのハイパーバイザ層は、カーネル状態ドライバーとして存在するハードウェア仮想化プラットフォームとして単純に理解できます。ホストOS内で。

仮想マシンがリソース分離を実現する方法は、独立したOSを使用し、ハイパーバイザーを使用してCPU、メモリ、IOデバイスなどを仮想化することです。たとえば、仮想 CPU の場合、ハイパーバイザーは各仮想 CPU のデータ構造を作成し、CPU のすべてのレジスタの値をシミュレートし、必要に応じてこれらの値を追跡および変更します。ほとんどの場合、仮想マシン ソフトウェア コードは、ハイパーバイザーの介入なしにハードウェア上で直接実行されることに注意してください。一部の高い特権リクエストの下でのみ、ゲスト OS はカーネル モードを実行して CPU のレジスタ データを変更する必要があり、ハイパーバイザーが介入して仮想 CPU の状態を変更および維持します。

ハイパーバイザーがメモリを仮想化する方法は、シャドウ ページ テーブルを作成することです。通常の状況では、ページ テーブルを使用して仮想メモリから物理メモリに変換できます。仮想化の場合、いわゆる物理メモリは依然として仮想であるため、シャドウ ページ テーブルは、仮想メモリ -> 仮想物理メモリ -> 実物理メモリを実行する必要があります。

IO デバイス仮想化の場合、ハイパーバイザーがページ フォールトを受信し、仮想物理メモリ アドレスが実際に I/O デバイスに対応していることが判明すると、ハイパーバイザーはソフトウェアを使用してこのデバイスの動作条件をシミュレートし、 を返します。たとえば、CPU がディスクに書き込みたい場合、ハイパーバイザーは対応するデータをホスト OS ファイルに書き込みます。このファイルは実際には仮想ディスクをシミュレートします。

仮想マシンのリソースと環境を分離するソリューションと比較すると、docker ははるかにシンプルです。 Docker Engine は、単純に Linux の NameSpace、Cgroup、およびイメージ管理ファイル システム操作のカプセル化として見ることができます。 Docker は、仮想マシンのような完全に独立したゲスト OS を使用せずに、現在 Linux カーネル自体がサポートしているコンテナ方式を使用して、リソースと環境の分離を実現します。簡単に言うと、docker はネームスペースを使用してシステム環境を分離し、Cgroup を使用してリソース制限を実装し、ミラーリングを使用してルート ディレクトリ環境を分離します。

推奨される学習: 「docker ビデオ チュートリアル 」

以上がdocker は物理マシン上で実行されますか? それとも仮想マシン上で実行されますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7490

7490

15

15

1377

1377

52

52

77

77

11

11

19

19

41

41

PHP 分散システムのアーキテクチャと実践

May 04, 2024 am 10:33 AM

PHP 分散システムのアーキテクチャと実践

May 04, 2024 am 10:33 AM

PHP 分散システム アーキテクチャは、ネットワークに接続されたマシン全体にさまざまなコンポーネントを分散することで、スケーラビリティ、パフォーマンス、およびフォールト トレランスを実現します。このアーキテクチャには、アプリケーション サーバー、メッセージ キュー、データベース、キャッシュ、ロード バランサーが含まれます。 PHP アプリケーションを分散アーキテクチャに移行する手順は次のとおりです。 サービス境界の特定 メッセージ キュー システムの選択 マイクロサービス フレームワークの採用 コンテナ管理への展開 サービスの検出

PHPマイクロサービスコンテナ化のアジャイル開発と運用

May 08, 2024 pm 02:21 PM

PHPマイクロサービスコンテナ化のアジャイル開発と運用

May 08, 2024 pm 02:21 PM

回答: PHP マイクロサービスは、アジャイル開発のために HelmCharts でデプロイされ、分離とスケーラビリティのために DockerContainer でコンテナ化されます。詳細説明: HelmCharts を使用して PHP マイクロサービスを自動的にデプロイし、アジャイル開発を実現します。 Docker イメージを使用すると、マイクロサービスの迅速な反復とバージョン管理が可能になります。 DockerContainer 標準はマイクロサービスを分離し、Kubernetes がコンテナの可用性とスケーラビリティを管理します。 Prometheus と Grafana を使用して、マイクロサービスのパフォーマンスと健全性を監視し、アラームと自動修復メカニズムを作成します。

PIノードティーチング:PIノードとは何ですか? PIノードをインストールしてセットアップする方法は?

Mar 05, 2025 pm 05:57 PM

PIノードティーチング:PIノードとは何ですか? PIノードをインストールしてセットアップする方法は?

Mar 05, 2025 pm 05:57 PM

ピン張りのノードの詳細な説明とインストールガイドこの記事では、ピネットワークのエコシステムを詳細に紹介します - PIノードは、ピン系生態系における重要な役割であり、設置と構成の完全な手順を提供します。 Pinetworkブロックチェーンテストネットワークの発売後、PIノードは多くの先駆者の重要な部分になり、テストに積極的に参加し、今後のメインネットワークリリースの準備をしています。まだピン張りのものがわからない場合は、ピコインとは何かを参照してください。リストの価格はいくらですか? PIの使用、マイニング、セキュリティ分析。パインワークとは何ですか?ピン競技プロジェクトは2019年に開始され、独占的な暗号通貨PIコインを所有しています。このプロジェクトは、誰もが参加できるものを作成することを目指しています

DeepSeekをインストールする方法

Feb 19, 2025 pm 05:48 PM

DeepSeekをインストールする方法

Feb 19, 2025 pm 05:48 PM

DeepSeekをインストールするには、Dockerコンテナ(最も便利な場合は、互換性について心配する必要はありません)を使用して、事前コンパイルパッケージ(Windowsユーザー向け)を使用してソースからコンパイル(経験豊富な開発者向け)を含む多くの方法があります。公式文書は慎重に文書化され、不必要なトラブルを避けるために完全に準備します。

コンテナ化を通じて Java 関数のパフォーマンスを最適化するにはどうすればよいですか?

Apr 29, 2024 pm 03:09 PM

コンテナ化を通じて Java 関数のパフォーマンスを最適化するにはどうすればよいですか?

Apr 29, 2024 pm 03:09 PM

コンテナ化により、次の方法で Java 関数のパフォーマンスが向上します。 リソースの分離 - 分離されたコンピューティング環境を確保し、リソースの競合を回避します。軽量 - 消費するシステム リソースが少なくなり、実行時のパフォーマンスが向上します。高速起動 - 関数の実行遅延を軽減します。一貫性 - アプリケーションとインフラストラクチャを分離して、環境全体で一貫した動作を保証します。

PHP CI/CD を使用して迅速に反復するにはどうすればよいですか?

May 08, 2024 pm 10:15 PM

PHP CI/CD を使用して迅速に反復するにはどうすればよいですか?

May 08, 2024 pm 10:15 PM

回答: PHPCI/CD を使用して、CI/CD パイプラインの設定、自動化されたテストおよび展開プロセスなどの迅速な反復を実現します。 CI/CD パイプラインのセットアップ: CI/CD ツールを選択し、コード リポジトリを構成し、ビルド パイプラインを定義します。自動テスト: 単体テストと統合テストを作成し、テスト フレームワークを使用してテストを簡素化します。実際のケース: TravisCI の使用: TravisCI をインストールし、パイプラインを定義し、パイプラインを有効にして、結果を表示します。継続的デリバリーを実装します。展開ツールを選択し、展開パイプラインを定義し、展開を自動化します。利点: 開発効率が向上し、エラーが減少し、納期が短縮されます。

Dockerコンテナを使用したJavaEEアプリケーションのデプロイ

Jun 05, 2024 pm 08:29 PM

Dockerコンテナを使用したJavaEEアプリケーションのデプロイ

Jun 05, 2024 pm 08:29 PM

Docker コンテナを使用した Java EE アプリケーションのデプロイ: Dockerfile を作成してイメージを定義し、イメージを構築し、コンテナを実行してポートをマップし、ブラウザでアプリケーションにアクセスします。サンプル JavaEE アプリケーション: REST API はデータベースと対話し、Docker 経由でデプロイ後にローカルホストでアクセスできます。

vscode に Docker 拡張機能をインストールする方法 vscode に Docker 拡張機能をインストールする手順

May 09, 2024 pm 03:25 PM

vscode に Docker 拡張機能をインストールする方法 vscode に Docker 拡張機能をインストールする手順

May 09, 2024 pm 03:25 PM

1. まず、インターフェイスを開いた後、左側の拡張機能アイコン ボタンをクリックします。 2. 次に、開いた拡張機能ページで検索バーの場所を見つけます。 3. 次に、マウスで「Docker」という単語を入力して拡張機能プラグインを見つけます。 4最後に、対象のプラグインを選択して右をクリックし、下隅にあるインストールボタンをクリックします。