lm393チップの機能や機能は何ですか?

lm393 チップの機能と機能は次のとおりです: 1. 出力負荷抵抗は、許容電源電圧範囲内の任意の電源電圧に接続でき、Vcc 端子電圧値に制限されません。出力部のシンク電流はドライブとデバイスのβ値によって制限される; 2. 制限電流 16mA に達すると出力トランジスタが抜け、出力電圧が急速に上昇します; 3. 出力飽和電圧は出力トランジスタのγSAT(約60Ω)により制限されますが、負荷電流が小さい場合は出力トランジスタのオフセット電圧(約1.0mV)が低いため、出力をゼロレベルにクランプできます。

#このチュートリアルの動作環境: Windows 10 システム、Dell G3 コンピューター。

lm393チップの機能と機能は何ですか?

LM393 概要:

LM393 は、デュアル電圧コンパレータ集積回路です。

出力負荷抵抗は、許容電源電圧範囲内の任意の電源電圧に接続でき、Vcc 端子電圧値に制限されず、単純な SPS 対グランド開放回路として使用できます。 (負荷抵抗を使用しない場合)、出力セクションのシンク電流は、使用可能なドライブとデバイスのベータ値によって制限され、制限電流 (16mA) に達すると、出力トランジスタが終了し、出力電圧は急速に上昇します。

主な特長:

この回路の特長は次のとおりです:

動作温度範囲: 0°C ~ 70°C

SVHC (高懸念物質): SVHC なし (2010 年 6 月 18 日)

デバイス番号: 393

動作電源電圧範囲は広く、単一電源であり、両電源動作可能、片電源: 2~36V、両電源: ±1~±18V;

低消費電流、ICC=0.4mA;

小さな入力オフセット電圧、 VIO=±2mV;

同相入力電圧範囲は広く、VIC=0~VCC-1.5V;

出力はTTL、DTL、MOS、CMOSなどと互換性があります。 ;

出力はオープンコレクタ「OR」ドアで接続可能;

表面実装デバイス: 表面実装

主な機能

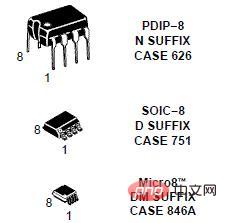

LM393のパッケージ形状

出力負荷抵抗は、Vcc端子の電圧値に制限されず、許容電源電圧範囲内の任意の電源電圧に接続可能です。この部分は駆動可能な能力とデバイスのβ値によって制限され、制限電流(16mA)に達すると出力トランジスタが抜け、出力電圧が急速に上昇します。出力飽和電圧は約60Ωの出力トランジスタのγSATにより制限されます。負荷電流が小さい場合、出力トランジスタの低いオフセット電圧(約1.0mV)により、出力をゼロレベルにクランプできます。

さらに関連する知識については、FAQ 列をご覧ください。

以上がlm393チップの機能や機能は何ですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7700

7700

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1230

1230

29

29

恩恵を受けるのは Nvidia だけではなく、AI トレーニングはメモリチップメーカーにも利益をもたらします

May 31, 2023 pm 05:16 PM

恩恵を受けるのは Nvidia だけではなく、AI トレーニングはメモリチップメーカーにも利益をもたらします

May 31, 2023 pm 05:16 PM

5月30日のニュースによると、メモリチップ市場は低迷しているものの、人工知能に対する需要は大きく、サムスンやSKハイニックスなどの企業に恩恵をもたらすという。 5 月 24 日に Nvidia は財務報告書を発表し、同社の市場価値は 2 日間で 2,070 億米ドル急上昇しました。以前、半導体業界は不況にありましたが、この財務報告の見通しは人々に大きな自信と希望を与えました。人工知能の分野が軌道に乗れば、マイクロソフトなどの伝統的なテクノロジー大手やオープンAIなどの新興企業はサムスンやSKハイニックスなどの企業に支援を求めるだろう。機械学習では、大量のデータを処理し、ビデオ、オーディオ、テキストを分析し、人間の創造性をシミュレートするためにメモリ チップが必要です。実際、AI企業はこれまで以上に多くのDRAMチップを購入している可能性があります。メモリチップの需要

1nmチップは中国製ですか、それとも米国製ですか?

Nov 06, 2023 pm 01:30 PM

1nmチップは中国製ですか、それとも米国製ですか?

Nov 06, 2023 pm 01:30 PM

1nmチップを誰が製造したかは不明です。研究開発の観点から見ると、1nmチップは台湾、中国、米国が共同開発した。量産の観点から見ると、この技術はまだ完全には実現されていません。この研究の主な責任者は中国人科学者であるMITのZhu Jiadi博士です。 Zhu Jiadi博士は、この研究はまだ初期段階にあり、大量生産にはまだ遠いと述べた。

中国初:Changxin MemoryがLPDDR5 DRAMメモリチップを発売

Nov 28, 2023 pm 09:29 PM

中国初:Changxin MemoryがLPDDR5 DRAMメモリチップを発売

Nov 28, 2023 pm 09:29 PM

長新メモリの公式ウェブサイトによると、長新メモリは最新のLPDDR5DRAMメモリチップを発売し、独自に開発・生産したLPDDR5製品を発売する初の国内ブランドとなり、国内市場での躍進を達成し、また、モバイル端末市場における長信ストレージの製品レイアウトもより多様化しています。この Web サイトでは、Changxin Memory LPDDR5 シリーズ製品には 12Gb LPDDR5 パーティクル、POP パッケージの 12GBLPDDR5 チップ、および DSC パッケージの 6GBLPDDR5 チップが含まれていることがわかりました。 12GBLPDDR5 チップは、Xiaomi や Transsion などの国内の主流携帯電話メーカーのモデルで検証されています。 LPDDR5 は、Changxin Storage がミッドエンドからハイエンドのモバイル デバイス市場向けに発売した製品です。

TSMCの高度なパッケージング顧客は注文を大幅に追いかけており、月産能力は来年120%増加する予定であると報告されている

Nov 13, 2023 pm 12:29 PM

TSMCの高度なパッケージング顧客は注文を大幅に追いかけており、月産能力は来年120%増加する予定であると報告されている

Nov 13, 2023 pm 12:29 PM

11 月 13 日のこのサイトのニュースによると、台湾経済日報によると、TSMC の CoWoS 高度パッケージング需要は爆発的に増加しつつあり、10 月に受注拡大を確認した NVIDIA に加えて、Apple、AMD、Broadcom、Marvell などの大口顧客も参入しています。最近も大幅に注文を追求しています。報道によると、TSMCは上記5大顧客のニーズを満たすため、CoWoS先進パッケージングの生産能力の拡大を加速させるべく懸命に取り組んでいるという。来年の月産能力は当初の目標から約20%増加し、3万5000個に達する見通しであるとアナリストらは、TSMCの主要顧客5社が大量発注を行っており、人工知能アプリケーションが広く普及しており、大手メーカーが関心を示していると述べた。人工知能チップの需要は大幅に増加しています。このサイトへの問い合わせによると、現在の CoWoS の高度なパッケージング技術は主に 3 つのタイプに分かれています。

NVIDIA が ChatGPT 専用 GPU をリリースし、推論速度を 10 倍に向上

May 13, 2023 pm 11:04 PM

NVIDIA が ChatGPT 専用 GPU をリリースし、推論速度を 10 倍に向上

May 13, 2023 pm 11:04 PM

かつて、人工知能はコンピューティング能力の不足により数十年にわたるボトルネックに陥り、GPU が深層学習に火をつけました。 ChatGPT の時代、AI はモデルが大きいため計算能力不足という問題に再び直面していますが、今回 NVIDIA にできることはあるのでしょうか? 3 月 22 日、GTC カンファレンスが正式に開催され、開催されたばかりの基調講演で、NVIDIA CEO の Jen-Hsun Huang 氏が ChatGPT 用に準備されたチップを運び出しました。 「コンピューティングの高速化は簡単ではありません。2012 年のコンピューター ビジョン モデル AlexNet は GeForceGTX580 を使用し、毎秒 262 ペタ FLOPS の処理が可能でした。このモデルは AI テクノロジーの爆発的な爆発を引き起こしました」と Huang 氏は述べています。 「10年後、Tr

Realtek 5GbE有線ネットワークカードチップRTL8126-CGには安定性の問題があり、来年に延期されると報告されています

Aug 25, 2023 am 11:53 AM

Realtek 5GbE有線ネットワークカードチップRTL8126-CGには安定性の問題があり、来年に延期されると報告されています

Aug 25, 2023 am 11:53 AM

8 月 24 日のこの Web サイトのニュースによると、ほとんどのテクノロジー メーカーが Gamescom でいくつかの新製品または今後の新製品を展示しました。たとえば、ASRock は、RTL8125-BG チップを使用する Z790 マザーボードの「半世代」アップデート バージョンを展示しました。は、6 月の Computex ショーでプロトタイプで使用された RTL8126-CG の代わりに使用されます。オランダのメディア Tweakers によると、Gamescom に参加している複数のマザーボード メーカーは、Realtek の 5GbE 有線ネットワーク カード チップ RTL8126-CG は安価であるものの、安定性の問題によりこの秋に発売されるマザーボードには搭載されないことを明らかにしたとのことです。問題はあるが、この秋に新しいマザーボードが登場するまでは修正できないだろう

Nvidia の優位性の時代は終わったのでしょうか? ChatGPTはGoogleとMicrosoftの間でチップ戦争を引き起こし、Amazonもゲームに参加する

May 22, 2023 pm 10:55 PM

Nvidia の優位性の時代は終わったのでしょうか? ChatGPTはGoogleとMicrosoftの間でチップ戦争を引き起こし、Amazonもゲームに参加する

May 22, 2023 pm 10:55 PM

ChatGPT が普及した後、Google と Microsoft の 2 つの巨人の間の AI 戦争は、新しいフィールド サーバー チップにまで焼きつきました。現在、AI とクラウド コンピューティングが戦場となっており、チップもコスト削減と企業顧客の獲得の鍵となっています。もともとAmazon、Microsoft、Googleなどの大手企業はソフトウェアで有名でしたが、今ではチップの開発と生産に数十億ドルを費やしています。大手テクノロジー企業が開発したAIチップ「ChatGPT」が人気を博し、大手メーカーがチップ競争を開始していると海外メディアThe Informationなどの報道によると、大手メーカー3社は現在8台のサーバーを立ち上げ、または発売する予定だという。社内製品開発、クラウド サーバーのレンタル、またはその両方用の AI チップ。 "もし、あんたが

情報筋によると、NVIDIA は AI チップ HGX H20、L20 PCle、L2 PCle の中国固有バージョンを開発中

Nov 09, 2023 pm 03:33 PM

情報筋によると、NVIDIA は AI チップ HGX H20、L20 PCle、L2 PCle の中国固有バージョンを開発中

Nov 09, 2023 pm 03:33 PM

最新のニュースによると、Science and Technology Innovation Board DailyとBlue Whale Financeのレポートによると、業界チェーンの情報筋は、NvidiaがHGXH20、L20PCle、L2PCleなどの中国市場に適した最新バージョンのAIチップを開発したことを明らかにしました。現時点でNVIDIAはコメントを出していないが、これら3つのチップはいずれもNVIDIA H100の改良版をベースにしており、NVIDIAは早ければ11月16日にサンプルを入手する予定だという。日々。公開情報を確認したところ、NVIDIAH100TensorCoreGPU は TSMC N4 プロセスをベースにし、800 億個のトランジスタを統合する新しい Hopper アーキテクチャを採用していることがわかりました。前世代の製品と比較して、マルチエキスパート (MoE) を提供できます。