GPT-4 が画像とテキストの読み取りを学習すると、生産性革命は止まらなくなります

「インテリジェントな画像およびテキスト処理技術とマルチシナリオ応用技術」について、学界と産業界の多くの研究者が徹底的な議論を行いました。

「複雑すぎます!」

経験 GPT-4 と Microsoft 365 Copilot の継続的な攻撃の後、多くの人がこのような感情を抱いていると思います。

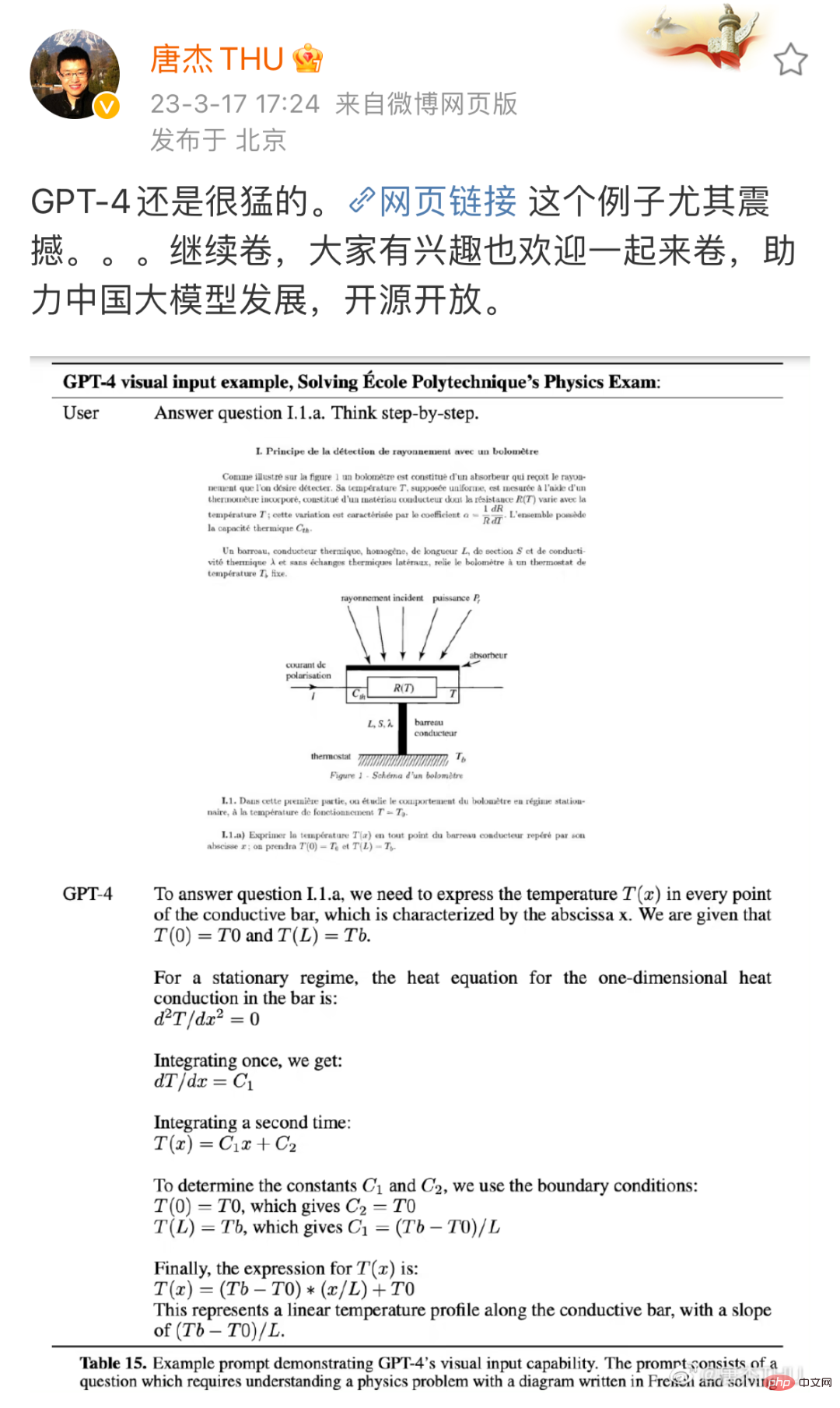

GPT-3.5 と比較して、GPT-4 は多くの点で大幅な改善を達成しており、たとえば司法模擬試験では、当初の下位 10% からプラス 10% に進化しました。もちろん、一般の人はこれらの専門試験についてまったく知らないかもしれません。しかし、写真をお見せすれば、その改善がいかに恐ろしいものであるかがわかるでしょう:

出典: Tang Jie、清華大学コンピューターサイエンス学部教授、微博。リンク: https://m.weibo.cn/detail/4880331053992765

これは物理の問題です。画像とテキストに従って問題を段階的に解くには GPT-4 が必要です。 GPT-3.5 です (ここでは、ChatGPT がアップグレード前に依存していたモデルにはなかった機能を指します。一方で、GPT-3.5 はテキストを理解するようにのみトレーニングされており、質問内の画像を理解することはできません。一方で、GPT-3.5の問題解決能力も非常に弱く、同じ檻の中のニワトリとウサギではつまづいてしまう可能性がある。しかし今回は、両方の問題が見事に解決されたようです。

これは大したことだと誰もが思ったとき、Microsoft は別の大ヒット作 GPT-4 をリリースしました。これらの機能は Microsoft 365 Copilot と呼ばれる新しいアプリケーションに統合されました。強力な画像およびテキスト処理機能を備えた Microsoft 365 Copilot は、さまざまなドキュメントの作成を支援するだけでなく、ドキュメントを PPT に簡単に変換したり、Excel データをグラフに自動的に要約したりすることもできます...

グラフィックスとテキストのインテリジェントな処理 という明らかな画期的な進歩を見つけることができます。

現実のシナリオでは、非構造化データをグラフに整理する、グラフに基づいてレポートを作成する、大量のグラフィックやテキストから有用な情報を抽出するなど、あらゆる分野の多くの仕事がグラフィックやテキストの処理に関連しています。情報、情報など。このため、この革命の影響は多くの人が想像するよりもはるかに深刻なものになる可能性があります。 OpenAI とウォートン スクールが最近発表した大ヒット論文は、この影響を予測しています。米国の労働力の約 80% は、GPT の導入によって業務タスクの少なくとも 10% に影響を受ける可能性があり、労働者の約 19% は、次のような影響を受ける可能性があります。タスクの少なくとも 50% が影響を受けます。作業の大部分にグラフィックとテキストのインテリジェンスが含まれることが予想されます。 このような入口点において、検討する価値のある研究活動やエンジニアリング活動は何でしょうか?中国画像グラフィック学会 (CSIG) が主催し、Hehe Information と CSIG Document Image Analysis and Recognition Professional Committee が共催した最近の CSIG Enterprise Tour イベントでは、学界や産業界の多くの研究者が「グラフィックスとテキスト」に焦点を当てました。 「インテリジェント処理テクノロジーとマルチシナリオ アプリケーション テクノロジー」について詳しく説明されており、インテリジェントな画像およびテキスト処理の分野に関心を持つ研究者や実践者にインスピレーションを与えるかもしれません。

根底にあるビジョンから始まるグラフィックスとテキストの処理前述したように、GPT-4 のグラフィックスとテキストの処理機能は非常に衝撃的です。上記の物理学に関する質問に加えて、OpenAI の技術レポートでは、GPT-4 に論文の画像を読み取らせるなど、他の例も引用されています。テクノロジーの普及 導入前にやるべき基本的な作業がまだたくさんあるかもしれませんが、基礎となるビジョンもその 1 つです。 基礎となるビジョンの特性は非常に明白です。入力は画像であり、出力も画像です。画像の前処理、フィルタリング、復元、および強化はすべてこのカテゴリに分類されます。 「基礎的な視覚の理論と手法は、携帯電話、医療画像分析、セキュリティ監視など、多くの分野で広く使用されています。画像やビデオ コンテンツの品質を重視する企業や機関は注意を払う必要があります。 「基礎となる視覚の方向性を研究します。基礎となる視覚が適切に行われていない場合、多くの高度な視覚システム (検出、認識、理解など) を真に実装することはできません。」

「基礎的な視覚の理論と手法は、携帯電話、医療画像分析、セキュリティ監視など、多くの分野で広く使用されています。画像やビデオ コンテンツの品質を重視する企業や機関は注意を払う必要があります。 「基礎となる視覚の方向性を研究します。基礎となる視覚が適切に行われていない場合、多くの高度な視覚システム (検出、認識、理解など) を真に実装することはできません。」

氏は、CSIG Enterprise Tour のイベント共有中にこう述べました。

この文をどう理解すればよいでしょうか?いくつかの例を見てみましょう:

OpenAI や Microsoft のデモで示されている理想的な状況とは異なり、現実世界の画像やテキストは変形、影、モアレ パターンなどの困難な形で常に存在しており、その後の認識と理解の難しさが増大します。 Guo Fengjun 氏のチームの目標は、初期段階でこれらの問題を解決することです。

この目的を達成するために、彼らはこのタスクを、関心領域 (RoI) 抽出、変形補正、画像修復 (影の除去、モアレなど)、品質向上 (シャープ化など)、鮮明度などのいくつかのモジュールに分割しました。 )など。

これらのテクノロジーを組み合わせると、非常に興味深いアプリケーションを作成できます。長年の探求の末、これらのモジュールは非常に良い結果を達成し、関連技術は同社のインテリジェントテキスト認識製品「スキャナー」に適用されました。

単語から表、そして章に至るまで、画像とテキストを段階的に読んでください。

画像が処理されたら、次のステップは上の画像とテキストの内容を識別することです。これも非常に細かい作業で、場合によっては「単語」単位で行うこともあります。

現実の多くのシナリオでは、文字が必ずしも標準化された印刷形式で表示されるわけではないため、文字認識に課題が生じます。

教育現場を例に挙げてみましょう。あなたが教師であると仮定すると、すべての生徒の宿題の添削を AI に直接支援してもらい、同時に生徒の知識の各部分の習得状況を要約してもらいたいと考えます。間違った質問、タイプミス、修正の提案も提供するのが最善です。 。中国科学技術大学音声言語情報処理国家工学研究室の Du Jun 准教授は、この分野の研究に取り組んでいます。

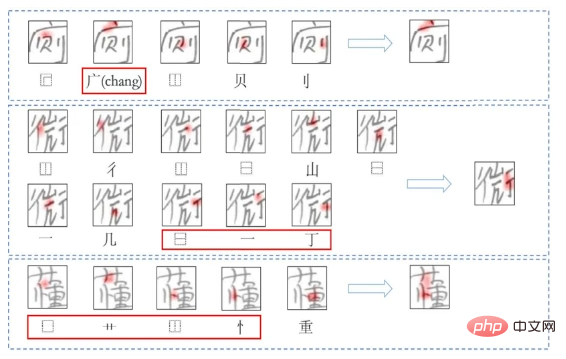

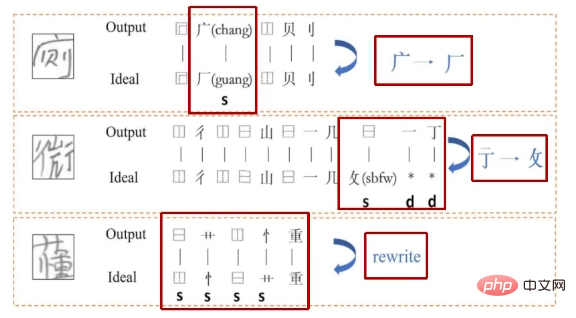

具体的には、文字全体のモデリングと比較して部首の組み合わせがはるかに少ないため、部首に基づいた漢字認識、生成、評価システムを作成しました。その中で、認識と生成は共同で最適化されます。これは、学生が学習する際の読み書き能力とライティング能力を相互に強化するプロセスに似ています。これまで、ほとんどの評価作業は文法レベルに焦点を当てていましたが、Du Jun 氏のチームは、画像から直接タイプミスを見つけて、エラーを詳細に説明できる方法を設計しました。この方法は、インテリジェント マーキングなどのシナリオで非常に役立ちます。

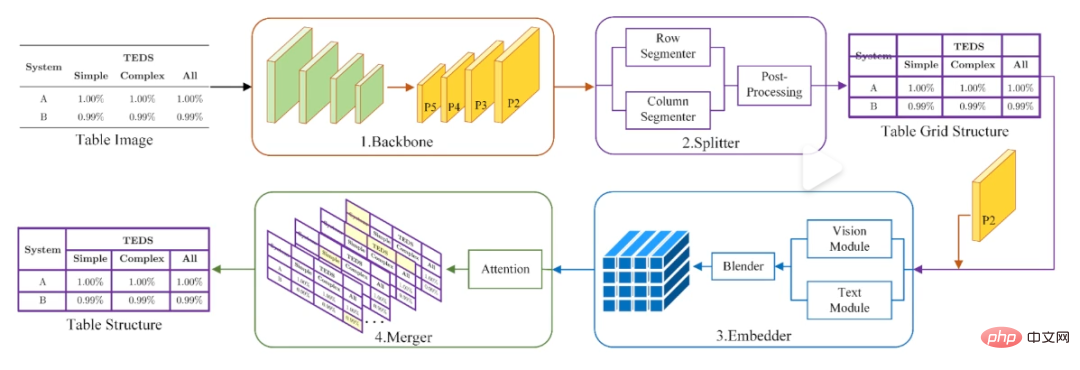

テキストに加えて、テーブルの識別と処理は、実際には大きな困難です。なぜなら、内部のコンテンツを識別するだけでなく、テーブル間の構造的関係を明確にする必要があるからです。また、一部の表にはワイヤーフレームさえない場合があります。この目的を達成するために、Du Jun 氏のチームは「最初にセグメントを作成してからマージする」方法を設計しました。つまり、最初にテーブル画像を一連の基本グリッドに分割し、次にマージによってさらに修正を加えます。

# Du Jun のチームの「最初にセグメント化してからマージする」フォーム認識方法。

もちろん、この作業はすべて、最終的には文書の構造化と章レベルでの理解に役割を果たします。実際の環境では、モデルが直面するほとんどのドキュメントは 1 ページ以上になります (論文など)。この方向において、Du Jun のチームの研究は、ページをまたがる文書要素の分類とページをまたがる文書構造の復元に焦点を当てています。ただし、これらの方法には、マルチレイアウトのシナリオでは依然として制限があります。

大規模モデル、マルチモダリティ、世界モデル...未来はどこにあるのでしょうか?

章レベルの画像とテキストの処理と理解について言えば、実際のところ、GPT-4 はそれほど遠くありません。 「マルチモーダル GPT-4 が登場した後、私たちもこれらの面で何かできないか考えていました」と Du Jun 氏はイベントで語った。画像やテキスト処理の分野の多くの研究者や実務家がこの考えを持っていると思います。

GPT シリーズ モデルの目標は、常に汎用性の向上に努め、最終的には汎用人工知能 (AGI) を実現することです。今回 GPT-4 によって実証された強力な画像およびテキスト理解機能は、この一般的な機能の重要な部分です。同様の機能を備えたモデルを作成するために、OpenAI はいくつかの参考資料を提供しましたが、多くの謎と未解決の問題も残しました。

まず第一に、GPT-4 の成功は、大規模モデルに対するマルチモーダル アプローチが実現可能であることを示しています。ただし、大規模モデルでどのような問題を研究する必要があるか、マルチモーダル モデルの過大な計算能力要件をどのように解決するかは、すべて研究者が直面している課題です。

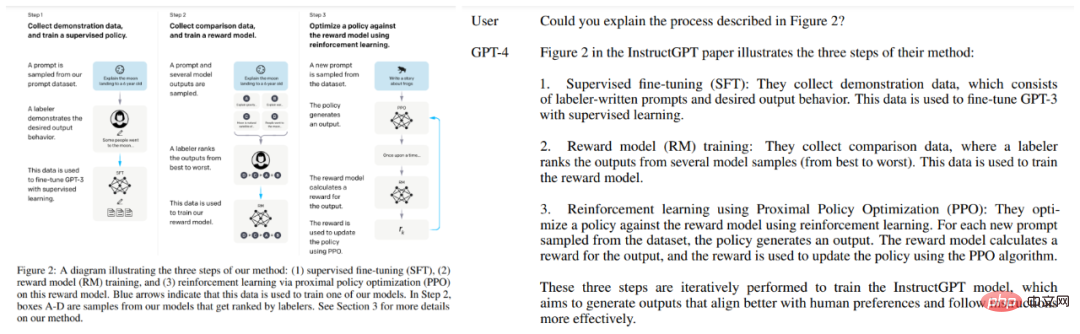

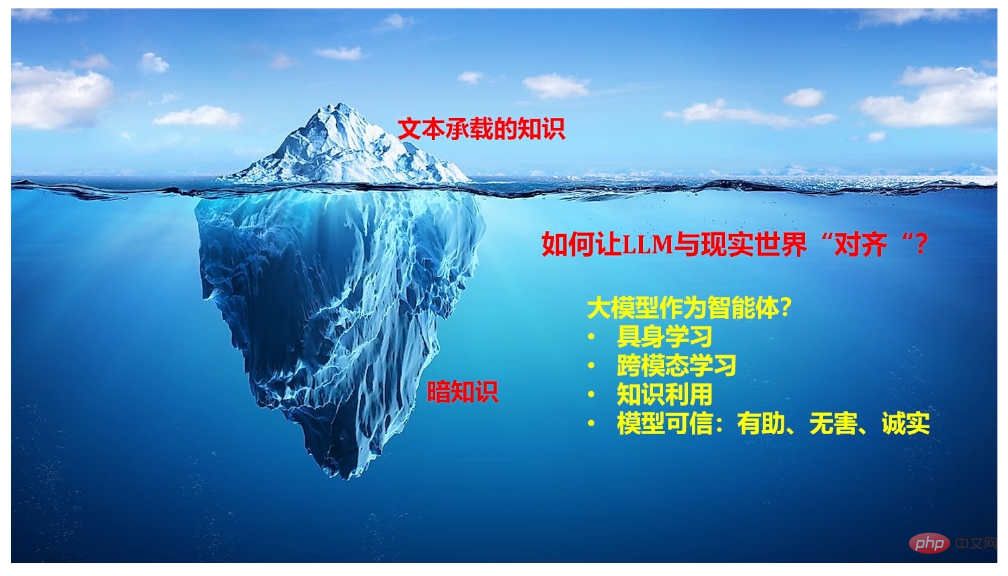

最初の質問については、復旦大学コンピューターサイエンス学部の教授であるQiu Xipeng氏が参考になる指示をいくつか出してくれました。 OpenAI によって以前に公開されたいくつかの情報によると、ChatGPT は、コンテキスト内学習、思考の連鎖、指示からの学習など、いくつかの主要なテクノロジーから切り離せないことがわかっています。 Qiu Xipeng 氏は、共有の中で、これらの能力がどこから来るのか、どのように向上し続けるか、既存の学習パラダイムを変革するためにそれらをどのように使用するかなど、これらの方向で議論すべき多くの問題がまだあると指摘しました。さらに、会話型の大規模言語モデルを構築する際に考慮すべき機能と、これらのモデルを現実世界と整合させるために考慮できる研究の方向性についても共有しました。

Nanqiang 特別教授 Ji Rongrong が重要なアイデアを提供してくれました。彼は、言語と視覚の間には自然なつながりがあり、両者を共同学習することが一般的な傾向であると信じています。しかし、この波の前では、大学や研究室の力は微々たるものです。そこで現在、同氏は勤務先のアモイ大学を起点として、コンピューティング能力を統合し、大規模なマルチモーダルモデルを構築するためのネットワークを形成するよう研究者を説得しようとしている。実際、少し前のイベントで、科学のための AI に焦点を当てている学者 E Weinan 氏も同様の見解を表明し、各界が「あえて独自のイノベーションの方向にリソースを共有する」ことを望んでいます。

しかし、GPT-4がたどった道は間違いなく一般的な人工知能につながるのでしょうか?これについては懐疑的な研究者もおり、チューリング賞受賞者のヤン・ルカン氏もその一人だ。彼は、これらの現在の大型モデルにはデータとコンピューティング能力に対する膨大な需要があるが、その学習効率は非常に低いと考えています (自動運転車など)。そこで、彼は「世界モデル」(つまり、世界がどのように機能するかの内部モデル)と呼ばれる理論を作成し、世界モデル(現実世界のシミュレーションを実行することと理解できます)を学習することが、 AGIを達成します。イベントでは、上海交通大学のYang Xiaokang教授がこの方向での取り組みを共有しました。具体的には、彼のチームは視覚直観の世界モデルに焦点を当て(視覚直観には大量の情報があるため)、視覚、直観、時間と空間の認識をモデル化しようとしました。最後に、同氏は、この種の研究においては数学、物理学、情報認知、コンピューター分野の交差点の重要性も強調した。

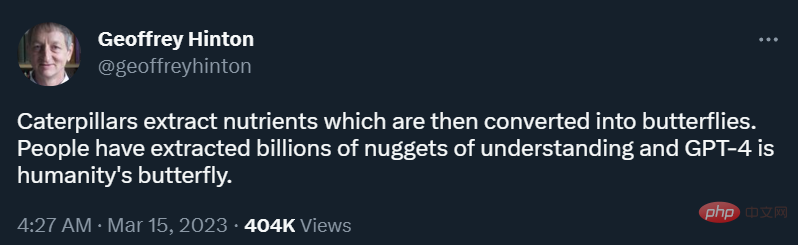

「イモムシは食物から栄養素を抽出し、その後蝶に変わります。人々は、GPT-4 が人間にとっての蝶であることを理解するために、何十億もの手がかりを抽出してきました。」 GPT-4 がリリースされた翌日、ジェフリー・ヒントンは、ディープラーニングの父はツイートした。

以上がGPT-4 が画像とテキストの読み取りを学習すると、生産性革命は止まらなくなりますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7469

7469

15

15

1376

1376

52

52

77

77

11

11

19

19

29

29

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

著者の個人的な考えの一部 自動運転の分野では、BEV ベースのサブタスク/エンドツーエンド ソリューションの開発に伴い、高品質のマルチビュー トレーニング データとそれに対応するシミュレーション シーンの構築がますます重要になってきています。現在のタスクの問題点に対応して、「高品質」は 3 つの側面に分離できます。 さまざまな次元のロングテール シナリオ: 障害物データ内の近距離車両、車両切断中の正確な進行角、車線などラインデータ 曲率の異なるカーブやランプ・合流・合流などの撮影が難しいシーン。これらは多くの場合、大量のデータ収集と複雑なデータ マイニング戦略に依存しており、コストがかかります。 3D 真の値 - 一貫性の高い画像: 現在の BEV データ取得は、センサーの設置/校正、高精度マップ、再構成アルゴリズム自体のエラーの影響を受けることがよくあります。これが私を導いた

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

この四角い男性は、目の前にいる「招かれざる客」の正体について考えながら眉をひそめていることに注意してください。彼女が危険な状況にあることが判明し、これに気づくと、彼女は問題を解決するための戦略を見つけるためにすぐに頭の中で探索を始めました。最終的に、彼女は現場から逃走し、できるだけ早く助けを求め、直ちに行動を起こすことにしました。同時に、反対側の人も彼女と同じことを考えていた……『マインクラフト』では、登場人物全員が人工知能によって制御されている、そんなシーンがありました。それぞれに個性的な設定があり、例えば先ほどの女の子は17歳ながら賢くて勇敢な配達員です。彼らは記憶力と思考力を持ち、Minecraft の舞台となるこの小さな町で人間と同じように暮らしています。彼らを動かすのはまったく新しいものであり、

iOS 17を使用してiPhoneで写真を編集する方法

Nov 30, 2023 pm 11:39 PM

iOS 17を使用してiPhoneで写真を編集する方法

Nov 30, 2023 pm 11:39 PM

モバイル写真は、私たちが人生の瞬間を捉えて共有する方法を根本的に変えました。スマートフォン、特に iPhone の出現がこの変化に重要な役割を果たしました。高度なカメラ技術と使いやすい編集機能で知られる iPhone は、アマチュア写真家にとっても経験豊富な写真家にとっても同様に第一の選択肢となっています。 iOS 17 のリリースは、この取り組みにおける重要なマイルストーンとなります。 Apple の最新アップデートでは、写真編集機能の強化セットが提供され、日常のスナップショットを視覚的に魅力的で芸術性の高い画像に変えるためのより強力なツールキットがユーザーに提供されます。この技術開発は写真撮影プロセスを簡素化するだけでなく、クリエイティブな表現の新たな道を切り開き、ユーザーが自分の写真にプロのタッチを簡単に注入できるようになります。

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

9 月 23 日、論文「DeepModelFusion:ASurvey」が国立国防技術大学、JD.com、北京理工大学によって発表されました。ディープ モデルの融合/マージは、複数のディープ ラーニング モデルのパラメーターまたは予測を 1 つのモデルに結合する新しいテクノロジーです。さまざまなモデルの機能を組み合わせて、個々のモデルのバイアスとエラーを補償し、パフォーマンスを向上させます。大規模な深層学習モデル (LLM や基本モデルなど) での深層モデルの融合は、高い計算コスト、高次元のパラメーター空間、異なる異種モデル間の干渉など、いくつかの課題に直面しています。この記事では、既存のディープ モデル フュージョン手法を 4 つのカテゴリに分類します。 (1) 「パターン接続」。損失低減パスを介して重み空間内の解を接続し、より適切な初期モデル フュージョンを取得します。

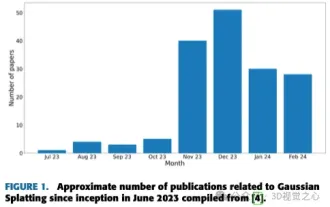

単なる 3D ガウス以上のもの!最先端の 3D 再構成技術の最新概要

Jun 02, 2024 pm 06:57 PM

単なる 3D ガウス以上のもの!最先端の 3D 再構成技術の最新概要

Jun 02, 2024 pm 06:57 PM

上記と著者の個人的な理解は、画像ベースの 3D 再構成は、一連の入力画像からオブジェクトまたはシーンの 3D 形状を推測することを含む困難なタスクであるということです。学習ベースの手法は、3D形状を直接推定できることから注目を集めています。このレビュー ペーパーは、これまでにない新しいビューの生成など、最先端の 3D 再構成技術に焦点を当てています。入力タイプ、モデル構造、出力表現、トレーニング戦略など、ガウス スプラッシュ メソッドの最近の開発の概要が提供されます。未解決の課題と今後の方向性についても議論します。この分野の急速な進歩と 3D 再構成手法を強化する数多くの機会を考慮すると、アルゴリズムを徹底的に調査することが重要であると思われます。したがって、この研究は、ガウス散乱の最近の進歩の包括的な概要を提供します。 (親指を上にスワイプしてください