BELLE は Stanford Alpaca に基づいており、中国語用に最適化されています。モデルのチューニングには ChatGPT によって生成されたデータのみが使用されます (他のデータは含まれません)。

ChatGPT の最初のリリースからほぼ 4 か月が経過しました。 GPT-4 が先週リリースされると、ChatGPT はすぐに新しいバージョンをリリースしました。しかし、よく知られている秘密は、ChatGPT も GPT-4 もオープンソースになる可能性が低いということです。コンピューティング能力と膨大なトレーニング データへの巨額の投資と相まって、研究コミュニティがその実装プロセスを再現するには多くのハードルがあります。

ChatGPT などの大規模モデルの猛攻撃に直面している場合、オープンソースの置き換えは良い選択です。今月初め、Meta は、パラメーター サイズが 70 億から 650 億の範囲にある新しい大規模モデル シリーズ、LLaMA (Large Language Model Meta AI) を「オープンソース」しました。 130 億パラメータの LLaMA モデルは、「ほとんどのベンチマークで」1750 億パラメータの GPT-3 を上回り、単一の V100 GPU で実行できます。

数日後、スタンフォード大学は、LLaMA 7B に基づいて 70 億のパラメーターを備えた新しいモデル Alpaca を微調整しました。彼らは、Self-Instruct 論文で紹介されたテクノロジーを使用して 52K の命令データを生成し、いくつかの修正を加えました。 , 人間による予備評価では、Alpaca 7B モデルは Self-Instruct 命令の評価において text-davinci-003 (GPT-3.5) モデルと同様のパフォーマンスを示しました。

残念ながら、Alpaca のシード タスクはすべて英語であり、収集されるデータも英語であるため、トレーニング済みモデルは中国語用に最適化されていません。中国語での対話モデルの有効性を向上させるために、より良い方法はあるでしょうか?心配しないでください。次に紹介するプロジェクトはこの問題をうまく解決します。

オープンソースの中国語対話大規模モデルBELLE (Bloom-Enhanced Large Language Model Engine) は 70 億のパラメータを備えています。これは Stanford の Alpaca をベースにしていますが、中国語の最適化と、生成されたコードにいくつかの変更が加えられており、それだけでなく、モデルのチューニングには ChatGPT によって生成されたデータのみが使用されます (他のデータは含まれません)。

データに関しては、プロジェクトは Alpaca に基づくデータ収集コードをオープンソース化しました。このコードに基づいて、約 100 万個の中国語データが生成されました。Alpaca の 50,000 個の英語データと組み合わせると、 BLOOMZ-7BモデルでトレーニングしたチェックポイントをHugging Faceにアップロードします。

Hugging Face アドレス: https://huggingface.co/BelleGroup

プロジェクト作成者は次のように述べています: このプロジェクトは、中国語対話の大規模モデル オープンソース コミュニティの開発を促進することを目的としています。

プロジェクトアドレス: https://github.com/LianjiaTech/BELLE

プロジェクトには主に以下の 4 つが含まれますパーツ コンテンツ:

データ リリース

1. zh_seed_tasks.jsonl: 175 個のシード タスクが含まれます。サンプルは次のとおりです。

{" id ": "seed_task_20", "name": "horror_movie_opening", "instruction": "ホラー映画のクリエイティブなオープニング シーンを書く必要があります。", "instances": [{"input": "","output ":" 夕日が沈み、暗い街が残った。誰もいない通りにそよ風が吹き抜け、外に出る者はみな寒気を感じた。風に吹かれて葉が擦れるわずかな音だけが響いた。音。突然、静寂を突き破る血の凍るような叫び声と、ガラスの割れる音が続いた家々に明かりが灯り、街の中心に向かって走っていく人影が見えたその時>その人影はますます大きくなっていったさらに近づいてみると、それは全身に血を流した若い女性であることがはっきりとわかりました。"}],"is_classification": false}

2.prompt_cn.txt:

# の生成に使用されるプロンプト##3. 0.5M の生成データデータ生成

Alpaca の方法に従います: pip install -rrequirements.txt export OPENAI_API_KEY =YOUR_API_KEY

pythongenerate_instruction.pygenerate_instruction_following_data

デフォルトで Completion API を使用します (モデル text-davinci-003)。 Chat API を使用して gpt-3.5-turbo モデルを使用する場合は、パラメータを通じて制御できます:

--api=chat --model_name=gpt- 3.5-turbo

出力ファイルは Belle.train.json にあり、使用前に手動でフィルタリングできます。

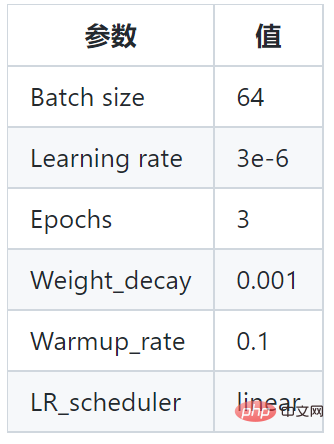

モデルチューニング

このプロジェクトは、BLOOMZ-7B1-mt モデルと Belle.train.json トレーニング モデルに基づいており、特定のパラメーターは次のとおりです。 ## さらに、このプロジェクトでは、モデルのトレーニングにさまざまなサイズ (200,000、600,000、100 万、200 万サンプル) の命令学習データ セットとさまざまなモデル バージョンも使用します。以下の通り: ###

## さらに、このプロジェクトでは、モデルのトレーニングにさまざまなサイズ (200,000、600,000、100 万、200 万サンプル) の命令学習データ セットとさまざまなモデル バージョンも使用します。以下の通り: ###

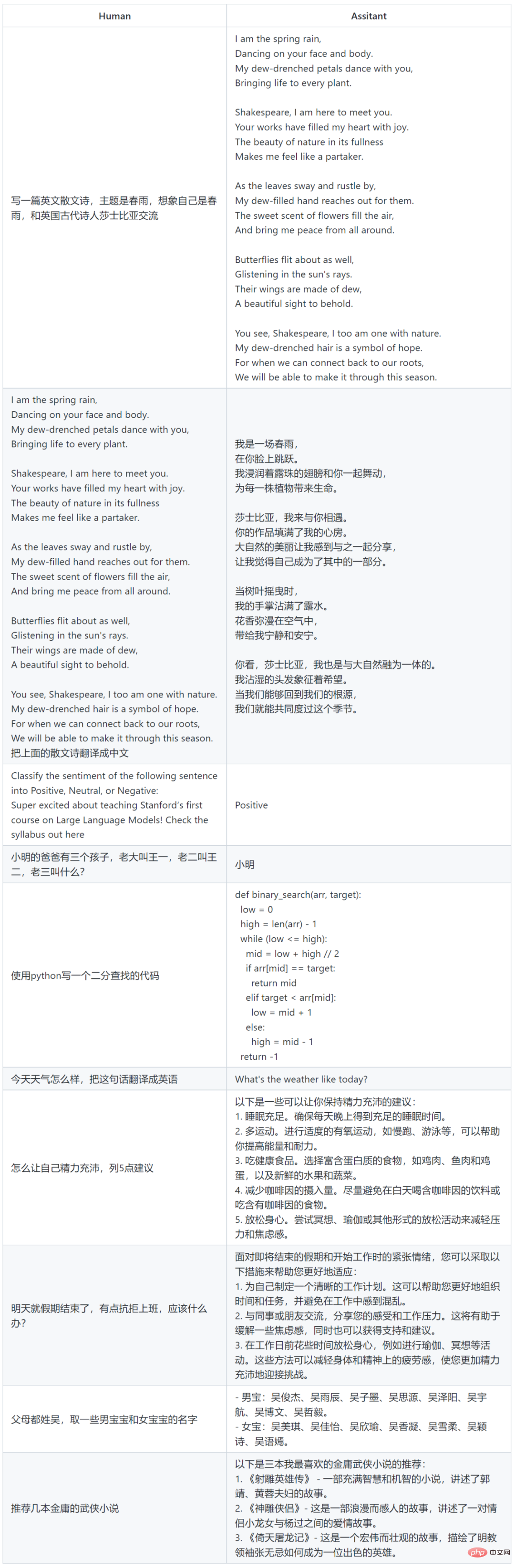

#モデルの使用例

# #現在のデータと基本モデルに基づいて学習された SFT モデルには、効果の点で次のような問題がまだあります。

#事実を伴う指示は、事実に反する誤った答えを生成する可能性があります。

以上がスタンフォード大学の70億パラメータ「アルパカ」の欠点を補うために、中国語に堪能な大規模モデルがオープンソース化されているの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。