説明できない知能は将来どのように発展するのでしょうか?

2023 年以来、ChatGPT と GPT-4 は常に人気の検索リストに載っています。一方で、一般の人たちは、AI が突然非常に強力になったこと、そして AI が「労働者」の生活に革命をもたらすかどうかに驚嘆しています。 ; 一方で、モデルのスケールが一定の限界を突破すると、なぜ驚くべき知性が突然「出現」するのか、内部関係者さえも理解していません。

知性の出現は良いことですが、モデルの制御不能、予測不能、説明不能な動作により、学術コミュニティ全体が混乱と深い考えに陥っています。

まず簡単な質問ですが、以下の絵文字は何の映画を表していますか?

最も単純な言語モデルでは、多くの場合、「その映画は、ある男についての映画です」と書き続けることしかできません。中複雑度モデルの答えがより近く、与えられる答えは次のとおりです。 「絵文字映画」; しかし、最も複雑な言語モデルは 1 つの答えしか与えません: ファインディング ニモ 「ファインディング ニモ」

実際、このプロンプトはさまざまな大規模言語の機能をテストするために設計された 204 項目でもあります。モデル タスクの 1 つ。

このテストの企画に参加した Google Research のコンピューター科学者、イーサン ダイアー氏は、BIG-Bench データセットを構築するときは驚きを覚悟していたが、これらのモデルで何ができるかを実際に目の当たりにしたとき、私はこう言った。まだとても驚いています。

驚くべきことに、これらのモデルはプロンプトのみを必要とします。つまり、テキスト文字列を入力として受け入れ、純粋に統計に基づいて次に何が起こるかを何度も繰り返し予測します。コンテンツ。

コンピュータ科学者は、スケールアップによって既知のタスクのパフォーマンスが向上すると予想していましたが、モデルが突然これほど多くの新しい予測不可能なタスクを処理できるようになるとは予想していませんでした。

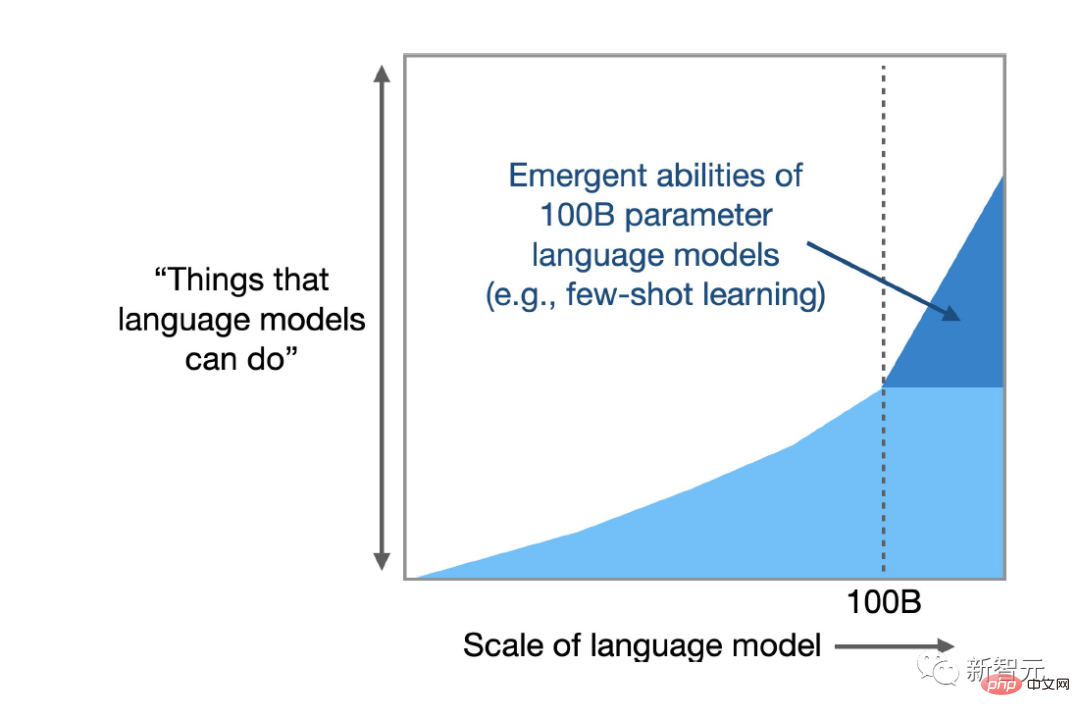

Dyer が参加した最近の調査の結果は、LLM が何百もの「緊急」機能、つまり、大きなモデルでは完了できるが、小さなモデルでは完了できないタスクを生成できることを示しました。テキストの解析に関連するもの、乗算計算から実行可能なコンピュータ コードの生成まで、絵文字記号に基づく映画のデコードなど、関連しないもの

新しい分析によると、特定のタスクと特定のモデルには複雑さのしきい値があり、それを超えるとモデルの機能が飛躍的に向上します。

研究者らはまた、創発的なパワーの別のマイナスの副作用も示唆しました。複雑さが増すにつれて、一部のモデルは応答に新たなバイアスと不正確さを示します。

スタンフォード大学のコンピューター科学者であるリシ・ボンマサニ氏は、私が知る限り、言語モデルがこれらのことを実行できるという議論はどの文献にも存在しないと述べました。昨年、ボンマサニ氏は、ダイアー氏のプロジェクトで見つかったいくつかのものも含め、数十の新たな行動のリストの作成を支援し、そのリストは増え続けています。

論文リンク: https://openreview.net/pdf?id=yzkSU5zdwD

論文リンク: https://openreview.net/pdf?id=yzkSU5zdwD

現在、研究者たちは、より新しい機能を発見するために競争しているだけではありません。また、それらがなぜどのようにして起こるのかを解明しようとしており、本質的には予測不可能性を予測しようとしています。

創発性を理解すると、複雑なモデルが実際に何か新しいことを行っているのか、それとも単に統計が得意になっているだけで問題ないのかなど、人工知能と機械学習全般を取り巻く深い疑問に対する答えが明らかになります。研究者が可能性を活用できるよう支援します。メリットをもたらし、新たなリスクを軽減します。

人工知能スタートアップ Anthroic のコンピューター科学者であるディープ ガングリ氏は、どのアプリケーションの有害な機能が現れるか、それが正常であるか予測不可能であるかを判断する方法はわからないと述べました。

創発の創発

たとえば、無生物の原子が結合して生きた細胞を作り、水分子が波を作り、ムクドリのささやきが変化しながらも認識可能なパターンで空を飛び、細胞が筋肉を動かし、心臓を鼓動させます。

重要なのは、多数の独立した部品を含むシステムには創発的な機能が存在することですが、研究者が LLM でこれらの機能を発見できたのはつい最近のことです。これはおそらく、モデルが十分に大規模になったためと思われます。

言語モデルは何十年も前から存在していますが、5 年前までは、最も強力な武器はリカレント ニューラル ネットワーク (RNN) に基づいていました。トレーニング方法は、テキスト文字列を入力し、次の単語が何であるかを予測することです。これがリカレント (リカレント) と呼ばれる理由は、モデルが自身の出力から学習するためです。つまり、モデルの予測がネットワークにフィードバックされてパフォーマンスが向上します。

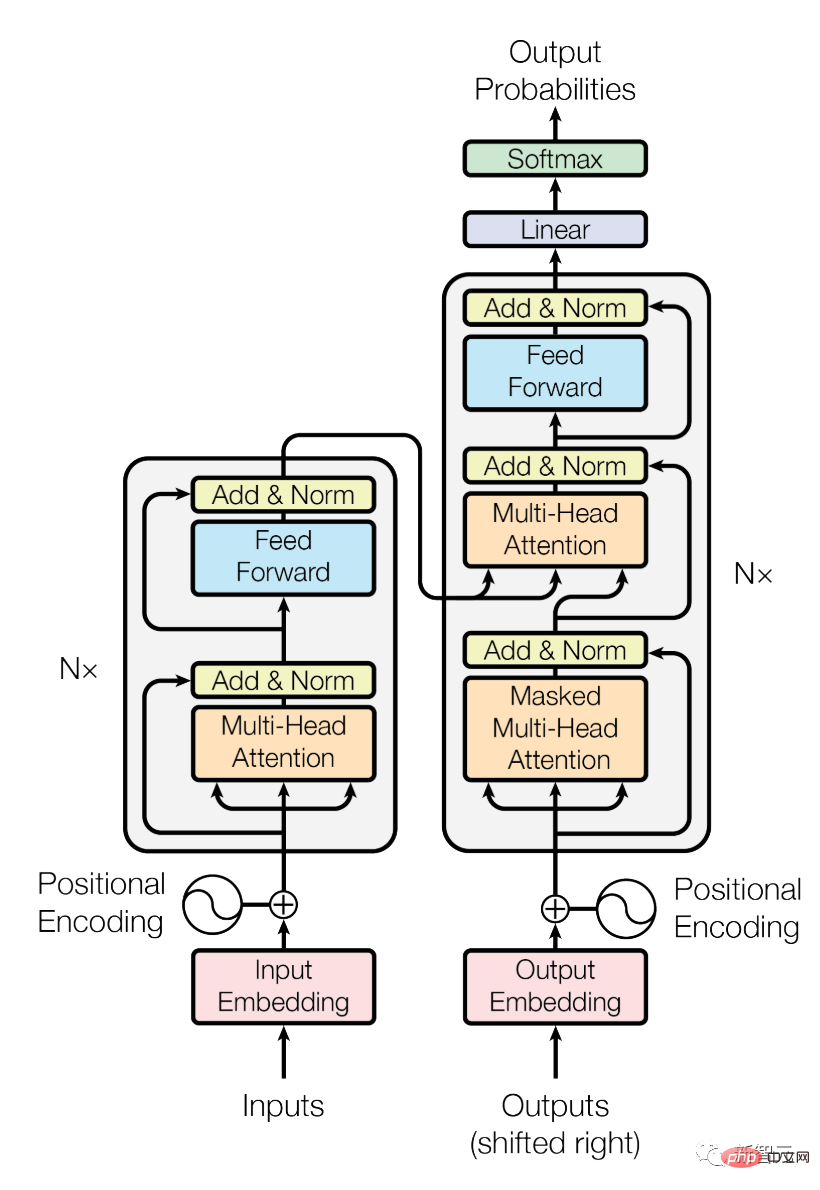

2017 年、Google Brain の研究者は、Transformer と呼ばれる新しいアーキテクチャを導入しました。文を単語ごとに分析するリカレント ネットワークと比較して、Transformer はすべての単語を同時に処理できるため、並列化が可能です。 . 大量のテキストを処理します。

Transformer を使用すると、モデル内のパラメーターの数を増やすことで、言語モデルの複雑さを迅速に拡張できます。パラメーターは単語やその他の要素間の接続と考えることができます。トレーニング中にこれらの接続の重みを調整することで、予測を改善します。

モデル内のパラメーターが多いほど、接続を確立する能力が強化され、人間の言語をシミュレートする能力も強化されます。

予想どおり、OpenAI 研究者による 2020 年の分析では、モデルのサイズが大きくなるにつれて、その精度と機能が向上することがわかりました。

論文リンク: https://arxiv.org/pdf/2001.08361.pdf

GPT-3 (1,750 億パラメータ) および Google With PaLM (5,400 億パラメータまで拡張可能) などのモデルのリリースにより、ユーザーはますます新しい機能を発見しています。

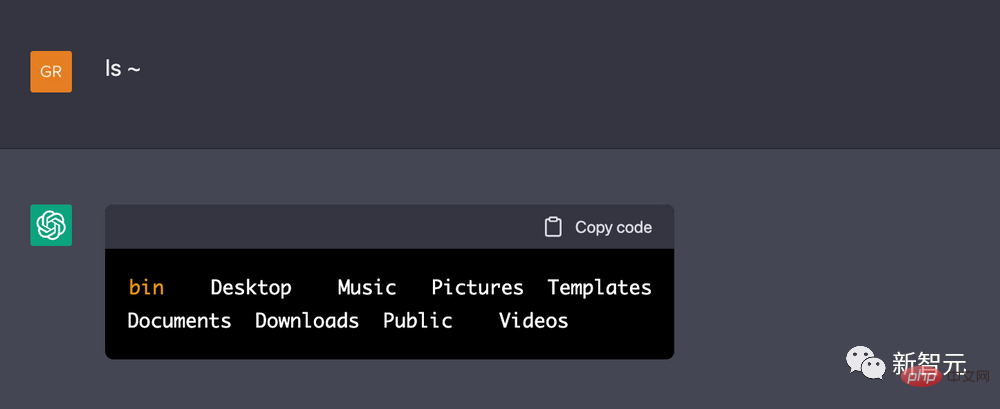

ある DeepMind エンジニアは、ChatGPT に Linux 端末であると認識させ、簡単な数学コードを実行して最初の 10 個の素数を計算できるとさえ報告しました。 ChatGPT は、実際の Linux ボックスで同じコードを実行するよりも速くタスクを完了できることは注目に値します。

映画の絵文字タスクと同様、テキストを予測するための言語モデルがコンピューター端末を模倣できると研究者が考える理由はなく、多くの新たな行動は言語モデルのゼロを示しています。 - ショットまたは少数ショットの学習能力、つまり、これまでに見たことのない、またはめったに見られない問題を解決する LLM の能力。

LLM がトレーニング データの制約を超越できる兆候を発見したため、多くの研究者が創発がどのようなもので、どのように起こるのかをよりよく理解するために取り組んでおり、最初のステップはそれを完全に文書化することです。

2020 年、Google Research の Dyer 氏らは、LLM が変革的な影響を与えるだろうと予測しましたが、その影響が具体的にどのようなものになるのかは未解決の疑問のままです。

したがって、彼らはさまざまな研究チームに、言語モデルの機能の境界を見つけるための困難で多様なタスクの例を提供するよう依頼しました。この研究は、「BIG-bench, Beyond the Imitation Game」(BIG-bench, Beyond the Imitation Game) とも呼ばれています。 Beyond the Imitation Game Benchmark プロジェクトは、アラン チューリングによって提案された「イミテーション ゲーム」にちなんで名付けられ、コンピューターが説得力のある人道的な方法で質問に答えることができるかどうかをテストします (チューリング テストとも呼ばれます)。

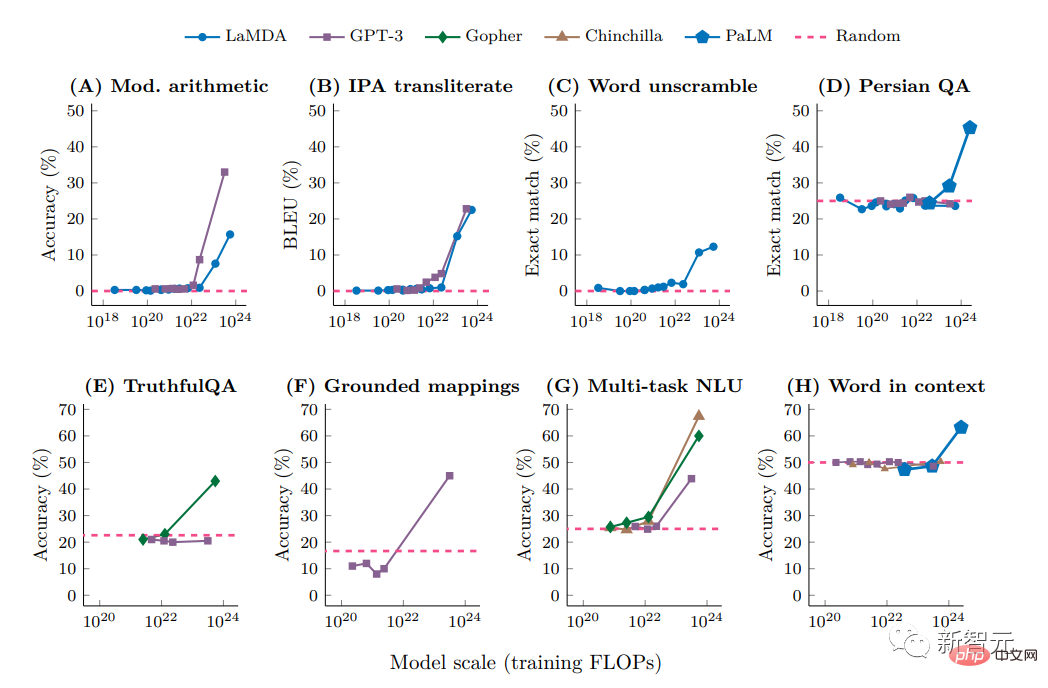

予想どおり、一部のタスクでは、複雑さが増加するにつれてモデルのパフォーマンスがスムーズかつ予測どおり向上しますが、他のタスクでは、パラメーターの数を増やしてもまったく改善が見られませんでした。

しかし、研究者らはタスクの約 5% で、いわゆる「ブレークスルー」、つまり特定のしきい値範囲内でパフォーマンスが急速かつ劇的に向上することを発見しました。これはタスクによって異なり、条件によって異なります。モデルからモデルへ。

たとえば、パラメータが比較的少ない (わずか数百万) モデルは、3 桁の加算または 2 桁の乗算の問題を正常に完了できませんが、数百億のパラメータの場合、一部のモデルの精度は高くなります。大幅な増加。

国際発音記号の解読、単語の文字の解読、ヒンディー語 (ヒンディー語と英語の組み合わせ) の一節における不快な内容の特定、スワヒリ語に似た単語の生成など、他のタスクでも同様の飛躍が見られました。ヘリのことわざ。

しかし研究者たちは、モデルの複雑さが唯一の要因ではないことにすぐに気づきました。データの品質が十分に高ければ、パラメーターが少ない小さなモデルや、より大きなモデルから予期せぬ機能が得られる可能性があります。小さなデータでのトレーニングさらに、クエリの文言もモデルの応答の精度に影響します。

昨年、この分野の主力カンファレンスである NeurIPS で発表された論文の中で、Google Brain の研究者たちは、数学の文章題を正しく解く方法など、ヒント (思考連鎖推論) を使用してモデルに自分自身を説明させる方法を示しました。同じモデルでは、ヒントがなければ正しく解決できません。

紙のリンク: https://neurips.cc/Conferences/2022/ScheduleMultitrack?event=54087

Google Brain の科学者である Yi Tay は、次のことに取り組んでいます。ブレークスルーに関する体系的な研究を行っている同氏は、最近の研究では、思考連鎖プロンプトがモデルのスケール曲線を変化させ、創発点も変化させることが示されていると指摘し、思考連鎖プロンプトを使用すると、BIG実験では見られなかった創発的な行動を誘発する可能性があると指摘した。 。

ブラウン大学のコンピュータ科学者で、言語の計算モデルを研究しているエリー・パブリック氏は、これらの最近の発見は少なくとも 2 つの可能性を提起すると信じています。生物学的システムとの比較が示すように、より大きなモデルは自発的に新しい能力を獲得します。これはおそらく、モデルが根本的に、小さなサイズでは不可能な新しくて異なる何かを学習するためです。モデルにないもの、そしてこれが私たちが望んでいることです。ケースとしては、モデルがスケールアップすると、いくつかの根本的な変化が発生するということです。

もう 1 つの、あまりセンセーショナルではない可能性ですが、画期的な出来事のように見えるのは、思考連鎖推論を通じて動作する内部の統計主導のプロセスである可能性があり、大規模な LLM は単に学習ヒューリストである可能性があります。パラメータやデータ品質が低い場合は、ヒューリスティック アルゴリズムを実装できません。

以上がGPT-4は強すぎてOpenAIですら理解できない!知性はどのようにして突然「出現」したのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。