大規模な言語モデルを包括的に理解するための参考文献リストは次のとおりです。

現代の大規模言語モデルの背後にある設計、制約、進化について学ぶには、この記事の参考文献リストを参照してください。

大規模言語モデルは世間の注目を集め、わずか 5 年で Transforme などのモデルは自然言語処理の分野をほぼ完全に変えました。さらに、コンピューター ビジョンや計算生物学などの分野にも革命を起こし始めています。

Transformers がすべての研究プロセスに非常に大きな影響を与えていることを考慮して、この記事では、機械学習の研究者や実践者が始めるための短い参考文献リストを紹介します。

次のリストは、主にいくつかの学術研究論文を時系列順に展開したものです。もちろん、他にも役立つリソースがたくさんあります。例:

- 「The Illustrated Transformer」Jay Alammar 著

- 「The Transformer Family」Lilian Weng 著

- 「Transformer モデル: 概要とカタログ」 — 2023 年版》

- nanoGPT ライブラリ (Andrej Karpathy 著)

主なアーキテクチャとタスクの理解

Transformers と大規模な言語モデルを初めて使用する場合は、これらの記事があなたに最適です。

論文 1: 「位置合わせと翻訳を共同学習することによるニューラル機械翻訳」

論文アドレス: https:// arxiv.org/pdf/1409.0473.pdf

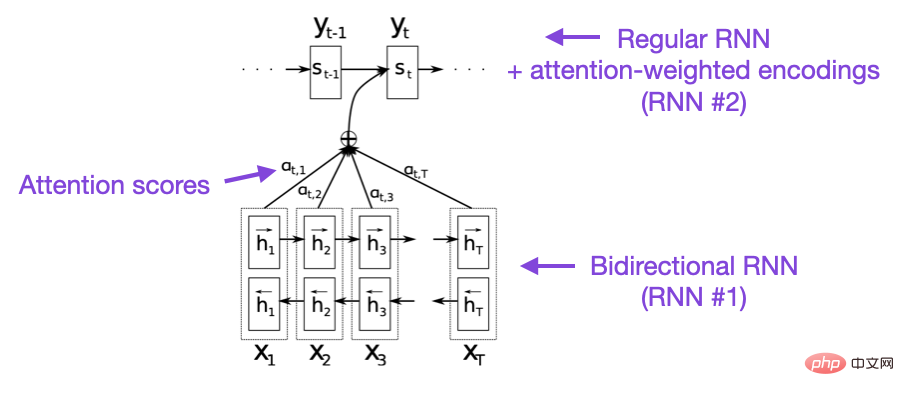

この記事では、モデルの長距離シーケンス モデリング機能を向上させるリカレント ニューラル ネットワーク (RNN) アテンション メカニズムを紹介します。これにより、RNN は長い文をより正確に翻訳できるようになります。これが、元の Transformer アーキテクチャの開発の背後にある動機です。

画像ソース: https://arxiv.org/abs/1409.0473

論文 2: 「必要なのは注意だけです」 》

論文アドレス: https://arxiv.org/abs/1706.03762

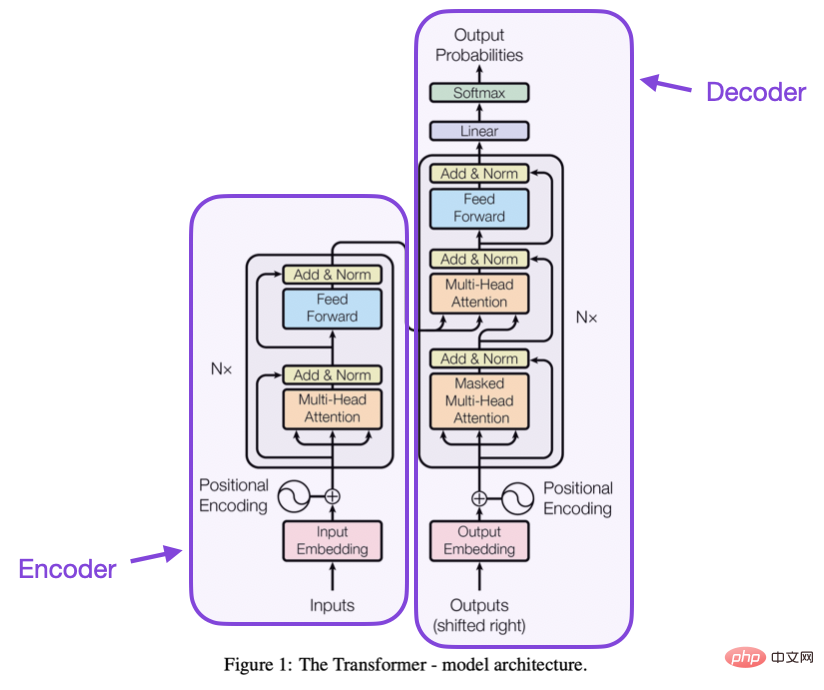

この記事では、エンコーダとデコーダの構成について紹介します。オリジナルの Transformer アーキテクチャでは、これらの部分は後で別個のモジュールとして導入されます。さらに、この記事では、スケーリング ドット積アテンション メカニズム、マルチヘッド アテンション ブロック、位置入力エンコーディングなどの概念も紹介します。これらは依然として現代の Transformers の基礎となっています。

出典: https://arxiv.org/abs/1706.03762

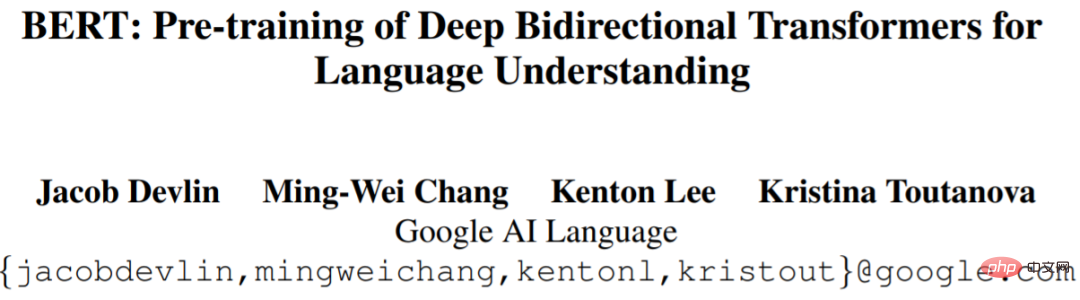

論文 3: 「BERT: Pre -言語理解のための深い双方向トランスフォーマーのトレーニング》

論文アドレス: https://arxiv.org/abs/1810.04805

Large - スケール言語モデルの研究は、初期の Transformer アーキテクチャに従い、その後、予測モデリング タスク (テキスト分類など) 用の Transformer と生成モデリング タスク (翻訳、要約、その他の形式のテキスト作成) 用の Transformer の 2 つの方向に拡張し始めました。変成器。

BERT 論文では、マスクされた言語モデリングの独自の概念が紹介されています。この研究分野に興味がある場合は、事前トレーニングの目標を簡素化する RoBERTa をフォローしてください。

画像ソース: https://arxiv.org/abs/1810.04805

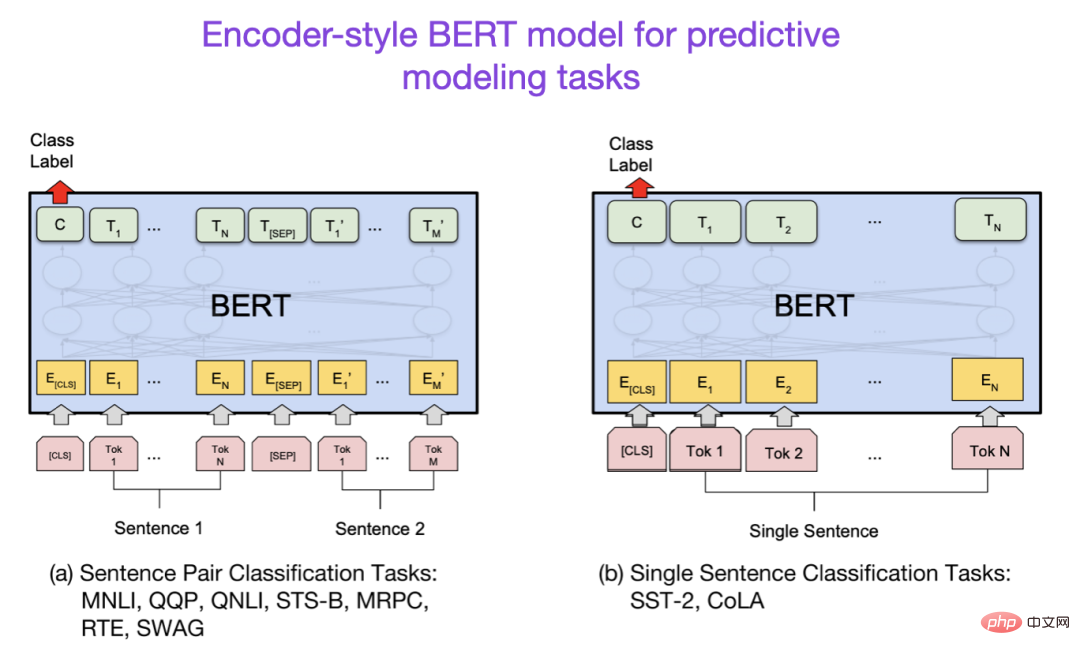

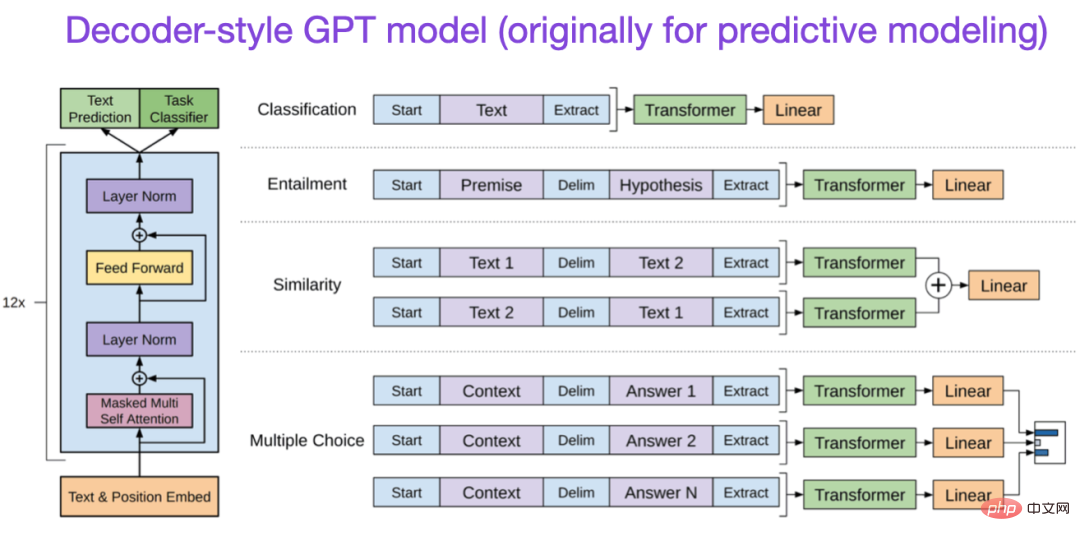

論文 4: 「言語の改善」生成的事前トレーニングによる理解》

論文アドレス: https://www.semanticscholar.org/paper/Improving-Language-Understanding-by-Generative- Radford-Narasimhan/cd18800a0fe0b668a1cc19f2ec95b5003d0a5035

元の GPT 論文では、人気のあるデコーダー スタイルのアーキテクチャと次の単語予測による事前トレーニングが紹介されています。 BERT は、マスクされた言語モデルの事前トレーニング目標により双方向の Transformer であると考えることができますが、GPT は一方向の自己回帰モデルです。 GPT 埋め込みも分類に使用できますが、GPT メソッドは ChatGPT など、今日最も影響力のある LLM の中核となっています。

この研究分野に興味がある場合は、GPT-2 および GPT-3 の論文をフォローしてください。なお、この記事ではInstructGPTメソッドについては後ほど別途紹介します。

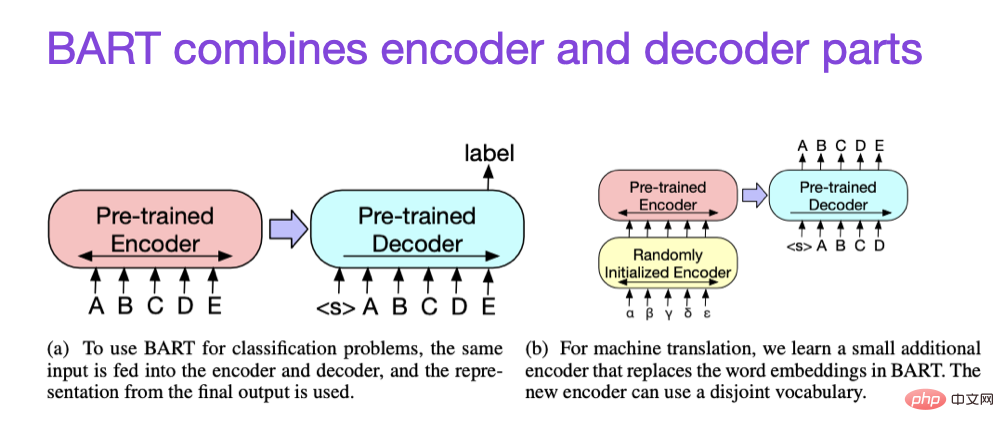

#論文 5: 「BART: 自然言語の生成、翻訳、理解のためのシーケンス間の事前トレーニングのノイズ除去」

#拡張則と効率改善

#拡張則と効率改善

変圧器の効率を改善する技術について詳しく知りたい場合は、次の論文を参照してください

論文 1:「変圧器の効率的なトレーニングに関する調査」- 論文アドレス: https://arxiv.org/abs/2302.01107

##論文 2:「FlashAttendant: IO 認識による高速かつメモリ効率の高い Exact Attendance」

論文 3: 「詰め込み: 1 日で 1 つの GPU で言語モデルをトレーニングする」

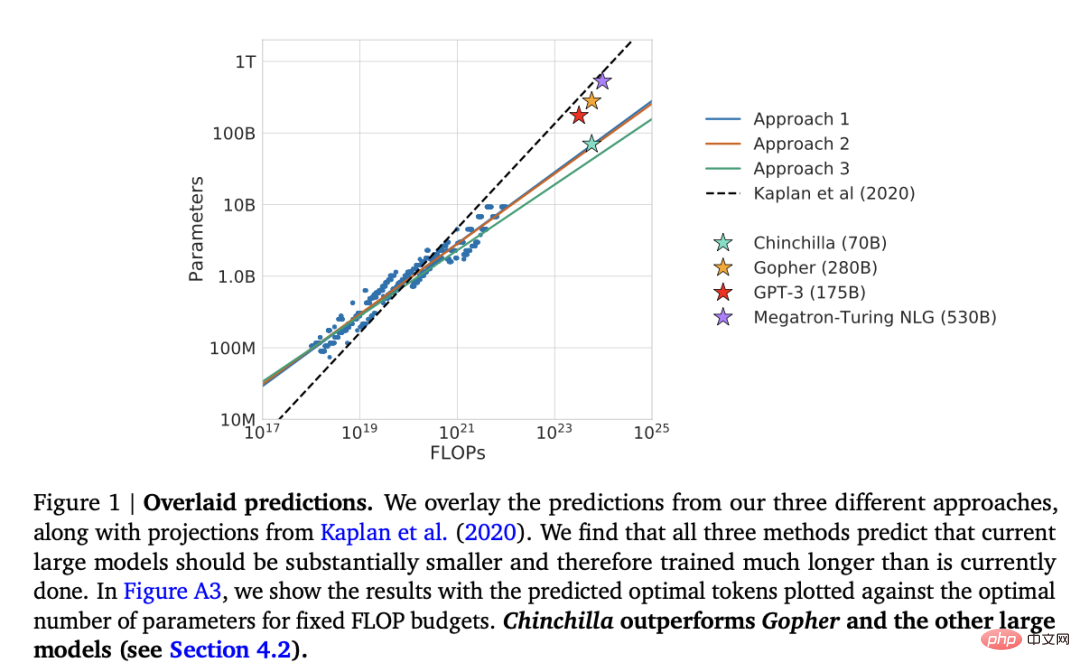

論文 4:「コンピューティングに最適な大規模言語モデルのトレーニング」

- さらに、論文「Training Compute-Optimal Large Language Models」

- 論文アドレス: https:// arxiv.org/abs /2203.15556

この記事では、生成モデリング タスクにおいて一般的な 1,750 億パラメータの GPT-3 モデルを上回る 700 億パラメータのチンチラ モデルを紹介します。ただし、その主なハイライトは、現代の大規模言語モデルが大幅にトレーニングされていないことです。

この記事では、大規模言語モデルのトレーニングのための線形スケーリング則を定義します。たとえば、Chinchilla は GPT-3 の半分のサイズですが、(3,000 億ではなく) 1 兆 4,000 億のトークンでトレーニングされているため、GPT-3 よりも優れたパフォーマンスを発揮します。言い換えれば、トレーニング トークンの数はモデルのサイズと同じくらい重要です。

調整 - 大規模な言語モデルを望ましい目標と関心に向けて導く

近年、比較的強力な手法が数多く登場しています。実際のテキストを生成できるモデル (GPT-3 や Chinchilla など)。一般的に使用されている事前トレーニング パラダイムに関しては、上限に達しているようです。 言語モデルを人間にとってより役立つものにし、誤った情報や悪い言葉を減らすために、研究者は、次の論文を含む、事前トレーニングされた基本モデルを微調整するための追加のトレーニング パラダイムを設計しました。

論文 1:「人間のフィードバックによる指示に従う言語モデルのトレーニング」論文のアドレス: https://arxiv.org/abs/2203.02155- このいわゆる InstructGPT 論文では、研究者は RLHF (ヒューマン フィードバックからの強化学習) を使用しました。彼らは、事前トレーニングされた GPT-3 ベース モデルから開始し、教師あり学習 (ステップ 1) を使用して、人間が生成したキューと応答のペアでモデルをさらに微調整しました。次に、報酬モデルをトレーニングするためにモデルの出力をランク付けするよう人間に依頼しました (ステップ 2)。最後に、報酬モデルを使用して、近位ポリシー最適化による強化学習を使用して、事前トレーニングおよび微調整された GPT-3 モデルを更新します (ステップ 3)。

- ところで、この論文は、ChatGPT の背後にあるアイデアを説明した論文としても知られています。最近の噂によると、ChatGPT は、より大きなデータセットで微調整された InstructGPT の拡張バージョンです。

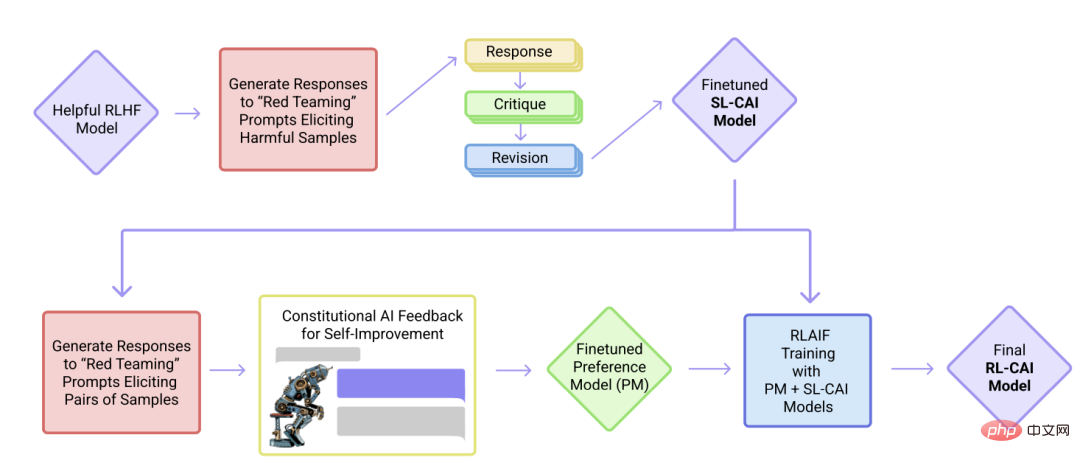

- 論文 2: 「憲法上の AI: AI フィードバックによる無害性」

- 論文アドレス: https://arxiv.org/abs/2212.08073

この記事の内容論文の中で、研究者らはアライメントの考え方をさらに進め、「無害な」AI システムを作成するためのトレーニング メカニズムを提案しています。研究者らは、人間が直接監督するのではなく、(人間が提供する)ルールのリストに基づいた自己訓練メカニズムを提案した。前述の InstructGPT の論文と同様に、提案された手法は強化学習手法を使用します。

概要

この記事では、上記のフォームの配置をできるだけシンプルかつ美しく保つよう努めています。最初の 10 個に焦点を当てることをお勧めします。現代の大規模言語モデルの背後にある考え方、設計、制限、進化を理解するための論文。

さらに詳しく読みたい場合は、上記の論文の参考文献を参照することをお勧めします。あるいは、読者がさらに詳しく調べるための追加リソースがいくつかあります:

GPT の代替オープンソース

- 論文 1: 「BLOOM: A 176B-Parameter Open」 -多言語言語モデルへのアクセス》

- 論文アドレス: https://arxiv.org/abs/2211.05100

- 論文 2 : 「OPT: オープンな事前トレーニング済み Transformer 言語モデル」

- 論文アドレス: https://arxiv.org/abs/2205.01068

ChatGPT 代替案

- 論文 1「LaMDA: ダイアログ アプリケーションの言語モデル」

- 論文アドレス: https://arxiv.org/abs/2201.08239

- 論文 2: 「対象を絞った人間の判断による対話エージェントの調整の改善」

- 論文のアドレス: https://arxiv.org/abs/2209.14375

- 論文 3: 「BlenderBot 3: 責任を持って関与することを継続的に学習する、デプロイされた会話型エージェント」

- 論文のアドレス: https://arxiv.org/abs /2208.03188

計算生物学における大規模言語モデル

- 論文 1: 「ProtTrans: 自己を介して生命のコードの言語を解読することに向けて」教師あり学習》

- 論文アドレス: https://arxiv.org/abs/2007.06225

- 論文 2: 「高精度」 AlphaFold によるタンパク質構造予測」

- 論文アドレス: https://www.nature.com/articles/s41586-021-03819-2

- ##論文 3:「大規模言語モデルは多様なファミリーにわたる機能的タンパク質配列を生成する」

- 論文アドレス: https://www.nature.com/articles/s41587-022-01618- 2

以上が大規模な言語モデルを包括的に理解するための参考文献リストは次のとおりです。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7529

7529

15

15

1378

1378

52

52

82

82

11

11

21

21

76

76

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverのファイアウォールの構成は、サーバーのセキュリティを確保するための重要なステップです。以下は、iPtablesやFirewalldの使用を含む、一般的に使用されるファイアウォール構成方法です。 iPtablesを使用してファイアウォールを構成してIPTablesをインストールします(まだインストールされていない場合):sudoapt-getupdatesudoapt-getinstalliptablesview現在のiptablesルール:sudoiptables-l configuration

Debian Apacheログレベルを設定する方法

Apr 13, 2025 am 08:33 AM

Debian Apacheログレベルを設定する方法

Apr 13, 2025 am 08:33 AM

この記事では、DebianシステムのApachewebサーバーのロギングレベルを調整する方法について説明します。構成ファイルを変更することにより、Apacheによって記録されたログ情報の冗長レベルを制御できます。方法1:メイン構成ファイルを変更して、構成ファイルを見つけます。Apache2.xの構成ファイルは、通常/etc/apache2/ディレクトリにあります。ファイル名は、インストール方法に応じて、apache2.confまたはhttpd.confである場合があります。構成ファイルの編集:テキストエディターを使用してルートアクセス許可を使用して構成ファイルを開く(nanoなど):sudonano/etc/apache2/apache2.conf

Debian Readdirのパフォーマンスを最適化する方法

Apr 13, 2025 am 08:48 AM

Debian Readdirのパフォーマンスを最適化する方法

Apr 13, 2025 am 08:48 AM

Debian Systemsでは、Directoryコンテンツを読み取るためにReadDirシステム呼び出しが使用されます。パフォーマンスが良くない場合は、次の最適化戦略を試してください。ディレクトリファイルの数を簡素化します。大きなディレクトリをできる限り複数の小さなディレクトリに分割し、Readdirコールごとに処理されたアイテムの数を減らします。ディレクトリコンテンツのキャッシュを有効にする:キャッシュメカニズムを構築し、定期的にキャッシュを更新するか、ディレクトリコンテンツが変更されたときに、頻繁な呼び出しをreaddirに削減します。メモリキャッシュ(memcachedやredisなど)またはローカルキャッシュ(ファイルやデータベースなど)を考慮することができます。効率的なデータ構造を採用する:ディレクトリトラバーサルを自分で実装する場合、より効率的なデータ構造(線形検索の代わりにハッシュテーブルなど)を選択してディレクトリ情報を保存およびアクセスする

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Systemsでは、Readdir関数はディレクトリコンテンツを読み取るために使用されますが、それが戻る順序は事前に定義されていません。ディレクトリ内のファイルを並べ替えるには、最初にすべてのファイルを読み取り、QSORT関数を使用してソートする必要があります。次のコードは、debianシステムにreaddirとqsortを使用してディレクトリファイルを並べ替える方法を示しています。

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

DebianシステムのReadDir関数は、ディレクトリコンテンツの読み取りに使用されるシステムコールであり、Cプログラミングでよく使用されます。この記事では、ReadDirを他のツールと統合して機能を強化する方法について説明します。方法1:C言語プログラムを最初にパイプラインと組み合わせて、cプログラムを作成してreaddir関数を呼び出して結果をinclude#include#include inctargc、char*argv []){dir*dir; structdireant*entry; if(argc!= 2){(argc!= 2){

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail ServerにSSL証明書をインストールする手順は次のとおりです。1。最初にOpenSSL Toolkitをインストールすると、OpenSSLツールキットがシステムに既にインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoapt-getUpdatesudoapt-getInstalopenssl2。秘密キーと証明書のリクエストを生成次に、OpenSSLを使用して2048ビットRSA秘密キーと証明書リクエスト(CSR)を生成します:Openss

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian Systemsでは、OpenSSLは暗号化、復号化、証明書管理のための重要なライブラリです。中間の攻撃(MITM)を防ぐために、以下の測定値をとることができます。HTTPSを使用する:すべてのネットワーク要求がHTTPの代わりにHTTPSプロトコルを使用していることを確認してください。 HTTPSは、TLS(Transport Layer Security Protocol)を使用して通信データを暗号化し、送信中にデータが盗まれたり改ざんされたりしないようにします。サーバー証明書の確認:クライアントのサーバー証明書を手動で確認して、信頼できることを確認します。サーバーは、urlsessionのデリゲート方法を介して手動で検証できます

Debian Hadoopログ管理を行う方法

Apr 13, 2025 am 10:45 AM

Debian Hadoopログ管理を行う方法

Apr 13, 2025 am 10:45 AM

DebianでHadoopログを管理すると、次の手順とベストプラクティスに従うことができます。ログ集約を有効にするログ集約を有効にします。Yarn.log-Aggregation-set yarn-site.xmlファイルでは、ログ集約を有効にします。ログ保持ポリシーの構成:yarn.log-aggregation.retain-secondsを設定して、172800秒(2日)などのログの保持時間を定義します。ログストレージパスを指定:Yarn.Nを介して