Google がマルチモーダル Vid2Seq を発表、オンラインでビデオ IQ を理解、字幕はオフラインにならない | CVPR 2023

中国の医師と Google の科学者は最近、ビデオ内の複数のイベントを区別して説明できる事前トレーニング済み視覚言語モデル Vid2Seq を提案しました。この論文は CVPR 2023 に受理されました。

最近、Google の研究者は、マルチイベント ビデオを記述するための事前トレーニング済み視覚言語モデル Vid2Seq を提案し、CVPR23 に受け入れられました。

以前は、ビデオには異なる時間スケールで発生する複数のイベントが含まれることが多かったため、ビデオ コンテンツを理解するのは困難な作業でした。

たとえば、マッシャーが犬をそりに繋ぎ、犬が走り始めるビデオには、長いイベント (犬ぞり) と短いイベント (犬がそりに繋がれている) が含まれます。

ビデオ理解研究を進める 1 つの方法は、高密度のビデオ アノテーション タスクを使用することです。これには、1 分間のビデオ内のすべてのイベントを時間的に位置特定して説明することが含まれます。

論文アドレス: https://arxiv.org/abs/2302.14115

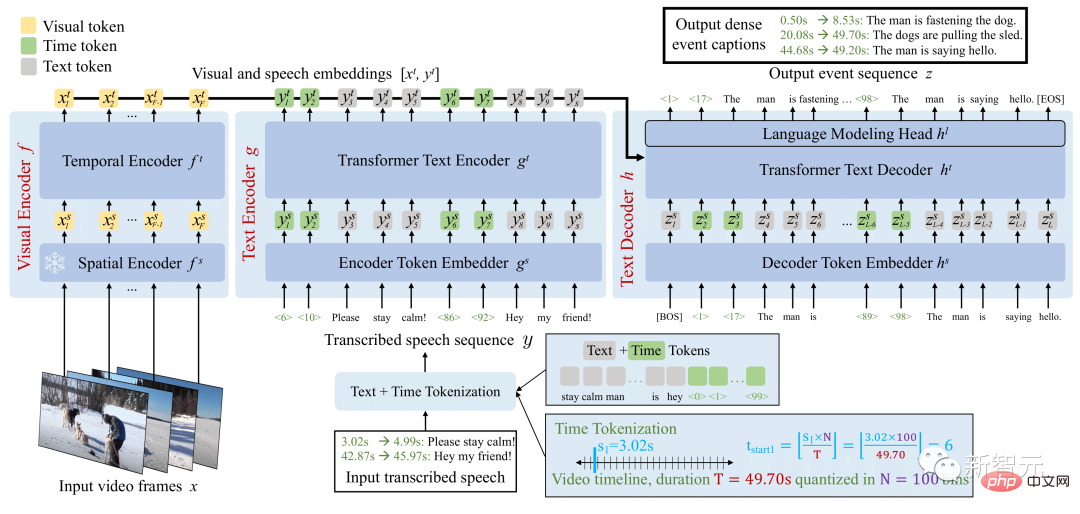

Vid2Seq アーキテクチャは、特別なタイムスタンプを使用して言語モデルを強化し、同じ出力シーケンス内のイベントの境界とテキストの説明をシームレスに予測します。

この統合モデルを事前トレーニングするために、研究者たちはラベルのないナレーション付きビデオを利用しました。

Vid2Seq モデルの概要

結果として得られた Vid2Seq モデルは、数百万のナレーション付きビデオで事前トレーニングされ、ビデオ アノテーション ベンチマークのさまざまな高密度の技術レベルが向上しました。 YouCook2、ViTT、ActivityNet のキャプション。

Vid2Seq は、数ショットの高密度ビデオ アノテーション設定、ビデオ セグメント アノテーション タスク、および標準ビデオ アノテーション タスクにも適しています。

高密度ビデオ注釈用の視覚言語モデル

マルチモーダル Transformer アーキテクチャにより、アクション認識などのさまざまなビデオ タスクの SOTA が更新されました。ただし、このようなアーキテクチャを、数分間のビデオ内のイベントを共同で見つけて注釈を付けるという複雑なタスクに適応させるのは簡単ではありません。

この目標を達成するために、研究者は、空間ドメインの Pix2Seq と同様に、ビデオ内の離散タイムスタンプを表す特別なタイム マーカー (テキスト マーカーなど) を使用して視覚言語モデルを強化しました。

特定のビジュアル入力に対して、結果として得られる Vid2Seq モデルは、入力を受け入れ、テキストおよび時間タグ付きシーケンスを生成することができます。

まず、これにより、Vid2Seq モデルは、単一のトークン シーケンスとして投影される、文字起こしされた音声入力の時間情報を理解できるようになります。第 2 に、これにより、Vid2Seq は単一のマーカー シーケンスを生成しながら、ビデオ内の高密度イベント アノテーションを時間的に統合して予測できるようになります。

Vid2Seq アーキテクチャには、ビデオ フレームと文字起こしされた音声入力をそれぞれエンコードするビジュアル エンコーダとテキスト エンコーダが含まれています。結果のエンコードはテキスト デコーダに転送され、高密度イベント アノテーションの出力シーケンスとビデオ内での時間的位置が自動的に予測されます。このアーキテクチャは、強力なビジュアル バックボーンと強力な言語モデルで初期化されています。

ビデオに関する大規模な事前トレーニング

高密度ビデオ アノテーションのアノテーションを手動で収集することは、タスクの集中的な性質のため、特にコストがかかります。

したがって、研究者らは、大規模に簡単に利用できる、ラベルのないナレーション ビデオを使用して Vid2Seq モデルを事前トレーニングしました。また、YT-Temporal-1B データセットも使用しました。これには、幅広い領域をカバーする 1,800 万本のナレーション付きビデオが含まれています。

研究者らは、書き起こされた音声文とそれに対応するタイムスタンプを監視として使用し、これらの文は単一のトークン シーケンスとして投影されました。

Vid2Seq は、視覚入力が与えられた文字起こしされた音声シーケンスのみを予測するようにデコーダーに教える生成目標と、マルチモーダル学習を促進するノイズ除去目標を使用して事前トレーニングされ、モデルにノイズの多い文字起こしされた音声のコンテキストでの予測マスクを要求します。シーケンスと視覚的な入力。特に、スパントークンをランダムにマスクすることによって、音声シーケンスにノイズが追加されます。

下流タスクのベンチマーク結果

結果として得られる事前トレーニング済み Vid2Seq モデルは、教師強制を使用する単純な最尤目標 (つまり、次のトークンに基づいて次のトークンを予測すると仮定した場合) を介して、下流タスクで微調整できます。以前の基本的な実際のトークン)。

微調整後、Vid2Seq は 3 つの標準的なダウンストリーム高密度ビデオ アノテーション ベンチマーク (ActivityNet Captions、YouCook2、および ViTT) と 2 つのビデオ クリップ アノテーション ベンチマーク (MSR-VTT、MSVD) で SOTA を上回りました。

この論文には、追加のアブレーション研究、定性的結果、数ショット設定およびビデオ段落注釈タスクの結果が含まれています。

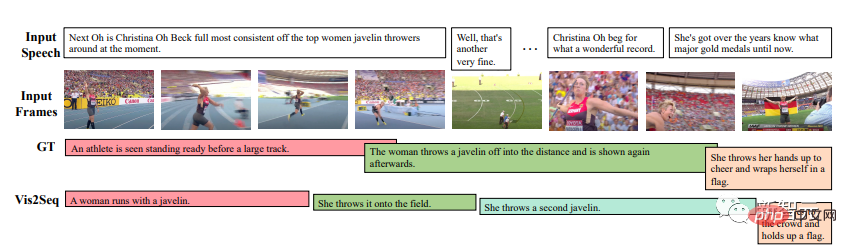

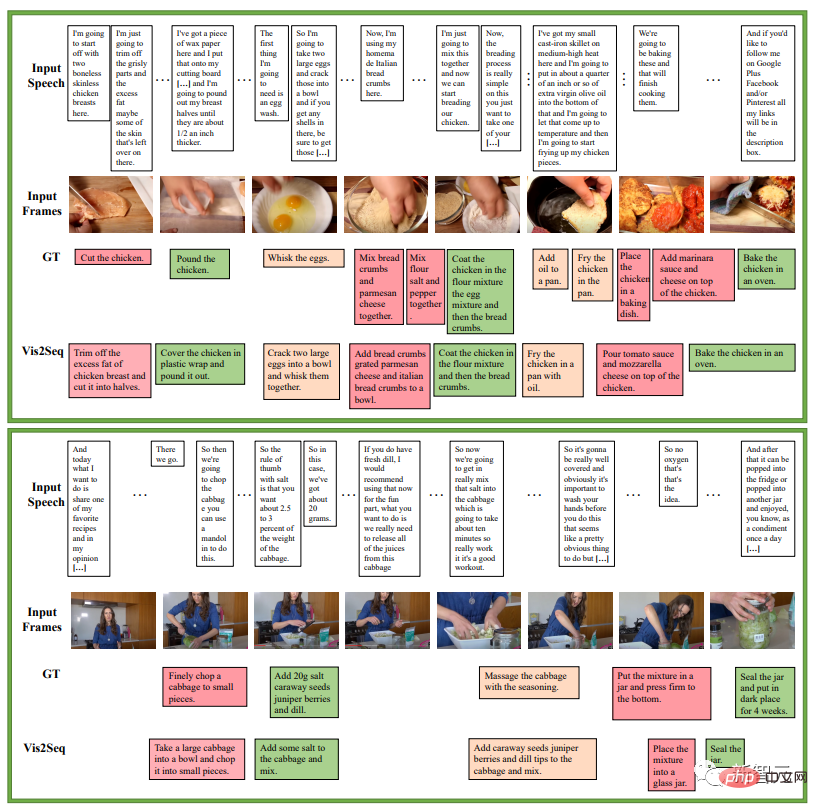

定性テスト

結果は、Vid2Seq が意味のあるイベントの境界と注釈を予測できること、および予測された注釈と境界が書き起こされた音声入力とは大きく異なることを示しています (これは、入力の重要性が重要であることも示しています)視覚マーカーの)。

次の例は、料理レシピの一連の指示に関するもので、YouCook2 検証セットに対する Vid2Seq による集中的なイベント アノテーション予測の例です。

以下は、ActivityNet Captions 検証セットでの Vid2Seq の高密度イベント アノテーション予測の例です。これらのビデオにはすべて、文字起こしされた音声がありません。

しかし、それでも失敗するケースはあるでしょう。たとえば、Vid2Seq 氏によると、下の赤でマークされた写真は、カメラの前で帽子を脱ぐ人物です。

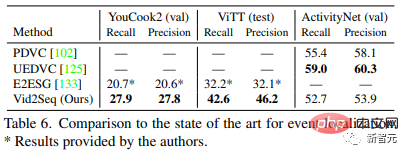

SOTA のベンチマーク

表 5 は、Vid2Seq と最先端の高密度ビデオ アノテーション メソッドを比較しています。Vid2Seq は、YouCook2、ViTT、ActivityNet Captions の 3 つのデータ セットで SOTA を更新します。

YouCook2 と ActivityNet Captions における Vid2Seq の SODA インジケーターは、PDVC と UEDVC よりそれぞれ 3.5 ポイントと 0.3 ポイント高くなっています。また、E2ESG は Wikihow でドメイン内のプレーン テキストの事前トレーニングを使用しており、Vid2Seq はこの方法よりも優れています。これらの結果は、事前トレーニングされた Vid2Seq モデルが高密度イベントをラベル付けする強力な能力を備えていることを示しています。

表 6 は、高密度ビデオ アノテーション モデルのイベント位置特定パフォーマンスを評価します。 YouCook2 や ViTT と比較して、Vid2Seq は高密度ビデオ アノテーションを単一のシーケンス生成タスクとして処理する点で優れています。

ただし、PDVC や UEDVC と比較すると、Vid2Seq は、ActivityNet キャプションでのパフォーマンスが低くなります。これら 2 つの方法と比較して、Vid2Seq は時間的位置特定に関する事前知識をあまり統合しませんが、他の 2 つの方法にはイベント カウンターなどのタスク固有のコンポーネントが含まれているか、位置特定サブタスク用にモデルを個別にトレーニングします。

実装の詳細

- アーキテクチャ

ビジュアル テンポラル トランスフォーマー エンコーダー、テキスト エンコーダー、およびテキスト デコーダーはすべて、12 レイヤー、12 ヘッド、埋め込み次元 768、 MLP 隠された次元 2048。

テキスト エンコーダーとデコーダーのシーケンスは、事前トレーニング中は L=S=1000 トークンに切り詰められるか、微調整中は S=1000 および L=256 トークンにパディングされます。推論中に、ビーム検索デコードが使用され、最初の 4 つのシーケンスが追跡され、0.6 の長さ正規化が適用されます。

- トレーニング

著者は、重み減衰なしで Adam オプティマイザー β=(0.9, 0.999) を使用しています。

事前トレーニング中、1e^-4 の学習率が使用され、最初の 1000 回の反復では線形にウォームアップ (0 から開始) され、残りの反復では一定に保たれます。

微調整中は、3e^-4 の学習率を使用し、反復の最初の 10% では線形にウォームアップ (0 から開始) し、残りの 90 % ではコサイン減衰 (0 まで) を維持します。反復の%。このプロセスでは、32 個のビデオのバッチ サイズが使用され、16 個の TPU v4 チップに分割されます。

著者は、YouCook2 に対して 40 エポック調整、ActivityNet Captions と ViTT に対して 20 エポック調整、MSR-VTT に対して 5 エポック調整、MSVD に対して 10 エポック調整を行いました。

結論

Googleが提案したVid2Seqは、高密度ビデオアノテーションのための新しいビジュアル言語モデルであり、ラベルのないナレーションビデオに対して大規模な事前トレーニングを効果的に実行でき、さまざまなダウンストリームでSOTA結果を達成しています高密度ビデオ注釈ベンチマーク。

著者紹介

論文の筆頭著者: Antoine Yang

Antoine Yang は、パリの Inria および高等師範学校の WILLOW チームの博士課程 3 年生で、指導教員は Antoine Mitoch、Josef Sivic、Ivan Laptev、Cordelia Schmid です。

現在の研究は、ビデオを理解するための視覚言語モデルの学習に焦点を当てています。彼は2019年にファーウェイのノアの方舟研究所でインターンし、2020年にパリのエコール・ポリテクニックで工学の学位を取得し、パリ国立大学サクレー校で数学、ビジョン、学習の修士号を取得し、2022年にGoogle Researchでインターンを務めた。

以上がGoogle がマルチモーダル Vid2Seq を発表、オンラインでビデオ IQ を理解、字幕はオフラインにならない | CVPR 2023の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7541

7541

15

15

1381

1381

52

52

83

83

11

11

21

21

86

86

Windows 11で不要な表示言語を完全に削除する方法

Sep 24, 2023 pm 04:25 PM

Windows 11で不要な表示言語を完全に削除する方法

Sep 24, 2023 pm 04:25 PM

同じセットアップで長時間作業したり、PC を他の人と共有したりします。いくつかの言語パックがインストールされている可能性があり、競合が発生することがよくあります。そこで、Windows 11 で不要な表示言語を削除しましょう。競合といえば、複数の言語パックがある場合、誤って Ctrl+Shift を押すとキーボード レイアウトが変更されてしまいます。これに注意しないと、当面の作業に支障をきたす可能性があります。それでは、早速メソッドの説明に入りましょう。 Windows 11 から表示言語を削除するにはどうすればよいですか? 1. [設定] から [+] を押して設定アプリを開き、ナビゲーション ペインから [時刻と言語] に移動して、[言語と地域] をクリックします。 Windows 削除する表示言語の横にある省略記号をクリックし、ポップアップ メニューから [削除] を選択します。クリック "

iPhoneで言語を変更する3つの方法

Feb 02, 2024 pm 04:12 PM

iPhoneで言語を変更する3つの方法

Feb 02, 2024 pm 04:12 PM

iPhone が最も使いやすい電子機器の 1 つであることは周知の事実であり、その理由の 1 つは、自分好みに簡単にカスタマイズできることです。個人設定では、iPhone のセットアップ時に選択した言語とは別の言語に変更できます。複数の言語に精通している場合、または iPhone の言語設定が間違っている場合は、以下で説明するように変更できます。 iPhoneの言語を変更する方法[3つの方法] iOSでは、ユーザーはさまざまなニーズに合わせてiPhoneの優先言語を自由に切り替えることができます。 Siri との対話言語を変更して、音声アシスタントとのコミュニケーションを容易にすることができます。同時に、ローカルキーボードを使用する場合、複数の言語を簡単に切り替えることができ、入力効率が向上します。

大規模な言語モデルに包括的なオーディオビジュアル機能を追加し、DAMO アカデミーがソース Video-LLaMA をオープンします

Jun 09, 2023 pm 09:28 PM

大規模な言語モデルに包括的なオーディオビジュアル機能を追加し、DAMO アカデミーがソース Video-LLaMA をオープンします

Jun 09, 2023 pm 09:28 PM

今日のソーシャル メディアやインターネット文化においてビデオの役割はますます重要になっており、Douyin、Kuaishou、Bilibili などは数億人のユーザーに人気のプラットフォームとなっています。ユーザーは、自分の人生の瞬間、創造的な作品、興味深い瞬間、その他のビデオを中心としたコンテンツを共有して、他のユーザーと交流し、コミュニケーションを図ります。最近、大規模な言語モデルが優れた機能を実証しました。大型モデルに「目」と「耳」を持たせて、動画を理解してユーザーと対話できるようにすることはできないだろうか。この問題から出発して、DAMO アカデミーの研究者は、包括的なオーディオビジュアル機能を備えた大規模モデルである Video-LLaMA を提案しました。 Video-LLaMA は、ビデオ内のビデオ信号とオーディオ信号を認識して理解することができ、ユーザーが入力した指示を理解して、オーディオとビデオに基づいた一連の複雑なタスクを完了できます。

Win10コンピュータの言語を中国語に設定するにはどうすればよいですか?

Jan 05, 2024 pm 06:51 PM

Win10コンピュータの言語を中国語に設定するにはどうすればよいですか?

Jan 05, 2024 pm 06:51 PM

コンピュータ システムをインストールしただけで、システムが英語になっている場合があります。この場合、コンピュータの言語を中国語に変更する必要があります。それでは、win10 システムでコンピュータの言語を中国語に変更するにはどうすればよいでしょうか?具体的な操作方法を説明します。 。 win10 でコンピューターの言語を中国語に変更する方法 1. コンピューターの電源を入れ、左下隅にあるスタート ボタンをクリックします。 2. 左側の設定オプションをクリックします。 3. 開いたページで「時刻と言語」を選択します 4. 開いたら、左側の「言語」をクリックします 5. ここで、希望するコンピューター言語を設定できます。

なんという騒音でしょう! ChatGPT は言語を理解できますか? PNAS:まず「理解」とは何かを勉強しましょう

Apr 07, 2023 pm 06:21 PM

なんという騒音でしょう! ChatGPT は言語を理解できますか? PNAS:まず「理解」とは何かを勉強しましょう

Apr 07, 2023 pm 06:21 PM

機械がそれについて考えることができるかどうかを問うのは、潜水艦が泳げるかどうかを問うようなものです。 ——ダイクストラ ChatGPT のリリース前から、業界はすでに大規模モデルによってもたらされる変化の匂いを嗅いでいました。昨年10月14日、サンタフェ研究所のメラニー・ミッチェル教授とデビッド・C・クラカウアー教授は、arXivに関するレビューを発表し、「大規模な事前トレーニング済み言語モデルが言語を理解できるかどうか」のあらゆる側面を包括的に調査した。 「賛成」と「反対」の議論、およびこれらの議論から導き出される広範な知能科学における重要な問題について説明します。論文リンク: https://arxiv.o

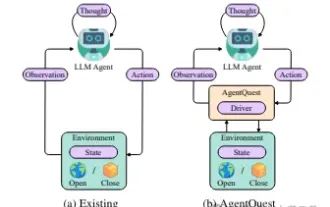

エージェントの境界の探索: 大規模な言語モデル エージェントのパフォーマンスを包括的に測定および改善するためのモジュール式ベンチマーク フレームワークである AgentQuest

Apr 11, 2024 pm 08:52 PM

エージェントの境界の探索: 大規模な言語モデル エージェントのパフォーマンスを包括的に測定および改善するためのモジュール式ベンチマーク フレームワークである AgentQuest

Apr 11, 2024 pm 08:52 PM

大規模モデルの継続的な最適化に基づいて、LLM エージェント - これらの強力なアルゴリズム エンティティは、複雑な複数ステップの推論タスクを解決する可能性を示しています。自然言語処理から深層学習に至るまで、LLM エージェントは徐々に研究や業界の焦点になりつつあります。LLM エージェントは、人間の言語を理解して生成するだけでなく、戦略を策定し、多様な環境でタスクを実行し、API 呼び出しやコーディングを使用して構築することもできます。ソリューション。この文脈において、AgentQuest フレームワークの導入はマイルストーンであり、LLM エージェントの評価と進歩のためのモジュール式ベンチマーク プラットフォームを提供するだけでなく、研究者にこれらのエージェントのパフォーマンスを追跡および改善するための強力なツールも提供します。より細かいレベル

口を動かすだけで原神がプレイできる! AIを使ってキャラクターを切り替えて敵を攻撃するネチズン「アヤカ、神里流フロストデストラクションを使って」

May 13, 2023 pm 07:52 PM

口を動かすだけで原神がプレイできる! AIを使ってキャラクターを切り替えて敵を攻撃するネチズン「アヤカ、神里流フロストデストラクションを使って」

May 13, 2023 pm 07:52 PM

過去 2 年間で世界中で人気を博した国産ゲームといえば、間違いなく原神が挙げられます。 5月に発表された今年第1四半期のモバイルゲーム収益調査報告書によると、「原神」が5億6,700万ドルの絶対的な優位性を獲得し、カードを引くモバイルゲームの中で断然1位を獲得したことも発表された。わずか 18 年でオンライン化され、数か月後、モバイル プラットフォームだけでの総収益は 30 億米ドル (約 130 億リンギット) を超えました。さて、Xumi オープン前の最後の 2.8 アイランド バージョンは長い間待ち望まれており、長いドラフト期間を経て、ようやく新しいプロットとプレイできるエリアが登場しました。でも、「肝臓皇帝」が何人いるのかは分かりませんが、島の探索が完了し、また草が生え始めました。宝箱は合計 182 個 + モラボックス 1 個 (含まれていません) 草期間が長くても心配する必要はありません。いや、長い草のあいだに

vivox60proの言語表示を変更する方法 vivox60proのシステム言語設定方法

Mar 23, 2024 am 09:06 AM

vivox60proの言語表示を変更する方法 vivox60proのシステム言語設定方法

Mar 23, 2024 am 09:06 AM

1. 電話機設定メニューの[システム管理]をクリックします。 2. [言語]オプションをクリックします。 3. 使用するシステム言語を選択します。