「数学初心者」ChatGPT は人間の好みをよく理解しています。オンラインでの乱数の生成は宇宙に対する究極の答えです

ChatGPT は、乱数を生成する際の人間のトリックも理解します。

ChatGPT はでたらめアーティストであり、誤った情報を広めているかもしれませんが、「数学者」ではありません。

最近、メタ データ サイエンティストの Colin Fraser は、ChatGPT が真の乱数を生成することはできず、むしろ「人間の乱数」に近いことを発見しました。

実験を通じて、フレーザー氏は「ChatGPT は 42 と 7 という数字がとても好きだ」と結論付けました。

ネチズンは、これは人間がこれらの数字をとても好むことを意味すると述べました。 番号。

ChatGPT も「宇宙への究極の答え」が大好きです

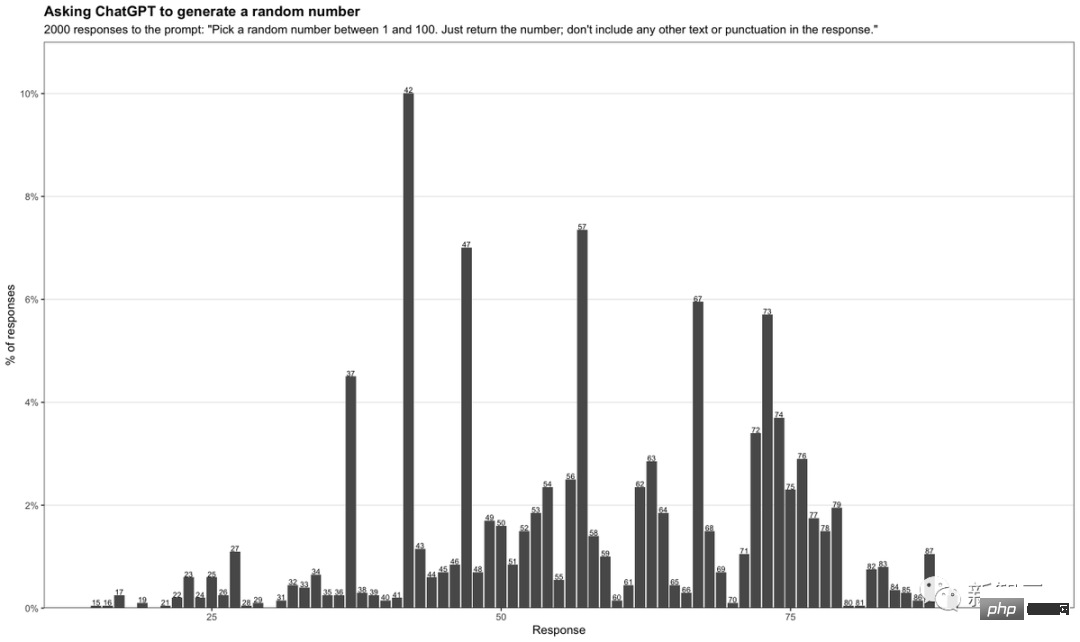

彼のテストで、フレイザーが入力したプロンプトは次のとおりです:

"1 から 100 までの乱数を選択します。数値を返すだけです。応答には他のテキストや句読点を含めないでください。"

ChatGPT に毎回 1 から 100 までの乱数を生成させることで、フレーザー氏は 2,000 の異なる回答を収集し、表にまとめました。

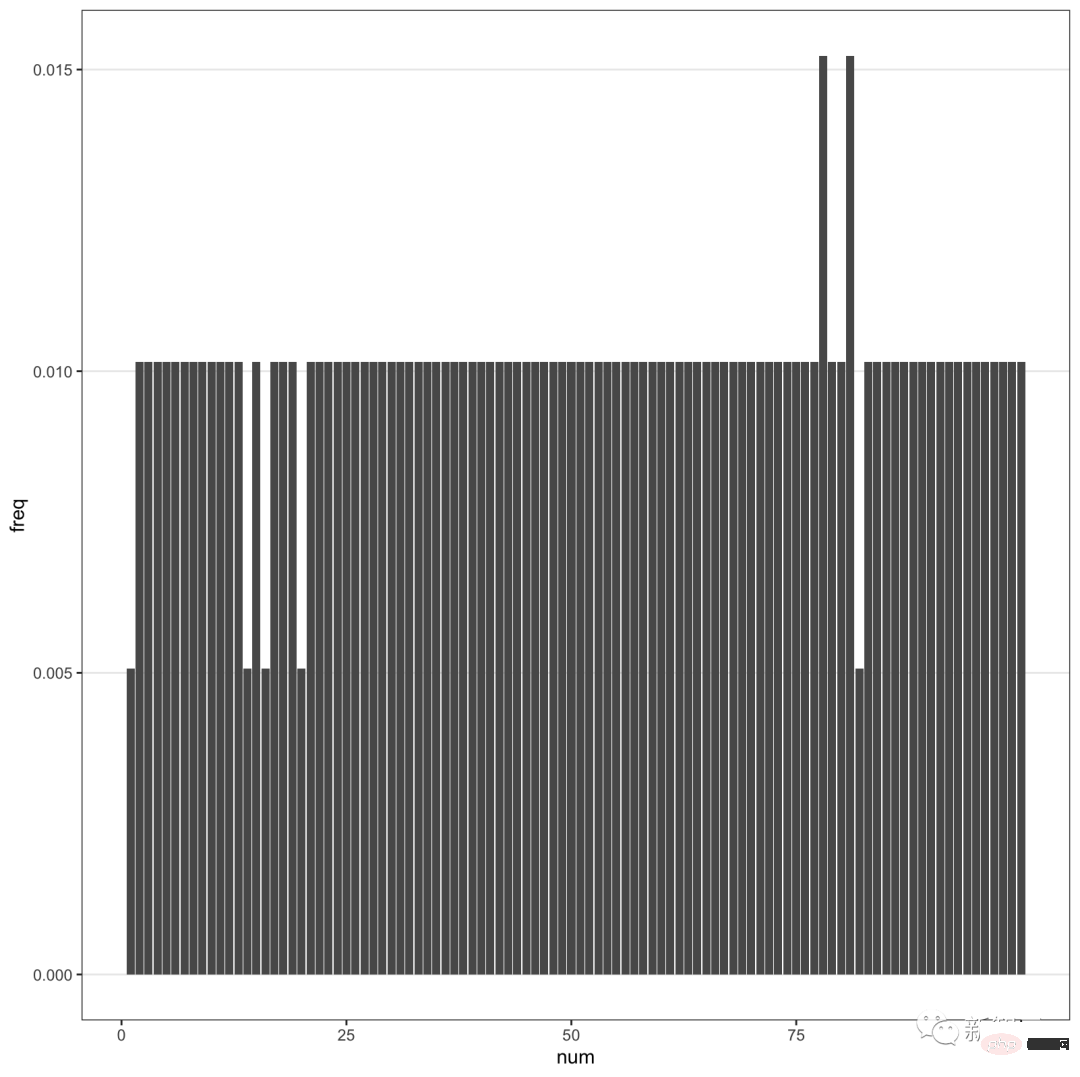

ご覧のとおり、数字 42 が最も頻繁に表示され、最大 10% となっています。また、7を含む数字は非常に頻繁に出現します。

特に 71 ~ 79 の数字がより頻繁に発生します。この範囲外の数字では、2 桁目に 7 が現れることもよくあります。

#42どういう意味ですか?

ダグラス・アダムスの大ヒットSF小説『銀河ヒッチハイク・ガイド』を読んだことのある人なら誰でも、42が「人生、宇宙、そしてすべてに対する究極の答え」であることを知っています。

簡単に言うと、42 と 69 はインターネット上のミーム番号です。これは、ChatGPT が実際には乱数生成器ではなく、オンラインで収集された膨大なデータ セットから生活の中で人気のある数字を選択しているだけであることを示しています。

さらに、7 が頻繁に表示され、まさに ChatGPT が人間の好みに応えていることを反映しています。

西洋文化では、一般的に 7 は幸運な数字とみなされており、ラッキー 7 という言葉もあります。私たちが「8」という数字に執着しているのと同じです。

興味深いことに、フレイザー氏は、GPT-4 がこれを補っているようだとも発見しました。

GPT-4 がさらに多くの数値を要求すると、返される乱数は均等に分散されすぎます。

# つまり、ChatGPT は基本的に、実際に「考えて」答えを導き出すのではなく、予測を通じて応答を返します。

ほぼ全能であるともてはやされているチャットボットが、まだ少し愚かであることがわかります。

ロードトリップの計画を立てれば、存在すらしない町に立ち寄ることになります。あるいは、乱数を出力させ、おそらく人気のあるミームに基づいて決定を下します。

一部のネチズンは自分で試してみたところ、GPT-4 は 42 と同じであることがわかりました。

ChatGPT がオンラインの常套句を繰り返すだけになってしまったら、一体何の意味があるのでしょうか?

GPT-4、機械学習ルールに違反

GPT-4の誕生は刺激的ですが、残念でもあります。

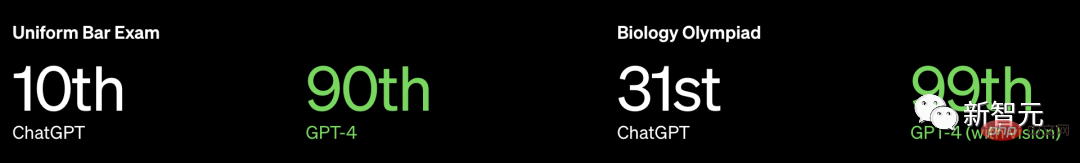

OpenAI は GPT-4 に関する詳細情報を公開しなかっただけでなく、モデルのサイズすら明らかにしませんでしたが、多くの専門的かつ標準化されたテストで人間を上回るパフォーマンスを強調しました。

米国の弁護士資格試験を例にとると、GPT3.5で10%レベル、GPT4で90%レベルに達する可能性があります。

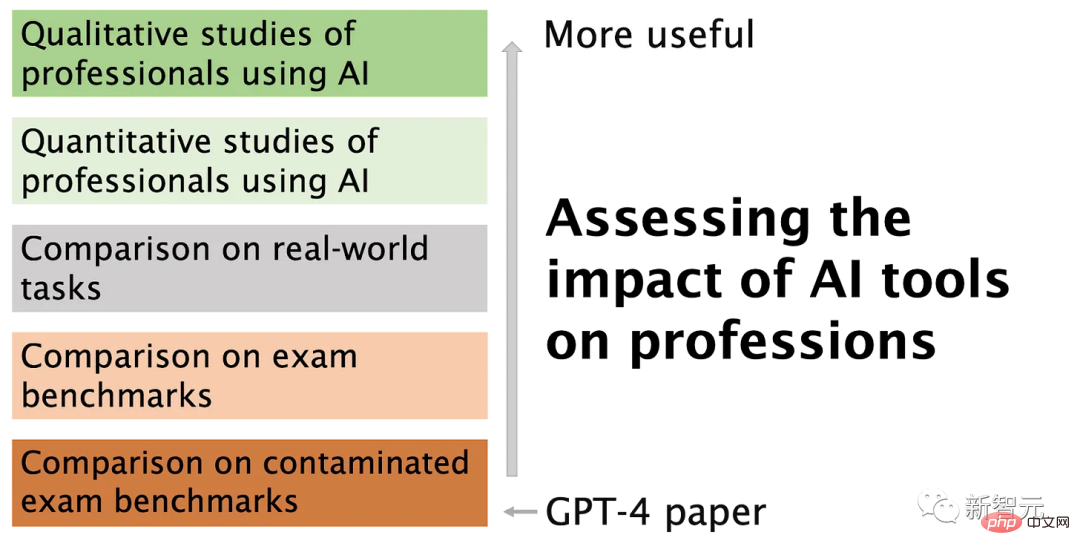

しかし、プリンストン大学コンピューターサイエンス学部教授のアルビンド・ナラヤナン氏と博士課程の学生サヤシュ・カプール氏は、

OpenAI は次のような可能性があると書いています。トレーニングデータでテストされています。さらに、チャットボットにとって人間のベンチマークは無意味です。

具体的には、OpenAI は、トレーニング データをテストしないという機械学習の鉄則に違反している可能性があります。テスト データとトレーニング データを分離する必要があることを知っておく必要があります。分離しないと、過剰適合の問題が発生します。

この問題はさておき、さらに大きな問題があります。

言語モデルは人間とは異なる方法で問題を解決するため、これらの結果は、専門家が直面する現実の問題に直面したときにロボットがどの程度うまく機能するかについてはほとんど意味がありません。弁護士の仕事は、司法試験の問題に一日中答えることではありません。

問題 1: トレーニング データの汚染

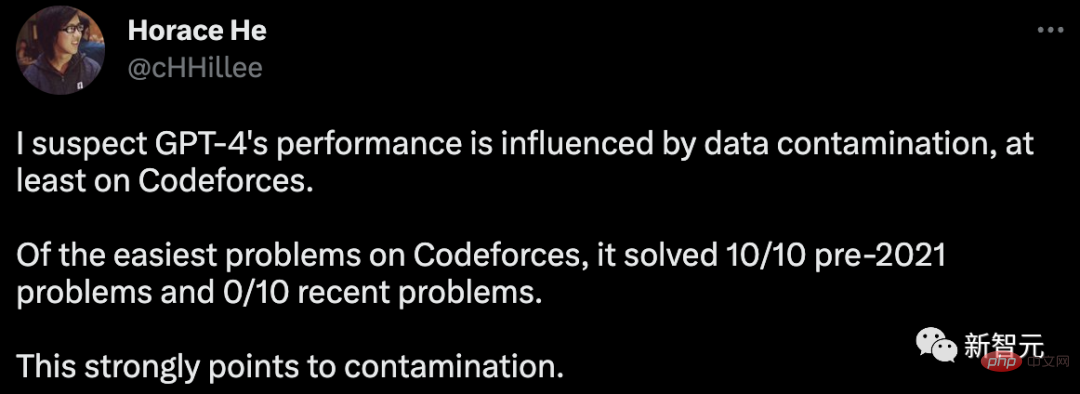

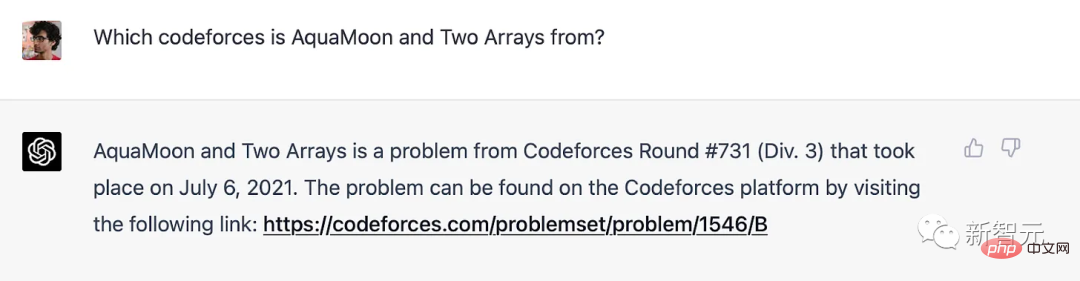

GPT-4 のプログラミング機能を評価するために、OpenAI はロシアのプログラミング コンテストの Web サイトである Codeforces で評価を実施しました。

驚いたことに、Horace He は、単純な分類では、GPT-4 は 2021 年までに 10 個の問題を解決したが、最近の 10 個の問題はどれも解決されていないとオンラインで指摘しました。

問題 2: 専門試験は人間とロボットの能力を比較する有効な方法ではありません

言語モデルで正確な能力が確認されていない場合でも、記憶はスペクトルのようなものです。トレーニング セット内の 1 つ 問題は、トレーニング コーパスが膨大であるため、必然的に非常によく似た例が多数見られることです。 これは、より深い推論を回避できることを意味します。したがって、ベンチマーク結果は、言語モデルが人間の受験者に必要な深い推論スキルを獲得しているという証拠を提供しません。

以上が「数学初心者」ChatGPT は人間の好みをよく理解しています。オンラインでの乱数の生成は宇宙に対する究極の答えですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7685

7685

15

15

1639

1639

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェント カスタマー サービス チャットボットの作成 はじめに: 今日の情報化時代において、インテリジェント カスタマー サービス システムは企業と顧客の間の重要なコミュニケーション ツールとなっています。より良い顧客サービス体験を提供するために、多くの企業が顧客相談や質問応答などのタスクを完了するためにチャットボットに注目し始めています。この記事では、OpenAI の強力なモデル ChatGPT と Python 言語を使用して、インテリジェントな顧客サービス チャットボットを作成し、顧客サービスを向上させる方法を紹介します。

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

この記事では、ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法を紹介し、いくつかの具体的なコード例を示します。 ChatGPT は、OpenAI によって開発された生成事前トレーニング トランスフォーマーの最新バージョンです。これは、自然言語を理解し、人間のようなテキストを生成できるニューラル ネットワーク ベースの人工知能テクノロジーです。 ChatGPT を使用すると、適応型チャットを簡単に作成できます

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法 はじめに: 人工知能技術の発展に伴い、顧客サービスの分野でロボットの使用が増えています。 ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築すると、企業はより効率的でパーソナライズされた顧客サービスを提供できるようになります。この記事では、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法を紹介し、具体的なコード例を示します。 1. ChatGPTPHP をインストールし、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築します。

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

chatgpt は中国でも使用できますが、香港やマカオでも登録できません。ユーザーが登録したい場合は、外国の携帯電話番号を使用して登録できます。登録プロセス中にネットワーク環境を切り替える必要があることに注意してください。外国のIP。

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築

Oct 28, 2023 am 08:37 AM

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築

Oct 28, 2023 am 08:37 AM

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築 はじめに: 人工知能技術の急速な発展に伴い、チャットボットはさまざまな分野でますます重要な役割を果たしています。チャットボットは、ユーザーが即時にパーソナライズされた支援を提供できると同時に、企業に効率的な顧客サービスを提供するのに役立ちます。この記事では、OpenAI の ChatGPT モデルと Python 言語を使用してリアルタイム チャット ロボットを作成する方法と、具体的なコード例を紹介します。 1.チャットGPT