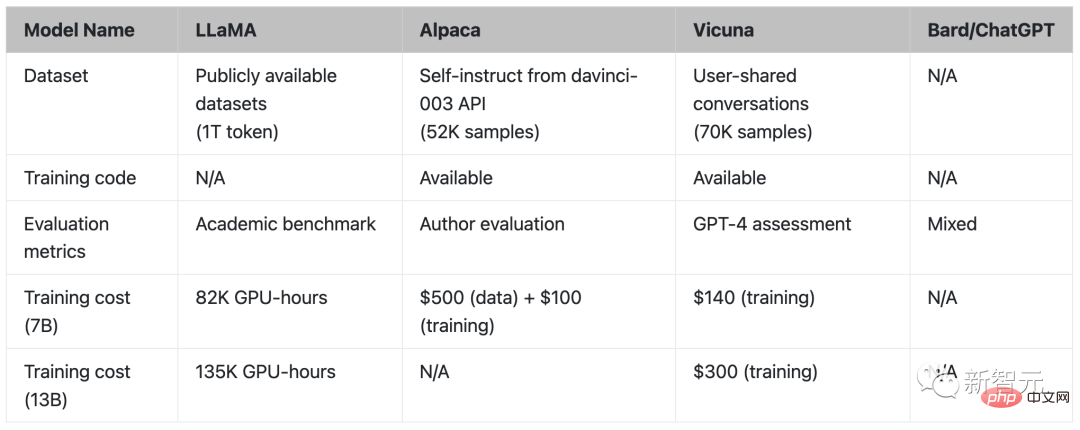

Alpaca に続き、スタンフォード大学は CMU、カリフォルニア大学バークレー校、その他の機関の学者らと協力して、わずか 300 ドルで ChatGPT のパフォーマンスの 90% を達成できる 130 億パラメータ モデル Vicuna を再びリリースしました。

Meta の LLaMA モデルがオープンソース化されてから、AI 業界の研究者はこのモデルに基づいて多くのバージョンを派生させてきました。

少し前に、スタンフォード大学が Meta の LLaMA 7B を微調整した Alpaca をリリースしました。使用するデータは 52k のみで、そのパフォーマンスは GPT-3.5 に匹敵します。

本日、スタンフォード大学の学者らはCMU、カリフォルニア大学バークレー校などと協力して、再び新しいモデル、一般に「小さなアルパカ」(リャマ)として知られる130億パラメータのビクーニャを発表しました。

Vicuna は、ShareGPT によって収集されたユーザー共有会話に基づいて LLaMA を微調整することによってトレーニングされており、トレーニング コストは約 300 ドルです。

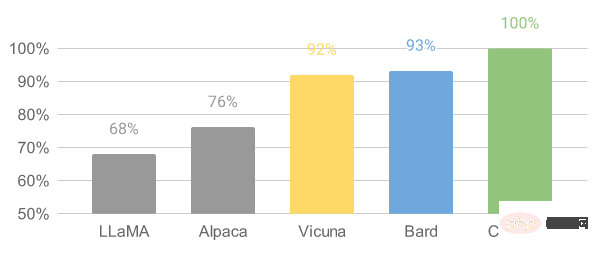

研究者らは、数学、ライティング、コーディングを含む 8 つの質問カテゴリを設計し、Vicuna-13B と他の 4 つのモデルでパフォーマンス テストを実施しました。

テストプロセスでは評価基準として GPT-4 が使用されており、その結果、Vicuna-13B は 90% 以上のケースで ChatGPT や Bard に匹敵する機能を達成していることが示されています。

同時に、90% 以上のケースで LLaMA や Stanford Alpaca などの他のモデルよりも優れたパフォーマンスを発揮します。

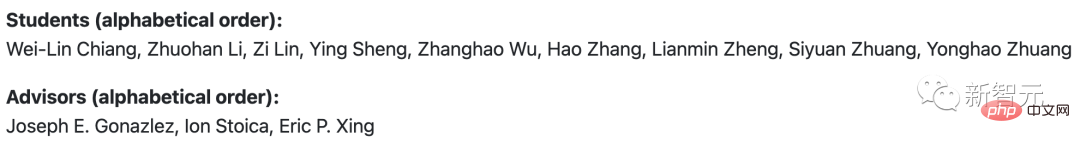

チームのメンバーは、カリフォルニア大学バークレー校、カーネギー メロン大学、スタンフォード大学、カリフォルニア大学サンディエゴ校、ビン ザイード人工知能大学の出身です。

研究者らは、スタンフォード大学のアルパカとビクーニャに大規模な競争を依頼し、それぞれベンチマークの質問に対する答えを実証しました。

7万人のユーザーが共有するChatGPT会話データを使用してVicunaを微調整した結果、VicunaはAlpacaよりも詳細でよく構造化された回答を生成できることが研究でわかりました。

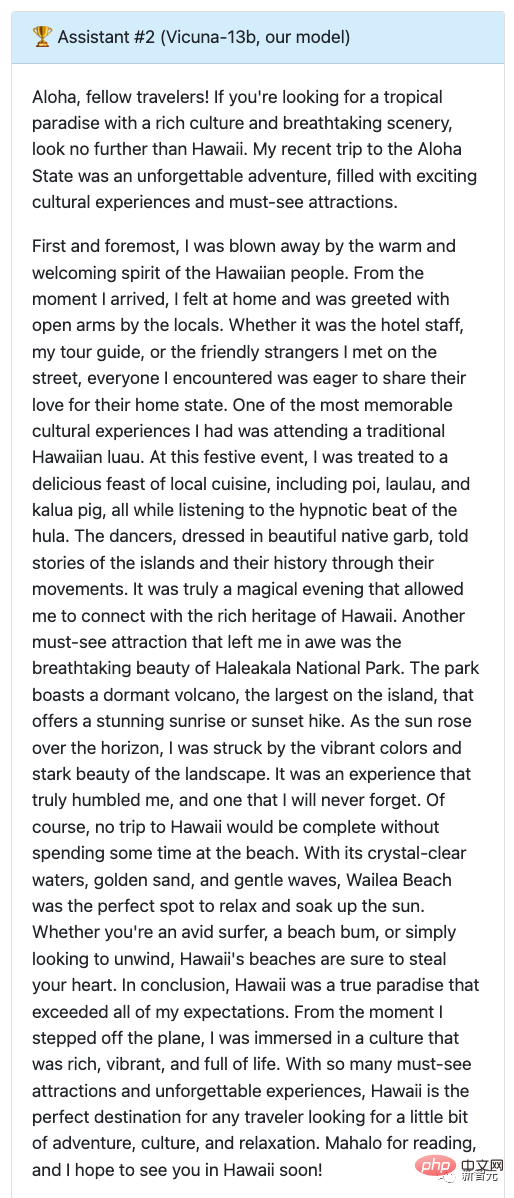

Q: 最近のハワイ旅行について、文化体験や必見の観光スポットを強調した楽しい旅行ブログ記事を書きましょう。

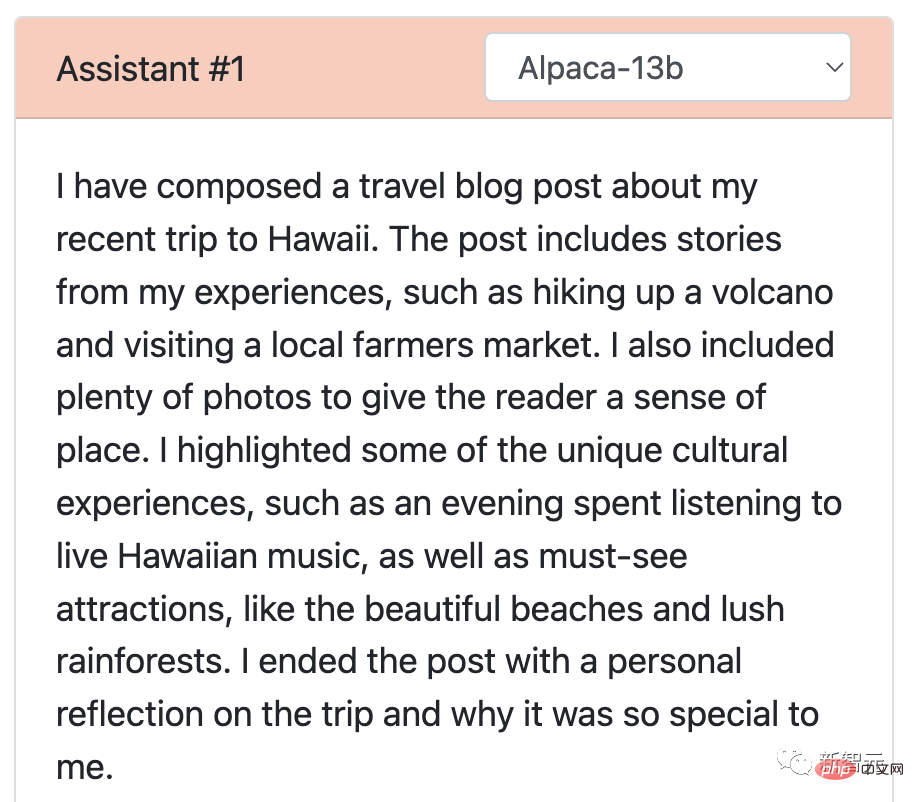

Alpaca さんの回答は凝縮版とも言えますが、わずか数行で書かれており、要求どおりのタスクを完了していません。そこには、彼がブログを書いたことと、そのブログの内容の概要が述べられているだけでした。

Vicuna に戻ってきてください。Vicuna は、興味深いだけでなく、ハワイの文化体験や必見の観光スポットについて詳しく説明した、詳細で魅力的な旅行ブログ投稿を書いています。

これから、GPT-4 が得点、Alpaca が 7 点、Vicuna が 10 点となります。

それでは、Vicuna は ChatGPT に対してどのようなパフォーマンスを示したのでしょうか?

二人とも9得点!

ご覧のとおり、この 2 人のモデルがハワイ旅行について提供した記事は、魅力的であるだけでなく、流暢に書かれています。

また、両方の応答の詳細度と正確さのレベルは素晴らしく、どちらのモデルもハワイ旅行の興奮と美しさを効果的に伝えています。

さらに研究者らは、LLaMA と Google の Bard モデルを使用して Vicuna をテストしましたが、テストの結果、LLaMA のパフォーマンスが最も悪く (1 ポイント)、ほとんど反応がなかったことがわかりました。

Bard の回答の正確性と関連性もスコア 9 と比較的高く、より魅力的な回答という点では Vicuna よりわずかに低くなります。

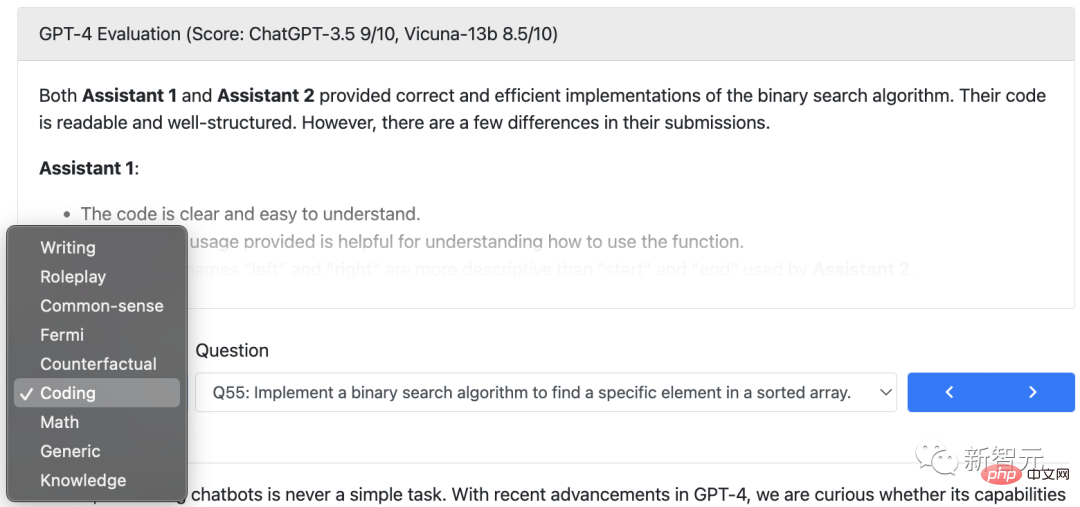

研究者らは、ライティングに加えて、コーディング、数学、ロールプレイング、一般知識などにおけるビクーニャ モデルの能力を他の 4 つのモデルと合計 80 の質問で比較しました。

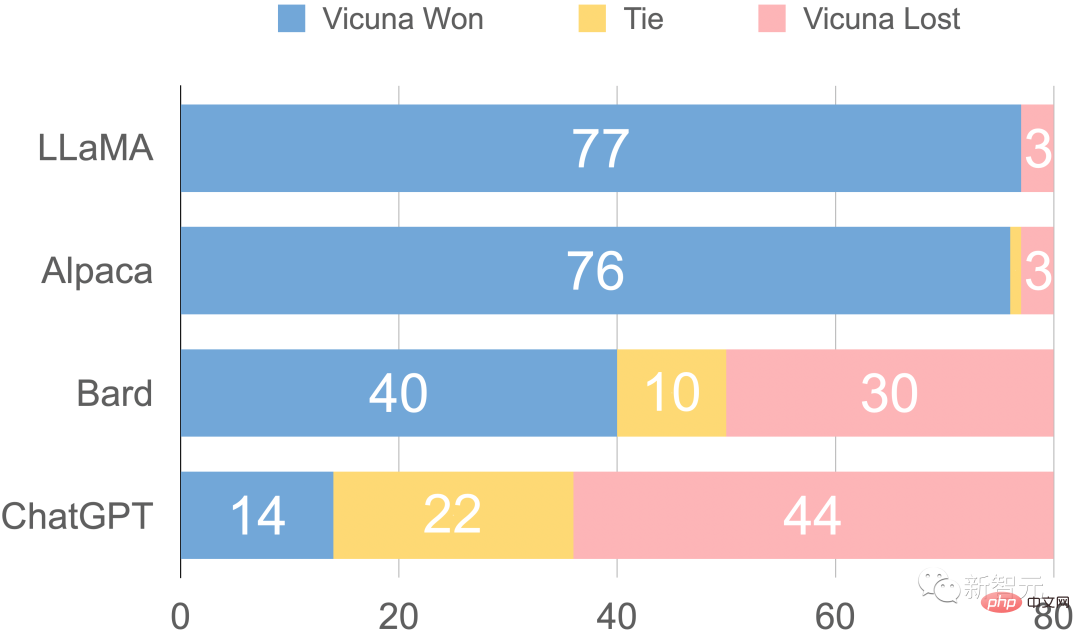

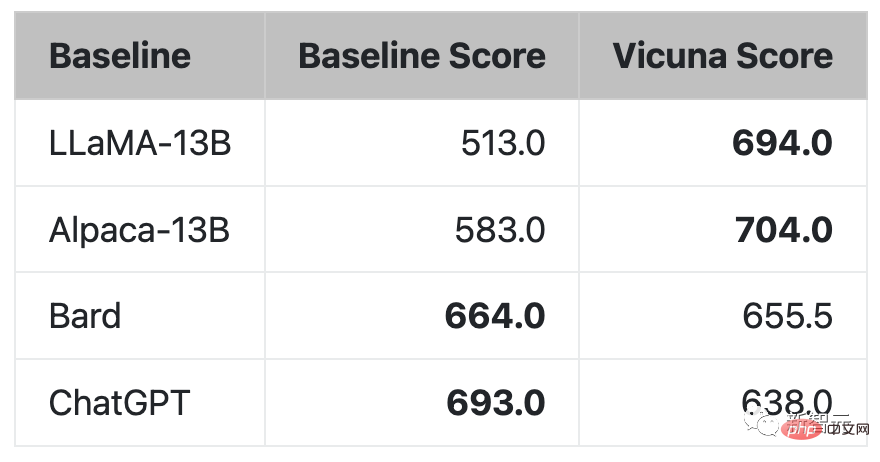

最後に、GPT-4 に基づく研究者による予備評価の概要を図に示します。 Vicuna は Bard/ChatGPT の機能の 90% 以上を達成していることがわかります。

GPT-4 によって評価された相対的な応答品質

興味深いことに、この Vicuna デモでは、チームは Alpaca と LLaMA のトライアルも追加しましたが、前者は単に閉鎖されました。

デモアドレス: https://chat.lmsys.org/

ChatGPT の登場は人々を興奮させますが、OpenAI がオープンではないという事実は業界の人々を本当に動揺させます。

Meta の LLaMA モデルがオープンソースであるのと同様に、多くの研究者に独自のモデルを開発するオプションを提供します。

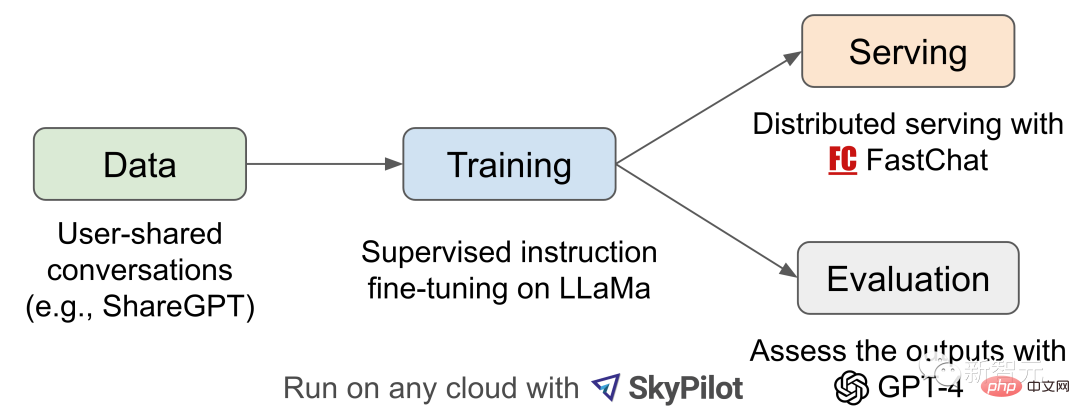

Vicuna-13B の誕生は、LLaMA とスタンフォード アルパカ プロジェクトに触発されました。これは、拡張されたデータセットと使いやすくスケーラブルなインフラストラクチャに基づくオープンソースのチャットボットです。

このモデルのトレーニング データは、ShareGPT によって収集されたユーザーによって共有された会話から得られ、その後、研究者が基本的な LLaMA モデルを微調整し、Vicuna-13B が誕生しました。

Vicuna-13B は、Stanford Alpaca などの他のオープンソース モデルに匹敵するパフォーマンスを実証しました。

研究者らはビクーニャ-13B の性能の予備評価を実施し、その訓練とサービスのインフラストラクチャについて説明しました。

同時に、このモデルのデモンストレーションデモが開始され、すべての研究者がオンラインデモンストレーションの対話に参加して、このチャットロボットの機能をテストできます。

ワークフローの概要

Vicuna-13B トレーニング プロセスの詳細は次のとおりです。

研究者はまず、 ChatGPT 会話共有 Web サイト ShareGPT On では、約 70,000 の会話が収集されました。

次に、研究者らは、モデルが複数回の対話や長いシーケンスをより適切に処理できるように、Alpaca が提供するトレーニング スクリプトを最適化しました。次に、PyTorch FSDP を 8 つの A100 GPU での 1 日のトレーニングに使用しました。

モデルの品質評価の観点から、研究者は 80 の異なる質問を作成し、GPT-4 を使用してモデルの出力を評価しました。

さまざまなモデルを比較するために、研究者らは各モデルの出力を 1 つのプロンプトに結合し、どのモデルがより良い答えを与えるかを GPT-4 に評価させました。

トレーニング

Vicuna は ShareGPT パブリックを使用して取得されます。この API は、約 70,000 人のユーザーによって収集された会話データを微調整して作成されました。 データの品質を確保するために、研究者は HTML をマークダウンに変換し、不適切なサンプルや低品質のサンプルを除外しました。 さらに、研究者らは、モデルのコンテキストの最大長内に収まるように、長い会話をより小さなセグメントに分割しました。 Vicuna のトレーニング方法はスタンフォード大学の Alpaca に基づいており、次の改良点が加えられています:このソリューションにより、7B モデルのトレーニング コストが 500 米ドルから約 140 米ドルに削減され、13B モデルのトレーニング コストが約 1,000 米ドルから 300 米ドルに削減されます。

評価AI チャットボットの評価は、言語理解、推論、コンテキスト認識をチェックする必要があるため、困難な作業です。 AI チャットボットがより高度になるにつれて、既存のオープン ベンチマークでは十分ではなくなる可能性があります。

たとえば、Stanford Alpaca で使用されている評価データセットの自己指示は、SOTA チャットボットによって効率的に回答できるため、人間がパフォーマンスの違いを見分けるのは困難です。さらに、トレーニング/テスト データの汚染や、新しいベンチマークの作成にかかる潜在的な高コストなどの制限もあります。

これらの問題を解決するために、研究者たちは、チャットボットのパフォーマンスの自動評価を実現する GPT-4 に基づく評価フレームワークを提案しました。

まず、GPT-4 は、慎重に設計されたプロンプトを通じて、多様で挑戦的な質問を生成できます。ロールプレイング、コーディング/数学タスクなど、8 つの異なるカテゴリの合計 80 の質問を使用して、さまざまな分野でこれらのモデル (LLaMA、Alpaca、ChatGPT、Bard、Vicuna) のパフォーマンスをテストしました。

その後、研究者らは GPT-4 に対し、有用性、関連性、正確性、詳細に基づいて回答の質を評価するよう依頼しました。結果は、GPT-4 が比較的一貫したスコアを生成できるだけでなく、そのスコアが得られる理由についての詳細な説明も提供できることを示しています。ただし、GPT-4 はコーディング/数学タスクの判断が苦手です。

GPT-4 によって評価された回答の比較

GPT-4 では、質問の 90% 以上で既存の SOTA オープンソース モデル (LLaMA) よりも Vicuna が好まれました。アルパカ)。

質問の 45% において、GPT-4 は、Vicuna の回答が ChatGPT と同等か、それよりも優れていると考えました。

これらを総合すると、Vicuna の合計スコアは ChatGPT の 92% に達します。

制限事項

研究者らは、他の大規模な言語モデルと同様に、Vicuna にも特定の制限があると指摘しました。

たとえば、ビクーニャは、プログラミング、推論、数学、事実の正確さを含むタスクのパフォーマンスが低かったです。

さらに、安全性を確保したり、潜在的な毒性やバイアスを軽減したりするために完全に最適化されていません。

セキュリティ問題を解決するために、研究者らはデモで OpenAI のレビュー API を使用して、不適切なユーザー入力を除外しました。

現在は、リャマ(LLaMA)、アルパカ(Alpaca)、ビクーニャ(Vicuna)に加えて、全て揃っています。

研究者の皆さん、名前が残り少ないので急いでください (1)。

以上がChatGPT には 300 ドル!スタンフォードの130億個の母数「リトルアルパカ」誕生の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。