プロンプト最適化問題の再検討、予測バイアスにより言語モデルのコンテキスト学習が強化される

LLM はインコンテキスト学習で優れたパフォーマンスを達成しましたが、別の例を選択すると、まったく異なるパフォーマンスが得られます。最近の研究成果では、予測バイアスの観点から迅速な検索戦略を提案し、例の最適な組み合わせを近似的に見つけます。

- 論文リンク: https://arxiv.org/abs/2303.13217

- コードリンク: https://github.com/MaHuanAAA /g_fair_searching

研究紹介

大規模な言語モデルは、コンテキスト学習において驚くべき機能を示しています。これらのモデルは、微調整を必要とせずに、いくつかの入出力例から構築されたコンテキストから学習できます。最適化は、多くの下流タスクに直接適用されます。ただし、これまでの研究では、トレーニング例、例の順序、プロンプト形式の変更により、コンテキスト学習が高度な不安定性を示す可能性があることが示されています。したがって、状況に応じた学習のパフォーマンスを向上させるには、適切なプロンプトを構築することが重要です。

従来の研究では、通常、この問題を 2 つの方向から研究しています: (1) 符号化空間でのプロンプト チューニング (プロンプト チューニング)、(2) 元の空間での検索 (プロンプト検索)。

プロンプト調整の重要なアイデアは、タスク固有の埋め込みを隠れ層に挿入し、勾配ベースの最適化を使用してこれらの埋め込みを調整することです。ただし、これらの方法では、モデルの元の推論プロセスを変更し、モデルの勾配を取得する必要がありますが、GPT-3 や ChatGPT のようなブラックボックス LLM サービスでは現実的ではありません。さらに、ヒント チューニングにより追加の計算コストとストレージ コストが発生し、LLM にとっては一般的に高価になります。

より実現可能で効率的なアプローチは、元のテキスト空間でおおよそのデモンストレーション サンプルとシーケンスを検索してプロンプトを最適化することです。一部の作業では、「グローバル ビュー」または「ローカル ビュー」からプロンプトが作成されます。グローバル ビュー ベースの方法では、通常、プロンプトのさまざまな要素が全体として最適化され、パフォーマンスが向上します。たとえば、多様性に基づくアプローチ [1] では、検索用のデモンストレーションの全体的な多様性を利用したり、サンプルの組み合わせ順序 [2] 全体を最適化してパフォーマンスを向上させたりします。グローバル ビューとは対照的に、ローカル ビューベースの方法は、KATE [3] などのさまざまなヒューリスティック選択基準を設計することによって機能します。

しかし、これらの方法には独自の制限があります: (1) 現在の研究のほとんどは、例の選択や順序などの単一の要素に沿って手がかりを検索することに主に焦点を当てています。ただし、各要因がパフォーマンスに与える全体的な影響は不明です。 (2) これらの方法は通常ヒューリスティック基準に基づいており、これらの方法がどのように機能するかを説明するには統一された視点が必要です。 (3) さらに重要なのは、既存の方法ではヒントをグローバルまたはローカルに最適化するため、パフォーマンスが不十分になる可能性があります。

この記事では、NLP 分野におけるプロンプト最適化問題を「予測バイアス」の観点から再検討し、重要な現象を発見します。それは、特定のプロンプトの品質は、そのプロンプトに固有のバイアスに依存するということです。この現象に基づいて、この記事では、予測バイアスに基づいてプロンプトの品質を評価するための代替基準を提案しています。このメトリクスは、追加の開発セットを必要とせずに、単一のフォワード プロセスを通じてプロンプトを評価できます。

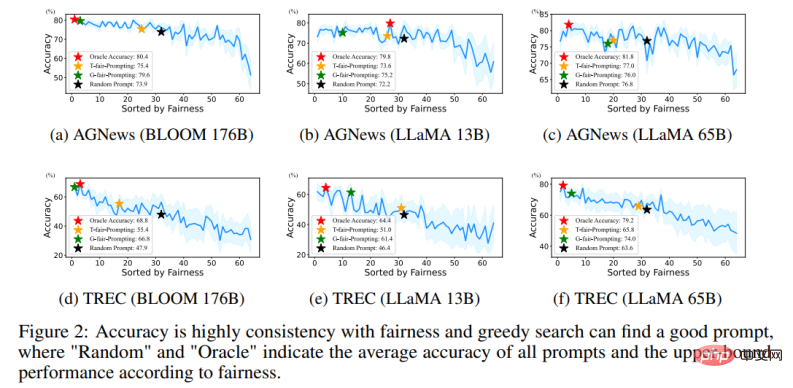

具体的には、特定のプロンプトで「コンテンツなし」テストを入力すると、モデルは均一な予測分布を出力することが期待されます (「コンテンツなし」入力には有用な情報が含まれません)。したがって、この論文では、特定のプロンプトの予測偏差を表すために、予測分布の均一性が使用されます。これは、以前のポストキャリブレーション方法 [4] で使用されるメトリクスに似ていますが、固定プロンプトの下で確率的なポストキャリブレーションにこのメトリクスを使用するポストキャリブレーションとは異なり、この論文では、近似プロンプトを自動的に検索する際のそのアプリケーションをさらに検討します。そして、広範な実験を通じて、特定のプロンプトに固有のバイアスと、特定のテストセットでの平均タスクパフォーマンスとの相関関係を確認しました。

さらに、このバイアスベースのメトリックにより、このメソッドは「ローカルからグローバルへ」の方法で適切なプロンプトを検索できます。しかし、現実的な問題として、その複雑さは O (N!) を超えるため、すべての組み合わせを走査して最適解を探索することは不可能です。

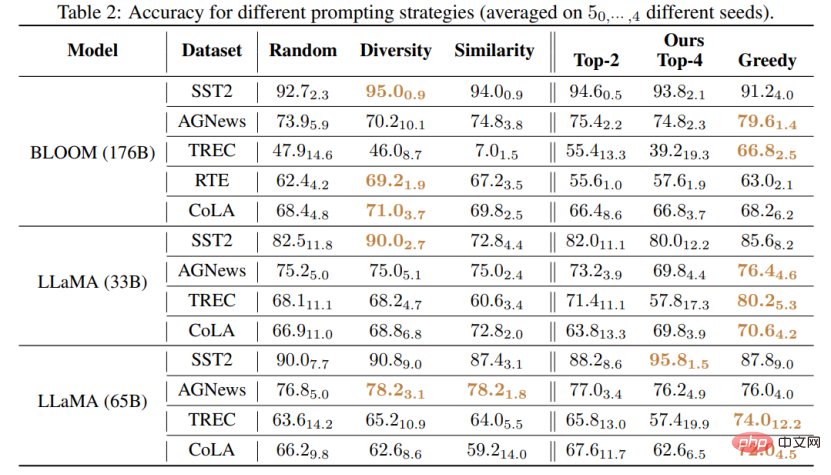

この研究では、高品質のプロンプトを効率的に検索するための 2 つの新しい戦略を提案しています: (1) T-フェア プロンプティング (2) G-フェア プロンプティング。 T-fair-Prompting は直感的なアプローチを使用し、最初に各サンプルの偏差を個別に計算してプロンプトを形成し、次に上位 k 個の最も公平なサンプルを選択して最終プロンプトに結合します。この戦略は非常に効率的で、複雑さは O (N) です。ただし、T-fair-Prompting は、最適なプロンプトは通常、最も偏りのない例から構築されるという前提に基づいていることに注意してください。ただし、これは実際の状況では当てはまらない可能性があり、多くの場合、局所的な最適解が得られます。したがって、検索品質を向上させるために、記事では G-fair-Prompting がさらに導入されています。 G-fair-Prompting は、貪欲な検索の通常のプロセスに従い、各ステップで局所的な最適な選択を行うことで最適なソリューションを見つけます。アルゴリズムの各ステップで、更新されたプロンプトが最悪の場合の時間計算量 O (N^2) で最適な公平性を達成するようにサンプルが選択され、検索品質が大幅に向上します。 G-fair-Prompting は、ローカルからグローバルへの観点から機能します。初期段階では個々のサンプルのバイアスが考慮され、後の段階ではグローバルな予測バイアスの削減に焦点が当てられます。

実験結果

この研究は、さまざまな下流タスクに適用できる、言語モデルのコンテキスト学習パフォーマンスを向上させるための効果的で解釈可能な方法を提案します。この記事では、さまざまな LLM (GPT シリーズのモデルや最近リリースされた LMaMA シリーズを含む) でのこれら 2 つの戦略の有効性を検証しています。SOTA 手法と比較して、G-fair-Prompting はさまざまなダウンストリーム タスクで 10% 以上を達成しました。 。

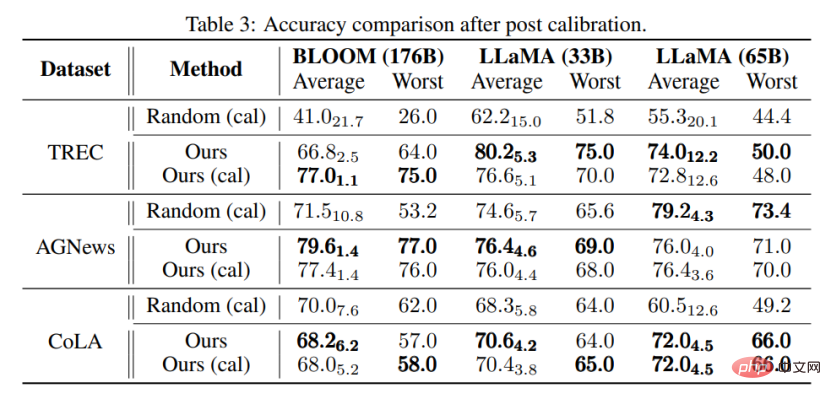

この研究に最も近いのは、使用前キャリブレーション [4] 手法です。どちらも、モデルのパフォーマンスを向上させるために「コンテンツのない」入力を使用します。ただし、使用前キャリブレーション方法は、この標準を使用して出力をキャリブレーションするように設計されており、使用されるサンプルの品質の影響を受けやすくなります。対照的に、この論文は、モデル出力の後処理を行わずに、元の空間を検索してモデルのパフォーマンスを向上させる最適に近いプロンプトを見つけることを目的としています。さらに、この論文は、使用前キャリブレーション方法ではまだ研究されていない、予測バイアスと最終的なタスクのパフォーマンスとの関連性を広範な実験を通じて初めて実証しました。

実験を通じて、キャリブレーションを行わなくても、この記事で提案した方法によって選択されたプロンプトは、キャリブレーションされたランダムに選択されたプロンプトよりも優れている可能性があることもわかります。これは、この方法が実際のアプリケーションで実用的かつ効果的であり、将来の自然言語処理研究にインスピレーションを与える可能性があることを示しています。

以上がプロンプト最適化問題の再検討、予測バイアスにより言語モデルのコンテキスト学習が強化されるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7697

7697

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

モデル、データ、フレームワークの詳細: 効率的な大規模言語モデルの 54 ページにわたる徹底的なレビュー

Jan 14, 2024 pm 07:48 PM

モデル、データ、フレームワークの詳細: 効率的な大規模言語モデルの 54 ページにわたる徹底的なレビュー

Jan 14, 2024 pm 07:48 PM

大規模言語モデル (LLM) は、自然言語理解、言語生成、複雑な推論などの多くの重要なタスクにおいて説得力のある能力を実証し、社会に大きな影響を与えてきました。ただし、これらの優れた機能には、大量のトレーニング リソース (左の図に示す) と長い推論時間 (右の図に示す) が必要です。したがって、研究者は効率の問題を解決するための効果的な技術的手段を開発する必要があります。さらに、図の右側からわかるように、Mistral-7B などのいくつかの効率的な LLM (LanguageModel) が、LLM の設計と展開にうまく使用されています。これらの効率的な LLM は、LLaMA1-33B と同様の精度を維持しながら、推論メモリを大幅に削減できます。

拡散 + 超解像度モデルの強力な組み合わせ、Google の画像生成ツール Imagen を支えるテクノロジー

Apr 10, 2023 am 10:21 AM

拡散 + 超解像度モデルの強力な組み合わせ、Google の画像生成ツール Imagen を支えるテクノロジー

Apr 10, 2023 am 10:21 AM

近年、マルチモーダル学習、特にテキストと画像の合成と画像とテキストの対比学習の 2 つの方向において、多くの注目が集まっています。 OpenAIが発表したテキスト画像モデルDALL・EやDALL-E 2、NVIDIAのGauGANやGauGAN2など、一部のAIモデルはクリエイティブな画像生成や編集への応用で広く注目を集めています。 Google も負けじと、独自のテキストから画像へのモデル Imagen を 5 月末にリリースしました。これにより、キャプション付きの条件付き画像生成の境界がさらに拡大されるようです。シーンの説明だけを与えると、Imagen は高品質、高解像度の画像を生成できます。

H100 を粉砕、Nvidia の次世代 GPU が明らかに!最初の 3nm マルチチップ モジュール設計、2024 年に発表

Sep 30, 2023 pm 12:49 PM

H100 を粉砕、Nvidia の次世代 GPU が明らかに!最初の 3nm マルチチップ モジュール設計、2024 年に発表

Sep 30, 2023 pm 12:49 PM

3nmプロセス、H100を超える性能!最近、海外メディア DigiTimes が、Nvidia が人工知能 (AI) およびハイパフォーマンス コンピューティング (HPC) アプリケーション向けの製品として、コードネーム「Blackwell」という次世代 GPU である B100 を開発しているというニュースを伝えました。 , B100はTSMCの3nmプロセスと、より複雑なマルチチップモジュール(MCM)設計を採用し、2024年の第4四半期に登場する予定だ。人工知能 GPU 市場の 80% 以上を独占している Nvidia にとって、B100 を使用して鉄は熱いうちに攻撃し、この AI 導入の波において AMD や Intel などの挑戦者をさらに攻撃することができます。 NVIDIA の推定によると、2027 年までに、この分野の生産額は約

マルチモーダル大型モデルの最も包括的なレビューがここにあります。 7 人のマイクロソフト研究者が精力的に協力、5 つの主要テーマ、119 ページの文書

Sep 25, 2023 pm 04:49 PM

マルチモーダル大型モデルの最も包括的なレビューがここにあります。 7 人のマイクロソフト研究者が精力的に協力、5 つの主要テーマ、119 ページの文書

Sep 25, 2023 pm 04:49 PM

マルチモーダル大型モデルの最も包括的なレビューがここにあります。マイクロソフトの中国人研究者7名が執筆した119ページで、すでに完成し、現在も最前線にある2種類のマルチモーダル大規模モデル研究の方向性から始まり、視覚理解と視覚生成という5つの具体的な研究テーマを包括的にまとめている。統合ビジュアル モデル LLM によってサポートされるマルチモーダル大規模モデル マルチモーダル エージェントは、マルチモーダル基本モデルが特殊なモデルから汎用的なモデルに移行したという現象に焦点を当てています。 Ps. 著者が論文の冒頭に直接ドラえもんの絵を描いたのはこのためである。このレビュー (レポート) は誰が読むべきですか? Microsoft の原文では次のようになります。プロの研究者でも学生でも、マルチモーダル基本モデルの基礎知識と最新の進歩を学ぶことに興味がある限り、このコンテンツは参加するのに非常に適しています。

SD コミュニティの I2V アダプター: 設定不要、プラグアンドプレイ、Tusheng ビデオ プラグインと完全に互換性あり

Jan 15, 2024 pm 07:48 PM

SD コミュニティの I2V アダプター: 設定不要、プラグアンドプレイ、Tusheng ビデオ プラグインと完全に互換性あり

Jan 15, 2024 pm 07:48 PM

画像からビデオへの生成 (I2V) タスクは、静止画像を動的なビデオに変換することを目的としたコンピューター ビジョンの分野における課題です。このタスクの難しさは、画像コンテンツの信頼性と視覚的な一貫性を維持しながら、単一の画像から時間次元で動的な情報を抽出して生成することです。既存の I2V 手法では、多くの場合、この目標を達成するために複雑なモデル アーキテクチャと大量のトレーニング データが必要になります。最近、Kuaishou が主導した新しい研究成果「I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels」が発表されました。この研究では、革新的な画像からビデオへの変換方法を導入し、軽量のアダプター モジュールを提案します。

VPR 2024 満点用紙! Meta は EfficientSAM を提案しています。すべてを素早く分割します。

Mar 02, 2024 am 10:10 AM

VPR 2024 満点用紙! Meta は EfficientSAM を提案しています。すべてを素早く分割します。

Mar 02, 2024 am 10:10 AM

EfficientSAM のこの作品は、5/5/5 の満点を獲得して CVPR2024 に収録されました。下の写真に示すように、著者は結果をソーシャル メディアで共有しました。ルカン チューリング賞受賞者もこの作品を強く推薦しました。最近の研究で、メタ研究者は、SAM を使用したマスク画像事前トレーニング (SAMI) という新しい改良された方法を提案しました。この方法では、MAE 事前トレーニング テクノロジーと SAM モデルを組み合わせて、高品質の事前トレーニングされた ViT エンコーダーを実現します。 SAMI を通じて、研究者はモデルのパフォーマンスと効率を向上させ、視覚タスクにより良いソリューションを提供しようとしています。この手法の提案は、コンピューター ビジョンとディープ ラーニングの分野をさらに探索し、発展させるための新しいアイデアと機会をもたらします。異なるものを組み合わせることで

2022 年ボルツマン賞が発表: ホップフィールド ネットワークの創設者が受賞

Aug 13, 2023 pm 08:49 PM

2022 年ボルツマン賞が発表: ホップフィールド ネットワークの創設者が受賞

Aug 13, 2023 pm 08:49 PM

IUPAP統計物理委員会(C3)が統計物理学の分野で優れた業績をあげた研究者を表彰するために創設した2022年度ボルツマン賞の受賞者2名が発表されました。受賞者は、これまでにボルツマン賞やノーベル賞を受賞したことのない科学者でなければなりません。この賞は 1975 年に始まり、統計物理学の創始者ルートヴィヒ ボルツマンを記念して 3 年ごとに授与されます。組織化されたクリティカルモデル、インターフェースの成長、無秩序

Google AI の新星が Pika に乗り換え: ビデオ生成の Lumiere が創設科学者を務める

Feb 26, 2024 am 09:37 AM

Google AI の新星が Pika に乗り換え: ビデオ生成の Lumiere が創設科学者を務める

Feb 26, 2024 am 09:37 AM

ビデオ生成は本格的に進歩しており、Pika は偉大な将軍、Pika の創設科学者を務める Google 研究者の Omer Bar-Tal を迎えました。 1か月前、Googleが共著者としてビデオ生成モデルLumiereをリリースしましたが、その効果は素晴らしかったです。当時、ネチズンは次のように述べました。「Google がビデオ生成の戦いに参加し、また見るべき良い番組ができた。」 StabilityAI CEOやGoogleの元同僚など、業界関係者の中には祝福の声が寄せられた。 Lumiere の最初の作品である Omer Bar-Tal は、修士号を取得して卒業したばかりで、2021 年にテルアビブ大学の数学およびコンピュータ サイエンス学部を卒業し、その後ワイツマン科学大学に進学してコンピュータの修士号を取得しました。科学、主に画像とビデオの合成分野の研究に焦点を当てています。彼の論文の結果は何度も出版されています