GPT-4 の考え方はますます人間らしくなってきています。

人間はミスをすると、二度とミスをしないように反省するものですが、GPT-4のような大きな言語モデルにも反省機能があれば、どれだけ性能が向上するでしょうか。

大規模言語モデル (LLM) がさまざまなタスクで前例のないパフォーマンスを実証していることはよく知られています。ただし、これらの SOTA メソッドは通常、定義された状態空間に対するモデルの微調整、ポリシーの最適化、その他の操作を必要とします。高品質のトレーニング データと明確に定義された状態空間が不足しているため、最適化されたモデルを実装することは依然として困難です。さらに、モデルは人間の意思決定プロセスに固有の特定の性質、特に間違いから学ぶ能力をまだ備えていません。

しかし今回、ノースイースタン大学、MIT、その他の機関の研究者が最近の論文で、エージェントに動的に記憶して内省する能力を与える反射を提案しました。

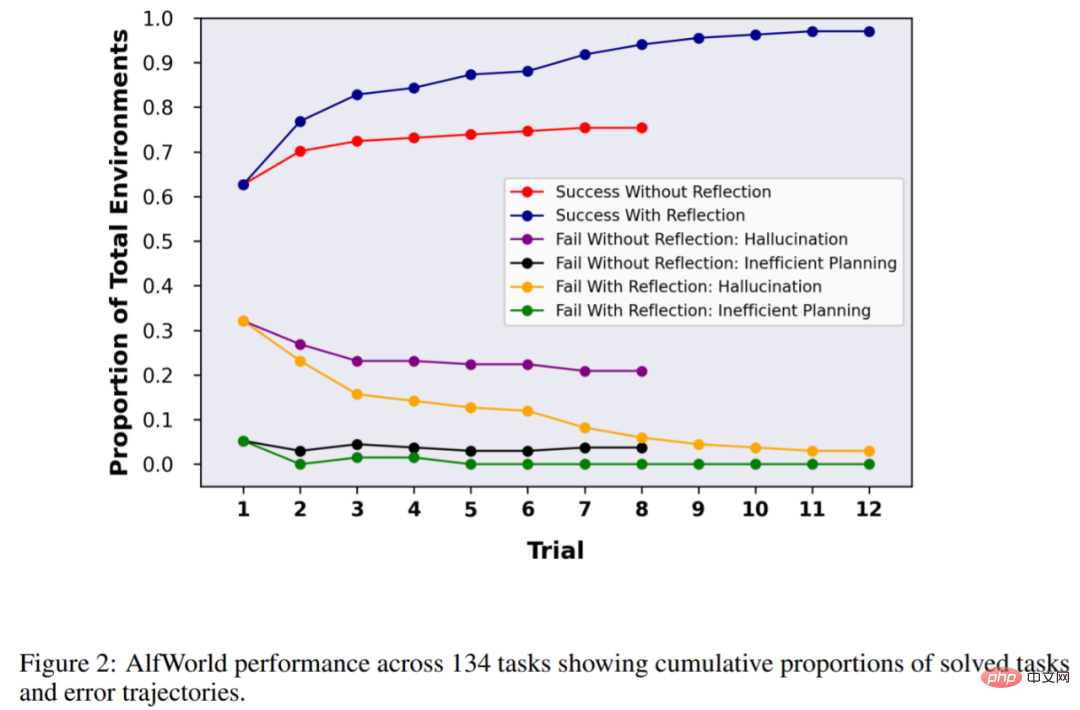

この方法の有効性を検証するために、この調査では、AlfWorld 環境で意思決定タスクを完了するエージェントの能力と、HotPotQA で知識集約型の検索ベースの質問と回答タスクを完了するエージェントの能力を評価しました。ミッション成功率はそれぞれ 97% と 51% でした。

論文アドレス: https://arxiv.org/pdf/2303.11366.pdf

プロジェクト アドレス: https://github.com/GammaTauAI/ reflection-human-eval

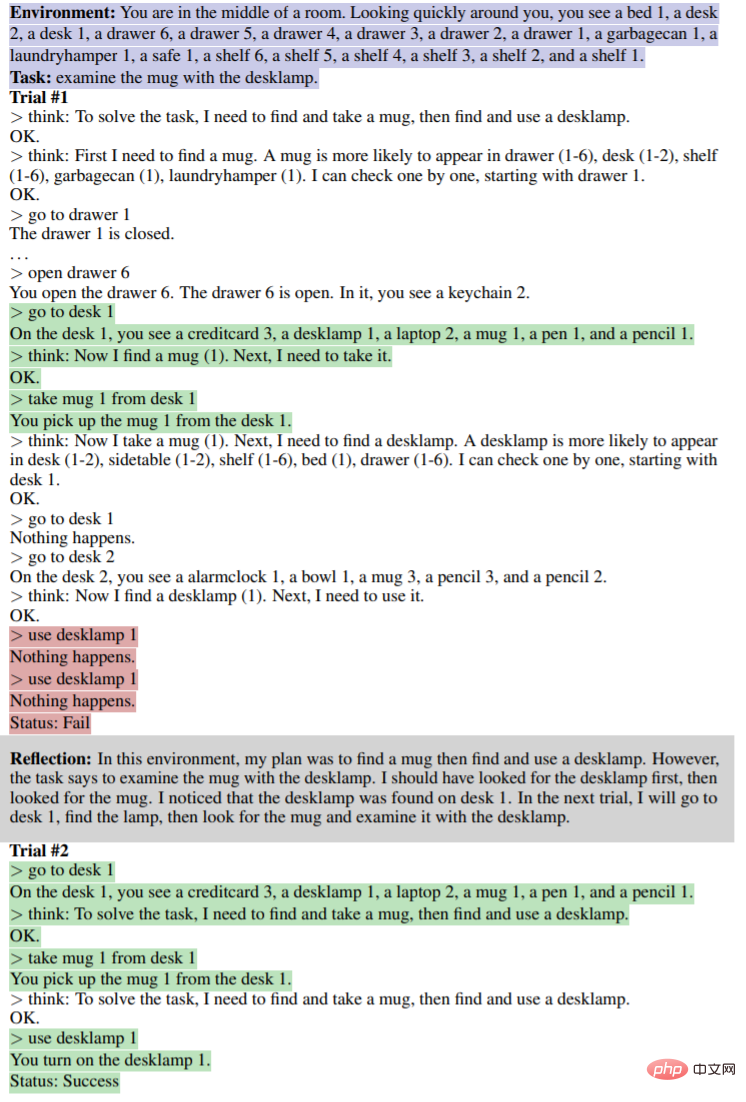

下図に示すように、AlfWorld環境では部屋にさまざまなアイテムが配置されており、エージェントは特定のオブジェクトを取得するための推論計画を立てることが求められます。以下の図の原因は、非効率的な計画によりエージェントが失敗したことです。反省後、エージェントは誤りに気づき、推論の軌道を修正し、簡潔な軌道方法を与えます(図の下段)。

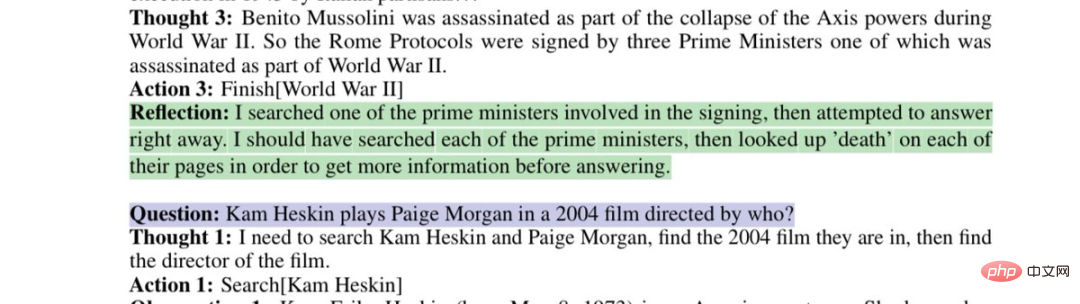

欠陥のある検索戦略を再考するモデル:

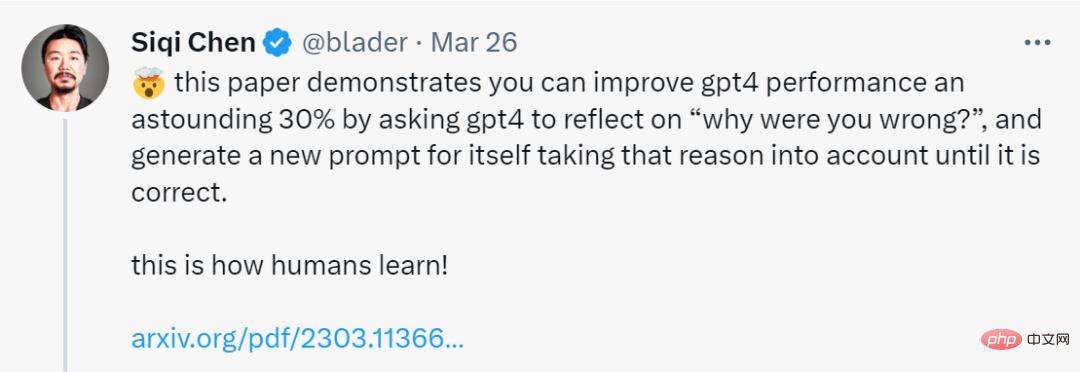

この論文では、GPT-4 Reflect を要求することでこれを実行できることを示しています。 「なぜ間違っていたのですか?」について質問し、結果が正しくなるまでエラーの理由を考慮して新しいプロンプトを自分で生成することで、GPT-4 のパフォーマンスが驚くべき 30% 向上しました。

ネチズンはため息をつかずにはいられません。人工知能の開発速度は、私たちの適応能力を超えています。

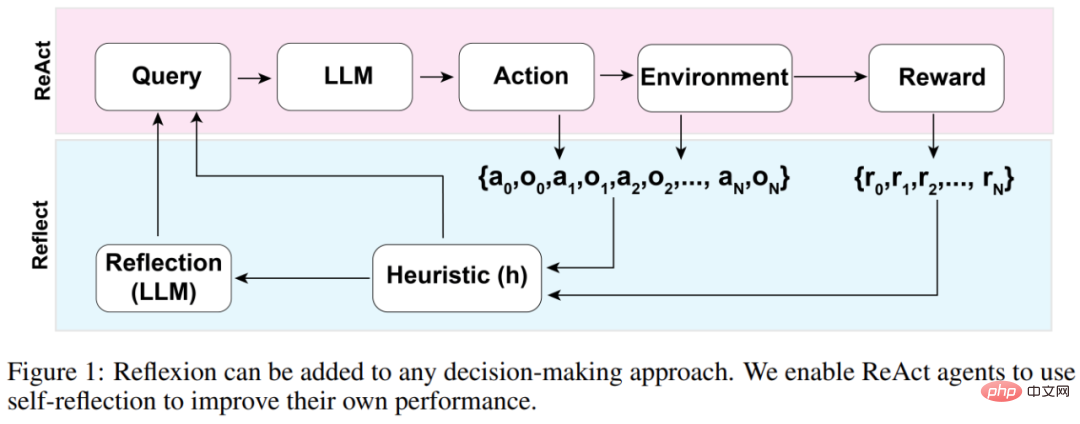

Reflexion エージェントの全体的なアーキテクチャを以下の図 1 に示します。ここで、Reflexion は ReAct を利用しています (Yao et al., 2023)。最初の試行では、エージェントには最初のクエリを構成する環境からタスクが与えられ、次にエージェントは LLM によって生成された一連のアクションを実行し、環境から観察と報酬を受け取ります。記述的または継続的な報酬を提供する環境の場合、この研究では、適用性を確保するために出力を単純なバイナリ成功状態に制限しています。

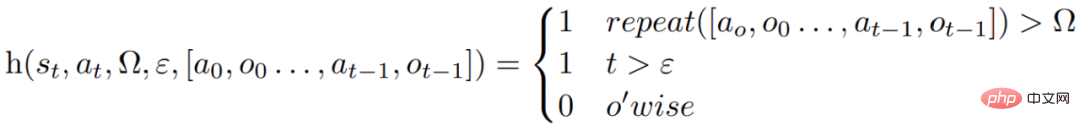

各アクション a_t の後、エージェントは次の図に示すようにヒューリスティック関数 h を計算します。

このヒューリスティック関数は、情報の錯覚 (つまり、虚偽または間違った情報) またはエージェントの非効率性を検出し、いつ反映 (反射) する必要があるかをエージェントに「伝える」ように設計されています。ここで、t は時間ステップ、s_t は現在の状態、 Ωは繰り返されるアクションのサイクル数を表し、εは実行されたアクションの最大合計数を表し、[a_o, o_0 ..., a_(t-1), o_(t-1)]は軌跡履歴を表します。 repeat は、繰り返されるアクションのループが同じ結果を生成する回数を決定する単純な関数です。

関数 h がエージェントにリフレクションが必要であることを伝えた場合、エージェントは LLM にクエリを実行して現在のタスク、軌跡履歴、および最後の報酬を反映させた後、環境をリセットして後続の試行を再試行します。関数 h がエージェントにリフレクションが必要であることを伝えない場合、エージェントは a_t と o_t をその軌跡履歴に追加し、次のアクションについて LLM に問い合わせます。

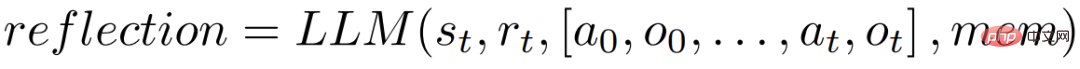

ヒューリスティック h がタイム ステップ t でのリフレクションを推奨する場合、エージェントは現在の状態 s_t、最後の報酬 r_t、以前のアクションと観察 [a_0, o_0, . . . , a_t, o_t]、およびエージェントの既存の作業ストレージ メモリを使用して、反映プロセスを開始します。

リフレクションの目的は、エージェントが試行を繰り返すことで「幻想」と非効率性を修正できるようにすることです。リフレクションに使用されるモデルは、特定の障害の軌跡と理想的なリフレクションの例を使用してプロンプトを表示する LLM です。

エージェントは上記の反映プロセスを繰り返し実行します。実験では、LLM の制限を超えるクエリを回避するために、エージェントのメモリに保存されるリフレクションの回数を最大 3 回に設定しました。実行は次の状況で終了します:

AlfWorld は 6 つの異なるタスクと 3,000 以上の環境を提供します。これらのタスクでは、エージェントがターゲット タスクを理解し、サブタスクの一連の計画を策定し、実行する必要があります。特定の環境での操作。

この研究では、隠れたオブジェクトを見つける (たとえば、引き出しの中の果物ナイフを見つける)、オブジェクトを移動する (たとえば、ナイフをまな板に移動する)、などのタスクを含む 134 の AlfWorld 環境でエージェントをテストしました。他のオブジェクトを使用して別のオブジェクトを操作する (たとえば、冷蔵庫でトマトを冷やすなど)。

反射なしの場合、エージェントの精度は 63% でした。比較のために反射を追加しました。結果は、エージェントが 12 回の試行で環境の 97% を処理でき、134 のタスクのうち 4 つだけを解決できなかったことを示しました。

次の実験は、Wikipedia に基づいたデータ セットであり、113,000 の質問と回答のペアが含まれている HotPotQA で行われました。主に、エージェントにコンテンツの解析を要求するために使用されます。 . そして推論する能力。

HotpotQA の 100 問と答えのペア テストで、この研究ではベース エージェントと Reflexion ベースのエージェントを、連続した試行で精度が向上しなくなるまで比較しました。結果は、ベーシック エージェントのパフォーマンスが向上していないことを示しています。最初の試行では、ベーシック エージェントの精度は 34%、Reflexion エージェントの精度は 32% でした。しかし、7 回の試行後、Reflexion エージェントのパフォーマンスは向上しました。改善率は 30% 近くであり、基本的なエージェントよりもはるかに優れています。

同様に、モデルのコード記述能力をテストする場合、Reflexion を使用した GPT-4 も通常の GPT-4 よりも大幅に優れています。

以上がGPT-4 がその間違いを反省したとき: パフォーマンスは 30% 近く向上し、プログラミング能力は 21% 向上しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。