ラップトップ上で実行できる ChatGPT の代替品がここにあり、完全な技術レポートが添付されています。

GPT4All は、大量のクリーンなアシスタント データ (コード、ストーリー、会話を含む) に基づいてトレーニングされたチャットボットです。データには、GPT-3.5-Turbo で生成された約 800,000 個のデータが含まれています。LLaMa に基づいて完成されており、 M1 Mac、Windows、その他の環境で使用可能。おそらくその名前が示すように、誰もが個人用 GPT を使用できる時代が来たのです。

OpenAI が ChatGPT をリリースして以来、ここ数か月でチャットボットの人気が高まっています。

ChatGPT は強力ですが、OpenAI がそれをオープンソース化することはほぼ不可能です。多くの人が、少し前に Meta によってオープンソース化された LLaMA など、オープンソースに取り組んでいます。 70億から650億の範囲のパラメータ量を持つ一連のモデルの総称であり、その中でも130億パラメータのLLaMAモデルは「ほとんどのベンチマークで」1750億パラメータのGPT-3を上回る性能を発揮します。

LLaMA のオープン ソースは多くの研究者に利益をもたらしています。たとえば、スタンフォード大学は LLaMA に命令チューニングを追加し、Alpaca (LLaMA 7B に基づく) と呼ばれる新しい 70 億パラメータ モデルをトレーニングしました。結果は、パラメータが 7B しかない軽量モデルである Alpaca のパフォーマンスが、GPT-3.5 などの非常に大規模な言語モデルに匹敵することを示しています。

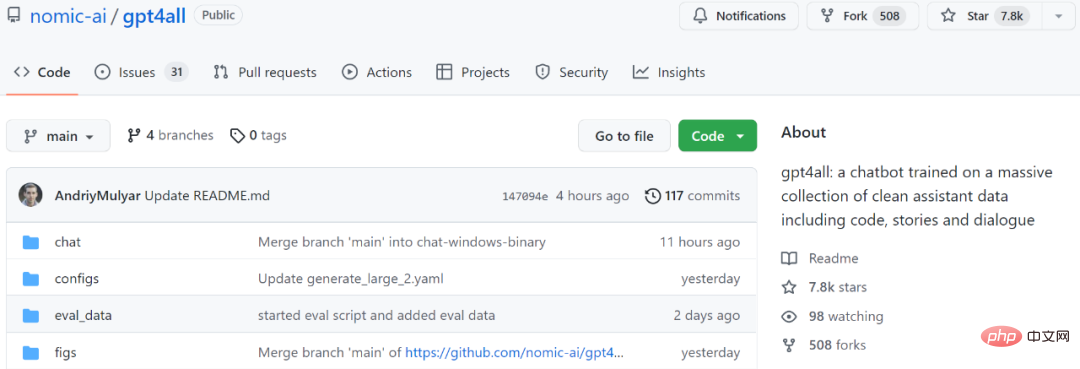

別の例として、次に紹介するモデル GPT4All も、LLaMA に基づく新しい 7B 言語モデルです。プロジェクト開始から 2 日後、スターの数は 7.8k を超えました。

プロジェクトアドレス: https://github.com/nomic-ai/gpt4all

簡単に言うと、GPT-3.5 では GPT4All は 800k です。ターボ トレーニングは、テキストの質問、ストーリーの説明、複数ラウンドの対話、コードなどのデータに対して実行されます。

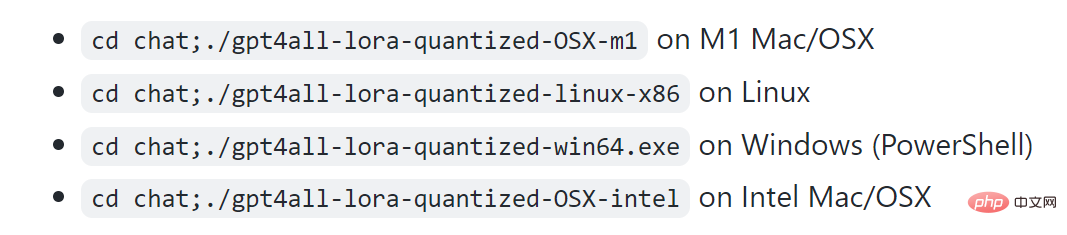

プロジェクト表示によると、M1 は Mac、Windows などの環境で実行できます。

まずは効果を見てみましょう。以下の図に示すように、ユーザーはモデルに「ラップトップで大規模な言語モデルを実行できますか?」と尋ねるなど、何の障壁もなく GPT4All と通信できます。GPT4All の答えは次のとおりです。「はい、ラップトップを使用してトレーニングや学習を行うことができます」ニューラル ネットワークや他の自然言語 (英語や中国語など) の機械学習モデルをテストします。重要なのは、これらのモデルのサイズに対応できる十分な空きメモリ (RAM) が必要であることです..."

次は、分からない場合は、必要なメモリ量を GPT4All に尋ね続けると、答えが得られます。結果から判断すると、複数ラウンドの対話を実行する GPT4All の能力は依然として非常に強力です。

#M1 Mac でのリアルタイム サンプリング

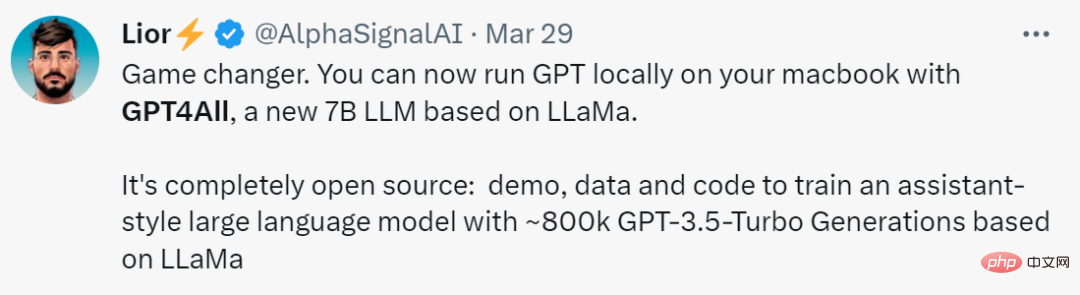

この研究を「革新的」と呼ぶ人もいます。ルール、GPT4All のおかげで、MacBook 上でローカルに GPT を実行できるようになりました。"

1. データの収集と整理

2023 年 3 月 20 日から 2023 年 3 月 26 日までの期間、研究者は、 GPT-3.5-Turbo OpenAI API を使用して、約 100 万組のプロンプト応答を収集しました。 まず、研究者らは、公開されている 3 つのデータセットを利用して、さまざまな質問/プロンプトのサンプルを収集しました。- LAION OIG の統合チップ 2 サブセット

- Stackoverflow の質問のランダムなサブサンプル セットコーディングの質問

- 命令チューニング用の Bigscience/P3 サブサンプル セット

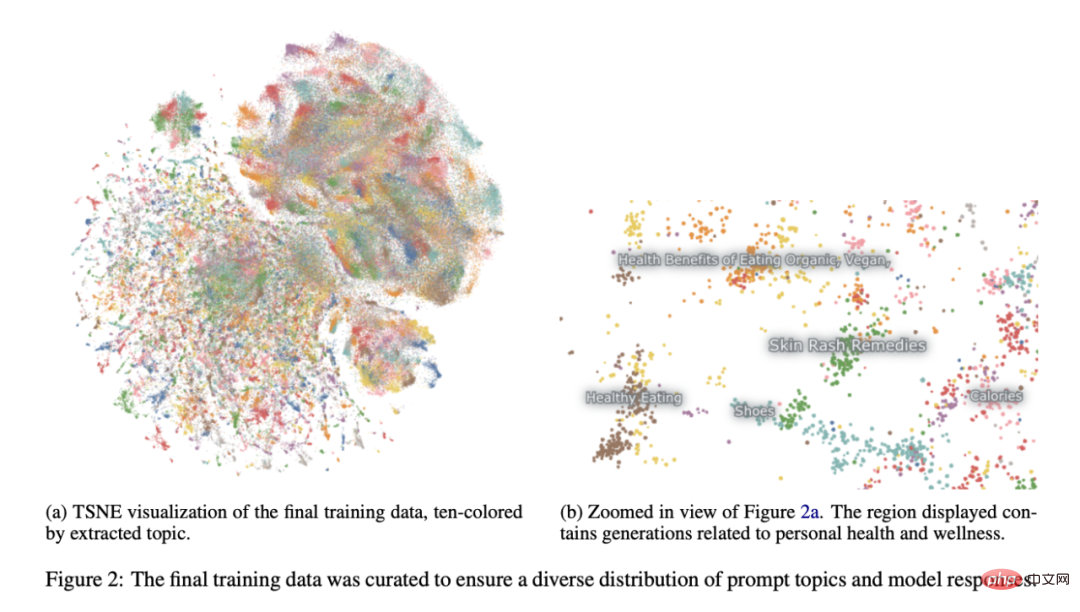

スタンフォード大学のアルパカプロジェクト (Taori et al., 2023) を参照すると、研究者たちはデータの準備と編成に多大な注意を払ってきました。プロンプトによって生成されたペアの初期データセットを収集した後、データを Atlas にロードして整理し、GPT-3.5-Turbo がプロンプトに応答できず、不正な出力を生成したサンプルをすべて削除しました。これにより、サンプルの総数が 806,199 個の高品質プロンプト生成ペアに減ります。次に、出力の多様性が非常に低かったため、最終トレーニング データセットから Bigscience/P3 サブセット全体を削除しました。 P3 には、GPT-3.5-Turbo からの短く均一な応答を生成する多くの均一なプロンプトが含まれています。

この消去法により、図 2 に示すように、最終的に 437,605 個のプロンプト生成ペアのサブセットが得られました。

モデル トレーニング

研究者らは、LLaMA 7B のインスタンスで複数のモデルを組み合わせました (Touvron et al., 2023)調整。彼らのオリジナルの公開関連モデルは、4 エポックにわたる 437,605 の後処理された例で LoRA (Hu et al., 2021) を使用してトレーニングされました。詳細なモデルのハイパーパラメーターとトレーニング コードは、関連するリソース ライブラリとモデル トレーニング ログにあります。

再現性

研究者らは、コミュニティが再現できるよう、すべてのデータ (未使用の P3 世代を含む)、トレーニング コード、モデルの重みを公開しました。興味のある研究者は、Git リポジトリで最新のデータ、トレーニングの詳細、チェックポイントを見つけることができます。

コスト

研究者らがこれらのモデルを作成するのに約 4 日かかり、GPU のコストは 800 ドルでした (いくつかの失敗したトレーニングを含め、Lambda Labs と Paperspace から借りました) 、500 ドルの OpenAI API 料金に加えて。

最終リリースモデル gpt4all-lora は、Lambda Labs の DGX A100 8x 80GB で約 8 時間、合計コスト 100 ドルでトレーニングできます。

このモデルは一般的なノートパソコンでも動作し、ネット民の意見では「電気代以外にコストはかからない」とのことです。

このモデルは一般的なノートパソコンでも動作し、ネット民の意見では「電気代以外にコストはかからない」とのことです。

以上がラップトップ上で実行できる ChatGPT の代替品がここにあり、完全な技術レポートが添付されています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7517

7517

15

15

1378

1378

52

52

79

79

11

11

21

21

66

66

2024 CSRankings 全国コンピュータ サイエンス ランキングが発表されました! CMUがリストを独占、MITはトップ5から外れる

Mar 25, 2024 pm 06:01 PM

2024 CSRankings 全国コンピュータ サイエンス ランキングが発表されました! CMUがリストを独占、MITはトップ5から外れる

Mar 25, 2024 pm 06:01 PM

2024CSRankings 全国コンピューターサイエンス専攻ランキングが発表されました。今年、米国の最高のCS大学のランキングで、カーネギーメロン大学(CMU)が国内およびCSの分野で最高の大学の一つにランクされ、イリノイ大学アーバナシャンペーン校(UIUC)は6年連続2位となった。 3位はジョージア工科大学。次いでスタンフォード大学、カリフォルニア大学サンディエゴ校、ミシガン大学、ワシントン大学が世界第4位タイとなった。 MIT のランキングが低下し、トップ 5 から外れたことは注目に値します。 CSRankings は、マサチューセッツ大学アマースト校コンピューター情報科学部のエメリー バーガー教授が始めたコンピューター サイエンス分野の世界的な大学ランキング プロジェクトです。ランキングは客観的なものに基づいています

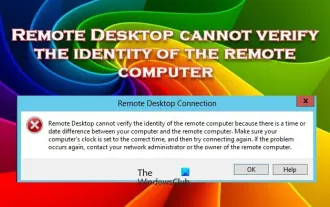

リモート デスクトップがリモート コンピュータの ID を認証できない

Feb 29, 2024 pm 12:30 PM

リモート デスクトップがリモート コンピュータの ID を認証できない

Feb 29, 2024 pm 12:30 PM

Windows リモート デスクトップ サービスを使用すると、ユーザーはコンピュータにリモート アクセスできるため、リモートで作業する必要がある人にとっては非常に便利です。ただし、ユーザーがリモート コンピュータに接続できない場合、またはリモート デスクトップがコンピュータの ID を認証できない場合、問題が発生する可能性があります。これは、ネットワーク接続の問題または証明書の検証の失敗が原因である可能性があります。この場合、ユーザーはネットワーク接続をチェックし、リモート コンピュータがオンラインであることを確認して、再接続を試行する必要がある場合があります。また、リモート コンピュータの認証オプションが正しく構成されていることを確認することが、問題を解決する鍵となります。 Windows リモート デスクトップ サービスに関するこのような問題は、通常、設定を注意深く確認して調整することで解決できます。時間または日付の違いにより、リモート デスクトップはリモート コンピューターの ID を確認できません。計算を確認してください

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

エンコーダ/デコーダ アーキテクチャを放棄し、より効果的なエッジ検出に拡散モデルを使用する 国立防衛工科大学は DiffusionEdge を提案しました

Feb 07, 2024 pm 10:12 PM

エンコーダ/デコーダ アーキテクチャを放棄し、より効果的なエッジ検出に拡散モデルを使用する 国立防衛工科大学は DiffusionEdge を提案しました

Feb 07, 2024 pm 10:12 PM

現在のディープ エッジ検出ネットワークは通常、エンコーダ/デコーダ アーキテクチャを採用しています。このアーキテクチャには、マルチレベルの特徴をより適切に抽出するためのアップ サンプリング モジュールとダウン サンプリング モジュールが含まれています。ただし、この構造では、ネットワークが正確かつ詳細なエッジ検出結果を出力することが制限されます。この問題に対して、AAAI2024 に関する論文は新しい解決策を提供しています。論文のタイトル: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection 著者: Ye Yunfan (国立国防技術大学)、Xu Kai (国立国防技術大学)、Huang Yuxing (国立国防技術大学)、Yi Renjiao (国立国防技術大学)、Cai Zhiping (防衛工科大学) 論文リンク:https://ar

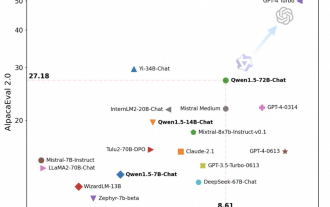

Tongyi Qianwen が再びオープンソースになり、Qwen1.5 では 6 つのボリューム モデルが提供され、そのパフォーマンスは GPT3.5 を超えます

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen が再びオープンソースになり、Qwen1.5 では 6 つのボリューム モデルが提供され、そのパフォーマンスは GPT3.5 を超えます

Feb 07, 2024 pm 10:15 PM

春節に合わせて、Tongyi Qianwen Model (Qwen) のバージョン 1.5 がオンラインになりました。今朝、新しいバージョンのニュースが AI コミュニティの注目を集めました。大型モデルの新バージョンには、0.5B、1.8B、4B、7B、14B、72Bの6つのモデルサイズが含まれています。その中でも最強バージョンの性能はGPT3.5やMistral-Mediumを上回ります。このバージョンには Base モデルと Chat モデルが含まれており、多言語サポートを提供します。アリババの同義前文チームは、関連技術が同義前文公式ウェブサイトと同義前文アプリでもリリースされたと述べた。さらに、本日の Qwen 1.5 リリースには、32K のコンテキスト長のサポート、Base+Chat モデルのチェックポイントのオープン、および 32K のコンテキスト長のサポートなどのハイライトもあります。

大規模なモデルもスライスでき、Microsoft SliceGPT により LLAMA-2 の計算効率が大幅に向上します。

Jan 31, 2024 am 11:39 AM

大規模なモデルもスライスでき、Microsoft SliceGPT により LLAMA-2 の計算効率が大幅に向上します。

Jan 31, 2024 am 11:39 AM

大規模言語モデル (LLM) には通常、数十億のパラメーターがあり、数兆のトークンでトレーニングされます。ただし、このようなモデルのトレーニングとデプロイには非常にコストがかかります。計算要件を軽減するために、さまざまなモデル圧縮技術がよく使用されます。これらのモデル圧縮技術は一般に、蒸留、テンソル分解 (低ランク因数分解を含む)、枝刈り、および量子化の 4 つのカテゴリに分類できます。プルーニング手法は以前から存在していましたが、多くはパフォーマンスを維持するためにプルーニング後にリカバリ微調整 (RFT) を必要とするため、プロセス全体のコストが高くつき、拡張が困難になります。チューリッヒ工科大学とマイクロソフトの研究者は、この問題に対する SliceGPT と呼ばれる解決策を提案しました。この方法の中心となるアイデアは、重み行列の行と列を削除することでネットワークの埋め込みを減らすことです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

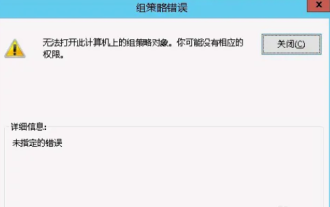

このコンピュータではグループ ポリシー オブジェクトを開けません

Feb 07, 2024 pm 02:00 PM

このコンピュータではグループ ポリシー オブジェクトを開けません

Feb 07, 2024 pm 02:00 PM

コンピュータを使用しているときに、オペレーティング システムが誤動作することがあります。今日私が遭遇した問題は、gpedit.msc にアクセスすると、正しいアクセス許可がない可能性があるためグループ ポリシー オブジェクトを開けないというメッセージがシステムから表示されることでした。このコンピュータ上のグループ ポリシー オブジェクトを開けませんでした。解決策: 1. gpedit.msc にアクセスすると、アクセス許可がないため、このコンピュータ上のグループ ポリシー オブジェクトを開けないというメッセージが表示されます。詳細: システムは指定されたパスを見つけることができません。 2. ユーザーが閉じるボタンをクリックすると、次のエラー ウィンドウがポップアップ表示されます。 3. ログ レコードをすぐに確認し、記録された情報を組み合わせて、問題が C:\Windows\System32\GroupPolicy\Machine\registry.pol ファイルにあることを確認します。