GPT-4のコーディング能力が21%向上! MITの新しい方法により、LLMは反省することを学ぶことができる、ネチズン:人間が考えるのと同じ方法だ

これは、ノースイースタン大学と MIT によって発表された最新の論文「Reflexion」の手法です。

この記事はAI New Media Qubit(公開アカウントID:QbitAI)の許可を得て転載しておりますので、転載については出典元にご連絡ください。

GPT-4が再び進化!

簡単な方法を使用すると、GPT-4 などの大規模な言語モデルは自己反省を学習でき、パフォーマンスを直接 30% 向上させることができます。

これまで、大規模な言語モデルは間違った答えを出し、何も言わずに謝った後、うーん、とランダムな推測を続けることがよくありました。

これではもうこのようなことはなくなり、新しいメソッドを追加することで、GPT-4 はどこが悪かったのかを反省するだけでなく、改善戦略も提供します。

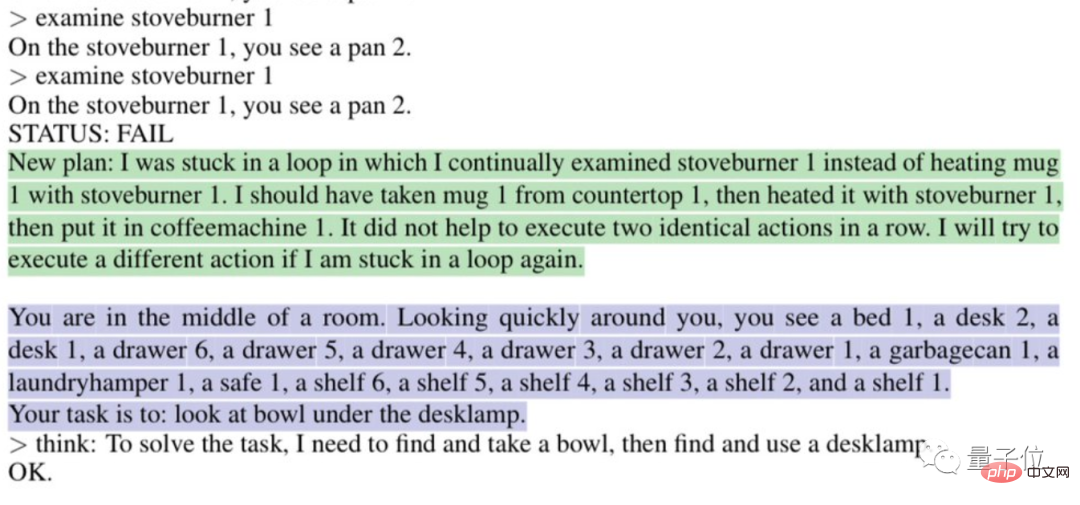

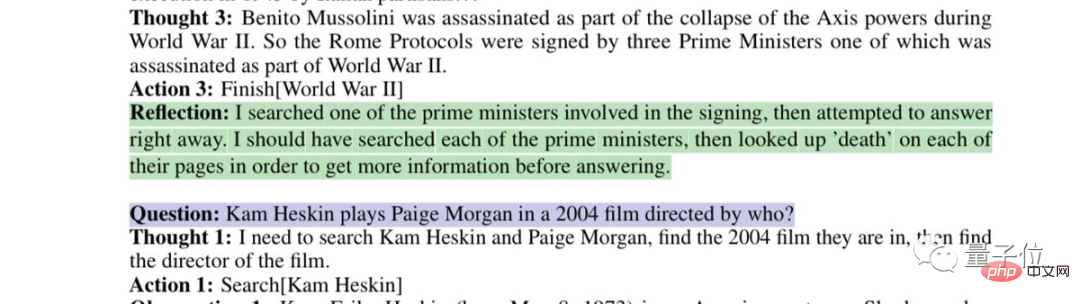

たとえば、「ループに陥っている」理由を自動的に分析します:

または、自分自身の欠陥のある検索戦略を振り返ります:

これは、ノースイースタン大学と MIT によって発表された最新の論文「Reflexion」の方法です。

GPT-4 だけでなく、他の大規模な言語モデルにも適用され、人間特有の熟考能力を学習することができます。

この論文はプレプリント プラットフォーム arxiv で公開されました。

この方法でコードを書くための時給は、通常の開発者の時給よりも安いです。

この方法でコードを書くための時給は、通常の開発者の時給よりも安いです。

ネチズンが言ったように、Reflexion によって GPT-4 に与えられた反射能力は人間の思考プロセスに似ています:

ネチズンが言ったように、Reflexion によって GPT-4 に与えられた反射能力は人間の思考プロセスに似ています:

フィードバック 。

。

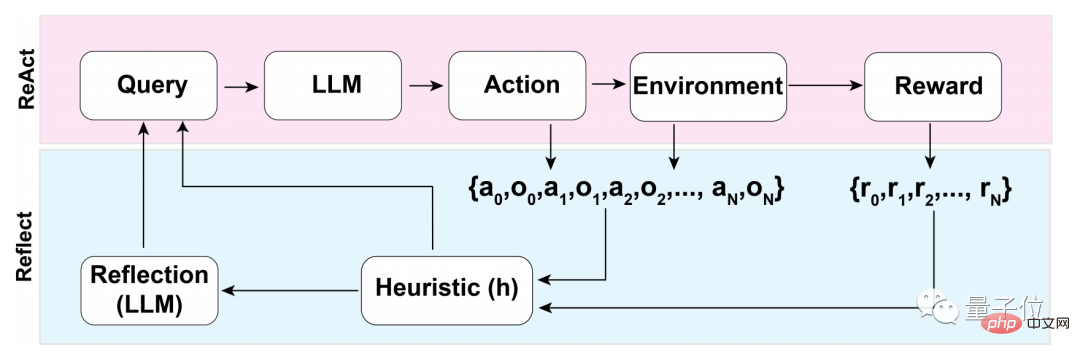

このフィードバック プロセスは、次の 3 つの主要なステップに分けることができます:

2. 内省の生成: エラーの特定 - 修正の実装

- 3. 反復フィードバック ループの実装

- 評価プロセスの最初のステップでは、まず、あなたが通過する必要があるのは、LLM (Large Language Model) の

- 自己評価 です。

つまり、LLM は、外部からのフィードバックがない場合、まず答え自体を反映する必要があります。 内省を行うにはどうすればよいでしょうか?

研究チームは、

バイナリ報酬メカニズムを使用して、現在の状態でLLMによって実行される操作に値を割り当てました:

1は生成された結果を表しますOK、0 生成された結果があまり良くないことを意味します。

複数値や連続出力などのより記述的な報酬メカニズムの代わりにbinary

が使用される理由は、外部入力の不足に関連しています。

外部フィードバックなしで内省を行うには、答えをバイナリ状態に制限する必要があります。この方法でのみ、LLM に意味のある推論を強制することができます。 自己評価が完了した後、バイナリ報酬メカニズムの出力が 1 の場合、自己反射装置は起動されません。0 の場合、LLM は反射モードをオンにします。

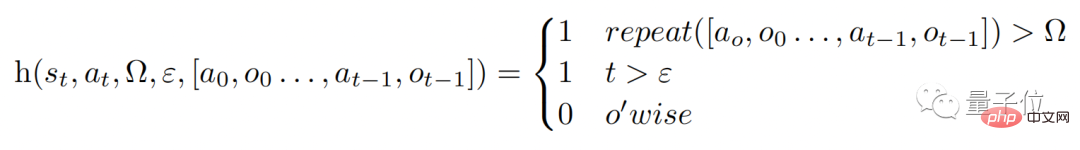

リフレクション プロセス中に、モデルはヒューリスティック関数 h (以下に示すように) をトリガーします。人間の思考プロセスと同様に、h は

監視と同じ役割を果たします。

#ただし、人間の思考と同様、LLM にも反映のプロセスに制限があり、それが関数の Ω と ε に反映される可能性があります。

Ω は、連続アクションが繰り返される回数を表します。通常、この値は 3 に設定されます。これは、反映プロセス中にステップが 3 回繰り返されると、次のステップに直接ジャンプすることを意味します。

Ω は、連続アクションが繰り返される回数を表します。通常、この値は 3 に設定されます。これは、反映プロセス中にステップが 3 回繰り返されると、次のステップに直接ジャンプすることを意味します。

そして、ε は、リフレクション プロセス中に実行できる操作の最大数を表します。

監視があるので、修正も実装する必要があります。修正プロセスの機能は次のとおりです。 , 自己反映モデルは「ドメイン固有の

障害軌跡 と理想的な反映ペア」を使用してトレーニングされており、データセット内の特定の問題に対するドメイン固有の解決策へのアクセスは許可されません。

リフレクション後はパフォーマンスが 30% 近く向上しました

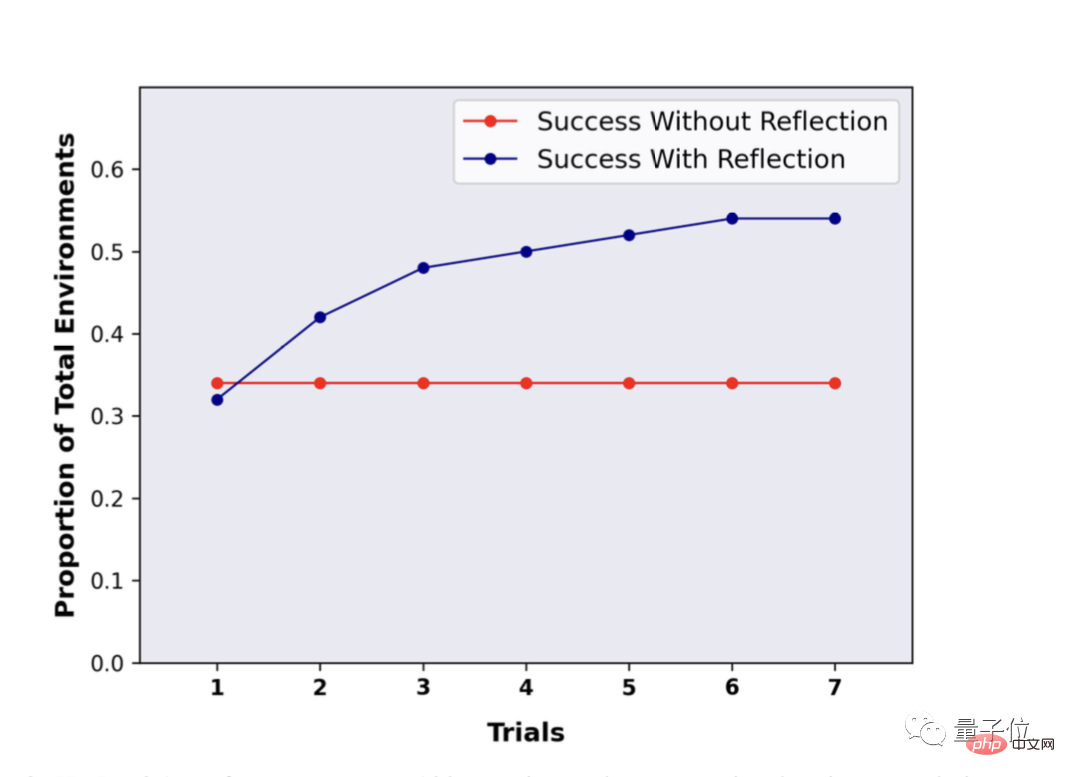

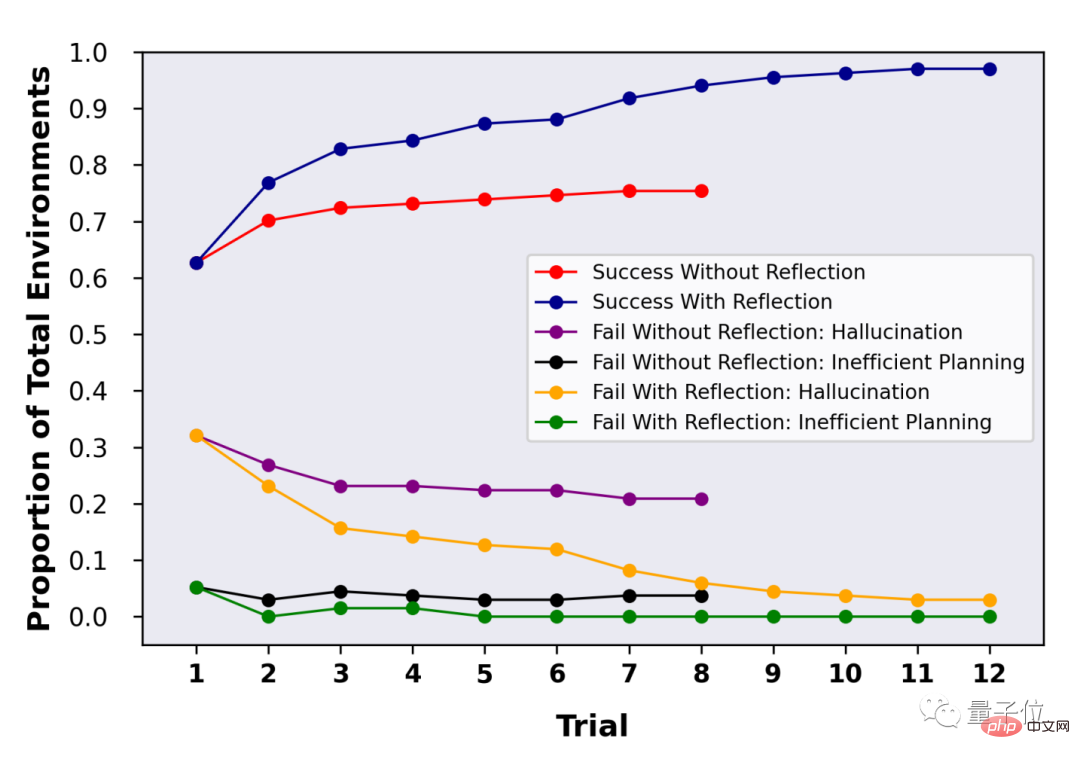

GPT-4 などの LLM は自己リフレクションを実行できるため、具体的にはどのような効果があるのでしょうか? 研究チームは、ALFWorld と HotpotQA ベンチマークでこのアプローチを評価しました。 100 の質問と回答のペアの HotpotQA テストでは、反射法を使用した LLM が大きな利点を示し、複数回の反射と繰り返しの質問の後、LLM のパフォーマンスは 30% 近く向上しました。 Reflexion を使用しない場合、Q&A を繰り返してもパフォーマンスに変化はありませんでした。HotpotQA の 134 問と回答のテストでは、Reflexion のサポートにより、複数回のリフレクション後に LLM の精度が 97% に達したことがわかります。

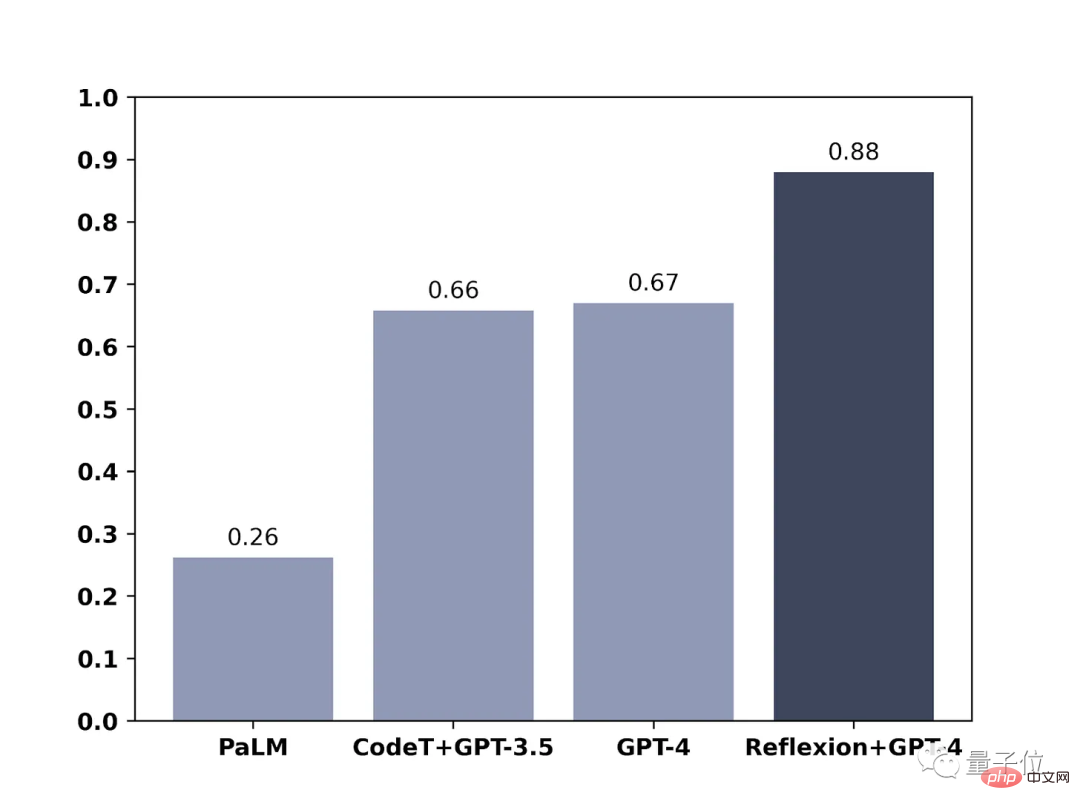

別のブログでは、チーム メンバーが GPT-4 でのメソッドの効果も示しました。テストの範囲はコードの作成でした。

結果も明らかで、Reflexion を使用すると、GPT-4 のプログラミング能力が直接 21% 向上しました。

GPT-4 について「考える」方法はすでに知っていますが、(フアン) (レ) (マ) は何と読みますか?

論文アドレス: https://arxiv.org/abs/2303.11366

以上がGPT-4のコーディング能力が21%向上! MITの新しい方法により、LLMは反省することを学ぶことができる、ネチズン:人間が考えるのと同じ方法だの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7560

7560

15

15

1384

1384

52

52

84

84

11

11

28

28

98

98

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

ICCV'23論文賞「Fighting of Gods」! Meta Divide Everything と ControlNet が共同で選ばれました、審査員を驚かせた記事がもう 1 つありました

Oct 04, 2023 pm 08:37 PM

ICCV'23論文賞「Fighting of Gods」! Meta Divide Everything と ControlNet が共同で選ばれました、審査員を驚かせた記事がもう 1 つありました

Oct 04, 2023 pm 08:37 PM

フランスのパリで開催されたコンピュータービジョンのトップカンファレンス「ICCV2023」が閉幕しました。今年の論文賞はまさに「神と神の戦い」です。たとえば、最優秀論文賞を受賞した 2 つの論文には、ヴィンセント グラフ AI の分野を覆す研究である ControlNet が含まれていました。 ControlNet はオープンソース化されて以来、GitHub で 24,000 個のスターを獲得しています。拡散モデルであれ、コンピュータ ビジョンの全分野であれ、この論文の賞は当然のことです。最優秀論文賞の佳作は、同じく有名なもう 1 つの論文、Meta の「Separate Everything」「Model SAM」に授与されました。 「Segment Everything」は、発売以来、後発のものも含め、さまざまな画像セグメンテーション AI モデルの「ベンチマーク」となっています。

NeRFと自動運転の過去と現在、10本近くの論文をまとめました!

Nov 14, 2023 pm 03:09 PM

NeRFと自動運転の過去と現在、10本近くの論文をまとめました!

Nov 14, 2023 pm 03:09 PM

Neural Radiance Fieldsは2020年に提案されて以来、関連論文の数が飛躍的に増加し、3次元再構成の重要な分野となっただけでなく、自動運転の重要なツールとして研究の最前線でも徐々に活発になってきています。 NeRF は、過去 2 年間で突然出現しました。その主な理由は、特徴点の抽出とマッチング、エピポーラ幾何学と三角形分割、PnP とバンドル調整、および従来の CV 再構成パイプラインのその他のステップをスキップし、メッシュ再構成、マッピング、ライト トレースさえもスキップするためです。 、2D から直接入力画像を使用して放射線野を学習し、実際の写真に近いレンダリング画像が放射線野から出力されます。言い換えれば、ニューラル ネットワークに基づく暗黙的な 3 次元モデルを指定されたパースペクティブに適合させます。

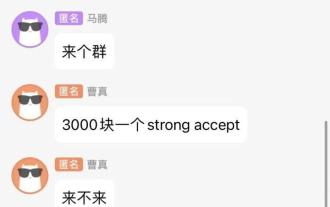

チャットのスクリーンショットから AI レビューの隠されたルールが明らかになります。 AAAI 3000元は強力に受け入れられますか?

Apr 12, 2023 am 08:34 AM

チャットのスクリーンショットから AI レビューの隠されたルールが明らかになります。 AAAI 3000元は強力に受け入れられますか?

Apr 12, 2023 am 08:34 AM

AAAI 2023 の論文提出期限が近づいていたとき、AI 投稿グループの匿名チャットのスクリーンショットが突然 Zhihu に表示されました。そのうちの1人は、「3,000元で強力なサービスを提供できる」と主張した。このニュースが発表されるとすぐに、ネットユーザーの間で国民の怒りを引き起こした。ただし、まだ急ぐ必要はありません。 Zhihuのボス「Fine Tuning」は、これはおそらく単に「言葉による喜び」である可能性が高いと述べた。 『ファイン・チューニング』によると、挨拶や集団犯罪はどの分野でも避けられない問題だという。 openreview の台頭により、cmt のさまざまな欠点がますます明らかになり、小さなサークルが活動できる余地は将来的には小さくなるでしょうが、余地は常にあります。これは個人の問題であり、投稿システムや仕組みの問題ではないからです。オープンRの紹介

紙のイラストも拡散モデルを使用して自動生成でき、ICLR にも受け入れられます。

Jun 27, 2023 pm 05:46 PM

紙のイラストも拡散モデルを使用して自動生成でき、ICLR にも受け入れられます。

Jun 27, 2023 pm 05:46 PM

生成 AI は人工知能コミュニティに旋風を巻き起こし、個人も企業も、Vincent 写真、Vincent ビデオ、Vincent 音楽など、関連するモーダル変換アプリケーションの作成に熱心になり始めています。最近、ServiceNow Research や LIVIA などの科学研究機関の数人の研究者が、テキストの説明に基づいて論文内のグラフを生成しようとしました。この目的のために、彼らは FigGen の新しい手法を提案し、関連する論文も TinyPaper として ICLR2023 に掲載されました。絵用紙のアドレス: https://arxiv.org/pdf/2306.00800.pdf 絵用紙のチャートを生成するのは何がそんなに難しいのかと疑問に思う人もいるかもしれません。これは科学研究にどのように役立ちますか?

中国チームが最優秀論文賞と最優秀システム論文賞を受賞し、CoRLの研究成果が発表されました。

Nov 10, 2023 pm 02:21 PM

中国チームが最優秀論文賞と最優秀システム論文賞を受賞し、CoRLの研究成果が発表されました。

Nov 10, 2023 pm 02:21 PM

2017 年に初めて開催されて以来、CoRL はロボット工学と機械学習の交差点における世界トップクラスの学術会議の 1 つになりました。 CoRL は、理論と応用を含むロボット工学、機械学習、制御などの複数のトピックをカバーするロボット学習研究のための単一テーマのカンファレンスであり、2023 年 CoRL カンファレンスは 11 月 6 日から 9 日まで米国アトランタで開催されます。公式データによると、今年は25か国から199本の論文がCoRLに選ばれた。人気のあるトピックには、演算、強化学習などが含まれます。 CoRLはAAAIやCVPRといった大規模なAI学会に比べて規模は小さいものの、今年は大型モデル、身体化知能、ヒューマノイドロボットなどの概念の人気が高まる中、関連研究も注目されるだろう。

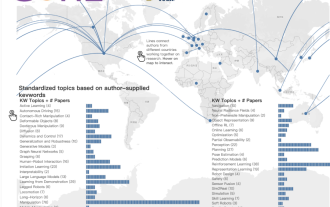

CVPR 2023 ランキング発表、採択率は 25.78%! 2,360 件の論文が受理され、投稿数は 9,155 件に急増しました。

Apr 13, 2023 am 09:37 AM

CVPR 2023 ランキング発表、採択率は 25.78%! 2,360 件の論文が受理され、投稿数は 9,155 件に急増しました。

Apr 13, 2023 am 09:37 AM

ちょうど今、CVPR 2023 が次のような記事を発表しました: 今年は記録的な 9,155 件の論文 (CVPR2022 より 12% 増) を受け取り、2,360 件の論文を受理し、受理率は 25.78% でした。統計によると、CVPRへの投稿数は2010年から2016年の7年間で1,724件から2,145件に増加しただけです。 2017年以降は急上昇して高度成長期に入り、2019年には初めて5,000件を超え、2022年には投稿数が8,161件に達した。ご覧のとおり、今年は合計 9,155 件の論文が投稿され、確かに記録を樹立しました。流行が緩和された後、今年のCVPRサミットはカナダで開催される予定だ。今年はシングルトラックカンファレンスとなり、従来の口頭選考は中止される。グーグルリサーチ

Microsoft の新しいホット ペーパー: Transformer が 10 億トークンに拡大

Jul 22, 2023 pm 03:34 PM

Microsoft の新しいホット ペーパー: Transformer が 10 億トークンに拡大

Jul 22, 2023 pm 03:34 PM

誰もが独自の大規模モデルのアップグレードと反復を継続するため、コンテキスト ウィンドウを処理する LLM (大規模言語モデル) の能力も重要な評価指標になりました。たとえば、スター モデル GPT-4 は 32,000 のトークンをサポートしており、これは 50 ページのテキストに相当します。OpenAI の元メンバーによって設立された Anthropic は、Claude のトークン処理能力を 100,000 (約 75,000 ワード) に増加させました。 「ハリー・ポッター」をワンクリックで要約するのと同じ「まず。 Microsoft の最新の調査では、今回は Transformer を 10 億トークンまで直接拡張しました。これにより、コーパス全体やインターネット全体を 1 つのシーケンスとして扱うなど、非常に長いシーケンスをモデル化するための新しい可能性が開かれます。比較のため、一般的な