ワンクリックで写真を切り取ることができます。 Meta が史上初の基本的な画像セグメンテーション モデルをリリースし、CV の新しいパラダイムを創出

たった今、Meta AI は、画像セグメンテーションの最初の基本モデルであるセグメント エニシング モデル (SAM) をリリースしました。

SAM は、写真やビデオから任意のオブジェクトをワンクリックでセグメンテーションすることができ、サンプルを使用せずに他のタスクに移行できます。

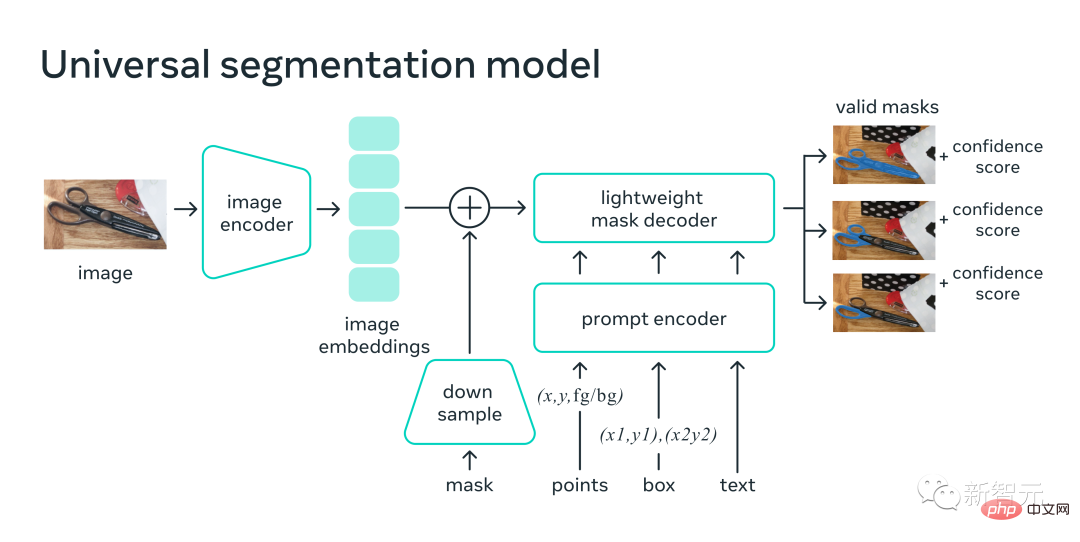

全体的に、SAM は基本モデル

1 の考え方に従います。テキスト、キーポイント、バウンディングボックスなどのマルチモーダルキューを処理できる、非常にシンプルでありながらスケーラブルなアーキテクチャ。

2. モデル設計と密接に関係する、直感的な注釈プロセス。

3. モデルを多数のラベルのない画像にブートストラップできるようにするデータ フライホイール。

そして、SAM は、未知の物体、見慣れないシーン (水中や顕微鏡下など)、ぼやけたものであっても、「オブジェクト」の一般的な概念を学習したと言っても過言ではありません。この場合も同様です。

さらに、SAM は新しいタスクや新しい分野に一般化することもでき、実践者自身がモデルを微調整する必要はなくなりました。

#論文アドレス: https://ai.facebook.com/research/publications/segment-anything/

#最も強力なのは、Meta がまったく異なる CV パラダイムを実装していることです。統合フレームワーク プロンプト エンコーダーで点、境界ボックス、文を指定して、ワンクリックでオブジェクトを直接セグメント化できます。

これに関して、Tencent AI アルゴリズムの専門家である Jin Tian 氏は、「NLP 分野のプロンプト パラダイムが CV 分野にも広がり始めています。今度は、従来の概念を完全に変える可能性があります」と述べています。 CV の予測思考。これで、モデルを実際に使用してあらゆるオブジェクトをセグメント化できるようになり、動的になります!」

NVIDIA AI 科学者のジム ファンもこれを賞賛しました: 私たちはすでにここにいますコンピュータービジョンの分野における「GPT-3の瞬間」!

では、CV は本当にもう存在しないのでしょうか?

SAM: ワンクリックで画像内のすべてのオブジェクトを「切り取る」Segment Anything は、画像のセグメンテーション専用の最初の基本モデルです。

セグメンテーションとは、どの画像ピクセルがオブジェクトに属しているかを識別することを指し、常にコンピューター ビジョンの中核的なタスクです。

ただし、特定のタスクに対して正確なセグメンテーション モデルを作成するには、通常、専門家による高度に専門化された作業が必要です。このプロセスには、AI をトレーニングするためのインフラストラクチャと多数の慎重に注釈が付けられたドメイン データであるため、しきい値は非常に高くなります。

この問題を解決するために、Meta は画像セグメンテーションの基本モデルである SAM を提案しました。このヒント可能なモデルは、多様なデータでトレーニングされ、さまざまなタスクに適応できるだけでなく、NLP モデルでヒントが使用される方法と同様に動作します。

SAM モデルは、「オブジェクトとは何か」という概念を理解しており、トレーニング中に表示されなかったオブジェクトも含め、あらゆる画像やビデオ内のあらゆるオブジェクトのマスクを生成できます。

SAM は非常に多用途であるため、さまざまなユースケースをカバーしており、水中写真や細胞顕微鏡など、追加のトレーニングなしですぐに新しいイメージング領域で使用できます。言い換えれば、SAM にはゼロサンプル移行の機能がすでに備わっています。

Meta 氏はブログで興奮気味に次のように述べています。将来的には、画像内のオブジェクトを検索してセグメント化する必要があるあらゆるアプリケーションで SAM が使用されることが予想されます。

SAM は、より大規模な AI システムの一部となり、Web ページのビジュアルおよびテキスト コンテンツの理解など、世界のより一般的なマルチモーダルな理解を開発することができます。

AR/VR の分野では、SAM はユーザーの視線に基づいてオブジェクトを選択し、そのオブジェクトを 3D に「アップグレード」できます。

コンテンツ作成者は、SAM を使用してコラージュやビデオ編集用に画像領域を抽出できます。

SAM は、ビデオ内の動物や物体の位置を特定して追跡することもできるため、自然科学や天文学の研究に役立ちます。

#一般的なセグメンテーション方法

これまで、セグメンテーションの問題を解決するには 2 つの方法がありました。

1 つはインタラクティブ セグメンテーションです。これは、あらゆるカテゴリのオブジェクトをセグメント化できますが、人が繰り返しマスクを微調整する必要があります。

2 つ目は自動セグメンテーションです。これは、事前に定義された特定のオブジェクトをセグメント化できますが、トレーニング プロセスでは、手動でラベル付けされた多数のオブジェクトが必要です (たとえば、猫をセグメント化するには、数千個のオブジェクトが必要です)。例)。

つまり、これら 2 つの方法はいずれも、汎用の完全自動セグメンテーション方法を提供することはできません。

SAM は、これら 2 つの方法を一般化したものとみなすことができ、対話型セグメンテーションと自動セグメンテーションを簡単に実行できます。

モデルのプロンプト表示可能なインターフェイスでは、モデルに適切なプロンプト (クリック、ボックス、テキストなど) を設計するだけで、幅広いセグメンテーション タスクを完了できます。

さらに、SAM は 10 億を超えるマスクを含む多様で高品質なデータセットでトレーニングされているため、モデルをその機能を超えて新しいオブジェクトや画像に一般化することができます。 。その結果、実務者はユースケースに合わせてモデルを微調整するために独自のセグメンテーション データを収集する必要がなくなりました。

新しいタスクや新しい分野に一般化できるこの種の柔軟性は、画像セグメンテーションの分野では初めてです。

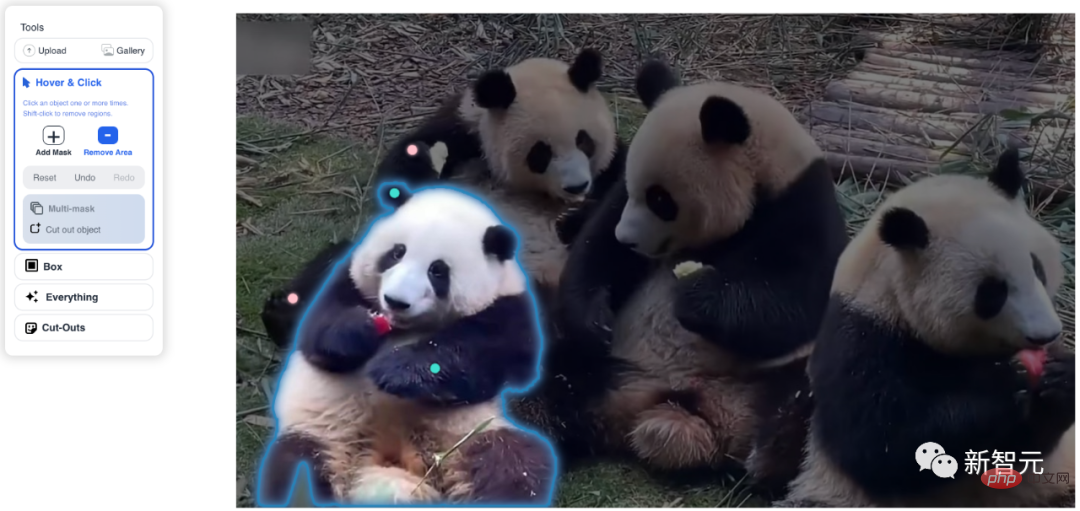

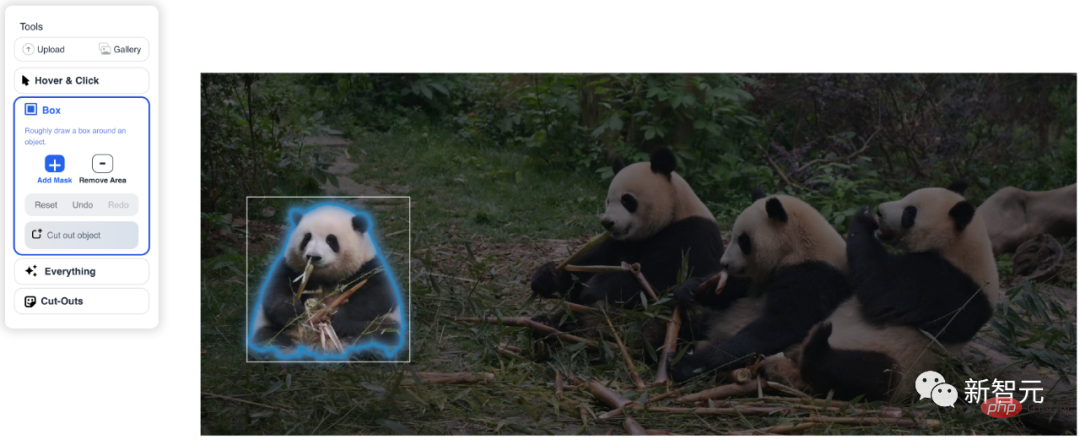

(1) SAM を使用すると、ユーザーはワンクリックでオブジェクトをセグメント化するか、多くの点を対話的にクリックすることができ、モデルの境界ボックスのヒントも使用できます。 (2) セグメント化されたオブジェクトの曖昧さに直面した場合、SAM は複数の有効なマスクを出力できます。これは、現実世界でのセグメント化の問題を解決するために不可欠な機能です。 (3) SAM は、画像内のすべてのオブジェクトを自動的に検出してブロックできます。 (4) 画像埋め込みを事前計算した後、SAM は任意のプロンプトに対してセグメンテーション マスクをリアルタイムで生成できるため、ユーザーはリアルタイムでモデルを操作できます。 仕組み研究者によって訓練された SAM は、あらゆるプロンプトに対して有効なセグメンテーション マスクを返すことができます。キューには、前景/背景ポイント、大まかなボックスまたはマスク、自由形式のテキスト、または一般に画像内でセグメンテーションが必要であることを示す任意の情報を使用できます。

効果的なマスキングの要件は、プロンプトがあいまいで複数のオブジェクトを参照している場合でも (たとえば、シャツ上の点がシャツまたは人のいずれかを表している可能性がある) ということを意味します。シャツを着ている ) 場合、出力はいずれかのオブジェクトの適切なマスクになるはずです。

特に、標準スタッフが注釈を付けるためにリアルタイムで SAM と効率的に対話できるように、モデルは Web ブラウザの CPU 上でリアルタイムで実行する必要があります。

実行時間の制約は、品質と実行時間の間にトレードオフがあることを意味しますが、研究者らは、実際には単純な設計でも良好な結果が得られることを発見しました。

SAM の画像エンコーダは画像の 1 回限りの埋め込みを生成しますが、軽量デコーダはあらゆるヒントをオンザフライでベクトル埋め込みに変換します。これら 2 つの情報源は、セグメンテーション マスクを予測する軽量デコーダーで結合されます。

画像の埋め込みを計算した後、SAM はわずか 50 ミリ秒で画像のセグメントを生成し、Web ブラウザーにプロンプトを表示します。

プロジェクトのデモ

複数の入力プロンプト

画像内で分割するコンテンツを指定するためのプロンプト、追加のトレーニングなしで、さまざまなセグメンテーション タスクを実装できます。

インタラクション ポイントとボックスをプロンプトとして使用する

画像内のすべての要素を自動的にセグメント化します

##曖昧なプロンプトに対して複数の有効なマスクを生成

プロンプト可能なデザイン

SAM は入力プロンプトを受け入れることができます他のシステムから。

たとえば、AR/VR ヘッドセットから送信されるユーザーの視覚焦点情報に基づいて、対応するオブジェクトを選択します。 Meta による現実世界を理解できる AI の開発は、将来のメタバースの旅への道を切り開くことになります。

#あるいは、オブジェクト検出器からの境界ボックスのヒントを使用して、テキストからオブジェクトへのセグメンテーションを実装します。

スケーラブルな出力

出力マスクは、他の AI システムへの入力として使用できます。

たとえば、オブジェクトのマスクをビデオ内で追跡したり、画像編集アプリケーションを通じて 3D に変換したり、コラージュなどのクリエイティブなタスクに使用したりできます。

SAM が学習した一般オブジェクトとは何かという概念 - この理解により、追加のトレーニングを必要とせずに、なじみのないオブジェクトや画像に対するゼロショットの一般化が可能になります。

#さまざまなレビュー

[ホバー&クリック]を選択し、[マスクの追加]をクリックすると緑色の点が表示され、[領域の削除]をクリックすると赤い点が表示されます。リンゴを食べるフワワはすぐに丸く囲まれました。

#Box 機能では、ボックスを選択するだけですぐに認識が完了します。

#[すべて] をクリックすると、システムによって認識されたすべてのオブジェクトがすぐに抽出されます。

カットアウトを選択すると、数秒で三角団子が完成します。

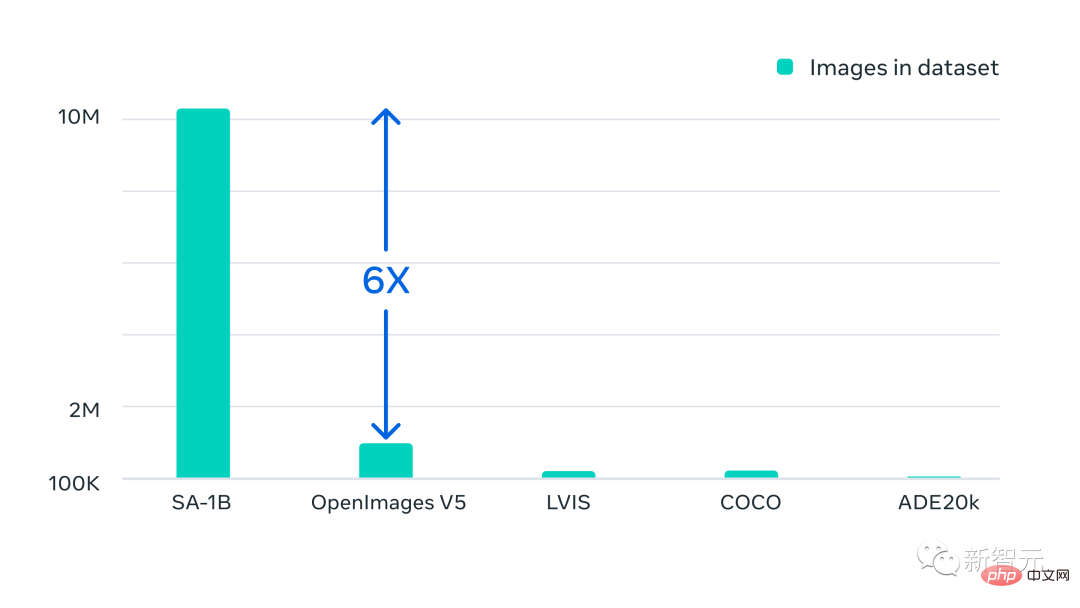

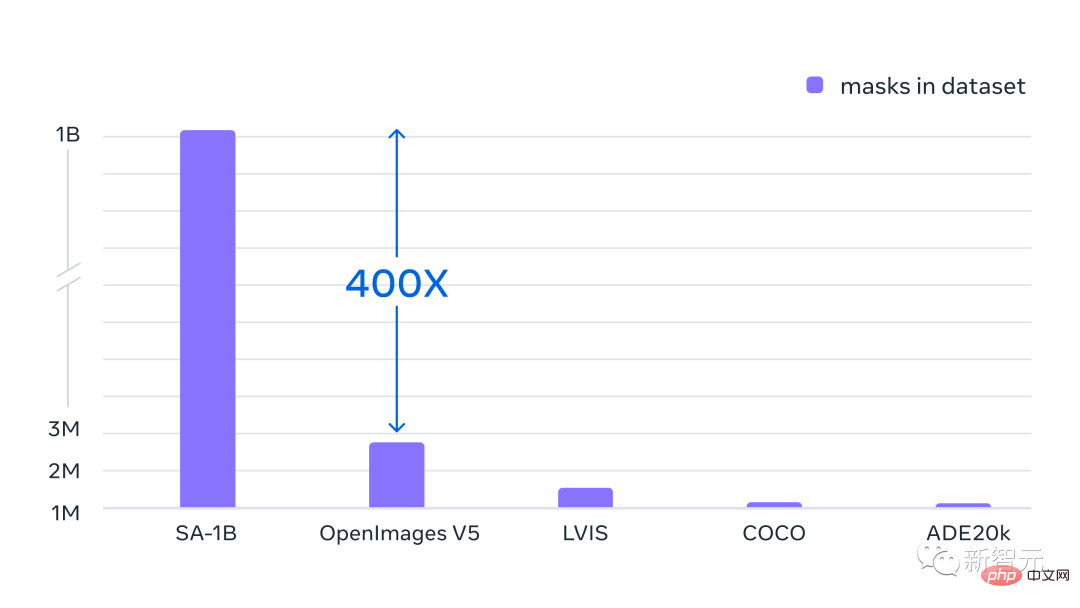

SA-1B データセット: 1,100 万枚の画像、11 億枚のマスク

リリースされた新しいモデルに加えて、Meta もリリースされましたSA-1B は、これまでで最大のセグメンテーション データセットです。

このデータセットは、1,100 万の多様な高解像度のプライバシー保護画像と 11 億の高品質セグメンテーション マスクで構成されています。

#データセットの全体的な特徴は次のとおりです。

# · 総画像数: 1,100 万

· マスクの総数: 11 億

· 画像あたりの平均マスク数: 100

· 平均画像解像度: 1500 × 2250 ピクセル

注: 画像またはマスクの注釈にはクラス ラベルがありません

メタは、これらのデータがデータ エンジンを通じて収集されることを特に強調しています。 、すべてのマスクはすべて SAM によって完全に自動生成されます。

SAM モデルを使用すると、新しいセグメンテーション マスクの収集がこれまでよりも速くなり、対話型でマスクに注釈を付けるのにかかる時間はわずか約 14 秒です。

マスクごとの注釈プロセスは、境界ボックスに注釈を付けるよりもわずか 2 倍遅いだけです。最速の注釈インターフェイスを使用すると、境界ボックスに注釈を付けるには約 7 秒かかります。

以前の大規模なセグメンテーション データ収集の取り組みと比較して、SAM モデル COCO の完全に手動のポリゴンベースのマスク アノテーションは、以前の最大規模のデータ アノテーションの取り組み (モデル補助も) 2 よりも 6.5 倍高速です。倍速くなります。

ただし、インタラクティブなアノテーション マスクに依存するだけでは、10 億を超えるマスクされたデータ セットを作成するには不十分です。そこで、Meta は SA-1B データセットを作成するためのデータ エンジンを構築しました。

このデータ エンジンには 3 つの「歯車」があります:

1. モデル補助アノテーション

2. 全自動アノテーションと補助アノテーションを組み合わせることで、収集されたマスクの多様性を高めることができます

#3. 全自動マスク作成により、データ セットの拡張が可能になります最終的なデータセットには、約 1,100 万枚の許可されたプライバシー保護画像から収集された 11 億を超えるセグメンテーション マスクが含まれています。

SA-1B には、既存のセグメンテーション データセットの 400 倍のマスクがあります。また、人による評価研究により、マスクは高品質で多様性があり、場合によっては、完全に手動で注釈が付けられた小規模なデータセットの以前のマスクと定性的に同等であることが確認されています。

SA-1B の写真は複数の国の写真提供者を通じて入手しました。これらの国は地理的に異なる地域にまたがっています。そして収入水準。

SA-1B の写真は複数の国の写真提供者を通じて入手しました。これらの国は地理的に異なる地域にまたがっています。そして収入水準。

一部の地理的領域は依然として過小評価されていますが、SA-1B には以前のセグメンテーション データセットよりも多くの画像があり、すべての地域にわたって全体的な表現が向上しています。

最後に、メタ社は、このデータが各マスクに関連付けられたテキストの説明などの追加の注釈を含む新しいデータセットの基礎を形成できることを期待していると述べています。

RBG マスターがチームを率いる

ロス・ガーシック

##Ross Girshick (RBG の第一人者と呼ばれることが多い) は、Facebook 人工知能研究所 (FAIR) の研究員であり、コンピューター ビジョンと機械学習の研究に取り組んでいます。

2012 年、Ross Girshick は、Pedro Felzenszwalb の監督の下、シカゴ大学からコンピュータ サイエンスの博士号を取得しました。

FAIR に入社する前、ロスは Microsoft Research の研究者であり、カリフォルニア大学バークレー校の博士研究員でした。そこでの指導者は Jitendra Malik と Trevor Darrell でした。

オープンソース ソフトウェアへの貢献が認められ、2017 年 PAMI 若手研究者賞、2017 年および 2021 年 PAMI マーク・エバリンガム賞を受賞しました。

ご存知のとおり、Ross と He Kaiming は R-CNN 法のターゲット検出アルゴリズムを共同開発しました。 2017 年、Ross と He Kaiming による Mask R-CNN 論文が ICCV 2017 で最優秀論文を受賞しました。

ネチズン: CV は実際にはもう存在しませんMeta が CV 分野でこのセグメンテーション基本モデルを作成したため、多くのネチズンがこう叫びました。 「存在しない。存在する。」

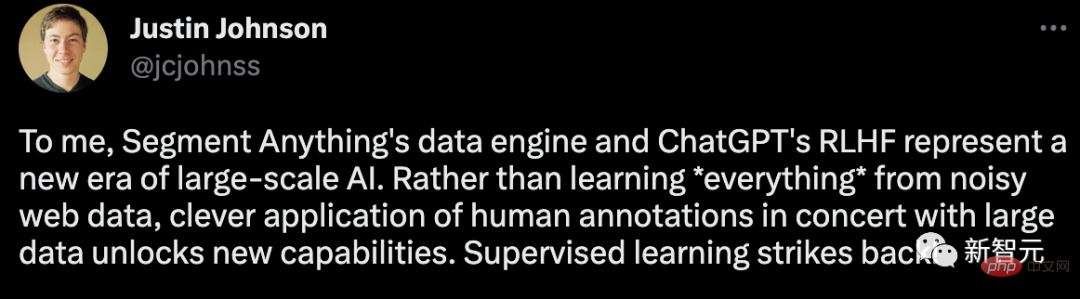

メタサイエンティストのジャスティン・ジョンソン氏は次のように述べています。「私にとって、Segment Anything のデータ エンジンと ChatGPT の RLHF は、最大の新しいデータ エンジンを表します。人工知能の時代です。ノイズの多いネットワーク データからすべてを学習するのではなく、人間による注釈をビッグ データと組み合わせて巧みに適用して、新しい機能を解放する方が良いでしょう。教師あり学習が帰ってきました!」

#唯一の残念な点は、SAM モデルのリリースが主にロス ガーシック氏によって主導されたのに、何ユーミン氏が欠席したことです。

親しい友人「matrix Mingzi」は、この記事はマルチモダリティがCVであることをさらに証明していると述べました。純粋な履歴書の場合。

以上がワンクリックで写真を切り取ることができます。 Meta が史上初の基本的な画像セグメンテーション モデルをリリースし、CV の新しいパラダイムを創出の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7514

7514

15

15

1378

1378

52

52

79

79

11

11

19

19

64

64

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Systemsでは、Readdir関数はディレクトリコンテンツを読み取るために使用されますが、それが戻る順序は事前に定義されていません。ディレクトリ内のファイルを並べ替えるには、最初にすべてのファイルを読み取り、QSORT関数を使用してソートする必要があります。次のコードは、debianシステムにreaddirとqsortを使用してディレクトリファイルを並べ替える方法を示しています。

Debian Readdirのパフォーマンスを最適化する方法

Apr 13, 2025 am 08:48 AM

Debian Readdirのパフォーマンスを最適化する方法

Apr 13, 2025 am 08:48 AM

Debian Systemsでは、Directoryコンテンツを読み取るためにReadDirシステム呼び出しが使用されます。パフォーマンスが良くない場合は、次の最適化戦略を試してください。ディレクトリファイルの数を簡素化します。大きなディレクトリをできる限り複数の小さなディレクトリに分割し、Readdirコールごとに処理されたアイテムの数を減らします。ディレクトリコンテンツのキャッシュを有効にする:キャッシュメカニズムを構築し、定期的にキャッシュを更新するか、ディレクトリコンテンツが変更されたときに、頻繁な呼び出しをreaddirに削減します。メモリキャッシュ(memcachedやredisなど)またはローカルキャッシュ(ファイルやデータベースなど)を考慮することができます。効率的なデータ構造を採用する:ディレクトリトラバーサルを自分で実装する場合、より効率的なデータ構造(線形検索の代わりにハッシュテーブルなど)を選択してディレクトリ情報を保存およびアクセスする

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian Systemsでは、OpenSSLは暗号化、復号化、証明書管理のための重要なライブラリです。中間の攻撃(MITM)を防ぐために、以下の測定値をとることができます。HTTPSを使用する:すべてのネットワーク要求がHTTPの代わりにHTTPSプロトコルを使用していることを確認してください。 HTTPSは、TLS(Transport Layer Security Protocol)を使用して通信データを暗号化し、送信中にデータが盗まれたり改ざんされたりしないようにします。サーバー証明書の確認:クライアントのサーバー証明書を手動で確認して、信頼できることを確認します。サーバーは、urlsessionのデリゲート方法を介して手動で検証できます

Debian Apacheログレベルを設定する方法

Apr 13, 2025 am 08:33 AM

Debian Apacheログレベルを設定する方法

Apr 13, 2025 am 08:33 AM

この記事では、DebianシステムのApachewebサーバーのロギングレベルを調整する方法について説明します。構成ファイルを変更することにより、Apacheによって記録されたログ情報の冗長レベルを制御できます。方法1:メイン構成ファイルを変更して、構成ファイルを見つけます。Apache2.xの構成ファイルは、通常/etc/apache2/ディレクトリにあります。ファイル名は、インストール方法に応じて、apache2.confまたはhttpd.confである場合があります。構成ファイルの編集:テキストエディターを使用してルートアクセス許可を使用して構成ファイルを開く(nanoなど):sudonano/etc/apache2/apache2.conf

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

DebianシステムのReadDir関数は、ディレクトリコンテンツの読み取りに使用されるシステムコールであり、Cプログラミングでよく使用されます。この記事では、ReadDirを他のツールと統合して機能を強化する方法について説明します。方法1:C言語プログラムを最初にパイプラインと組み合わせて、cプログラムを作成してreaddir関数を呼び出して結果をinclude#include#include inctargc、char*argv []){dir*dir; structdireant*entry; if(argc!= 2){(argc!= 2){

Debian syslogを学ぶ方法

Apr 13, 2025 am 11:51 AM

Debian syslogを学ぶ方法

Apr 13, 2025 am 11:51 AM

このガイドでは、Debian SystemsでSyslogの使用方法を学ぶように導きます。 Syslogは、ロギングシステムとアプリケーションログメッセージのLinuxシステムの重要なサービスです。管理者がシステムアクティビティを監視および分析して、問題を迅速に特定および解決するのに役立ちます。 1. syslogの基本的な知識Syslogのコア関数には以下が含まれます。複数のログ出力形式とターゲットの場所(ファイルやネットワークなど)をサポートします。リアルタイムのログ表示およびフィルタリング機能を提供します。 2。syslog(rsyslogを使用)をインストールして構成するDebianシステムは、デフォルトでrsyslogを使用します。次のコマンドでインストールできます:sudoaptupdatesud

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail ServerにSSL証明書をインストールする手順は次のとおりです。1。最初にOpenSSL Toolkitをインストールすると、OpenSSLツールキットがシステムに既にインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoapt-getUpdatesudoapt-getInstalopenssl2。秘密キーと証明書のリクエストを生成次に、OpenSSLを使用して2048ビットRSA秘密キーと証明書リクエスト(CSR)を生成します:Openss

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverのファイアウォールの構成は、サーバーのセキュリティを確保するための重要なステップです。以下は、iPtablesやFirewalldの使用を含む、一般的に使用されるファイアウォール構成方法です。 iPtablesを使用してファイアウォールを構成してIPTablesをインストールします(まだインストールされていない場合):sudoapt-getupdatesudoapt-getinstalliptablesview現在のiptablesルール:sudoiptables-l configuration