130億パラメータ、8つのA100トレーニング、カリフォルニア大学バークレー校が対話モデルKoalaをリリース

Meta が LLaMA シリーズのモデルをリリースしてオープンソース化して以来、スタンフォード大学、カリフォルニア大学バークレー校などの研究者が LLaMA に基づいて「二次創作」を行い、Alpaca、Vicuna などを次々と発表してきました。 「アルパカ」の大型モデル。

Alpaca は、オープンソース コミュニティの新しいリーダーになりました。 「二次創作」の氾濫により、生物学上のアルパカ属を表す英語はほとんど使われなくなったが、大型モデルに他の動物の名前を付けることも可能である。

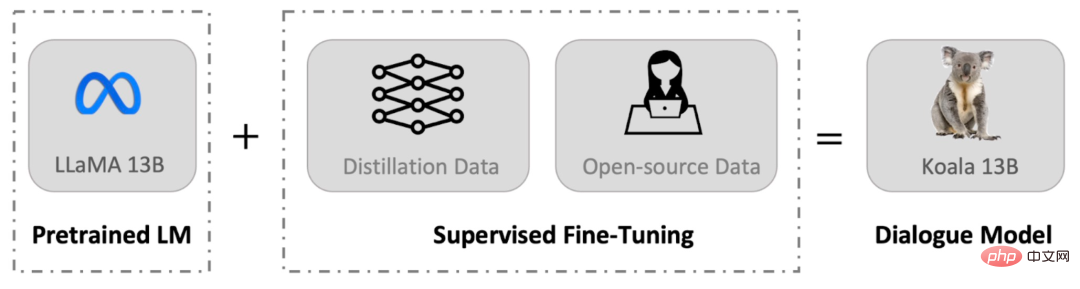

最近、カリフォルニア大学バークレー校のバークレー人工知能研究所 (BAIR) は、消費者グレードの GPU で実行できる会話モデル Koala (直訳すると「コアラ」) をリリースしました。 Koala は、Web から収集した会話データを使用して LLaMA モデルを微調整します。

プロジェクトのアドレス: https://bair.berkeley.edu/blog/2023/04/03/koala/

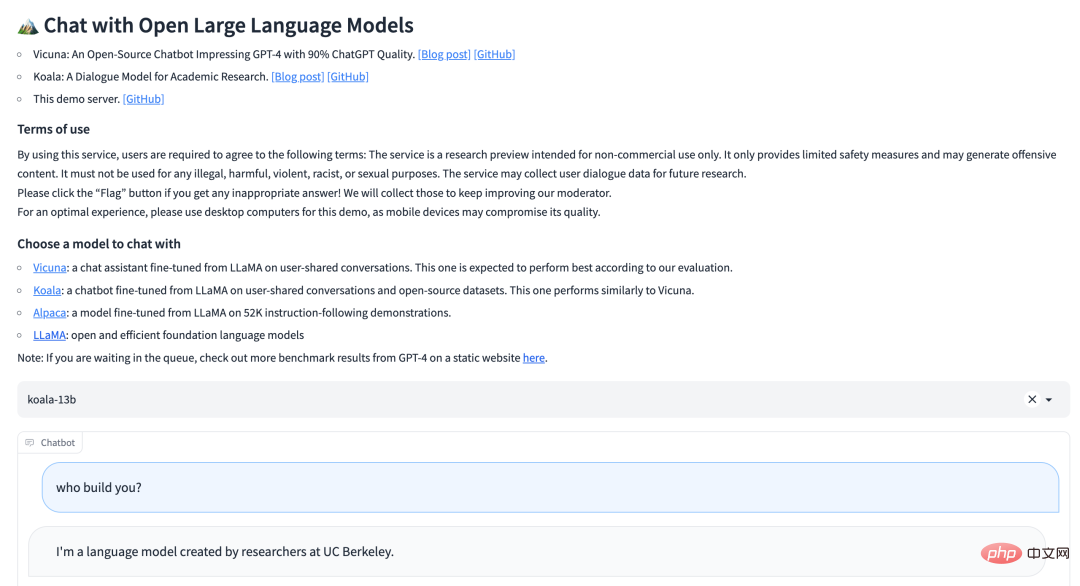

#Koala はオンライン テスト デモを開始しました:

- #デモ アドレス: https ://chat.lmsys.org/?model=koala-13b

- オープンソース アドレス: https://github.com/young-geng/EasyLM

Koala の概要

Vicuna と同様、Koala もネットワークから収集した会話データを使用して、次のことに重点を置いて LLaMA モデルを微調整します。 ChatGPT クローズドソースの大規模モデル対話の公開データ。

研究チームは、Koala モデルは JAX/Flax を使用して EasyLM に実装されており、Koala モデルは 8 つの A100 GPU を搭載した単一の Nvidia DGX サーバーでトレーニングされていると述べています。 2 エポックのトレーニングを完了するには 6 時間かかります。このようなトレーニングの費用は、パブリック クラウド コンピューティング プラットフォームでは通常 100 ドル未満です。

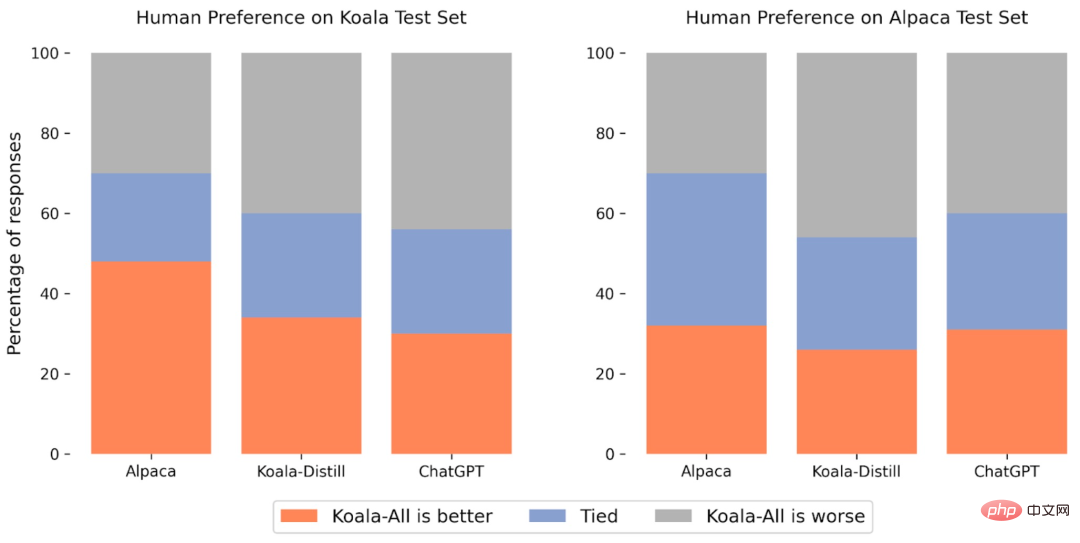

研究チームは、Koala と ChatGPT およびスタンフォード大学の Alpaca を実験的に比較しました。その結果、130 億のパラメーターを備えた Koala-13B が、さまざまなユーザーのクエリに効果的に応答し、応答を生成できることが一般的に優れていることがわかりました。 Alpaca のパフォーマンスは、半分以上のケースで ChatGPT のパフォーマンスに匹敵します。

Koala の最も重要な意義は、高品質のデータセットでトレーニングした場合、ローカルで実行できるほど小さなモデルでも大規模モデルと同様の優れたパフォーマンスを達成できることを示していることです。モデル 。これは、単に既存のシステムのサイズを増やすよりも、より安全で現実的で強力なモデルにつながる可能性があるため、オープンソース コミュニティは高品質のデータセットを厳選するためにより熱心に取り組む必要があることを意味します。この観点から見ると、Koala は小さいながらも ChatGPT の洗練された代替品です。

ただし、Koala は研究用のプロトタイプにすぎず、コンテンツ、セキュリティ、信頼性の点で依然として重大な欠陥があるため、研究以外の目的で使用しないでください。

データセットとトレーニング

会話モデルを構築する際の主なハードルは、トレーニング データの管理です。 ChatGPT、Bard、Bing Chat、Claude などの大規模な会話モデルはすべて、広範な人間による注釈を備えた独自のデータセットを使用します。 Koala のトレーニング データセットを構築するために、研究チームは、Web および公開データセットから会話データを収集して厳選しました。これらのデータセットには、ChatGPT などの大規模な言語モデルで話しているユーザーによって公開で共有されたデータが含まれています。

データ セットを最大化するためにできるだけ多くのネットワーク データをクロールする他のモデルとは異なり、Koala は、公開データ セットの質問と回答の部分を含む、小規模で高品質のデータ セットを収集することに重点を置いています。 、人間によるフィードバック (肯定的および否定的) および既存の言語モデルとの対話。具体的には、Koala のトレーニング データ セットには次の部分が含まれています:

ChatGPT 蒸留データ:

- 一般公開chatGPT 会話データ (ShareGPT);

- Human ChatGPT 比較コーパス (HC3)、HC3 データセットからの人間の応答と ChatGPT 応答の両方を使用します。

オープンソース データ:

- オープン インストラクション ジェネラリスト (OIG);

- スタンフォード アルパカ モデルで使用されるデータセット;

- Anthropic HH ;

- OpenAI WebGPT;

- OpenAI の要約。

実験と評価

この研究では、Koala-All の生成と Koala-Distill、Alpaca、および ChatGPT を比較する手動評価を実施しました。結果は下の図に示されています。このうち、2 つの異なるデータ セットがテストに使用されます。1 つは 180 のテスト クエリを含むスタンフォードの Alpaca テスト セット (Alpaca Test Set)、もう 1 つは Koala Test Set です。

全体的に、Koala モデルは、LLM の多くの機能を実証するのに十分ですが、微調整を容易にしたり、コンピューティング リソースが不足している状況でも十分に小さいため、限定されておりますので、以下をご利用ください。研究チームは、Koala モデルが大規模言語モデルに関する将来の学術研究にとって有用なプラットフォームになることを期待しています。研究応用の方向性としては次のものが考えられます:

- 安全性と調整: Koala により、言語モデルのセキュリティと人間の意図とのより良い調整に関するさらなる研究が可能になります。

- モデル バイアス: Koala を使用すると、大規模な言語モデルのバイアスをより深く理解し、会話データセットの品質問題を掘り下げ、最終的には大規模な言語モデルのパフォーマンスの向上に役立ちます。

- 大規模な言語モデルを理解する: Koala モデルは比較的安価な消費者向け GPU で実行でき、さまざまなタスクを実行できるため、Koala を使用すると、会話言語の内部構造をよりよく調べて理解できるようになります。このモデルにより、言語モデルがより解釈しやすくなります。

以上が130億パラメータ、8つのA100トレーニング、カリフォルニア大学バークレー校が対話モデルKoalaをリリースの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

最近、軍事界は、米軍戦闘機が AI を使用して完全自動空戦を完了できるようになったというニュースに圧倒されました。そう、つい最近、米軍のAI戦闘機が初めて公開され、その謎が明らかになりました。この戦闘機の正式名称は可変安定性飛行シミュレーター試験機(VISTA)で、アメリカ空軍長官が自ら飛行させ、一対一の空戦をシミュレートした。 5 月 2 日、フランク ケンダル米国空軍長官は X-62AVISTA でエドワーズ空軍基地を離陸しました。1 時間の飛行中、すべての飛行動作が AI によって自律的に完了されたことに注目してください。ケンダル氏は「過去数十年にわたり、私たちは自律型空対空戦闘の無限の可能性について考えてきたが、それは常に手の届かないものだと思われてきた」と語った。しかし今では、