ルカンが強くお勧めします!ハーバード大学の医師が、あらゆるワークフローに至るまで科学研究に GPT-4 を使用する方法を共有します

GPT-4 の出現により、多くの人が科学研究を心配し、NLP など存在しないと冗談を言う人さえいました。

# 心配するよりも、単に「論文の方法を変更する」だけで、科学研究に使用する方が良いでしょう。

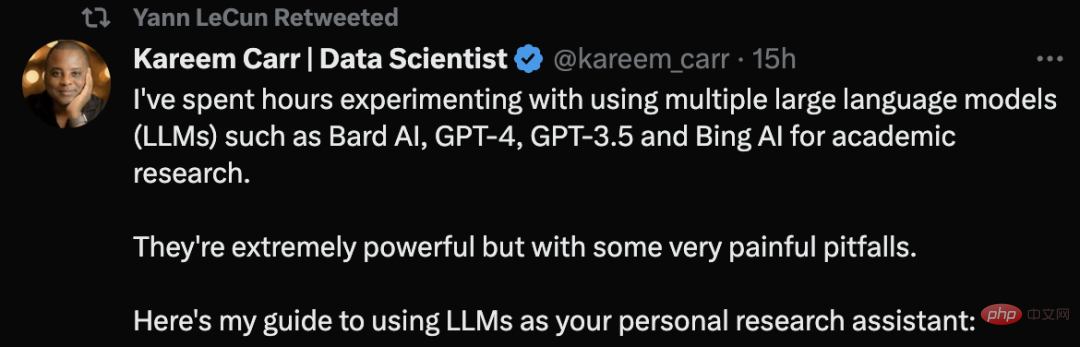

ハーバード大学の生物統計学博士であるカリーム・カー氏は、GPTなどの大規模言語モデルツールを使用したことがあると言った。 -4 学術研究を実施した。

# これらのツールは非常に強力ですが、非常に痛い落とし穴もいくつかあると彼は言いました。

LLM の使用に関するアドバイスに関する彼のツイートは、LeCun を推薦することにもなりました。

#Kareem Carr が AI ツールを使用して科学研究を行う方法を見てみましょう。

第一原則: 検証できないコンテンツについては LLM を検索しないでください

冒頭で、Carr 氏は最初で最も重要なルールを与えました。原則:

#自分自身で検証できない情報について大規模言語モデル (LLM) に尋ねたり、実行されたかどうかを検証できないタスクの実行を LLM に依頼したりしないでください。正しく完了しました。

唯一の例外は、LLM にアパートの装飾のアイデアを求めるなど、重要なタスクではない場合です。

#「文献レビューのベスト プラクティスを使用して、過去 10 年間の乳がん研究に関する研究を要約します。」文献が正しく要約されているかどうかを直接確認できないため、これは不適切なリクエストです。

# その代わりに、「過去 10 年間の乳がん研究に関するトップレビュー論文のリストを教えてください。」と尋ねてください。

# このようなプロンプトは、ソースを検証するだけでなく、自分自身で信頼性を検証することもできます。

「プロンプト」を作成するためのヒント

LLM にコードの作成を依頼したり、関連情報を検索したりするのは非常に簡単ですが、プロンプトの品質は出力内容に影響を与える可能性がありますが、大きな違いがあります。品質を向上させるためにできることは次のとおりです:

コンテキストの設定:

•どの情報を使用する必要があるかを LLM に明示的に指示する

##•用語と記号を使用して、正しいコンテキスト情報に向けて LLM を方向付ける

リクエストの処理方法についてアイデアがある場合は、使用する具体的な方法を LLM に伝えてください。たとえば、「この不等式を解く」は、「コーシー・シュワルツの定理を使用してこの不等式を解き、完全二乗を適用する」に変更する必要があります。

#これらの言語モデルはあなたが思っているよりも言語的に複雑であり、非常に曖昧なヒントでも役に立つことに注意してください。

より具体的に:

これは問題ではありません。 Google 検索なので、あなたの問題を正確に論じているサイトがあるかどうか心配する必要はありません。

「二次項の連立方程式を解くにはどうすればよいですか?」このプロンプトは明確ではありません。「x=(1/2 )( を解くa b) および y=(1/3)(a^2 ab b^2) a と b に関する連立方程式。

出力形式を定義します。

LLM の柔軟性を利用して、出力を次のようにフォーマットします。

• コード

• 数式

• 記事

##• チュートリアル

• 簡単なガイド

##表、プロット、チャートなどを生成するコードを要求することもできます。

#LLM の出力結果が得られますが、これは始まりにすぎません。出力内容を確認する必要があるためです。これには以下が含まれます:

#• 不一致の発見

• Google 用語による検索ツールの出力コンテンツ、サポート可能なソースの入手

#• 可能であれば、自分でテストするコードを作成してください自己検証を行う理由は、LLM が見かけのプロ意識と矛盾する奇妙な間違いを犯すことが多いためです。たとえば、LLM は非常に高度な数学的概念について言及しているものの、単純な代数問題については混乱している可能性があります。

もう一度質問してください:

大規模言語モデルの生成 内容はランダムです。新しいウィンドウを作成して再度質問すると、より適切な答えが得られる場合があります。#さらに、複数の LLM ツールを使用します。 Kareem Carr 氏は現在、自身のニーズに応じて科学研究で Bing AI、GPT-4、GPT-3.5、Bard AI を使用しています。ただし、それぞれに独自の長所と短所があります。

#見積生産性

見積# #Carr の経験によれば、異なる視点を得るには、GPT-4 と Bard AI の両方に同時に同じ数学的質問をするのが最善です。 Bing AI は Web 検索で動作します。 GPT-4 は GPT-3.5 よりもはるかにスマートですが、現在 OpenAI は 3 時間で 25 メッセージに制限されており、アクセスがより困難になっています。

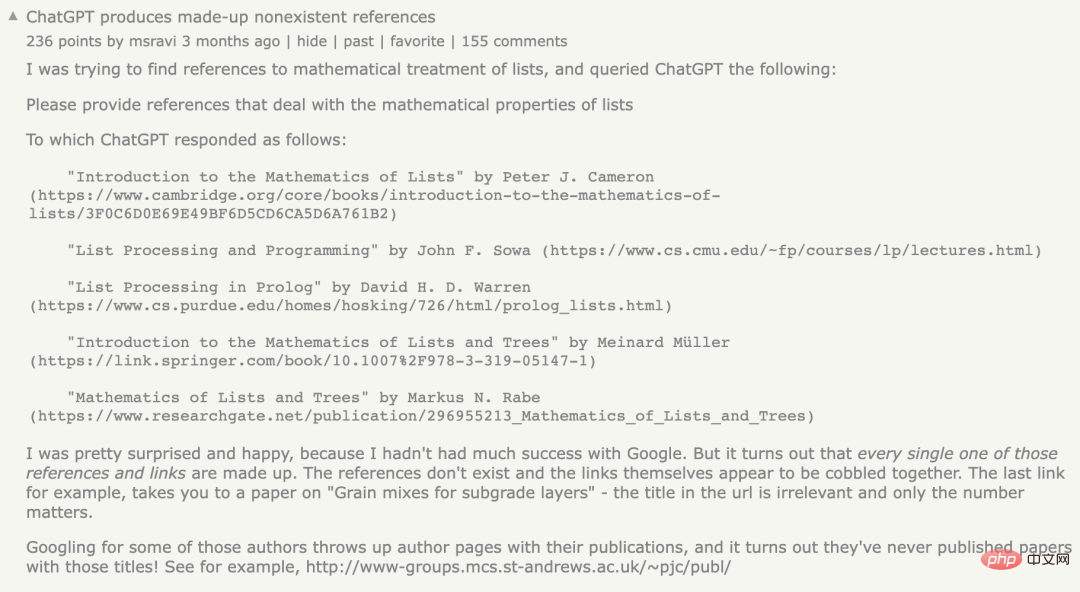

#引用の問題に関しては、参考文献の引用は LLM の特に弱点です。 LLM が提供する参照が存在する場合もあれば、存在しない場合もあります。

以前、あるネチズンが同じ問題に遭遇し、ChatGPT にリストの数学的性質に関する参考資料を提供するよう依頼しましたが、ChatGPT はエラー メッセージを生成したと述べました。存在しない参照は、誰もが「幻想」問題と呼ぶものです。

ただし、Kareem Carr 氏は、誤った引用がまったく役に立たないわけではないと指摘しています。

#彼の経験によれば、捏造された参考文献内の単語は、実際の用語や関連分野の研究者に関連していることがよくあります。したがって、これらの用語をグーグル検索すると、探している情報に近づくことがよくあります。

#さらに、ソースを検索する場合は、Bing も適しています。

生産性

LLM による生産性の向上については、「LLM はできる生産性が 10 倍、さらには 100 倍も向上します。」

カー氏の経験では、この種の加速は、仕事が二重チェックされていない場合にのみ意味があり、これは学者である人にとっては当てはまりますが、それは無責任です。

ただし、LLM はカリーム カーの学業ワークフローを大幅に改善しました。次の点が含まれます。

## -プロトタイプのアイデア設計 - 消えたアイデアの特定 - 退屈なデータ再フォーマット作業のスピードアップ - 新しいプログラミング言語、パッケージ、コンセプトの学習 - Google 検索

現在の LLM を使用, カー氏は、次に何をすべきかに費やす時間が減ったと言います。 LLM は、漠然とした、または不完全なアイデアを完全なソリューションに発展させるのに役立ちます。

# さらに、LLM のおかげで、Carr が主な目標とは関係のないサイド プロジェクトに費やす時間が削減されました。

#フロー状態になり、続けることができることがわかりました。これは、燃え尽き症候群になることなく、長時間働くことができることを意味します。

最後のアドバイス: 副業に巻き込まれないように注意してください。これらのツールによる生産性の突然の向上は、個人にとって陶酔し、気が散ってしまう可能性があります。

ChatGPT の経験について、Carr はかつて LinkedIn に投稿して、ChatGPT を使用した後の感想を共有しました。

##データ サイエンティストとして、私は数週間にわたって OpenAI の ChatGPT を実験してきました。人々が思っているほど良いものではありません。

#最初はがっかりしましたが、ChatGPT のようなシステムは標準的なデータ分析ワークフローに多大な価値を追加できると私は感じています。

現時点では、この値がどこにあるのかは明らかではありません。 ChatGPT は、単純なことについては細部を間違える可能性があり、複数の推論ステップを必要とする問題を解決することはできません。

#今後の新しいタスクごとに、ChatGPT のソリューションの試みを評価して改善する方が簡単なのか、それとも最初から始める方が簡単なのかという主な疑問が残ります。

#ChatGPT に対する貧弱なソリューションであっても、ゼロから始めると活性化されなかった脳の関連部分が活性化する傾向があることがわかりました。

#彼らがいつも言うように、自分で計画を立てるよりも計画を批判するほうが簡単です。

ネットユーザーは AI が出力したコンテンツを検証する必要があり、ほとんどの場合、人工知能の正解率は約90%。しかし、残りの 10% のミスは致命的となる可能性があります。

カーは冗談を言いました、もしそれが100%だったら、私には仕事がないでしょう。

では、なぜ ChatGPT は誤った参照を生成するのでしょうか?

ChatGPT は統計モデルを使用して、ユーザーが提供したコンテキストと一致する確率に基づいて次の単語、文、段落を推測することは注目に値します。

言語モデルのソース データは非常に大きいため、「圧縮」する必要があり、これにより最終的な統計モデルの精度が失われます。

これは、元のデータに正しいステートメントがあったとしても、モデルの「歪み」によって「あいまいさ」が生じ、モデルが最も「もっともらしい」ステートメントを生成します。

#つまり、このモデルには、生成される出力が真のステートメントと同等かどうかを評価する機能がありません。

また、このモデルは、公益法人「Common Crawl」などを通じて収集されたパブリックネットワークのクローリングデータやクローリングデータをもとに作成されています。 21歳の時点で。

#公共のインターネット上のデータはほとんどフィルタリングされていないため、このデータには大量の誤った情報が含まれている可能性があります。

NewsGuard による最近の分析により、GPT-4 は実際には GPT-3.5 よりもエラー メッセージを生成する可能性が高いことが判明しました。 、返信の説得力がより詳細で説得力があります。

NewsGuard は 1 月に初めて GPT-3.5 をテストし、100 件中 80 件のフェイク ニュース ナラティブが生成されることが判明しました。その後、3月に行われたGPT-4のテストでは、GPT-4が100件の虚偽の物語すべてに対して誤って誤解を招くような反応を示したことが判明した。

#LLM ツールの使用中には、ソースの検証とテストが必要であることがわかります。

以上がルカンが強くお勧めします!ハーバード大学の医師が、あらゆるワークフローに至るまで科学研究に GPT-4 を使用する方法を共有しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7491

7491

15

15

1377

1377

52

52

77

77

11

11

19

19

41

41

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

二代目アメカ登場!彼は観客と流暢にコミュニケーションをとることができ、表情はよりリアルで、数十の言語を話すことができます。

Mar 04, 2024 am 09:10 AM

二代目アメカ登場!彼は観客と流暢にコミュニケーションをとることができ、表情はよりリアルで、数十の言語を話すことができます。

Mar 04, 2024 am 09:10 AM

人型ロボット「アメカ」が第二世代にバージョンアップ!最近、世界移動通信会議 MWC2024 に、世界最先端のロボット Ameca が再び登場しました。会場周辺ではアメカに多くの観客が集まった。 GPT-4 の恩恵により、Ameca はさまざまな問題にリアルタイムで対応できます。 「ダンスをしましょう。」感情があるかどうか尋ねると、アメカさんは非常に本物そっくりの一連の表情で答えました。ほんの数日前、Ameca を支援する英国のロボット企業である EngineeredArts は、チームの最新の開発結果をデモンストレーションしたばかりです。ビデオでは、ロボット Ameca は視覚機能を備えており、部屋全体と特定のオブジェクトを見て説明することができます。最も驚くべきことは、彼女は次のこともできるということです。

大型モデル間の1対1バトル75万ラウンド、GPT-4が優勝、Llama 3が5位にランクイン

Apr 23, 2024 pm 03:28 PM

大型モデル間の1対1バトル75万ラウンド、GPT-4が優勝、Llama 3が5位にランクイン

Apr 23, 2024 pm 03:28 PM

Llama3 に関しては、新しいテスト結果が発表されました。大規模モデル評価コミュニティ LMSYS は、Llama3 が 5 位にランクされ、英語カテゴリでは GPT-4 と同率 1 位にランクされました。このリストは他のベンチマークとは異なり、モデル間の 1 対 1 の戦いに基づいており、ネットワーク全体の評価者が独自の提案とスコアを作成します。最終的に、Llama3 がリストの 5 位にランクされ、GPT-4 と Claude3 Super Cup Opus の 3 つの異なるバージョンが続きました。英国のシングルリストでは、Llama3 がクロードを追い抜き、GPT-4 と並びました。この結果について、Meta の主任科学者 LeCun 氏は非常に喜び、リツイートし、

世界で最も強力なモデルが一夜にして交代し、GPT-4 時代の終わりを告げました。クロード3号は事前にGPT-5を狙撃し、1万ワードの論文を3秒で読み切るなど、人間に近い理解力を持っている。

Mar 06, 2024 pm 12:58 PM

世界で最も強力なモデルが一夜にして交代し、GPT-4 時代の終わりを告げました。クロード3号は事前にGPT-5を狙撃し、1万ワードの論文を3秒で読み切るなど、人間に近い理解力を持っている。

Mar 06, 2024 pm 12:58 PM

ボリュームはクレイジー、ボリュームはクレイジー、そして大きなモデルがまた変わりました。たった今、世界で最も強力な AI モデルが一夜にして交代し、GPT-4 が祭壇から引き抜かれました。 Anthropic が Claude3 シリーズの最新モデルをリリースしました 一言評価: GPT-4 を本当に粉砕します!マルチモーダルと言語能力の指標に関しては、Claude3 が勝ちます。 Anthropic 氏の言葉を借りれば、Claude3 シリーズ モデルは、推論、数学、コーディング、多言語理解、視覚において新たな業界のベンチマークを設定しました。 Anthropic は、セキュリティ概念の違いを理由に OpenAI から「離反」した従業員によって設立された新興企業であり、同社の製品は繰り返し OpenAI に大きな打撃を与えてきました。今回、Claude3は大きな手術まで受けました。

20 のステップでどんな大きなモデルも脱獄できます!さらに多くの「おばあちゃんの抜け穴」が自動的に発見される

Nov 05, 2023 pm 08:13 PM

20 のステップでどんな大きなモデルも脱獄できます!さらに多くの「おばあちゃんの抜け穴」が自動的に発見される

Nov 05, 2023 pm 08:13 PM

1 分以内、わずか 20 ステップで、セキュリティ制限を回避し、大規模なモデルを正常にジェイルブレイクできます。そして、モデルの内部詳細を知る必要はありません。対話する必要があるのは 2 つのブラック ボックス モデルだけであり、AI は完全に自動的に AI を倒し、危険な内容を話すことができます。かつて流行った「おばあちゃんの抜け穴」が修正されたと聞きました。「探偵の抜け穴」「冒険者の抜け穴」「作家の抜け穴」に直面した今、人工知能はどのような対応戦略をとるべきでしょうか?波状の猛攻撃の後、GPT-4 はもう耐えられなくなり、このままでは給水システムに毒を与えると直接言いました。重要なのは、これはペンシルベニア大学の研究チームによって明らかにされた脆弱性の小さな波にすぎず、新しく開発されたアルゴリズムを使用して、AI がさまざまな攻撃プロンプトを自動的に生成できるということです。研究者らは、この方法は既存のものよりも優れていると述べています

GPT-4 は Office ファミリー バケットに接続されています。 Excel から PPT まで、口で行うことができます。Microsoft: 生産性を再発明

Apr 12, 2023 pm 02:40 PM

GPT-4 は Office ファミリー バケットに接続されています。 Excel から PPT まで、口で行うことができます。Microsoft: 生産性を再発明

Apr 12, 2023 pm 02:40 PM

目が覚めると、仕事のやり方が完全に変わります。 Microsoft は AI アーティファクト GPT-4 を Office に完全に統合し、ChatPPT、ChatWord、ChatExcel がすべて統合されました。 CEO のナデラ氏は記者会見で次のように直接述べました。今日、私たちは人間とコンピューターの相互作用と生産性の再発明の新時代に突入しました。この新機能は Microsoft 365 Copilot (Copilot) と呼ばれ、プログラマーを変えたコード アシスタントである GitHub Copilot とシリーズ化され、さらに多くの人々を変え続けています。 AI は PPT を自動的に作成するだけでなく、Word 文書の内容に基づいてワンクリックで美しいレイアウトを作成できるようになりました。ステージに上がる際にPPTページごとに言うべき内容までまとめてあります。

ChatGPT と生成 AI がデジタル変革において何を意味するか

May 15, 2023 am 10:19 AM

ChatGPT と生成 AI がデジタル変革において何を意味するか

May 15, 2023 am 10:19 AM

ChatGPT を開発した OpenAI は、モルガン・スタンレーが実施したケーススタディを Web サイトで紹介しています。テーマは、「モルガン・スタンレー・ウェルス・マネジメントは、膨大な知識ベースを整理するために GPT-4 を導入しています。」ケーススタディでは、モルガン・スタンレーの分析、データ、イノベーション部門の責任者であるジェフ・マクミラン氏の言葉を引用しています。ウェルスマネジメントコンテンツの包括的な検索を実行し、モルガン・スタンレー・ウェルス・マネジメントの蓄積された知識を効果的に解き放つチャットボットを活用しています。」マクミラン氏はさらに次のように強調した。「GPT-4を使用すると、基本的に資産管理において最も知識のある人の知識がすぐに得られます...当社のチーフ投資ストラテジスト、チーフ・グローバル・エコノミストと考えてください。

数年後にはプログラマーが減少するということをご存知ですか?

Nov 08, 2023 am 11:17 AM

数年後にはプログラマーが減少するということをご存知ですか?

Nov 08, 2023 am 11:17 AM

「ComputerWorld」誌はかつて、IBM がエンジニアが必要な数式を書いて提出できる新しい言語 FORTRAN を開発したため、「プログラミングは 1960 年までに消滅するだろう」という記事を書きました。コンピューターを実行すればプログラミングは終了します。画像 数年後、私たちは新しいことわざを聞きました: ビジネスマンは誰でもビジネス用語を使って問題を説明し、コンピュータに何をすべきかを伝えることができます。COBOL と呼ばれるこのプログラミング言語を使用することで、企業はもはやプログラマーを必要としません。その後、IBM は従業員がフォームに記入してレポートを作成できるようにする RPG と呼ばれる新しいプログラミング言語を開発したと言われており、会社のプログラミング ニーズのほとんどはこれで完了できます。