人工知能を学びたいなら、このデータセットをマスターする必要があります。

人工知能を学習するには、必然的にいくつかのデータセットが必要になります。たとえば、ポルノを識別するための人工知能には、いくつかの同様の写真が必要です。音声認識のための人工知能とコーパスは不可欠です。人工知能を初めて使用する学生は、データセットについて心配することがよくあります。今日は、非常にシンプルですが非常に便利なデータセット、MNIST を紹介します。このデータセットは、人工知能関連のアルゴリズムを学習および実践するのに非常に適しています。

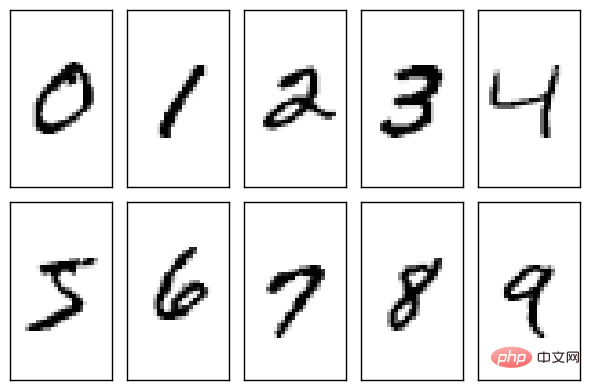

MNIST データ セットは、国立標準技術研究所 (NIST) によって作成された非常に単純なデータ セットです。では、このデータセットは何についてのものなのでしょうか?これは実際には手書きのアラビア数字 (0 から 9 までの 10 個の数字) です。

#NIST は、データセットの作成に今でも非常に真剣です。データセット内のトレーニング セットは、250 人の異なる人々からの手書きの数字で構成されており、そのうち 50% は高校生、50% は国勢調査局の職員です。テスト セットも同じ割合の手書き数字データです。

MNIST データ セットのダウンロード方法

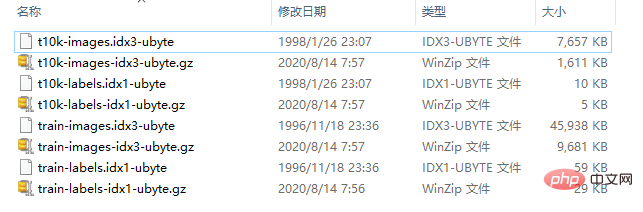

MNIST データ セットは、公式 Web サイト (http://yann.lecun.com/exdb/mnist/) からダウンロードできます。海外のウェブサイトの場合、ダウンロードが難しい、遅い場合があります。これには 4 つの部分が含まれています:

- トレーニング セットのイメージ: train-images-idx3-ubyte.gz (9.9 MB、解凍後 47 MB、60,000 のサンプルが含まれます)

- トレーニング セットラベル: train-labels-idx1-ubyte.gz (29 KB、解凍後の 60 KB、60,000 のラベルを含む)

- テスト セット イメージ: t10k-images-idx3-ubyte.gz (1.6 MB、解凍後の 7.8 MB)解凍、10,000 サンプルを含む)

- テスト セット ラベル: t10k-labels-idx1-ubyte.gz (5KB、解凍後 10 KB、10,000 ラベルを含む)

上記には 2 つが含まれていますコンテンツの種類には、写真とラベルがあり、写真とラベルは 1 対 1 に対応します。ただし、ここで表示されている画像は、私たちがよく見る画像ファイルではなく、バイナリ ファイルです。このデータセットには、60,000 枚の画像がバイナリ形式で保存されています。ラベルは画像に対応する実数です。

下の図に示すように、この記事ではデータ セットをローカルにダウンロードし、結果を解凍します。比較しやすいように、元の圧縮パッケージと解凍されたファイルが含まれています。

データ セットの形式の簡単な分析

誰もが、解凍後の圧縮パッケージは画像ではなく、それぞれの圧縮パッケージであることを発見しました。独立した質問に対応します。このファイルには、数万枚の写真やタグに関する情報が保存されています。では、この情報はどのようにしてこのファイルに保存されるのでしょうか?

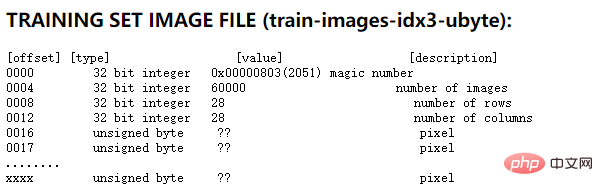

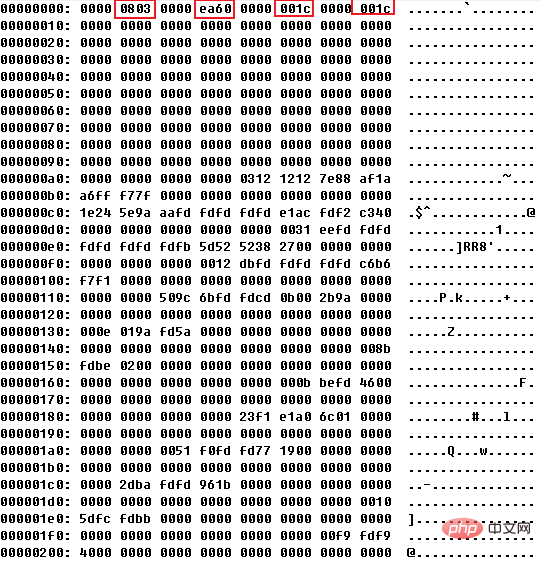

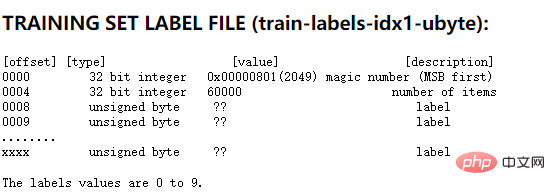

実はMNISTの公式サイトに詳しく解説されています。トレーニング セットの画像ファイルを例に挙げると、公式 Web サイトで提供されているファイル形式の説明は次のとおりです。

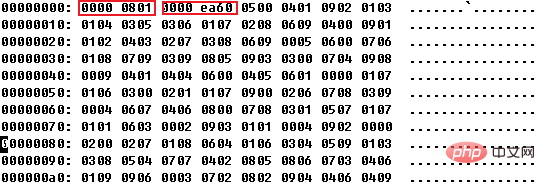

上の図からわかるように、最初の 4 つの 32 桁の数字は、トレーニング セットの説明情報です。最初はマジックナンバーで、固定値は 0x0803、2 番目は画像の数、0xea60、つまり 60000、3 番目と 4 番目は画像のサイズ、つまり画像は 28*28 ピクセルです。 。以下に 1 バイト内の各ピクセルについて説明します。このファイルでは 1 バイトがピクセルを記述するために使用されるため、ピクセルの値は 0 ~ 255 であることがわかります。ここで、0 は白を意味し、255 は黒を意味します。

データセットのファイル形式についてはわかったので、実際にやってみましょう。

データ セットの視覚的処理

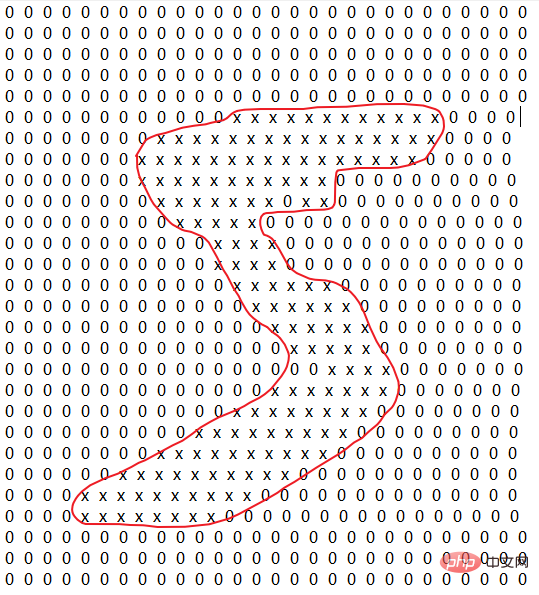

上記のデータの保存形式がわかったら、データを解析できます。たとえば、次の記事では、画像コレクション内の画像を解析し、視覚的な結果を取得するための小さなプログラムを実装しています。もちろん、実際にはラベル セットの値に基づいて画像が何であるかを知ることができますが、これは単なる実験です。最終結果は、手書きを表す文字「Y」と背景色を表す文字「0」を使用してテキスト ファイルに保存されます。具体的なプログラム コードは非常に単純なので、この記事では詳しく説明しません。

# -*- coding: UTF-8 -*-

def trans_to_txt(train_file, txt_file, index):

with open(train_file, 'rb') as sf:

with open(txt_file, "w") as wf:

offset = 16 + (28*28*index)

cur_pos = offset

count = 28*28

strlen = 1

out_count = 1

while cur_pos < offset+count:

sf.seek(cur_pos)

data = sf.read(strlen)

res = int(data[0])

#虽然在数据集中像素是1-255表示颜色,这里简化为Y

if res > 0 :

wf.write(" Y ")

else:

wf.write(" 0 ")

#由于图片是28列,因此在此进行换行

if out_count % 28 == 0 :

wf.write("n")

cur_pos += strlen

out_count += 1

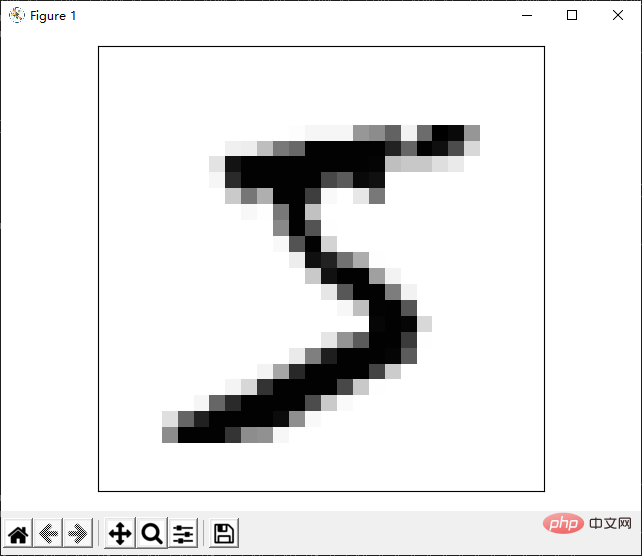

trans_to_txt("../data/train-images.idx3-ubyte", "image.txt", 0)上記のコードを実行すると、image.txt という名前のファイルを取得できます。ファイルの内容は次のようにして確認できます。赤い注記は、主に視認性を向上させるために後で追加されました。写真を見てわかるように、これは実際には手書きの「5」です。

# 前回は、ネイティブ Python インターフェイスを通じてデータセットを視覚的に分析しました。 Python にはすでに実装されたライブラリ関数が多数あるため、ライブラリ関数を使用して上記の関数を簡略化できます。

サードパーティ ライブラリに基づくデータの解析

ネイティブ Python インターフェイスを使用して実装するのは少し複雑です。 Python には多くのサードパーティ ライブラリがあることがわかっているので、サードパーティ ライブラリを使用してデータ セットを解析して表示できます。具体的なコードは次のとおりです。

# -*- coding: utf-8 -*-

import os

import struct

import numpy as np

# 读取数据集,以二维数组的方式返回图片信息和标签信息

def load_mnist(path, kind='train'):

# 从指定目录加载数据集

labels_path = os.path.join(path,

'%s-labels.idx1-ubyte'

% kind)

images_path = os.path.join(path,

'%s-images.idx3-ubyte'

% kind)

with open(labels_path, 'rb') as lbpath:

magic, n = struct.unpack('>II',

lbpath.read(8))

labels = np.fromfile(lbpath,

dtype=np.uint8)

with open(images_path, 'rb') as imgpath:

#解析图片信息,存储在images中

magic, num, rows, cols = struct.unpack('>IIII',

imgpath.read(16))

images = np.fromfile(imgpath,

dtype=np.uint8).reshape(len(labels), 784)

return images, labels

# 在终端打印某个图片的数据信息

def print_image(data, index):

idx = 0;

count = 0;

for item in data[index]:

if count % 28 == 0:

print("")

if item > 0:

print("33[7;31mY 33[0m", end="")

else:

print("0 ", end="")

count += 1

def main():

cur_path = os.getcwd()

cur_path = os.path.join(cur_path, "..data")

imgs, labels = load_mnist(cur_path)

print_image(imgs, 0)

if __name__ == "__main__":

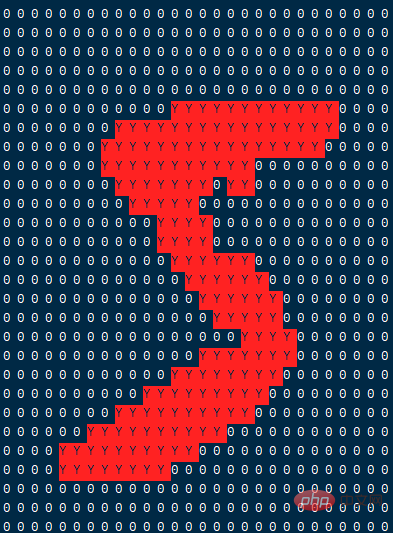

main()上記のコードは 2 つのステップに分かれており、最初のステップではデータ セットを解析して配列にし、次のステップでは配列内の特定の画像を表示します。ここでの表示もテキスト プログラムを介して行われますが、ファイルに保存されるのではなく、端末上で印刷されます。たとえば、最初の画像を印刷すると、その効果は次のようになります。

上記の結果の表示は、文字を介して画像をシミュレートするだけです。実際、サードパーティのライブラリを使用して、より完璧な画像プレゼンテーションを実現できます。次に、matplotlib ライブラリを使用して画像を表示する方法を紹介します。このライブラリは非常に便利なので、後でこのライブラリについて触れます。

我々は

def show_image(data, index): fig, ax = plt.subplots(nrows=1, ncols=1, sharex=True, sharey=True, ) img = data[0].reshape(28, 28) ax.imshow(img, cmap='Greys', interpolation='nearest') ax.set_xticks([]) ax.set_yticks([]) plt.tight_layout() plt.show()

この時点で、

実装時にいくつかのサードパーティ ライブラリが欠落している可能性があることがわかります。 matplotlib などの上記の関数。

pip install matplotlib -i http://pypi.douban.com/simple/ --trusted-host pypi.douban.com

TensorFlowによるデータ解析

MNISTは非常に有名で、既にTensorFlowでサポートされています。したがって、TensorFlow を通じてロードして解析できます。以下に TensorFlow で実装されたコードを示します。

# -*- coding: utf-8 -*-

from tensorflow.examples.tutorials.mnist import input_data

import pylab

def show_mnist():

# 通过TensorFlow库解析数据

mnist = input_data.read_data_sets("../data", one_hot=True)

im = mnist.train.images[0]

im = im.reshape(28 ,28)

# 进行绘图

pylab.imshow(im, cmap='Greys', interpolation='nearest')

pylab.show()

if __name__ == "__main__":

show_mnist()このコードによって達成される最終的な効果は前の例と同じなので、ここでは詳しく説明しません。

以上が人工知能を学びたいなら、このデータセットをマスターする必要があります。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7481

7481

15

15

1377

1377

52

52

77

77

11

11

19

19

34

34

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G