事前訓練された言語モデルに基づく業界検索の応用と研究

1. 業界調査の背景

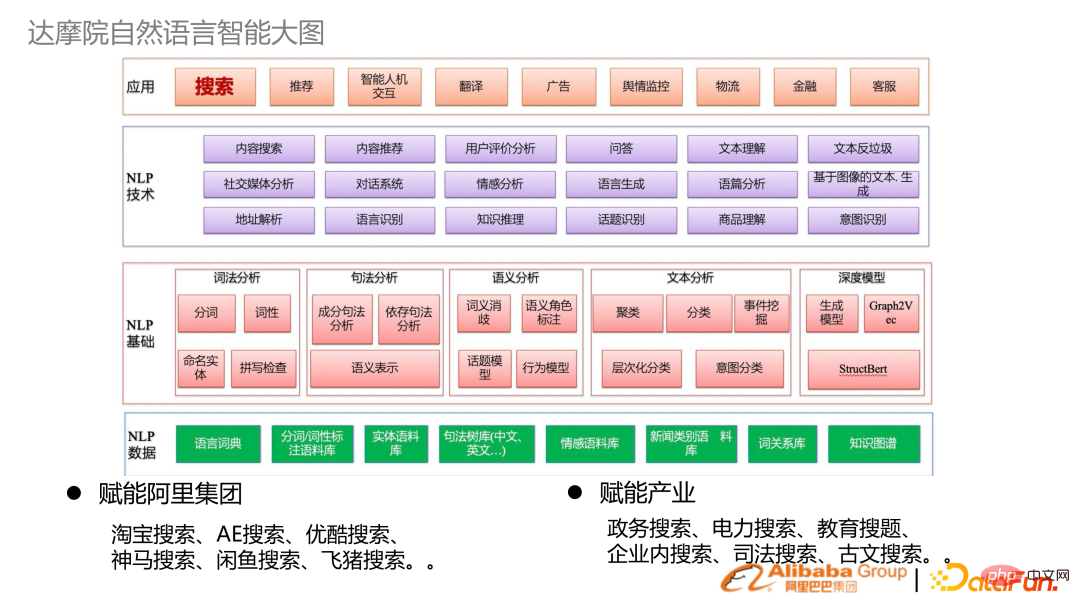

##1. Damo Academy Natural Language Intelligence の全体像

##上の図は、DAMO アカデミーの自然言語処理インテリジェンスの技術ブロック図で、下から上に次のものが含まれています。

- #業界への応用: DAMO アカデミーはさらに多くのことを行います基礎研究に加えて、Alibaba Group に権限を与え、Alibaba Cloud と統合して業界を強化します。業界におけるエンパワーメントのシナリオの多くは検索です。

- #2. 業界検索の性質

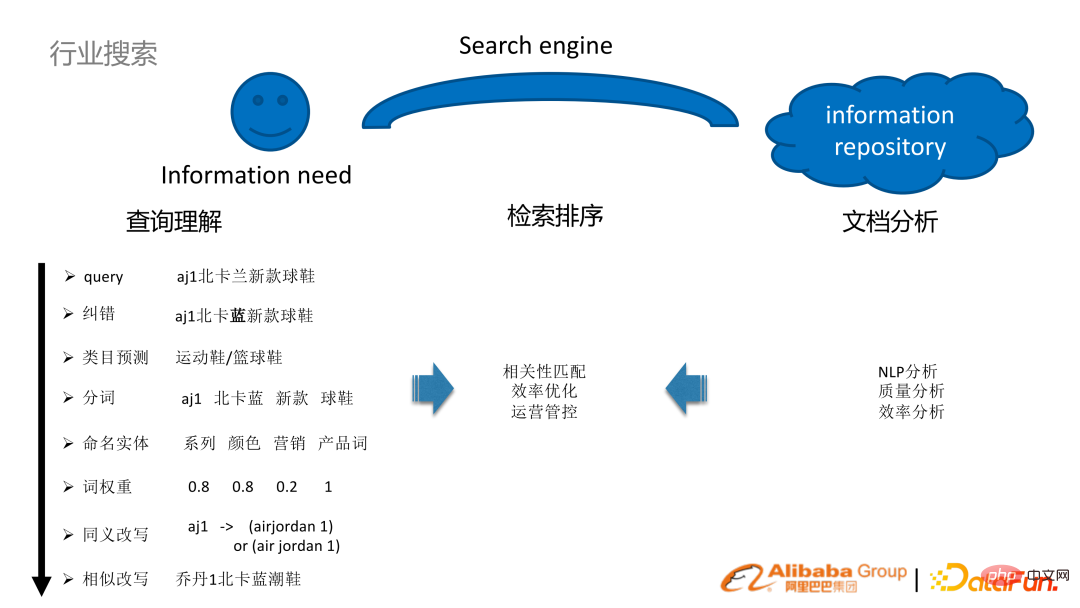

##産業用インターネットと民生用インターネットの検索の本質は同じです。ユーザーは情報取得ニーズがあると同時に情報リソース ライブラリを持っており、この 2 つは検索エンジンを通じて橋渡しされます。

##産業用インターネットと民生用インターネットの検索の本質は同じです。ユーザーは情報取得ニーズがあると同時に情報リソース ライブラリを持っており、この 2 つは検索エンジンを通じて橋渡しされます。

# e コマースのシナリオを例に挙げます。たとえば、ユーザーが e コマース ストアで aj1 ノースカロライナ ブルーの新しいスニーカーを検索するとします。このようなユーザーのクエリをよりよく理解するには、一連のタスクを実行する必要があります:

クエリ理解の分析: NLP エラー修正、単語セグメンテーションとカテゴリ 予測、エンティティ認識の単語重み付け、クエリの書き換えおよびその他のテクノロジー

- (オフライン) ドキュメント分析: NLP 分析、品質効率分析

- 検索と並べ替え: クエリとドキュメントの分析と、検索エンジン自体のいくつかの検索および並べ替えメカニズムを組み合わせることで、この 2 つの橋渡しという目標を達成できます。

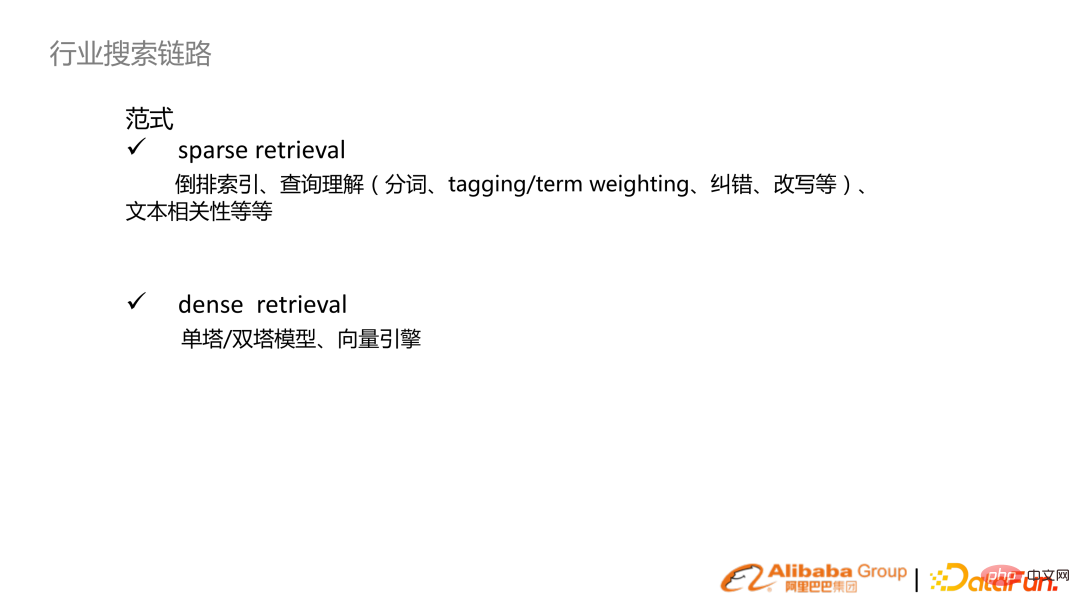

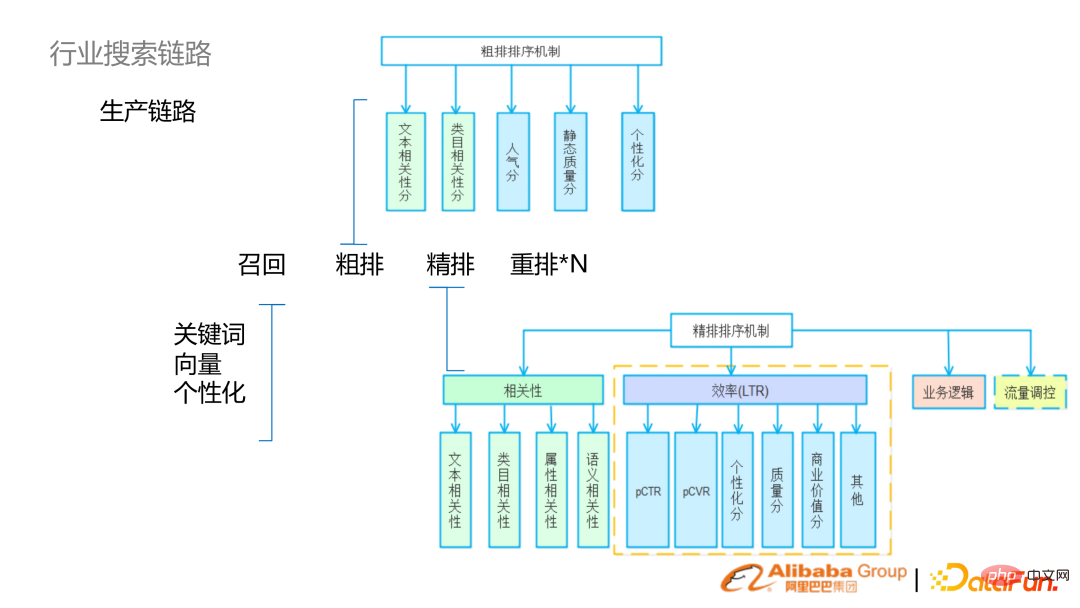

- #3. 業界検索リンク

検索パラダイムに従って分けると、一般にスパース検索とデンス検索に分けられます。

スパース検索: 従来は、単語に基づいて転置インデックスを構築し、同時にクエリを理解するための一連の機能を構築していました。 this. 、いくつかのテキスト関連性ソートなどを含む;

- 高密度検索: 事前トレーニング済み言語モデルの台頭により、単一タワーと二重タワーが実現されます。事前にトレーニングされた基底モデルに基づいて、ベクトル エンジンと組み合わせて検索メカニズムを確立します。

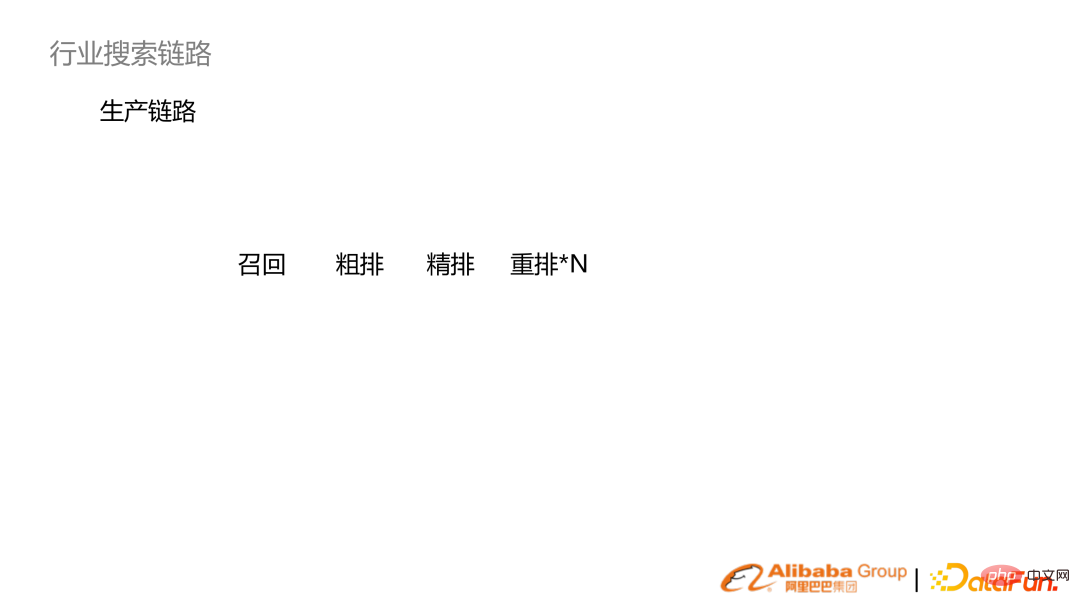

- #一般に、検索はリンク、呼び出し、並べ替え (大まかな並べ替え、詳細な並べ替え) に分かれています。 、並べ替えます)。

#リコールフェーズ:

- #従来の疎な検索のキーワード想起

- ##密な検索ベクトル想起、パーソナライズされた想起

- 大まかな並べ替え段階: テキスト関連性 (静的) スコアを使用してフィルタリングする

- 細かい並べ替え段階: 比較的複雑で、ビジネス効率化モデル (LTR) と組み合わせることができる相関モデルです。

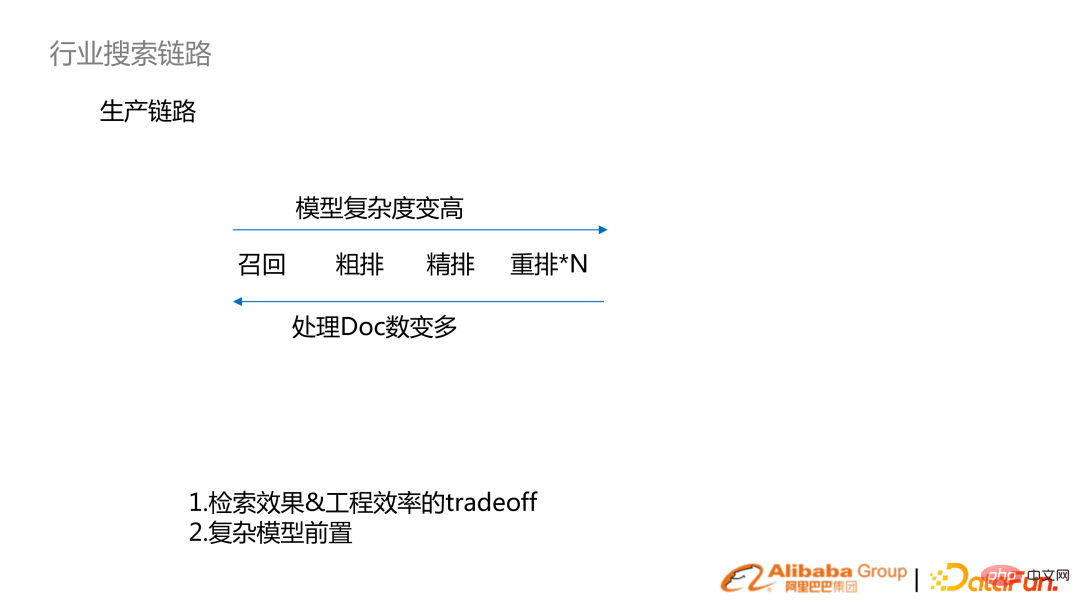

左からそうです、モデルの複雑さと効果の精度はより高くなります。右から左に向かって、処理されるドキュメントの数が増加します。淘宝網の電子商取引を例に挙げると、リコール (10 億)、予備ランキング (数十万)、細かいランキング (数百、千)、並べ替え (数十) などです。

#生産リンクの検索は、検索効果とエンジニアリング効率がトレードオフの関係にあるシステムです。コンピューティング能力が向上するにつれて、複雑なモデルが置き換えられ始めます。たとえば、細かく分類されたモデルは、徐々に大まかな分類またはリコールの段階に移行します。

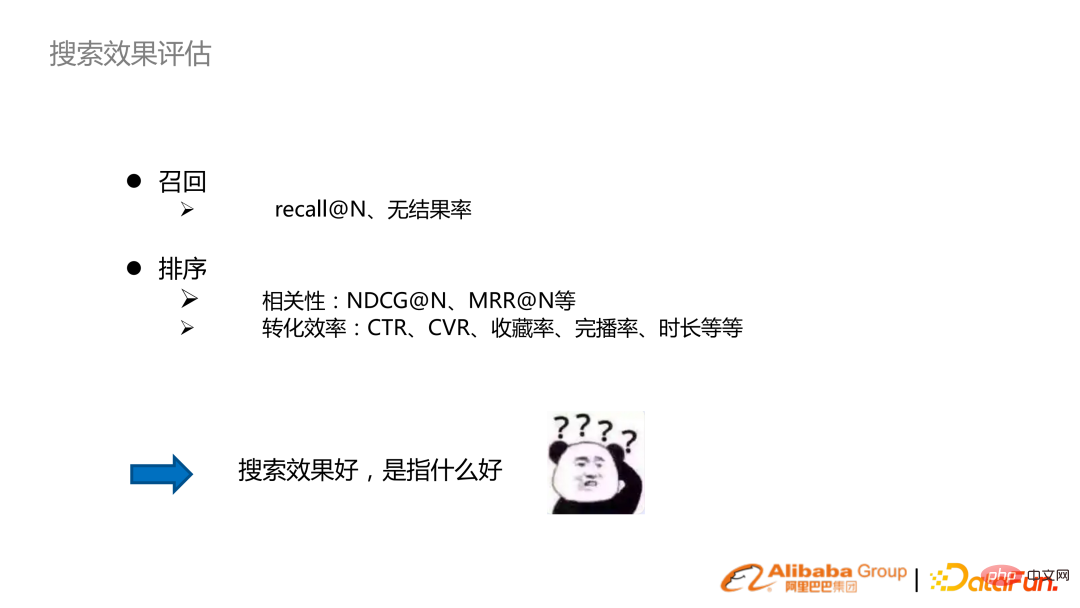

#想起: 想起または結果なしの割合

- 順序付け: 関連性、変換効率 (ビジネスに近い)

- 関連性: NDCG、MRR

- コンバージョン効率: クリックスルー率、コンバージョン率

- 4. 消費者向けインターネットと産業用インターネットでの検索

検索は、業界のシナリオによって大きく異なります。こちらをご覧ください。これは、消費者向けインターネット検索と産業用インターネット検索に分かれています:

検索は、業界のシナリオによって大きく異なります。こちらをご覧ください。これは、消費者向けインターネット検索と産業用インターネット検索に分かれています:

#ユーザー グループと UV

- :消費者向けインターネット検索 UV は非常に規模が大きく、産業用インターネットは政府機関や企業の従業員を対象としています。 検索追跡指標

- : インターネットを利用する際、検索結果と正確な検索を追求することに加えて、高いコンバージョン率も追求します。インダストリアル インターネットでは、情報の一致の必要性がより重要であるため、想起と関連性に重点を置きます。 エンジニアリング システム要件

- : コンシューマー インターネット QPS 要件は非常に高く、多数のユーザーが必要となります。動作が蓄積されるため、リアルタイムのログ分析とリアルタイムのモデル トレーニングが必要になります。産業用インターネットの要件は低くなります。 #アルゴリズムの方向

- : 消費者向けインターネットは、オフラインでの大規模なユーザー行動の分析とモデリングから取得されます。ニアライン、オンラインのメリットが大きくなります。産業用インターネットのユーザー行動はまばらであるため、NLP や視覚的理解などのコンテンツ理解により多くの注意が払われます。研究の方向性には、低リソース学習や転移学習が含まれます。 # 2. 関連技術の調査

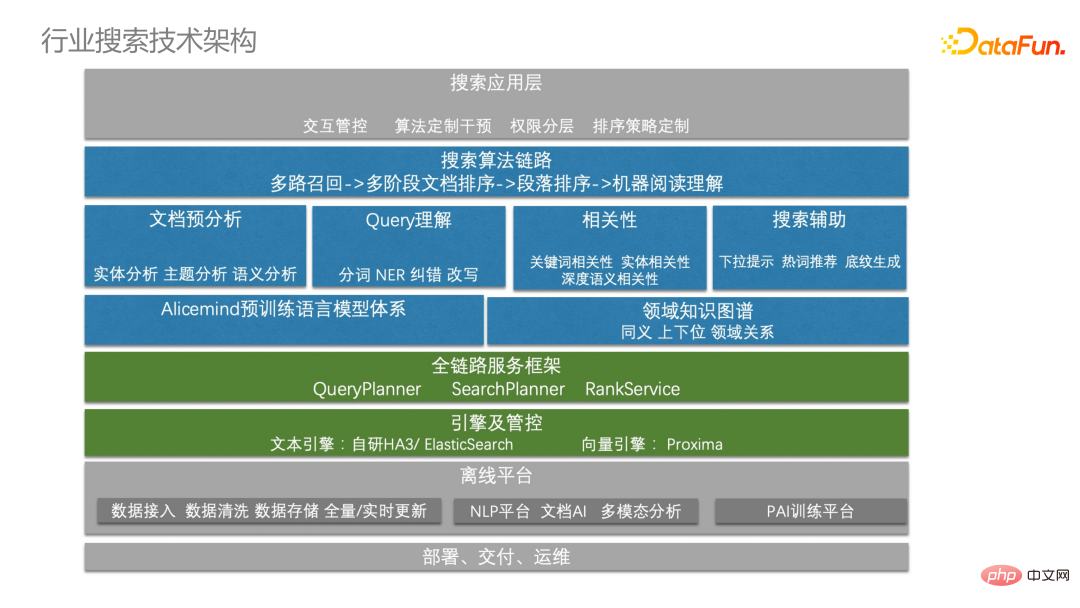

##検索は withシステム フレームワークは密接に結合されています: オフライン データ、検索サービス フレームワーク (緑色の部分)、および検索テクノロジ アルゴリズム システム (青色の部分) が含まれます。そのベースとなるのは、Alicemind の事前トレーニング済み言語モデル システムであり、ドキュメント分析、クエリも収束します。理解と相関関係。待ってください。

1.AliceMind システム

AliceMind は、DAMO アカデミーによって構築された階層型事前トレーニング言語モデル システムです。一般的な事前トレーニング モデル、多言語、マルチモーダル、対話などが含まれており、すべての NLP タスクのベースとなります。

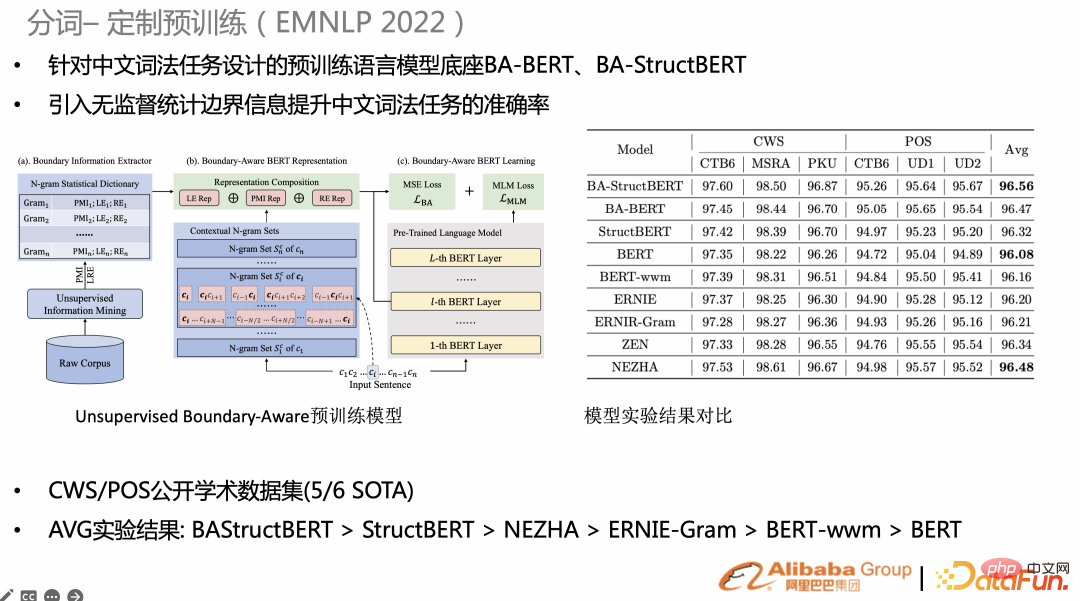

2. 単語の分割

検索単語の分割 (アトミック機能) , 検索インデックスの粒度を決定し、その後の相関や BM25 の粒度にも関係します。タスク固有のタスクについては、一部の事前トレーニングをカスタマイズすると、一般的な事前トレーニングよりも効果が高くなります。たとえば、最近の研究では、統計単語、グラム粒度、境界エントロピーなどの教師なし統計情報をネイティブ BERT 事前トレーニング タスクに追加し、事前トレーニングに mse 損失を追加することを望んでいます。 CWS/POS と NER (右の図) では、多くのタスクが SOTA に到達しました。

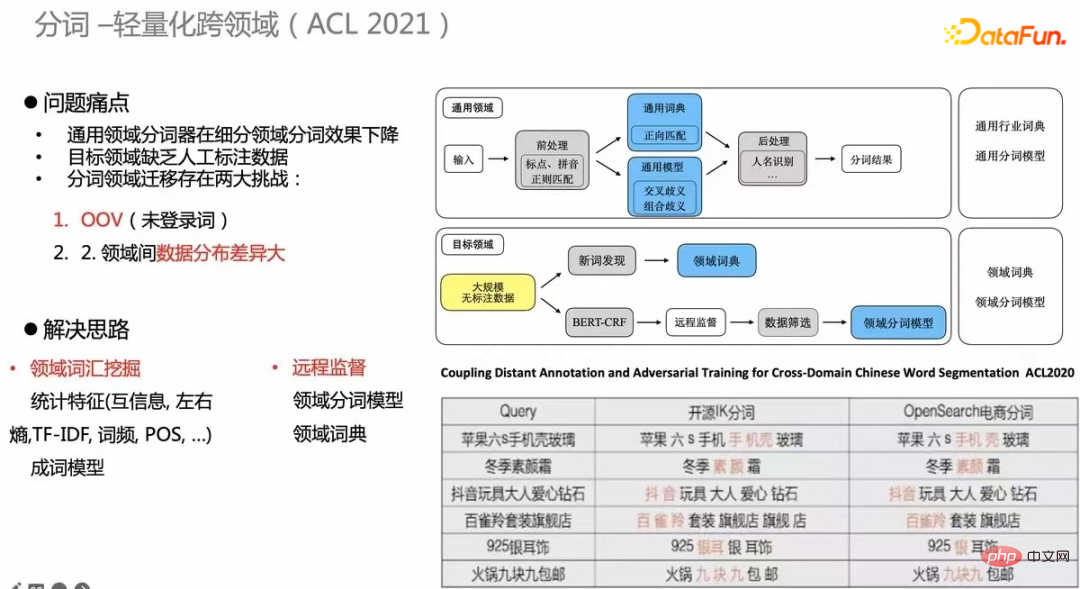

別の研究は横断的なものです。データにラベルを付けたり、毎回監視タスクを構築したりするコストは非常に高いため、クロスドメインの教師なし単語分割メカニズムを構築する必要があります。右下の表は一例ですが、ECの単語分割はオープンソースの単語分割と比べて品質が大幅に向上しており、この手法はACL2020でも公開されています。

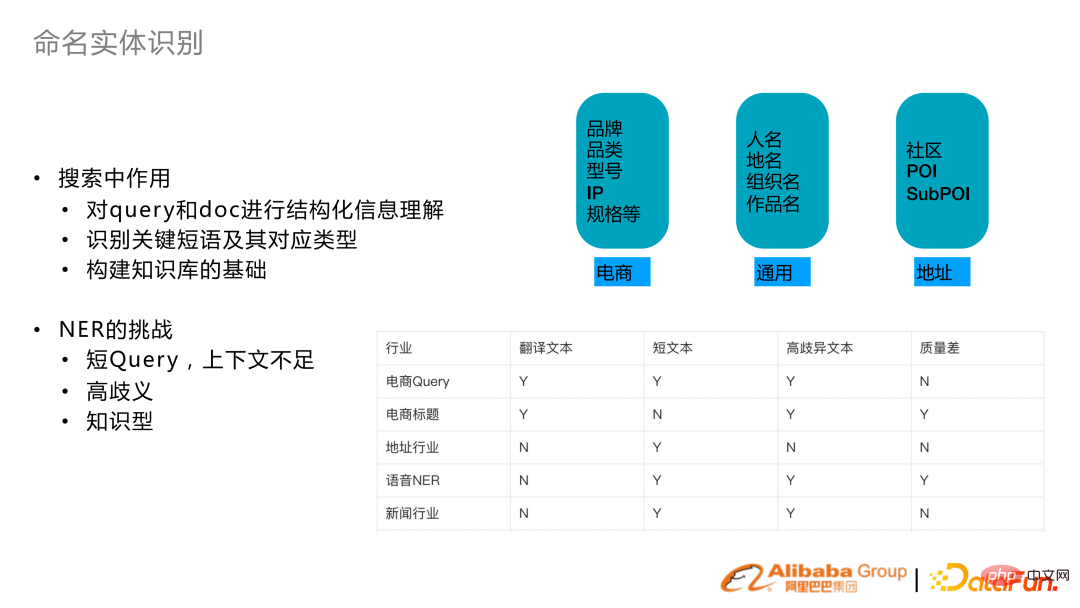

#3. 固有表現の認識

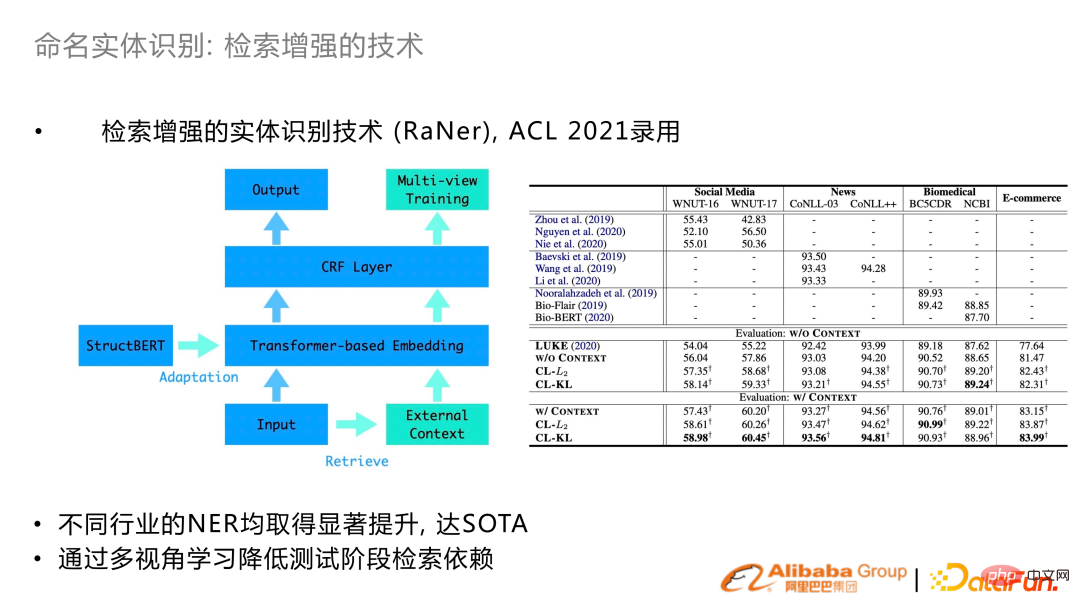

##Search 固有表現認識には主に、クエリとドキュメントの構造化された理解と、キー フレーズとタイプの識別が含まれます。同時に、検索知識グラフの構築も NER 関数に依存します。

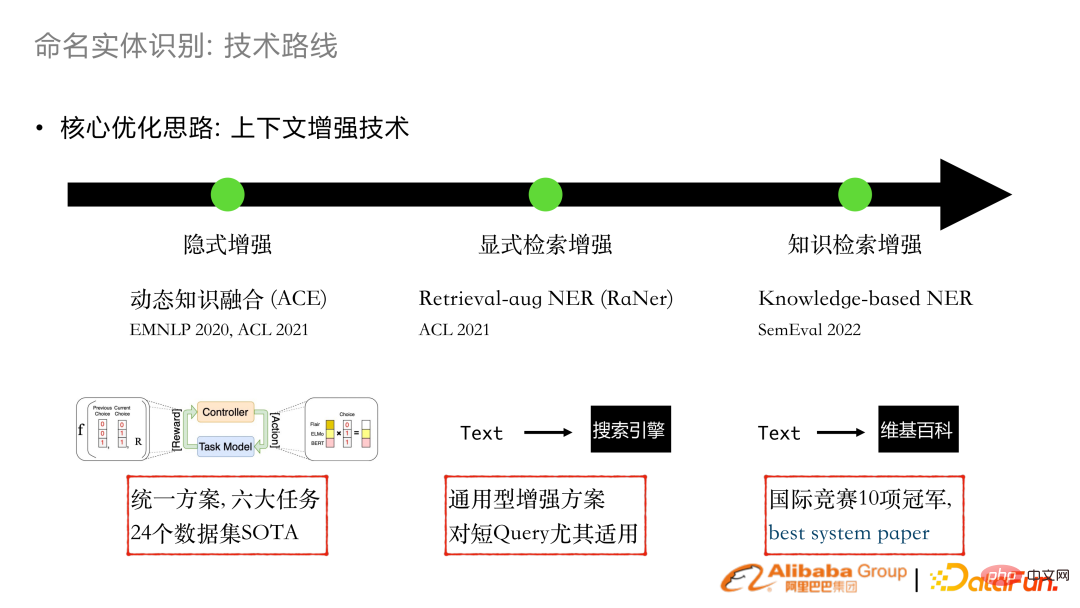

#NER の検索にはいくつかの課題もあります。主な理由は、クエリが比較的短く、コンテキストが欠けていることが多いためです。たとえば、電子商取引のクエリ エンティティは非常に曖昧で知識が豊富です。したがって、近年の NER の最適化の中心となるアイデアは、コンテキストや知識の導入を通じて NER の表現を強化することです。

#2020 年と 2021 年に暗黙的な強化作業コンボの埋め込みを行いました。既存の単語抽出または GLUE 表現を動的に統合することにより、多くのビジネス タスクで使用して SOTA を実現できます。

2021 年には、明示的な検索の強化を開発し、テキストの一部が検索エンジンを通じて強化されたコンテキストを取得し、それをトランスフォーマー構造に統合します。この作品はACL 2021に掲載されました。

この成果に基づいて、私たちは SemEval 2022 の多言語 NER 評価に参加し、10 回のチャンピオンシップを獲得し、最優秀システム論文も受賞しました。

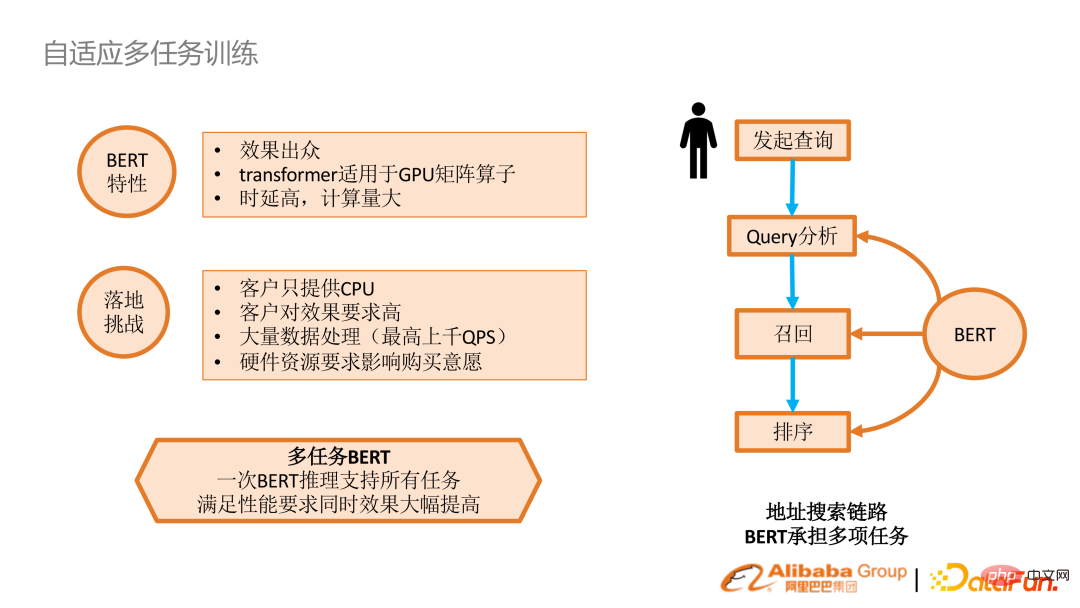

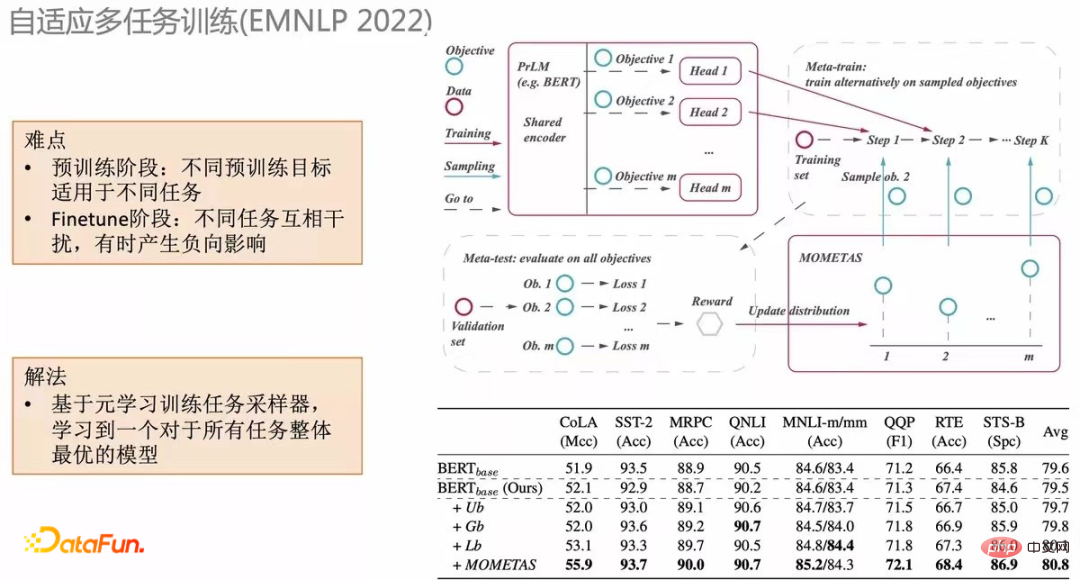

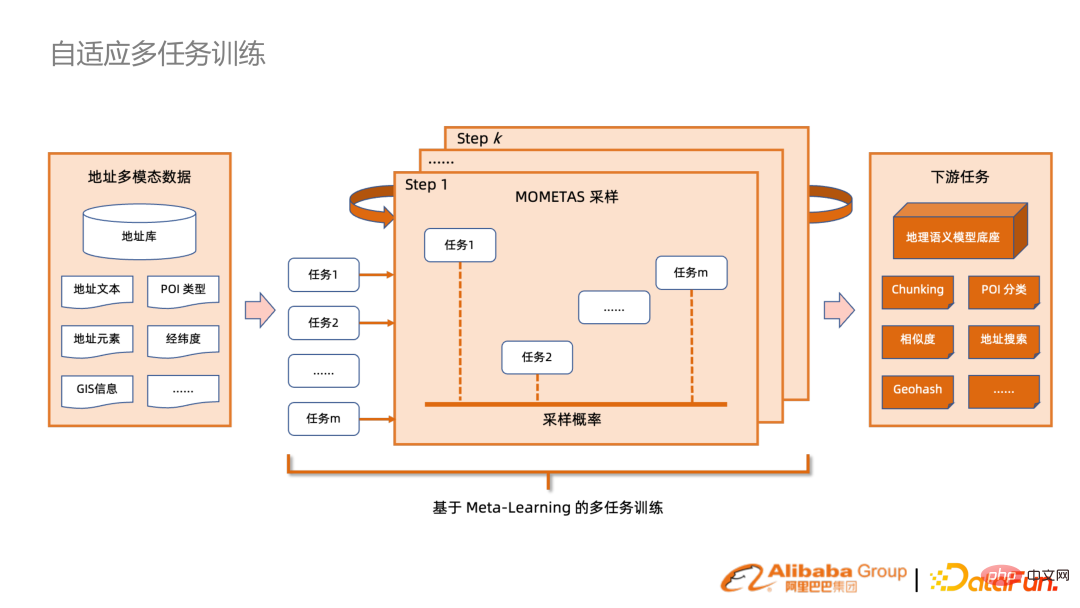

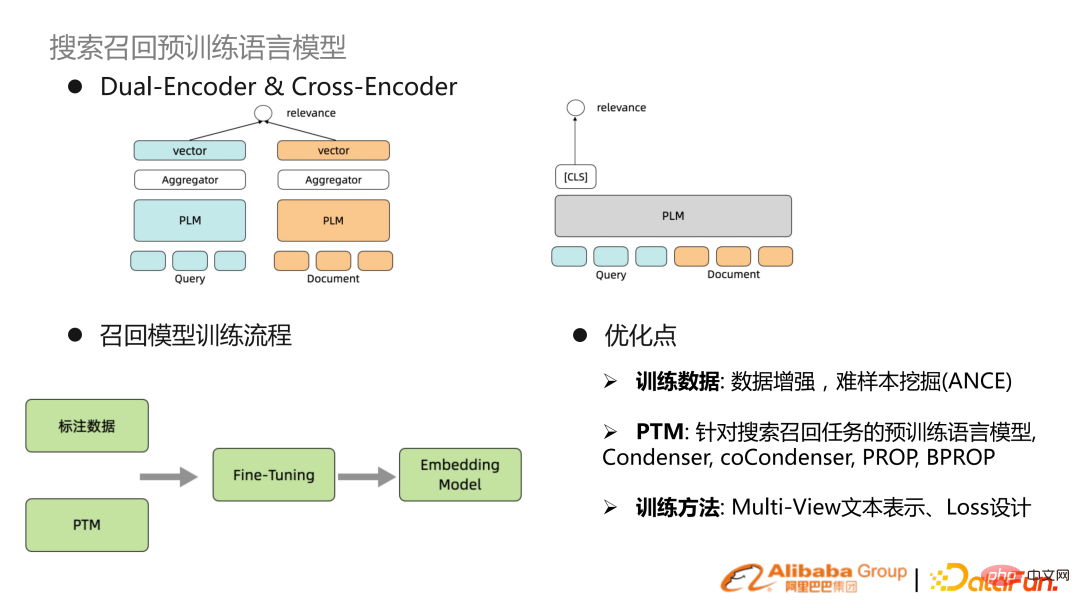

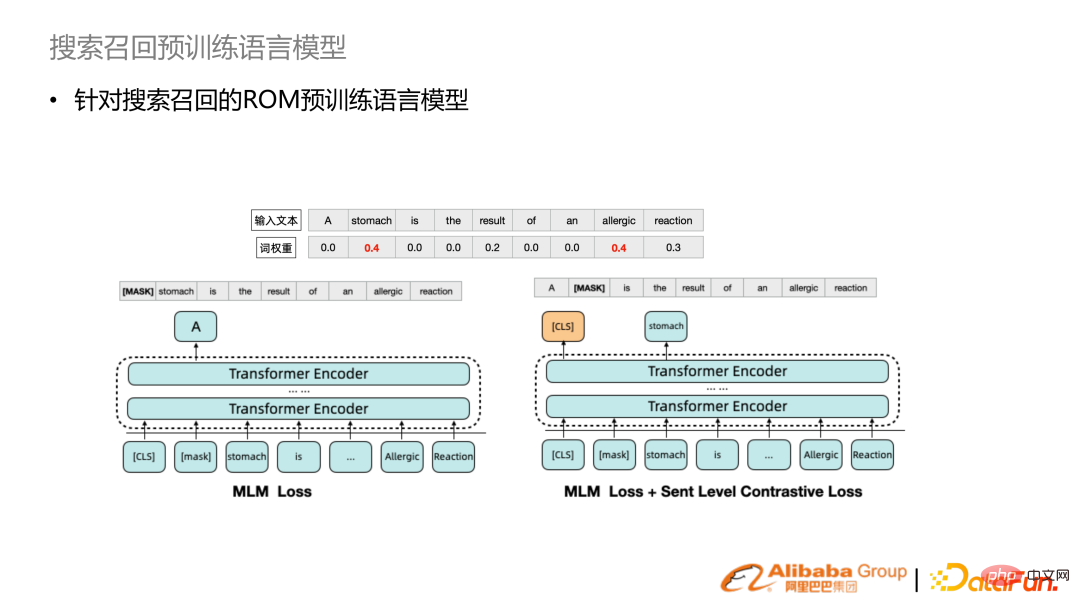

BERT 自体は非常に効果的ですが、実際の効果は非常に小さいですGPU クラスターがあり、タスクごとに推論が必要になるため、パフォーマンスの面で非常にコストがかかります。推論を 1 回だけ実行できるかどうかを検討し、エンコーダーの後に各タスクを独自に適応させて、より良い結果が得られるようにします。 #直感的な方法は、メタタスク フレームワークを通じて NLP クエリ分析タスクを組み込むことです。しかし、従来のメタタスクは均一にサンプリングされた分布です。我々は、さまざまなタスクに対してサンプリングを自己適応させる適応型メタ学習ベースの手法である MOMETAS を提案します。複数のタスクを学習するプロセスでは、さまざまなタスクの学習の効果を確認するためのテストに検証データを定期的に使用します。報酬は、以前のトレーニングのサンプリングをガイドします。 (下表) 多くのタスクでこのメカニズムを組み合わせると、UB (均一分散) と比較して多くの改善が得られます。 上記のメカニズムを多くの業界の検索シナリオに適用すると、BERT を通じてエンコーディングと保存は多くの下流タスクで直接再利用できるため、パフォーマンスが大幅に向上します。 深い検索2 つのタワーまたは 1 つのタワーにすぎません。一般的なトレーニング パラダイムは、教師付き信号と事前トレーニングされたモデルです。埋め込みを取得するために Finetune が実行され、クエリとドキュメントが表現されます。最近の最適化ルートは主にデータ強化または困難なサンプル マイニングであり、もう 1 つは事前トレーニングされた言語モデルの最適化です。ネイティブ BERT は検索に特に適したテキスト表現ではないため、テキスト表現を検索するための事前トレーニングされた言語モデルが存在します。その他の最適化は、マルチビュー テキスト表現と特殊損失設計にあります。

6. HLATR 再配置モデル

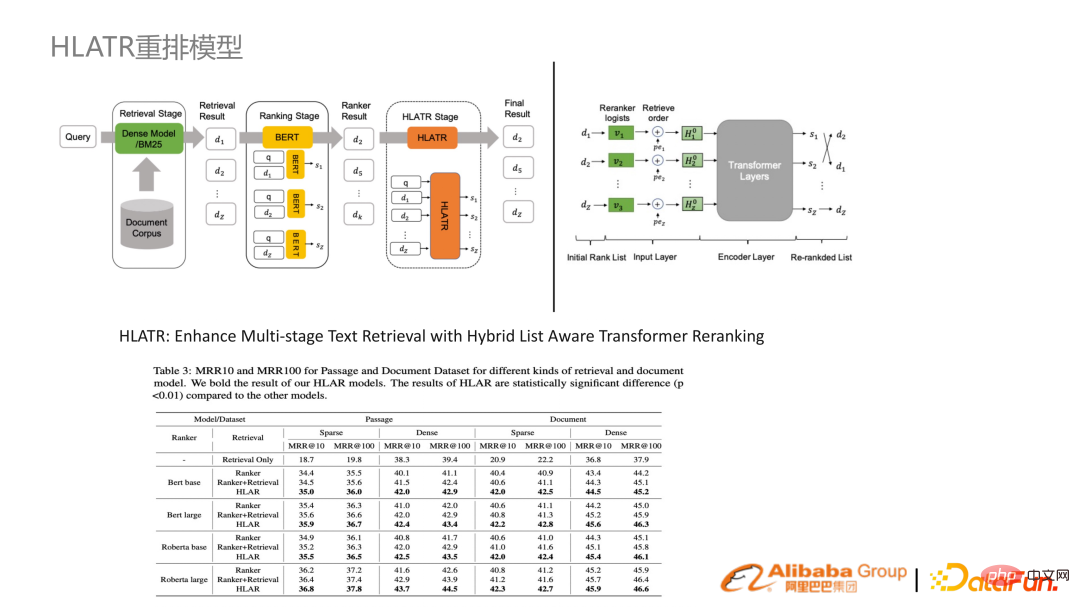

ROM と HLATR の 2 つのソリューションを組み合わせた場合、3 月から現在 (7 月) までの結果は依然として SOTA です。

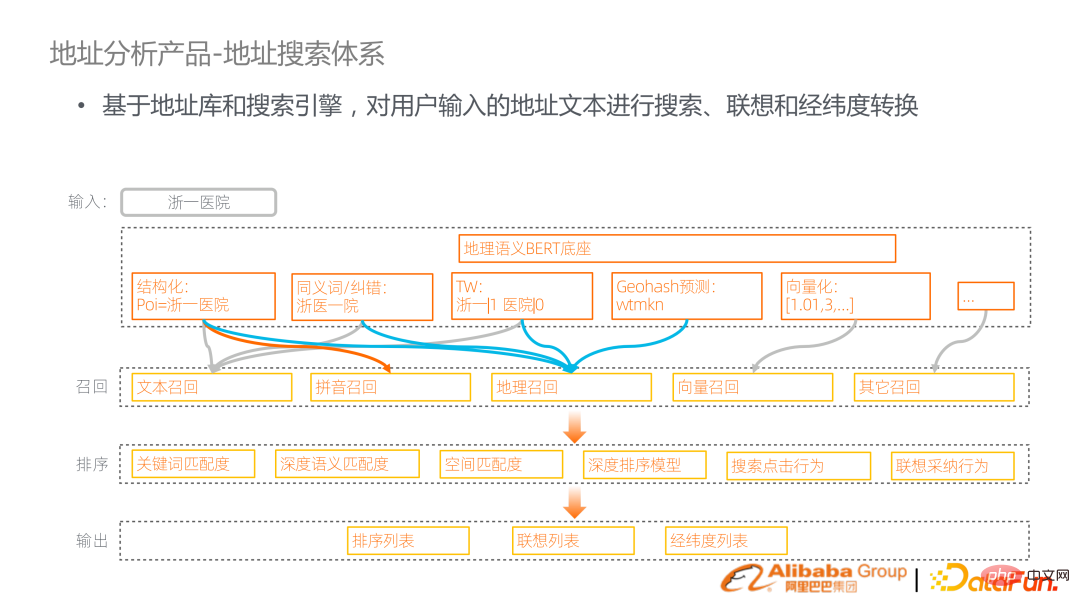

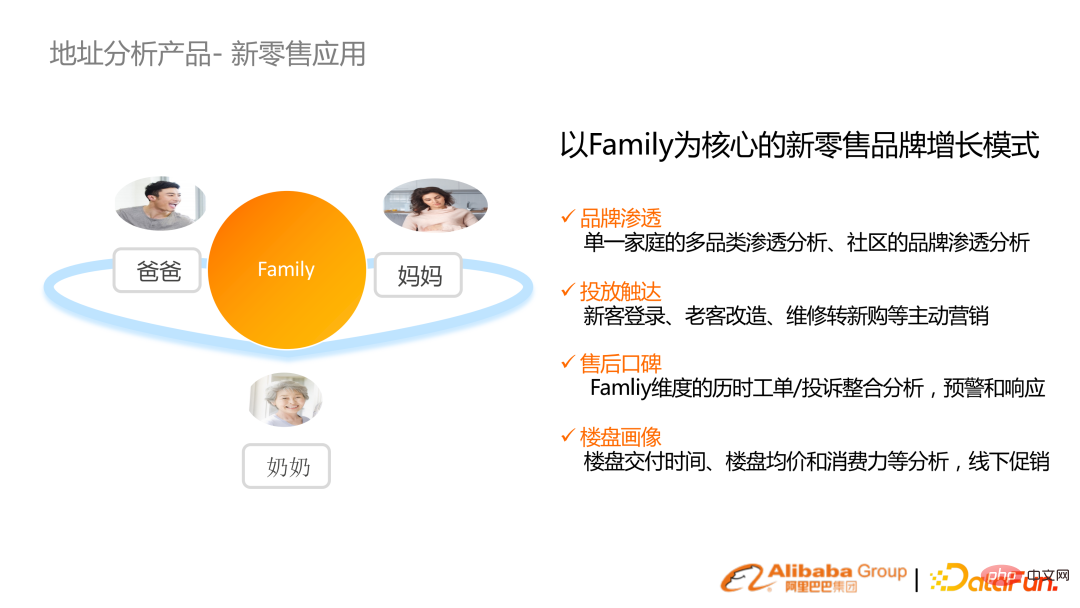

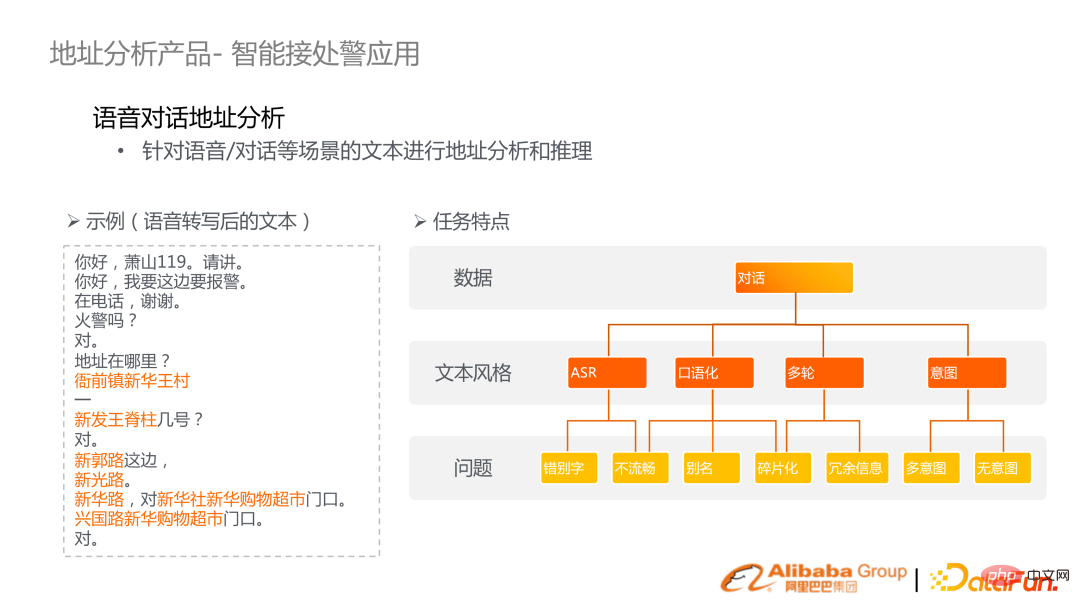

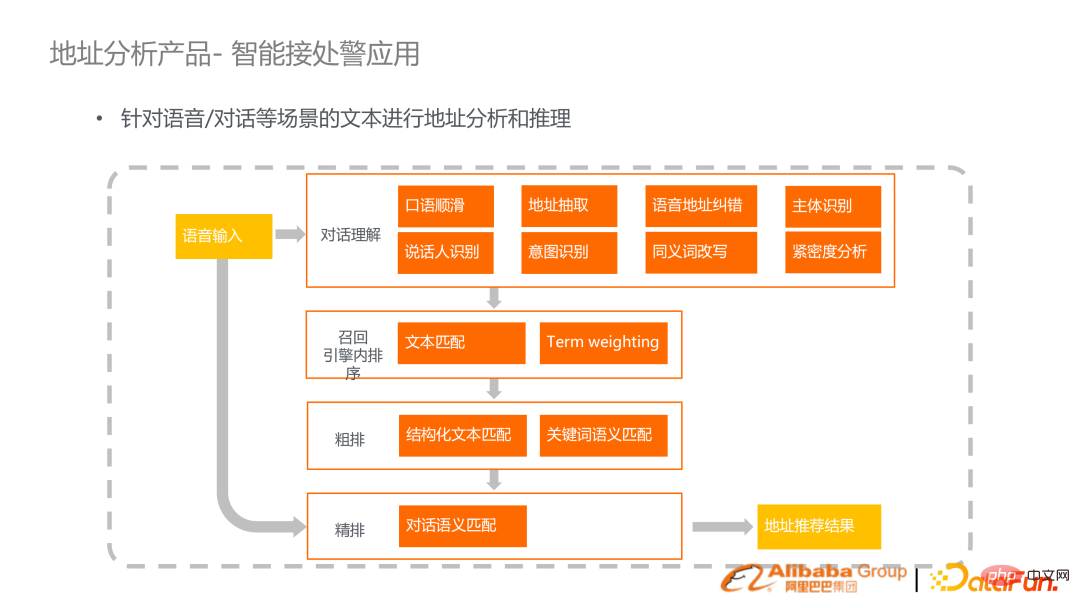

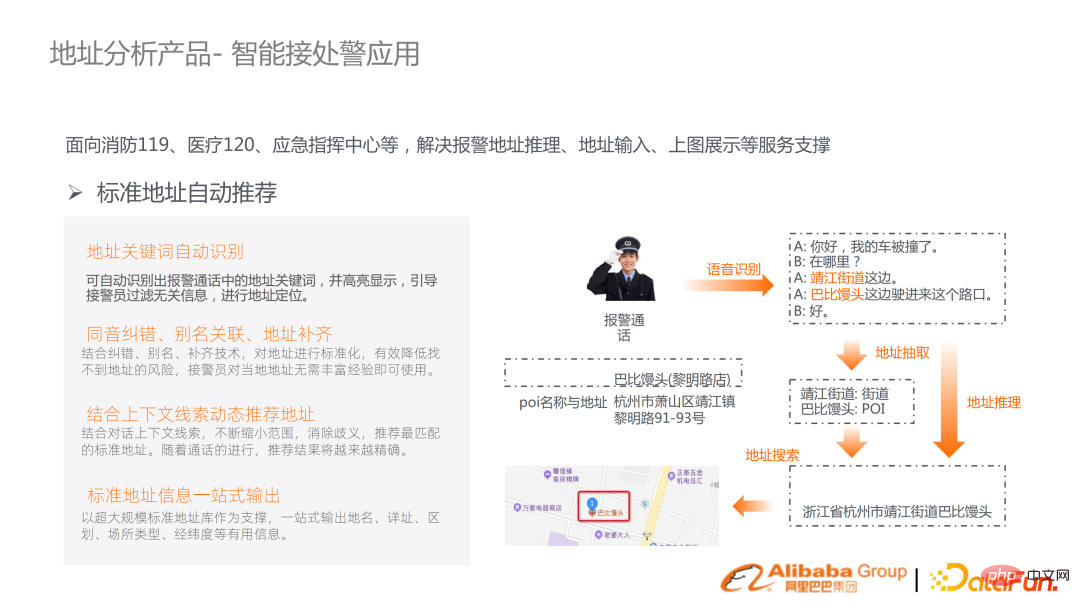

中心となるリンクは、地理的な事前トレーニング言語モデルを橋渡しし、基本的なタスクに対処し、検索エンジンをトリガーすることでそれらを橋渡しすることです。たとえば、Zhejiang No. 1 Hospital を検索する場合、構造化、同義語の修正、用語の重み付け、ベクトル化、Geohash 予測を実行できます。解析結果をもとにリコールを行います。このリンクは、テキスト呼び出し、ピンイン呼び出し、ベクトル呼び出しを実行し、地理的呼び出しも追加する標準の検索リンクです。リコールの後には、多粒度の特徴融合を含む多段階のソートが続きます。 #住所検索システムの直感的なアプリケーションは、住所を入力して提案シーンで検索するか、Amap マップで検索することです。ある時点で、スペースにマッピングする必要があります。 # 次に、比較的産業用途に適した 2 つのソリューションを紹介します。 1 つ目は、新しい小売ファミリー ID であり、顧客管理システムを維持することが中心的な要件ですが、各システムのユーザー情報が接続されておらず、効果的な統合が達成できません。 例えば、ブランドメーカーがエアコンを販売する際、購入・設置・メンテナンスのため、家族がさまざまな住所や携帯電話番号を登録するが、実際には対応する住所は同じ住所である。確立されたアドレス検索正規化テクノロジーは、さまざまな表現でアドレスを正規化し、フィンガープリントを生成し、さまざまなユーザー ID をファミリーの概念に集約します。 # 家族による集約の概念は、新しい小売の下で、より優れた浸透分析、広告リーチ、その他のマーケティング活動を達成します。 #もう 1 つのアプリケーション シナリオは、119、129、緊急およびその他のインテリジェント アラーム受信アプリケーションです。人々の個人的および財産の安全に関わるため、一秒一秒が重要です。私たちは、音声認識技術とテキスト意味理解技術を組み合わせることで、この効率を向上させたいと考えています。 (左の例) このシーンには、ASR 転写におけるタイプミス、流暢さ、口語表現など、多くの特徴があります。 . .目標は、自動音声文字起こし分析に基づいてアラームの位置を推測することです。 #2. 教育写真検索トピック

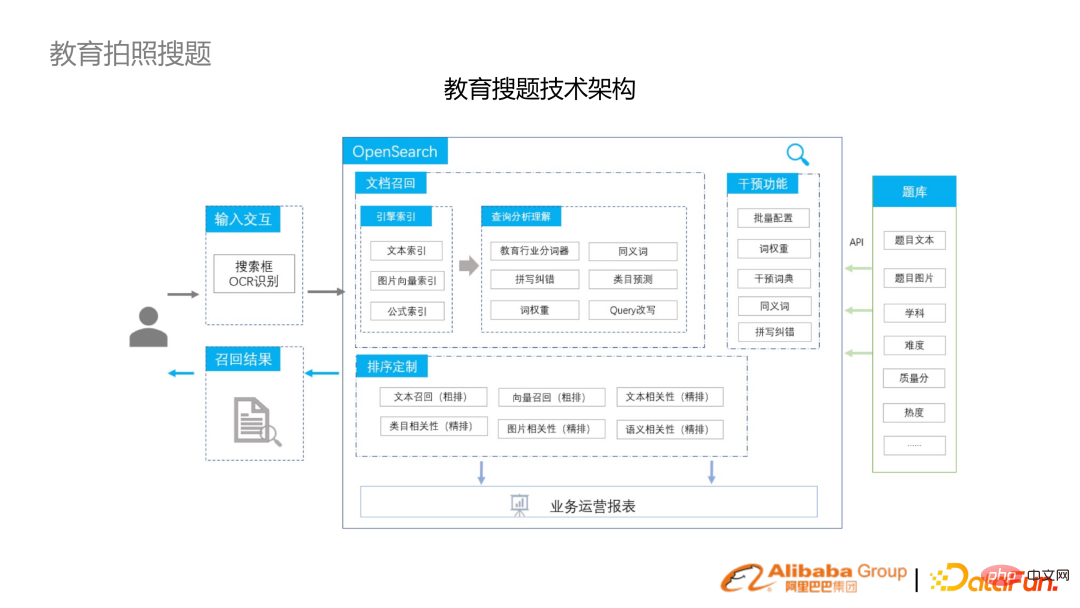

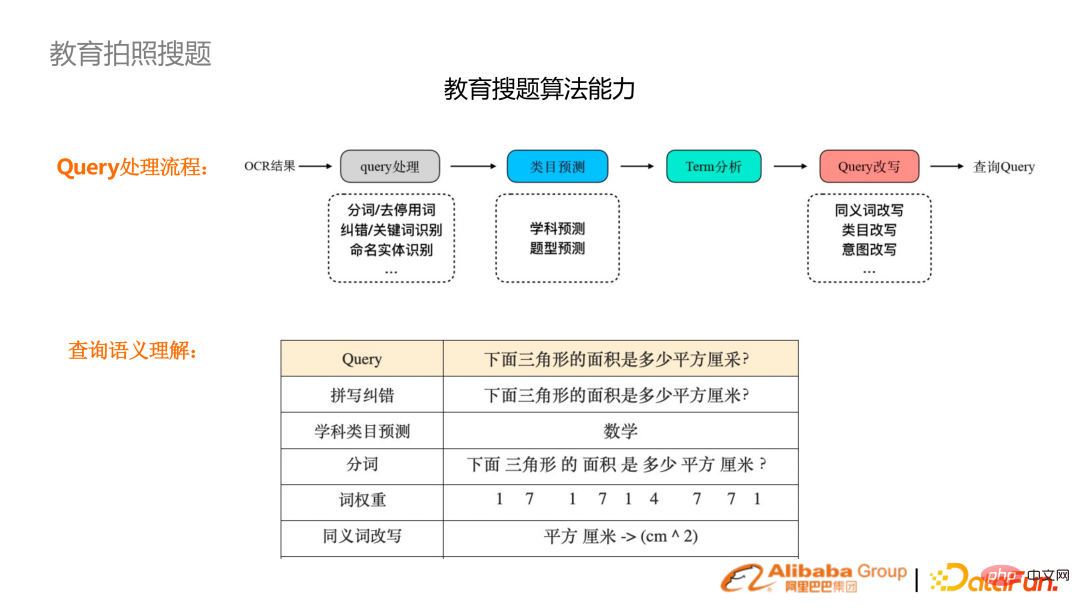

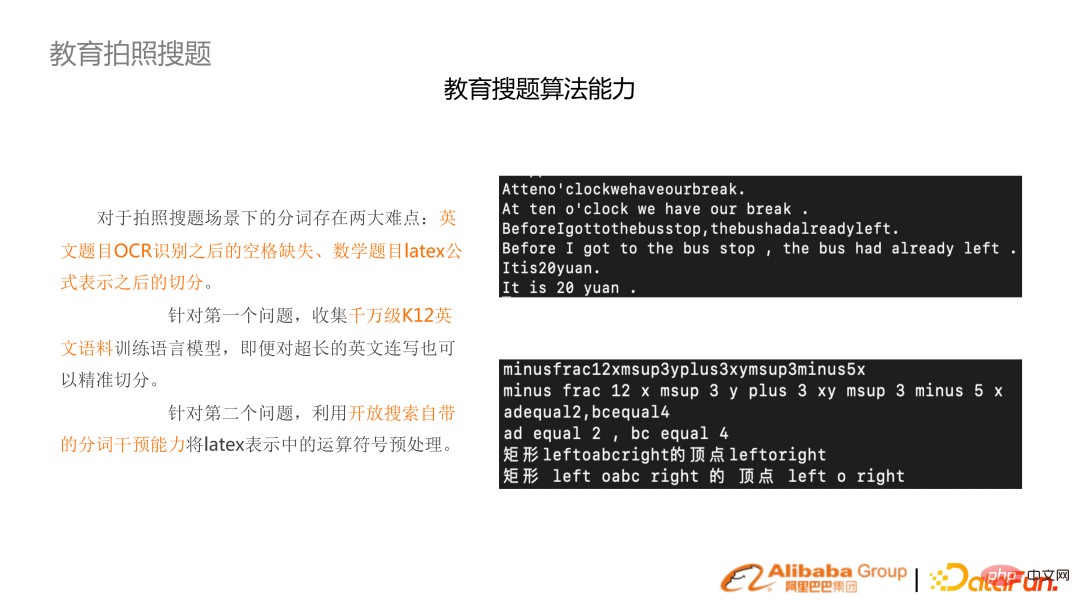

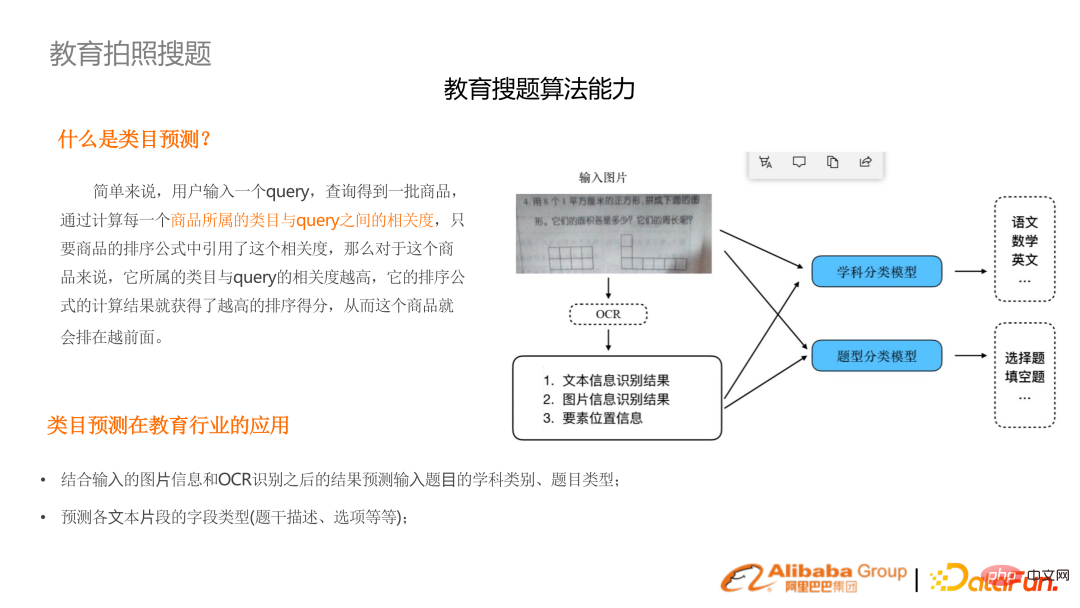

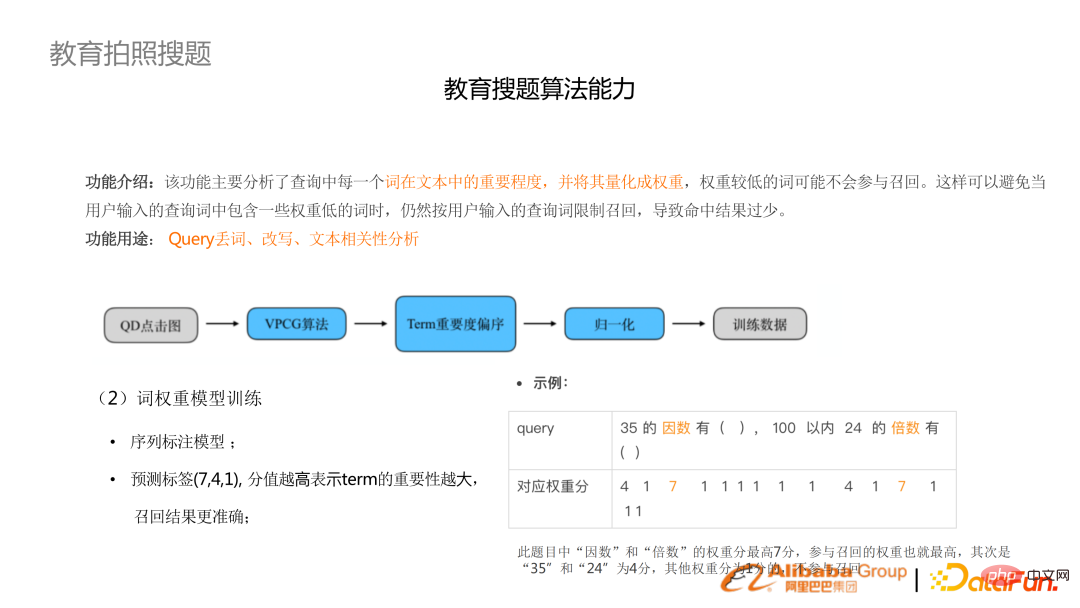

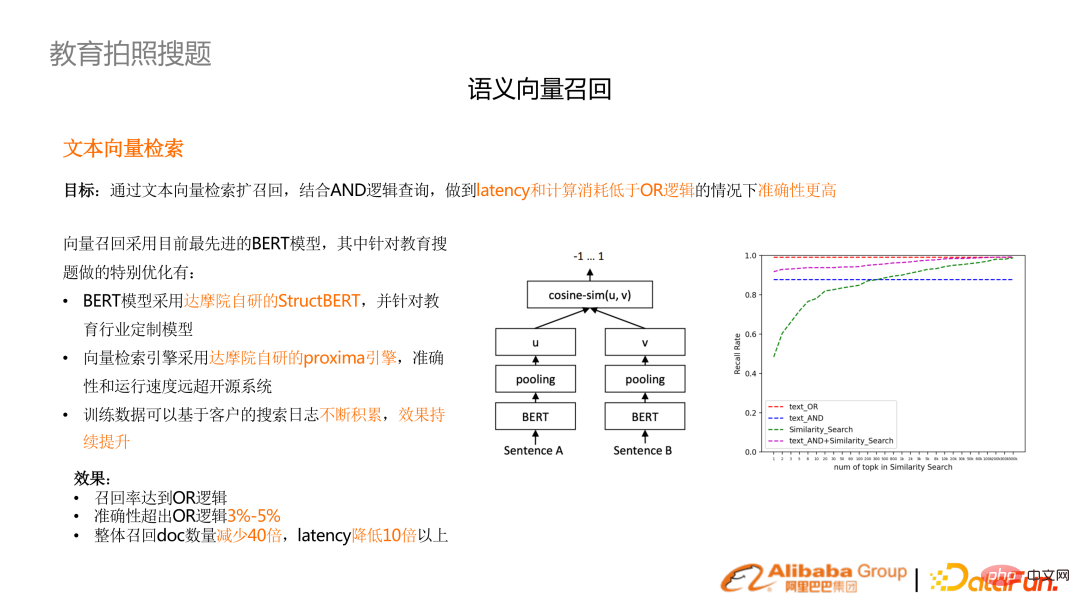

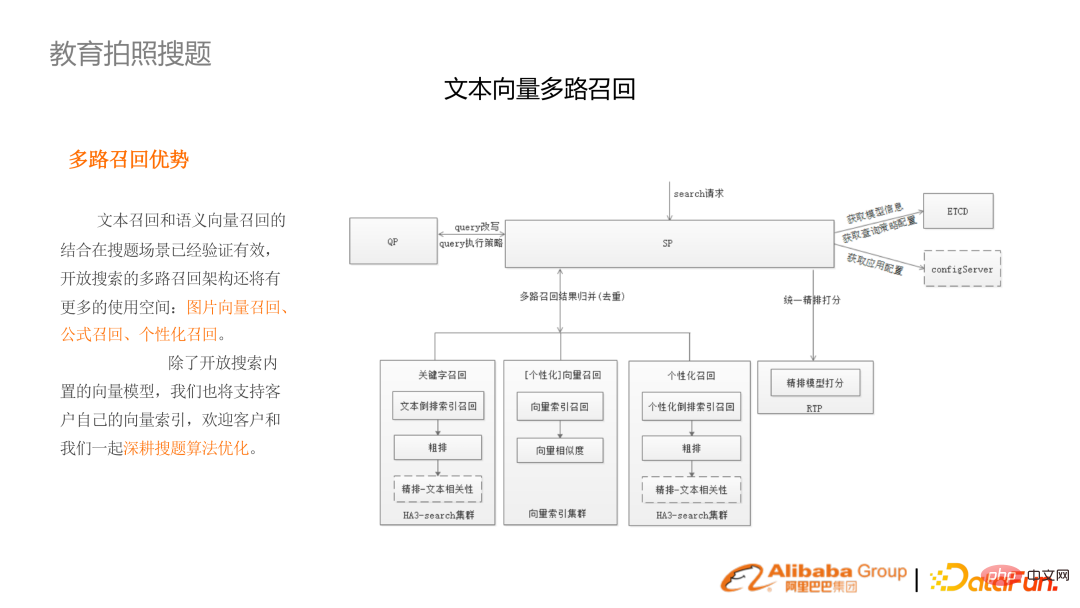

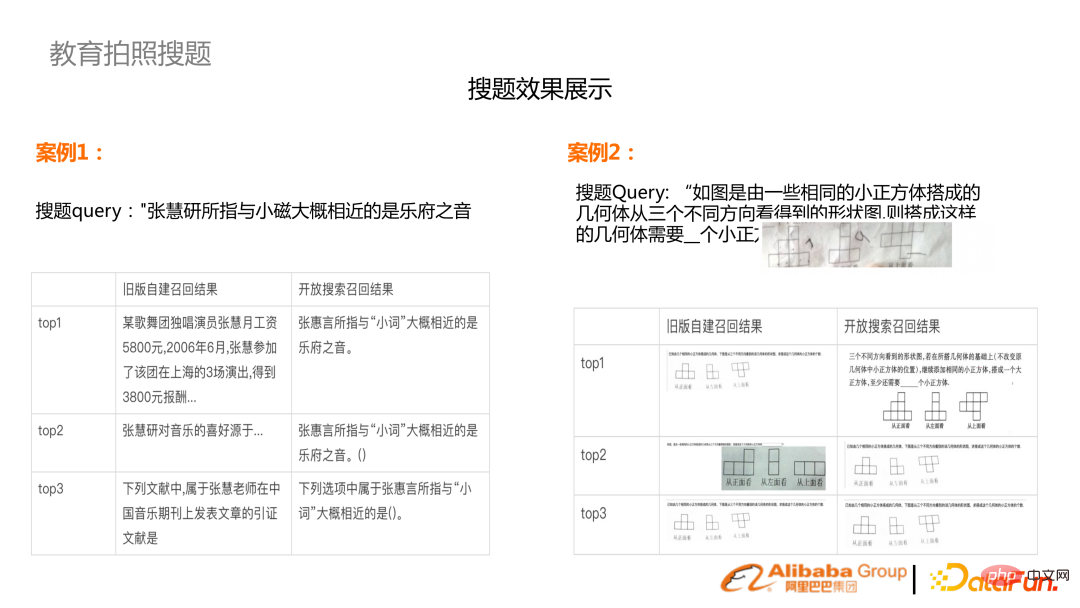

#たとえば、携帯電話で写真を撮って OCR 認識した後、スペル修正、主題予測、単語分割、単語分割などの一連の作業が実行されます。検索を容易にするために、単語の重み付けが実行されます。 OCR は英語のスペースを認識しないため、K12 英語事前トレーニング アルゴリズム モデルのセットは、英語のセグメンテーション。 同時に、主題や質問の種類は未知であるため、事前に予測する必要があります。マルチモダリティを使用して画像とテキストを組み合わせて意図を理解します。 写真検索の質問は通常のユーザー検索とは異なります。ユーザー検索のクエリは短いことが多いですが、写真検索の質問は多くの場合、完全な質問です。質問内の多くの単語は重要ではないため、単語の重み分析を実行し、重要でない単語を破棄するか、並べ替えてランクを下げる必要があります。 #写真検索シーンにおける最も明白な最適化効果は、ベクトルの再現です。パフォーマンス要件により、OR リコール メカニズムの使用が困難になり、AND ロジックを使用する必要がありますが、その分リコールが比較的少ないという特徴があります。再現率を向上させるには、用語の重み付けやエラー修正などの冗長モジュールをさらに実行する必要があります。 (右の図) テキストとベクトルのマルチチャンネルリコール効果は純粋な OR ロジックの効果を上回り、レイテンシは 10 分の 1 に短縮されます。 #写真検索リンクには、画像ベクトル再現、式再現、およびパーソナライズされた再現が含まれます。 #2 つ目は、グラフィックスを含む写真を撮影することです。これは、マルチチャンネルでの画像呼び出しと組み合わせる必要があります。 3. 電力知識ベースの統合検索 4. アダプティブ マルチタスク トレーニング

## MS MARCO で実験を行って、以前の実践と比較して最良の結果を達成してください。実際のシーン検索タスクでも、大きな改善をもたらす可能性があります。同時にMSランキングにも参戦した。

## MS MARCO で実験を行って、以前の実践と比較して最良の結果を達成してください。実際のシーン検索タスクでも、大きな改善をもたらす可能性があります。同時にMSランキングにも参戦した。

ROM リコール段階を除くさらに、詳細なランキングと再ランキングの段階では、一連のリスト対応の Transformer 再ランキングが提案されており、Transformer を通じて多くの分類器の結果が有機的に統合され、比較的大きな改善がもたらされます。

ROM リコール段階を除くさらに、詳細なランキングと再ランキングの段階では、一連のリスト対応の Transformer 再ランキングが提案されており、Transformer を通じて多くの分類器の結果が有機的に統合され、比較的大きな改善がもたらされます。 3. 業界検索アプリケーション

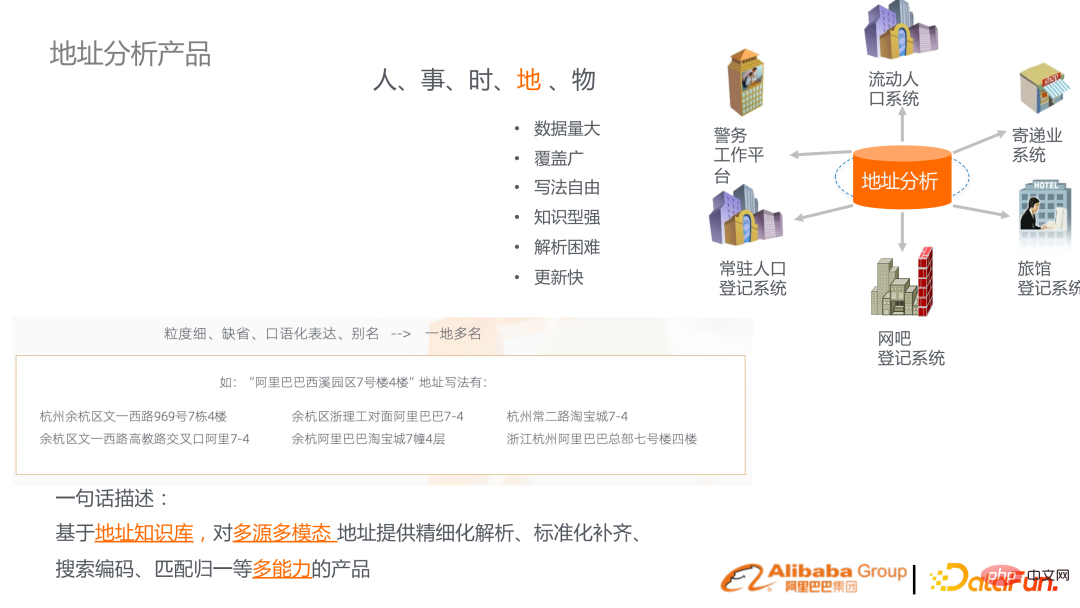

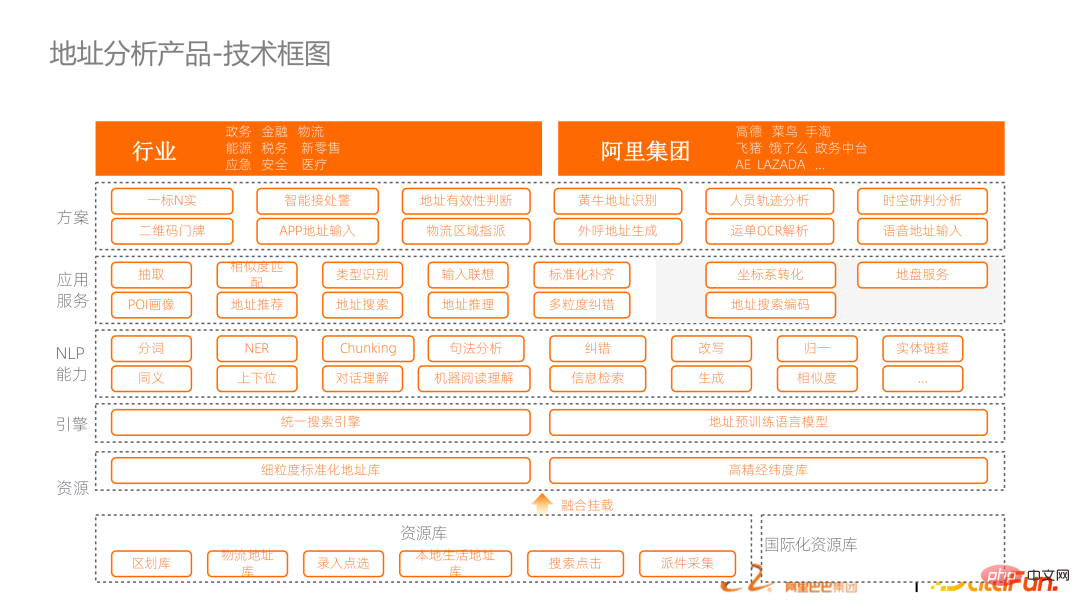

##1. アドレス分析製品

#これは製品の技術ブロック図です。下から上に、リンク全体を接続するための検索エンジン ベースのフレームワークを含む、アドレス ナレッジ グラフとアドレス事前トレーニング言語モデルの構築が含まれます。上記のベンチマーク機能は API の形式で提供され、業界ソリューションにパッケージ化されています。

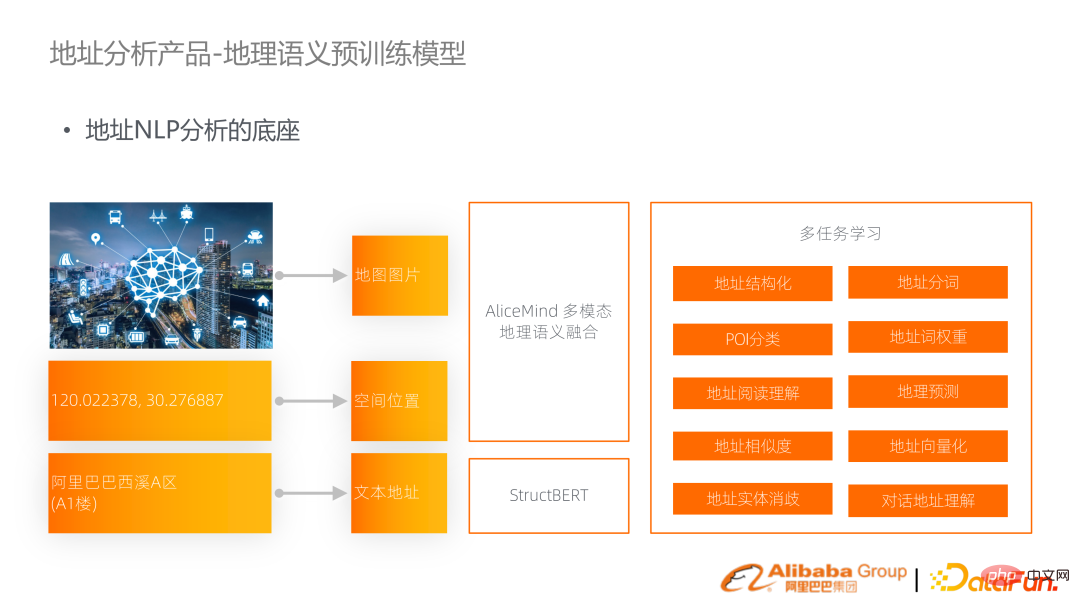

#これは製品の技術ブロック図です。下から上に、リンク全体を接続するための検索エンジン ベースのフレームワークを含む、アドレス ナレッジ グラフとアドレス事前トレーニング言語モデルの構築が含まれます。上記のベンチマーク機能は API の形式で提供され、業界ソリューションにパッケージ化されています。  このテクノロジーのより重要なポイントの 1 つは、地理的意味論の事前トレーニング済み言語モデルです。住所はテキストでは文字列として表されますが、実際には空間内の経度と緯度で表されることが多く、地図上には対応する画像が表示されます。したがって、これら 3 つのモダリティの情報は、その場所でのタスクをサポートするためにマルチモーダル地理意味論的言語モデルに有機的に統合されます。

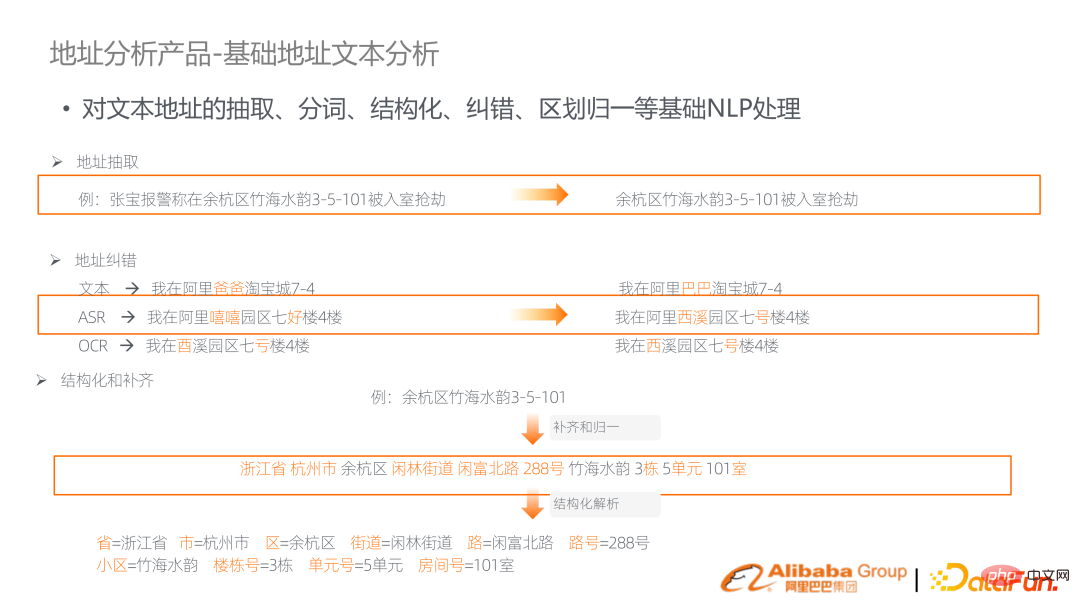

このテクノロジーのより重要なポイントの 1 つは、地理的意味論の事前トレーニング済み言語モデルです。住所はテキストでは文字列として表されますが、実際には空間内の経度と緯度で表されることが多く、地図上には対応する画像が表示されます。したがって、これら 3 つのモダリティの情報は、その場所でのタスクをサポートするためにマルチモーダル地理意味論的言語モデルに有機的に統合されます。  上で述べたように、単語の分割、エラー修正、構造化など、アドレスに関連する多くの基本的な機能が必要です。その他の分析。

上で述べたように、単語の分割、エラー修正、構造化など、アドレスに関連する多くの基本的な機能が必要です。その他の分析。

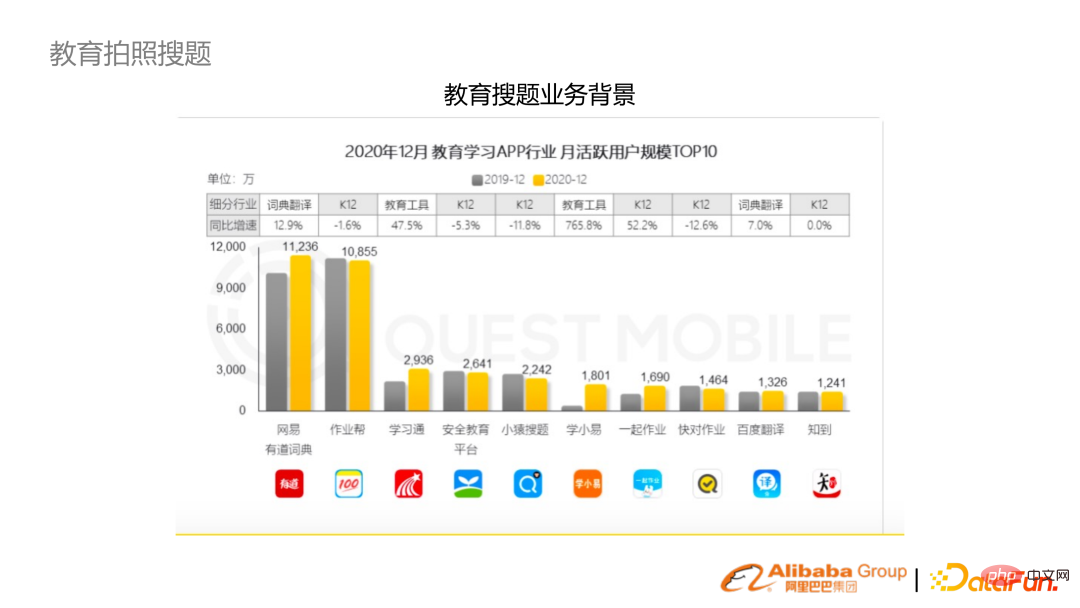

#写真検索の質問にはいくつかの特徴があり、段階的に更新される質問バンクがあり、大規模なユーザー ベースを持っています。さらに、さまざまな分野や年齢層に対応する分野の知識が豊富です。同時に、これは OCR からその後の意味理解と検索までの一連のリンクを備えたマルチモーダル アルゴリズムでもあります。

#写真検索の質問にはいくつかの特徴があり、段階的に更新される質問バンクがあり、大規模なユーザー ベースを持っています。さらに、さまざまな分野や年齢層に対応する分野の知識が豊富です。同時に、これは OCR からその後の意味理解と検索までの一連のリンクを備えたマルチモーダル アルゴリズムでもあります。  近年、写真収集のためにアルゴリズムからシステムまでの完全なリンクが構築されています。

近年、写真収集のためにアルゴリズムからシステムまでの完全なリンクが構築されています。

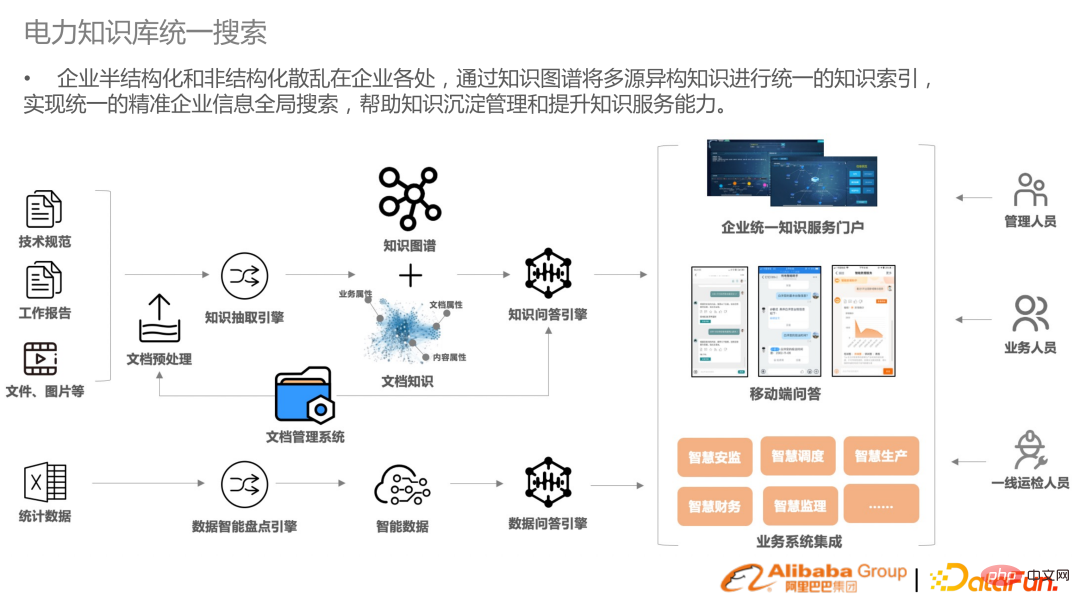

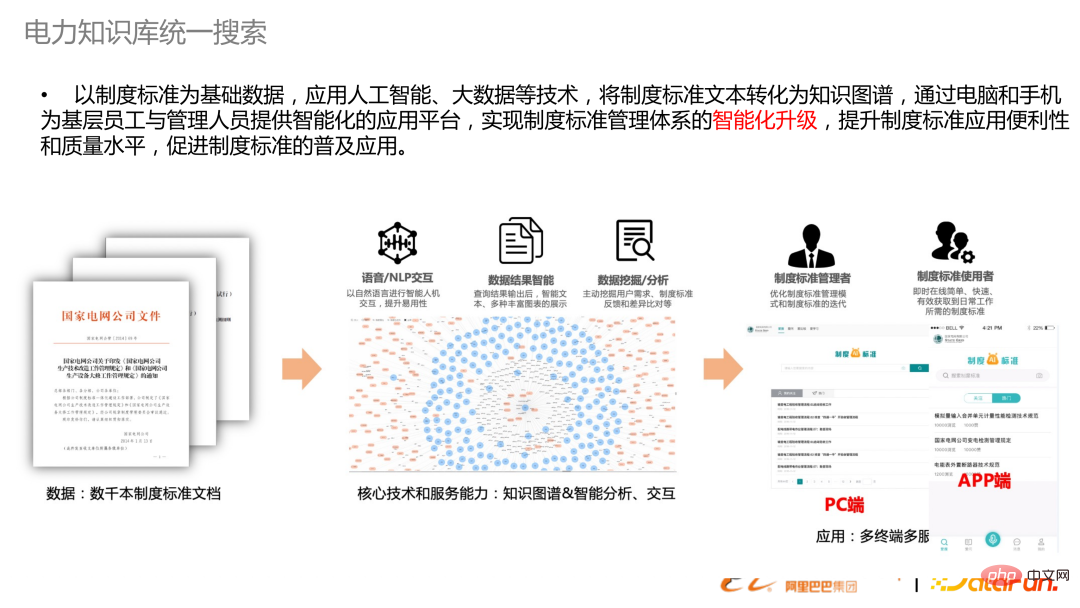

##エンタープライズ検索には半構造化データと非構造化データが大量にあり、企業がデータ リソースを統合するのに役立つ統合検索が提供されます。電力業界に限らず、他の業界でも同様のニーズがあります。ここでの検索はもはや絞り込み検索ではなく、文書の前処理とナレッジ グラフの構築の AI に加え、その後の質問と回答の橋渡しをする機能も含まれています。上記は電力知識ベースにおける機関標準テキスト群の構築から検索、応用までの作成の模式図です。

以上が事前訓練された言語モデルに基づく業界検索の応用と研究の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7491

7491

15

15

1377

1377

52

52

77

77

11

11

19

19

41

41

トークン化を 1 つの記事で理解しましょう!

Apr 12, 2024 pm 02:31 PM

トークン化を 1 つの記事で理解しましょう!

Apr 12, 2024 pm 02:31 PM

言語モデルは、通常は文字列の形式であるテキストについて推論しますが、モデルへの入力は数値のみであるため、テキストを数値形式に変換する必要があります。トークン化は自然言語処理の基本タスクであり、特定のニーズに応じて、連続するテキスト シーケンス (文、段落など) を文字シーケンス (単語、フレーズ、文字、句読点など) に分割できます。その中の単位はトークンまたはワードと呼ばれます。以下の図に示す具体的なプロセスに従って、まずテキスト文がユニットに分割され、次に単一の要素がデジタル化され (ベクトルにマッピングされ)、次にこれらのベクトルがエンコード用のモデルに入力され、最後に下流のタスクに出力され、さらに最終結果を取得します。テキストセグメンテーションは、テキストセグメンテーションの粒度に応じて Toke に分割できます。

大規模言語モデルの効率的なパラメータ微調整 - BitFit/Prefix/Prompt 微調整シリーズ

Oct 07, 2023 pm 12:13 PM

大規模言語モデルの効率的なパラメータ微調整 - BitFit/Prefix/Prompt 微調整シリーズ

Oct 07, 2023 pm 12:13 PM

2018 年に Google が BERT をリリースしました。リリースされると、11 個の NLP タスクの最先端 (Sota) 結果を一気に打ち破り、NLP 界の新たなマイルストーンとなりました。BERT の構造は次のとおりです。下の図では、左側は BERT モデルのプリセット、右側はトレーニング プロセス、右側は特定のタスクの微調整プロセスです。このうち、微調整ステージは、テキスト分類、品詞のタグ付け、質問と回答システムなど、その後のいくつかの下流タスクで使用されるときに微調整するためのものです。BERT はさまざまな上で微調整できます。構造を調整せずにタスクを実行できます。 「事前トレーニング済み言語モデル + 下流タスク微調整」のタスク設計により、強力なモデル効果をもたらします。以来、「言語モデルの事前トレーニング + 下流タスクの微調整」が NLP 分野のトレーニングの主流になりました。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

大規模なモデルをクラウドにデプロイするための 3 つの秘密

Apr 24, 2024 pm 03:00 PM

大規模なモデルをクラウドにデプロイするための 3 つの秘密

Apr 24, 2024 pm 03:00 PM

コンピレーション|Xingxuan によって制作|51CTO テクノロジー スタック (WeChat ID: blog51cto) 過去 2 年間、私は従来のシステムよりも大規模言語モデル (LLM) を使用した生成 AI プロジェクトに多く関与してきました。サーバーレス クラウド コンピューティングが恋しくなってきました。そのアプリケーションは、会話型 AI の強化から、さまざまな業界向けの複雑な分析ソリューションやその他の多くの機能の提供まで多岐にわたります。多くの企業は、パブリック クラウド プロバイダーが既製のエコシステムをすでに提供しており、それが最も抵抗の少ない方法であるため、これらのモデルをクラウド プラットフォームにデプロイしています。ただし、安くはありません。クラウドは、スケーラビリティ、効率、高度なコンピューティング機能 (オンデマンドで利用可能な GPU) などの他の利点も提供します。パブリック クラウド プラットフォームでの LLM の展開については、あまり知られていない側面がいくつかあります

RoSA: 大規模なモデルパラメータを効率的に微調整するための新しい方法

Jan 18, 2024 pm 05:27 PM

RoSA: 大規模なモデルパラメータを効率的に微調整するための新しい方法

Jan 18, 2024 pm 05:27 PM

言語モデルが前例のない規模に拡大するにつれて、下流タスクの包括的な微調整には法外なコストがかかります。この問題を解決するために、研究者はPEFT法に注目し、採用し始めました。 PEFT 手法の主なアイデアは、微調整の範囲を少数のパラメータ セットに制限して、自然言語理解タスクで最先端のパフォーマンスを達成しながら計算コストを削減することです。このようにして、研究者は高いパフォーマンスを維持しながらコンピューティング リソースを節約でき、自然言語処理の分野に新たな研究のホットスポットをもたらします。 RoSA は、一連のベンチマークでの実験を通じて、同じパラメーター バジェットを使用した以前の低ランク適応 (LoRA) および純粋なスパース微調整手法よりも優れたパフォーマンスを発揮することが判明した新しい PEFT 手法です。この記事ではさらに詳しく説明します

史上最大の ViT を便利にトレーニングしましたか? Google、ビジュアル言語モデルPaLIをアップグレード:100以上の言語をサポート

Apr 12, 2023 am 09:31 AM

史上最大の ViT を便利にトレーニングしましたか? Google、ビジュアル言語モデルPaLIをアップグレード:100以上の言語をサポート

Apr 12, 2023 am 09:31 AM

近年の自然言語処理の進歩は主に大規模言語モデルによるものであり、新しいモデルがリリースされるたびにパラメータと学習データの量が新たな最高値に押し上げられ、同時に既存のベンチマーク ランキングが壊滅することになります。たとえば、今年 4 月に Google は、5,400 億パラメータの言語モデル PaLM (Pathways Language Model) をリリースしました。これは、一連の言語および推論テストで人間を超えることに成功し、特に数ショットの小規模サンプル学習シナリオで優れたパフォーマンスを発揮しました。 PaLM は、次世代言語モデルの開発方向であると考えられています。同様に、視覚言語モデルは実際に驚くべき働きをしており、モデルの規模を大きくすることでパフォーマンスを向上させることができます。もちろん、それが単なるマルチタスク視覚言語モデルであれば、

Meta が 650 億のパラメータを持つ大規模言語モデルである AI 言語モデル LLaMA を発表

Apr 14, 2023 pm 06:58 PM

Meta が 650 億のパラメータを持つ大規模言語モデルである AI 言語モデル LLaMA を発表

Apr 14, 2023 pm 06:58 PM

2月25日のニュースによると、Metaは現地時間金曜日、研究コミュニティ向けに人工知能(AI)に基づく新しい大規模言語モデルを立ち上げ、ChatGPTに刺激されたMicrosoft、Google、その他の企業も人工知能に参加すると発表した。 . 知的な競争。 Meta の LLaMA は、「Large Language Model MetaAI」(LargeLanguageModelMetaAI) の略称であり、政府、コミュニティ、学術界の研究者および団体が非営利ライセンスに基づいて利用できます。同社は、基礎となるコードをユーザーが利用できるようにするため、ユーザーはモデルを自分で調整して研究関連のユースケースに使用できるようになります。 Meta 氏は、モデルの計算能力要件について次のように述べています。

BLOOM は AI 研究の新しい文化を生み出すことができますが、課題はまだ残っています

Apr 09, 2023 pm 04:21 PM

BLOOM は AI 研究の新しい文化を生み出すことができますが、課題はまだ残っています

Apr 09, 2023 pm 04:21 PM

翻訳者 | Li Rui によるレビュー | Sun Shujuan BigScience 研究プロジェクトは最近、大規模言語モデル BLOOM をリリースしましたが、一見すると、OpenAI の GPT-3 をコピーする別の試みのように見えます。しかし、BLOOM が他の大規模自然言語モデル (LLM) と異なる点は、機械学習モデルの研究、開発、トレーニング、リリースへの取り組みです。近年、大手テクノロジー企業は大規模な自然言語モデル (LLM) を厳格な企業秘密のように隠しており、BigScience チームはプロジェクトの開始時から BLOOM の中心に透明性とオープン性を据えてきました。その結果、研究して研究し、誰もが利用できる大規模な言語モデルが誕生しました。 B