ChatGPT をプレイできないことがまだ心配ですか?これらの数十のオープンソース代替手段とのインテリジェントな対話を体験することもできます

ChatGPT の最初のリリースからほぼ 4 か月が経過しました。この間、ChatGPT の驚異的なパフォーマンスにより、人々は AIGC が事前に実現するのではないかと疑っていました。

しかし、よく知られている秘密は、ChatGPT がオープンソースになる可能性が低いということです。コンピューティング能力と膨大なトレーニング データへの巨額の投資と相まって、研究に多くの障害をもたらしています。コミュニティがその実装プロセスをコピーするレベル。

ChatGPT の猛攻撃に直面すると、オープンソースの代替案は良い選択であり、同様の機能を実現すると同時に、代替案を通じて ChatGPT の動作メカニズムを理解することもできます。

テクノロジーの進歩に伴い、ChatGPT に似た他の新しい AI モデルが多数登場しています。この記事では、ChatGPT のオープンソース代替プロジェクトを概観します。内容は 2 つの部分に分かれており、1 つは ChatGPT 風のオープンソース プロジェクトの概要であり、もう 1 つはプロジェクトの概要の補足です。

プロジェクトの概要

プロジェクト作成者 nichtdax は、9 つのオープンソース ChatGPT 代替プロジェクトをコンパイルしました。次回からは順次紹介していきます。

#プロジェクトアドレス: https://github.com/nichtdax/awesome -totally-open-chatgpt

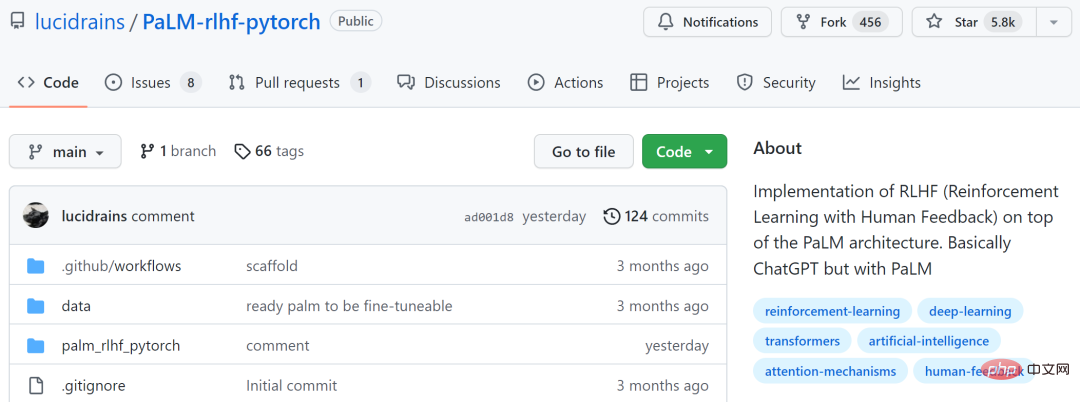

PaLM-rlhf-pytorch

最初のプロジェクトは「 PaLM-rlhf-pytorch」のプロジェクト作成者は Phil Wang です。このプロジェクトは、PaLM アーキテクチャ上に RLHF (ヒューマン フィードバックによる強化学習) を実装したもので、基本的には PaLM を使用した ChatGPT です。

このプロジェクトは、GitHub で 5.8k スターを獲得しました。

プロジェクトアドレス: https://github.com/lucidrains/PaLM-rlhf- pytorch

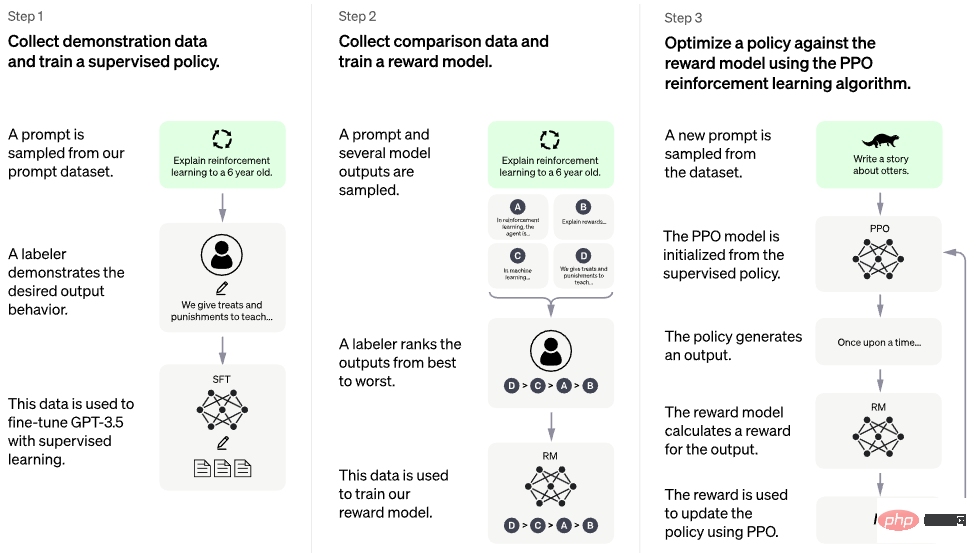

#下の図はトレーニング プロセスを示しています。

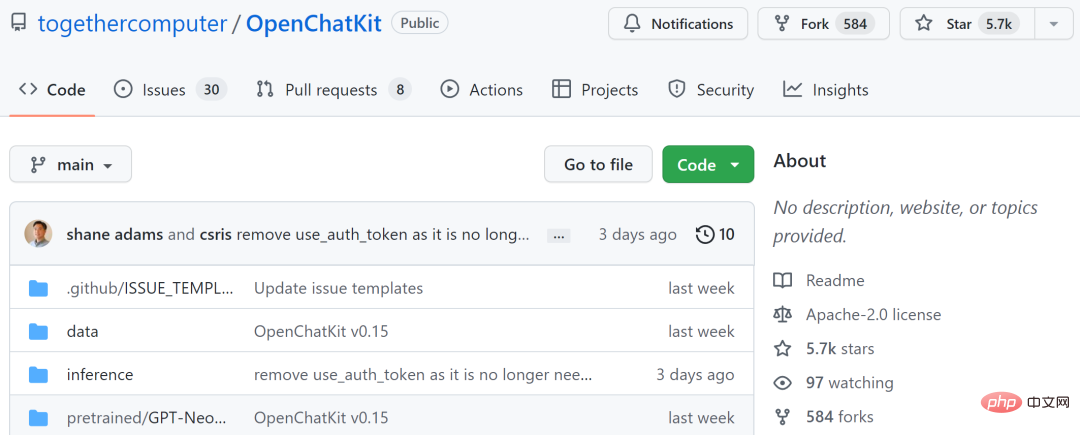

OpenChatKit は、Togetter、LAION、Ontocord.ai を統合した OIG-43M トレーニング データセットでトレーニングされています。プロジェクトの作成者は、これはモデルのリリースであるだけでなく、オープンソース プロジェクトの始まりでもあると述べています。彼らは一連のツールとプロセスをリリースし、コミュニティへの貢献を通じてそれらを継続的に改善しています。

このプロジェクトは、GitHub で 5.7,000 個のスターを獲得しました。

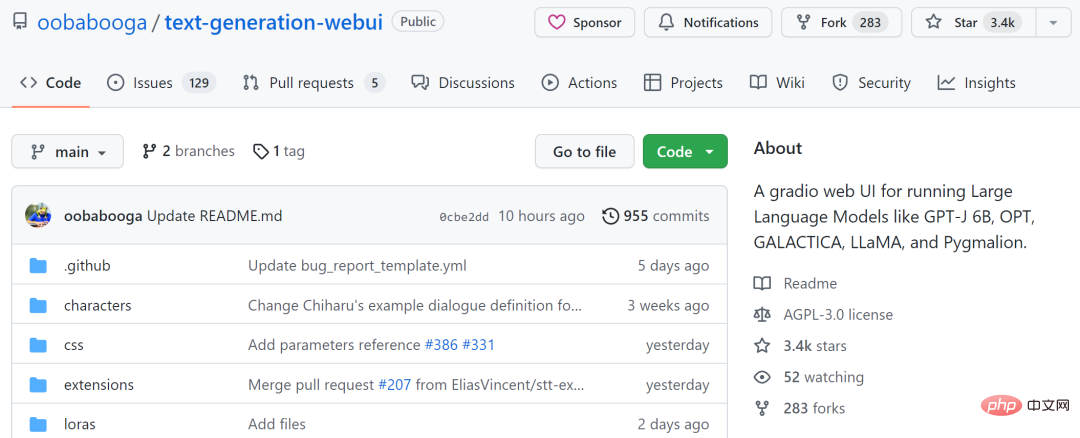

text-generation-webui

3 番目のプロジェクトは「text-generation-webui」です。これは、GPT-J 6B、OPT、GALACTICA、LLaMA、および Gradio Web を実行するためのツールです。 Pygmalion などの大規模言語モデルの UI。このプロジェクトは、テキスト生成の AUTOMATIC1111/stable-diffusion-webui を目指しています。

機能には、ドロップダウン メニューを使用した異なるモデル間の切り替え、OpenAI プレイグラウンドに似たノートブック モードの提供、対話やロールプレイングのためのチャット モードの提供、美しい HTML 出力の生成などが含まれます。

このプロジェクトは GitHub で 3.4k を受け取りました。

プロジェクトアドレス: https://github.com/oababooga/text-generation- webui

KoboldAI-Client

4 番目のプロジェクトは「KoboldAI-Client」です。これは、複数のローカルおよびリモート AI モデルによるブラウザベースのフロントエンドです。AI を実装します。執筆補助。

KoboldAI-Client は、メモリ、作成者メモ、世界情報、保存とロード、調整可能な AI 設定、書式設定オプション、既存のテキストのインポートなどの標準ツール セットを提供します。 AIダンジョンアドベンチャーゲーム。アドベンチャー モードをオンにしたり、AI Dungeon Unleashed などのゲームをプレイしたりできます。

このプロジェクトは GitHub で 1.4k を受け取りました。

プロジェクトアドレス: https://github.com/KoboldAI/KoboldAI-Client

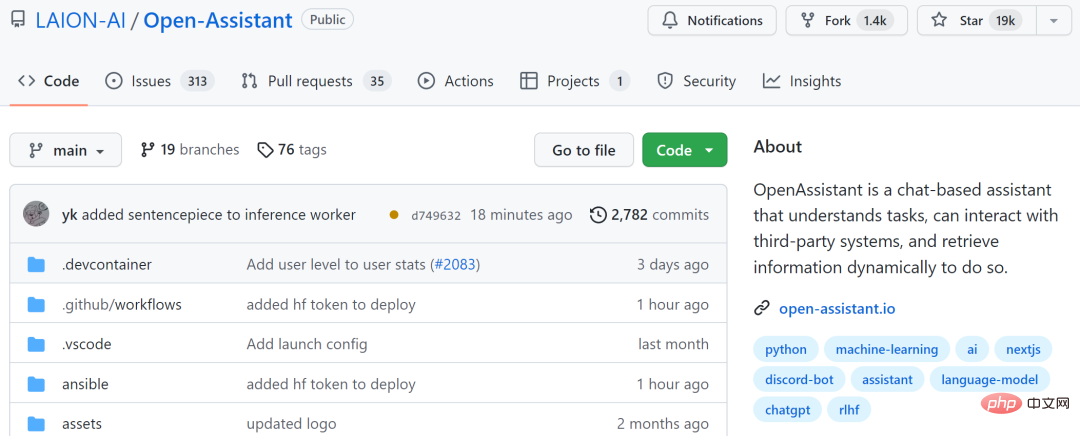

Open-Assistant5 番目のプロジェクトは「Open-Assistant」です。これは、大規模なチャットベースの言語モデルを誰でも利用できるようにすることを目的としています。プロジェクトの作成者らは、安定した普及が世界に新しい方法で芸術や画像を生み出すのと同じように、言語の革新に革命を起こすことを望んでいる。

プロジェクト作成者は、50,000 件を超えることを目標に、手動で生成された高品質の命令実行サンプル (命令応答) を収集することを計画しています。収集された指示ごとに、複数の完了結果がサンプリングされます。次に、指導と報酬モデルに基づいて RLHF トレーニング フェーズに入ります。

このプロジェクトは、GitHub で 19,000 個のスターを獲得しました。

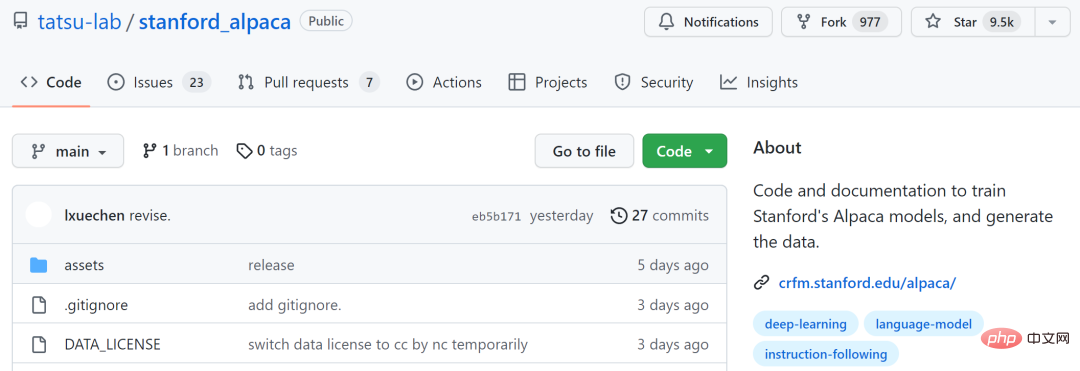

stanford_alpaca

6 番目のプロジェクトは「stanford_alpaca」です。これは、命令に従う LLaMA モデルを構築して共有することを目的としています。このリポジトリには、モデルを微調整するための 52k データ、データを生成するコード、モデルを微調整するためのコードが含まれています。このプロジェクトは、GitHub で 9.5,000 個のスターを獲得しました。

ChatRWKV

7 番目のプロジェクトは「ChatRWKV」です。これは ChatGPT に似ていますが、RWKV (100% RNN) モデルによってサポートされており、オープン ソースです。プロジェクトの作成者によると、RWKV は現在、品質とスケーラビリティの点でトランスフォーマーに匹敵し、さらに高速で VRAM を節約できる唯一の RNN モデルです。

このプロジェクトは、GitHub で 3.5,000 個のスターを獲得しました。

ChatGLM-6B

8 番目のプロジェクトは、同社の Zhipu AI オープンソース、中国語と英語のバイリンガル会話言語モデル「ChatGLM-6B」で、清華社の技術成果を一般言語モデルに基づいて変換したものです。 62 億パラメータを持つ (GLM) アーキテクチャ。モデル量子化テクノロジーと組み合わせることで、ユーザーはそれを民生用グラフィック カードにローカルに展開できます (INT4 量子化レベルでは最低 6GB のビデオ メモリが必要です)。

ChatGLM-6B は、ChatGPT と同様のテクノロジーを使用しており、中国語の Q&A と対話用に最適化されています。約 1T の識別子を使用した中国語と英語のバイリンガル トレーニングを経て、教師付き微調整、フィードバック セルフサービス、ヒューマン フィードバック強化学習、その他のテクノロジーによって補完された後、62 億のパラメーターを備えた ChatGLM-6B は、次の内容と完全に一致する回答を生成することができました。人間の好み。

ただし、ChatGLM-6B は規模が小さいため、事実/数学的論理エラー、有害/偏った情報が生成される可能性など、かなりの制限があることが現在知られています。弱い文脈スキル、混乱した自己認識、中国語の指示と完全に矛盾する英語の指示の作成。

このプロジェクトは GitHub で 6,000 個のスターを獲得しました。

プロジェクトアドレス: https://github.com/THUDM/ChatGLM-6B

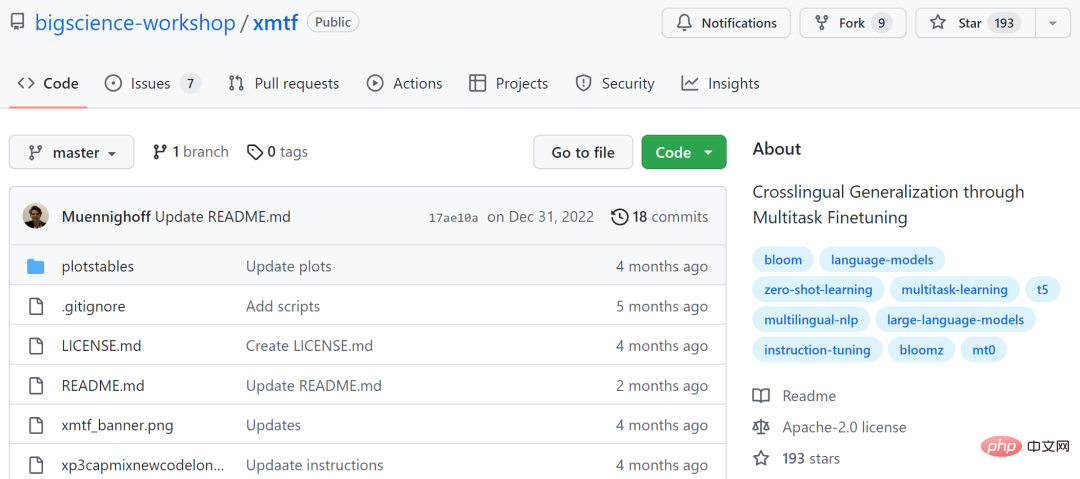

xmtf9 番目のプロジェクトは「xmtf」です。これには、作成論文「マルチタスク微調整によるクロスリンガルの一般化」で紹介された BLOOMZ、mT0、および xP3 のすべてのコンポーネントが含まれています。

その中で、BLOOMZ は 1,760 億のパラメータとオープンアクセスの多言語モデルであり、mT0 (ここでは特に Google の T5X を指します)、xP3 は 46 言語の教師ありデータセットです。英語と機械翻訳のプロンプトがあります。

プロジェクトアドレス: https://github.com/bigscience-workshop/xmtf

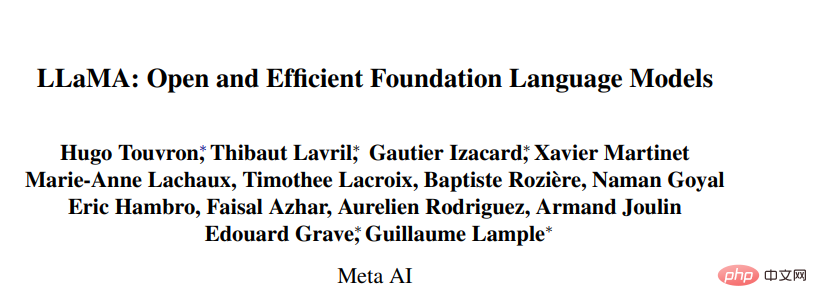

上記のモデルに加えて、ChatGPT 代替プロジェクトには、メタ オープン ソースの大規模モデル シリーズ LLaMA (Large Language Model Meta AI) に基づくいくつかの研究も含まれています。モデルの範囲は 70 億から 650 億です。 130 億のパラメータを持つ LLaMA モデルは、「ほとんどのベンチマーク」で GPT-3 (1,750 億のパラメータ) を上回るパフォーマンスを示し、単一の V100 GPU で実行できます。一方、650 億のパラメータを持つ最大の LLaMA モデルは、Google Chinchilla-70B および PaLM- に匹敵します。 540B。

- 論文リンク: https://research.facebook.com/publications/llama-open-and-efficient-foundation- language -models/

- GitHub リンク: https://github.com/facebookresearch/llama

この調査に基づいて、開発者はいくつかのオープンソース プロジェクトも提案されています。

llama.cpp GPU は不要、LLaMA を実行できますllama.cpp プロジェクトは MacBook 上で LLaMA を実行することを実現し、開発者は 4GB の MacBook 上で LLaMA を実行することに成功しました。 RAM LLaMA 7B は Raspberry Pi 上で実行されています。要約すると、開発者は GPU がなくても LLaMA モデルを実行できます。

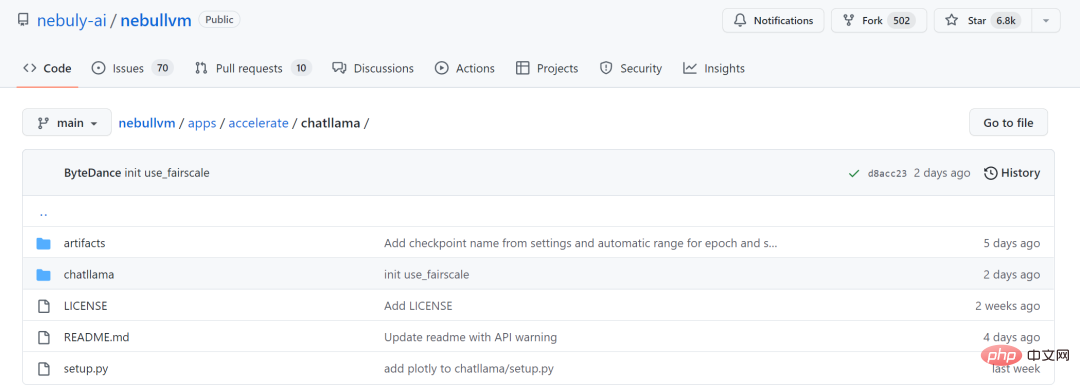

ChatLLaMA LLaMA 大型モデル シリーズは RLHF メソッドを使用していないため、スタートアップ Nebuly AI は LLaMA の RLHF バージョン (ChatLLaMA) のトレーニング メソッドをオープンソース化しました。そのトレーニング プロセスは ChatGPT に似ており、このプロジェクトでは、事前トレーニングされた LLaMA モデルに基づいて ChatGPT スタイルのサービスを構築できます。 ChatGPT と比較すると、LLaMA のアーキテクチャは小さいですが、トレーニング プロセスとシングル GPU 推論は高速で安価です。ライブラリはすべての LLaMA モデル アーキテクチャ (7B、13B、33B、65B) もサポートしているため、ユーザーはパフォーマンスの好みを推論できます。モデルを微調整します。 プロジェクトアドレス: https://github.com/nebuly-ai/nebullvm/ tree/main/apps/accelerate/chatllama 今後さらに多くのオープンソース プロジェクトが参加することを楽しみにしています。

以上がChatGPT をプレイできないことがまだ心配ですか?これらの数十のオープンソース代替手段とのインテリジェントな対話を体験することもできますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7536

7536

15

15

1379

1379

52

52

82

82

11

11

21

21

86

86

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

テキスト注釈は、テキスト内の特定のコンテンツにラベルまたはタグを対応させる作業です。その主な目的は、特に人工知能の分野で、より深い分析と処理のためにテキストに追加情報を提供することです。テキスト注釈は、人工知能アプリケーションの教師あり機械学習タスクにとって非常に重要です。これは、自然言語テキスト情報をより正確に理解し、テキスト分類、感情分析、言語翻訳などのタスクのパフォーマンスを向上させるために AI モデルをトレーニングするために使用されます。テキスト アノテーションを通じて、AI モデルにテキスト内のエンティティを認識し、コンテキストを理解し、新しい同様のデータが出現したときに正確な予測を行うように教えることができます。この記事では主に、より優れたオープンソースのテキスト注釈ツールをいくつか推奨します。 1.LabelStudiohttps://github.com/Hu

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

画像の注釈は、ラベルまたは説明情報を画像に関連付けて、画像の内容に深い意味と説明を与えるプロセスです。このプロセスは機械学習にとって重要であり、画像内の個々の要素をより正確に識別するために視覚モデルをトレーニングするのに役立ちます。画像に注釈を追加することで、コンピュータは画像の背後にあるセマンティクスとコンテキストを理解できるため、画像の内容を理解して分析する能力が向上します。画像アノテーションは、コンピュータ ビジョン、自然言語処理、グラフ ビジョン モデルなどの多くの分野をカバーする幅広い用途があり、車両が道路上の障害物を識別するのを支援したり、障害物の検出を支援したりするなど、幅広い用途があります。医用画像認識による病気の診断。この記事では主に、より優れたオープンソースおよび無料の画像注釈ツールをいくつか推奨します。 1.マケセンス

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

顔の検出および認識テクノロジーは、すでに比較的成熟しており、広く使用されているテクノロジーです。現在、最も広く使用されているインターネット アプリケーション言語は JS ですが、Web フロントエンドでの顔検出と認識の実装には、バックエンドの顔認識と比較して利点と欠点があります。利点としては、ネットワーク インタラクションの削減とリアルタイム認識により、ユーザーの待ち時間が大幅に短縮され、ユーザー エクスペリエンスが向上することが挙げられます。欠点としては、モデル サイズによって制限されるため、精度も制限されることが挙げられます。 js を使用して Web 上に顔検出を実装するにはどうすればよいですか? Web 上で顔認識を実装するには、JavaScript、HTML、CSS、WebRTC など、関連するプログラミング言語とテクノロジに精通している必要があります。同時に、関連するコンピューター ビジョンと人工知能テクノロジーを習得する必要もあります。 Web 側の設計により、次の点に注意してください。

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

マルチモーダル文書理解機能のための新しい SOTA!アリババの mPLUG チームは、最新のオープンソース作品 mPLUG-DocOwl1.5 をリリースしました。これは、高解像度の画像テキスト認識、一般的な文書構造の理解、指示の遵守、外部知識の導入という 4 つの主要な課題に対処するための一連のソリューションを提案しています。さっそく、その効果を見てみましょう。複雑な構造のグラフをワンクリックで認識しMarkdown形式に変換:さまざまなスタイルのグラフが利用可能:より詳細な文字認識や位置決めも簡単に対応:文書理解の詳しい説明も可能:ご存知「文書理解」 「」は現在、大規模な言語モデルの実装にとって重要なシナリオです。市場には文書の読み取りを支援する多くの製品が存在します。その中には、主にテキスト認識に OCR システムを使用し、テキスト処理に LLM と連携する製品もあります。

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

リリースされたばかりの!ワンクリックでアニメ風の画像を生成するオープンソース モデル

Apr 08, 2024 pm 06:01 PM

リリースされたばかりの!ワンクリックでアニメ風の画像を生成するオープンソース モデル

Apr 08, 2024 pm 06:01 PM

最新の AIGC オープンソース プロジェクト、AnimagineXL3.1 をご紹介します。このプロジェクトは、アニメをテーマにしたテキストから画像へのモデルの最新版であり、より最適化された強力なアニメ画像生成エクスペリエンスをユーザーに提供することを目的としています。 AnimagineXL3.1 では、開発チームは、モデルのパフォーマンスと機能が新たな高みに達することを保証するために、いくつかの重要な側面の最適化に重点を置きました。まず、トレーニング データを拡張して、以前のバージョンのゲーム キャラクター データだけでなく、他の多くの有名なアニメ シリーズのデータもトレーニング セットに含めました。この動きによりモデルの知識ベースが充実し、さまざまなアニメのスタイルやキャラクターをより完全に理解できるようになります。 AnimagineXL3.1 では、特別なタグと美学の新しいセットが導入されています

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

FP8 以下の浮動小数点数値化精度は、もはや H100 の「特許」ではありません。 Lao Huang は誰もが INT8/INT4 を使用できるようにしたいと考え、Microsoft DeepSpeed チームは NVIDIA からの公式サポートなしで A100 上で FP6 の実行を開始しました。テスト結果は、A100 での新しい方式 TC-FPx の FP6 量子化が INT4 に近いか、場合によってはそれよりも高速であり、後者よりも精度が高いことを示しています。これに加えて、エンドツーエンドの大規模モデルのサポートもあり、オープンソース化され、DeepSpeed などの深層学習推論フレームワークに統合されています。この結果は、大規模モデルの高速化にも即座に影響します。このフレームワークでは、シングル カードを使用して Llama を実行すると、スループットはデュアル カードのスループットの 2.65 倍になります。 1つ