長年にわたり、Volcano Engine は、一般的なビデオ プラットフォーム向けに音声認識テクノロジに基づいたインテリジェントなビデオ字幕ソリューションを提供してきました。簡単に説明すると、AI技術を利用して動画内の音声や歌詞を自動でテキスト化して動画作成を支援する機能です。しかし、プラットフォーム ユーザーの急速な増加と、より豊富で多様な言語タイプの要求に伴い、従来使用されてきた教師あり学習テクノロジーがますますボトルネックに達し、チームは大きな問題に直面しています。

ご存知のとおり、従来の教師あり学習は、特に大規模言語の継続的な最適化や小規模言語のコールド スタートにおいて、手動で注釈が付けられた教師ありデータに大きく依存します。中国語、北京語、英語などの主要言語を例に挙げると、ビデオ プラットフォームはビジネス シナリオに十分な音声データを提供しますが、教師付きデータが一定の規模に達すると、継続的なアノテーションの ROI は非常に低くなります。技術担当者は必然的に、大規模言語の音声認識のパフォーマンスをさらに向上させるために、数百の教師付きデータ、数万時間のラベルなしデータを効果的に利用する方法を検討する必要があります。

比較的ニッチな言語または方言の場合、リソース、人員、その他の理由によりデータのラベル付けのコストが高くなります。ラベル付きデータが非常に少ない場合 (約 10 時間)、教師付きトレーニングの効果は非常に低く、正常に収束しないこともあります。また、購入したデータがターゲット シナリオと一致せず、ユーザーのニーズを満たすことができないことがよくあります。仕事。

したがって、火山エンジン音声チームは、ラベル付けされていない大量のデータを可能な限り低いラベル付けコストで最大限に活用し、少ない量で認識効果を向上させる方法を早急に検討する必要があります。ラベル付きデータを作成し、実際のビジネスに実装します。 したがって、教師なし事前トレーニング テクノロジーが、ビデオ プラットフォームの ASR (自動音声認識/自動音声認識) 機能を小規模言語に普及させるための鍵となっています。

学術コミュニティは、近年、Wav2vec2.0[1]など、音声の教師なし事前トレーニングの分野で多くの重要な進歩を遂げてきましたが、 、HuBERT[2]などがありますが、業界での導入事例は少ないので参考にしてください。 全体として、Volcano Voice チームは、次の 3 つの理由が教師なし事前トレーニング テクノロジの実装を妨げていると考えています。

上記の 3 つの主要な問題点を考慮して、アルゴリズムの改善とエンジニアリングの最適化が実行され、完全で推進しやすい実装計画が作成されました。この記事では、実装プロセス、アルゴリズムの最適化、エンジニアリングの最適化に至るまで、ソリューションを詳しく紹介します。

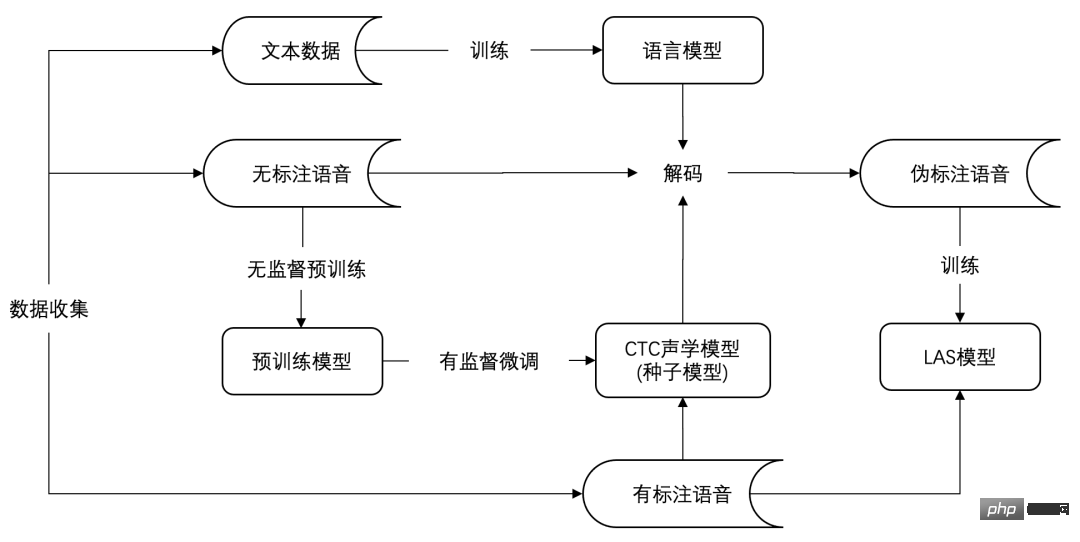

実装プロセス次の図は、低リソース言語 ASR の教師なし事前トレーニングの実装プロセスであり、大きく分けて データ 収集、シード モデルのトレーニング、モデルの移行という 3 つの段階があります。

# #具体的には、データ収集の最初の段階では、言語転用、調達、その他の手段を通じて、ターゲット言語のラベルなし音声、ラベル付き音声、およびプレーンテキストデータを収集できます。

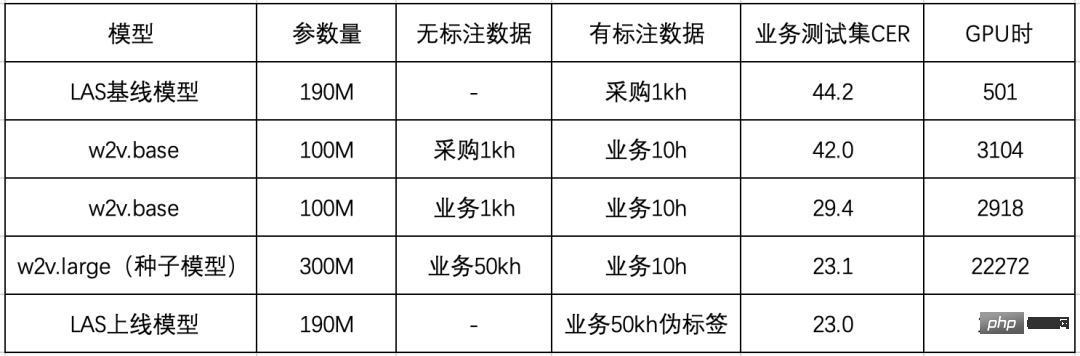

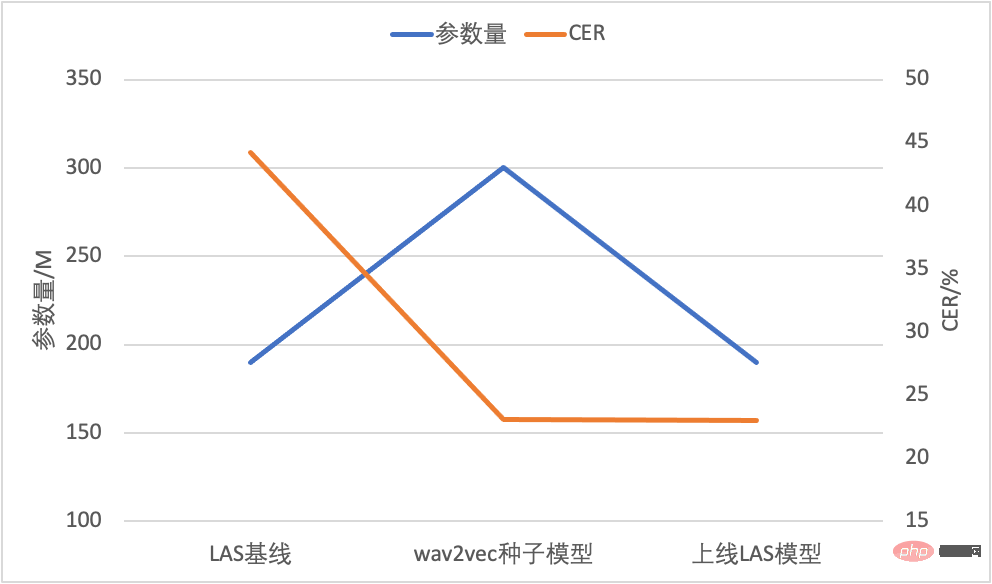

シード モデル トレーニングの第 2 段階は、古典的な「教師なし事前トレーニングと教師あり微調整」プロセスです。 この段階で、音響モデルが取得されます。これは通常、コネクショニスト時間分類 (CTC[3]) 損失関数に基づいて微調整されます。純粋なテキストでトレーニングされた言語モデルと音響モデルを組み合わせることで、良好な認識結果を達成できる完全な音声認識システムが形成されます。シード モデルと呼ばれる理由は、このモデルがビジネスに直接導入するのには適していないためであり、Volcano エンジンは LAS (Listen, Attend and Spell[4]) または RNN- を使用することを好みます。 T (リカレント ニューラル) ネットワーク トランスデューサー[5]) このタイプのエンドツーエンド モデルはオンラインで展開されます。 主な理由は、LAS/RNN-T が優れたエンドツーエンドのモデリング機能を備えていると同時に、近年従来の CTC モデルよりも優れた結果を達成しているためです。 、業界で広く使用されています。 Volcano Engine は、エンドツーエンドの音声認識モデルの推論と展開に関して多くの最適化作業を行い、多くのビジネスをサポートする比較的成熟したソリューションを形成しました。効果をロスなく維持しつつ、エンドツーエンドの推論エンジンを利用できれば、エンジンの運用保守コストを大幅に削減できます。 これに基づいて、チームはモデル移行フェーズである 3 番目のフェーズを設計しました。 主に知識の蒸留のアイデアを活用し、シード モデルを使用してラベルのないデータを疑似ラベルし、トレーニング用に少数のパラメーターを備えた LAS モデルを同期的に提供します。モデル構造の移行と推論計算の圧縮を実現します。 プロセス全体の有効性は広東 ASR で検証されており、具体的な実験結果は次の表に示されています。 #まず第一に、チームは実験比較のために 1kh の完成品データを購入しましたが、LAS モデルを直接トレーニングした場合のパフォーマンスは低く、文字エラー率 (CER) は 44.2% と高かったです。ボルケーノ エンジンでは分析の結果、調達データ(会話)とビジネス テスト セット(ビデオ)フィールドの不一致が主な原因であると考えており、wav2vec2.0 の予備実験でも同様の現象が確認されました。 最後に、火山エンジンはモデル移行の効果を検証し、広東語モデルを組み合わせて 50kh の言語をデコードしました。ラベルのないデータを使用して擬似ラベルを取得し、LAS モデルをトレーニングします。 擬似ラベルトレーニングに基づく LAS モデルは、基本的に CTC シード モデルの認識効果を維持でき、モデル パラメーターの数が 3 分の 1 に削減され、直接展開できることがわかります。オンラインの成熟したエンドツーエンド推論エンジンに基づいています。 #モデル パラメーターと CER の比較 最後に、モデル内でパラメーターの数が変わらないという前提の下で、チームは 50 時間のラベルなしビジネス データと 10 時間のラベル付きビジネス データを使用して、23.0% の CER を達成しました。これは、ベースライン モデルと比較して 48% 減少です。

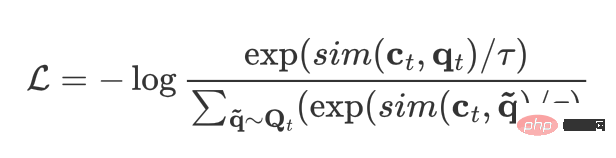

アルゴリズム最適化wav2vec2.0 は、2020 年にメタ AI によって提案された自己教師あり事前トレーニング モデルとして、教師なし表現を可能にしますスピーチの新たな章。中心となるアイデアは、量子化モジュールを使用して入力特徴を離散化し、比較学習の最適化を通じて、モデルの本体が BERT と同様のランダム マスク部分入力特徴を実現することです。 wav2vec2.0 モデルの構造図 (出典: wav2vec 2.0 図 1 [1]) ビジネス データで wav2vec 2.0 モデルをトレーニングするときに遭遇する問題が 2 つあります。 : 1 つは学習効率が低く、64 枚のカードを含む 300M の大きなモデルを完了するのに 10 日以上かかること、もう 1 つは学習が不安定で分岐しやすいことです。 この Volcano エンジンは、上記 2 つの問題を軽減するために効率的な wav2vec を提案します。 トレーニング効率が低いという問題に関して、チームはモデルのフレーム レートを下げ、入力特徴を波形からフィルターバンクに置き換えることでトレーニング速度を加速しました。フレームレートは元の 20ms から 40ms に変更されました。これにより、特徴抽出畳み込みの計算量が大幅に削減されるだけでなく、Transformer の内部エンコード長も大幅に短縮され、学習効率が向上します。学習が不安定であるという問題は、教師なし事前学習と総合判断による学習方法をビジネスデータの実態と組み合わせて分析することで解決され、比較学習損失は次の式で表されます。 各フレーム t について、ct はフレームのエンコーダ出力 を表します。 qt は、フレームの量子化された出力を表します。さらに、他のいくつかのフレームを負のサンプルとしてサンプリングする必要があるため、現在のフレームと負のサンプル フレームのセットは、動的に構築された語彙 Qt と同等になります。

上記の 2 つの問題を解決するために、Volcano エンジンは 2 つの改善を提案しました:

改良された効率的な wav2vec は、以前と比較して安定して 5% パフォーマンスが向上していることがわかります。オリジナルの wav2vec 2.0 に比べて、トレーニング効率がほぼ 2 倍になっています。 チームが提案した効率的なwav2vecは、アルゴリズムレベルで学習効率を2倍近く向上させましたが、300Mモデルの通信量が多いため、学習にはまだばらつきがあります。通信効率やマルチマシン拡張効率が低い。これに関して、Volcano Engine Voice チームは次のように結論付けています。「同期勾配シナリオにおけるモデルの事前トレーニングの通信効率を向上させるために、BytePS 分散トレーニング フレームワークに基づいた通信バックエンド上のバケット グループ通信最適化テクノロジを完成させました。データ並列効率は 10% の向上を達成できます。同時に、モデル パラメーター定義の順序と勾配更新順序の違いによって引き起こされる待機問題に対処するために、適応パラメーターの並べ替え (パラメーター リオーダー) 戦略も実装されています。」 ##これらの最適化をベースに、さらに勾配累積やその他の技術を組み合わせることで、300M モデルのシングルカード拡張効率は 55.42% から 81.83% に向上し、マルチマシン拡張効率は 60.54% から 91.13% に向上しました。 %. 当初トレーニングに 6.5 日かかったモデルは、現在ではわずか 4 日でトレーニングできるようになり、時間が 40% 短縮されました。 さらに、将来検討される大規模モデルのビッグデータ シナリオをサポートするために、Volcano Engine 音声チームはさらにシリーズを完成させました。超大規模モデルの原子能力構築。 まず、ローカル OSS テクノロジが実装され、オプティマイザが占有する冗長メモリのほとんどを削除しながらマシン間の拡張効率の問題を解決しました。その後、同期勾配でのバケットをサポートしました。 Lazy init は、ビデオ メモリの使用量をパラメータ数の 2 倍に削減し、ピーク メモリ値を大幅に削減し、ビデオ メモリ リソースが不足している非常に大規模なモデル シナリオに適応します。最後に、データ並列処理に基づいて、モデル並列処理とパイプライン並列処理がサポートされます。 、1B および 10B モデルでは検証とカスタマイズのサポートが完了しています。この一連の最適化により、大規模モデルとビッグデータのトレーニングのための強固な基盤が築かれます。 現在、低リソース ASR 実装プロセスを採用することで、2 つの低リソース言語がビデオ字幕とコンテンツ セキュリティ サービスの実装に成功しています。 wav2vec2.0 に基づく事前トレーニング モデルは、音声認識に加えて、オーディオ イベント検出、言語認識、感情検出など、他の多くの下流タスクでも大幅な向上を達成しており、ビデオ コンテンツのセキュリティにも段階的に実装される予定です。 、将来の推奨および分析、オーディオオフロード、電子商取引顧客サービスセンチメント分析およびその他の関連事業。 教師なし事前トレーニング テクノロジの実装により、さまざまな種類の音声データのラベル付けコストが大幅に削減され、ラベル付けサイクルが短縮され、ビジネス ニーズへの迅速な対応が実現されます。 実際には、Volcano Engine は wav2vec2.0 に基づいた一連の低リソース言語 ASR 実装ソリューションを検討してきました。問題を解決します。 高い推論オーバーヘッドの問題を解決し、エンドツーエンド エンジンとのシームレスな接続を実現します。 wav2vec2.0 のトレーニング効率の低さと不安定性という中心的な問題に対処するために、効率的な wav2vec が提案されました。 wav2vec2.0 と比較して、下流タスクへの効果が 5% 向上し、事前トレーニング時間が半分に短縮され、エンジニアリングの最適化と組み合わせることで、最終的な事前トレーニング時間はオリジナル バージョンと比較して 70% 短縮されました。 今後も、Volcano Engine は次の 3 つの方向への探求を続けていきます: Volcano Voice、長期サービス ByteDance の各ビジネスライン向けの最先端の音声テクノロジーは Volcano エンジンを通じて開かれ、業界をリードする AI 音声テクノロジー機能と優れた完全な機能を提供します。 -スタック音声製品 ソリューションには、音声理解、音声合成、仮想デジタル ヒューマン、会話型インタラクション、音楽検索、インテリジェント ハードウェアなどが含まれます。現在、Volcano Engine の音声認識と音声合成は複数の言語と方言をカバーしており、多くの技術論文がさまざまなトップ AI カンファレンスに選ばれており、Douyin、Jianying、Feishu、Tomato Novels、Pico およびその他のビジネスに主要な音声機能を提供しています。ショートビデオ、ライブブロードキャスト、ビデオ作成、オフィス、ウェアラブルデバイスなどのさまざまなシナリオに適しています。 参考文献 [1] Baevski, A.、Zhou, Y.、Mohamed, A.、Auli, M. 、2020. wav2vec 2.0: 音声表現の自己教師あり学習のためのフレームワーク. Advances in Neural Information Processing Systems, 33, pp.12449-12460. #[ 2] Hsu, W.N.、Bolte, B.、Tsai, Y.H.H.、Lakhotia, K.、Salakhutdinov, R.、Mohamed, A.、2021. Hubert: 隠れ単位のマスク予測による自己教師あり音声表現学習. IEEE /ACM Transactions on Audio, Speech, and Language Processing, 29, pp.3451-3460. ##[3] Graves, A.、Fernández, S.、Gomez, F. および Schmidhuber, J.、2006 年 6 月. コネクショニスト時間分類: リカレント ニューラル ネットワークによるセグメント化されていないシーケンス データのラベル付け. 第 23 回機械学習国際会議議事録 (pp. 369-376). #[4] Chan, W.、Jaitly, N.、Le, Q.、Vinyals, O.、2016 年 3 月、聞いて、参加して、綴る: 大量の語彙のためのニューラル ネットワーク会話型音声認識。2016 年の音響、音声、信号処理に関する IEEE 国際会議 (ICASSP) (pp. 4960-4964)。IEEE. [5] Graves, A.、2012 年。リカレント ニューラル ネットワークによるシーケンス変換。 arXiv プレプリント arXiv:1211.3711. [6] He、K.、Chen、X.、Xie、S.、Li、Y.、Dollár、Pマスクされたオートエンコーダは、スケーラブルな視覚学習器です。コンピューター ビジョンとパターン認識に関する IEEE/CVF 会議議事録 (pp. 16000-16009). [7] Baevski, A.、Hsu、 W.N.、Xu、Q.、Babu、A.、Gu, J.、Auli, M.、2022年。 Data2vec: 音声、視覚、言語における自己教師あり学習のための一般的なフレームワーク。 arXiv プレプリント arXiv:2202.03555. [8] Conneau, A.、Baevski, A.、Collobert, R.、Mohamed, A.、および Auli, M ., 2020. 音声認識のための教師なし異言語表現学習。 arXiv プレプリント arXiv:2006.13979. [9] Lu, Y.、Huang, M.、Qu, X.、Wei, P.、および Ma, Z 、2022年5月。スパース共有サブネットワークを使用した言語適応型クロスリンガル音声表現学習。 ICASSP 2022-2022 IEEE 音響、音声および信号処理に関する国際会議 (ICASSP) (pp. 6882-6886)。 IEEE. [10] Park, D.S.、Zhang, Y.、Jia, Y.、Han, W.、Chiu, C.C.、Li, B. 、Wu、Y. および Le、Q.V.、2020 年。自動音声認識のための騒々しい学生のトレーニングを改善しました。 arXiv プレプリント arXiv:2005.09629.

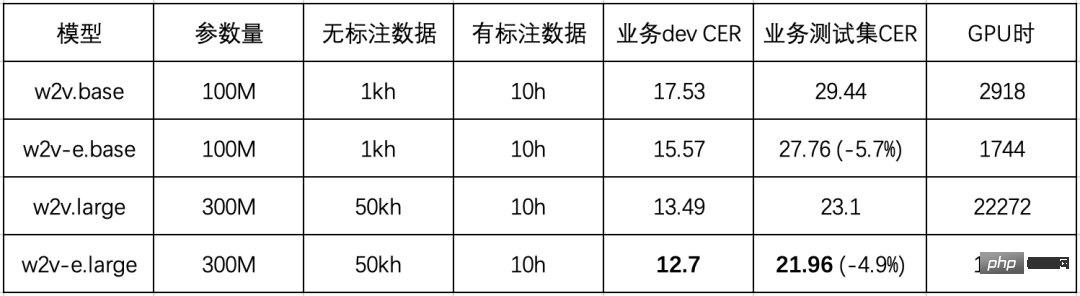

wav2vec2.0 (w2v) と Efficient wav2vec (w2v-e) のビジネス データへの効果を比較した結果、次の表に示す結果が得られました (全モデル)はトレーニングに 64 個の V100 GPU を使用しています):

エンジニアリングの最適化

以上がHuoshan Voice の教師なし事前トレーニング技術と「アルゴリズムの最適化 + エンジニアリングの革新」の実装を徹底調査の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。