清華チームによるもう 1 つのオープンソースの傑作である「クリックベイト」を排除してください。

名前をつけるのが苦手な私にとって、高校の小論文で一番困るのは、いい記事は書けるけど、どんなタイトルを付ければいいのかわからないということです。タイトルを考えるたびに髪の毛が大量に抜けてしまいました....

最近、ついにGitHubで大規模な「Name Waste」の光を発見しました。清華大学と OpenBMB オープン ソース コミュニティによってリリースされた興味深いアプリケーション: 「Outsmart」「タイトル」にテキストの内容を入力すると、ワンクリックでホットなタイトルを生成できます。

箱から出してすぐに使えます。使ってみた感想は、「香りがいい!」ということだけです。

オンライン体験: https://live.openbmb.org/ant

GitHub: https://github.com/OpenBMB/CPM-Live

この見出しを作るアーティファクトに関しては、次のことについて話さなければなりません。まずはその「オントロジー」、つまり大規模モデル CPM-Ant について話しましょう。

CPM-Ant は、中国で初めてライブ トレーニングされた数百億モデルです。トレーニングには 68 日間かかり、2022 年 8 月 5 日に完了し、OpenBMB によって正式にリリースされました。

- #5 つの優れた機能 ##4 つの革新的なブレークスルー

- ##トレーニング プロセスは低コストで環境に優しいです。

- #最も重要なことは、完全にオープンソースであることです。

- 中国の大規模モデルの最初のライブ トレーニングとして、CPM-Ant は大規模モデルのトレーニング、微調整、圧縮、推論、アプリケーションなどで実現可能なソリューションを提供します。実践的な計画では、さまざまなフォロワーにさまざまなヘルプと参考情報を提供したいと考えています。

それでは、CPM-Ant リリース結果コンテンツ レポートを見てみましょう。

モデルの概要CPM-Ant は、10B パラメーターを備えたオープンソースの中国語の事前トレーニング済み言語モデルであり、CPM-Live ライブ トレーニング プロセスの最初のマイルストーンでもあります。

トレーニング プロセス全体は低コストで環境に優しいです。高いハードウェア要件やランニング コストを必要としません。デルタ チューニング手法に基づいており、CUGE ベンチマークで優れた結果を達成しています。テスト。CPM-Ant 関連のコード、ログ ファイル、およびモデル パラメーターは、オープン ライセンス契約に基づいて完全にオープン ソースです。 OpenBMB は、完全なモデルに加えて、さまざまなハードウェア構成に適合するさまざまな圧縮バージョンも提供します。

#CPM-Ant の 5 つの優れた機能:

# (1) 計算効率

BMTrain[1] ツールキットを使用すると、分散コンピューティング リソースの機能を最大限に活用して、大規模なモデルを効率的にトレーニングできます。

CPM-Ant のトレーニングは 68 日間続き、費用は 43 万元でした。これは、Google による T5-11B モデルのトレーニング費用約 130 万ドルの 20 分の 1 です。訓練用 CPM-Ant の温室効果ガス排出量は約 4872kg CO₂e ですが、訓練用 T5-11B の排出量は 46.7t CO₂e[9]で、CPM-Ant ソリューションはその排出量の約 1/10 です。

(2) 優れたパフォーマンス

OpenDelta[3] ツールを使用すると、インクリメンタルな実行が非常に便利です。 CPM-Ant をダウンストリーム タスクに適応させる微調整。

実験の結果、CPM-Ant は 630 万個のパラメーターを微調整するだけで、3/6 CUGE タスクで最高の結果が得られることがわかりました。この結果は他のフルパラメータ微調整モデルを上回っており、例: CPM-Ant の微調整パラメータ数は CPM2 (微調整 11B パラメータ) のわずか 0.06% です。

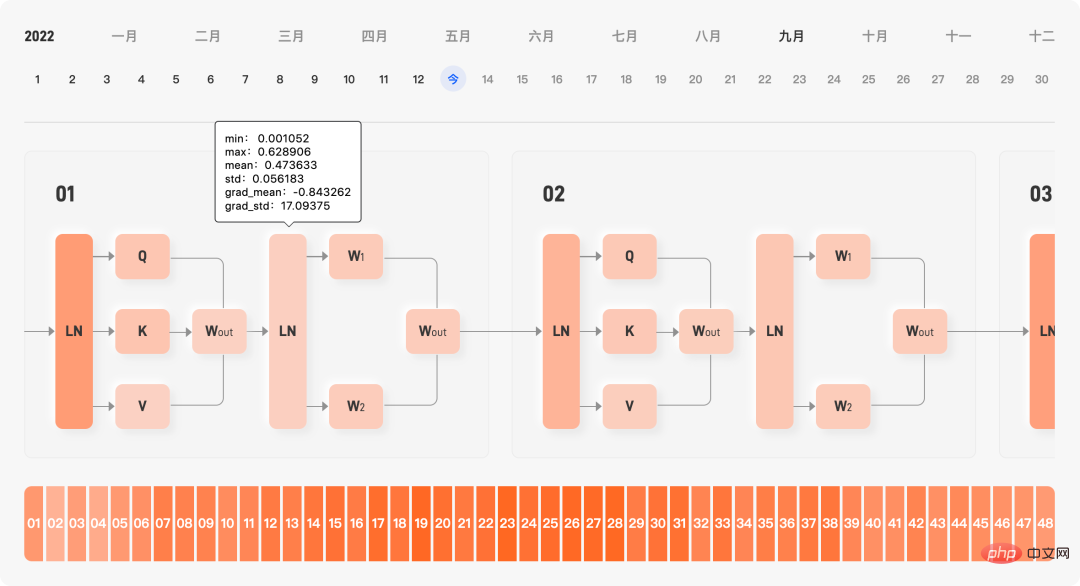

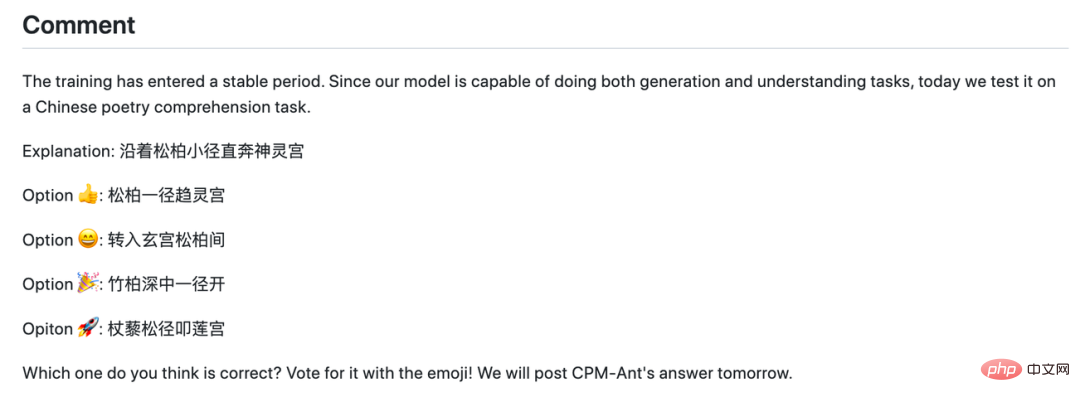

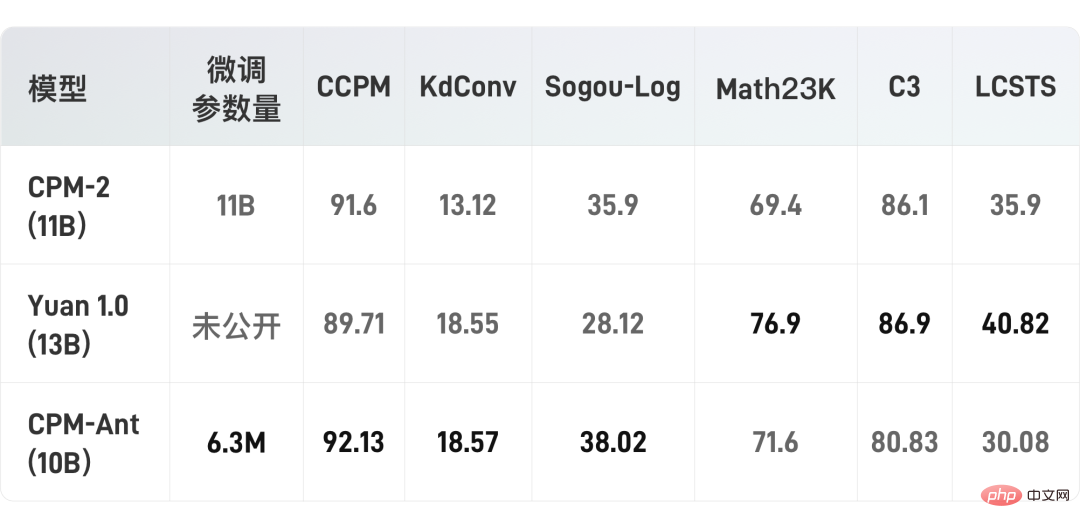

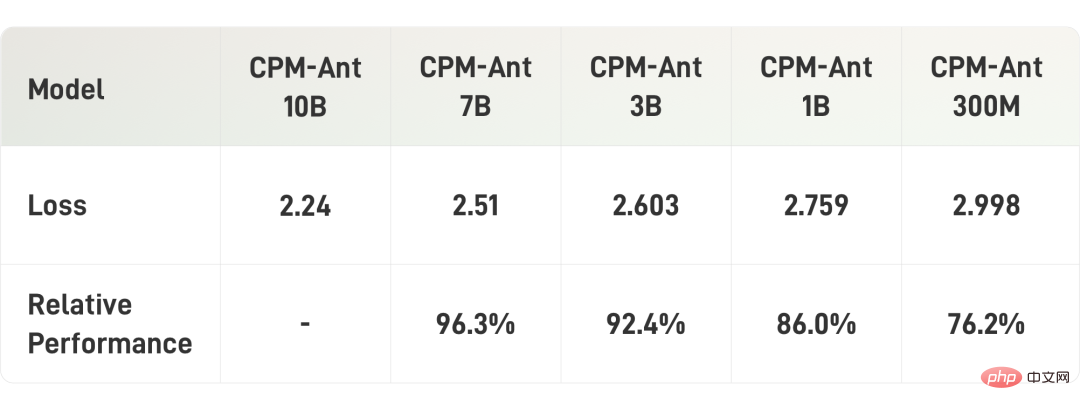

(3) 導入の経済性

BMCook[7] および BMInf[4] ツールキットの助けを借りて、限られたコンピューティング リソースで CPM-Ant を駆動できます。 BMInf に基づいて、コンピューティング クラスターを置き換え、単一の GPU (GTX 1060 などのコンシューマー グレードのグラフィック カードでも) で大規模なモデル推論を実行できます。 CPM-Ant の導入をより経済的にするために、OpenBMB は BMCook を使用して、元の 10B モデルをさまざまなバージョンにさらに圧縮します。圧縮モデル (7B、3B、1B、300M) は、さまざまな低リソース シナリオのニーズに適応できます。 (4) 使いやすさ オリジナルの 10B モデルであっても、関連する圧縮バージョンであっても、数行のコードで簡単にロードして実行できます。 OpenBMB は CPM-Ant を ModelCenter[8] に追加し、モデルのさらなる開発を容易にします。 (5) オープンデモクラシー CPM-Ant のトレーニングプロセスは完全にオープンです。 OpenBMB は、すべてのコード、ログ ファイル、モデル アーカイブをオープン アクセスとして公開します。また、CPM-Antは商用化を可能にするオープンライセンスを採用しています。 大規模モデルのトレーニングが可能なメーカーや研究機関にとって、CPM-Ant トレーニング プロセスは、中国の大規模モデルの完全な実践記録を提供します。トレーニング。 OpenBMB は、CPM-Live シリーズのモデルのモデル設計、トレーニング スキーム、データ要件、実装コードをリリースしました。 CPM-Live のモデル アーキテクチャに基づいて、大規模なモデル トレーニング プログラムを迅速かつ簡単に設計および実装し、関連するビジネス データを整理してモデルの事前調査とデータ準備を完了することができます。 公式 Web サイトでは、損失関数、学習率、学習データ、スループット、勾配サイズ、コスト曲線、モデルの内部パラメーターなど、トレーニング プロセス中のすべてのトレーニング ダイナミクスが記録されます。これらのトレーニング ダイナミクスを通じて、ユーザーはモデルのトレーニング プロセスに問題があるかどうかを迅速に診断できます。 #モデルトレーニングの内部パラメータのリアルタイム表示 さらに、OpenBMB の研究開発学生は、トレーニング記録の概要を毎日リアルタイムで更新します。この概要には、損失値、勾配値、全体的な進捗状況が含まれます。また、トレーニング プロセス中に発生した問題やバグも記録されます。ユーザーは、モデルのトレーニング プロセスで遭遇する可能性のあるさまざまな「落とし穴」を事前に理解できます。 モデルのトレーニングが「落ち着いている」日には、研究開発担当者はいくつかの有名な引用を述べたり、最新の論文を紹介したり、推測アクティビティを開始したりすることもあります。 #ログ内の推測アクティビティ さらに、OpenBMB も実際に大規模なモデルのトレーニングを必要としている企業では、関連するトレーニング高速化テクノロジを通じて、トレーニング コストが許容可能なレベルまで削減されています。 BMTrain[1] ツールキットを使用すると、数百億の大規模モデル CPM-Ant をトレーニングする計算コストはわずか 430,000 元です (現在のコストはパブリック クラウドの価格に基づいて計算されています) 、実際のコストはこれより低くなります )。これは、11B 大型モデル T5 の外部推定コスト 130 万ドルの約 1/20 です。 CPM-Ant は下流タスクの適応にどのように役立ちますか? 大規模モデルの研究者向けに、OpenBMB はパラメータの効率的な微調整に基づく大規模モデルのパフォーマンス評価ソリューションを提供します。これにより、下流のタスクの迅速な適応とモデルのパフォーマンスの評価が容易になります。 パラメーターの効率的な微調整、つまりデルタ チューニングを使用して、6 つのダウンストリーム タスクにおける CPM-Ant のパフォーマンスを評価します。実験では LoRA [2] が使用されました。これは、各注目層に 2 つの調整可能な低ランク行列を挿入し、元のモデルのすべてのパラメーターをフリーズします。このアプローチを使用すると、タスクごとに 630 万個のパラメーターのみが微調整され、パラメーター全体の 0.067% にすぎません。 OpenDelta[3] の助けを借りて、OpenBMB は元のモデルのコードを変更することなくすべての実験を実施しました。ダウンストリーム タスクで CPM-Ant モデルを評価する際には、データ拡張手法は使用されなかったことに注意してください。実験結果を次の表に示します。 いくつかのパラメーターを微調整するだけで、OpenBMB モデルが良好にパフォーマンスしたことがわかります。 3 つのデータセットでのパフォーマンスは、CPM-2 および Source 1.0 を上回りました。 一部のタスク (LCSTS など) は、微調整されたパラメーターがほとんどない場合、学習が難しい場合があります。CPM-Live のトレーニング プロセスは続行され、各タスクのパフォーマンスが向上します。さらに磨きをかけます。 興味のある学生は、以下の GitHub リンクにアクセスして、まず CPM-Ant と OpenDelta を体験し、他のタスクでの CPM-Ant の機能をさらに探索してください。 https://github.com/OpenBMB/CPM-Live 大規模モデルのパフォーマンスは驚くべきものですが、高いハードウェア要件とランニング コストが常に多くのユーザーを悩ませてきました。大規模モデルのユーザー向けに、OpenBMB は、さまざまなハードウェア環境でさまざまなモデル バージョンをより簡単に実行できる、ハードウェアに優しい一連の使用方法を提供します。 BMInf[4] ツールキットを使用すると、シングル カード 1060 などの低リソース環境でも CPM-Ant を実行できます。 さらに、OpenBMB は CPM-Ant も圧縮します。これらの圧縮モデルには、CPM-Ant-7B/3B/1B/0.3B が含まれます。これらのモデル圧縮サイズはすべて、既存のオープンソースの事前トレーニング済み言語モデルの従来のサイズに対応できます。 ユーザーがリリースされたチェックポイントでさらなる開発を実行できることを考慮して、OpenBMB は主にタスクに依存しない構造化プルーニングを使用して CPM-Ant を圧縮します。枝刈りプロセスも段階的に行われ、10B から 7B、7B から 3B、3B から 1B、そして最後に 1B から 0.3B になります。 特定の枝刈りプロセスでは、OpenBMB は動的学習可能なマスク行列をトレーニングし、このマスク行列を使用して対応するパラメーターを枝刈りします。最後に、パラメーターは、ターゲットのスパース性に基づいて決定されるマスク行列のしきい値に従って枝刈りされます。圧縮の詳細については、技術ブログ [5] を参照してください。 次の表は、モデル圧縮の結果を示しています。 これで、ハードコア コンテンツは次のようになります。では、大きなモデルは「タイトルの選択」にどのように役立つでしょうか? CPM-Ant に基づいて、すべての大規模モデル開発者と愛好家が開発できます。興味深いテキストの楽しいアプリケーションです。 モデルの有効性をさらに検証し、例を提供するために、OpenBMB は CPM-Ant に基づいてホット タイトル ジェネレーターを微調整し、モデルの機能を実証しました。 下のテキスト ボックスにテキスト コンテンツを貼り付け、クリックして生成するだけで、大きなモデルが提供する刺激的なタイトルを取得できます。 #CPM-Ant 実績レポートの最初の記事のタイトルは、ジェネレーターによって生成されます このデモは継続的に改良され、ユーザー エクスペリエンスを向上させるために将来さらに特殊効果が追加される予定です。 興味のあるユーザーは、CPM-Ant を使用してビルドすることもできます。独自の表示アプリケーション。アプリケーションのアイデアがある場合、技術サポートが必要な場合、またはデモの使用中に問題が発生した場合は、いつでも CPM-Live フォーラム [6] でディスカッションを開始できます。 CPM-Ant のリリースは CPM-Live の最初のマイルストーンですが、これはトレーニングの第 1 段階にすぎず、OpenBMB は今後も一連のトレーニングを実施していきます。 簡単にネタバレすると、多言語サポートや構造化された入出力などの新機能が次のトレーニング期間に追加される予定です。 プロジェクト GitHub アドレス: https://github.com/OpenBMB/CPM -ライブ デモ体験アドレス (PC アクセスのみ): https://live.openbmb.org/ant 完全な大規模モデル トレーニングの実践

SOTA を繰り返し作成した効率的な微調整ソリューション

ハードウェアに適した一連の推論メソッド

予想外に興味深い大規模モデル アプリケーション

ポータル|プロジェクト リンク

以上が清華チームによるもう 1 つのオープンソースの傑作である「クリックベイト」を排除してください。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7442

7442

15

15

1371

1371

52

52

76

76

11

11

9

9

6

6

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

顔の検出および認識テクノロジーは、すでに比較的成熟しており、広く使用されているテクノロジーです。現在、最も広く使用されているインターネット アプリケーション言語は JS ですが、Web フロントエンドでの顔検出と認識の実装には、バックエンドの顔認識と比較して利点と欠点があります。利点としては、ネットワーク インタラクションの削減とリアルタイム認識により、ユーザーの待ち時間が大幅に短縮され、ユーザー エクスペリエンスが向上することが挙げられます。欠点としては、モデル サイズによって制限されるため、精度も制限されることが挙げられます。 js を使用して Web 上に顔検出を実装するにはどうすればよいですか? Web 上で顔認識を実装するには、JavaScript、HTML、CSS、WebRTC など、関連するプログラミング言語とテクノロジに精通している必要があります。同時に、関連するコンピューター ビジョンと人工知能テクノロジーを習得する必要もあります。 Web 側の設計により、次の点に注意してください。

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

マルチモーダル文書理解機能のための新しい SOTA!アリババの mPLUG チームは、最新のオープンソース作品 mPLUG-DocOwl1.5 をリリースしました。これは、高解像度の画像テキスト認識、一般的な文書構造の理解、指示の遵守、外部知識の導入という 4 つの主要な課題に対処するための一連のソリューションを提案しています。さっそく、その効果を見てみましょう。複雑な構造のグラフをワンクリックで認識しMarkdown形式に変換:さまざまなスタイルのグラフが利用可能:より詳細な文字認識や位置決めも簡単に対応:文書理解の詳しい説明も可能:ご存知「文書理解」 「」は現在、大規模な言語モデルの実装にとって重要なシナリオです。市場には文書の読み取りを支援する多くの製品が存在します。その中には、主にテキスト認識に OCR システムを使用し、テキスト処理に LLM と連携する製品もあります。

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません