人工知能では大きな出来事が起こっており、LeCun も変革しました

シンボル処理は、論理、数学、コンピューター サイエンスで一般的なプロセスであり、思考を代数演算として扱います。 70 年近くにわたり、人工知能の分野における最も基本的な議論は、人工知能システムが記号処理に基づくべきか、それとも人間の脳に似た神経システムに基づくべきかということでした。

実際には、中間点として 3 番目の可能性、つまりハイブリッド モデルがあります。ハイブリッド モデルは、ニューラル ネットワークのデータ駆動型学習と記号処理の強力な抽象化機能を組み合わせることにより、両方の利点を最大限に活用しようとします。ここは私がキャリアのほとんどを費やしてきた場所でもあります。

NOEMA 誌に掲載された最近の記事では、チューリング賞受賞者でメタ社の主任人工知能科学者であるヤン・ルカン氏と、ルカン研究所の「常駐哲学者」であるジェイコブ・ブラウニング氏もこの論争に関与していると述べています。この記事は新しい代替案を提供しているように見えますが、詳しく調べてみると、そのアイデアは新しいものでも説得力のあるものでもないことがわかります。

Yann LeCun と Jacob Browning は、NOEMA 誌に掲載された記事で初めて「ディープラーニングが壁にぶつかった」という考えに対して正式に回答し、次のように述べています。冒頭、批評家らは「ニューラル ネットワークが乗り越えられない壁にぶつかっていると時期尚早に信じているが、そのたびに一時的な障害にすぎないことが判明した。」

記事の冒頭で、批評家はハイブリッド モデルに反対しているようです。として定義されることが多く、ニューラル ネットワークの深層学習とシンボル処理を組み合わせたシステムです。しかし最後までに、ルカン氏は、珍しく多くの言葉で、ハイブリッド システムが存在すること、つまりそれが重要であり、前進する可能性があること、そして私たちがそれを常に知っていることを認めました。記事自体が矛盾しています。

なぜこのような矛盾が生じるのかというと、ルカンとブラウニングが記号処理を学習するモデルはハイブリッドモデルではないとなぜか信じているということしか考えられません。しかし、学習は発展途上の問題 (システムはどのようにして生じるのか?) であり、開発されたシステムが (1 つまたは 2 つのメカニズムで) どのように機能するかは計算問題です。合理的な尺度から見て、シンボリック ネットワーク メカニズムとニューラル ネットワーク メカニズムの両方を利用するシステムはハイブリッド システムです。 。 (おそらく、彼らが本当に言いたいのは、AI は生得的なハイブリッドではなく、学習されたハイブリッドに近いということです。しかし、学習されたハイブリッドもハイブリッドであることに変わりはありません。)

2010 年頃、シンボリック処理は深層学習の支持者によって悪い言葉とみなされていました。 ; 2020 年、シンボリック処理の起源を理解することが私たちの最優先事項になりました。

私は、記号処理は生得的なものであるか、あるいは記号処理の習得に間接的に寄与するものがあると考えています。システムが記号の抽象化を学習できる基盤が何かを早く理解すればするほど、世界中のすべての知識を適切に活用するシステムをより早く構築できるようになり、システムの安全性、信頼性、説明可能性がより早く向上します。

しかし、まず最初に、人工知能開発の歴史におけるこの重要な議論の詳細を理解する必要があります。

初期の AI の先駆者であるマービン ミンスキーとジョン マッカーシーは、記号処理が今後の唯一の合理的な方法であると信じていましたが、ニューラル ネットワークの先駆者であるフランク ローゼンブラットは、AI はニューロンのような「ノード」セットの融合を中心に構築される方がよいと信じていました。データの構造を操作して統計の重労働を行うことができます。

これら 2 つの可能性は相互に排他的ではありません。人工知能で使用される「ニューラル ネットワーク」は、文字通りの生物学的なニューロン ネットワークではありません。代わりに、これは実際の生物学的な脳にある程度似ていますが、複雑さは最小限に抑えられた簡略化されたデジタル モデルです。原理的には、これらの抽象ニューロンはさまざまな方法で接続でき、そのうちのいくつかは論理的および記号的処理を直接可能にすることができます。この可能性は、この分野の最も初期の論文の 1 つである「神経活動に内在するアイデアの論理計算」において 1943 年には明確に認められていました。

1950 年代のフランク ローゼンブラットと 1980 年代のデビッド ルメルハートとジェイ マクレランドは、シンボル処理の代替手段としてニューラル ネットワークを提案し、ジェフリー ヒントンはこの立場を一般に支持しました。

ここで語られない歴史は、2010 年代初頭に、LeCun、Hinton、Yoshua Bengio が、ようやく実用になりつつある多層ニューラル ネットワークに非常に熱中していたために、シンボル処理を完全に廃止したいと考えていたということです。 。 2015 年までに、ディープ ラーニングはまだ気ままで熱心な時代にあり、ルカン、ベンジオ、ヒントンはネイチャー誌にディープ ラーニングに関するマニフェストを書きました。この記事はシンボルへの攻撃で終わり、「シンボル式に対するルールベースの演算を大きなベクトルに対する演算に置き換える新しいパラダイムが必要である」と主張している。

実際、ヒントンはシンボル処理が行き詰まりであると強く確信していたので、同じ年にスタンフォード大学で「エーテリアルシンボル」と呼ばれる講義を行い、シンボルを科学史上最大の間違いの一つに喩えました。

同様に、ヒントンの共同研究者であるルメルハートとマクレランドも1980年代に同様の指摘をし、1986年の本の中でシンボルは「人間の計算の本質」ではないと主張した。

私が 2018 年にシンボル処理を擁護する記事を書いたとき、LeCun は Twitter で私のハイブリッド システムの見解を「ほとんど間違っている」と呼びました。当時、ヒントンはまた、私の仕事を「ガソリンエンジン」で時間を無駄にしていることに喩え、「電気エンジン」が最善の方法であるとも言いました。 2020年11月にもヒントン氏は「ディープラーニングであらゆることができるようになる」と主張した。

したがって、LeCun と Browning が今、皮肉を込めずに「深層学習に取り組んでいる誰もが、人間に似た AI を作成するには記号処理が必要な機能であることに同意している」と書いているとき、彼らは数十年にわたる議論の歴史を覆すことになります。スタンフォード大学の人工知能教授クリストファー・マニング氏は、「ルカン氏の立場はいくぶん変化した。」

明らかに、10年前の手法はもはや適用できない。 。

2010 年代、機械学習コミュニティの多くの人が、(実際の証拠なしに)「シンボルは生物学的にありえない」と主張しました。 10 年後、LeCun は、生得的か学習的かを問わず、記号処理を伴う新しいアプローチを検討していました。記号処理が重要であるという LeCun と Browning の新しい見解は、深層学習の分野にとって大きな譲歩を意味します。

人工知能の歴史家は、ディープ ラーニング トリオの 1 人である LeCun がハイブリッド AI の必然性を直接認めた最初の人物である NOEMA 誌の記事を大きな転換点として考慮する必要があります。

今年初めに、深層学習ビッグ 3 の他のメンバー 2 人もハイブリッド AI システムへの支持を表明したことは注目に値します。コンピュータ科学者の Andrew Ng 氏と LSTM の共同作成者である Sepp Hochreiter 氏も、そのようなシステムへの支持を表明しています。ユルゲン・シュミットフーバー氏の AI 企業 NNAISANCE は現在、記号処理と深層学習の組み合わせに関する研究を行っています。

LeCun と Browning の記事の残りの部分は、おおまかに 3 つの部分に分けることができます:

- 私の立場の誤った特徴付け;

- ハイブリッド モデルを縮小する取り組み範囲;

- シンボル処理が生得的ではなく学習される理由について話し合います。

たとえば、LeCun と Browning は次のように述べています。「マーカスは、最初に記号操作ができなければ、後でそれもできないと信じています。実際、私は 2001 年の著書『The Algebraic Mind』で次のことを明確にしました: 記号処理が生来のものであるかどうかはわかりません。

彼らはまた、私がディープラーニングに「これ以上の進歩はない」と予想しているとも言いましたが、私の実際の言いたいことは、どの問題についてもこれ以上の進歩はないということではなく、ディープラーニングは次のような特定のタスクには役立つということでした。組み合わせとして、それ自体が性的問題や因果推論の問題に対する間違ったツールです)。

彼らはまた、「記号推論はモデルにとってオール・オア・ナッシングであると私は考えています。DALL-E は処理の基礎として記号や論理規則を使用せず、実際には記号を使用しないからです。」とも言いました。 「理屈だよ」と言うと、私はそんなことは言いませんでした。 DALL·E は記号を使用して推論しませんが、これは、記号推論を含むシステムがオール オアナッシングでなければならないという意味ではありません。少なくとも 1970 年代の時点では、エキスパート システム MYCIN には、あらゆる種類の定量的推論を実行できる純粋に記号的なシステムがありました。

「学習されたシンボルを含むモデルはハイブリッド モデルではない」と仮定することに加えて、彼らはまた、ハイブリッド モデルを「微分不可能なシンボル プロセッサを含むモデル」と同一視しようとしています。彼らは、私がハイブリッド モデルを「パターン補完深層学習モジュールの上にハードコーディングされた記号処理モジュールを挿入するという 2 つの単純な組み合わせ」と同等だと考えています。実際、ニューラル シンボルに実際に取り組んでいるすべての人々、AI に取り組んでいる人々、仕事はそれほど単純ではないことを理解してください。

むしろ、誰もが認識しているように、問題の核心はハイブリッド システムを構築する正しい方法です。シンボリック ネットワークとニューラル ネットワークを組み合わせるためのさまざまな方法が検討されており、ニューラル ネットワークからシンボリック ルールを抽出する、シンボリック ルールをニューラル ネットワークに直接変換する、ニューラル ネットワークとシンボリック システムの間で情報を受け渡すことができる中間システムを構築するなどの技術に焦点を当てています。そしてニューラルネットワーク自体を再構築します。多くの道が模索されています。

最後に、最も重要な質問を見てみましょう。シンボル処理は、最初から組み込まれているのではなく、学習を通じて学習できるのでしょうか?

私は率直に答えました: もちろんです。私の知る限り、記号処理が学習できることを否定する人はいません。私は 2001 年に『代数的思考』のセクション 6.1 でこの質問に答えました。その可能性は低いとは思いましたが、絶対に不可能だとは言いませんでした。代わりに、私は次のように結論付けました:「これらの実験と理論は、シンボル処理能力が生得的であることを保証するものではありませんが、アイデアには当てはまります。」

全体として、私の要点は 2 つの部分で構成されます。 1 つ目は「学習可能性」の観点です。代数的思考を通じて、特定のタイプのシステム (基本的には今日のより深いシステムの前身) が失敗することを示しています。シンボル処理のさまざまな側面が学習されるため、どのシステムでも学習できるという保証はありません。シンボル処理を学びます。私の本の最初の言葉にあるように、

いくつかのことは生まれつきのものでなければなりません。しかし、「自然」と「育ち」の間には真の対立はありません。自然は、私たちが環境と対話できるようにする一連のメカニズム、世界から知識を抽出するための一連のツール、およびこの知識を活用するための一連のツールを提供します。生来の学習ツールがなければ、私たちはまったく学習できません。発達心理学者のエリザベス・スペルケはかつてこう言いました。「いくつかの開始点(オブジェクト、セット、記号処理用のデバイスなど)が組み込まれたシステムは、実際、ルカン自身の畳み込みニューラル ネットワークに関する最も有名な研究でも、この点を説明できます。

2 番目の点は、人間の幼児が記号処理能力の証拠を示しているということです。私の研究室でよく引用される一連のルール学習実験では、幼児は訓練された特定の例を超えて、さまざまな抽象パターンを一般化しました。人間の幼児の暗黙の論理的推論能力に関する追跡調査により、これがさらに確認されるでしょう。

残念ながら、ルカン氏とブラウニング氏は私の指摘の両方を完全に避けています。奇妙なことに、彼らは代わりに、学習記号を「地図、絵画的表現、儀式、さらには社会的役割」など、後に獲得したものと同一視しているが、私や他の数人の認知科学者が認知科学の膨大な文献から学んだことには明らかに気づいていないようだ。子羊が生まれてすぐに丘を這い下りることができるのであれば、なぜ初期のニューラル ネットワークに少しのシンボル処理を追加できないのでしょうか?

最後に、ルカンとブラウニングがなぜ行くのかは不可解です。シンボル処理の本質的な性質に反対するために、そこまでのことを主張するのですか? 彼らは、シンボル処理の本質的な性質に対して強力な原則に基づいた議論を提供していませんし、それを証明するための原則に基づいた理由も示していません。シンボル処理は学習されます。

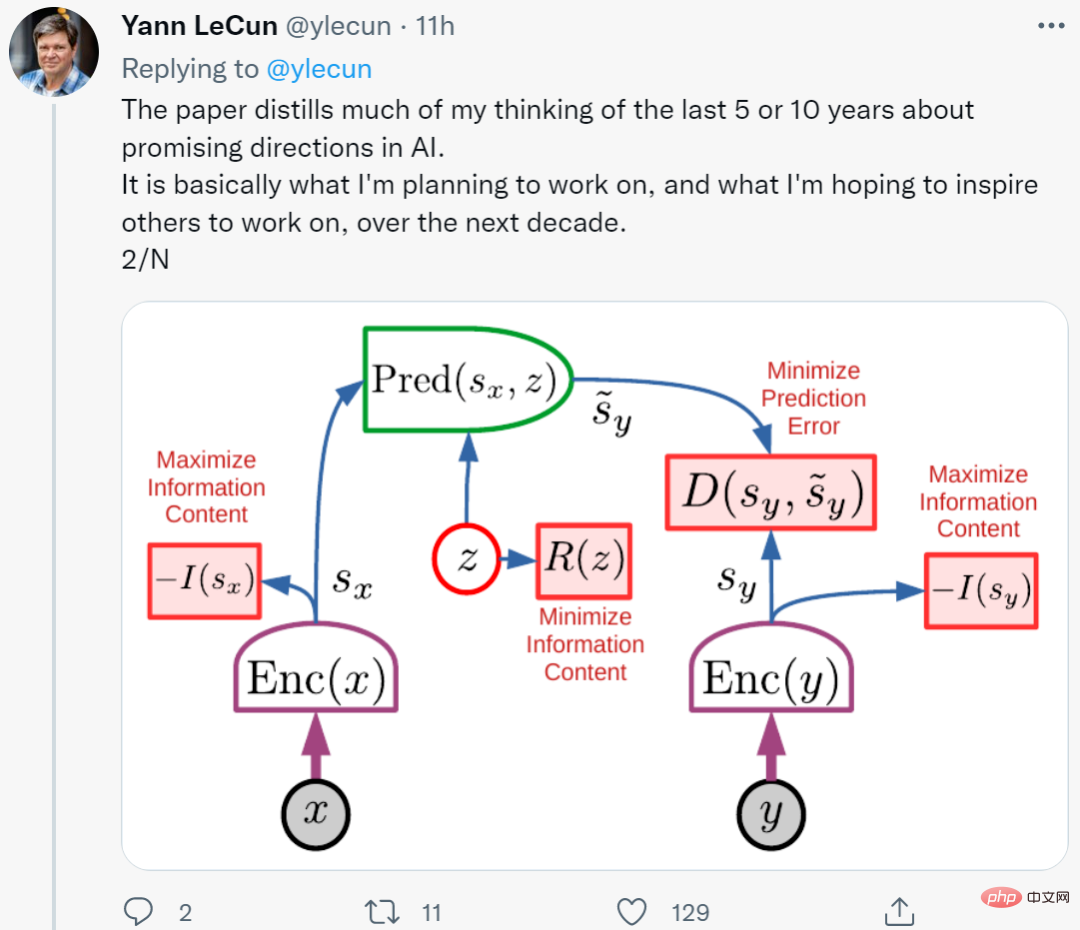

## LeCun の最新の研究には、いくつかの「生来の」シンボル処理が含まれていることは注目に値します。彼が最近発表した新しいアーキテクチャは全体で 6 つのモジュールで構成されており、そのほとんどは調整可能ですが、すべてが内蔵されています。さらに、言語モデルには固有の記号処理メカニズムがないため、LeCun と Browning は、言語の理解と推論においてよく知られている特定の問題を解決する方法を指定していません。

20 年にわたる「代数的思考」の影響で、現在のシステムは、膨大なデータセットとトレーニングに直面しても、記号処理 (乗算など) を依然として確実に抽出することができません。人間の幼児や幼児の例は、人間が正式な教育を受ける前に、自然言語と推論(おそらく本質的には象徴的)の複雑な概念を一般化できることを示しています。

#少し記号を組み込むだけで、学習効率が大幅に向上します。 LeCun 自身の畳み込み (ニューラル ネットワークの接続方法に関する組み込みの制約) での成功は、この状況をよく示しています。 AlphaFold 2 の成功の一部は、慎重に構築された分子生物学の固有の表現に由来しており、もう 1 つの部分はモデルの役割に由来しています。 DeepMind の新しい論文では、ターゲットに関する生来の知識に関する体系的な推論の構築においてある程度の進歩があったと述べています。 そして、ルカンとブラウニングが何も言ってもそれは変わりません。 一歩下がって、世界は大きく 3 つの部分に分けることができます。- 工場に完全に設置されたシンボル処理装置を備えたシステム (ほぼすべての既知のプログラミング言語など)。

- 生得的な学習デバイスを備えたシステムには記号処理がありませんが、適切なデータとトレーニング環境があれば、記号処理を取得するには十分です。

- 十分なトレーニングを行ったとしても、完全なシンボル処理メカニズムを備えたシステムを取得することはできません。

以上が人工知能では大きな出来事が起こっており、LeCun も変革しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7730

7730

15

15

1643

1643

14

14

1397

1397

52

52

1290

1290

25

25

1233

1233

29

29

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

エディター | Radish Skin 2021 年の強力な AlphaFold2 のリリース以来、科学者はタンパク質構造予測モデルを使用して、細胞内のさまざまなタンパク質構造をマッピングし、薬剤を発見し、既知のあらゆるタンパク質相互作用の「宇宙地図」を描いてきました。ちょうど今、Google DeepMind が AlphaFold3 モデルをリリースしました。このモデルは、タンパク質、核酸、小分子、イオン、修飾残基を含む複合体の結合構造予測を実行できます。 AlphaFold3 の精度は、これまでの多くの専用ツール (タンパク質-リガンド相互作用、タンパク質-核酸相互作用、抗体-抗原予測) と比較して大幅に向上しました。これは、単一の統合された深層学習フレームワーク内で、次のことを達成できることを示しています。

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス