Google チームがパノラマ セグメンテーション ソリューションを最適化する新しい Transformer を発表

最近、Google AI チームは、Transformer と DETR からインスピレーションを得た、Mask Transformer を使用したパノラマ セグメンテーションのためのエンドツーエンド ソリューションを提案しました。

正式名称は、マスク トランスフォーマーを使用したパノプティック セグメンテーションのエンドツーエンド ソリューションで、主にセグメンテーション MaskTransformer アーキテクチャの拡張機能を生成するために使用されます。

このソリューションでは、ピクセル パス (畳み込みニューラル ネットワークまたはビジュアル トランスフォーマーで構成) を使用してピクセル特徴を抽出し、メモリ パス (トランスフォーマー デコーダー モジュールで構成) でメモリ特徴を抽出し、デュアル パスを使用します。ピクセルの特徴とメモリ間の相互作用の特性のためのトランスフォーマー。

ただし、クロスアテンションを利用したデュアルパス Transformer は、もともと言語タスク用に設計されており、その入力シーケンスは数百の単語で構成されています。

視覚的なタスク、特にセグメンテーションの問題の場合、入力シーケンスは数万のピクセルで構成されます。これは、入力スケールの大きさがはるかに大きいことを示すだけでなく、言語の単語と比較して表現が低いことを示します。 . 埋め込みのレベル。

パノラマ セグメンテーションはコンピュータ ビジョンの問題であり、現在多くのアプリケーションの中核的なタスクとなっています。

これは、セマンティック セグメンテーションとインスタンス セグメンテーションの 2 つの部分に分かれています。

セマンティック セグメンテーションは、「人」や「空」など、画像内の各ピクセルにセマンティック ラベルを割り当てることに似ています。

インスタンス セグメンテーションでは、「歩行者」や「車」など、グラフ内の数えられるオブジェクトのみを識別してセグメント化し、さらにそれらをいくつかのサブタスクに分割します。

各サブタスクは個別に処理され、追加のモジュールが適用されて各サブタスク段階の結果がマージされます。

このプロセスは複雑であるだけでなく、サブタスクを処理し、さまざまなサブタスクの結果を統合するときに、人為的に設計された多くの事前分布も導入します。

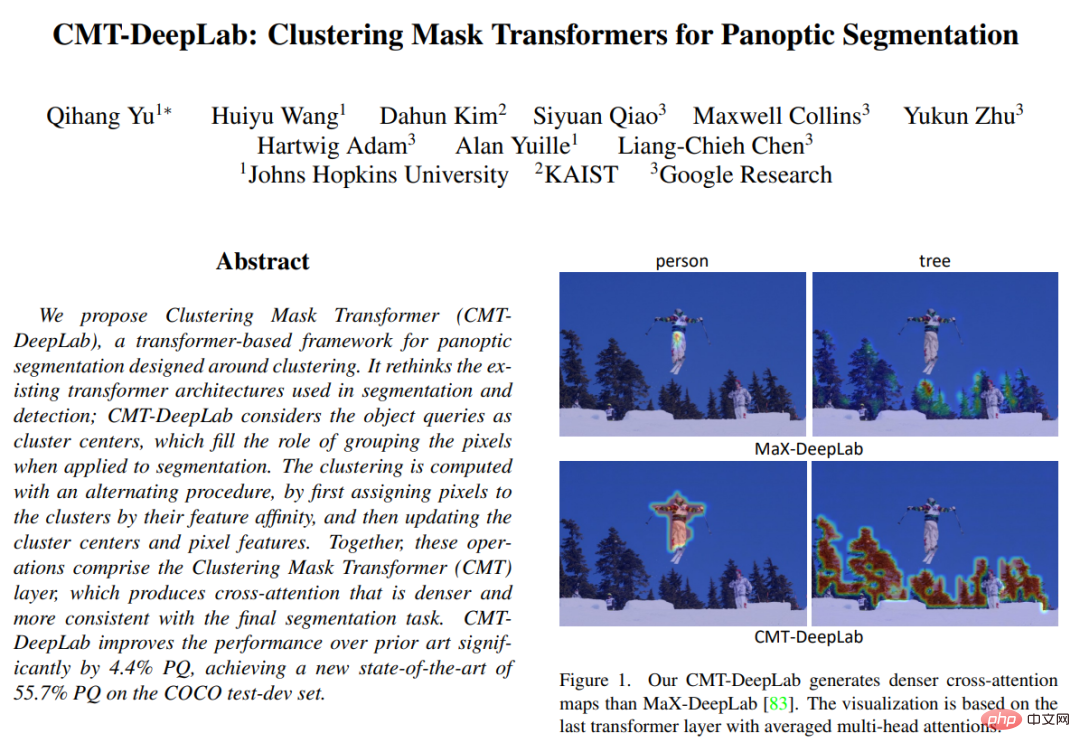

CVPR 2022 で公開された「CMT-DeepLab: Clustering Mask Transformers for Panoptic Segmentation」では、クロス アテンションのクラスタリングの観点からクロス アテンションを再解釈し、再設計することを提案しています。 (つまり、同じセマンティック ラベルを持つピクセルを同じグループにグループ化する)、視覚的なタスクによりよく適応します。

CMT-DeepLab は、以前の最先端の手法である MaX-DeepLab を基にして構築されており、クロスアテンションを実行するためにピクセル クラスタリング手法を採用しており、その結果、より高密度で合理的なアテンション マップが得られます。

kMaX-DeepLab は、アクティベーション関数を簡単に変更するだけで、k-means クラスタリング アルゴリズムに近くなるようにクロスアテンションをさらに再設計します。

構造概要

研究者は、変更を加えずに視覚タスクに直接相互注意を適用するのではなく、クラスタリングの観点からそれを再解釈します。

具体的には、Mask Transformer オブジェクトのクエリは (同じセマンティック ラベルを持つピクセルをグループ化することを目的とした) クラスター センターとして考えることができることに注目しています。

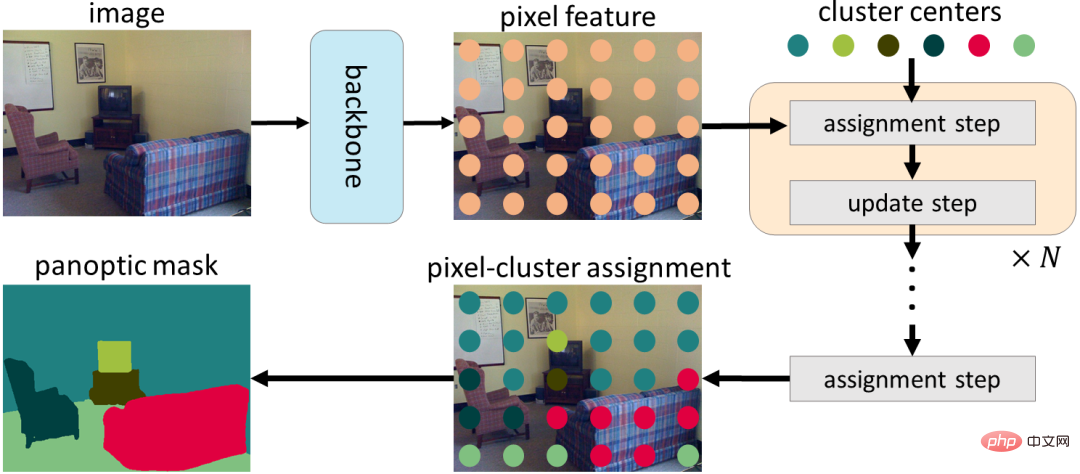

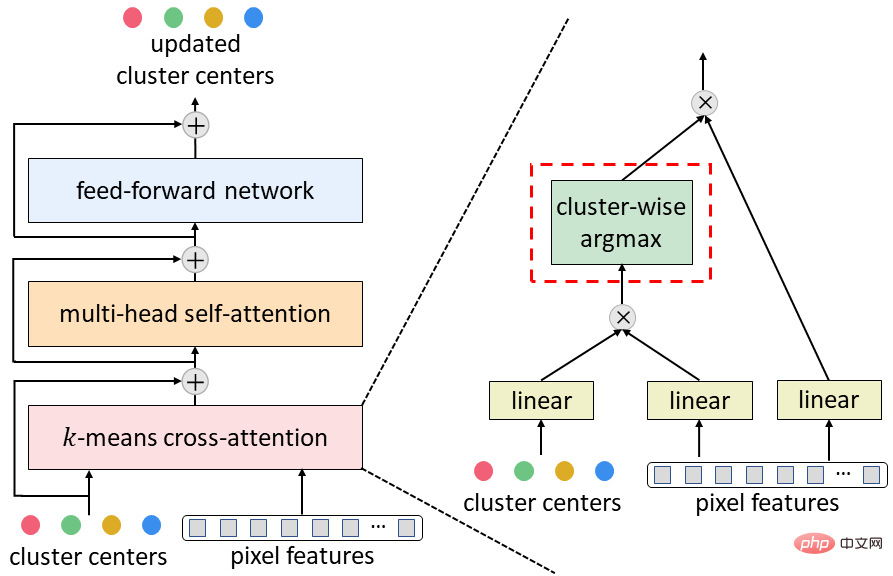

クロスアテンションのプロセスは、K 平均法クラスタリング アルゴリズム (1) ピクセルをクラスターの中心に割り当てる反復プロセスに似ています。このプロセスでは、複数のピクセルを 1 つのクラスターの中心に割り当てることができ、一部のクラスター中心にはピクセルが割り当てられていない可能性があり、(2) クラスターの中心は、同じクラスターの中心に割り当てられたピクセルを平均することによって更新されます。ピクセルが割り当てられていない場合、クラスターの中心は更新されません)。

クラスタリングの観点から MaskTransformer のクロスアテンションを再構築すると、セグメンテーションのパフォーマンスが大幅に向上し、複雑な MaskTransformer パイプラインが簡素化されて解釈しやすくなります。

まず、エンコーダー/デコーダー構造を使用して、入力画像からピクセル特徴を抽出します。次に、ピクセルはクラスター中心のセットを使用してグループ化され、クラスターの割り当てに基づいてさらに更新されます。最後に、クラスターの割り当てと更新のステップが繰り返し実行され、最後の割り当てをセグメンテーション予測として直接使用できます。

典型的な MaskTransformer デコーダ (クロスアテンション、マルチヘッド セルフ アテンション、およびフィードフォワード ネットワークで構成される) をK 平均クロスアテンション上で提案されたものは、空間的なソフトマックスをクラスター的な最大パラメータに置き換えるだけです。

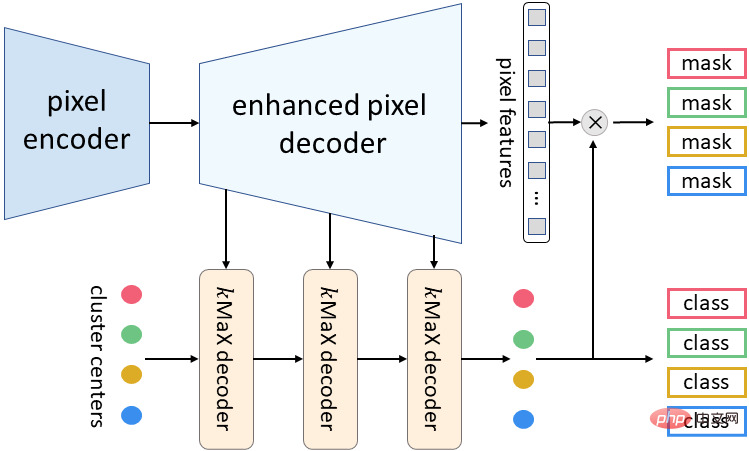

今回提案するkMaX-DeepLabのメタアーキテクチャは、ピクセルエンコーダ、拡張ピクセルデコーダ、kMaXデコーダの3つのコンポーネントで構成されます。

ピクセル エンコーダはあらゆるネットワークのバックボーンであり、画像の特徴を抽出するために使用されます。

強化されたピクセル デコーダには、ピクセルの特徴を強化するための Transformer エンコーダと、より高解像度の特徴を生成するためのアップサンプリング レイヤーが含まれています。

一連の kMax デコーダは、クラスター中心を (1) 予測マスクを生成するためにピクセル特徴と乗算されるマスク埋め込みベクトル、および (2) 各マスクのクラス予測に変換します。

kMaX-DeepLab のメタ アーキテクチャ

研究結果

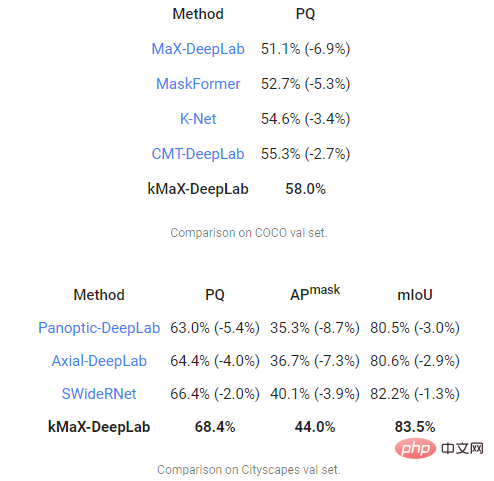

研究チームは最後に、最も困難な 2 つのパノラマ セグメンテーション データで成功を収めました。 COCO および Cityscapes のパノラマ品質 (PQ) メトリクスを使用して CMT-DeepLab と kMaX-DeepLab を評価し、MaX-DeepLab を他の最先端の手法と比較します。

その中で、CMT-DeepLab は大幅なパフォーマンス向上を達成しましたが、kMaX-DeepLab は修正を簡略化するだけでなく、さらに改善し、COCO val set の PQ は 58.0%、PQ は 68.4%、44.0 でした。 % マスク平均精度 (マスク AP)、Cityscapes 検証セットの平均交差オーバーユニオン (mIoU) 83.5% (テスト時の拡張や外部データセットの使用なし)。

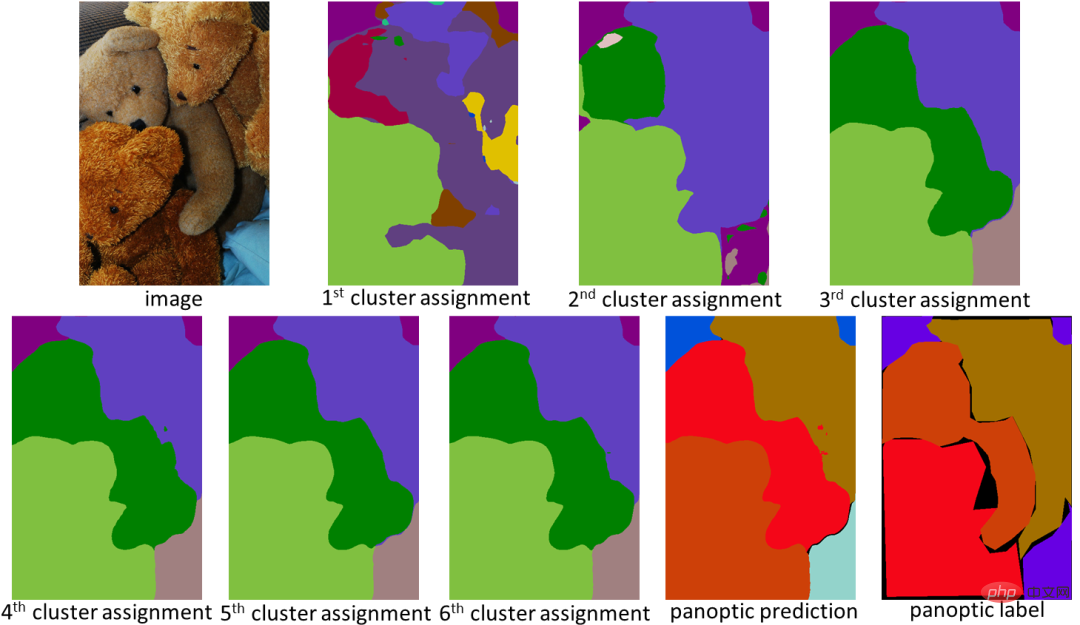

クラスタリングの観点から設計された kMaX-DeepLab は、パフォーマンスが高いだけでなく、アテンション マップをより合理的に視覚化し、その動作メカニズムを理解することができます。

以下の例では、kMaX-DeepLab はクラスターの割り当てと更新を繰り返し実行し、マスクの品質を徐々に向上させます。

kMaX-DeepLab のアテンション マップはパノラマ セグメンテーションとして直接視覚化できるため、モデルの動作メカニズムがより合理的になります

結論

この研究ビジョン タスクで MaskTransformers をより適切に設計する方法を示します。

簡単な変更を加えることで、CMT-DeepLab と kMaX-DeepLab はクロスアテンションを再構築し、よりクラスタリング アルゴリズムに似たものになります。

したがって、提案されたモデルは COCO および Cityscapes データセット上で最先端のパフォーマンスを実現します。

研究チームは、DeepLab2 ライブラリ内の kMaX-DeepLab のオープンソース バージョンが、ビジュアル トランスフォーマー専用のアーキテクチャの設計に関する将来の研究に貢献することを期待していると述べました。

以上がGoogle チームがパノラマ セグメンテーション ソリューションを最適化する新しい Transformer を発表の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7752

7752

15

15

1643

1643

14

14

1398

1398

52

52

1293

1293

25

25

1234

1234

29

29

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

この記事では、SESAME Open Exchange(gate.io)Webバージョンの登録プロセスとGate Tradingアプリを詳細に紹介します。 Web登録であろうとアプリの登録であろうと、公式Webサイトまたはアプリストアにアクセスして、本物のアプリをダウンロードし、ユーザー名、パスワード、電子メール、携帯電話番号、その他の情報を入力し、電子メールまたは携帯電話の確認を完了する必要があります。

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

ログインステップやパスワード回復プロセスなど、セサミオープンエクスチェンジWebバージョンのログイン操作の詳細な紹介も、ログイン障害、ページを開くことができず、プラットフォームにスムーズにログインするのに役立つ検証コードを受信できません。

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか? BYBITは、ユーザーにトレーディングサービスを提供する暗号通貨交換です。 Exchangeのモバイルアプリは、次の理由でAppStoreまたはGooglePlayを介して直接ダウンロードすることはできません。1。AppStoreポリシーは、AppleとGoogleがApp Storeで許可されているアプリケーションの種類について厳しい要件を持つことを制限しています。暗号通貨交換アプリケーションは、金融サービスを含み、特定の規制とセキュリティ基準を必要とするため、これらの要件を満たしていないことがよくあります。 2。法律と規制のコンプライアンス多くの国では、暗号通貨取引に関連する活動が規制または制限されています。これらの規制を遵守するために、BYBITアプリケーションは公式Webサイトまたはその他の認定チャネルを通じてのみ使用できます

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

この記事では、Binance、Okx、Gate.io、Bitflyer、Kucoin、Bybit、Coinbase Pro、Kraken、Bydfi、Xbit分散化された交換など、注意を払う価値のある上位10の暗号通貨取引プラットフォームを推奨しています。これらのプラットフォームには、トランザクションの数量、トランザクションの種類、セキュリティ、コンプライアンス、特別な機能の点で独自の利点があります。適切なプラットフォームを選択するには、あなた自身の取引体験、リスク許容度、投資の好みに基づいて包括的な検討が必要です。 この記事があなたがあなた自身に最適なスーツを見つけるのに役立つことを願っています

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

アプリをダウンロードしてアカウントの安全を確保するために、正式なチャネルを選択することが重要です。

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Webサイトログインポータルの最新バージョンにアクセスするには、これらの簡単な手順に従ってください。公式ウェブサイトに移動し、右上隅の[ログイン]ボタンをクリックします。既存のログインメソッドを選択してください。「登録」してください。登録済みの携帯電話番号または電子メールとパスワードを入力し、認証を完了します(モバイル検証コードやGoogle Authenticatorなど)。検証が成功した後、Binance公式WebサイトLogin Portalの最新バージョンにアクセスできます。

ビットゲット取引プラットフォーム公式アプリのダウンロードとインストールアドレス

Feb 25, 2025 pm 02:42 PM

ビットゲット取引プラットフォーム公式アプリのダウンロードとインストールアドレス

Feb 25, 2025 pm 02:42 PM

このガイドは、AndroidおよびiOSシステムに適した公式Bitget Exchangeアプリの詳細なダウンロードとインストール手順を提供します。このガイドは、公式ウェブサイト、App Store、Google Playなど、複数の権威ある情報源からの情報を統合し、ダウンロードおよびアカウント管理中の考慮事項を強調しています。ユーザーは、App Store、公式WebサイトAPKダウンロード、公式Webサイトジャンプ、完全な登録、ID検証、セキュリティ設定など、公式チャネルからアプリをダウンロードできます。さらに、ガイドはよくある質問や考慮事項をカバーします。

2025年のBitgetの最新のダウンロードアドレス:公式アプリを取得する手順

Feb 25, 2025 pm 02:54 PM

2025年のBitgetの最新のダウンロードアドレス:公式アプリを取得する手順

Feb 25, 2025 pm 02:54 PM

このガイドは、AndroidおよびiOSシステムに適した公式Bitget Exchangeアプリの詳細なダウンロードとインストール手順を提供します。このガイドは、公式ウェブサイト、App Store、Google Playなど、複数の権威ある情報源からの情報を統合し、ダウンロードおよびアカウント管理中の考慮事項を強調しています。ユーザーは、App Store、公式WebサイトAPKダウンロード、公式Webサイトジャンプ、完全な登録、ID検証、セキュリティ設定など、公式チャネルからアプリをダウンロードできます。さらに、ガイドはよくある質問や考慮事項をカバーします。