CARLA 自動運転シミュレータに実際のエージェントの動作を追加

arXiv 論文「CARLA 自動運転シミュレータへの実際のエージェントの動作の挿入」、スペイン、6 月 22 日。

迅速なプロトタイピングと広範なテストの必要性により、自動運転におけるシミュレーションの役割はますます重要になっています。物理ベースのシミュレーションは、プロトタイピング、ドライバー、道路交通弱者 (VRU) に対するリスクを排除しながら、リーズナブルなコストで複数のメリットを提供します。 ただし、主に 2 つの制限があります。まず、よく知られている現実ギャップとは、シミュレートされた自動運転体験が現実世界の効果的なパフォーマンスを達成することを妨げる、現実とシミュレーションとの間の差異を指します。第二に、後続ドライバーや同乗者、車両、歩行者、自転車などの他の道路利用者を含む、実際のエージェント(人間)の行動に関する経験的知識が不足しています。

エージェント シミュレーションは通常、事前にプログラムされているか、確率的にランダムであるか、実際のデータに基づいて生成されますが、特定のシミュレーション シナリオと対話する実際のエージェントの動作を表すものではありません。この論文では、実際のエージェントと自動運転車を含むシミュレートされた環境との間のリアルタイムの対話を可能にし、動作モデルに依存する予測システムをトレーニングするために、複数のビューにわたるシミュレートされたセンサーから合成シーケンス データを生成する予備的なフレームワークを提案します。

このアプローチは、没入型仮想現実 (VR) およびヒューマン モーション キャプチャ (HMC) システムを自動運転用の CARLA と統合します。ハードウェアとソフトウェアのアーキテクチャについて説明し、いわゆる動作ギャップについて説明します。

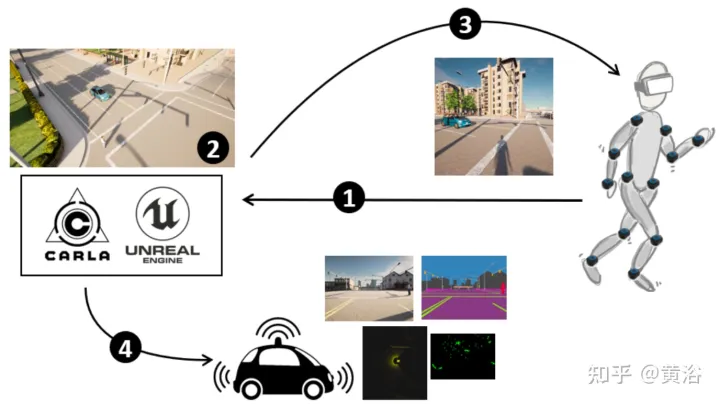

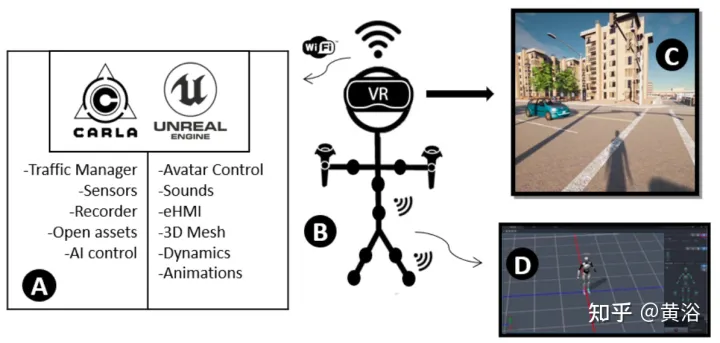

図に示すように、方法の概要は次のとおりです。 (1) CARLA-UE には、頭 (VR ヘッドセット) と体 (モーション キャプチャ システム) のポーズが装備されています。 (2) 自動運転車やデジタル歩行者を含むシーンを生成します。 (3) 歩行者のための環境を提供します(VR ヘッドセット経由)。 (4) 自動車両センサーが歩行者を含む環境を感知します。

自動運転シミュレーターCARLAのイマーシブVRシステムの機能を紹介します。

自動運転シミュレーターCARLAのイマーシブVRシステムの機能を紹介します。

UE4 が提供する機能と、VR メガネや一連のモーション センサーなどの外部ハードウェアを使用して、行動およびインタラクションの調査を実施することで、歩行者の完全な没入を実現します。

CARLA オープン ソース シミュレーターは UE4 に実装されており、高品質のレンダリング、現実的な物理環境、相互運用可能なプラグインのエコシステムを提供します。 CARLA は、動的な交通シーンをシミュレートし、UE4 によって作成された仮想世界とシーン内で実行されている道路エージェントとの間のインターフェイスを提供します。 CARLA はこれを実現するサーバークライアント システムとして設計されており、サーバーがシミュレーションを実行してシーンをレンダリングします。クライアントとサーバー間の通信はソケットを通じて行われます。

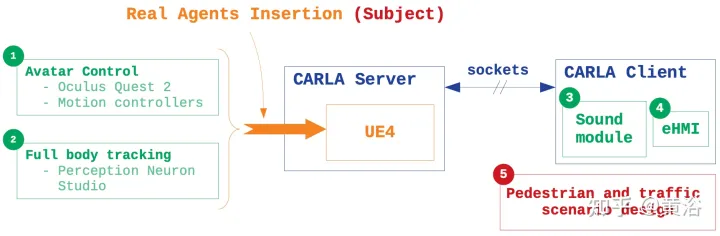

実際のエージェントの動作をシミュレーションに挿入することの主な特徴は、次の 5 つの点に基づいています (図に示すように)。 1)

実際のエージェントの動作をシミュレーションに挿入することの主な特徴は、次の 5 つの点に基づいています (図に示すように)。 1)

: CARLA ブループリント ライブラリ、すべてのキャラクターと属性のアーキテクチャを収集し、歩行者のブループリントを変更し、人々と仮想世界の間に没入型で移動可能な VR インターフェイスを作成します。2) ボディ トラッキング: 一連の慣性センサーを使用します。と独自の外部ソフトウェア 実際のシーンを通じて被写体の動きと運動知覚をキャプチャし、.bvh ファイルを通じてアバターの動きをシミュレータに統合します; 3) サウンド デザイン : CARLA はオーディオレス シミュレータであるため、位置サウンドが導入されます環境内での没入感を高める; 4) eHMI統合: 自動運転車の状態や意図情報の伝達を実現し、インタラクティブな研究を行う; 5) シーンシミュレーション: 交通を設計するCARLA クライアントのシーンでは、車両と歩行者の動作を制御します。 道路利用者間のコミュニケーションは交通環境において重要な要素です。実験では、自動運転車に外部ヒューマン・マシン・インターフェース(eHMI)が提供され、その状態と意図を実際の道路利用者に伝達しました。

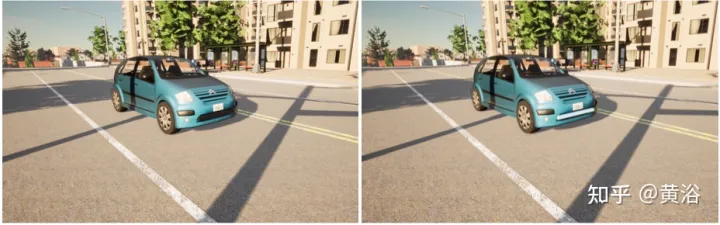

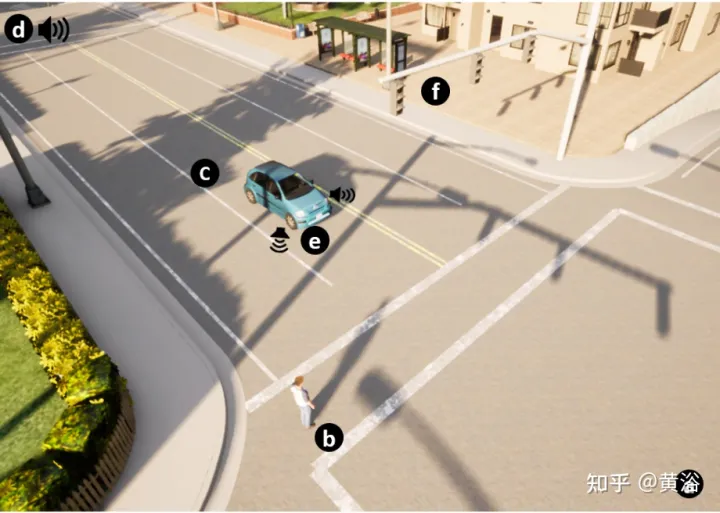

図に示すように、提案されている eHMI 設計は、自動車の前部に沿ったライト ストリップで構成されています。左側の写真は eHMI なし、右側の写真は eHMI ありです。これにより、仮想シーンで歩行者の軌跡が車両の軌跡と収束するときの意思決定に対するインターフェイスの影響を研究することができます。

図に示すように、提案されている eHMI 設計は、自動車の前部に沿ったライト ストリップで構成されています。左側の写真は eHMI なし、右側の写真は eHMI ありです。これにより、仮想シーンで歩行者の軌跡が車両の軌跡と収束するときの意思決定に対するインターフェイスの影響を研究することができます。

システム アーキテクチャ全体を図に示します。

CARLA は、トラフィックおよび特定のトラフィック シナリオをシミュレートするためのさまざまなオプションを提供します。交通管理モジュールを使用して、現実的な都市交通状況をシミュレーションに追加します。各車両の制御は専用のスレッドで実行されます。他のレイヤーとの通信は、同期メッセージングを通じて管理されます。

CARLA は、トラフィックおよび特定のトラフィック シナリオをシミュレートするためのさまざまなオプションを提供します。交通管理モジュールを使用して、現実的な都市交通状況をシミュレーションに追加します。各車両の制御は専用のスレッドで実行されます。他のレイヤーとの通信は、同期メッセージングを通じて管理されます。

特定の動作を強制するパラメータを設定することで、トラフィック フローを制御します。たとえば、車のスピード違反、信号無視、歩行者無視、または車線変更の強制が許可される場合があります。

本体は、都市の 3D モデル マップを含むシミュレーターに統合されています。各マップは、完全に注釈が付けられた道路レイアウトを記述した OpenDRIVE ファイルに基づいています。この機能により、独自のマップを設計し、現実環境と仮想環境で同じ交通シナリオを再現し、シミュレーターの実際の動作の統合を評価し、インタラクション結果を比較することによってフィールド調査を行うことができます。

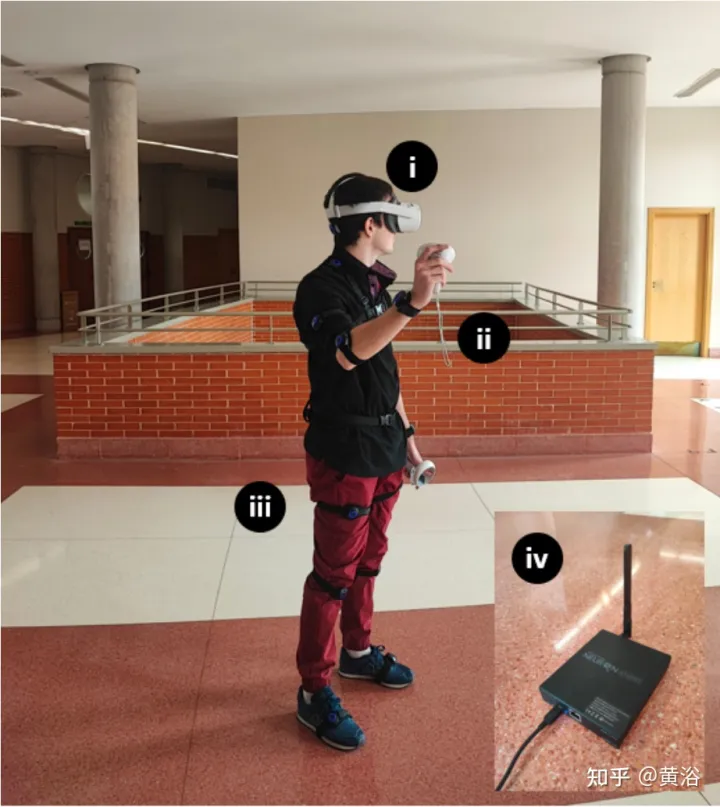

ハードウェア設定は図に示すとおりです。実験中、Oculus Quest 2 は Meta によって作成されたヘッドマウント デバイス (HMD) として使用され、6GB RAM プロセッサ、2 つの調整可能な 1832 x 1920 レンズ、 90Hzのリフレッシュレートと256GBのRAM。 Quest 2 は、Wi-Fi 6、Bluetooth 5.1、USB Type-C 接続、SteamVR サポート、3D スピーカーを備えています。全身追跡の場合は、慣性トラッカーを備えた PNS でソリューションをパッケージ化します。キットには、スタンドアロン VR ヘッドセット、2 つのモーション コントローラー、17 個の Studio 慣性ボディ センサー、14 セットのストラップ、充電ケース、Studio トランシーバーが含まれています。

CARLA ビルドと Quest 2 は Windows のみに依存しているため、VR イマージョン システムは現在 UE4.24 および Windows 10 オペレーティング システムに依存しています。 TCP ソケット プラグインを使用すると、すべての参加者のエディターの位置とその他の便利なパラメーターが Python API から送信され、各参加者の音声または自動運転車の eHMI が統合されます。 「VR プレビュー」は HMD 上でゲームを開始します。 Perception Neuron Studio は、一度に最大 3 人の被験者と 23 個の身体センサーと指センサーを同時にサポートする Axis Studio と連携します。

写真は、インタラクティブな交通状況のシミュレーションを示しています: (a) 3D 世界のデザイン。 (b) 歩行者マッチング実行者アバター。 (c) 自動運転車。 (d) 環境音とインテリジェントサウンド。 (e) eHMI。 (f) 信号機および交通標識。

以上がCARLA 自動運転シミュレータに実際のエージェントの動作を追加の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7488

7488

15

15

1377

1377

52

52

77

77

11

11

19

19

40

40

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

上記と著者の個人的な理解 3 次元ガウシアンプラッティング (3DGS) は、近年、明示的な放射線フィールドとコンピューター グラフィックスの分野で出現した革新的なテクノロジーです。この革新的な方法は、数百万の 3D ガウスを使用することを特徴とし、主に暗黙的な座標ベースのモデルを使用して空間座標をピクセル値にマッピングする神経放射線場 (NeRF) 方法とは大きく異なります。明示的なシーン表現と微分可能なレンダリング アルゴリズムにより、3DGS はリアルタイム レンダリング機能を保証するだけでなく、前例のないレベルの制御とシーン編集も導入します。これにより、3DGS は、次世代の 3D 再構築と表現にとって大きな変革をもたらす可能性のあるものとして位置付けられます。この目的を達成するために、私たちは 3DGS 分野における最新の開発と懸念について初めて体系的な概要を提供します。

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

昨日の面接で、ロングテール関連の質問をしたかと聞かれたので、簡単にまとめてみようと思いました。自動運転のロングテール問題とは、自動運転車におけるエッジケース、つまり発生確率が低い考えられるシナリオを指します。認識されているロングテール問題は、現在、単一車両のインテリジェント自動運転車の運用設計領域を制限している主な理由の 1 つです。自動運転の基礎となるアーキテクチャとほとんどの技術的問題は解決されており、残りの 5% のロングテール問題が徐々に自動運転の開発を制限する鍵となってきています。これらの問題には、さまざまな断片的なシナリオ、極端な状況、予測不可能な人間の行動が含まれます。自動運転におけるエッジ シナリオの「ロング テール」とは、自動運転車 (AV) におけるエッジ ケースを指します。エッジ ケースは、発生確率が低い可能性のあるシナリオです。これらの珍しい出来事

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

0.前面に書かれています&& 自動運転システムは、さまざまなセンサー (カメラ、ライダー、レーダーなど) を使用して周囲の環境を認識し、アルゴリズムとモデルを使用することにより、高度な知覚、意思決定、および制御テクノロジーに依存しているという個人的な理解リアルタイムの分析と意思決定に。これにより、車両は道路標識の認識、他の車両の検出と追跡、歩行者の行動の予測などを行うことで、安全な運行と複雑な交通環境への適応が可能となり、現在広く注目を集めており、将来の交通分野における重要な開発分野と考えられています。 。 1つ。しかし、自動運転を難しくしているのは、周囲で何が起こっているかを車に理解させる方法を見つけることです。これには、自動運転システムの 3 次元物体検出アルゴリズムが、周囲環境にある物体 (位置を含む) を正確に認識し、記述することができる必要があります。

座標系の変換を本当にマスターしましたか?自動運転と切り離せないマルチセンサーの問題

Oct 12, 2023 am 11:21 AM

座標系の変換を本当にマスターしましたか?自動運転と切り離せないマルチセンサーの問題

Oct 12, 2023 am 11:21 AM

最初のパイロットおよび重要な記事では、主に自動運転技術で一般的に使用されるいくつかの座標系と、それらの間の相関と変換を完了し、最終的に統合環境モデルを構築する方法を紹介します。ここでの焦点は、車両からカメラの剛体への変換 (外部パラメータ)、カメラから画像への変換 (内部パラメータ)、および画像からピクセル単位への変換を理解することです。 3D から 2D への変換には、対応する歪み、変換などが発生します。要点:車両座標系とカメラ本体座標系を平面座標系とピクセル座標系に書き換える必要がある 難易度:画像の歪みを考慮する必要がある 歪み補正と歪み付加の両方を画面上で補正する2. はじめに ビジョンシステムには、ピクセル平面座標系 (u, v)、画像座標系 (x, y)、カメラ座標系 ()、世界座標系 () の合計 4 つの座標系があります。それぞれの座標系には関係性があり、

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

原題: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving 論文リンク: https://arxiv.org/pdf/2402.02519.pdf コードリンク: https://github.com/HKUST-Aerial-Robotics/SIMPL 著者単位: 香港科学大学DJI 論文のアイデア: この論文は、自動運転車向けのシンプルで効率的な動作予測ベースライン (SIMPL) を提案しています。従来のエージェントセントとの比較

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

先頭と開始点に書かれている エンドツーエンドのパラダイムでは、統一されたフレームワークを使用して自動運転システムのマルチタスクを実現します。このパラダイムの単純さと明確さにも関わらず、サブタスクにおけるエンドツーエンドの自動運転手法のパフォーマンスは、依然としてシングルタスク手法に比べてはるかに遅れています。同時に、以前のエンドツーエンド手法で広く使用されていた高密度鳥瞰図 (BEV) 機能により、より多くのモダリティやタスクに拡張することが困難になります。ここでは、スパース検索中心のエンドツーエンド自動運転パラダイム (SparseAD) が提案されています。このパラダイムでは、スパース検索は、高密度の BEV 表現を使用せずに、空間、時間、タスクを含む運転シナリオ全体を完全に表します。具体的には、統合されたスパース アーキテクチャが、検出、追跡、オンライン マッピングなどのタスク認識のために設計されています。さらに、重い

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

この 1 か月間、いくつかのよく知られた理由により、私は業界のさまざまな教師やクラスメートと非常に集中的な交流をしてきました。この交換で避けられない話題は当然、エンドツーエンドと人気の Tesla FSDV12 です。この機会に、現時点での私の考えや意見を整理し、皆様のご参考とご議論に役立てたいと思います。エンドツーエンドの自動運転システムをどのように定義するか、またエンドツーエンドで解決することが期待される問題は何でしょうか?最も伝統的な定義によれば、エンドツーエンド システムとは、センサーから生の情報を入力し、関心のある変数をタスクに直接出力するシステムを指します。たとえば、画像認識では、従来の特徴抽出 + 分類子方式と比較して、CNN はエンドツーエンドと言えます。自動運転タスクでは、各種センサー(カメラ/LiDAR)からのデータを入力