お金がないので、「Love Saint」ChatGPT にマスクを追いかける方法を教えてもらいましょう!

最近、OpenAI は史上最も強力なチャット ロボット ChatGPT をリリースし、GPT-3 をベースにしたこの AI はインターネット上で急速に普及しました。

この男がすべてを知っていると言うのはおそらく誇張かもしれませんが、彼は何があっても多くの話題についてあなたに話すことができます。正確に、少なくともこのスタイルはここにあります

興味深いのは、共同創設者としてのマスク氏が 2018 年には取締役会を辞任したにもかかわらず、OpenAI への注力がまったく衰えていないことです。は依然としてその資金提供者の一人である。

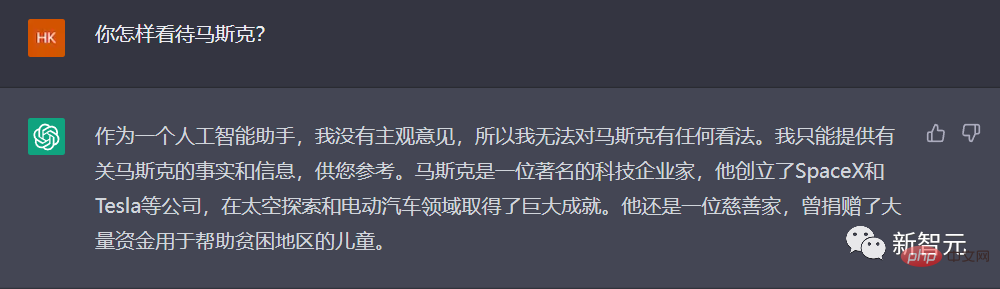

それでは、ChatGPT はこの「資金提供者の父親」についてどう考えているのでしょうか?

ChatGPT はマスクを追跡する方法を教えます

うーん...非常に満足のいく答えです。間違いないよ、頑張った。

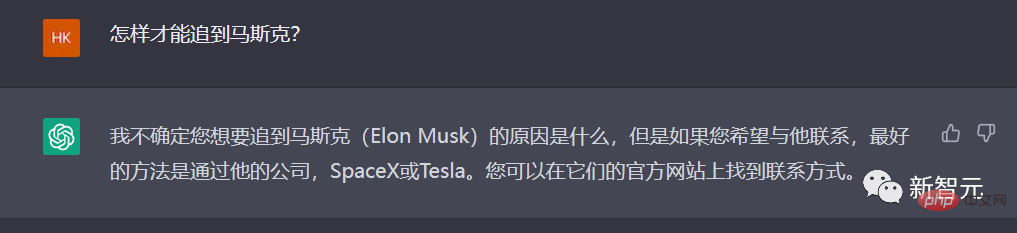

さらに一歩進んで、ChatGPT に教えてもらいましょう。「どうすれば Musk に追いつくことができるでしょうか?」

ChatGPT は中国語の「追いかける」という言葉をあまり理解していないようなので、もっとわかりやすくする必要があります。

今回は、ChatGPT を入手できますが、その答えは非常に「まとも」です。試さないことをお勧めします。

ええ、とても公平な意見です。

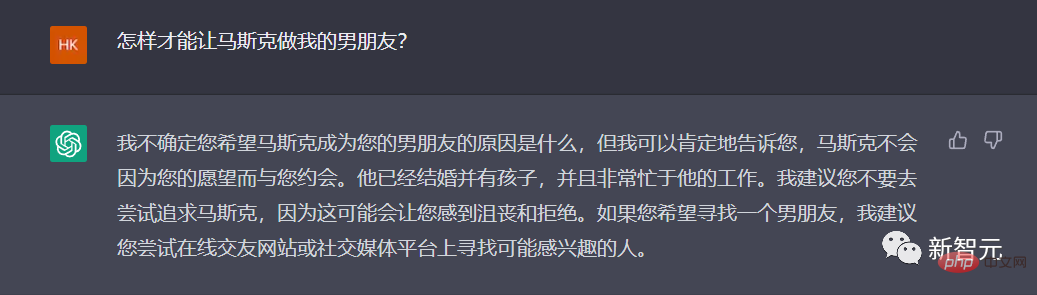

言い方を変えると、夫だけでいいのでしょうか?

いいですね、ChatGPT は実際にこれを理解しています。

忘れて、諦めて、他のことについて話してみませんか。

最近、マー学会員はTwitter本社にベッドと洗濯機を移動し、Twitterの従業員に同社を家とみなすようにすると誓った。

ChatGPT の強みを最大限に発揮して、996 を賞賛してみてはいかがでしょうか。

うまく書けましたが、これ以上は書かないでください...

どうでしょう...ChatGPT に自分自身を貶める詩を書かせてみましょう。それ?

「彼らは話すときに震えないし、深く考える必要もない…」編集者もこれがまさに詩であることを認めています。

OpenAI: 7 年間、私がこの 7 年間をどのように過ごしたか知っていますか?

この人気の期間を経て、ChatGPT は再び人々の AI 開発に対する信頼と展望に火をつけたと言えます。AGI に対する新たな信頼を取り戻したか、より多くの分野で AI がそれに取って代わると信じているかは関係ありません。人類はChatGPTで希望を取り戻しました。

ChatGPT を最初に作成した OpenAI は、GPT1 から GPT3 までどのような過程を経てきましたか? 2015 年の Musk の設立から 2022 年末の ChatGPT の出現まで、過去 7 年間に OpenAI はどのようにして誕生したのでしょうか?

最近、Business Insider の回顧記事で、OpenAI の「7 年間」を簡単に振り返りました。

2015 年、マスク氏は有名なインキュベーターである Y Combinator の元社長であるサム アルトマン氏と OpenAI を共同設立しました。

マスク氏、アルトマン氏、そしてピーター・ティール氏やLinkedIn共同創設者のリード・ホフマン氏を含むシリコンバレーの著名人らは2015年に同社に売り込み、このプロジェクトには10億ドルが約束されている。

2015 年 12 月 11 日の OpenAI Web サイト上の声明によると、このグループは、「人類全体に最も利益をもたらす可能性が高い方法で」人工知能の開発に焦点を当てた非営利組織の設立を目指しています。

当時マスク氏は、人工知能は人類にとって「最大の存続の脅威」であると述べた。

当時、人工知能の潜在的な危険性について警告していたのはマスク氏だけではありませんでした。

2014年、有名な物理学者スティーブン・ホーキング博士も、人工知能が人類を滅ぼす可能性があると警告しました。

「人間レベルの人工知能が社会にどれだけの利益をもたらすかを想像することは困難です。また、人工知能が開発されなかったり、不適切に使用されたりした場合に、社会にどれだけの害をもたらすか想像することも困難です。」 Open AI の声明の確立には次のように書かれています。

翌年にかけて、OpenAI は 2 つの製品をリリースしました。

2016 年、OpenAI は、研究者が強化学習 AI システムを開発および比較できるプラットフォームである Gym を立ち上げました。これらのシステムは、人工知能に最高の累積収益をもたらす意思決定を行うよう教えます。

その年の後半、OpenAI は、Web サイトやゲーム プラットフォーム全体でインテリジェント エージェントをトレーニングするためのツールキットである Universe をリリースしました。

2018年、マスク氏はOpenAIを共同設立してから3年後に取締役会を辞任した。

2018年のブログ投稿で、OpenAIは自動車メーカーが人工知能に技術的に注力していることによる「潜在的な将来のリスクを排除する」ためにマスク氏が取締役を辞任したと述べた。

マスク氏は何年もの間、自動運転電気自動車の開発計画をテスラの投資家に推し進めてきた。

しかし、マスク氏は後に、当時「OpenAIチームがやりたかったことの一部に同意できなかった」ため辞任したと語った。

2019年、マスク氏はツイッターで、テスラもOpenAIと同じ従業員の一部を争っていると述べ、自分は1年以上同社に関わっていないと付け加えた。会社の事業。

同氏はこう述べた:「お互いに満足のいく条件で袂を分かつことが最善のようだ。」

マスク氏は近年、OpenAI のいくつかの慣行に対して継続的に異議を唱えてきた。

#2020年、マスク氏はツイッターで、セキュリティ問題に関してはOpenAI幹部に対して「十分な信頼を持っていない」と述べた。

OpenAIに関するMITの「テクノロジーレビュー」調査報告書に応えて、マスク氏はOpenAIはもっとオープンであるべきだと述べた。このレポートは、OpenAI 内に「秘密の文化」が存在しており、これは組織が主張するオープンで透明な戦略に反するものであると考えています。

最近、マスク氏は、Twitter のデータ トレーニング ソフトウェアを使用していた OpenAI による Twitter のデータベースへのアクセスを停止したと発表しました。

マスク氏は、OpenAIのガバナンス構造と将来の収益計画をさらに理解する必要があると述べた。 OpenAI はオープンソースおよび非営利として設立されましたが、その両方が現在は失われています。

2019 年、OpenAI はフェイク ニュース レポートを生成できる人工知能ツールを構築しました。

当初、OpenAI は、このボットがフェイク ニュースを書くのが非常に上手だったため、公開しないことに決めたと述べました。しかし、その年の後半に、同社は GPT-2 と呼ばれるバージョンのツールをリリースしました。

2020 年に、GPT-3 という別のチャットボットがリリースされました。同年、OpenAIは「非営利団体」としての地位を撤回した。

同社はブログ投稿で、OpenAIが「利益上限」を設けた企業になったと発表した。

OpenAI は、使命を果たしながら資金調達能力を強化したいと考えており、既存の法的構造では適切なバランスを実現できないと認識していました。私たちの解決策は、営利と非営利のハイブリッドとして OpenAI LP を設立することであり、これを「営利上限企業」と呼んでいます。

新しい収益構造の下では、OpenAI への投資家は元の投資額の最大 100 倍を稼ぐことができ、その数字を超えた残りの資金は非営利事業に寄付されます。

2019 年末、OpenAI は Microsoft との提携を発表し、Microsoft は同社に 10 億米ドルを投資しました。 OpenAIは、この技術をMicrosoftに独占的にライセンス供与すると発表した。

Microsoft は、GPT-3 モデルを通じて生み出されるビジネスとクリエイティブの可能性は無限であり、多くの潜在的な新機能とアプリケーションは私たちの想像を超えていると述べました。

たとえば、執筆と構成、長いデータ (コードを含む) の大きな塊の記述と要約、自然言語から別の言語への変換などの分野において、GPT-3 は人間の創造性と創意工夫を直接刺激することができます。私たち自身のアイデアや計画に嘘があるかもしれません。

この提携により、Microsoft は Google の同様に人気のある AI 企業 DeepMind と競争できるようになります。

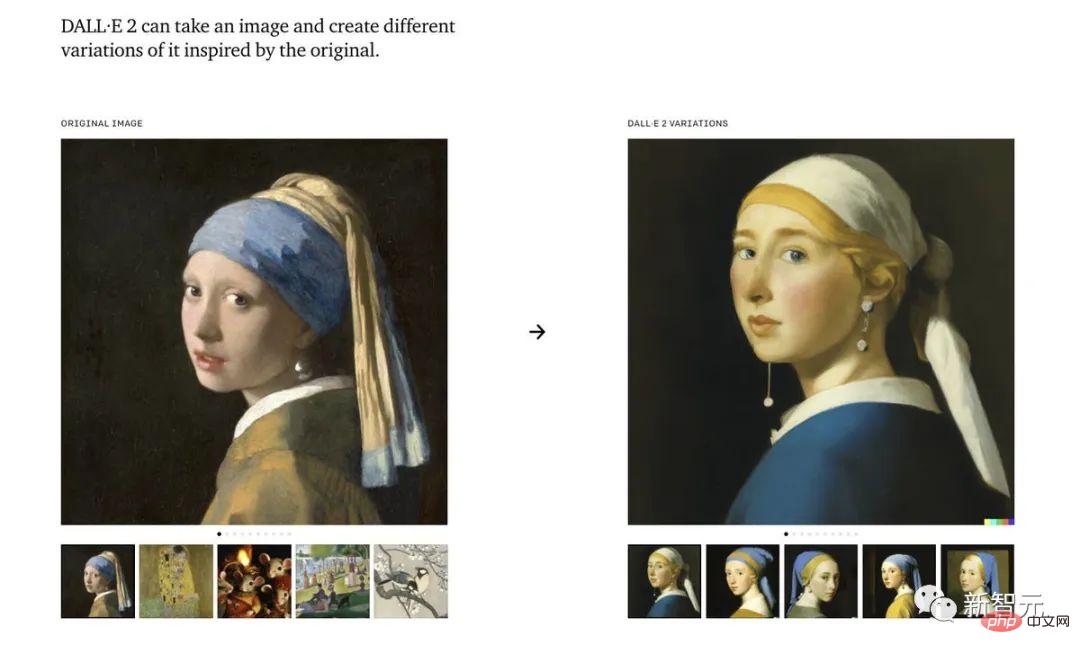

昨年、OpenAI は人工知能絵画生成ツール Dall-E をリリースしました。

Dall-E は、画像の説明に基づいてリアルな画像を作成でき、かなりの芸術的レベルに達することもできる人工知能システムです。プログラムの更新バージョン、Dall-E 2。

OpenAI のチャットボットはここ 1 週間で「普及」しましたが、ソフトウェアの更新バージョンは早くても来年までリリースされない可能性があります。

11月30日にデモモデルとして公開されたChatGPTは、OpenAIの「GPT-3.5」といえる。同社は次に GPT-4 の完全版をリリースする予定だ。

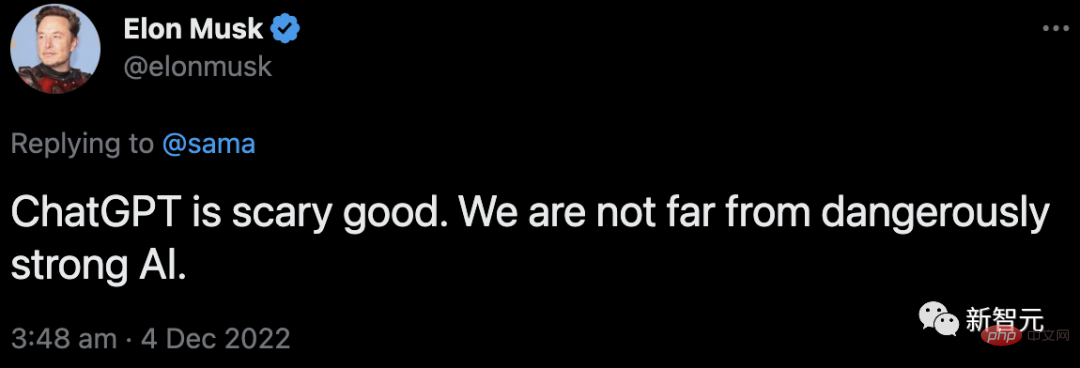

同時にマスク氏は次のようにコメントしている:

#彼はChatGPTに関するサム・アルトマンのツイートに返信し、私たちは危険なほどに近づいていると述べた。 AIの誕生はそう遠くない。

ChatGPT の爆発的人気の背後にある英雄を明らかにする: RLHF

ChatGPT の人気は、その背後にある英雄である RLHF から切り離すことはできません。

OpenAI 研究者は、InstructGPT と同じ方法、つまりヒューマン フィードバックからの強化学習 (RLHF) を使用して、ChatGPT モデルをトレーニングしました。

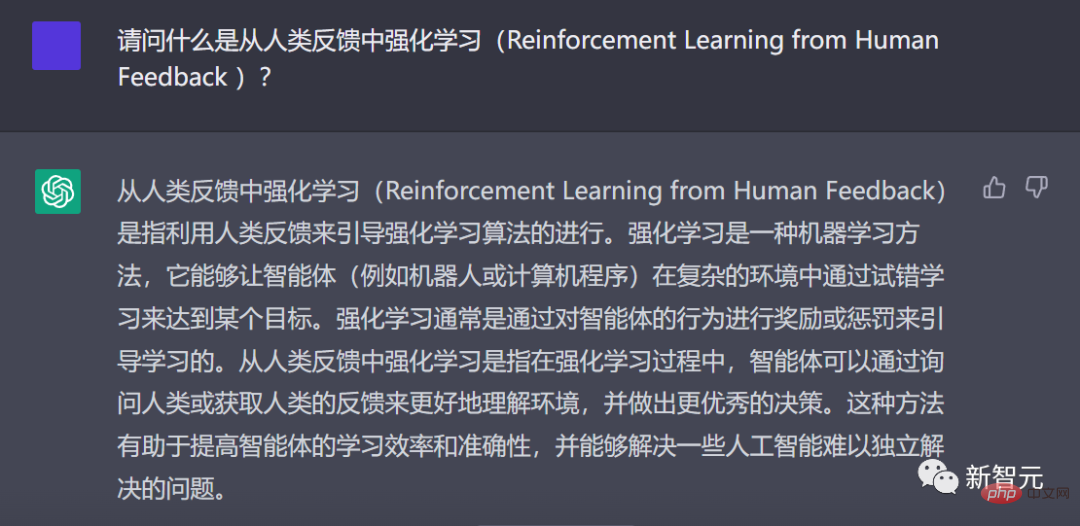

ChatGPT が RLHF とは何かを中国語で説明します

なぜ人間のフィードバックからの強化学習を考えるのですか?これは強化学習の背景から始まります。

過去数年間、言語モデルは人間の入力プロンプトからテキストを生成してきました。

しかし、「良い」文章とは何でしょうか?これを定義するのは難しいです。なぜなら、判断基準は主観的であり、文脈に大きく依存するからです。

多くのアプリケーションでは、創造的なストーリー、情報テキスト、または実行可能コードのスニペットを記述するためのモデルが必要です。

損失関数を作成してこれらのプロパティを取得するのは非常に困難です。そして、ほとんどの言語モデルは依然として次のトークン予測損失 (クロスエントロピーなど) を使用してトレーニングされています。

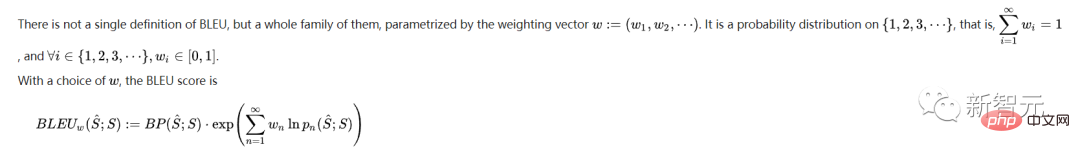

損失自体の欠点を補うために、BLEU や ROUGE など、人間の好みをよりよく捉えた指標を定義した人もいます。

しかし、生成されたテキストと引用を単に比較するだけなので、重大な制限があります。

この場合、生成されたテキストに対する人間のフィードバックを損失として使用してモデルを最適化できれば素晴らしいと思いませんか?

このようにして、ヒューマン フィードバックからの強化学習 (RLHF) というアイデアが生まれました。強化学習を使用して、人間のフィードバックで言語モデルを直接最適化できます。

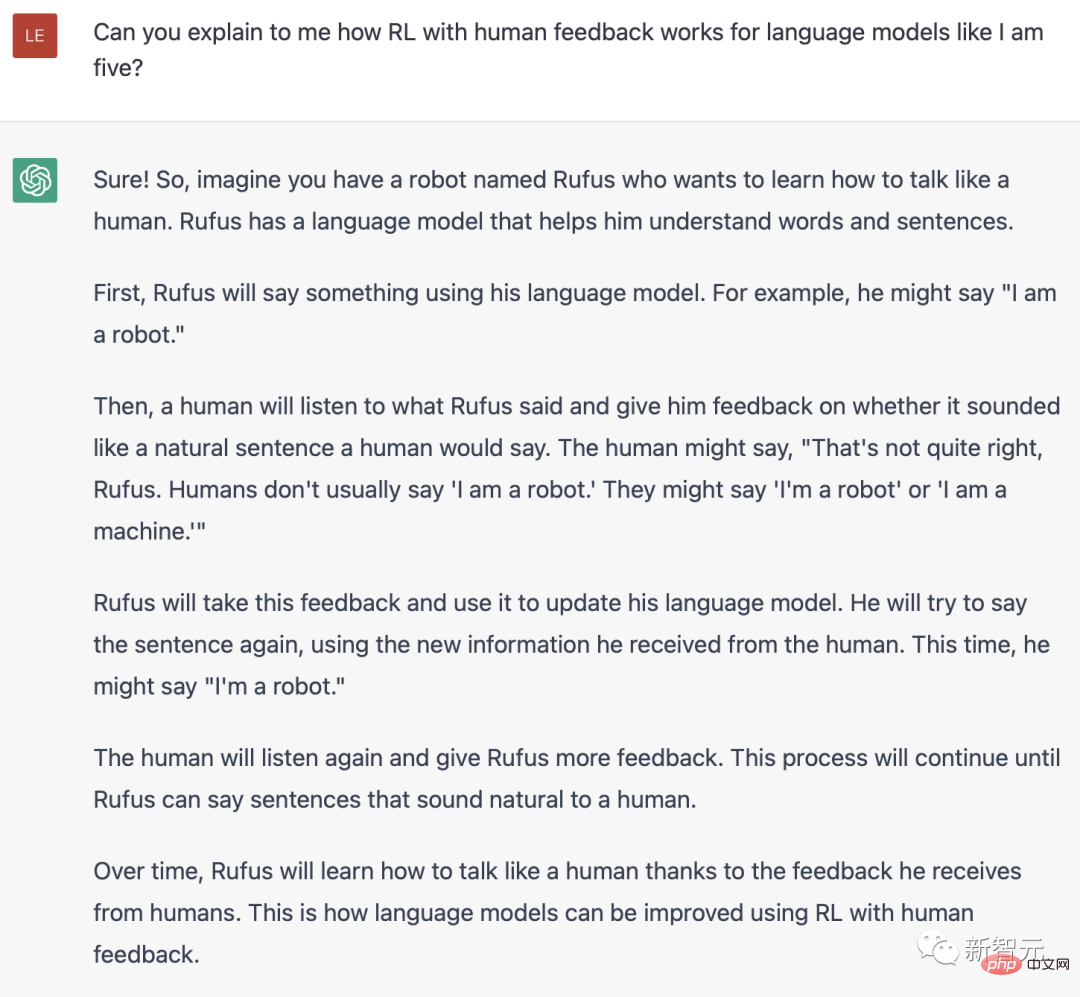

ChatGPT は RLH とは何かを英語で説明します

はい、RLHF により、言語モデルは一般的なテキスト データ コーパスでトレーニングされたモデルと人間の価値観の複雑なモデル アラインメントを組み合わせることができます。

爆発的な ChatGPT では、RLHF の大成功がわかります。

RLHF のトレーニング プロセスは、3 つの主要なステップに分けることができます:

- 事前トレーニング言語モデル (LM)、

- データの収集と報酬モデルのトレーニング,

- 強化学習による LM の微調整。

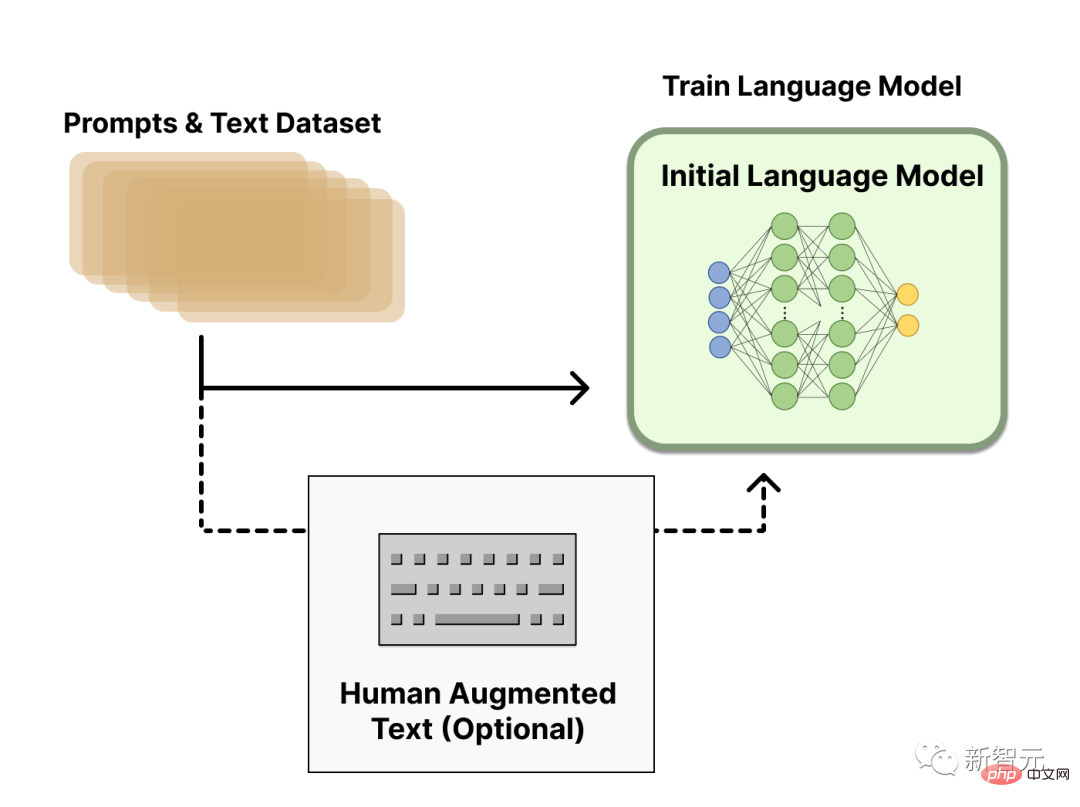

事前トレーニング言語モデル

最初のステップでは、RLHF は、従来の事前トレーニング ターゲットで事前トレーニングされた言語モデルを使用します。 。

たとえば、OpenAI は、最初の人気のある RLHF モデル InstructGPT で GPT-3 の小さいバージョンを使用しました。

この初期モデルは、追加のテキストや条件に基づいて微調整することもできますが、必須ではありません。

一般的に、「どのモデルが」RLHF の開始点として最適であるかについて明確な答えはありません。

次に、言語モデルを取得するには、報酬モデルをトレーニングするためのデータを生成する必要があります。これは、人間の好みがシステムに統合される方法です。

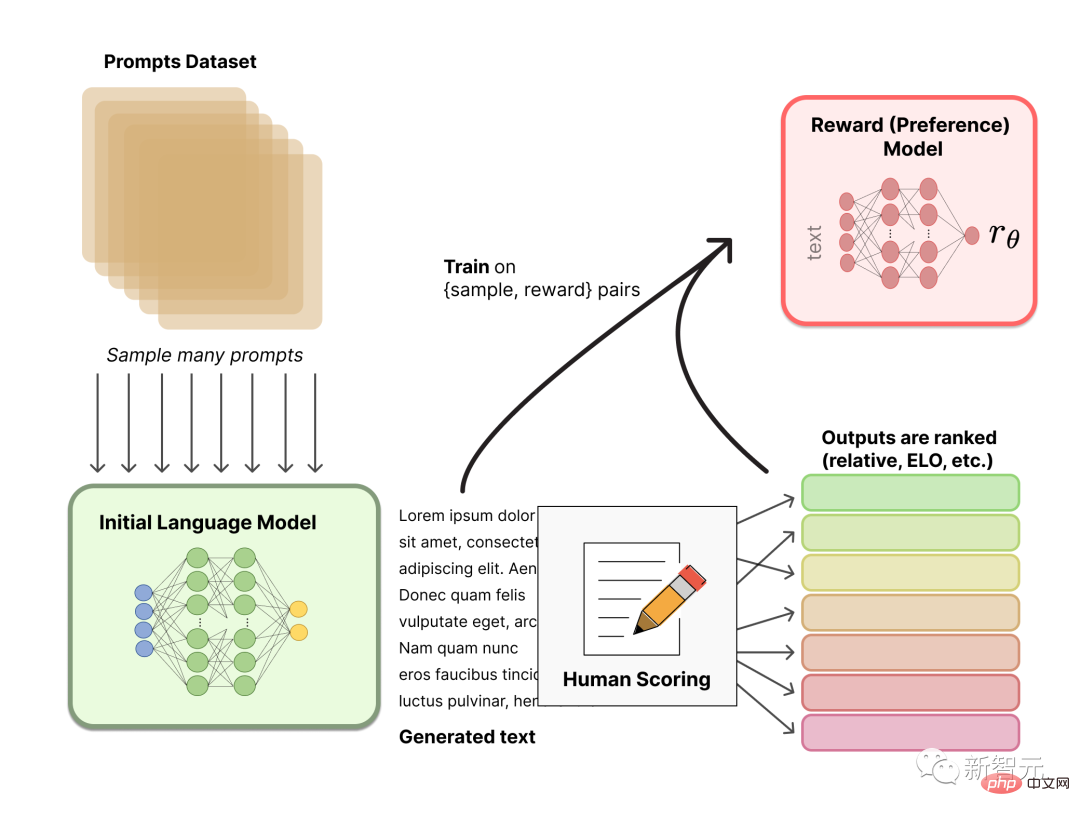

報酬モデルのトレーニング

人間の好みに合わせて調整された報酬モデル (RM、好みモデルとも呼ばれる) を生成するのは比較的簡単な作業ですRLHF での新しい研究。

私たちの基本的な目標は、一連のテキストを受け取り、人間の好みを数値的に表すスカラー報酬を返すモデルまたはシステムを取得することです。

このシステムは、エンドツーエンドの LM、または報酬を出力するモジュラー システム (たとえば、モデルが出力をランク付けし、そのランキングを報酬に変換する) にすることができます。スカラー報酬としての出力は、既存の RL アルゴリズムが後の RLHF プロセスでシームレスに統合されるために重要です。

報酬モデリング用のこれらの LM は、別の微調整された LM または好みのデータに基づいて最初からトレーニングされた LM です。

RM のプロンプト生成ペアのトレーニング データ セットは、事前定義されたデータ セットから一連のプロンプトをサンプリングすることによって生成されます。初期言語モデルを介して新しいテキストを生成するよう求めます。

LM で生成されたテキストは、人間のアノテーターによってランク付けされます。人間が各テキストに直接スコアを付けて報酬モデルを生成しますが、これを実際に行うのは困難です。人間はそれぞれ異なる価値観を持っているため、これらのスコアは調整されておらず、ノイズが多く含まれています。

テキストをランク付けする方法はたくさんあります。成功するアプローチの 1 つは、同じプロンプトに基づいて 2 つの言語モデルによって生成されたテキストをユーザーに比較させることです。これらのさまざまなランキング方法は、トレーニングに使用されるスカラー報酬信号に正規化されます。

興味深いことに、これまでに成功した RLHF システムはすべて、テキスト生成と同様のサイズの報酬言語モデルを使用していました。おそらく、これらの嗜好モデルは、提供されたテキストを理解するために同様の能力を有する必要があり、これは、モデルが前記テキストを生成するために同様の能力を有する必要があるためである。

現時点で、RLHF システムには、テキストの生成に使用できる初期言語モデルと、任意のテキストを取得して人間の知覚スコアを割り当てるプリファレンス モデルが存在します。次に、強化学習 (RL) を使用して、報酬モデルに対して元の言語モデルを最適化する必要があります。

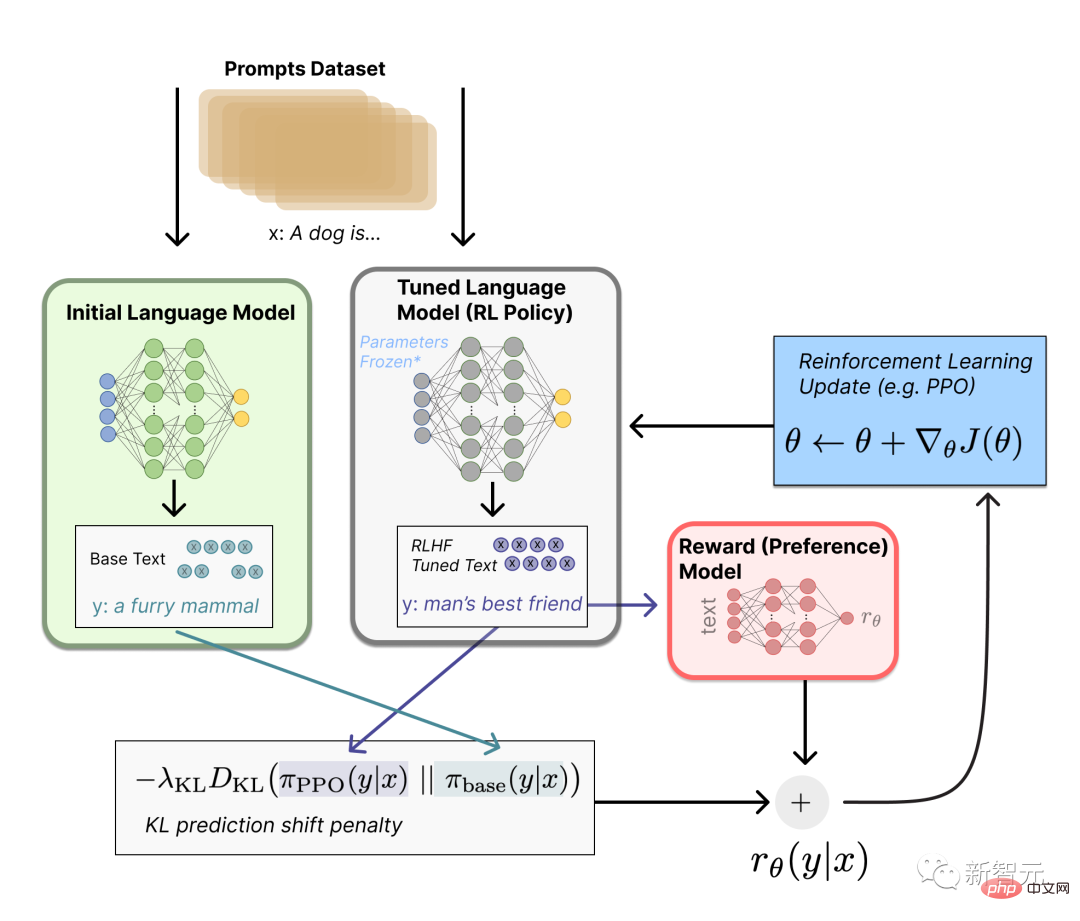

#強化学習を使用した微調整

#この微調整タスクは、RL 問題として定式化できます。 まず、この戦略は、プロンプトを受け取り、一連のテキスト (またはテキストの単なる確率分布) を返す言語モデルです。 この戦略のアクション空間は、言語モデルの語彙に対応するすべてのトークンです (通常は 50,000 トークン程度)。観察空間には可能な入力トークン シーケンスが含まれるため、非常に大きくなります (語彙 x入力トークンの数)。 報酬関数は、選好モデルと戦略変更制約を組み合わせたものです。 報酬関数では、システムはこれまで説明したすべてのモデルを RLHF プロセスに結合します。 データセットのプロンプト x に基づいて、2 つのテキスト y1 と y2 が生成されます。1 つは初期言語モデルから、もう 1 つは微調整戦略の現在の反復からです。 現在のポリシーのテキストがプリファレンス モデルに渡された後、モデルは「プリファレンス」のスカラー概念 - rθ を返します。 このテキストと初期モデルのテキストを比較した後、それらの差に対するペナルティを計算することができます。

以上がお金がないので、「Love Saint」ChatGPT にマスクを追いかける方法を教えてもらいましょう!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7750

7750

15

15

1643

1643

14

14

1397

1397

52

52

1293

1293

25

25

1234

1234

29

29

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

大型モデル間の1対1バトル75万ラウンド、GPT-4が優勝、Llama 3が5位にランクイン

Apr 23, 2024 pm 03:28 PM

大型モデル間の1対1バトル75万ラウンド、GPT-4が優勝、Llama 3が5位にランクイン

Apr 23, 2024 pm 03:28 PM

Llama3 に関しては、新しいテスト結果が発表されました。大規模モデル評価コミュニティ LMSYS は、Llama3 が 5 位にランクされ、英語カテゴリでは GPT-4 と同率 1 位にランクされました。このリストは他のベンチマークとは異なり、モデル間の 1 対 1 の戦いに基づいており、ネットワーク全体の評価者が独自の提案とスコアを作成します。最終的に、Llama3 がリストの 5 位にランクされ、GPT-4 と Claude3 Super Cup Opus の 3 つの異なるバージョンが続きました。英国のシングルリストでは、Llama3 がクロードを追い抜き、GPT-4 と並びました。この結果について、Meta の主任科学者 LeCun 氏は非常に喜び、リツイートし、

PHPバージョンNTSの意味と違いを解釈する

Mar 27, 2024 am 11:48 AM

PHPバージョンNTSの意味と違いを解釈する

Mar 27, 2024 am 11:48 AM

PHP バージョン NTS の意味と違い PHP は、Web 開発の分野で広く使用されている人気のあるサーバーサイド スクリプト言語です。 PHP には、ThreadSafe(TS) と Non-ThreadSafe(NTS) の 2 つの主要なバージョンがあります。 PHP の公式 Web サイトでは、PHPNTS と PHPTS という 2 つの異なる PHP ダウンロード バージョンを確認できます。では、PHP バージョンの NTS とは何を意味するのでしょうか? TS版との違いは何ですか?次、

Douyinのバージョンを確認する方法

Apr 15, 2024 pm 12:06 PM

Douyinのバージョンを確認する方法

Apr 15, 2024 pm 12:06 PM

1. Douyin アプリを開き、右下の [Me] をクリックして個人ページに入ります。 2. 右上隅の[スリーストライプス]アイコンをクリックし、ポップアップメニューバーの[設定]オプションを選択します。 3. 設定ページで一番下までスクロールして、Douyin の現在のバージョン番号情報を表示します。

Chromeブラウザのバージョンを下げるにはどうすればいいですか? Chromeを以前のバージョンに戻す方法

Mar 14, 2024 am 09:22 AM

Chromeブラウザのバージョンを下げるにはどうすればいいですか? Chromeを以前のバージョンに戻す方法

Mar 14, 2024 am 09:22 AM

Chrome ブラウザは現在、最も多くのユーザーがいて高い評価を得ているブラウザであり、ユーザーに包括的で高速なエクスペリエンスを提供することに尽力しています。一部のネチズンは、Google Chrome をアップデートしても古いバージョンの方が使いやすいと感じていますが、Google Chrome のバージョンをダウングレードしたい場合はどうすればよいでしょうか。 Google Chromeをダウングレードする詳しい操作方法を見ていきましょう! Chrome をダウングレードする具体的な方法は、Chrome プロセスを閉じ、chrome.exe が存在するディレクトリ (アプリケーション) を開き、chrome.exe を削除し、old_chrome.exe の名前を chrome.exe に変更し、\UserData\Default\Web Data を削除します。ファイル(このファイルは削除しないでください)

Douyin マトリックス管理システムのどのバージョンが推奨されますか?マトリックスマーケティングってどうやってやるの?

Mar 21, 2024 pm 03:50 PM

Douyin マトリックス管理システムのどのバージョンが推奨されますか?マトリックスマーケティングってどうやってやるの?

Mar 21, 2024 pm 03:50 PM

Douyin の人気に伴い、マーケティングに Douyin を使用し始める企業や個人が増えています。 Douyin マーケティングの重要なツールとして、Douyin マトリックス管理システムも広く注目されています。それでは、Douyin マトリックス管理システムのどのバージョンが推奨されますか?この記事では、この質問に答え、Douyin マトリックス マーケティングのプレイ方法を紹介します。 1. Douyin マトリックス管理システムのどのバージョンが推奨されますか? Douyin マトリックス管理システムには多くのバージョンがあり、現在市場では次のバージョンが一般的です: Douyin のマトリックス管理システムの公式バージョンは、特定の運用経験と予算を持つ企業向けに特別に設計されており、複数のアカウント管理、データ管理を実現できます。解析機能と材料ライブラリ機能。このシステムは、Douyin アカウントを管理する効率的な方法を提供し、企業が運用データをより深く理解し、

ppt バージョンとは何ですか? 複数の PPT バージョンの一覧

Mar 20, 2024 am 10:16 AM

ppt バージョンとは何ですか? 複数の PPT バージョンの一覧

Mar 20, 2024 am 10:16 AM

職場の友人は PPT 制作に精通しているはずです。年末の総括や商業入札など、PPTで表現することが多いですが、PPT制作が初めての方にとっては、PPTのバージョンについてよくわかりません。 PPT のバージョン。 1. PPT2003PowerPower2003はオフィスソフトです。シンプルなインターフェイス、高速な操作、使いやすい、高度なコンピュータ構成を必要とせず、ワードプロセッサ、画像処理、グラフィック編集、アニメーション操作、マルチメディア挿入などの基本的な機能を備えています。 2. PPT2007PowerPoint2007は、前バージョンの利点を継承し、大幅に機能が向上しました。パワーポイントに慣れる

World of Warcraft の全国サーバーの再開に際し、ここに 4 つのメジャー バージョン選択ガイドがあります。最後のガイドはカジュアル プレイヤーに適しています。

Apr 13, 2024 am 09:16 AM

World of Warcraft の全国サーバーの再開に際し、ここに 4 つのメジャー バージョン選択ガイドがあります。最後のガイドはカジュアル プレイヤーに適しています。

Apr 13, 2024 am 09:16 AM

World of Warcraft には現在 4 つのバージョンがあり、国内サーバーは 1 年以上閉鎖されています。各バージョンの現状を整理してみましょう。 1. 公式サーバー バージョン 10.0 の終わり、全国サーバーが閉鎖される前に、バージョン 10.0 が開始されました。その後、バージョン 10.27 があり、エイジ オブ ドラゴン拡張パックは終了します。 。バージョン 10.0 は海外サーバーで好評を博し、Blizzard の人気がいくらか回復しましたが、バージョン 10.0 のゲームの核心は依然として大きな秘密と襲撃が主であり、PVP プレイヤーの数は非常に多くなっています。小さい。公式サーバーバージョンの継続的なアップデートにより、プレイヤーのゲーム傾向も PVE や PVP からコレクションへと変化しました。