ツリーベースのモデルが依然として表形式データでの深層学習よりも優れている理由

この記事では、「なぜツリーベースのモデルが表形式データの深層学習よりも優れているのか」という論文について詳しく説明しますこの論文では、さまざまな分野の世界中の機械学習の専門家によって観察された観察について説明します。観測結果 - ツリーベースのモデルは、深層学習/ニューラル ネットワークよりも表形式データの分析に優れています。

論文に関する注意事項

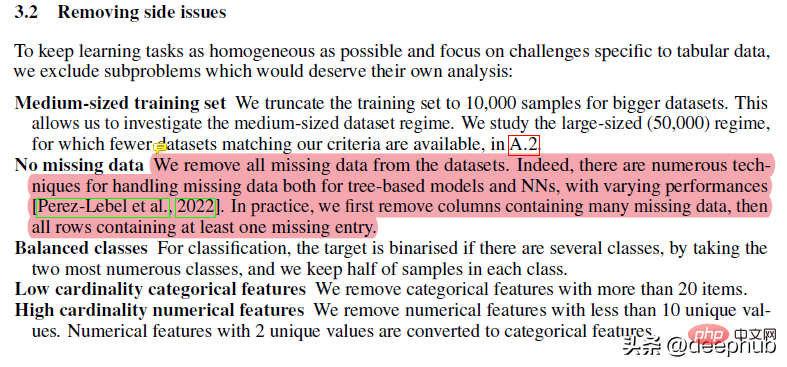

この論文には多くの前処理が施されています。たとえば、欠落データの削除などはツリーのパフォーマンスを妨げる可能性がありますが、データが非常に乱雑であり、多くの特徴とディメンションが含まれている場合には、ランダム フォレストはデータ欠落の状況に最適です。 RF の堅牢性と利点により、RF は問題が発生しやすい「高度な」ソリューションよりも優れています。

残りの作業のほとんどは非常に標準的なものです。私は個人的には、データセットの多くのニュアンスが失われる可能性があるため、あまり多くの前処理テクニックを適用するのは好きではありませんが、この論文で実行される手順は基本的に同じデータセットを生成します。ただし、最終結果を評価するときにも同じ処理方法が使用されることに注意することが重要です。

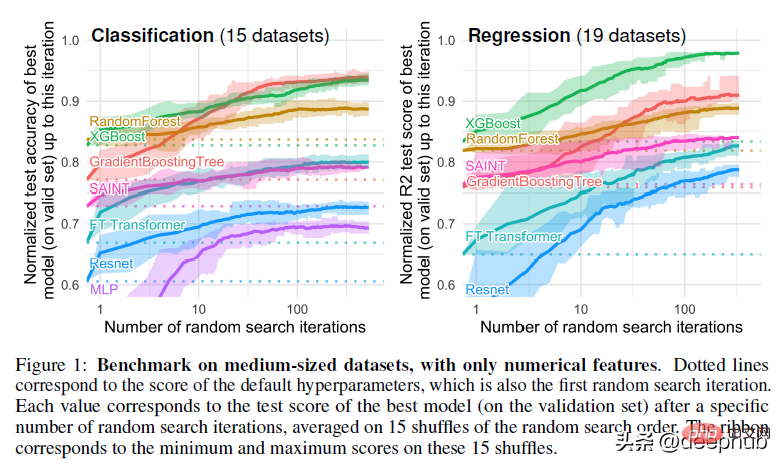

この論文では、ハイパーパラメータ調整にランダム検索も使用しています。これは業界標準でもありますが、私の経験では、ベイジアン検索の方がより広い検索空間での検索に適しています。

これを理解すると、なぜツリーベースの手法が深層学習よりも優れたパフォーマンスを発揮するのかという主要な疑問に踏み込むことができます。

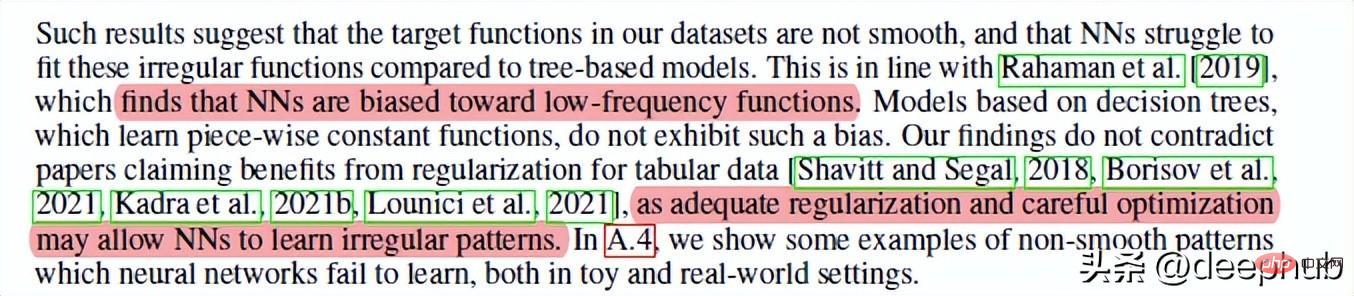

1. ニューラル ネットワークは滑らかすぎるソリューションになる傾向があります

これは著者が共有する最初の理由は、深層学習ニューラル ネットワークがランダム フォレストと競合できない理由です。つまり、滑らかでない関数や決定境界に関しては、ニューラル ネットワークは最適な適合を作成するのが困難です。ランダム フォレストは、奇妙な/ギザギザ/不規則なパターンでより効果的です。

理由を推測すると、ニューラル ネットワークで勾配が使用されている可能性があります。勾配は定義上滑らかな微分可能な検索空間に依存しているため、鋭い点といくつかのランダム関数を区別することは不可能です。したがって、進化的アルゴリズム、従来型検索、その他の基本的な概念などの AI の概念を学習することをお勧めします。これらの概念は、NN が失敗したときのさまざまな状況で素晴らしい結果につながる可能性があります。

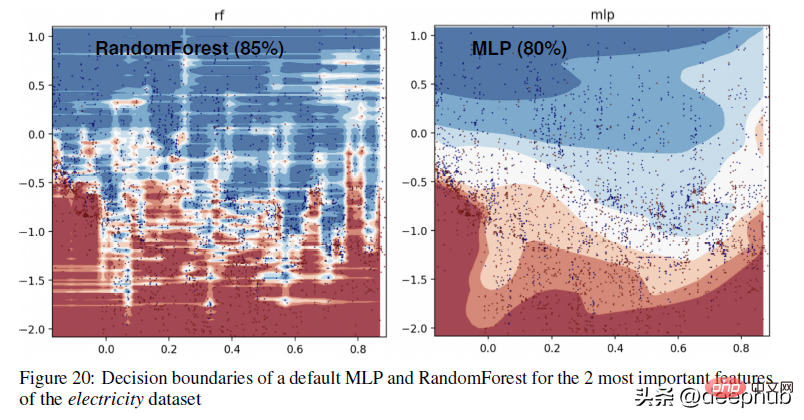

ツリーベースのメソッド (RandomForests) とディープラーナーの間の決定境界の違いのより具体的な例については、以下の図をご覧ください -

付録で、著者は上記の視覚化を次のように説明しています。

このパートでは、RandomForest が MLP では学習できない x 軸上の不規則なパターン (日付特徴に対応) を学習できることがわかります。学ぶ。この違いを、ニューラル ネットワークの典型的な動作であるデフォルトのハイパーパラメーターで示しますが、実際には、これらのパターンを適切に学習するハイパーパラメーターを見つけるのは困難です (不可能ではありません)。

2. 有益ではない特性は、mlp のようなニューラル ネットワークに影響を及ぼします。

もう 1 つの重要な要素は、特に複数の関係を同時にエンコードする大規模なデータ セットにとって重要です。無関係な特徴をニューラル ネットワークに供給すると、ひどい結果になります (モデルのトレーニングにより多くのリソースを無駄にすることになります)。これが、EDA/ドメイン探索に多くの時間を費やすことが非常に重要である理由です。これは機能を理解し、すべてがスムーズに実行されるようにするのに役立ちます。

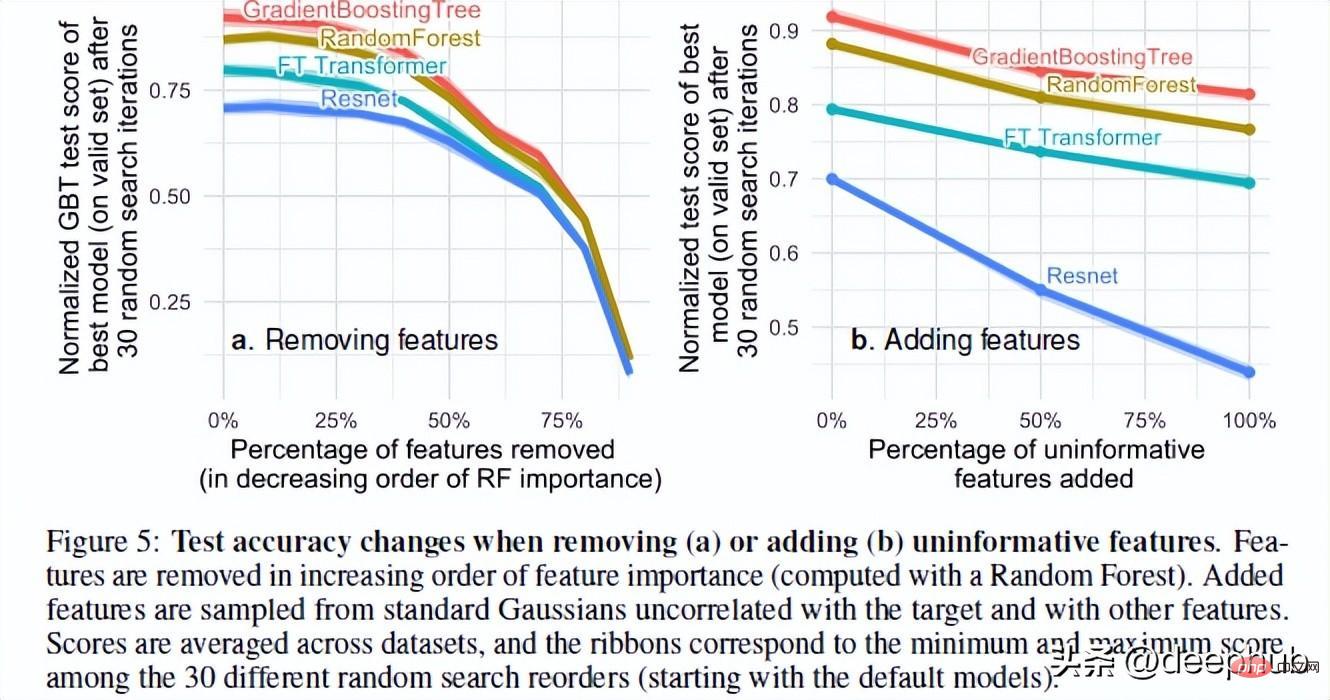

論文の著者は、ランダムな機能を追加したり、不要な機能を削除したりするときのモデルのパフォーマンスをテストしました。その結果に基づいて、2 つの非常に興味深い結果が見つかりました。

多数の機能を削除すると、モデル間のパフォーマンスのギャップが減少します。これは、ツリー モデルの利点の 1 つが、特徴が有用かどうかを判断し、不要な特徴の影響を回避できることであることを明確に示しています。

データセットにランダムな特徴を追加すると、ニューラル ネットワークがツリーベースの方法よりも大幅に劣化することがわかります。 ResNet は特に、これらの役に立たない特性に悩まされています。トランスの改良は、その中のアテンション機構がある程度役に立つからかもしれません。

この現象について考えられる説明の 1 つは、デシジョン ツリーの設計方法です。 AI コースを受講したことのある人なら誰でも、デシジョン ツリーにおける情報ゲインとエントロピーの概念を知っているでしょう。これにより、デシジョン ツリーは残りの特徴を比較して最適なパスを選択できます。

本題に戻りますが、表形式データに関しては、RF のパフォーマンスが NN より優れていることが最後に 1 つあります。それが回転不変性です。

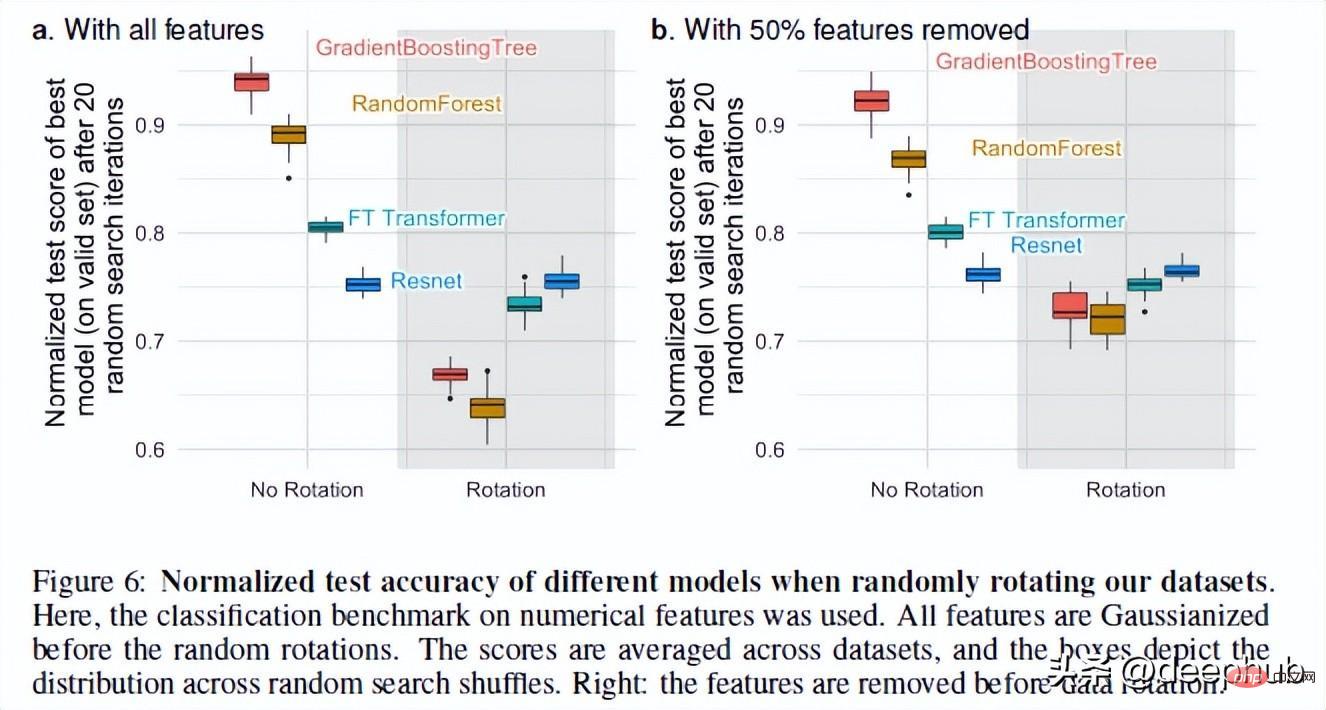

3. NN は回転不変ですが、実際のデータはそうではありません

ニューラル ネットワークは回転不変です。これは、データ セットに対してローテーション操作を実行しても、パフォーマンスが変化しないことを意味します。データセットをローテーションした後、さまざまなモデルのパフォーマンスとランキングが大幅に変化しました。ResNets は常に最悪でしたが、ローテーション後も元のパフォーマンスを維持しましたが、他のすべてのモデルは大きく変化しました。

これは非常に興味深いです: データ セットを回転するとは、具体的には何を意味しますか? 論文全体には詳細な説明がありません (著者に連絡しましたので、フォローアップします)この現象)。ご意見がございましたら、コメント欄で共有してください。

しかし、この操作により、回転の分散がなぜ重要なのかがわかります。著者らによれば、特徴の線形結合 (これが ResNets を不変にする理由です) を採用すると、実際には特徴とその関係が誤って表現される可能性があります。

元のデータをエンコードして最適なデータ バイアスを取得すると、非常に異なる統計的特性を持つ特徴が混在する可能性があり、回転不変モデルでは回復できないため、モデルのパフォーマンスが向上します。

概要

これは非常に興味深い論文です。深層学習はテキストや画像のデータセットでは大きな進歩を遂げましたが、基本的に表形式のデータではまったく利点がありません。この論文では、さまざまなドメインからの 45 のデータセットをテストに使用しており、その結果は、その優れた速度を考慮しなくても、中程度のデータ (約 10,000 サンプル) ではツリーベースのモデルが依然として最先端であることを示しています。

以上がツリーベースのモデルが依然として表形式データでの深層学習よりも優れている理由の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7526

7526

15

15

1378

1378

52

52

81

81

11

11

21

21

74

74

Python での感情分析に BERT を使用する方法と手順

Jan 22, 2024 pm 04:24 PM

Python での感情分析に BERT を使用する方法と手順

Jan 22, 2024 pm 04:24 PM

BERT は、2018 年に Google によって提案された事前トレーニング済みの深層学習言語モデルです。正式名は BidirectionEncoderRepresentationsfromTransformers で、Transformer アーキテクチャに基づいており、双方向エンコードの特性を備えています。従来の一方向コーディング モデルと比較して、BERT はテキストを処理するときにコンテキスト情報を同時に考慮できるため、自然言語処理タスクで優れたパフォーマンスを発揮します。その双方向性により、BERT は文内の意味関係をより深く理解できるようになり、それによってモデルの表現能力が向上します。事前トレーニングおよび微調整方法を通じて、BERT は感情分析、命名などのさまざまな自然言語処理タスクに使用できます。

YOLOは不滅です! YOLOv9 がリリースされました: パフォーマンスとスピード SOTA~

Feb 26, 2024 am 11:31 AM

YOLOは不滅です! YOLOv9 がリリースされました: パフォーマンスとスピード SOTA~

Feb 26, 2024 am 11:31 AM

現在の深層学習手法は、モデルの予測結果が実際の状況に最も近くなるように、最適な目的関数を設計することに重点を置いています。同時に、予測に十分な情報を取得するには、適切なアーキテクチャを設計する必要があります。既存の方法は、入力データがレイヤーごとの特徴抽出と空間変換を受けると、大量の情報が失われるという事実を無視しています。この記事では、ディープネットワークを介してデータを送信する際の重要な問題、つまり情報のボトルネックと可逆機能について詳しく説明します。これに基づいて、深層ネットワークが複数の目的を達成するために必要なさまざまな変化に対処するために、プログラマブル勾配情報 (PGI) の概念が提案されています。 PGI は、目的関数を計算するためのターゲット タスクに完全な入力情報を提供することで、ネットワークの重みを更新するための信頼できる勾配情報を取得できます。さらに、新しい軽量ネットワーク フレームワークが設計されています。

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

以前に書きましたが、今日は、深層学習テクノロジーが複雑な環境におけるビジョンベースの SLAM (同時ローカリゼーションとマッピング) のパフォーマンスをどのように向上させることができるかについて説明します。ここでは、深部特徴抽出と深度マッチング手法を組み合わせることで、低照度条件、動的照明、テクスチャの弱い領域、激しいセックスなどの困難なシナリオでの適応を改善するように設計された多用途のハイブリッド ビジュアル SLAM システムを紹介します。当社のシステムは、拡張単眼、ステレオ、単眼慣性、ステレオ慣性構成を含む複数のモードをサポートしています。さらに、他の研究にインスピレーションを与えるために、ビジュアル SLAM と深層学習手法を組み合わせる方法も分析します。公開データセットと自己サンプリングデータに関する広範な実験を通じて、測位精度と追跡堅牢性の点で SL-SLAM の優位性を実証しました。

潜在空間の埋め込み: 説明とデモンストレーション

Jan 22, 2024 pm 05:30 PM

潜在空間の埋め込み: 説明とデモンストレーション

Jan 22, 2024 pm 05:30 PM

潜在空間埋め込み (LatentSpaceEmbedding) は、高次元データを低次元空間にマッピングするプロセスです。機械学習と深層学習の分野では、潜在空間埋め込みは通常、高次元の入力データを低次元のベクトル表現のセットにマッピングするニューラル ネットワーク モデルです。このベクトルのセットは、「潜在ベクトル」または「潜在ベクトル」と呼ばれることがよくあります。エンコーディング」。潜在空間埋め込みの目的は、データ内の重要な特徴をキャプチャし、それらをより簡潔でわかりやすい形式で表現することです。潜在空間埋め込みを通じて、低次元空間でデータの視覚化、分類、クラスタリングなどの操作を実行し、データをよりよく理解して活用できます。潜在空間埋め込みは、画像生成、特徴抽出、次元削減など、多くの分野で幅広い用途があります。潜在空間埋め込みがメイン

1 つの記事で理解: AI、機械学習、ディープラーニングのつながりと違い

Mar 02, 2024 am 11:19 AM

1 つの記事で理解: AI、機械学習、ディープラーニングのつながりと違い

Mar 02, 2024 am 11:19 AM

今日の急速な技術変化の波の中で、人工知能 (AI)、機械学習 (ML)、および深層学習 (DL) は輝かしい星のようなもので、情報技術の新しい波をリードしています。これら 3 つの単語は、さまざまな最先端の議論や実践で頻繁に登場しますが、この分野に慣れていない多くの探検家にとって、その具体的な意味や内部のつながりはまだ謎に包まれているかもしれません。そこで、まずはこの写真を見てみましょう。ディープラーニング、機械学習、人工知能の間には密接な相関関係があり、進歩的な関係があることがわかります。ディープラーニングは機械学習の特定の分野であり、機械学習

超強い!深層学習アルゴリズムのトップ 10!

Mar 15, 2024 pm 03:46 PM

超強い!深層学習アルゴリズムのトップ 10!

Mar 15, 2024 pm 03:46 PM

2006 年にディープ ラーニングの概念が提案されてから、ほぼ 20 年が経過しました。ディープ ラーニングは、人工知能分野における革命として、多くの影響力のあるアルゴリズムを生み出してきました。では、ディープラーニングのトップ 10 アルゴリズムは何だと思いますか?私の考えでは、ディープ ラーニングのトップ アルゴリズムは次のとおりで、いずれもイノベーション、アプリケーションの価値、影響力の点で重要な位置を占めています。 1. ディープ ニューラル ネットワーク (DNN) の背景: ディープ ニューラル ネットワーク (DNN) は、多層パーセプトロンとも呼ばれ、最も一般的なディープ ラーニング アルゴリズムです。最初に発明されたときは、コンピューティング能力のボトルネックのため疑問視されていました。最近まで長年にわたる計算能力、データの爆発的な増加によって画期的な進歩がもたらされました。 DNN は、複数の隠れ層を含むニューラル ネットワーク モデルです。このモデルでは、各層が入力を次の層に渡し、

1.3ミリ秒には1.3ミリ秒かかります。清華社の最新オープンソース モバイル ニューラル ネットワーク アーキテクチャ RepViT

Mar 11, 2024 pm 12:07 PM

1.3ミリ秒には1.3ミリ秒かかります。清華社の最新オープンソース モバイル ニューラル ネットワーク アーキテクチャ RepViT

Mar 11, 2024 pm 12:07 PM

論文のアドレス: https://arxiv.org/abs/2307.09283 コードのアドレス: https://github.com/THU-MIG/RepViTRepViT は、モバイル ViT アーキテクチャで優れたパフォーマンスを発揮し、大きな利点を示します。次に、この研究の貢献を検討します。記事では、主にモデルがグローバル表現を学習できるようにするマルチヘッド セルフ アテンション モジュール (MSHA) のおかげで、軽量 ViT は一般的に視覚タスクにおいて軽量 CNN よりも優れたパフォーマンスを発揮すると述べられています。ただし、軽量 ViT と軽量 CNN のアーキテクチャの違いは十分に研究されていません。この研究では、著者らは軽量の ViT を効果的なシステムに統合しました。

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

エディター | Radish Skin 2021 年の強力な AlphaFold2 のリリース以来、科学者はタンパク質構造予測モデルを使用して、細胞内のさまざまなタンパク質構造をマッピングし、薬剤を発見し、既知のあらゆるタンパク質相互作用の「宇宙地図」を描いてきました。ちょうど今、Google DeepMind が AlphaFold3 モデルをリリースしました。このモデルは、タンパク質、核酸、小分子、イオン、修飾残基を含む複合体の結合構造予測を実行できます。 AlphaFold3 の精度は、これまでの多くの専用ツール (タンパク質-リガンド相互作用、タンパク質-核酸相互作用、抗体-抗原予測) と比較して大幅に向上しました。これは、単一の統合された深層学習フレームワーク内で、次のことを達成できることを示しています。