人工知能に関する 10 の質問: AI がますます複雑になるにつれ、未来はどこにあるのでしょうか?

近年、人工知能は爆発、発展、そして最近では徐々に人気が低下しており、人工知能は大企業だけができるゲームになりつつあるようです。

理由は、人工知能に対する「敷居」がどんどん高くなっているからです。

少し前に、Google AIの代表格であるジェフ・ディーン氏が新作を発表しましたが、業界ではかなりの物議を醸しました。理由は作品自体が素晴らしいからではありません。この研究では、最新の結果と比較して 0.03% の改善しかありませんでしたが、TPU の計算能力に 57,000 ドル以上のコストがかかり、これは大きな問題です。

現在のAI研究はコンピューティングパワーとリソースの代表的なものになっていて、普通の学者はもう勉強できないと言っている人が多いです。

人工知能は私たちにどのような変化をもたらしたのでしょうか?このような疑問を抱いている人はまだたくさんいます。囲碁をプレイする以外に何ができるのでしょうか?そしてその将来はどうなるでしょうか?

これらの質問について、私たちはフォン ジー博士と綿密なコミュニケーションをとりました。彼は、Nanjing AI Research Institute of Sinovation Ventures のエグゼクティブ ディレクターであり、Bei Yang Quantitative の創設者でもあり、AI 分野で長年の研究経験を持っています。この会話を通じて、私たちは AI の将来の開発と実装について新たな理解を得ることができました。

1 人工知能のイノベーション、天井にぶつかりましたか?

Google は最近この問題に関して多くの注目を集めています。検討する価値のある問題が 3 つあると思います:

まず、大きな問題です。メーカーは徐々に「暴力的な美学」への移行を始めています。 とは、「超大規模データ」と「超大規模コンピューティング能力」を使用して、ディープ ニューラル ネットワークの天井を暴力的に探索することを意味します。しかし、このアプローチの境界と限界はどこにあるのでしょうか?

第二に、学術的および科学的研究の観点から見ると、この方法が AI の唯一の解決策なのでしょうか? 実際には、知覚知能から認知知能に変換する方法や、比較的少量のデータを使用して人工知能が遭遇する問題を解決する方法など、他の技術的ルートを模索する研究がすでに多く行われています。

#第三に、業界の実際のアプリケーションには、これほど大きなコンピューティング能力が本当に必要なのでしょうか? 業界には音声以外の画像、テキストに関連するタスクが多数あり、学術コミュニティもより効率的なアルゴリズムの開発を余儀なくされています。

2 人工知能アルゴリズム、ディープ ニューラル ネットワークのみ?

1990年代以前の「人工知能」の代表的な技術は、まだ「象徴主義」、つまり論理的推論に基づいた計画や検索などの技術でした。

2010 年以降、人工知能における重要な変化が到来しました。これは、ニューラル ネットワーク テクノロジを使用して、これらの知覚タスクをより適切に表現することでした。しかし、人工知能には、論理的推論の方法、常識の使い方、記憶のモデル化の改善方法など、未解決の「聖杯」問題がまだ多数残されています。

これらの問題を解決するには、ディープ ニューラル ネットワークを使用するだけで十分でしょうか?これは、学界と産業界がより懸念している次の重要な方向性かもしれません。

3 人工知能の未来: 知覚 vs 認知?

いわゆる「知覚人工知能」は、実際には、画像認識、音声テキスト変換、一部のテキスト生成タスクなど、近年成功した人工知能の実装の代表的な例です。 。

しかし、より重要なのは、知覚タスクから認知タスクにどのように移行するか、特に人工知能を使用して論理的推論と常識を達成し、それによって一般的な人工知能を真に実現する方法でしょうか?

この問題に対応するには、私の知る限り、学術界には 3 つの主要な技術的ルートがあります。

まず、引き続きニューラル ネットワークの道をたどり、データと計算能力を継続的に蓄積することで問題の解決を試みます。

第二に、象徴主義の技術、つまりコネクショニズムと象徴主義の組み合わせを導入してみます。

3 番目に、従来の論理的推論テクニックを改善し続けます。このルートは最も困難でもあります。

4 データ: デジタル時代に石油を抽出するにはどうすればよいですか?

データは人工知能エンジニアリングにとってますます重要になっています。 業界は、「データ中心」開発モデルと呼ばれる新しい概念を提案しました。 対照的に、これは以前は「モデル中心」と呼ばれていました。

従来、エンジニアは、システムのパフォーマンスを向上させるためにモデルを構築する方法とパラメータを調整する方法に多くの時間を費やしていました。しかし現在では、全員の関心の 80% は、データ セットをより良くする方法、トレーニング セットをより良くする方法、トレーニング セットのバランスをより良くする方法、そして適切なデータ セットでモデルをトレーニングさせる方法に向けられています。より良い結果が得られます。

データプライバシーに対する要求が徐々に高まるにつれて、データによってもたらされる悪影響や非技術的な要件も増加しています。たとえば、複数の機関が共同モデリングを行う場合、データのプライバシーを保護するために機関間でデータを共有することはできません。 したがって、フェデレーテッド ラーニングのようなテクノロジーは、データ プライバシーを保護しながら共同モデリングを実現するように設計されています。

今では、特定の産業開発における各組織の違いはデータであることに誰もが徐々に気づいています。 非常に便利なソフトウェア オープン ソース フレームワークと非常に効率的なハードウェア実装が存在する今、エンジニアはデータに注目するようになりました。 - これはパラダイム シフト、つまりパラダイム レベルのシフトです。

私自身が立ち上げたBeyang Quantitativeは、AI技術を核としたヘッジファンドです。企業内で毎日保存する必要があるデータの量は約 25 ~ 30 TB です。そこで「メモリの壁」問題に遭遇します。

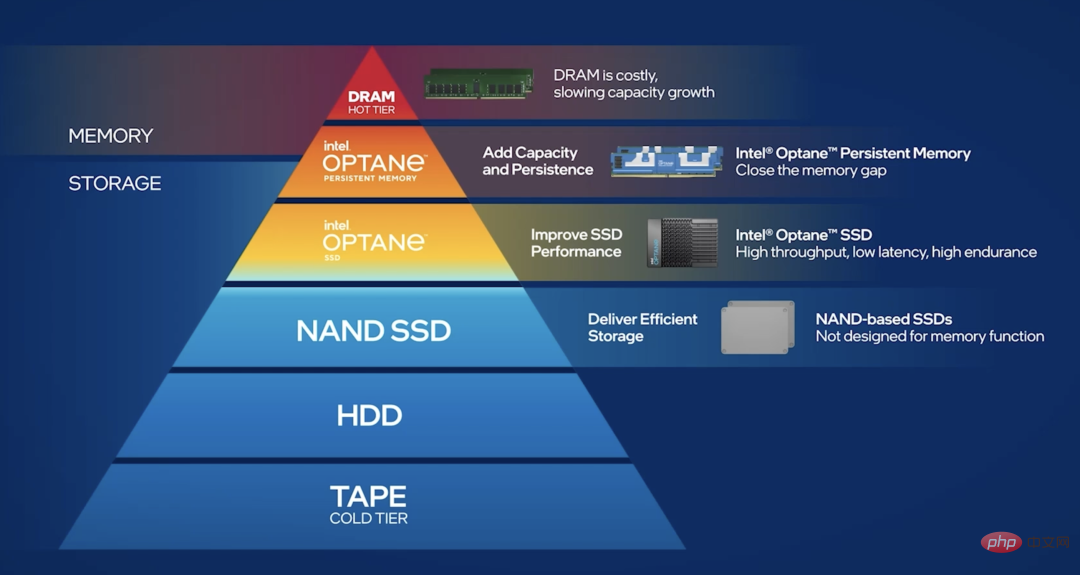

メモリ上の大量のデータによってもたらされるプレッシャーに対処するために、データをコールド データ、ウォーム データ、ホット データに分割します。 「コールド データ」とは、データ アクセスの頻度がそれほど高くなく、データベースにドロップできるデータを意味します。 「ホットデータ」とは、大量の読み取りおよび書き込みタスクを実行する必要があり、一般にデータが分散しており、毎回の読み取りおよび書き込みの量が非常に多いことを意味します。では、ホットデータを分散して保存するにはどうすればよいでしょうか?

純粋な SSD ソリューションと比較すると、Optane 永続メモリなど、メモリと SSD の間にある、より優れたソリューションが現在あります。データを分散して保存できるため、「メモリの壁」問題をある程度軽減できます。

5「AI ネイティブ」IT インフラストラクチャは登場するのでしょうか?

現在、クラウド コンピューティング インフラストラクチャの再構築を促進する「クラウド ネイティブ」と呼ばれる非常に人気のある概念があります。そして 人工知能の「AI ネイティブ」は実際に起こりました。 特に過去 10 年間、コンピューター ハードウェアの革新は実際に人工知能アプリケーションを中心に発展してきました。

たとえば、現在、クラウドにおけるトラステッド コンピューティングに対する需要が高まっています。例えば、AIモデルの計算プロセスは企業の中核となる知的財産であり、それをクラウドやパブリックプラットフォーム上に置くと、当然、計算プロセスが盗まれるリスクが懸念されます。

この場合、ハードウェアベースの解決策はありますか?答えは「はい」です。たとえば、インテル チップ上で SGX プライバシー サンドボックスを使用しています。これにより、ハードウェアでの計算を保護できます。これは実際、組織間の協力にとって非常に重要な基盤です。

これは非常に典型的な例です。つまり、需要から始まり、チップまたはハードウェアのメーカーに対応するソリューションの提供を促します。

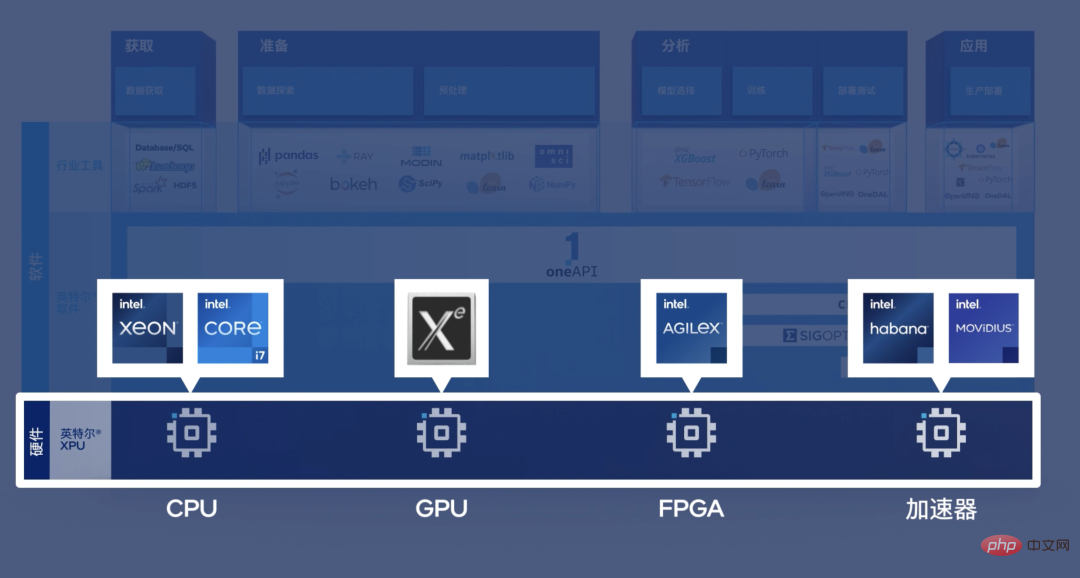

6 人工知能ハードウェアは GPU と同等ですか?

この見方は確かに一方的です。 BeiYang Quantitative の日常業務を例に挙げると、定量取引を行う場合、データを CPU から GPU にコピーしてからコピーし直すと、多くの定量取引タスクでは手遅れになります。言い換えれば、非常に高性能な CPU バージョンの人工知能モデルの実装が必要になります。

別の例として、ネットワーク カード上のデータの直接分析と処理を必要とするタスクが数多くあり、ネットワーク カードには通常 FPGA チップが搭載されています。 GPU に転送されます。立ち上がるのにも遅すぎます。人工知能テクノロジーの助けを必要とするこの種の低遅延シナリオでは、ヘテロジニアス アーキテクチャが必要です。

言い換えれば、FPGA、ASIC、CPU、GPU のいずれであっても、さまざまなシナリオでさまざまな用途があります。

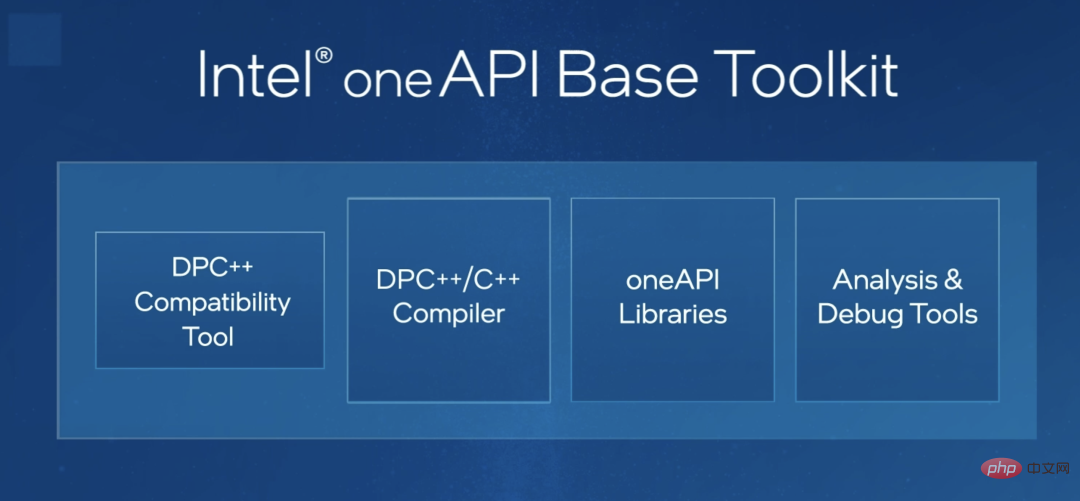

異種プラットフォーム向けのプログラミングに関しては、業界ではすでにいくつかの試みが行われているようです。例えばIntelのoneAPI、これは非常に重要なツールだと思います。言い換えれば、oneAPI を使用すると、同じコード セットを CPU、FPGA、またはその他のタイプのチップに自動的に適応させることができます。これにより、エンジニアはプログラミングの難しさが大幅に軽減され、アルゴリズムの革新に集中できるようになります。

これは異種アプリケーションを促進するために非常に重要だと思います。

7 将来の人工知能開発の他の方向性は何ですか?

より優れたエンドツーエンドのソリューションが必要になる可能性があると思います。今、私たちは実際に「ソフトウェア 1.0」から「ソフトウェア 2.0」の時代にアップグレードしました。言い換えれば、 は、複雑なソフトウェア エンジニアリングの従来のルール駆動型構築から、データ駆動型ソフトウェア エンジニアリング構築手法に変更しました。

以前は、高度な創意工夫に頼って、プログラム全体を実行するための一連の精巧なシステムを作成する必要がありました。これは機械式時計と似ており、優秀なプログラマーは「歯車」の動作を構築し、この「時計」をどのように動かすかに重点を置いています。

この一連の操作ルールを決定する方法がわからない場合は、それを大量のデータまたは機械学習アルゴリズムに与えてください。このアルゴリズムは、新しいアルゴリズム、そしてこの新しいアルゴリズムが私たちが取得したいものです。このアプローチは、ロボットを構築するロボットの構築に似ています。

ソフトウェア 2.0 時代には、ソフトウェア エンジニアリング全体の開発パラダイムが大きく変わります。私たちは、一連のエンドツーエンドのソリューションを手に入れることを強く望んでいます。それをいかに便利に実装するかという「データ中心」のソフトウェアエンジニアリング開発。

8 人工知能は将来どのように実装されるのでしょうか?

#おそらく 2 つの側面があると思います。まず、産業の観点から見ると、私たちは依然として第一原則から始める必要があります。つまり、私たち自身のニーズに基づいて、多くの非技術的要因を考慮に入れる必要があります。たとえば、地域のセキュリティのために顔認証システムを開発したいという企業を見たことがありますが、入口と出口ごとに 4 つの非常に高価な GPU が必要で、これはニーズとコストから始めていない典型的な例です。

第二に、学術研究は必ずしもトレンドに従うわけではありません。冒頭で述べたように、モデルのサイズに関して互いに競争する必要はありません。あなたが数千億のモデルを持っているなら、私は数兆のモデルを構築し、あなたが数兆のモデルを持っているなら、私は構築します。一、十兆。

実際には、小規模なパラメータを必要とするタスクや、コストやその他の制約により少数のサンプルしか提供できないタスクが多数あります。このような状況下で、どのようにイノベーションを起こし、ブレークスルーを起こすのでしょうか?これは学術界が率先して担うべき責任である。

9 人工知能の起業家精神は今でもホットな話題ですか?

考えてみましょう。1990 年代後半、当時はネットワーク プログラミングのスキルを持つ人がほとんどいなかったため、Web サイトを構築するには 20,000 ~ 30,000 元かかりました。しかし今では、おそらく高校生なら誰でも、マウスをワンクリックするだけでウェブサイトを構築できるでしょう。

#言い換えれば、ネットワークの知識は、すべての一般的なプログラマーのツール キットにすでに組み込まれています。

#実は、同じことが人工知能テクノロジーにも当てはまります。 2015 年頃、深層学習フレームワークを構築して GPU で実行できる人はおそらく世界中で 1,000 人もいなかったと思います。しかし今では指数関数的な成長を遂げており、多くの人がその方法を知っています。約 5 年以内に、すべてのプログラマーがツールキットにさらに豊富な人工知能ソリューションを組み込むようになり、その実装の敷居が確実に継続的に低下すると信じる理由があります。この方法によってのみ、人工知能テクノロジーをあらゆる企業でより一般的に使用できるようになります。

# したがって、大規模工場の AI ラボは必然的に消滅します。 2000 年頃と同様、多くの企業がインターネット ラボを設置しています。インターネット ラボは、企業のネットワーク関連のすべてを専門に扱う研究所であり、この研究所は他のビジネス部門に技術的な成果を提供しています。この技術を知っている人が非常に少ないため、このようにする必要があるからです。

AI Labも同様で、AI技術の導入の敷居が徐々に下がり、事業部門にも同様の技術を持っている人が多くなったとき、このようなAI Labは、必然的に消滅する。これは技術開発の過程における一時的なものであり、それはそれで良いことだと思います。 大手メーカーに AI ラボがないときが、おそらく人工知能が本当に開花するときです。

10 人工知能は公衆にどのような利益をもたらしますか?

まず、ムーアの法則の祝福も必要です。 大量の計算能力を必要とするタスクがまだ多数あります。ハードウェアを反復し、アルゴリズムを更新し続ける必要があります。クラスター上で実行する必要があるものが携帯電話上で実行できる場合にのみ、AI を大量に実装できます。

第二に、人工知能イノベーションの焦点は、インターネット ビジネスから一部の伝統的な産業に移らなければなりません。 以前は、誰もが人工知能を使用して、より優れたビジュアル ソリューション、より優れたレコメンデーション システム、またはより優れた P ピクチャ ソフトウェアを作成する方法に焦点を当てていました。しかし、現実の経済では、実際にはデータを生成する部門や企業が多数存在します。これらの現実の経済データがより適切な情報に基づいて得られるようになれば、それらがもたらす価値は現在の仮想経済の価値をはるかに超える可能性があります。

以上が人工知能に関する 10 の質問: AI がますます複雑になるにつれ、未来はどこにあるのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7479

7479

15

15

1377

1377

52

52

77

77

11

11

19

19

33

33

酸性特性を理解する:信頼できるデータベースの柱

Apr 08, 2025 pm 06:33 PM

酸性特性を理解する:信頼できるデータベースの柱

Apr 08, 2025 pm 06:33 PM

データベース酸属性の詳細な説明酸属性は、データベーストランザクションの信頼性と一貫性を確保するための一連のルールです。データベースシステムがトランザクションを処理する方法を定義し、システムのクラッシュ、停電、または複数のユーザーの同時アクセスの場合でも、データの整合性と精度を確保します。酸属性の概要原子性:トランザクションは不可分な単位と見なされます。どの部分も失敗し、トランザクション全体がロールバックされ、データベースは変更を保持しません。たとえば、銀行の譲渡が1つのアカウントから控除されているが別のアカウントに増加しない場合、操作全体が取り消されます。 TRANSACTION; updateaccountssetbalance = balance-100wh

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

MySQLはJSONデータを返すことができます。 json_extract関数はフィールド値を抽出します。複雑なクエリについては、Where句を使用してJSONデータをフィルタリングすることを検討できますが、そのパフォーマンスへの影響に注意してください。 JSONに対するMySQLのサポートは絶えず増加しており、最新バージョンと機能に注意を払うことをお勧めします。

マスターSQL制限条項:クエリの行数を制御する

Apr 08, 2025 pm 07:00 PM

マスターSQL制限条項:クエリの行数を制御する

Apr 08, 2025 pm 07:00 PM

sqllimit句:クエリ結果の行数を制御します。 SQLの制限条項は、クエリによって返される行数を制限するために使用されます。これは、大規模なデータセット、パジネートされたディスプレイ、テストデータを処理する場合に非常に便利であり、クエリ効率を効果的に改善することができます。構文の基本的な構文:SelectColumn1、column2、... FromTable_nameLimitnumber_of_rows; number_of_rows:返された行の数を指定します。オフセットの構文:SelectColumn1、column2、... FromTable_nameLimitoffset、number_of_rows; offset:skip

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

MySQLデータベースパフォーマンス最適化ガイドリソース集約型アプリケーションでは、MySQLデータベースが重要な役割を果たし、大規模なトランザクションの管理を担当しています。ただし、アプリケーションのスケールが拡大すると、データベースパフォーマンスのボトルネックが制約になることがよくあります。この記事では、一連の効果的なMySQLパフォーマンス最適化戦略を検討して、アプリケーションが高負荷の下で効率的で応答性の高いままであることを保証します。実際のケースを組み合わせて、インデックス作成、クエリ最適化、データベース設計、キャッシュなどの詳細な主要なテクノロジーを説明します。 1.データベースアーキテクチャの設計と最適化されたデータベースアーキテクチャは、MySQLパフォーマンスの最適化の基礎です。いくつかのコア原則は次のとおりです。適切なデータ型を選択し、ニーズを満たす最小のデータ型を選択すると、ストレージスペースを節約するだけでなく、データ処理速度を向上させることもできます。

Prometheus MySQL ExporterでMySQLおよびMariadb液滴を監視します

Apr 08, 2025 pm 02:42 PM

Prometheus MySQL ExporterでMySQLおよびMariadb液滴を監視します

Apr 08, 2025 pm 02:42 PM

MySQLおよびMariaDBデータベースの効果的な監視は、最適なパフォーマンスを維持し、潜在的なボトルネックを特定し、システム全体の信頼性を確保するために重要です。 Prometheus MySQL Exporterは、プロアクティブな管理とトラブルシューティングに重要なデータベースメトリックに関する詳細な洞察を提供する強力なツールです。

MySQLの主な鍵はヌルにすることができます

Apr 08, 2025 pm 03:03 PM

MySQLの主な鍵はヌルにすることができます

Apr 08, 2025 pm 03:03 PM

MySQLプライマリキーは、データベース内の各行を一意に識別するキー属性であるため、空にすることはできません。主キーが空になる可能性がある場合、レコードを一意に識別することはできません。これにより、データの混乱が発生します。一次キーとして自己挿入整数列またはUUIDを使用する場合、効率やスペース占有などの要因を考慮し、適切なソリューションを選択する必要があります。

MongoDBデータベースパスワードを表示するNAVICATの方法

Apr 08, 2025 pm 09:39 PM

MongoDBデータベースパスワードを表示するNAVICATの方法

Apr 08, 2025 pm 09:39 PM

Hash値として保存されているため、Navicatを介してMongoDBパスワードを直接表示することは不可能です。紛失したパスワードを取得する方法:1。パスワードのリセット。 2。構成ファイルを確認します(ハッシュ値が含まれる場合があります)。 3.コードを確認します(パスワードをハードコードできます)。

SQLで条項ごとに注文をマスターする:効果的にデータを並べ替える

Apr 08, 2025 pm 07:03 PM

SQLで条項ごとに注文をマスターする:効果的にデータを並べ替える

Apr 08, 2025 pm 07:03 PM

SQLORDERBY句の詳細な説明:Data OrderBY句の効率的なソートは、クエリ結果セットをソートするために使用されるSQLの重要なステートメントです。単一の列または複数の列で昇順(ASC)または下降順序(DESC)で配置でき、データの読みやすさと分析効率を大幅に改善できます。 Orderby Syntax SelectColumn1、column2、... fromTable_nameOrderByColumn_name [asc | desc]; column_name:列ごとに並べ替えます。 ASC:昇順の注文ソート(デフォルト)。 DESC:降順で並べ替えます。 Orderbyの主な機能:マルチコラムソート:複数の列のソートをサポートし、列の順序によりソートの優先度が決まります。以来