AIは絵がとても上手です。

最近、Meta は AI「ペインター」である Make-A-Scene も開発しました。

テキストを使用して絵画を生成することはそれほど簡単だとまだ思いますか?

少し前に Google が立ち上げた「アーティスト」Parti のように、テキストによる説明のみに依存すると、場合によっては「ひっくり返る」可能性があることを知っておく必要があります。

「バナナのない皿と、その隣にオレンジジュースの入っていないグラス。」

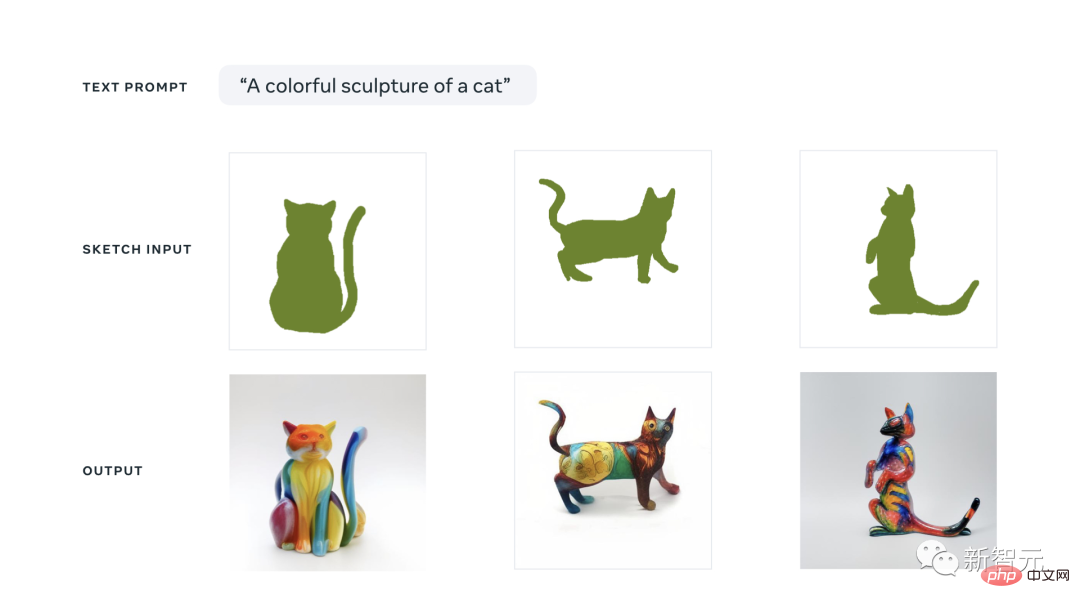

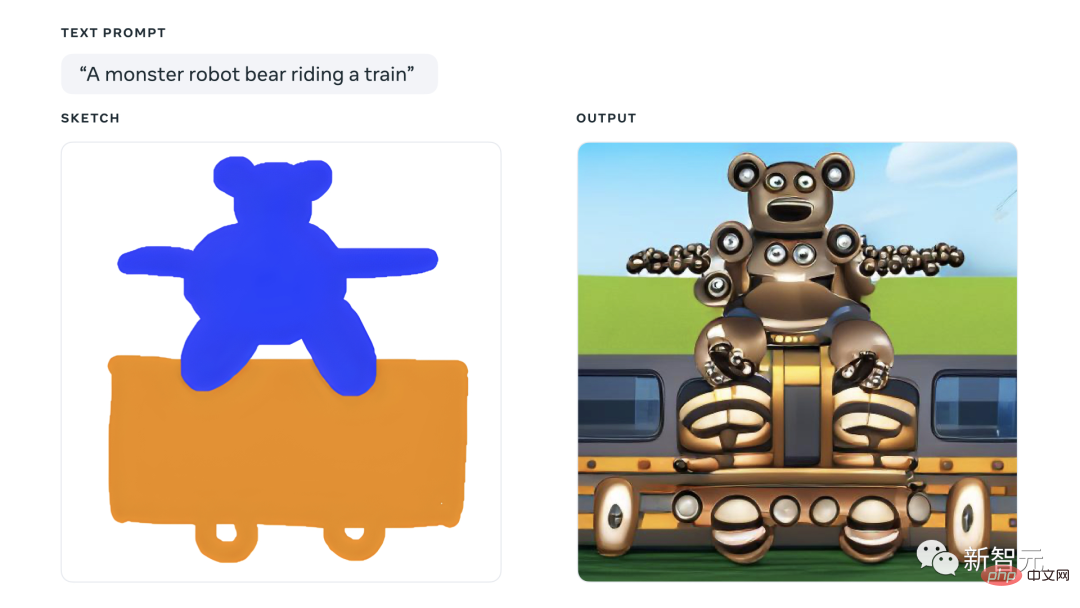

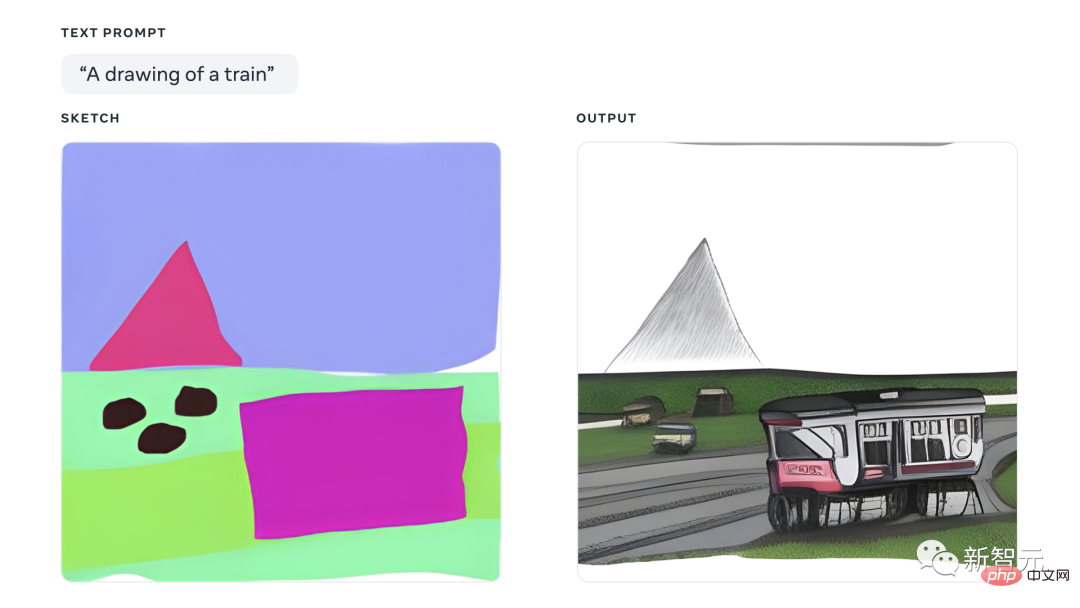

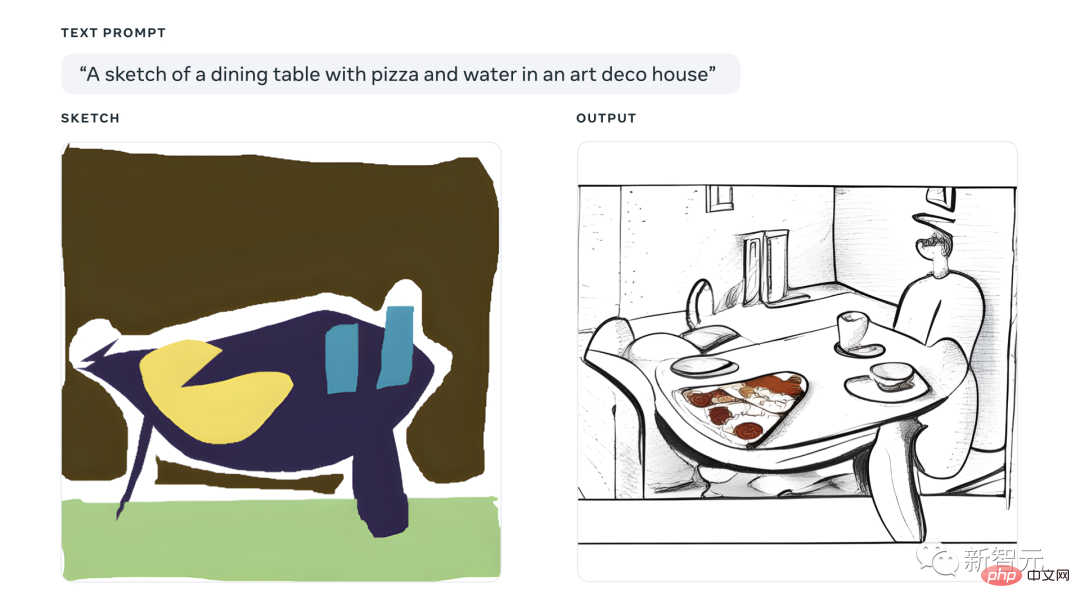

今回のメイク・ア・シーンは次のように説明できます。テキストとスケッチを使用して、希望の外観を作成します。

作品の上下、左右、サイズ、形、その他の要素について最終決定権を持ちます。

LeCun も自社製品のプロモーションに名乗りを上げていますが、クリエイティビティは言うまでもなく、鍵となるのは「コントロール可能」です。

Make-A-Scene はとても素晴らしいので、見てみましょう。

練習なしの話ばかり、インチキトリック!

人々が想像力を実現するためにメイク・ア・シーンをどのように使用しているかを見てみましょう。

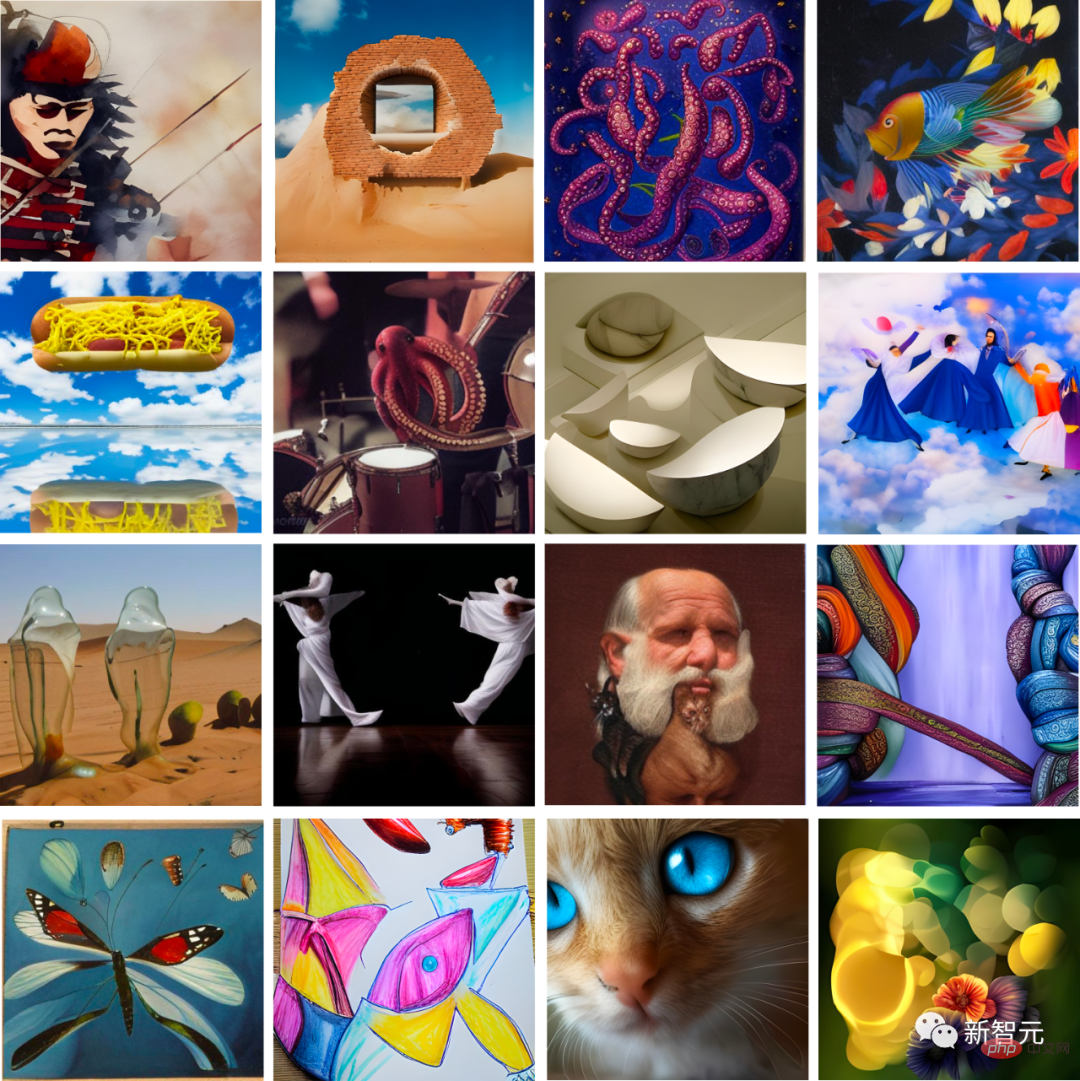

研究チームは、有名な人工知能アーティストとメイク・ア・シーンのデモンストレーションセッションを実施します。

アーティスト チームには、Sofia Crespo、Scott Eaton、Alexander Reben、Refik Anadol などを含む強力なラインナップが揃っています。これらのマスターは、生成人工知能の適用について直接の経験を持っています。 。 経験。

研究開発チームは、これらのアーティストがクリエイティブ プロセスの一部としてメイク ア シーンを使用し、使用中にフィードバックを提供できるようにしています。

次は、巨匠たちが作った作品をメイク・ア・シーンで鑑賞しましょう。

たとえば、ソフィア クレスポは、自然とテクノロジーの交差点に焦点を当てたアーティストです。彼女は、これまで存在しなかった人工生命体を想像するのが好きだったので、Make-A-Scene のスケッチ機能とテキスト プロンプト機能を使用して、全く新しい「ハイブリッド クリーチャー」を作成しました。

たとえば、花の形をしたクラゲ。

Crespo は無料の描画機能を活用して、新しいアイデアを迅速に反復します。彼女は、メイク・ア・シーンはアーティストが自分たちの創造性をよりよく表現できるようになり、より直感的なインターフェースを使って絵を描くことができるようになると語った。

(フラワー ジェリーフィッシュ)

スコット イートンは、アーティスト、教育者、クリエイティブ テクノロジーの専門家であり、現代の現実とテクノロジー間の関係を研究しています。

彼はシーンを構成する方法としてメイク・ア・シーンを使用し、気候を強調するために「砂漠に沈んで朽ち果てた高層ビル」などのテーマを使用するなど、さまざまな手がかりを通じてシーンの変化を探ります。 。

(砂漠の高層ビル)

Alexander Reben はアーティスト、研究者、ロボット工学者です。

彼は、出力をもっとコントロールできれば、芸術的な意図を表現するのに本当に役立つと信じています。彼はこれらのツールを進行中のシリーズに組み込んでいます。

メディア アーティスト兼ディレクターの Refik Anadol にとって、このツールは想像力の発達を促進し、未知の領域をより良く探索する方法です。

#実は、このプロトタイプ ツールはアートに興味がある人だけを対象としたものではありません。

研究チームは、メイク・ア・シーンは、芸術的才能があまりない人も含め、誰でも自分自身をより良く表現できるのに役立つと信じています。

手始めに、研究チームはメイダの従業員に部分的なアクセスを提供しました。彼らは Make-A-Scene の体験をテストし、フィードバックを提供しています。

Meda プロジェクト マネージャーの Andy Boyatzis は、Make-A-Scene を使用して 2 歳と 4 歳の子供たちとアートを作成しています。彼らは遊び心のある絵を使って、自分たちのアイデアや想像力に命を吹き込みます。

以下は彼らの作品です~

カラフルな猫の彫刻~かわいいでしょう?しかし、この色は実際には、子供が粘土の大きな塊をこねているような、見るに耐えない色です。

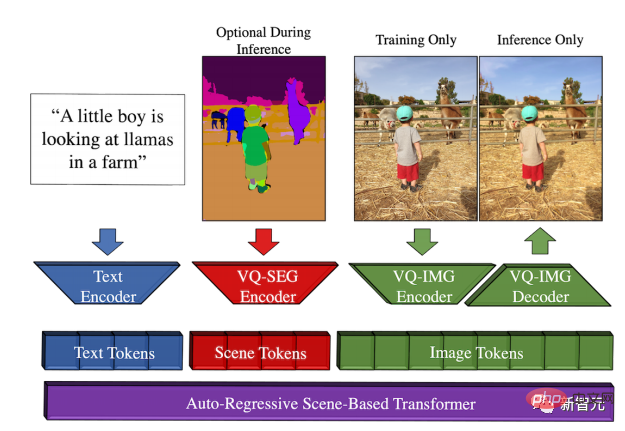

これは、テキスト、シーン、イメージという 3 つの独立した連続トークン スペースを持つ自己回帰トランスフォーマーに依存しています。

トークン シーケンスは、BPE エンコーダによってエンコードされたテキスト トークン、VQ-SEG によってエンコードされたシーン トークン、および VQ-IMG によってエンコードまたはデコードされたイメージ トークンで構成されます。

シーンベースの Transformer をトレーニングする前に、エンコードされた各トークン シーケンスは [テキスト、シーン、画像] タプルに対応し、対応するエンコーダーを使用して抽出されます。

さらに、著者らは、無条件サンプルを条件付きサンプルに誘導するプロセスである分類子なしのガイダンスも採用しました。

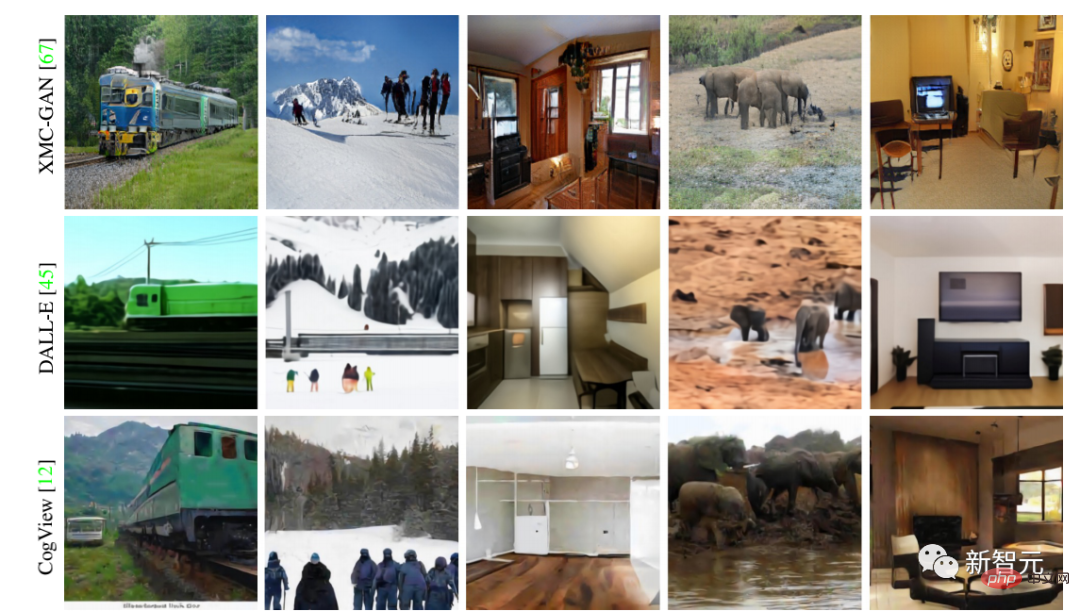

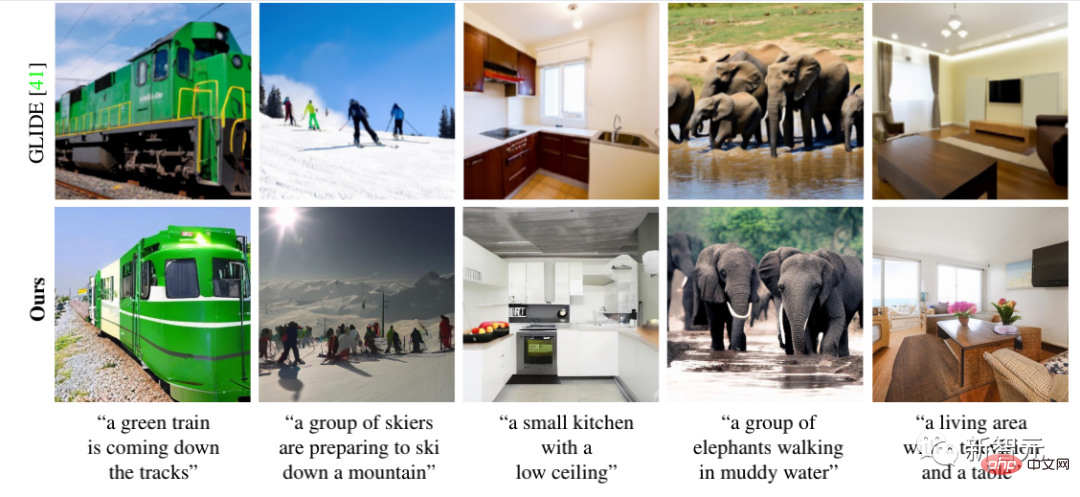

このモデルは SOTA の結果を達成します。以前の方法との比較を詳しく見てみましょう

研究者らはまた、Make-A-Scene を超解像度ネットワークを使用すると、2048x2048 と 4 倍の解像度の画像を生成できます。

は次のとおりです:

実際、他の生成 AI モデルと同様に、Make-A-Scene は何百万ものサンプル画像との関係をトレーニングすることで視覚を学習します。テキスト。

トレーニング データに反映されたバイアスがこれらのモデルの出力に影響を与える可能性があることは否定できません。

研究者らが指摘したように、Make-A-Scene にはまだ改善すべき点がたくさんあります。

以上がMeta の最新の画像生成ツールは、夢を現実に変えることができるため、非常に人気があります。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。