機械学習回帰モデルに関連する重要な知識ポイントのまとめ

1. 線形回帰の前提とは何ですか?

線形回帰には 4 つの仮定があります。

- 線形: 独立変数 (x) と従属変数 (y) の間には線形関係がある必要があります。 x 値も同じ方向に y 値を変更する必要があります。

- 独立性: 特徴は互いに独立している必要があります。これは、多重共線性が最小限であることを意味します。

- 正規性: 残差は正規分布する必要があります。

- 等分散性: 回帰直線の周囲のデータ ポイントの分散は、すべての値で同じである必要があります。

2.残差とは何ですか?回帰モデルの評価に残差はどのように使用されますか?

残差とは、予測値と観測値の間の誤差を指します。回帰直線からのデータ ポイントの距離を測定します。観測値から予測値を差し引くことで計算されます。

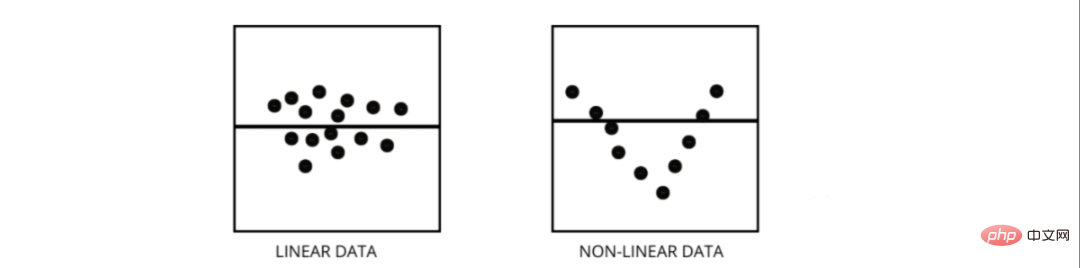

残差プロットは回帰モデルを評価する良い方法です。これは、縦軸にすべての残差、x 軸に特徴を示すグラフです。データ ポイントがパターンのない直線上にランダムに散在している場合は、線形回帰モデルがデータによく適合します。そうでない場合は、非線形モデルを使用する必要があります。

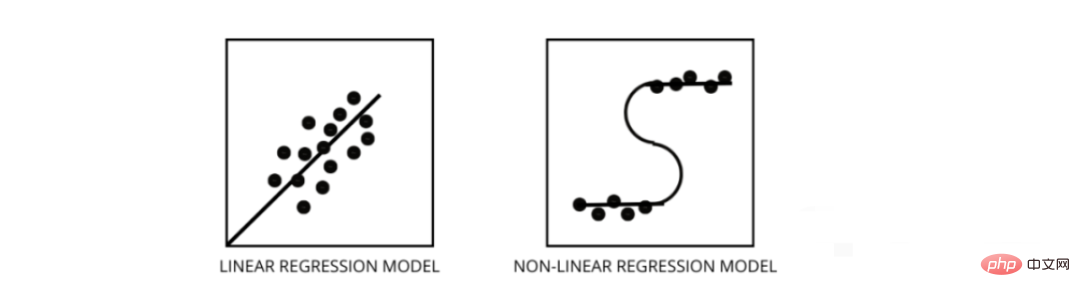

3. 線形回帰モデルと非線形回帰モデルを区別するにはどうすればよいですか?

どちらも回帰問題の一種です。 2 つの違いは、トレーニングに使用されるデータです。

線形回帰モデルは、フィーチャとラベルの間に線形関係があることを前提としています。つまり、すべてのデータ ポイントを取得して線形 (直線) にプロットすると、データが適合するはずです。

非線形回帰モデルは、変数間に線形関係がないことを前提としています。非線形 (曲線) 線はデータを分離し、正しくフィットさせる必要があります。

データが線形か非線形かを確認するための 3 つの最良の方法 -

- 残差プロット

- 散布点図

- データが線形であると仮定すると、線形モデルがトレーニングされ、精度によって評価されます。

4.多重共線性とは何ですか?それはモデルのパフォーマンスにどのような影響を与えますか?

多重共線性は、特定の特徴が相互に高度に相関している場合に発生します。相関とは、ある変数が別の変数の変化によってどのような影響を受けるかを示す尺度を指します。

特徴 a の増加が特徴 b の増加につながる場合、2 つの特徴には正の相関があります。 a の増加により特徴 b が減少する場合、2 つの特徴は負の相関関係にあります。トレーニング データに相関性の高い 2 つの変数があると、モデルがデータ内のパターンを見つけることができないため多重共線性が生じ、モデルのパフォーマンスが低下します。したがって、モデルをトレーニングする前に、まず多重共線性の除去を試みる必要があります。

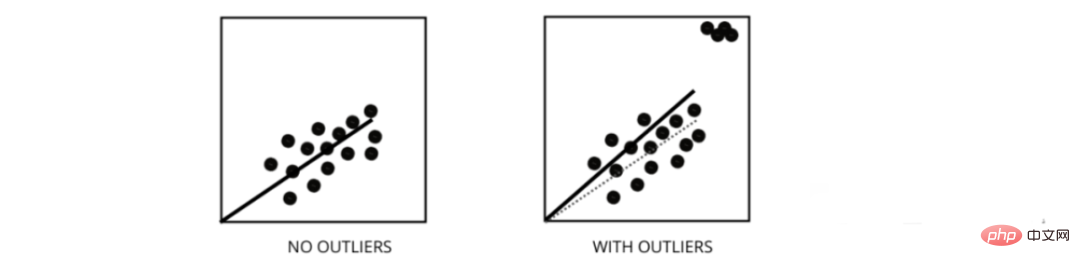

5. 外れ値は線形回帰モデルのパフォーマンスにどのような影響を与えますか?

外れ値は、値がデータ ポイントの平均範囲と異なるデータ ポイントです。つまり、これらの点はデータと異なっているか、第 3 の基準から外れています。

# 線形回帰モデルは、残差を減らす最適な直線を見つけようとします。データに外れ値が含まれている場合、最適な線は外れ値に向かって少しシフトし、エラー率が増加し、その結果、モデルの MSE が非常に高くなります。

6.MSE と MAE の違いは何ですか?

MSE は平均二乗誤差の略で、実際の値と予測値の二乗差です。 MAE は目標値と予測値の差の絶対値です。

MSE は大きなミスを罰しますが、MAE は罰しません。 MSE と MAE の両方の値が減少するにつれて、モデルはより良い適合線になる傾向があります。

7. L1 および L2 正則化とは何ですか?いつ使用する必要がありますか?

機械学習における主な目標は、トレーニング データとテスト データでより優れたパフォーマンスを発揮できる一般的なモデルを作成することですが、データが非常に少ない場合、基本的な線形回帰モデルは過剰適合する傾向があります。 l1 と l2 の正規化を使用します。

L1 正則化またはラッソ回帰は、コスト関数内にペナルティ項として傾きの絶対値を追加することで機能します。しきい値未満の傾き値を持つすべてのデータ ポイントを削除することで、外れ値を削除するのに役立ちます。

L2 正則化またはリッジ回帰では、係数サイズの 2 乗に等しいペナルティ項が追加されます。傾き値が高いフィーチャにペナルティを与えます。

l1 と l2 は、トレーニング データが小さく、分散が高く、予測された特徴が観測値より大きく、データに多重共線性が存在する場合に役立ちます。

8.不均一分散性とは何を意味しますか?

これは、最適な直線の周囲のデータ ポイントの分散が範囲内で異なる状況を指します。その結果、残留物が不均一に分散します。データ内にそれが存在する場合、モデルは無効な出力を予測する傾向があります。不均一分散性をテストする最良の方法の 1 つは、残差をプロットすることです。

データ内の不均一分散の最大の原因の 1 つは、範囲特徴間の大きな違いです。たとえば、1 から 100000 までの列がある場合、値を 10% 増やしても、低い値は変わりませんが、高い値では非常に大きな差が生じるため、大きな分散の差が生じます。 。

9. 分散インフレ係数の役割は何ですか?

分散インフレ係数 (vif) は、他の独立変数を使用して独立変数をどの程度正確に予測できるかを調べるために使用されます。

機能 v1、v2、v3、v4、v5、v6 を含むデータの例を見てみましょう。ここで、v1 の vif を計算するには、これを予測子変数とみなして、他のすべての予測子変数を使用して予測を試みます。

VIF の値が小さい場合は、データから変数を削除することをお勧めします。値が小さいほど変数間の相関が高いことを示すためです。

10. ステップワイズ回帰はどのように機能しますか?

ステップワイズ回帰は、仮説検定を利用して予測子変数を削除または追加することによって回帰モデルを作成する方法です。各独立変数の重要性を反復的にテストし、各反復後にいくつかの特徴を削除または追加することで、従属変数を予測します。これは n 回実行され、観測値と予測値の間の誤差が最小になるように従属変数を予測するパラメーターの最適な組み合わせを見つけようとします。

大量のデータを非常に効率的に管理し、高次元の問題を解決できます。

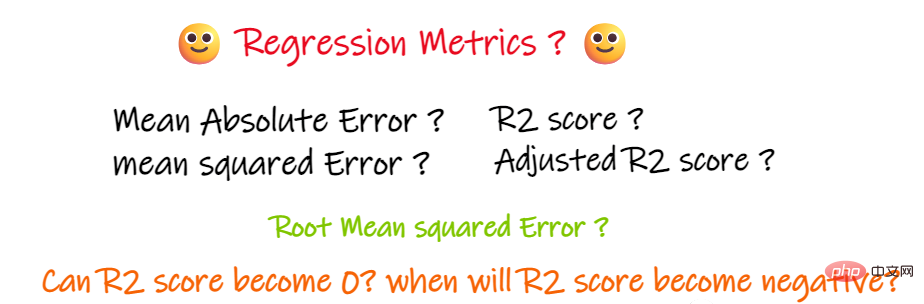

11. MSE と MAE に加えて、他に重要な回帰指標はありますか?

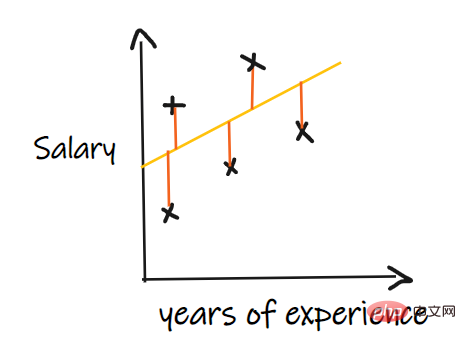

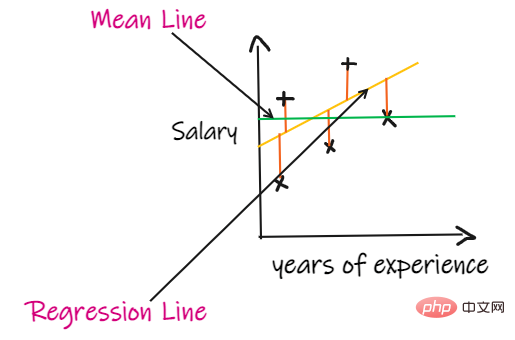

これらの指標を導入するために回帰問題を使用します。入力は職歴、出力は給与です。以下のグラフは、給与を予測するために引かれた線形回帰直線を示しています。

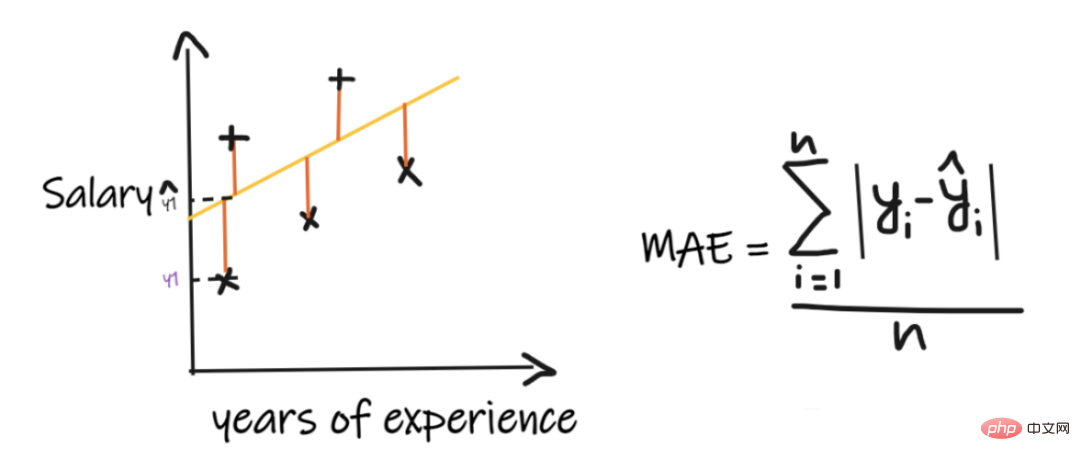

1. 平均絶対誤差 (MAE):

平均絶対誤差 (MAE) は最も単純な回帰測定です。 。各実際の値と予測値の差を加算し、それを観測値の数で割ります。回帰モデルが優れたモデルであるとみなされるためには、MAE が可能な限り小さい必要があります。

MAE の利点は次のとおりです。

シンプルで理解しやすい。結果の単位は出力と同じになります。例: 出力列の単位が LPA の場合、MAE が 1.2 であれば、結果を 1.2LPA または -1.2LPA として解釈できます。MAE は外れ値に対して比較的安定しています (他の回帰指標と比較すると、MAE は外れ値の影響は小さくなります)。

MAE の欠点は次のとおりです。

MAE はモジュラー関数を使用しますが、モジュラー関数はすべての点で微分可能ではないため、多くの場合損失関数として使用できません。

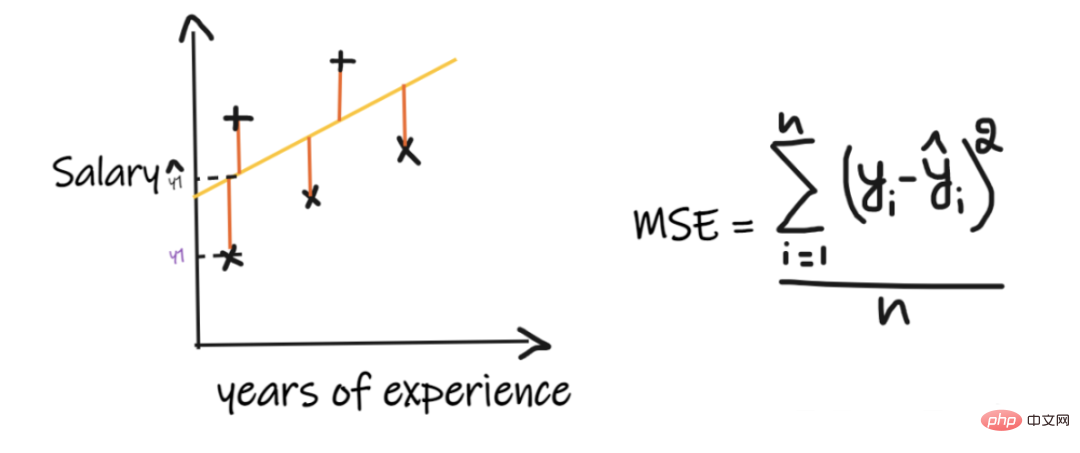

2. 平均二乗誤差 (MSE):

MSE は、各実際の値と予測値の差を取得し、その差を 2 乗して加算し、最後に観測値の数で割ります。回帰モデルが優れたモデルであるとみなされるためには、MSE が可能な限り小さい必要があります。

MSE の利点: 二乗関数はすべての点で微分可能であるため、損失関数として使用できます。

MSE の欠点: MSE は二乗関数を使用するため、結果の単位は出力の二乗になります。したがって、結果を解釈するのは困難です。二乗関数を使用するため、データに外れ値がある場合、差も二乗されるため、外れ値に対して MSE は安定しません。

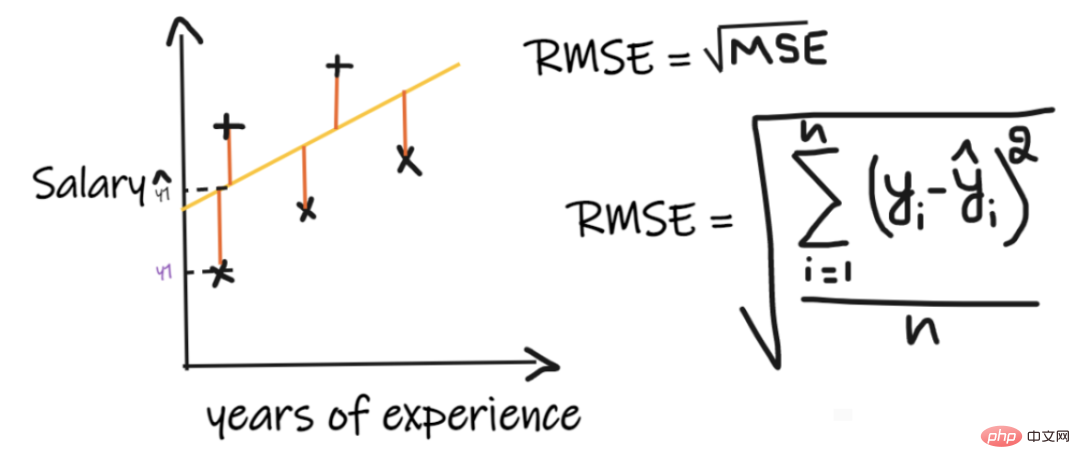

3. 二乗平均平方根誤差 (RMSE):

二乗平均平方根誤差 (RMSE) は、各実際の値と予測値の差を計算します。次に、差を二乗して加算し、最後に観測値の数で割ります。次に、結果の平方根を求めます。したがって、RMSE は MSE の平方根です。回帰モデルが優れたモデルであるとみなされるためには、RMSE が可能な限り小さい必要があります。

RMSE は MSE の問題を解決します。単位は平方根を取るため出力の単位と同じになりますが、それでも外れ値に対して安定性が低くなります。

上記の指標は、解決している問題のコンテキストによって異なります。実際の問題を理解せずに、MAE、MSE、RMSE の値だけを見てモデルの品質を判断することはできません。

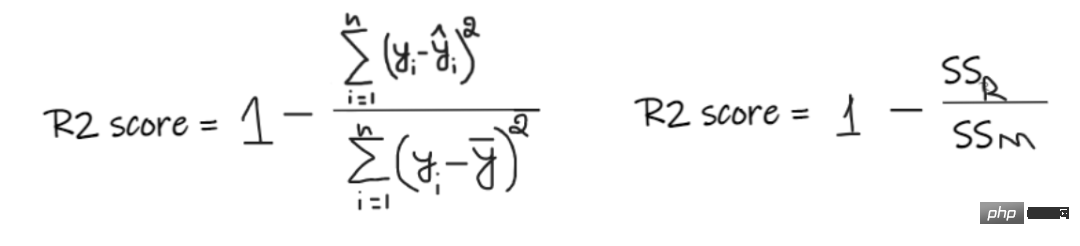

4、R2 スコア:

入力データはありませんが、この会社で彼がどれくらいの給与を得ることができるかを知りたい場合は、最善の方法は、全従業員の給与の平均を与えることです。

#R2 スコアは 0 から 1 までの値を示し、あらゆるコンテキストに対して解釈できます。それはフィット感の良さとして理解できます。

SSR は回帰直線の二乗誤差の合計、SSM は移動平均の二乗誤差の合計です。回帰直線を平均線と比較します。

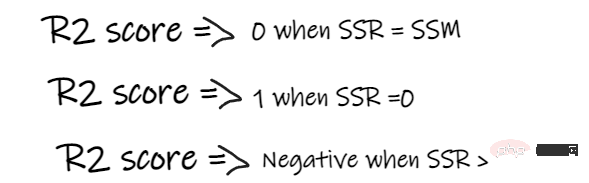

- #R2 スコアが 0 の場合、モデルの結果が平均と同じであるため、モデルを改善する必要があることを意味します。

- R2 スコアが 1 の場合、方程式の右側は 0 になります。これは、モデルがエラーなく各データ ポイントに適合する場合にのみ発生します。

- R2 スコアが負の場合は、方程式の右側が 1 より大きいことを意味します。これは、SSR > SSM の場合に発生する可能性があります。これは、モデルが平均より最悪であることを意味します。つまり、モデルが平均を予測するよりも悪いということです。

モデルの R2 スコアが 0.8 の場合、これは次のように言えます。モデルが出力分散の 80% を説明できること。つまり、賃金変動の80%はインプット(勤務年数)で説明できるが、残りの20%は不明ということになる。

モデルに勤務年数と面接スコアという 2 つの特徴がある場合、モデルはこれら 2 つの入力特徴を使用して給与の変化の 80% を説明できます。

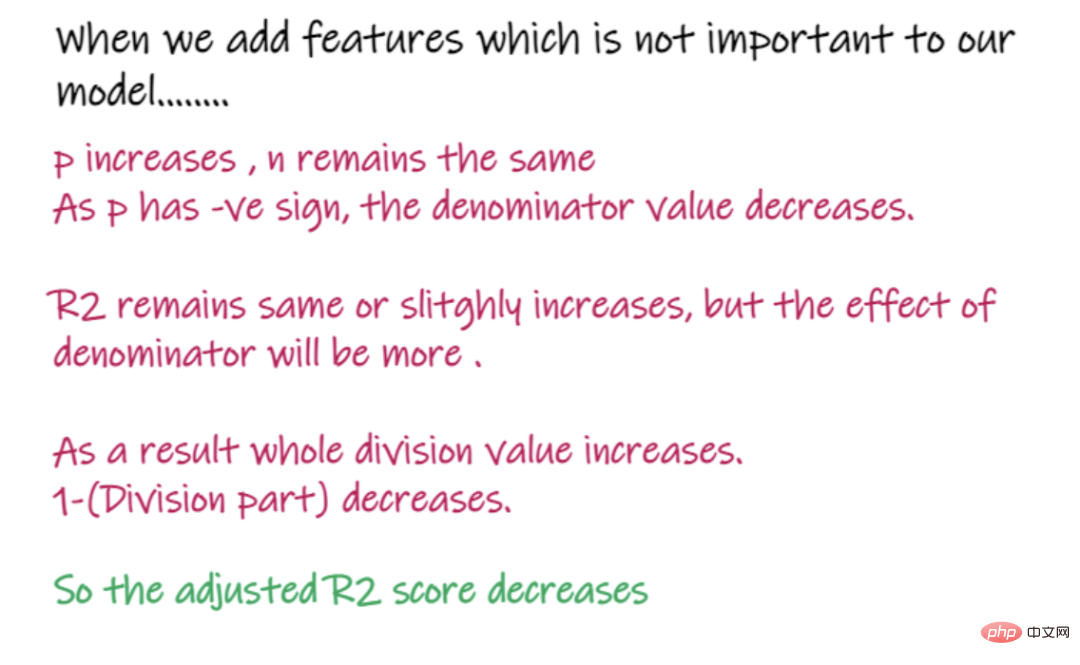

R2 の欠点:

入力特徴の数が増加すると、R2 はそれに応じて増加するか、変化しない傾向がありますが、入力特徴がモデルにとって役に立たない場合でも、減少することはありません。重要です (例: インタビュー当日の気温を例に追加すると、気温が出力にとって重要でない場合でも R2 は減少しません)。

5. 調整された R2 スコア:

上の式では、R2 は R2、n は観測値 (行) の数、p は独立した特徴の数です。調整されたR2はR2の問題を解決します。

賃金を予測するために気温を追加するなど、モデルにとってそれほど重要ではない機能を追加する場合....

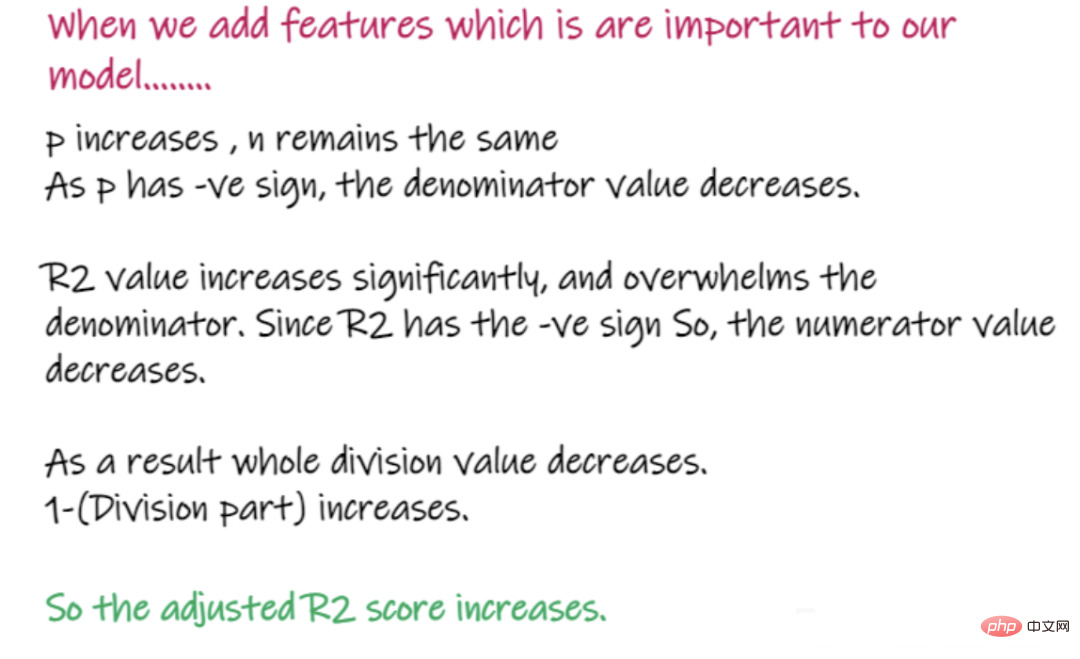

給与を予測するために面接スコアを追加するなど、モデルに重要な機能を追加する場合...

上記は回帰問題 回帰問題を解く上での重要な知識と各種重要指標の紹介とそのメリット・デメリットについてご紹介しますので、ご参考になれば幸いです。

以上が機械学習回帰モデルに関連する重要な知識ポイントのまとめの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7677

7677

15

15

1393

1393

52

52

1207

1207

24

24

91

91

11

11

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

機械学習とデータ サイエンスの分野では、モデルの解釈可能性が常に研究者や実務家に焦点を当ててきました。深層学習やアンサンブル手法などの複雑なモデルが広く適用されるようになったことで、モデルの意思決定プロセスを理解することが特に重要になってきました。 Explainable AI|XAI は、モデルの透明性を高めることで、機械学習モデルに対する信頼と自信を構築するのに役立ちます。モデルの透明性の向上は、複数の複雑なモデルの普及や、モデルを説明するための意思決定プロセスなどの方法によって実現できます。これらの方法には、特徴重要度分析、モデル予測間隔推定、ローカル解釈可能性アルゴリズムなどが含まれます。特徴重要度分析では、入力特徴に対するモデルの影響度を評価することで、モデルの意思決定プロセスを説明できます。モデルの予測間隔の推定

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

総合的にDPOを超える:Chen Danqi氏のチームはシンプルなプリファレンス最適化SimPOを提案し、最強の8Bオープンソースモデルも洗練させた

Jun 01, 2024 pm 04:41 PM

総合的にDPOを超える:Chen Danqi氏のチームはシンプルなプリファレンス最適化SimPOを提案し、最強の8Bオープンソースモデルも洗練させた

Jun 01, 2024 pm 04:41 PM

大規模言語モデル (LLM) を人間の価値観や意図に合わせるには、人間のフィードバックを学習して、それが有用で、正直で、無害であることを確認することが重要です。 LLM を調整するという点では、ヒューマン フィードバックに基づく強化学習 (RLHF) が効果的な方法です。 RLHF 法の結果は優れていますが、最適化にはいくつかの課題があります。これには、報酬モデルをトレーニングし、その報酬を最大化するためにポリシー モデルを最適化することが含まれます。最近、一部の研究者はより単純なオフライン アルゴリズムを研究しており、その 1 つが直接優先最適化 (DPO) です。 DPO は、RLHF の報酬関数をパラメータ化することで、選好データに基づいてポリシー モデルを直接学習するため、明示的な報酬モデルの必要性がなくなります。この方法は簡単で安定しています

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

OpenAI データは必要ありません。大規模なコード モデルのリストに加わりましょう。 UIUC が StarCoder-15B-Instruct をリリース

Jun 13, 2024 pm 01:59 PM

OpenAI データは必要ありません。大規模なコード モデルのリストに加わりましょう。 UIUC が StarCoder-15B-Instruct をリリース

Jun 13, 2024 pm 01:59 PM

ソフトウェア テクノロジの最前線に立つ UIUC Zhang Lingming のグループは、BigCode 組織の研究者とともに、最近 StarCoder2-15B-Instruct 大規模コード モデルを発表しました。この革新的な成果により、コード生成タスクにおいて大きな進歩が達成され、CodeLlama-70B-Instruct を上回り、コード生成パフォーマンス リストのトップに到達しました。 StarCoder2-15B-Instruct のユニークな特徴は、その純粋な自己調整戦略であり、トレーニング プロセス全体がオープンで透過的で、完全に自律的で制御可能です。このモデルは、高価な手動アノテーションに頼ることなく、StarCoder-15B 基本モデルの微調整に応じて、StarCoder2-15B を介して数千の命令を生成します。

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

翻訳者 | Li Rui によるレビュー | 今日、人工知能 (AI) および機械学習 (ML) モデルはますます複雑になっており、これらのモデルによって生成される出力はブラックボックスになっており、関係者に説明することができません。 Explainable AI (XAI) は、利害関係者がこれらのモデルがどのように機能するかを理解できるようにし、これらのモデルが実際に意思決定を行う方法を確実に理解できるようにし、AI システムの透明性、信頼性、およびこの問題を解決するための説明責任を確保することで、この問題を解決することを目指しています。この記事では、さまざまな説明可能な人工知能 (XAI) 手法を検討して、その基礎となる原理を説明します。説明可能な AI が重要であるいくつかの理由 信頼と透明性: AI システムが広く受け入れられ、信頼されるためには、ユーザーは意思決定がどのように行われるかを理解する必要があります

フラッシュ アテンションは安定していますか?メタとハーバードは、モデルの重みの偏差が桁違いに変動していることを発見しました

May 30, 2024 pm 01:24 PM

フラッシュ アテンションは安定していますか?メタとハーバードは、モデルの重みの偏差が桁違いに変動していることを発見しました

May 30, 2024 pm 01:24 PM

MetaFAIR はハーバード大学と協力して、大規模な機械学習の実行時に生成されるデータの偏りを最適化するための新しい研究フレームワークを提供しました。大規模な言語モデルのトレーニングには数か月かかることが多く、数百、さらには数千の GPU を使用することが知られています。 LLaMA270B モデルを例にとると、そのトレーニングには合計 1,720,320 GPU 時間が必要です。大規模なモデルのトレーニングには、これらのワークロードの規模と複雑さにより、特有のシステム上の課題が生じます。最近、多くの機関が、SOTA 生成 AI モデルをトレーニングする際のトレーニング プロセスの不安定性を報告しています。これらは通常、損失スパイクの形で現れます。たとえば、Google の PaLM モデルでは、トレーニング プロセス中に最大 20 回の損失スパイクが発生しました。数値的なバイアスがこのトレーニングの不正確さの根本原因です。