淘宝網の主な検索リコールシナリオにおけるマルチモーダルテクノロジーの探求

検索システムの基礎となる検索想起は、効果向上の上限を決定します。既存の大規模リコール結果に差別化された増分価値をもたらし続ける方法は、私たちが直面している主な課題です。マルチモーダルな事前トレーニングとリコールの組み合わせは、私たちに新たな地平を切り開き、オンライン効果に大幅な改善をもたらします。

まえがき

マルチモーダル事前トレーニングは、学界と産業界での研究の焦点です。異なるモダリティ間の意味論的な対応により、視覚的な質問応答、視覚的な推論、画像とテキストの検索など、さまざまな下流タスクのパフォーマンスを向上させることができます。 グループ内では、マルチモーダル事前トレーニングの研究と応用も行っています。 淘宝網のメイン検索シナリオでは、ユーザーが入力したクエリとリコール対象の商品との間に自然なクロスモーダル検索要件がありますが、以前はさらに多くのタイトルが存在していました。商品には統計的特徴が使用され、画像などのより直感的な情報は無視されました。 しかし、視覚的要素を含む一部のクエリ (白いドレス、花柄のドレスなど) では、誰もが検索結果ページの最初の画像に魅了されると思います。

▐ 技術的な問題と解決策

概要検索およびリコールのシナリオにマルチモーダル テクノロジを適用する場合、解決する必要がある主な問題が 2 つあります:- マルチモーダル グラフィックおよびテキストの事前トレーニング モデルは、通常、画像とテキストのモダリティを統合します。メイン検索にはクエリの存在があり、製品画像とタイトルの元の画像とテキスト モダリティに基づいて、追加のテキスト モダリティを考慮する必要があります。同時に、クエリと製品タイトルの間には意味上のギャップがあり、クエリは比較的短く幅広いものですが、製品タイトルは販売者が SEO を行うため、長くキーワードが詰め込まれていることがよくあります。

- 通常、事前トレーニング タスクとダウンストリーム タスクの関係は、事前トレーニングでは大規模なラベルなしデータが使用され、ダウンストリームでは少量のラベル付きデータが使用されます。しかし、メインの検索とリコールでは、下流のベクトル リコール タスクの規模は膨大で、データは数十億に達しますが、GPU リソースが限られているため、事前トレーニングで使用できるデータは比較的少量のみです。この場合、事前トレーニングが下流のタスクにもメリットをもたらすかどうか。

私たちの解決策は次のとおりです:

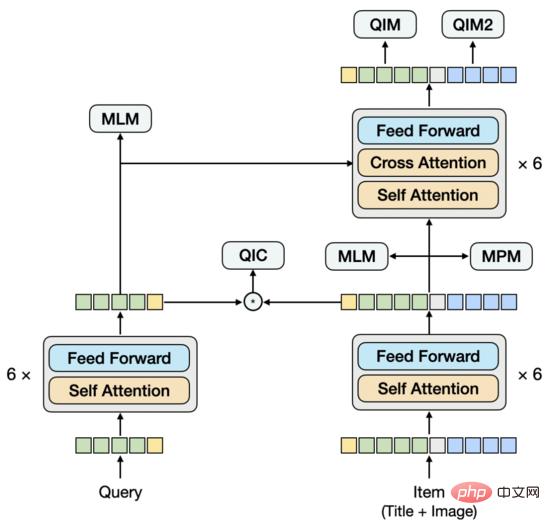

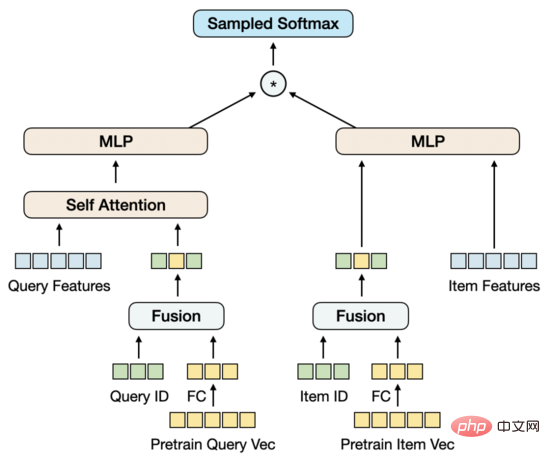

- Text-Graphic Pre-training : クエリと製品アイテムをそれぞれエンコーダに渡し、それらをツインタワーステートエンコーダーとしてのクロスモデル。クエリ タワーとアイテム タワーを見ると、2 ストリーム モデルと同様に、後の段階で相互作用しますが、特にアイテム タワーを見ると、画像とタイトルの 2 つのモードが初期段階で相互作用します。シングルストリームモデル。したがって、私たちのモデル構造は、一般的なシングルストリーム構造やデュアルストリーム構造とは異なります。この設計の開始点は、クエリ ベクトルとアイテム ベクトルをより効果的に抽出し、下流のツインタワー ベクトル再現モデルに入力を提供し、事前トレーニング段階でツインタワー内積モデリング手法を導入することです。クエリとタイトルの間のセマンティックな接続とギャップをモデル化するために、クエリとアイテムのツインタワーのエンコーダーを共有し、言語モデルを個別に学習します。

- 事前トレーニングとリコールタスク間のリンク : サンプル構築方法と下流の損失を考慮して設計ベクトルリコールタスク 事前学習段階のタスクとモデリング方法について説明します。一般的な画像とテキストのマッチング タスクとは異なり、クエリとアイテムのマッチング タスクとクエリと画像のマッチング タスクを使用し、クエリで最もクリック数の多かったアイテムをポジティブ サンプルとして使用し、バッチ内の他のサンプルをネガティブ サンプルとして使用します。クエリとアイテムのツインタワー、内積の方法でモデル化された複数分類タスク。この設計の出発点は、事前トレーニングをベクトル呼び出しタスクに近づけ、限られたリソースの下で可能な限り下流のタスクに効果的な入力を提供することです。さらに、ベクトルリコールタスクでは、トレーニングプロセス中にトレーニング前の入力ベクトルが固定されている場合、大規模なデータに対して効果的に調整することができないため、ベクトル内のトレーニング前の入力ベクトルもモデル化しました。タスクのリコール、トレーニング ベクトルの更新。

#事前トレーニング済みモデル

▐ モデリング方法

マルチモーダル事前トレーニング モデルでは、画像から特徴を抽出し、テキスト特徴と融合する必要があります。画像から特徴を抽出するには主に 3 つの方法があります。CV フィールドでトレーニングされたモデルを使用して、画像の RoI 特徴、グリッド特徴、およびパッチ特徴を抽出します。モデル構造の観点から見ると、画像特徴とテキスト特徴の異なる融合方法に応じて、シングルストリーム モデルとデュアルストリーム モデルの 2 つの主なタイプがあります。シングルストリーム モデルでは、画像特徴とテキスト特徴が初期段階で結合されて Encoder に入力されますが、デュアル ストリーム モデルでは、画像特徴とテキスト特徴がそれぞれ 2 つの独立した Encoder に入力され、その後、処理のためにクロスモーダル エンコーダーに入力します。▐ 最初の調査

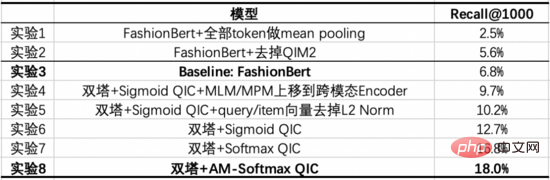

画像の特徴を抽出する方法は次のとおりです: 画像を分割します。パッチ シーケンスについては、ResNet を使用して各パッチの画像特徴を抽出します。モデル構造としては、Query、title、imageをつなぎ合わせてEncoderに入力するというシングルストリーム構造を試してみました。複数セットの実験の後、この構造の下では、下流のツインタワー ベクトル呼び出しタスクの入力として純粋な Query ベクトルとアイテム ベクトルを抽出するのが難しいことがわかりました。特定のベクトルを抽出するときに不要なモードをマスクすると、予測がトレーニングと矛盾します。この問題は、対話型モデルからツインタワー モデルを直接抽出することに似ていますが、私たちの経験によれば、このモデルは学習済みのツインタワー モデルほど効果的ではありません。これに基づいて、新しいモデル構造を提案します。#▐ モデル構造

##デュアルフロー構造と同様に、モデルの下部はツインタワーで構成され、上部はクロスモーダルエンコーダを介してツインタワーと統合されています。デュアルストリーム構造とは異なり、ツインタワーは単一のモードで構成されていません。アイテムタワーにはタイトルと画像のデュアルモードが含まれています。タイトルと画像は結合されてエンコーダに入力されます。この部分は、シングルストリームモデル。クエリとタイトルの間の意味関係とギャップをモデル化するために、クエリとアイテムのツインタワーのエンコーダーを共有し、言語モデルを個別に学習します。

##デュアルフロー構造と同様に、モデルの下部はツインタワーで構成され、上部はクロスモーダルエンコーダを介してツインタワーと統合されています。デュアルストリーム構造とは異なり、ツインタワーは単一のモードで構成されていません。アイテムタワーにはタイトルと画像のデュアルモードが含まれています。タイトルと画像は結合されてエンコーダに入力されます。この部分は、シングルストリームモデル。クエリとタイトルの間の意味関係とギャップをモデル化するために、クエリとアイテムのツインタワーのエンコーダーを共有し、言語モデルを個別に学習します。

▐ 事前トレーニング タスク

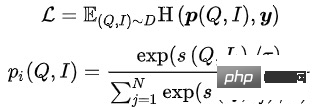

- マスク言語モデリング (MLM): テキスト内Token 、15% をランダムにマスクし、残りのテキストと画像を使用してマスクされたテキスト トークンを予測します。クエリとタイトルには、それぞれ MLM タスクがあります。 MLM はクロスエントロピー損失を最小限に抑えます:

ここで # は残りのテキスト トークンを表します

ここで # は残りのテキスト トークンを表します

- マスクされたパッチ モデリング (MPM): 画像内パッチ トークンの 25% はランダムにマスクされ、残りの画像とテキストはマスクされた画像トークンを予測するために使用されます。 MPM は KL 発散損失を最小限に抑えます:

ここで # は残りのイメージ トークンを表します

ここで # は残りのイメージ トークンを表します

-

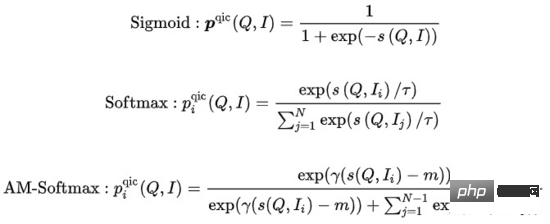

クエリ項目分類 (QIC): クエリの下で最もクリック数が多かったアイテムが正のサンプルとして使用され、バッチ内の他のサンプルが負のサンプルとして使用されます。 QIC は、線形レイヤーを通じてクエリ タワーとアイテム タワー [CLS] トークンの次元を 256 次元に削減し、類似度計算を実行して予測確率を取得し、クロス エントロピー ロスを最小限に抑えます。

はさまざまな方法で計算できます:

はさまざまな方法で計算できます:

このうち、

このうち、

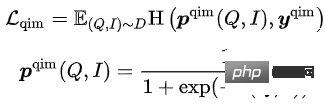

は類似度計算を表し、 は温度ハイパーパラメータを表し、 と mそれぞれ、スケーリング係数と緩和係数を表しますクエリ アイテム マッチング (QIM): クエリの下で最もクリック数が多かったアイテムがポジティブ サンプルとして使用され、バッチ内のその他のアイテムはポジティブ サンプルとして使用されます。現在のクエリに最も類似したものがネガティブ サンプルとして使用されます。 QIM はクロスモーダル エンコーダーの [CLS] トークンを使用して予測確率を計算し、クロス エントロピー損失を最小限に抑えます:

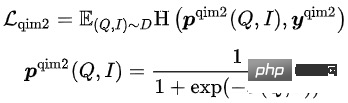

クエリ画像マッチング (QIM2): QIM サンプルでは、マスクはタイトルを削除して、クエリと画像の間のマッチングを強化します。 QIM2 はクロスエントロピー損失を最小限に抑えます:

モデルのトレーニング目標は、全体的な損失を最小限に抑えることです:

これらの 5 つのプレでは、 -条件 トレーニング タスクでは、MLM タスクと MPM タスクがアイテム タワーの上に配置され、タイトルまたは画像のトークンの一部がマスクされた後にクロスモーダル情報を使用して相互に回復する機能をモデル化します。クエリタワーの上には独立したMLMタスクがあり、クエリタワーとアイテムタワーのエンコーダを共有することで、クエリとタイトルの意味関係やギャップがモデル化されます。 QIC タスクは、2 つのタワーの内積を使用して、事前トレーニング タスクと下流ベクトル呼び出しタスクをある程度調整し、AM-Softmax を使用して、クエリの表現とクエリで最もクリックされたアイテムの表現との間の距離を縮めます。 、クエリと最もクリックされたアイテムの間の距離、その他のアイテムの距離を押しのけます。 QIM タスクはクロスモーダル エンコーダーの上に位置し、クロスモーダル情報を使用してクエリとアイテムの一致をモデル化します。計算量の都合上、通常のNSPタスクの陽性サンプルと陰性サンプルの比率は1:1ですが、さらに陽性サンプルと陰性サンプルの距離を広げるために、QICの類似度計算結果をもとに困難な陰性サンプルを構築します。タスク。 QIM2 タスクは QIM タスクと同じ位置にあり、テキストに関連して画像によってもたらされる増分情報を明示的にモデル化します。

#ベクトル再現モデル

▐

モデリング手法大規模な情報検索システムでは、想起モデルが最下位にあり、大量の候補セットでスコアを付ける必要があります。パフォーマンス上の理由から、ユーザーとアイテムのツイン タワーの構造は、ベクトルの内積を計算するためによく使用されます。ベクトル再現モデルの中心的な問題は、正および負のサンプルをどのように構築するか、および負のサンプルのサンプリングの規模です。私たちの解決策は、ページ上のアイテムに対するユーザーのクリックを肯定的なサンプルとして使用し、製品プール全体のクリック分布に基づいて数万の否定的なサンプルをサンプリングし、サンプリングされたソフトマックス損失を使用してサンプリング サンプルから次のことを推定することです。アイテムは完全な製品プールにあります。クリック確率は です。

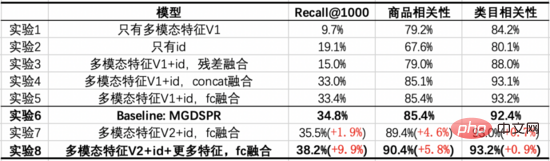

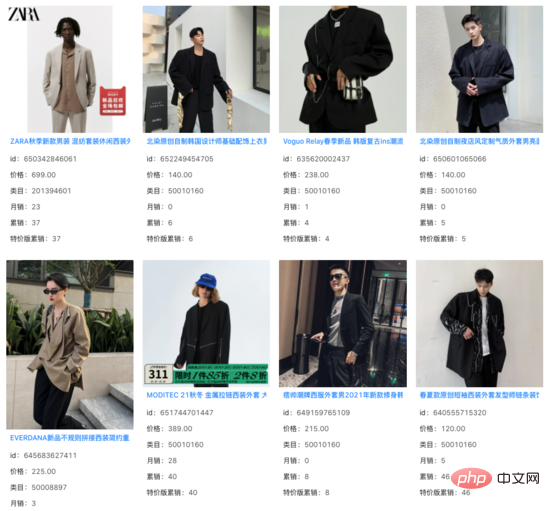

は類似度の計算を表し、 は温度を表しますハイパーパラメータ 一般的な FineTune パラダイムに従って、事前トレーニングされたデータを変換しようとしました。ベクトルをツイン タワー MLP に直接入力し、大規模なネガティブ サンプリングとサンプル ソフトマックスと組み合わせて、マルチモーダル ベクトル再現モデルをトレーニングします。ただし、通常の小規模な下流タスクとは対照的に、ベクトル再現タスクのトレーニング サンプル サイズは数十億のオーダーと巨大です。 MLP のパラメーター量ではモデルのトレーニングをサポートできず、すぐに独自の収束状態に達しますが、その効果は良好ではないことが観察されました。同時に、事前トレーニングされたベクトルはベクトル再現モデルのパラメーターではなく入力として使用され、トレーニングの進行につれて更新することはできません。その結果、比較的小規模なデータに関する事前トレーニングは、大規模なデータに関する下流のタスクと競合します。 解決策はいくつかありますが、事前学習モデルをベクトル再現モデルに統合する方法がありますが、事前学習モデルのパラメータ数が多すぎるため、サンプルサイズが大きくなり、ベクトル再現モデルでは、ベクトル再現モデルでは使用できませんが、限られたリソースの制約の下では、合理的な時間内で定期的なトレーニングを実行する必要があります。もう 1 つの方法は、ベクトル再現モデルでパラメータ行列を構築し、事前トレーニングされたベクトルを行列にロードし、トレーニングの進行に応じて行列のパラメータを更新することです。調査した結果、この方法は工学的な実装の観点から比較的高価であることがわかりました。これに基づいて、事前トレーニングベクトルの更新を簡単かつ実現可能にモデル化するモデル構造を提案します。 始めましょうFC を使用して事前トレーニング ベクトルの次元数を削減します。事前トレーニングではなくここで次元数を削減する理由は、現在の高次元ベクトルが依然として負のサンプル サンプリングの許容可能なパフォーマンス範囲内にあるためです。この場合, ベクトル想起タスクの次元削減は、トレーニング目標とより一致します。同時に、クエリとアイテムの ID 埋め込み行列を導入し、埋め込み次元は縮小された事前トレーニング ベクトルの次元と一致し、ID と事前トレーニング ベクトルがマージされます。この設計の開始点は、大規模なトレーニング データをサポートするのに十分な量のパラメーターを導入すると同時に、トレーニングの進行に応じて事前トレーニング ベクトルを適応的に更新できるようにすることです。 ID ベクトルと事前トレーニング ベクターのみを使用して融合すると、モデルの効果は事前トレーニング ベクターのみを使用したツインタワー MLP の効果を超えるだけでなく、ベースライン モデル MGDSPR も超えます。より多くの機能が含まれています。さらに、これに基づいてさらに多くの機能を導入すると、効果がさらに向上します。 Recall@K : 評価データ セットは、トレーニング セットの翌日のデータで構成されています。まず、さまざまなクリックとトランザクションの結果です。同じクエリ内のユーザーを ベクトル再現モデルの場合、Recall@K が一定レベルまで増加した後は、Query とItem の間の相関にも注意する必要があります。関連性の低いモデルは、たとえ検索効率を向上させることができたとしても、ユーザー エクスペリエンスの低下や、悪いケースの増加による苦情や世論の増加にも直面することになります。 オンライン相関モデルと一致するオフライン モデルを使用して、クエリと項目の間、およびクエリと項目カテゴリの間の相関を評価します。 いくつかのカテゴリから 1 つを選択します10億レベルの製品プールが構築され、事前トレーニングデータセットが構築されます。 私たちのベースライン モデルは、QIM および QIM2 タスクを追加して最適化された FashionBert です。クエリ ベクトルとアイテム ベクトルを抽出するときは、非パディング トークンに対してのみ平均プーリングを使用します。次の実験では、単一のタワーと比較して 2 つのタワーを使用したモデリングによってもたらされる利点を調査し、アブレーション実験を通じて主要な部品の役割を示します。 これらの実験から、次の結論を導き出すことができます: 10 億レベルのクリックされたページを選択しますベクトルリコールデータセットを構築します。各ページにはポジティブ サンプルとして 3 つのクリック項目が含まれており、クリック分布に基づいて製品プールから 10,000 のネガティブ サンプルがサンプリングされます。これに基づいて、トレーニング データの量をさらに拡大したり、ネガティブ サンプルのサンプリングを行ったりしても、効果の顕著な改善は観察されませんでした。 私たちのベースライン モデルは、メイン検索の MGDSPR モデルです。以下の実験では、ベースラインに対するベクトル再現とマルチモーダル事前トレーニングを組み合わせることによってもたらされる利益を調査し、アブレーション実験を通じて主要な部分の役割を示します。 これらの実験から、次の結論を導き出すことができます: ベクトル再現モデルの上位 1000 件の結果のうち、オンライン システムが再現できた項目をフィルタリングして除外したところ、残りの増分結果の相関関係は基本的に次のとおりであることがわかりました。変更なし。多数のクエリの下では、これらの増分結果が製品のタイトルを超えた画像情報をキャプチャし、クエリとタイトルの間の意味上のギャップにおいて一定の役割を果たしていることがわかります。 #クエリ: ハンサムなスーツ メインの検索シナリオのアプリケーション要件に応えて、クエリとアイテムのツインタワー入力を使用したテキスト画像の事前トレーニング モデルを提案しました。クロスモーダル エンコーダ: アイテム タワーがマルチモーダル グラフィックスとテキストを含む単一フロー モデルである構造。 Query-Item と Query-Image のマッチング タスク、および Query と Items のツインタワーの内積によってモデル化された Query-Item 多分類タスクにより、事前トレーニングが下流のベクトル想起タスクに近づくようになります。同時に、事前トレーニングされたベクトルの更新はベクトルリコールでモデル化されます。リソースが限られている場合でも、比較的少量のデータを使用した事前トレーニングでも、大量のデータを使用する下流タスクのパフォーマンスを向上させることができます。 製品の理解、関連性、並べ替えなどの主要な検索の他のシナリオでも、マルチモーダル テクノロジを適用する必要があります。私たちはこれらのシナリオの調査にも参加しており、マルチモーダルテクノロジーが将来的にはますます多くのシナリオにメリットをもたらすと信じています。 淘宝網メイン検索リコール チーム: このチームは、メイン検索リンク内のリンクのリコールと大まかな並べ替えを担当しており、現在の主な技術的方向性は次のとおりです。全空間サンプルの多目的パーソナライズされたベクトル想起、大規模な事前トレーニングに基づくマルチモーダル想起、対照学習に基づく同様のクエリ意味書き換え、および粗いランキングモデルなど。 ▐ 最初の調査

▐ モデル構造

実験分析

##▐ 評価指標

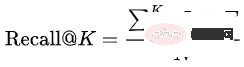

事前トレーニング済みモデルの効果は通常、下流タスクの指標を使用して評価され、別個の評価指標が使用されることはほとんどありません。ただし、この方法では、モデルのバージョンの各反復で、対応するベクトル想起タスクをトレーニングし、次にベクトル想起タスクの指標を評価する必要があるため、事前トレーニングされたモデルの反復コストは比較的高くなります。プロセス全体が非常に長くなります。事前トレーニングされたモデルのみを評価するための効果的な指標はありますか?最初にいくつかの論文で Rank@K を試しました. この指標は主に画像とテキストのマッチング タスクを評価するために使用されます: 最初に事前トレーニングされたモデルを使用して人工的に構築された候補セットをスコア付けし、次に に従ってソートされた上位 K の結果を計算します。画像とテキストにヒットするスコア。一致する陽性サンプルの割合。 Rank@K をクエリ項目マッチング タスクに直接適用したところ、結果が期待と一致しないことがわかりました。Rank@K を使用したより優れた事前トレーニング モデルは、下流のベクトル再現モデルでより悪い結果を達成する可能性があり、事前にガイドすることができません。トレーニング: モデルのトレーニングの反復。これに基づいて、事前トレーニング モデルの評価とベクトル再現モデルの評価を統合し、同じ評価指標とプロセスを使用することで、事前トレーニング モデルの反復を比較的効果的に導くことができます。

に集約し、モデルによって予測される上位 K の結果の割合を計算します。hit:

に集約し、モデルによって予測される上位 K の結果の割合を計算します。hit:

▐ 事前トレーニング実験

▐ ベクトルリコール実験

概要と展望

チーム紹介

以上が淘宝網の主な検索リコールシナリオにおけるマルチモーダルテクノロジーの探求の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1664

1664

14

14

1421

1421

52

52

1315

1315

25

25

1266

1266

29

29

1239

1239

24

24

タオバオの配送先住所を確認する方法 タオバオ アプリで注文した商品の配送先住所を確認する方法

Mar 12, 2024 pm 04:00 PM

タオバオの配送先住所を確認する方法 タオバオ アプリで注文した商品の配送先住所を確認する方法

Mar 12, 2024 pm 04:00 PM

タオバオ アプリは、ショッピングに関するすべての問題を解決します。非常に多くの販売業者と非常に多くの商品が選択を待っています。購入したい商品の種類に関係なく、ここで検索して見つけることができます。誰もが直接注文できるようになります。注文から購入まで、すべての機能を自由に操作できます。注文が正常に完了したら、販売者が商品を出荷し、物流配送を実行するのを待つだけで済みます。非常に便利で多くの、誰もが閲覧することを選択できますこれらの製品の出荷場所を確認し、製品の出荷場所を知ることができます。特に電子製品を購入する場合は、関連する出荷場所の情報を確認して、整備済み機械を購入する際の問題を回避できます。

タオバオの無料赤い封筒 2024 を入手する方法

May 09, 2024 pm 03:22 PM

タオバオの無料赤い封筒 2024 を入手する方法

May 09, 2024 pm 03:22 PM

2024年のタオバオ無料注文イベントは1日3回開催され、誰もが対応する時間に対応する量の商品を注文し、支払う必要があります。無料注文金額は同額の赤い封筒の形で配布されます。次に、2024 年に淘宝網の無料注文の赤い封筒を受け取る方法を紹介します。それを入手します。無料のユーザーの場合、赤い封筒の資格は、アクティベーション状態にあるカードとクーポンのパッケージに発行されます。タオバオのウェブ版には現在カードとクーポンのパッケージがなく、無料注文イベントの当選記録のみが表示されます。カードとクーポンのパッケージは [淘宝網 APP - 私の淘宝網 - 私の権利 - 赤い封筒] にあります。淘宝網の無料赤い封筒を入手する方法 20241. 無料の注文を獲得したユーザーには、有効化を待機している状態のカードとクーポン パッケージに赤い封筒の資格が配布されます。 2. 現在、淘宝網の Web バージョンでは、カードとクーポンのパッケージがあり、無料注文アクティビティの当選記録のみが表示されます。 ;3. カード クーポン パッケージは [淘宝網 APP - 私の淘宝網 - 私の権利 - 赤い封筒] にあります。

タオバオでパスワードフリー決済をオフにする方法 パスワードフリー決済の設定方法を解除する方法。

Mar 12, 2024 pm 12:07 PM

タオバオでパスワードフリー決済をオフにする方法 パスワードフリー決済の設定方法を解除する方法。

Mar 12, 2024 pm 12:07 PM

タオバオアプリには非常に多くの機能があります。これらの機能は、誰もがより良いショッピング体験を得ることができるようにするために存在します。多数の製品タイプは、さまざまなユーザーのショッピングニーズを十分に満たすことができます。誰もが本当に望んでいます。あなたは欲しいものを何でも買うことができます。 「カテゴリー検索」「直接検索」でも問題ありません。どなたでも安心してネットショッピングをお楽しみいただけます。お得なショッピングサービスをご提供いたします。欲しいものはすべて必ず手に入ります。もちろん、ここで買い物をすると、さまざまな買い物方法が表示され、選択できるようになります。ここでのパスワード不要の支払い機能を好む人もいますし、そうでない人もいます。私はとても気に入っていますが、セキュリティはそれほど高くないと思います. もちろん、誰でもいつでもキャンセルできます。

タオバオで赤い封筒のリマインダーをオフにする方法

Apr 01, 2024 pm 06:25 PM

タオバオで赤い封筒のリマインダーをオフにする方法

Apr 01, 2024 pm 06:25 PM

タオバオは、多くの友人がよく使用するオンライン ショッピング ソフトウェアです。あなたは通常、タオバオで注文したり、さまざまなものを購入したりします。ユーザーに赤い封筒のリマインダー機能を提供します。これをオフにしたいという友人もいます。急いで PHP 中国語をチェックしてください。ウェブサイトをご覧ください。タオバオで赤い封筒のリマインダーをオフにする手順のリスト 1. タオバオ APP のパーソナルセンターを開き、[設定] ボタンを選択してページに入ります。 2. [メッセージ通知] オプションを見つけて、メッセージプッシュスイッチを選択し、赤い封筒のメッセージを見つけてスイッチをオフにします。 3. または、携帯電話の設定ページから淘宝アプリの通知許可をオフにすることもできます。これにより、淘宝網からのすべてのメッセージはプッシュされず、通知許可をオンにした後にのみ表示されます。 4. 受信するメッセージの種類をユーザーが設定できるため、使いやすくなります。

タオバオで名前を変更する方法

Mar 24, 2024 pm 03:31 PM

タオバオで名前を変更する方法

Mar 24, 2024 pm 03:31 PM

名前変更機能を使用すると、ユーザーはタオバオで自分の名前とニックネームを自由に変更できます。一部のユーザーはタオバオで名前を変更する方法がわかりません。マイ タオバオの設定でアバターのタオバオ アカウントをクリックするだけで変更できます。次に、編集者がお届けします 名前とニックネームの変更方法を紹介しますので、まだご存じない方はぜひダウンロードして試してみてください。タオバオの使い方チュートリアル タオバオの名前変更方法 答え: マイ タオバオの設定でアバターのタオバオ アカウントをクリックして変更します 詳細: 1. タオバオに入り、右下の[マイ タオバオ]をクリックします。 2. 右上の[設定]アイコンをクリックします。 3. アバターをクリックします。 4. もう一度[タオバオアカウント]をクリックします。 5. [アカウント名の変更]をクリックし、入力・変更します。

「タオバオ」の無料紅包の返金は返ってくるのでしょうか?

May 08, 2024 am 08:16 AM

「タオバオ」の無料紅包の返金は返ってくるのでしょうか?

May 08, 2024 am 08:16 AM

タオバオで買い物をするとき、割引を受けるために無料の赤い封筒をよく使います。しかし、返金が必要な場合、この無料の赤い封筒は返却されるのでしょうか?この質問に対する答えを見てみましょう。タオバオの無料の赤い封筒は返金されますか? 状況によっては、赤い封筒を受け取ったときに、製品を引き換える前に赤い封筒がアクティブ化保留状態になっているため、アクティブ化される赤い封筒は使用できません。購入した製品の受領が確認されるまで一時的に待機し、アクティベートする必要がある赤い封筒を使用できます。無料の赤い封筒を使用した後に製品に問題があり、返品する必要がある場合、赤い封筒の返却は実際の状況に応じて判断する必要があります。 1. 返金ルール 11. 返品後に返金が発生した場合赤い封筒を使用した場合、赤い封筒は比例して返却されます。 2. 返却期限を過ぎていない場合は、返却された赤い封筒の使用期間が本来の使用期限となります。期限を過ぎた場合は7日以内に発行されます。

「タオバオ」510無料紅封筒の使い方

May 08, 2024 pm 10:00 PM

「タオバオ」510無料紅封筒の使い方

May 08, 2024 pm 10:00 PM

タオバオ510の無料赤い封筒の使い方は?タオバオは最近、510周年を記念して無料注文イベントを開始しました。このイベントでは、多くの特典があり、このイベントに参加したいと考えている友人もいます。ですが、具体的な使い方がわかっている場合は、今日の関連する紹介を見てみましょう。タオバオの 510 周年記念無料注文レッド パックの使用手順: 無料注文レッド パックは、推測質問のためのすべての注文が確認され受信された後に使用できます。 1. ユーザーはウェブ版淘宝網を通じて無料の赤い封筒を発行および回収することができます。現在、カードとクーポンのパッケージはありませんが、[淘宝網 APP - 私の淘宝網 - 私の権利 - 赤い封筒] で見ることができます。無料の注文を取得したユーザーには、赤い封筒の資格がカードとクーポンのパッケージに配布され、カードとクーポンのパッケージは賞品獲得のために有効化されています。

タオバオでの総消費額の確認方法 総消費額の確認方法

Mar 12, 2024 pm 03:07 PM

タオバオでの総消費額の確認方法 総消費額の確認方法

Mar 12, 2024 pm 03:07 PM

通常オンラインショッピングをする必要がある場合、私たちは皆、すべてのショッピングニーズを完全に満たすことができるプラットフォームとしてタオバオを選択するでしょう、タオバオにはさまざまな商品のためのリソースが豊富にあり、本当にあらゆる種類の商品が集まっています。このプラットフォームには、多くのカテゴリの製品があり、自分のニーズに合わせて選択できることに誰もが気づきました。欲しいものは何でも購入できるので、誰もが間違いなくここで購入します。多くの製品があり、これらの商品の価格は大きく異なります。これらの買い物記録はすべて保存できるので、誰でもいつでも確認することができて便利です。そこで、ここで何を買い物しているかがわかっている場合は、具体的には何ですか? いくらお金を使いましたか?とても興味があるはずです。以下にお話します。

はさまざまな方法で計算できます:

はさまざまな方法で計算できます: