###こんにちは、みんな。

短いビデオを視聴しているときに、このようなビデオを見たことはありませんか?ビデオ内の人物の静止画像は、頭を傾けたり瞬きしたりするなど、動くことがあります。

以下のエフェクトと同様です

左端のキャラクターがオリジナルのアクションで、上が静止画です。 AI技術により、一番左のキャラクターの動きを上の静止画に当てはめることができ、すべての絵が同じ動きをするようになります。

このテクノロジーは通常、GAN (敵対的生成ネットワーク) に基づいて実装されています。今日は、上記の効果を再現できるオープン ソース プロジェクトを共有します。興味深いプロジェクトを実行したり、古い友人を思い出すことができます。

1. プロジェクトを実行します

プロジェクト アドレス: https://github.com/AliaksandrSiarohin/first-order-model

まず、git clone によりプロジェクトをlocal、依存関係をインストールするプロジェクトを入力します。

git clone https://github.com/AliaksandrSiarohin/first-order-model.git<br>cd first-order-model<br>pip install -r requirements.txt

ログイン後にコピー

次に、プロジェクトのホームページの「事前トレーニング済みチェックポイント」というタイトルの下で、モデルのダウンロード リンクを見つけて、モデル ファイルをダウンロードします。モデルはたくさんあります。私は vox-adv-cpk.pth.tar を使用します。

モデルファイルを準備したら、プロジェクトのルートディレクトリで以下のコマンドを実行します。

python demo.py<br>--config config/vox-adv-256.yaml <br>--driving_video src_video.mp4 <br>--source_image src_img.jpg <br>--checkpoint weights/vox-adv-cpk.pth.tar

ログイン後にコピー

パラメータの説明:

--config: モデル設定ファイル、- --driving_video: アクションビデオを提供します

-

- -source_image: アニメーション化する必要がある静的画像 - --checkpoint: ダウンロードしたばかりのモデル ファイル

-

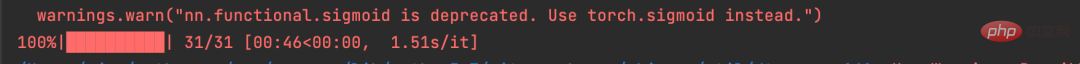

実行が完了すると、次の入力が表示されます。

このプロジェクトでは PyTorch を使用してニューラル ネットワークを構築し、GPU と CPU の動作をサポートしているため、コンピューターに CPU しか搭載されていない場合、動作は遅くなります。

CPU で実行していますが、上の図からわかるように、driving_video には 31 フレームしかありません。 CPU でも実行している場合は、driving_video ビデオの長さを制御するのが最善です。そうしないと、実行時間が長くなります。

このプロジェクトでは、いくつかの興味深い試みを自分で行うことができます。

2. Python API

上記は、公式 Web サイトに従ってコマンド ラインでプロジェクトを実行する方法を示しています。

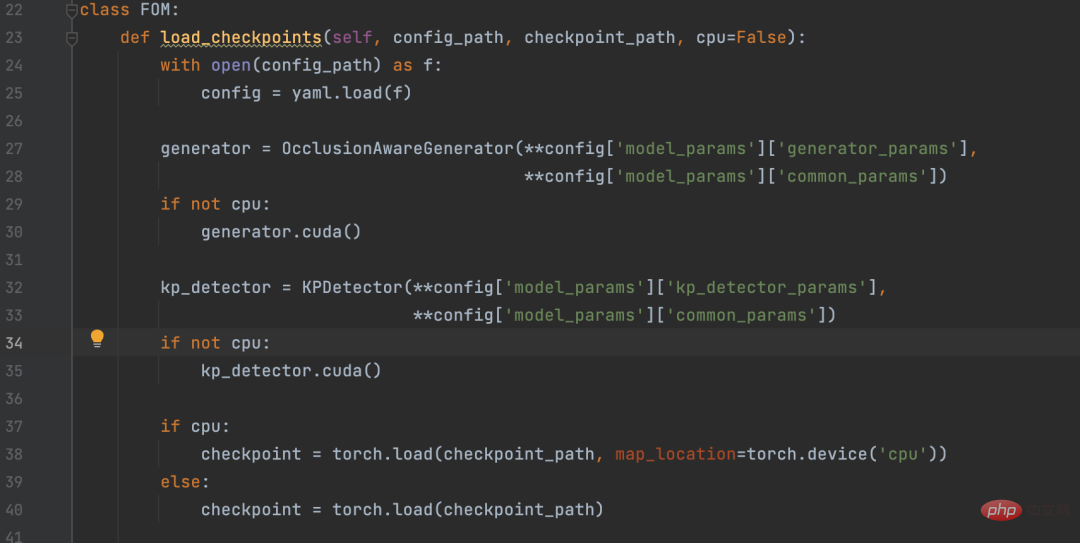

友達の中には Python プロジェクトで呼び出したい人もいるかもしれないので、demo.py のコア コードを抽出し、Python API をカプセル化しました。

必要な友人は、このファイルをダウンロードして、first-order-model と同じディレクトリに置き、次のコードに従って呼び出すことができます。

rreeee

以上がPython+AIで静止画を動かすの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。