StarCraft II 協力対決ベンチマークが SOTA を上回り、新しい Transformer アーキテクチャがマルチエージェント強化学習問題を解決

マルチエージェント強化学習 (MARL) は、各エージェントのポリシー改善の方向性を特定するだけでなく、全体のパフォーマンスを向上させるために個々のエージェントのポリシー更新を組み合わせる必要がある難しい問題です。最近、この問題は最初に解決され、一部の研究者は、エージェントがトレーニング段階でグローバル情報にアクセスできるようにする集中トレーニング分散実行 (CTDE) 手法を導入しました。ただし、これらの方法では、マルチエージェント インタラクションの複雑さをすべてカバーすることはできません。

実際、これらの方法のいくつかは失敗であることが判明しています。この問題を解決するために、マルチエージェント支配分解定理を提案した人がいます。これに基づいて、HATRPO および HAPPO アルゴリズムが導出されます。ただし、これらのアプローチには限界があり、依然として慎重に設計された最大化目標に依存しています。

近年、シーケンス モデル (SM) は自然言語処理 (NLP) の分野で大幅な進歩を遂げました。たとえば、GPT シリーズと BERT は、幅広いダウンストリーム タスクで優れたパフォーマンスを発揮し、小さなサンプルの汎化タスクでも優れたパフォーマンスを実現します。

シーケンスモデルは言語のシーケンス特性に自然に適合するため、言語タスクに使用できますが、シーケンスメソッドは NLP タスクに限定されず、広く適用可能な一般的な基本ですモデル。たとえば、コンピューター ビジョン (CV) では、画像をサブ画像に分割し、それらを NLP タスクのトークンであるかのようにシーケンスに配置できます。 Flamingo、DALL-E、GATOなどの最近の有名なモデルにはすべてシーケンスメソッドの影があります。

Transformer などのネットワーク アーキテクチャの出現に伴い、シーケンス モデリング テクノロジは RL コミュニティからも大きな注目を集めており、Transformer アーキテクチャに基づいた一連のオフライン RL 開発が推進されています。これらの方法は、最も基本的な RL トレーニングの問題のいくつかを解決する上で大きな可能性を示しています。

これらの方法は顕著な成功を収めましたが、マルチエージェント システムの最も困難な (そして MARL に特有の) 側面であるエージェント間の対話をモデル化するように設計されたものはありませんでした。実際、単にすべてのエージェントに Transformer ポリシーを与えて個別にトレーニングしたとしても、MARL ジョイントのパフォーマンスが向上するという保証はまだありません。したがって、利用可能な強力なシーケンス モデルが多数ある一方で、MARL はシーケンス モデルのパフォーマンスを実際には活用していません。

MARL 問題を解決するためにシーケンス モデルを使用するにはどうすればよいですか?上海交通大学、Digital Brain Lab、オックスフォード大学などの研究者らは、協調的な MARL 問題をシーケンス モデルの問題に効果的に変換できる新しいマルチエージェント トランスフォーマー (MAT、マルチエージェント トランスフォーマー) アーキテクチャを提案しました。エージェントの観察シーケンスをエージェントの最適なアクションシーケンスに変換します。

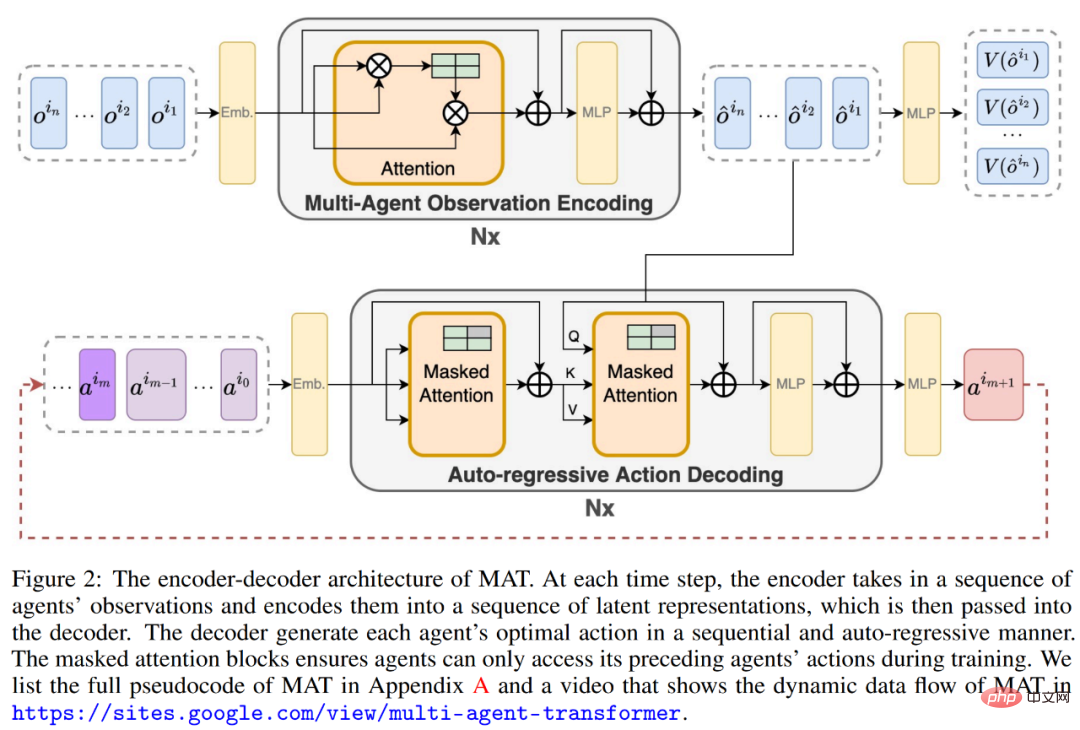

このペーパーの目標は、MARL の最新のシーケンス モデルのモデリング機能を解放するために、MARL と SM の間にブリッジを構築することです。 MAT の中核は、エンコーダ/デコーダ アーキテクチャです。これは、マルチエージェントの利点分解定理を使用して、共同戦略探索問題を逐次意思決定プロセスに変換するため、マルチエージェント問題は線形時間計算量を示し、ほとんどの重要なのは、そうすることで MAT のパフォーマンスが単調に向上することが保証されるということです。事前に収集されたオフライン データを必要とする Decision Transformer などの以前の手法とは異なり、MAT は、環境からのオンラインの試行錯誤を通じて、オンラインで戦略的な方法でトレーニングされます。

- #論文アドレス: https://arxiv.org/pdf/2205.14953 .pdf

- プロジェクトのホームページ: https://sites.google.com/view/multi-agent-transformer

MAT を検証するために、研究者は StarCraftII、マルチエージェント MuJoCo、Dexterous Hands Manipulation、Google Research Football ベンチマークについて広範な実験を実施しました。結果は、MAPPO や HAPPO などの強力なベースラインと比較して、MAT のパフォーマンスとデータ効率が優れていることを示しています。さらに、この研究は、エージェントの数がどのように変化しても、MAT は目に見えないタスクでより優れたパフォーマンスを発揮することも証明しましたが、小規模サンプル学習器としては優れていると言えます。

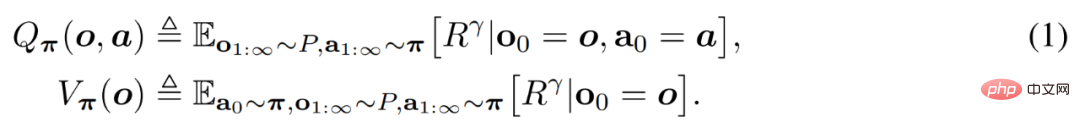

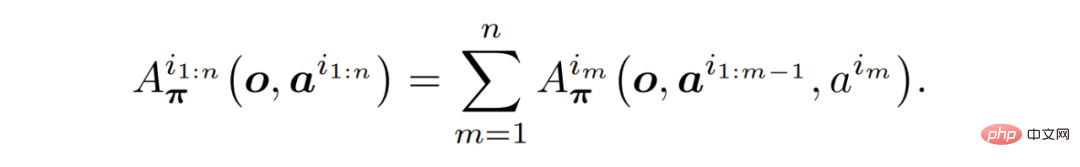

背景知識このセクションでは、研究者が最初に、この記事の基礎である協調 MARL 問題公式とマルチエージェント利点分解定理を紹介します。次に、既存の MAT 関連の MARL メソッドを検討し、最終的に Transformer に至ります。

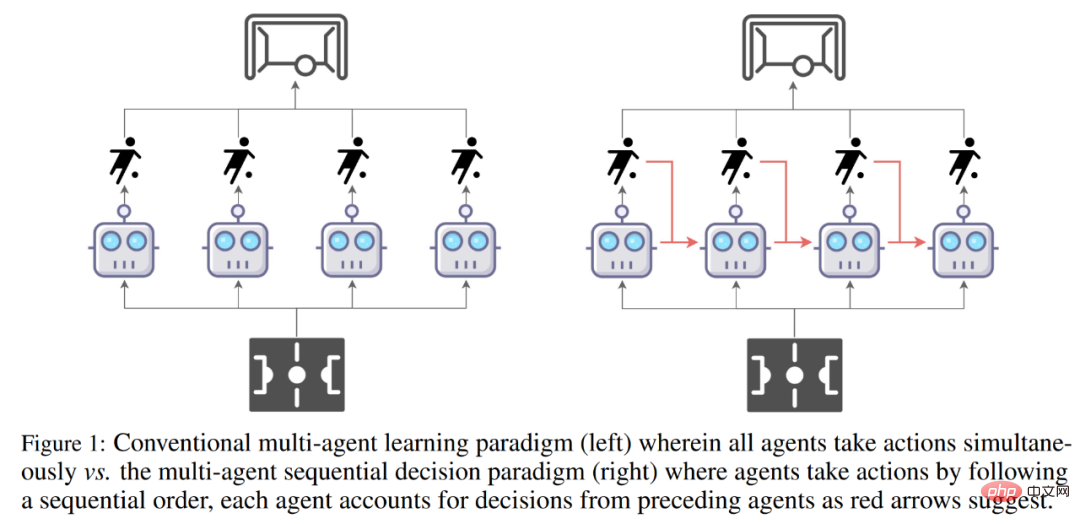

従来のマルチエージェント学習パラダイム (左) とマルチエージェント シーケンス意思決定パラダイム (右) の比較。

#問題の式協調 MARL 問題は、通常、部分的に観察可能な個別のマルコフ決定プロセス (Dec-POMDP)# で構成されます。モデルに。  マルチエージェント支配分解定理

マルチエージェント支配分解定理

既存の MARL メソッド

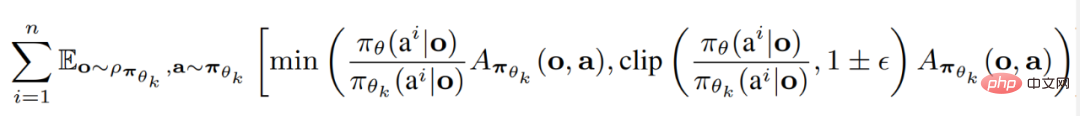

研究者らは、現在の 2 つの SOTA MARL アルゴリズムを要約しました。どちらも Proximal Policy Optimization (PPO) に基づいて構築されています。 PPO は、そのシンプルさとパフォーマンスの安定性で知られる RL 手法です。マルチエージェント近接ポリシー最適化 (MAPPO) は、PPO を MARL に適用する最初で最も簡単な方法です。

トランス モデル

定理 ( 1) シーケンスのプロパティと HAPPO の背後にある原理は、Transformer モデルを使用してマルチエージェントの信頼ドメイン学習を実装することを直感的に考慮できるようになりました。エージェント チームをシーケンスとして扱うことにより、Transformer アーキテクチャでは、MAPPO/HAPPO の欠点を回避しながら、可変の数とタイプを使用してエージェント チームをモデル化できます。マルチエージェント トランスフォーマー

MARL のシーケンス モデリング パラダイムを実現するために、研究者が提供したソリューションはマルチエージェント トランスフォーマー (MAT) です。 Transformer アーキテクチャを適用するというアイデアは、エージェントがシーケンスの入力 (o^i_1,..., o^i_n) とアクション シーケンスの出力 (a^i_1, . . ., a^i_n) マッピングは、機械翻訳に似たシーケンス モデリング タスクです。定理 (1) が回避しているように、アクション a^i_m はすべてのエージェントの以前の決定 a^i_1:m−1 に依存します。したがって、下の図 (2) に示すように、MAT には共同観察表現を学習するためのエンコーダーと、各エージェントのアクションを出力するための自己回帰手法が含まれています。

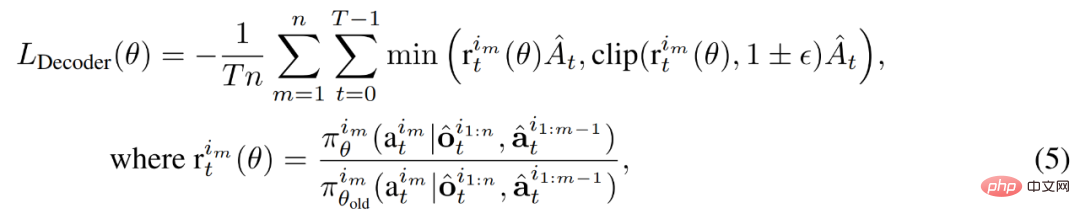

デコーダのパラメータは θ で表され、これには関節動作 a^i_0:m−1, m = {1, . . . n} (ここで a^i_0復号の開始を示す任意のシンボル)が復号ブロック シーケンスに渡されます。重要なことは、各デコード ブロックにはマスクされたセルフ アテンション メカニズムがあるということです。デコーダをトレーニングするために、次のように切り取られた PPO 目標を最小化します。

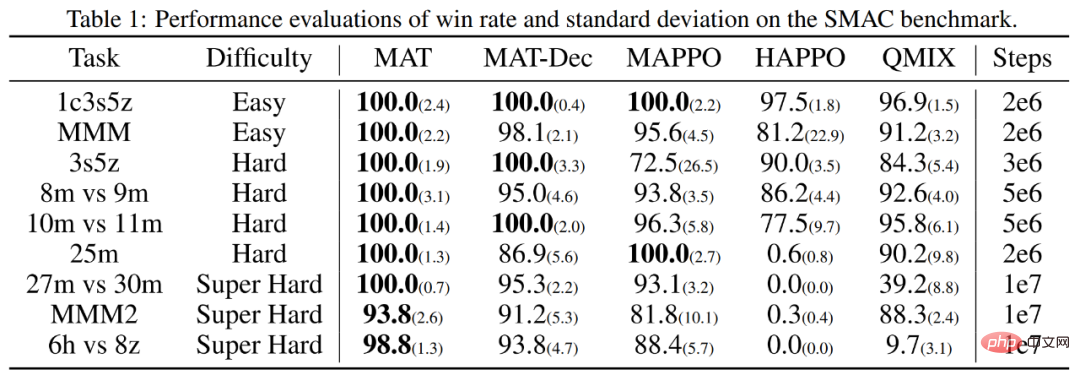

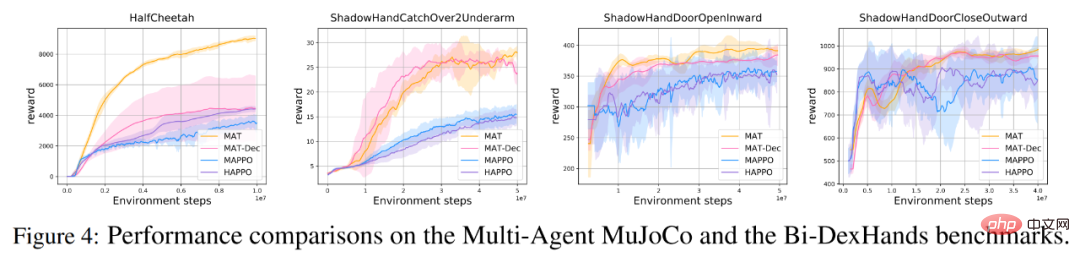

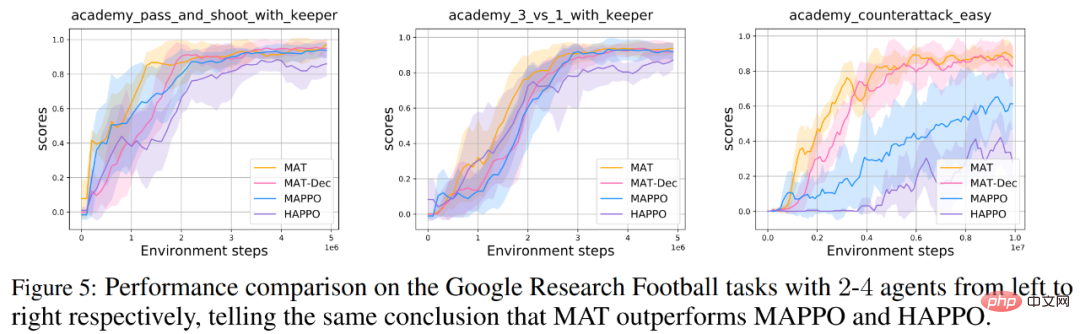

MAT が期待を満たすかどうかを評価するために、研究者は StarCraft II Multi-Agent Challenge (SMAC) ベンチマーク (MAT の上に MAPPO を追加) をテストしました。マルチエージェント MuJoCo ベンチマークでテストされました (HAPPO は SOTA パフォーマンスを備えています)。 さらに、研究者らは、Bimanual Dxterous Hand Manipulation (Bi-DexHands) および Google Research Football ベンチマークに関する MAT の拡張テストも実施しました。前者は両手で行うさまざまな挑戦的なタスクを提供し、後者はフットボールの試合内でさまざまな協力シナリオを提供します。 最後に、Transformer モデルは通常、小さなサンプル タスクに対して強力な汎化パフォーマンスを示すため、研究者らは、MAT もまだ見ぬ MARL タスクに対しても同様の強力なパフォーマンスを発揮できると考えています。したがって、彼らは SMAC およびマルチエージェント MuJoCo タスクに関するゼロショットおよびスモールショット実験を設計しました。 以下の表 1 と図 4 に示すように、SMAC、マルチエージェント MuJoCo、および Bi-DexHands ベンチマークの MAT はほぼすべてのタスクにおいて MAPPO や HAPPO よりも大幅に優れており、同種および異種のエージェント タスクに対する強力な構築能力を示しています。さらに、MAT は MAT-Dec よりも優れたパフォーマンスも達成しており、MAT 設計におけるデコーダ アーキテクチャの重要性を示しています。 同様に、Google Research Football ベンチマークの研究者も同様のパフォーマンス結果を示しています以下の図 5 に示すように、結果が得られました。 研究者らは、対照グループと同様にゼロからトレーニングされた同じデータを使用して MAT のパフォーマンスも提供しました。以下の表に示すように、MAT はほとんどの最良の結果を達成しており、MAT の少数ショット学習の強力な汎化パフォーマンスを示しています。

実験結果

協調的 MARL ベンチマークでのパフォーマンス

#少数ショット学習用の MAT

#少数ショット学習用の MAT

以上がStarCraft II 協力対決ベンチマークが SOTA を上回り、新しい Transformer アーキテクチャがマルチエージェント強化学習問題を解決の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7478

7478

15

15

1377

1377

52

52

77

77

11

11

19

19

33

33

飛び回ったり、口を開けたり、見つめたり、眉毛を上げたりする顔の特徴をAIが完璧に模倣し、ビデオ詐欺を防ぐことは不可能

Dec 14, 2023 pm 11:30 PM

飛び回ったり、口を開けたり、見つめたり、眉毛を上げたりする顔の特徴をAIが完璧に模倣し、ビデオ詐欺を防ぐことは不可能

Dec 14, 2023 pm 11:30 PM

これほど強力なAIの模倣能力では、それを防ぐことは本当に不可能です。 AIの発展は今ここまで進んでいるのか?前足で顔の特徴を浮き上がらせ、後ろ足で全く同じ表情を再現し、見つめたり、眉を上げたり、口をとがらせたり、どんなに大袈裟な表情でも完璧に真似しています。難易度を上げて、眉毛を高く上げ、目を大きく開き、口の形も歪んでいるなど、バーチャルキャラクターアバターで表情を完璧に再現できます。左側のパラメータを調整すると、右側の仮想アバターもそれに合わせて動きが変化し、口や目の部分がアップになります。同じです(右端)。この研究は、GaussianAvatars を提案するミュンヘン工科大学などの機関によるものです。

強化学習における報酬関数設計の問題

Oct 09, 2023 am 11:58 AM

強化学習における報酬関数設計の問題

Oct 09, 2023 am 11:58 AM

強化学習における報酬関数設計の問題 はじめに 強化学習は、エージェントと環境の間の相互作用を通じて最適な戦略を学習する方法です。強化学習では、報酬関数の設計がエージェントの学習効果にとって重要です。この記事では、強化学習における報酬関数の設計の問題を調査し、具体的なコード例を示します。報酬関数の役割と目標報酬関数は強化学習の重要な部分であり、特定の状態でエージェントが取得する報酬値を評価するために使用されます。その設計は、エージェントが最適なアクションを選択することで長期的な疲労を最大化するようにガイドするのに役立ちます。

Panda-Gym のロボット アーム シミュレーションを使用した Deep Q-learning 強化学習

Oct 31, 2023 pm 05:57 PM

Panda-Gym のロボット アーム シミュレーションを使用した Deep Q-learning 強化学習

Oct 31, 2023 pm 05:57 PM

強化学習 (RL) は、エージェントが試行錯誤を通じて環境内でどのように動作するかを学習できる機械学習手法です。エージェントは、望ましい結果につながるアクションを実行すると、報酬または罰を受けます。時間の経過とともに、エージェントは期待される報酬を最大化するアクションを取ることを学習します。RL エージェントは通常、逐次的な決定問題をモデル化するための数学的フレームワークであるマルコフ決定プロセス (MDP) を使用してトレーニングされます。 MDP は 4 つの部分で構成されます。 状態: 環境の可能な状態のセット。アクション: エージェントが実行できる一連のアクション。遷移関数: 現在の状態とアクションを考慮して、新しい状態に遷移する確率を予測する関数。報酬機能:コンバージョンごとにエージェントに報酬を割り当てる機能。エージェントの目標は、ポリシー機能を学習することです。

Spring Data JPA のアーキテクチャと動作原理は何ですか?

Apr 17, 2024 pm 02:48 PM

Spring Data JPA のアーキテクチャと動作原理は何ですか?

Apr 17, 2024 pm 02:48 PM

SpringDataJPA は JPA アーキテクチャに基づいており、マッピング、ORM、トランザクション管理を通じてデータベースと対話します。そのリポジトリは CRUD 操作を提供し、派生クエリによりデータベース アクセスが簡素化されます。さらに、遅延読み込みを使用して必要な場合にのみデータを取得するため、パフォーマンスが向上します。

1.3ミリ秒には1.3ミリ秒かかります。清華社の最新オープンソース モバイル ニューラル ネットワーク アーキテクチャ RepViT

Mar 11, 2024 pm 12:07 PM

1.3ミリ秒には1.3ミリ秒かかります。清華社の最新オープンソース モバイル ニューラル ネットワーク アーキテクチャ RepViT

Mar 11, 2024 pm 12:07 PM

論文のアドレス: https://arxiv.org/abs/2307.09283 コードのアドレス: https://github.com/THU-MIG/RepViTRepViT は、モバイル ViT アーキテクチャで優れたパフォーマンスを発揮し、大きな利点を示します。次に、この研究の貢献を検討します。記事では、主にモデルがグローバル表現を学習できるようにするマルチヘッド セルフ アテンション モジュール (MSHA) のおかげで、軽量 ViT は一般的に視覚タスクにおいて軽量 CNN よりも優れたパフォーマンスを発揮すると述べられています。ただし、軽量 ViT と軽量 CNN のアーキテクチャの違いは十分に研究されていません。この研究では、著者らは軽量の ViT を効果的なシステムに統合しました。

MotionLM: マルチエージェント動作予測のための言語モデリング技術

Oct 13, 2023 pm 12:09 PM

MotionLM: マルチエージェント動作予測のための言語モデリング技術

Oct 13, 2023 pm 12:09 PM

この記事は自動運転ハート公式アカウントより許可を得て転載しておりますので、転載については出典元までご連絡ください。原題: MotionLM: Multi-Agent Motion Forecasting as Language Modeling 論文リンク: https://arxiv.org/pdf/2309.16534.pdf 著者の所属: Waymo 会議: ICCV2023 論文のアイデア: 自動運転車の安全計画のために、将来の動作を確実に予測するロードエージェントの数は非常に重要です。この研究では、連続的な軌跡を離散的なモーション トークンのシーケンスとして表現し、マルチエージェントのモーション予測を言語モデリング タスクとして扱います。私たちが提案するモデル MotionLM には次の利点があります。

Golang フレームワーク アーキテクチャの学習曲線はどれくらい急ですか?

Jun 05, 2024 pm 06:59 PM

Golang フレームワーク アーキテクチャの学習曲線はどれくらい急ですか?

Jun 05, 2024 pm 06:59 PM

Go フレームワーク アーキテクチャの学習曲線は、Go 言語とバックエンド開発への慣れ、選択したフレームワークの複雑さ、つまり Go 言語の基本の十分な理解によって決まります。バックエンドの開発経験があると役立ちます。フレームワークの複雑さが異なると、学習曲線も異なります。

数年後にはプログラマーが減少するということをご存知ですか?

Nov 08, 2023 am 11:17 AM

数年後にはプログラマーが減少するということをご存知ですか?

Nov 08, 2023 am 11:17 AM

「ComputerWorld」誌はかつて、IBM がエンジニアが必要な数式を書いて提出できる新しい言語 FORTRAN を開発したため、「プログラミングは 1960 年までに消滅するだろう」という記事を書きました。コンピューターを実行すればプログラミングは終了します。画像 数年後、私たちは新しいことわざを聞きました: ビジネスマンは誰でもビジネス用語を使って問題を説明し、コンピュータに何をすべきかを伝えることができます。COBOL と呼ばれるこのプログラミング言語を使用することで、企業はもはやプログラマーを必要としません。その後、IBM は従業員がフォームに記入してレポートを作成できるようにする RPG と呼ばれる新しいプログラミング言語を開発したと言われており、会社のプログラミング ニーズのほとんどはこれで完了できます。